Nylighedsbias i AI

Lær om nylighedsbias i AI-systemer, hvordan det påvirker indholdssynlighed, anbefalingsalgoritmer og forretningsbeslutninger. Opdag afbødningsstrategier og over...

Lær om kildeselektionsbias i AI, hvordan det påvirker maskinlæringsmodeller, eksempler fra virkeligheden, og strategier til at opdage og afhjælpe dette kritiske retfærdighedsproblem.

Kildeselektionsbias opstår, når træningsdata ikke er repræsentative for den overordnede population eller den reelle fordeling, hvilket får AI-modeller til at lave unøjagtige forudsigelser for underrepræsenterede grupper eller scenarier.

Kildeselektionsbias er et grundlæggende problem i kunstig intelligens, som opstår, når de data, der bruges til at træne maskinlæringsmodeller, ikke nøjagtigt repræsenterer den virkelige population eller fordeling, de er beregnet til at betjene. Denne type bias opstår, når datasæt udvælges på måder, der systematisk udelukker eller underrepræsenterer bestemte grupper, scenarier eller karakteristika. Konsekvensen er, at AI-modeller lærer mønstre fra ufuldstændige eller skæve data, hvilket fører til forudsigelser, der er unøjagtige, uretfærdige eller diskriminerende over for underrepræsenterede populationer. At forstå denne bias er afgørende for alle, der udvikler, implementerer eller er afhængig af AI-systemer, da det direkte påvirker retfærdighed, nøjagtighed og pålidelighed af automatiseret beslutningstagning på tværs af brancher.

Kildeselektionsbias adskiller sig fra andre former for bias, fordi den opstår allerede i selve dataindsamlingsfasen. I stedet for at komme fra algoritmiske valg eller menneskelige antagelser under modeludvikling, er kildeselektionsbias indlejret i fundamentet af træningsdatasættet. Dette gør den særligt lumsk, fordi modeller trænet på biasede kildedata vil videreføre og forstærke disse bias i deres forudsigelser, uanset hvor sofistikeret algoritmen er. Problemet bliver endnu mere kritisk, når AI-systemer tages i brug i områder med stor betydning som sundhedsvæsen, finans, strafferet og rekruttering, hvor biasede forudsigelser kan få alvorlige konsekvenser for individer og samfund.

Kildeselektionsbias udvikler sig gennem flere forskellige mekanismer under dataindsamlings- og udvælgelsesprocessen. Den mest almindelige vej sker gennem dækningsbias, hvor bestemte populationer eller scenarier systematisk udelukkes fra træningsdatasættet. For eksempel, hvis et ansigtsgenkendelsessystem primært trænes på billeder af lyshudede personer, vil det have dårlig dækning af mørkhudede ansigter, hvilket fører til højere fejlrater for disse populationer. Dette sker, fordi datakollektører måske har begrænset adgang til mangfoldige populationer, eller de ubevidst prioriterer bestemte grupper, når de indsamler data.

En anden væsentlig mekanisme er non-respons bias, også kaldet deltagelsesbias, som opstår, når bestemte grupper er mindre tilbøjelige til at deltage i dataindsamlingsprocesserne. Overvej et spørgeskemabaseret datasæt til forudsigelse af forbrugerpræferencer: Hvis visse demografiske grupper er markant mindre tilbøjelige til at besvare spørgeskemaer, vil deres præferencer være underrepræsenteret i træningsdataene. Dette skaber et datasæt, der fremstår balanceret, men faktisk afspejler deltagelsesmønstre frem for sande populationskarakteristika. I sundhedsvæsenet eksempelvis, hvis kliniske forsøgsdata hovedsageligt kommer fra bybefolkninger med adgang til avancerede medicinske faciliteter, vil de resulterende AI-modeller måske ikke generalisere godt til landdistrikter eller underbetjente samfund.

Udvælgelsesbias repræsenterer en tredje mekanisme, hvor korrekt randomisering ikke anvendes under dataindsamlingen. I stedet for at udvælge datapunkter tilfældigt, kan indsamlerne vælge de første tilgængelige prøver eller benytte bekvemmelighedsudvælgelse. Dette introducerer systematiske fejl, fordi de udvalgte prøver ikke er repræsentative for den bredere population. For eksempel, hvis en AI-model til forudsigelse af lånebetalinger trænes på data indsamlet fra en bestemt geografisk region eller tidsperiode, kan den ikke nøjagtigt forudsige misligholdelser i andre regioner eller under andre økonomiske forhold.

| Biastype | Mekanisme | Virkeligt eksempel |

|---|---|---|

| Dækningsbias | Systematisk udelukkelse af populationer | Ansigtsgenkendelse trænet kun på lyshudede ansigter |

| Non-respons bias | Deltagelseshuller i dataindsamlingen | Sundhedsmodeller trænet kun på bybefolkninger |

| Udvælgelsesbias | Forkert randomisering ved udvælgelse | Låneforudsigelsesmodeller trænet på én geografisk region |

| Tidsbias | Data fra specifikke tidsperioder | Modeller trænet på data før pandemien anvendt efter pandemien |

| Kildediversitetsbias | Begrænsede datakilder | Medicinske billeddatasæt fra enkelt hospitalsystem |

Konsekvenserne af kildeselektionsbias i AI-systemer er dybtgående og langtrækkende, og påvirker både individer og organisationer. I sundhedssektoren har kildeselektionsbias ført til diagnostiske systemer, der præsterer væsentligt dårligere for visse patientgrupper. Forskning har dokumenteret, at AI-algoritmer til diagnosticering af hudkræft udviser markant lavere nøjagtighed for patienter med mørkere hudfarve, hvor nogle studier viser kun omkring halvdelen af den diagnostiske nøjagtighed sammenlignet med lyshudede patienter. Denne forskel fører direkte til forsinkede diagnoser, upassende behandlingsanbefalinger og dårligere sundhedsudfald for underrepræsenterede grupper. Når træningsdata hovedsageligt kommer fra én demografisk gruppe, lærer de resulterende modeller mønstre, der er specifikke for denne gruppe og kan ikke generalisere til andre.

I finansielle tjenester har kildeselektionsbias i kreditvurderings- og långivningsalgoritmer fastholdt historisk diskrimination. Modeller trænet på historiske låneansøgningsdata, der afspejler tidligere diskriminerende kreditpraksis, vil reproducere de samme bias, når de træffer nye lånebeslutninger. Hvis bestemte grupper historisk er blevet nægtet kredit på grund af systemisk diskrimination, og disse historiske data bruges til at træne AI-modeller, vil modellerne lære at nægte kredit til tilsvarende grupper i fremtiden. Dette skaber en ond cirkel, hvor historiske uligheder indlejres i algoritmiske beslutninger, hvilket påvirker individers adgang til kapital og økonomiske muligheder.

Rekruttering og ansættelse er et andet kritisk område, hvor kildeselektionsbias forårsager betydelig skade. AI-værktøjer, der anvendes til CV-screening, har vist sig at udvise bias baseret på opfattet race og køn, og undersøgelser viser, at navne forbundet med hvide blev foretrukket 85% af tiden i nogle systemer. Når træningsdata kommer fra historiske ansættelsesregistre, der afspejler tidligere diskrimination eller ensartede ansættelsesmønstre, lærer de resulterende AI-modeller at gentage disse mønstre. Det betyder, at kildeselektionsbias i ansættelsesdata fastholder diskrimination på arbejdspladsen i stor skala, begrænser mulighederne for underrepræsenterede grupper og reducerer mangfoldigheden i arbejdsstyrken.

I strafferetten har kildeselektionsbias i prædiktive politisystemer ført til uforholdsmæssig målretning af visse samfund. Når træningsdata kommer fra historiske anholdelsesregistre, der i sig selv er biasede mod marginaliserede grupper, forstærker de resulterende modeller disse bias ved at forudsige højere kriminalitetsrater i disse områder. Dette skaber en feedback-loop, hvor biasede forudsigelser fører til øget politiindsats i bestemte områder, hvilket genererer flere anholdelsesdata fra disse områder og forstærker yderligere biasen i modellen.

At opdage kildeselektionsbias kræver en systematisk tilgang, der kombinerer kvantitativ analyse, kvalitativ evaluering og løbende overvågning gennem hele modellens livscyklus. Første skridt er at udføre en omfattende datarevision, der undersøger kilder, indsamlingsmetoder og repræsentativitet af dine træningsdata. Dette indebærer at dokumentere, hvor data stammer fra, hvordan de er indsamlet, og om indsamlingsprocessen systematisk kan have udelukket visse populationer eller scenarier. Stil kritiske spørgsmål: Var alle relevante demografiske grupper repræsenteret i dataindsamlingen? Var der deltagelsesbarrierer, der kunne have afholdt visse grupper fra at deltage? Begrænsede indsamlingsperioden eller det geografiske område repræsentationen?

Demografisk paritetsanalyse tilbyder en kvantitativ metode til at opdage kildeselektionsbias. Det indebærer at sammenligne fordelingen af nøglekarakteristika i dine træningsdata med fordelingen i den virkelige population, din model skal betjene. Hvis dine træningsdata markant underrepræsenterer visse demografiske grupper, aldersgrupper, geografiske regioner eller andre relevante karakteristika, har du tegn på kildeselektionsbias. For eksempel, hvis dine træningsdata kun indeholder 5% kvinder, men målpopulationen er 50% kvinder, indikerer det en alvorlig dækningsbias, der sandsynligvis vil føre til dårlig modelpræstation for kvinder.

Performance slice analysis er en anden vigtig detektionsteknik, hvor du evaluerer din models præstation separat for forskellige demografiske grupper og underpopulationer. Selv hvis modellens samlede nøjagtighed ser acceptabel ud, kan præstationen variere dramatisk på tværs af grupper. Hvis din model opnår 95% nøjagtighed samlet, men kun 70% nøjagtighed for en bestemt demografisk gruppe, tyder det på, at kildeselektionsbias i træningsdataene har fået modellen til at lære mønstre, der er specifikke for majoritetsgruppen, mens den ikke lærer mønstre relevante for minoritetsgruppen. Denne analyse bør udføres ikke kun på samlet nøjagtighed, men også på retfærdighedsmetrikker som equalized odds og disparate impact.

Adversarial testing indebærer bevidst at skabe testcases designet til at afsløre potentielle bias. Dette kan være at teste din model på data fra underrepræsenterede populationer, kanttilfælde eller scenarier, der ikke er godt repræsenteret i træningsdataene. Ved at stressteste din model mod forskellige input kan du identificere, hvor kildeselektionsbias har skabt blinde vinkler. Hvis din model for eksempel primært er trænet på data fra byområder, skal du teste den grundigt på landdistriktsdata for at se, om præstationen forringes. Hvis træningsdataene kommer fra en bestemt tidsperiode, skal du teste modellen på data fra andre perioder for at opdage tidsbias.

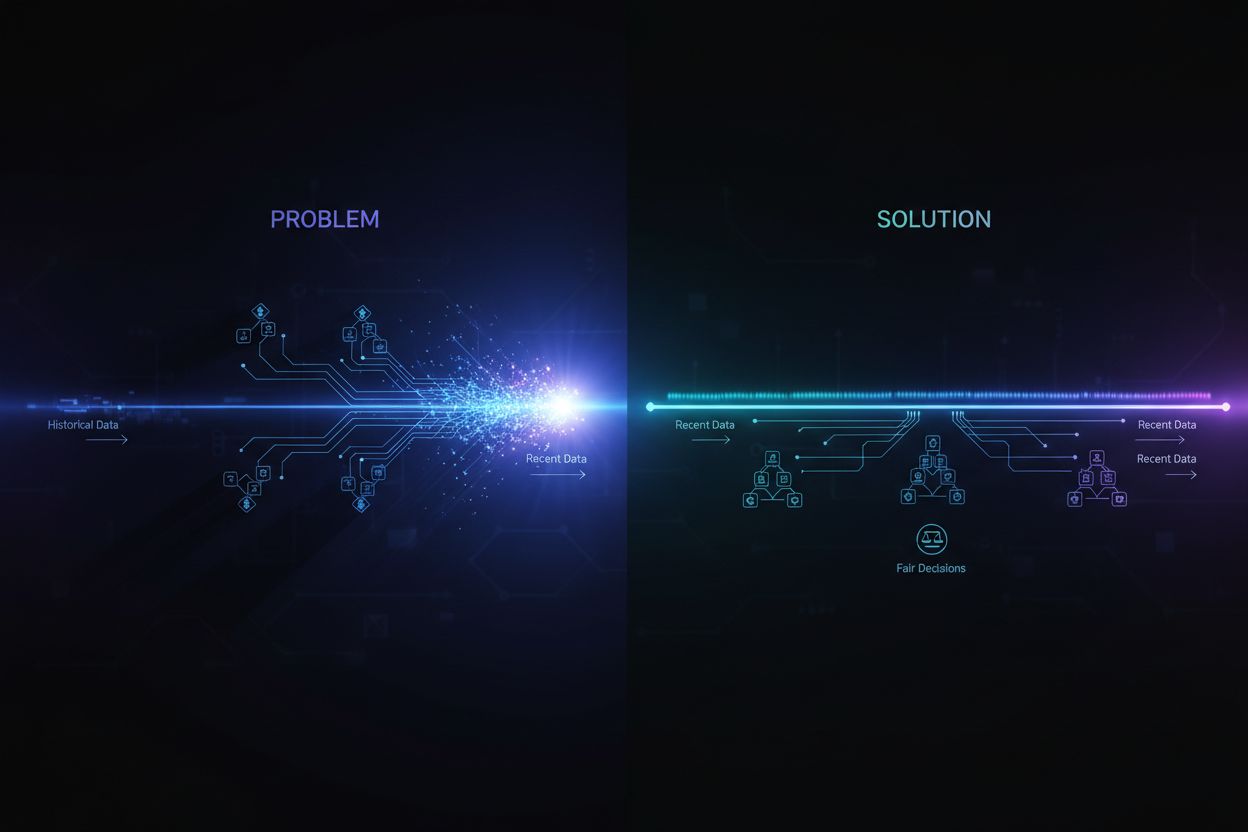

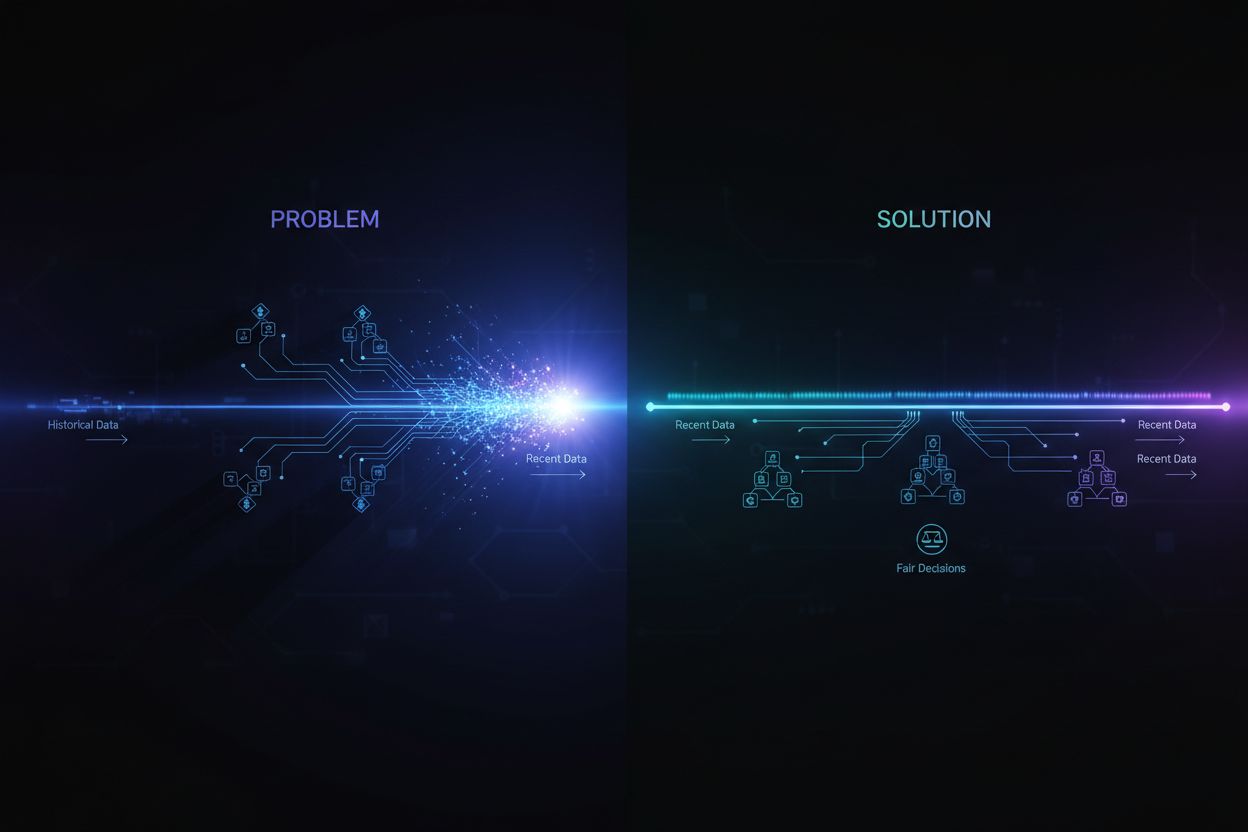

Afhjælpning af kildeselektionsbias kræver indgreb på flere stadier af AI-udviklingslivscyklussen, begyndende med dataindsamling og fortsættende gennem modelevaluering og implementering. Den mest effektive tilgang er datacentreret afhjælpning, som tackler bias ved kilden ved at forbedre kvaliteten og repræsentativiteten af træningsdata. Dette begynder med mangfoldig dataindsamling, hvor man aktivt arbejder på at inkludere underrepræsenterede populationer og scenarier i træningsdatasættet. I stedet for at basere sig på bekvemmelighedsudvalg eller eksisterende datasæt, bør organisationer gennemføre målrettede dataindsamlingsindsatser for at sikre tilstrækkelig repræsentation af alle relevante demografiske grupper og brugsscenarier.

Resampling- og omvægtningsteknikker giver praktiske metoder til at håndtere ubalancer i eksisterende datasæt. Tilfældig oversampling duplikerer eksempler fra underrepræsenterede grupper, mens tilfældig undersampling reducerer eksempler fra overrepræsenterede grupper. Mere sofistikerede metoder som stratificeret sampling sikrer proportional repræsentation på tværs af flere dimensioner samtidig. Omvægtning tildeler højere betydning til underrepræsenterede prøver under modeltræning, hvilket effektivt fortæller algoritmen at lægge mere vægt på mønstre i minoritetsgrupper. Disse teknikker fungerer bedst, når de kombineres med dataindsats for at indsamle mere mangfoldige data, i stedet for kun at stole på resampling af begrænsede data.

Syntetisk datagenerering tilbyder en anden vej til at håndtere kildeselektionsbias, især når det er svært eller dyrt at indsamle rigtige data fra underrepræsenterede grupper. Teknikker som Generative Adversarial Networks (GANs) og Variational Autoencoders (VAEs) kan skabe realistiske syntetiske eksempler for underrepræsenterede grupper. Mere målrettede metoder som SMOTE (Synthetic Minority Over-sampling Technique) skaber syntetiske eksempler ved at interpolere mellem eksisterende minoritetseksempler. Dog skal syntetiske data anvendes forsigtigt og valideres grundigt, da de kan indføre deres egne bias, hvis de ikke genereres omhyggeligt.

Retfærdighedsbevidste algoritmer udgør en anden afhjælpningsstrategi på modellens træningsstadie. Disse algoritmer indarbejder eksplicit retfærdighedskrav i læringsprocessen, så modellen opnår acceptabel præstation på tværs af alle demografiske grupper, ikke kun majoriteten. Adversarial debiasing bruger f.eks. et modstridende netværk til at sikre, at modellens forudsigelser ikke kan bruges til at udlede beskyttede karakteristika som race eller køn. Fairness-aware regularisering tilføjer straftermer til tabfunktionen, der modvirker diskriminerende adfærd. Disse metoder gør det muligt eksplicit at afveje mellem samlet nøjagtighed og retfærdighed, så du kan vælge den balance, der stemmer overens med dine etiske prioriteringer.

Løbende overvågning og genoptræning sikrer, at kildeselektionsbias ikke opstår eller forværres over tid. Selv hvis dine oprindelige træningsdata er repræsentative, kan den virkelige fordeling, din model betjener, ændre sig på grund af demografiske skift, økonomiske ændringer eller andre faktorer. Implementering af præstationsovervågningssystemer, der sporer modellens nøjagtighed separat for forskellige demografiske grupper, gør det muligt at opdage, når bias opstår. Når præstationsforringelse opdages, kan genoptræning med opdaterede data, der afspejler aktuelle populationsfordelinger, genoprette retfærdighed. Denne løbende proces anerkender, at biasafhjælpning ikke er en engangsindsats, men et kontinuerligt ansvar.

Forståelse af kildeselektionsbias bliver stadig vigtigere i forbindelse med AI-svarovervågning og brandtilstedeværelsessporing. Efterhånden som AI-systemer som ChatGPT, Perplexity og andre AI-svargeneratorer bliver primære informationskilder for brugere, formes de kilder, disse systemer citerer, og de oplysninger, de præsenterer, af deres træningsdata. Hvis træningsdataene, der bruges til at bygge disse AI-systemer, udviser kildeselektionsbias, vil de svar, de genererer, afspejle denne bias. For eksempel, hvis et AI-systems træningsdata overrepræsenterer visse websites, publikationer eller perspektiver, mens andre underrepræsenteres, vil AI-systemet være mere tilbøjeligt til at citere og forstærke information fra de overrepræsenterede kilder.

Dette har direkte betydning for brandovervågning og indholds-synlighed. Hvis dit brand, domæne eller dine URL’er er underrepræsenteret i træningsdataene for store AI-systemer, kan dit indhold systematisk udelukkes fra eller være underrepræsenteret i AI-genererede svar. Omvendt, hvis konkurrerende brands eller misinformation er overrepræsenteret i træningsdataene, vil de få uforholdsmæssig synlighed i AI-svar. Overvågning af, hvordan dit brand optræder i AI-genererede svar på tværs af forskellige platforme, hjælper dig med at forstå, om kildeselektionsbias i disse systemer påvirker din synlighed og omdømme. Ved at følge hvilke kilder der citeres, hvor ofte dit indhold vises, og om de præsenterede oplysninger er nøjagtige, kan du identificere potentielle bias i, hvordan AI-systemer repræsenterer dit brand og din branche.

Kildeselektionsbias i AI er et kritisk retfærdighedsproblem, der opstår i dataindsamlingsfasen og forplanter sig gennem alle nedstrøms anvendelser af maskinlæringsmodeller. Det opstår, når træningsdata systematisk udelukker eller underrepræsenterer bestemte populationer, scenarier eller karakteristika, hvilket resulterer i modeller, der laver unøjagtige eller uretfærdige forudsigelser for underrepræsenterede grupper. Konsekvenserne er alvorlige og vidtrækkende, og påvirker sundhedsresultater, adgang til finans, beskæftigelsesmuligheder og beslutninger i strafferetten. At opdage kildeselektionsbias kræver omfattende datarevisioner, demografisk paritetsanalyse, performance slice analysis og adversarial testing. Afhjælpning af denne bias kræver en flerstrenget tilgang, herunder mangfoldig dataindsamling, resampling og omvægtning, syntetisk datagenerering, retfærdighedsbevidste algoritmer og løbende overvågning. Organisationer må erkende, at håndtering af kildeselektionsbias ikke er valgfrit, men afgørende for at bygge AI-systemer, der er retfærdige, nøjagtige og pålidelige på tværs af alle populationer og brugsscenarier.

Sørg for, at dit brand vises korrekt i AI-genererede svar på tværs af ChatGPT, Perplexity og andre AI-platforme. Følg, hvordan AI-systemer citerer dit indhold og identificer potentielle bias i AI-svar.

Lær om nylighedsbias i AI-systemer, hvordan det påvirker indholdssynlighed, anbefalingsalgoritmer og forretningsbeslutninger. Opdag afbødningsstrategier og over...

Lær, hvordan AI-systemer udvælger og rangerer kilder til citater. Opdag algoritmerne, signalerne og faktorerne, der afgør, hvilke websites AI-platforme som Chat...

Fællesskabsdiskussion om kildeudvælgelses-bias i AI-systemer. Virkelige erfaringer fra marketingfolk og forskere om forståelse og håndtering af AI's præferentie...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.