Sådan fungerer AI-søgemaskiner: Arkitektur, hentning og generering

Lær hvordan AI-søgemaskiner som ChatGPT, Perplexity og Google AI Overviews fungerer. Opdag LLM'er, RAG, semantisk søgning og realtids-hentemekanismer.

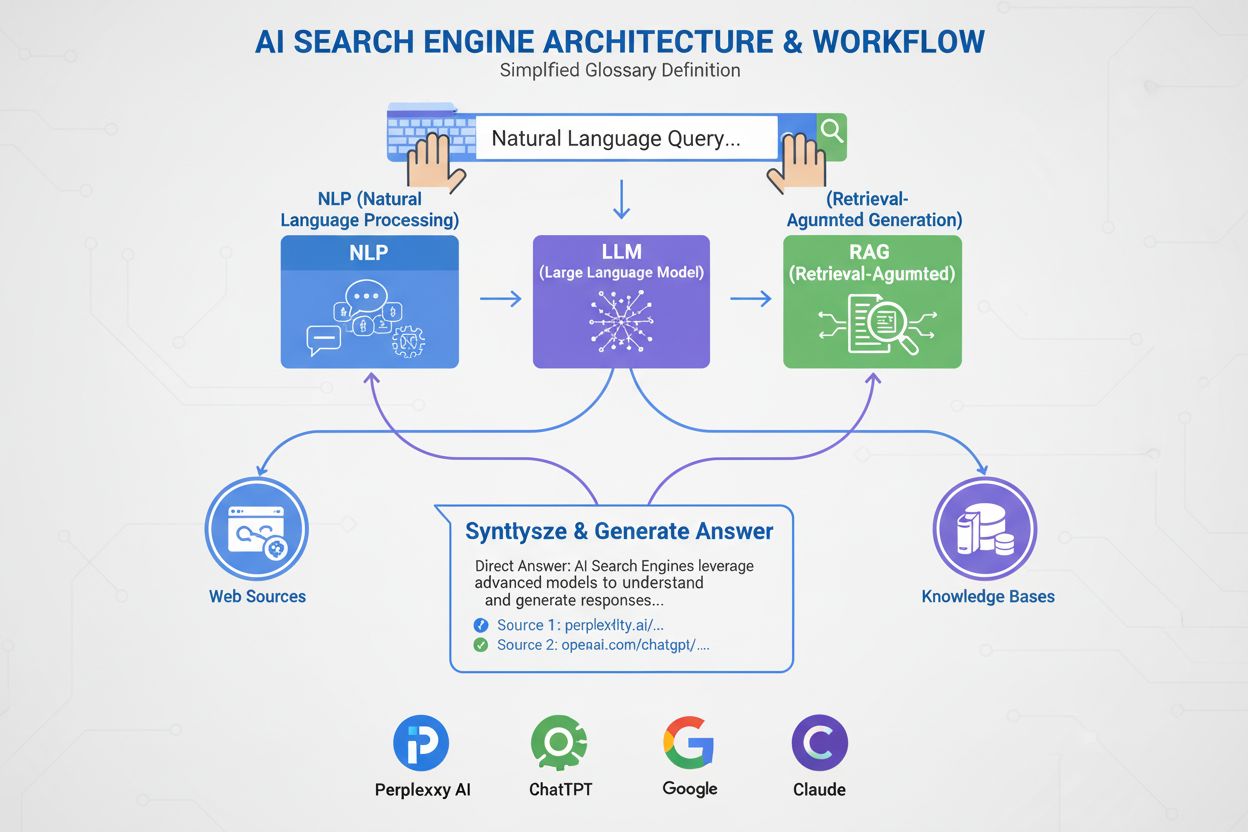

En AI-søgemaskine er en platform, der bruger kunstig intelligens, naturlig sprogbehandling og store sprogmodeller til at fortolke brugerforespørgsler og generere direkte, samtalebaserede svar, der er syntetiseret fra webkilder, i stedet for at vise traditionelle lister med links. Disse platforme udnytter retrieval-augmented generation (RAG) til at levere aktuelle, citerede oplysninger med adgang til nettet i realtid.

En AI-søgemaskine er en platform, der bruger kunstig intelligens, naturlig sprogbehandling og store sprogmodeller til at fortolke brugerforespørgsler og generere direkte, samtalebaserede svar, der er syntetiseret fra webkilder, i stedet for at vise traditionelle lister med links. Disse platforme udnytter retrieval-augmented generation (RAG) til at levere aktuelle, citerede oplysninger med adgang til nettet i realtid.

En AI-søgemaskine er en platform, der bruger kunstig intelligens, naturlig sprogbehandling (NLP) og store sprogmodeller (LLM’er) til at fortolke brugerforespørgsler og generere direkte, samtalebaserede svar, der er syntetiseret fra webkilder. I modsætning til traditionelle søgemaskiner, der viser lister med links, leverer AI-søgemaskiner korte, letforståelige resuméer, der direkte adresserer brugerens hensigt. Disse platforme udnytter retrieval-augmented generation (RAG) til at kombinere indhentning fra nettet i realtid med generativ AI-syntese, hvilket gør det muligt at levere aktuelle, citerede oplysninger. AI-søgemaskiner repræsenterer et grundlæggende skift i, hvordan folk opdager information online, fra søgeordbaserede linklister til semantisk forståelse og direkte svar. Teknologien bag disse systemer integrerer flere AI-discipliner—herunder semantisk søgning, entitetsgenkendelse og samtale-AI—for at skabe en mere intuitiv og effektiv søgeoplevelse.

Fremkomsten af AI-søgemaskiner markerer en betydelig udvikling inden for informationssøgningsteknologi. I årtier har søgemaskiner fungeret ud fra et søgeordsmatchende paradigme, hvor relevans blev bestemt af tilstedeværelse og hyppighed af søgetermer i indekserede dokumenter. Men fremkomsten af store sprogmodeller og fremskridt inden for naturlig sprogforståelse har fundamentalt ændret mulighederne. Det globale marked for AI-søgemaskiner nåede 15,23 mia. USD i 2024 og forventes at opnå en årlig gennemsnitlig vækst (CAGR) på 16,8% frem til 2032, ifølge markedsanalyser. Denne eksplosive vækst afspejler både virksomheders brug og forbrugernes efterspørgsel på mere intelligente, samtalebaserede søgeoplevelser.

Generativ AI har forandret måden, hvorpå folk opdager information online, og har skubbet søgning ud over den velkendte liste af blå links mod mere direkte, samtalebaserede svar. Branchenavne som Google og Microsoft Bing har hurtigt integreret AI på tværs af deres platforme for at følge med nye aktører som Perplexity og You.com. Ifølge McKinsey har cirka 50% af Google-søgninger allerede AI-resuméer, et tal der forventes at stige til over 75% i 2028. Dette skift er mere end blot en brugergrænsefladeændring—det redefinerer indholdsstrategi og søgemaskineoptimering til en ny æra kaldet “generative engine optimization” (GEO).

Overgangen afspejler en bredere organisatorisk indførelse af AI-teknologier. 78% af organisationerne rapporterede brug af AI i 2024, op fra 55% året før, ifølge Stanford’s AI Index Report. For søge- og marketingfolk betyder det, at synlighed nu afhænger af forståelsen af, hvordan AI-systemer fortolker, kondenserer og genfortæller indhold i letforståelige resuméer. Udfordringen er, at AI-genererede svar ofte flytter trafik væk fra de oprindelige websites, hvilket både giver muligheder og udfordringer for indholdsskabere og brands, der søger synlighed i denne nye virkelighed.

AI-søgemaskiner arbejder gennem en sofistikeret, flertrins pipeline, der kombinerer indhentning, rangering og syntese. Processen starter med forespørgselsforståelse, hvor systemet analyserer brugerens input ved hjælp af naturlig sprogbehandling for at udtrække betydning, hensigt og kontekst. I stedet for at behandle forespørgslen som en simpel række søgeord, skaber systemet flere repræsentationer: en leksikalsk form til eksakt-match indhentning, en tæt embedding til semantisk søgning og en entitetsform til knowledge graph-matchning.

Når forespørgslen er forstået, anvender de fleste AI-søgemaskiner retrieval-augmented generation (RAG), et centralt arkitektonisk mønster, der adresserer store sprogmodellers grundlæggende svagheder. RAG gennemfører et live indhentningstrin, hvor der søges i webindekser eller API’er for at finde relevante dokumenter og afsnit. Disse kandidater omrangeres derefter ved hjælp af mere sofistikerede modeller, der vurderer både forespørgsel og kandidat for at opnå en finere relevansscore. De højest rangerede resultater føres ind i en stor sprogmodel som kontekst, der danner grundlag for et samtalebaseret svar, mens der holdes fast ved de hentede kilder.

Hybride indhentningspipelines er standard på førende platforme. Disse kombinerer leksikalsk søgning (søgeordbaseret, med algoritmer som BM25) med semantisk søgning (embedding-baseret, med vektorsimilaritet). Leksikalsk søgning er god til præcision ved eksakte match, sjældne termer og navngivne entiteter, mens semantisk søgning er god til genkaldelse af konceptuelt relateret indhold. Ved at kombinere begge tilgange og anvende cross-encoder omrangering opnår AI-søgemaskiner højere nøjagtighed end ved brug af én metode alene. Den endelige syntese sker med en stor sprogmodel, der sammensætter et sammenhængende, menneskelignende svar, der integrerer information fra flere kilder, samtidig med at nøjagtigheden opretholdes og der gives kildehenvisninger.

| Aspekt | Traditionelle søgemaskiner | AI-søgemaskiner |

|---|---|---|

| Resultatformat | Lister af links med korte uddrag | Samtalebaserede resuméer med direkte svar |

| Forespørgselsbehandling | Søgeordsmatchning og rangering | Semantisk forståelse og hensigtsanalyse |

| Læringsmekanisme | Starter forfra ved hver forespørgsel | Lærer løbende af brugerinteraktion og feedback |

| Informationsindhentning | Leksikalsk/søgeordsbaseret match | Hybrid (leksikalsk + semantisk + entitetsbaseret) |

| Inputformater | Kun tekst | Tekst, billeder, stemme og video (multimodal) |

| Opdateringer i realtid | Indeksbaseret, periodisk crawling | Realtidsadgang til nettet via RAG |

| Citeringsadfærd | Ingen citeringer; brugeren finder selv kilder | Integrerede kildehenvisninger og kildeangivelse |

| Brugerinteraktion | Enkelt forespørgsel, statiske resultater | Flerdrejede samtaler med opfølgende spørgsmål |

| Bias-håndtering | Kuratorer organiserer information | AI-syntese kan medføre udviklerbias |

| Hallucinationsrisiko | Lav (links er faktuelle) | Højere (LLM’er kan generere falsk information) |

Forskellige AI-søgemaskiner implementerer forskellige arkitektoniske tilgange, hver med unikke optimeringsimplikationer. Googles AI Overviews og AI Mode anvender en query fan-out-strategi, hvor en enkelt brugerforespørgsel splittes op i flere underforespørgsler, der målretter forskellige hensigtsdimensioner. Disse underforespørgsler kører parallelt mod forskellige datakilder—webindeks, Knowledge Graph, YouTube-transkriptioner, Google Shopping-feeds og specialindekser. Resultater aggregeres, deduplikeres og rangeres, før de syntetiseres til et overblik. For GEO-specialister betyder det, at indholdet skal dække flere facetter af en forespørgsel på udtræksbare måder for at overleve fan-out-processen.

Bing Copilot repræsenterer en mere traditionel søgebaseret tilgang, hvor Microsofts modne Bing-rangeringsinfrastruktur udnyttes og GPT-klassens syntese lægges ovenpå. Platformen benytter dobbeltsporet indhentning, hvor BM25 leksikalsk søgning kombineres med tæt vektorbaseret semantisk søgning. Resultaterne passerer gennem en kontekstuel cross-encoder omranger, der fokuserer på relevans på afsnitsniveau fremfor hele sider. Denne arkitektur betyder, at klassiske SEO-signaler—crawlbarhed, canonical-tags, ren HTML, sidehastighed—stadig er meget vigtige, fordi de afgør, hvilke kandidater der når grundlaget. Bing Copilot lægger også vægt på udtræksbarhed: afsnit med klart afgrænset indhold, lister, tabeller og definitionspræget formulering citeres oftere.

Perplexity AI arbejder med bevidst gennemsigtighed og viser kilder tydeligt før selve det genererede svar. Platformen udfører søgninger i realtid, ofte med indhentning fra både Google- og Bing-indekser, hvorefter kandidater vurderes ud fra en blanding af leksikalsk og semantisk relevans, tematisk autoritet og udtræksbarhed. Forskning, der analyserer 59 forskellige faktorer for Perplexitys rangeringsadfærd, viser, at platformen prioriterer direkte svarformatering—sider, der eksplicit gentager forespørgslen i en overskrift, efterfulgt af et kort, informationsrigt svar, er overrepræsenteret i citationssæt. Entitetsprominens og linking spiller også en stor rolle; Perplexity favoriserer afsnit, hvor nøgleenheder er tydeligt navngivet og kontekstuelt linket til relaterede begreber.

ChatGPT Search har en opportunistisk tilgang, hvor søgeforespørgsler genereres dynamisk, og Bings API bruges til at hente specifikke URL’er. I modsætning til platforme med vedvarende indekser henter ChatGPT indhold i realtid, hvilket betyder, at inklusion afhænger fuldstændigt af indhentningsmuligheden i øjeblikket. Hvis et site er blokeret af robots.txt, langsomt at indlæse, skjult bag client-side rendering eller semantisk uigennemskueligt, vil det ikke blive brugt i syntesen. Denne arkitektur prioriterer tilgængelighed og klarhed: sider skal være teknisk crawlbare, lette og semantisk gennemsigtige, så on-the-fly-forespørgsler giver rent, læsbart tekstindhold.

Naturlig sprogbehandling (NLP) er den grundlæggende teknologi, der gør det muligt for AI-søgemaskiner at bevæge sig ud over søgeordsmatchning. NLP gør det muligt for systemer at analysere struktur, semantik og hensigt bag søgeforespørgsler, forstå kontekst og genkende synonymer og relaterede begreber. Når en bruger spørger “bedste steder at spise nær mig med udendørsservering”, forstår et NLP-drevet system, at forespørgslen handler om restauranter med terrasse, selvom disse ord ikke indgår eksplicit. Denne semantiske forståelse gør AI-søgemaskiner i stand til at levere nyttige resultater, selv når hensigten er mindre åbenlys eller formuleret samtalebaseret.

Store sprogmodeller (LLM’er) driver syntesestadiet i AI-søgemaskiner. Trænet på enorme mængder tekstdata forudsiger LLM’er det næste mest logiske ord ud fra kontekst, hvilket gør dem i stand til at producere sammenhængende, grammatisk korrekt tekst, der ligner menneskeskrevet indhold. Men LLM’er medfører også risici. De kan hallucinere—præsentere usandheder som fakta—fordi de genererer tekst ud fra sandsynlig viden fremfor at citere live kilder. Derfor er retrieval-augmented generation (RAG) kritisk: Ved at forankre LLM-syntese i friskhentede, autoritative kilder mindsker AI-søgemaskiner risikoen for hallucination og forbedrer den faktuelle nøjagtighed. Nogle platforme har indført linje-for-linje artikelhenvisninger for yderligere at nedbringe hallucination, selvom de citerede artikler ikke altid er præcise og nogle gange slet ikke eksisterer.

AI-søgemaskiner adskiller sig fra traditionelle søgemaskiner på flere grundlæggende måder. For det første leverer de resuméer i stedet for links. Almindelige søgemaskiner viser resultater som lister med links og korte uddrag, mens AI-søgemaskiner genererer korte resuméer, der besvarer forespørgsler direkte, så brugerne slipper for at scrolle og klikke rundt på flere websites. For det andet lærer AI-søgning over tid, mens traditionel søgning starter forfra hver gang. AI-søgemaskiner er designet til løbende at lære og tilpasse sig brugerinteraktioner og nye data, hvilket forbedrer deres præstation over tid. Traditionelle søgemaskiner arbejder fra bunden ved hver ny forespørgsel, uden hensyn til tidligere forespørgsler eller brugerinteraktioner.

For det tredje fokuserer AI-søgning på semantik, mens traditionel søgning fokuserer på søgeord. Almindelige søgemaskiner er primært afhængige af søgeordsmatchning til at fortolke forespørgsler, mens AI-søgemaskiner fokuserer på semantik—ordets bredere betydning i kontekst. Dette gør AI-søgemaskiner i stand til grundigere at forstå brugerens hensigt og levere resultater, der tættere matcher det, brugeren søger. For det fjerde accepterer AI-søgning flere inputformater, mens traditionel søgning kun accepterer tekst. Nogle AI-søgemaskiner har multimodale evner, hvilket betyder, at de kan behandle og forstå information i andre formater end tekst, såsom billeder, videoer og lyd. Dette giver en mere intuitiv og fleksibel søgeoplevelse end blot at indtaste søgeord.

Fremvæksten af AI-søgemaskiner ændrer måden, hvorpå brands arbejder med synlighed og indholdsstrategi. I stedet for kun at konkurrere om søgeordsplaceringer skal udgivere og virksomheder nu tage højde for, hvordan AI-systemer fortolker, kondenserer og genfortæller deres indhold i letforståelige resuméer. Dette skift har indledt en ny æra med “generative engine optimization” (GEO), hvor målet ikke bare er at rangere, men at blive hentet, syntetiseret og citeret af AI-systemer.

Forskning indikerer, at selv GEO-præstationen for branchens førende kan halte 20 til 50 procent bagefter SEO, ifølge McKinsey-analyse. Denne forskel afspejler GEO-strategiernes umodne karakter og kompleksiteten i at optimere til flere AI-platforme samtidigt. For brands er konsekvenserne betydelige: Synlighed i AI-søgning afhænger af, at indholdet er søgbart (optræder i søgeresultater), udtræksbart (struktureret, så AI-systemer let kan udtrække og citere det) og troværdigt (demonstrerer ekspertise, autoritet og troværdighed). Overvågningsværktøjer som AmICited sporer nu brandomtaler på tværs af AI-platforme—herunder Perplexity, ChatGPT, Google AI Overviews og Claude—for at måle denne nye form for synlighed og identificere optimeringsmuligheder.

AI-søgelandskabet udvikler sig hurtigt med store konsekvenser for, hvordan information opdages, distribueres og tjenes penge på. Det globale marked for AI-søgemaskiner forventes at vokse med en CAGR på 16,8% frem til 2032, drevet af stigende virksomhedsanvendelse og forbrugernes efterspørgsel på samtalebaserede, intelligente søgeoplevelser. Efterhånden som AI-søgemaskiner modnes, kan vi forvente, at flere vigtige tendenser opstår.

For det første vil konsolidering og specialisering sandsynligvis accelerere. Mens generalistplatforme som Google, Bing og Perplexity fortsat vil dominere, vil specialiserede AI-søgemaskiner målrettet specifikke vertikaler—jura, medicin, teknik, e-handel—blomstre. Disse vil tilbyde dybere domæneekspertise og mere præcis syntese til nicheforespørgsler. For det andet vil citerings- og kildeangivelsesmekanismer blive mere sofistikerede og standardiserede. Da regulatorisk pres øges, og udgivere kræver tydeligere kildeangivelse, vil AI-søgemaskiner sandsynligvis indføre mere granulære citeringssystemer, så brugere lettere kan spore påstande til kilder og udgivere kan måle synligheden.

For det tredje vil definitionen og målingen af “synlighed” fundamentalt ændre sig. I SEO-æraen betød synlighed placering og klikrate. I GEO-æraen betyder synlighed at blive hentet, syntetiseret og citeret—målepunkter, der kræver nye rammer og værktøjer. AmICited og lignende platforme er pionerer inden for denne måling, hvor de sporer brandomtaler på tværs af flere AI-platforme og giver indsigt i, hvor ofte og i hvilken kontekst brands optræder i AI-genererede svar.

For det fjerde vil spændingen mellem AI-søgning og traditionel søgning intensiveres. Efterhånden som AI-søgemaskiner fanger mere brugeropmærksomhed og trafik, vil traditionelle søgemaskiner føle sig pressede til at forny sig eller risikere at blive irrelevante. Googles integration af AI i sin kerneprodukt er et strategisk svar på denne trussel, men den langsigtede vinder er stadig uvis. Udgivere og brands skal optimere til både traditionelle og AI-baserede søgninger på samme tid, hvilket skaber en mere kompleks og ressourcekrævende indholdsstrategi.

Endelig vil tillid og nøjagtighed blive afgørende. Efterhånden som AI-søgemaskiner bliver primære informationskilder, vil kravene til nøjagtighed og bias-minimering stige. Regulatoriske rammer omkring AI-gennemsigtighed og ansvarlighed vil sandsynligvis opstå, hvilket kræver, at AI-søgemaskiner afslører deres træningsdata, rangeringsfaktorer og citeringsmetoder. For brands og udgivere betyder det, at E-E-A-T-signaler—ekspertise, erfaring, autoritet og troværdighed—vil blive endnu vigtigere for synlighed i både traditionelle og AI-søge-kontekster.

+++ showCTA = true ctaHeading = “Overvåg dit brands synlighed på tværs af AI-søgemaskiner” ctaDescription = “At forstå AI-søgemaskiner er kun første skridt. Spor hvor og hvordan dit brand optræder i ChatGPT, Perplexity, Google AI Overviews og Claude med AmICiteds AI-søgeovervågningsplatform. Mål din GEO-præstation, identificer citeringsmuligheder, og optimer dit indhold til næste generation af søgning.” ctaPrimaryText = “Kontakt os” ctaPrimaryURL = “/contact/” ctaSecondaryText = “Prøv det nu” ctaSecondaryURL = “https://app.amicited.com ” +++

Traditionelle søgemaskiner viser resultater som lister med links og korte uddrag, mens AI-søgemaskiner genererer samtalebaserede resuméer, der besvarer forespørgsler direkte. AI-søgemaskiner bruger naturlig sprogbehandling og store sprogmodeller til at forstå brugerens hensigt semantisk i stedet for udelukkende at stole på søgeordsmatchning. De lærer løbende af brugerinteraktioner og kan behandle flere inputformater, herunder tekst, billeder og stemme. Derudover tilbyder AI-søgemaskiner ofte adgang til nettet i realtid via retrieval-augmented generation (RAG), hvilket gør det muligt at levere aktuelle oplysninger med kildehenvisninger.

Retrieval-augmented generation (RAG) er en teknik, der gør det muligt for store sprogmodeller at hente og inkorporere friske oplysninger fra eksterne kilder, før der genereres svar. RAG løser de grundlæggende begrænsninger ved LLM'er—hallucinationer og videnbegrænsninger—ved at forankre svar i data, der er hentet i realtid. I AI-søgemaskiner fungerer RAG ved først at udføre en live-søgning eller hentning, hvor relevante dokumenter eller uddrag indsamles, hvorefter der syntetiseres et svar baseret på disse hentede elementer. Denne tilgang sikrer, at svarene både er aktuelle og kan spores til specifikke kilder, hvilket gør kildehenvisninger mulige og forbedrer den faktuelle nøjagtighed.

Førende AI-søgemaskiner inkluderer Perplexity (kendt for gennemsigtige kildehenvisninger), ChatGPT Search (drevet af GPT-4o med adgang til nettet i realtid), Google Gemini og AI Overviews (integreret med Googles søgeinfrastruktur), Bing Copilot (bygget på Microsofts søgeindeks) og Claude (Anthropics model med selektiv websøgning). Perplexity prioriterer realtidsindhentning og synlig kildeangivelse, mens ChatGPT genererer søgeforespørgsler opportunistisk. Googles tilgang bruger query fan-out til at dække flere hensigtsdimensioner, og Bing Copilot kombinerer traditionelle SEO-signaler med generativ syntese. Hver platform har forskellige arkitekturer for indhentning, citeringsadfærd og optimeringskrav.

AI-søgemaskiner følger en flertrinsproces: Først analyseres brugerforespørgslen ved hjælp af naturlig sprogbehandling for at forstå hensigten; dernæst hentes relevante dokumenter eller afsnit fra webindeks eller API’er ved hjælp af hybridindhentning (kombination af leksikalsk og semantisk søgning); derefter omrangeres kandidaterne baseret på relevans og udtræksbarhed; endelig syntetiseres et samtalebaseret svar med en stor sprogmodel, hvor kildehenvisninger indsættes til kildedokumenterne. Mekanismen for kildehenvisning varierer fra platform til platform—nogle viser inline-henvisninger, andre viser kildeoversigter, og nogle integrerer henvisninger i selve svaret. Kvaliteten og nøjagtigheden af henvisninger afhænger af, hvor godt de hentede afsnit matcher de syntetiserede påstande.

Generative engine optimization (GEO) er praksissen med at optimere indhold og brandets synlighed specifikt til AI-søgemaskiner, i modsætning til traditionel SEO, som fokuserer på søgeordsplaceringer i linkbaserede søgeresultater. GEO fokuserer på at gøre indhold søgbart, udtræksbart og citerbart af AI-systemer. Vigtige GEO-strategier inkluderer at strukturere indholdet for klarhed og direkte svar, bruge naturligt sprog, der matcher brugerens hensigt, implementere entitetsmarkering og schema, sikre hurtige indlæsningstider og opbygge tematisk autoritet. Ifølge McKinsey har cirka 50% af Google-søgninger allerede AI-resuméer, og det forventes at stige til over 75% i 2028, hvilket gør GEO stadig vigtigere for brandets synlighed.

AI-søgemaskiner kan både øge og mindske websitets trafik afhængigt af, hvordan indholdet er optimeret. Når indhold citeres i AI-genererede svar, opnår det synlighed og troværdighed, men brugerne kan få deres svar direkte uden at klikke sig videre til kilden. Forskning indikerer, at AI Overviews kan lede trafik væk fra de oprindelige websites, selvom de også giver kildeangivelse og links. For brands betyder skiftet, at synlighed nu afhænger af at blive hentet, syntetiseret og citeret af AI-systemer—ikke kun af placering i traditionelle søgeresultater. Overvågningsværktøjer som AmICited sporer brandomtaler på tværs af AI-platforme (Perplexity, ChatGPT, Google AI Overviews, Claude) for at måle denne nye form for synlighed og optimere derefter.

Naturlig sprogbehandling (NLP) er grundlaget for, hvordan AI-søgemaskiner forstår og behandler brugerforespørgsler. NLP gør det muligt for systemerne at analysere struktur, semantik og hensigt bag søgeforespørgsler i stedet for blot at matche søgeord. Det gør AI-søgemaskiner i stand til at forstå kontekst, afklare betydning og genkende synonymer og relaterede begreber. NLP driver også syntesestadiet, hvor sprogmodeller genererer grammatisk korrekte, sammenhængende svar, der lyder naturlige for brugerne. Derudover hjælper NLP AI-søgemaskiner med at udtrække og strukturere information fra websider og identificere nøgleenheder, relationer og udsagn, der kan indgå i de genererede svar.

AI-søgemaskiner håndterer realtidsinformation via retrieval-augmented generation (RAG), som udfører live-søgninger eller API-kald for at hente aktuelle data på forespørgselstidspunktet i stedet for kun at stole på træningsdata. Platforme som Perplexity og Googles AI Mode søger aktivt på nettet i realtid, så svarene afspejler de nyeste oplysninger. ChatGPT bruger Bings søge-API til at få adgang til aktuelt webindhold, når browsing er aktiveret. Aktualitetssignaler indgår også i rangeringsalgoritmer—sider med nylige udgivelsesdatoer og opdateret indhold vægtes højere for tidssensitive forespørgsler. Dog er der stadig nogle AI-søgemaskiner, der delvist er afhængige af træningsdata, som kan halte efter virkelighedens begivenheder, hvilket gør realtidsindhentning til en vigtig differentieringsfaktor mellem platformene.

Begynd at spore, hvordan AI-chatbots nævner dit brand på tværs af ChatGPT, Perplexity og andre platforme. Få handlingsrettede indsigter til at forbedre din AI-tilstedeværelse.

Lær hvordan AI-søgemaskiner som ChatGPT, Perplexity og Google AI Overviews fungerer. Opdag LLM'er, RAG, semantisk søgning og realtids-hentemekanismer.

Lær hvordan AI-søgeindekser fungerer, forskellene mellem ChatGPT, Perplexity og SearchGPT's indekseringsmetoder, og hvordan du optimerer dit indhold for AI-søge...

Opdag de bedste gratis AI-søgeværktøjer, herunder Perplexity, ChatGPT, Google Gemini og flere. Sammenlign funktioner, kapaciteter og priser på AI-svar-generator...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.