Hvad er BERT, og er det stadig relevant i 2024-2025?

Lær om BERT, dets arkitektur, anvendelser og aktuelle relevans. Forstå hvordan BERT sammenlignes med moderne alternativer, og hvorfor det fortsat er essentielt ...

BERT-opdateringen er Googles algoritmeforbedring fra oktober 2019, der bruger Bidirectional Encoder Representations from Transformers til at forbedre forståelsen af naturligt sprog i søgeforespørgsler. Den påvirker cirka 10% af alle søgeforespørgsler ved at gøre Google bedre til at forstå kontekst, præpositioner og semantisk betydning i samtalebaserede og komplekse søgefraser.

BERT-opdateringen er Googles algoritmeforbedring fra oktober 2019, der bruger Bidirectional Encoder Representations from Transformers til at forbedre forståelsen af naturligt sprog i søgeforespørgsler. Den påvirker cirka 10% af alle søgeforespørgsler ved at gøre Google bedre til at forstå kontekst, præpositioner og semantisk betydning i samtalebaserede og komplekse søgefraser.

BERT-opdateringen er en stor forbedring af Googles søgealgoritme, der blev annonceret den 25. oktober 2019, og som grundlæggende ændrede, hvordan søgemaskinen forstår naturligt sprog. BERT står for Bidirectional Encoder Representations from Transformers, en neurale netværksbaseret teknik til naturlig sprogbehandling, der gør det muligt for Google at forstå kontekst, nuancer og semantisk betydning af ord i søgeforespørgsler. I stedet for at analysere ordene enkeltvist eller sekventielt fra venstre mod højre, behandler BERT tekst bidirektionelt—undersøger hvert ord i relation til alle omkringliggende ord samtidigt—hvilket gør Google i stand til at forstå den fulde kontekstuelle betydning af komplekse, samtalebaserede forespørgsler. Ifølge Googles officielle meddelelse fra Pandu Nayak, Vice President of Search, repræsenterer denne opdatering et af de største fremskridt inden for søgeteknologi i de seneste fem år og påvirker cirka 10% af alle søgeforespørgsler (omtrent 560 millioner forespørgsler dagligt alene i USA). BERT-opdateringen blev især udviklet til at forbedre søgeresultaterne for længere, mere naturlige forespørgsler, hvor præpositioner og kontekstuelle relationer mellem ord er afgørende for at forstå brugerens hensigt.

Udviklingen af BERT repræsenterer kulminationen på mange års forskning i naturlig sprogbehandling og maskinlæring hos Google. Google-forskere introducerede BERT som et open source-framework i oktober 2018, bygget oven på tidligere fremskridt inden for transformerbaserede neurale netværk. Teknologien udsprang af Googles bredere indsats for at gå videre fra simpel nøgleords-matchning mod semantisk forståelse—en rejse, der begyndte med Hummingbird-opdateringen i 2013 og fortsatte med RankBrain i 2015. Mens RankBrain hjalp Google med at forstå nye forespørgsler ved at matche dem til lignende, introducerede BERT en grundlæggende anderledes tilgang ved at læse tekst bidirektionelt. Dette gennembrud blev muligt takket være fremskridt inden for maskinlæring og adgang til mere kraftfuld computerinfrastruktur, herunder Cloud TPUs (Tensor Processing Units), som Google for første gang brugte til at levere søgeresultater i stor skala. Forskningsteamet hos Google AI indså, at tidligere algoritmer havde svært ved at forstå betydningen af små ord som “for”, “to” og “no” i forespørgsler og ofte misforstod brugerens hensigt. BERT’s bidirektionelle træningsmetodologi løste dette problem ved at lade algoritmen tage højde for hele konteksten for hvert ord i en sætning, ikke kun de ord, der kom før eller efter i rækkefølgen.

BERT fungerer gennem en sofistikeret neurale netværksarkitektur, der behandler sprog på en grundlæggende anderledes måde end tidligere algoritmer. Hovedinnovation er dens bidirektionelle tilgang: I stedet for at læse tekst fra venstre mod højre eller højre mod venstre sekventielt, analyserer BERT alle ord i en sætning samtidigt og forstår hvert ords betydning ud fra dets relation til alle andre ord i konteksten. Dette opnås gennem transformermodeller, der bruger attention-mekanismer til at vægte vigtigheden af forskellige ord i forhold til hinanden. Når en bruger indtaster en søgeforespørgsel, opdeler BERT teksten i enkeltelementer (tokens) og behandler derefter disse tokens gennem flere lag af transformer-encodere. Hvert lag forfiner algoritmens forståelse af ordrelationer og kontekstuel betydning. Den “bidirektionelle” del er afgørende: Det betyder, at BERT ikke kun ser på, hvad der kommer før et ord, men også på, hvad der kommer efter, og dermed får et komplet kontekstbillede. For eksempel i forespørgslen “do estheticians stand a lot at work” forstår BERT, at “stand” henviser til fysisk positionering (et verbum relateret til jobkrav) og ikke “stand-alone” (et sammensat adjektiv), fordi den analyserer hele sætningskonteksten. Denne bidirektionelle behandling gør BERT i stand til at håndtere tvetydige ord med flere betydninger, forstå betydningen af præpositioner og opfange sproglige nuancer, som tidligere algoritmer gik glip af. Modellen blev trænet på enorme mængder u-mærket tekst, hvilket gjorde det muligt at lære sprogmønstre og semantiske relationer uden manuel annotation.

Den praktiske betydning af BERT-opdateringen for søgeresultater har været betydelig, især for komplekse og samtalebaserede forespørgsler. Google demonstrerede dette med flere virkelige eksempler i deres officielle meddelelse. Et bemærkelsesværdigt eksempel var forespørgslen “2019 Brazil traveler to USA need a visa”—før BERT fokuserede Googles algoritme for meget på nøgleords-matchning og viste resultater om amerikanske statsborgere, der rejser til Brasilien, og missede fuldstændig den retning, ordet “to” angav. Efter BERT forstod søgemaskinen korrekt, at forespørgslen handlede om en brasilianer, der rejser til USA, og viste relevant visuminformation til det specifikke scenarie. Et andet eksempel viste, hvordan BERT forbedrede resultaterne for “do estheticians stand a lot at work” ved at forstå, at “stand” henviste til arbejdets fysiske krav og ikke til “stand-alone” i irrelevante resultater. Disse forbedringer betyder, at brugere nu kan søge på en mere naturlig, samtalebaseret måde uden at bruge det, Google kalder “keyword-ese”—praksissen med at skrive akavede nøgleordsstrenge, som brugerne troede, søgemaskiner forstod. Med BERT kan brugerne stille spørgsmål, som de naturligt ville sige dem, og Google forstår deres hensigt mere præcist. Dette skift har især været gavnligt for stemmesøgning, hvor forespørgsler typisk er længere og mere samtalebaserede. Opdateringen forbedrede også featured snippets, idet Google anvender BERT-modeller til bedre at identificere, hvilke indholdsafsnit der mest præcist og kortfattet besvarer brugerens spørgsmål og derved giver mere relevante position-nul-resultater.

| Algoritme | Udgivelsesår | Primært fokus | Behandlingsmetode | Forespørgselsindflydelse | Nøgleinnovation |

|---|---|---|---|---|---|

| RankBrain | 2015 | Forståelse af nye forespørgsler | Sekventiel mønstergenkendelse | ~15% af forespørgsler | Håndterer ukendte søgeforespørgsler via lighedsmatchning |

| BERT | 2019 | Kontekstuel sprogforståelse | Bidirektionel transformer-analyse | ~10% af forespørgsler | Læser tekst i begge retninger samtidigt for fuld kontekst |

| MUM | 2021 (begrænset udrulning) | Multimodal og flersproget forståelse | Multitask unified model | Udvides | 1.000x kraftigere end BERT; håndterer billeder, video, tekst |

| Hummingbird | 2013 | Naturlig sprog-søgning | Semantisk nøgleordsanalyse | ~90% af forespørgsler | Introducerede semantisk søgning og samtalebaserede forespørgsler |

| Panda | 2011 | Vurdering af indholdskvalitet | Indholdsevaluering | Variabel | Straffede indhold af lav kvalitet og tyndt indhold |

BERT-opdateringen ændrede grundlæggende SEO-best practices væk fra stiv nøgleordsoptimering mod semantisk SEO og tilpasning til brugerens hensigt. Da BERT belønner naturligt skrevet, kontekstuelt relevant indhold, måtte SEO-folk tilpasse deres strategier. En vigtig konsekvens er, at keyword stuffing og kunstig placering af nøgleord blev endnu mindre effektivt, da BERT nu kan skelne mellem naturlig sprogbrug og tvungen nøgleordsindsættelse. Indholdsskabere skal fokusere på at skrive klart og grammatisk korrekt materiale, der reelt besvarer brugerens spørgsmål, i stedet for at optimere efter specifikke nøgleordsfraser. Opdateringen understregede også vigtigheden af topic clusters og omfattende emnedækning—i stedet for at målrette enkeltstående nøgleord handler succesrig SEO nu om at skabe dybdegående indhold, der belyser et emne fra flere vinkler og naturligt inkluderer relaterede termer og begreber. Featured snippets blev mere konkurrenceprægede, da BERTs forbedrede forståelse betyder, at kun reelt hjælpsomme, velstrukturerede svar sandsynligvis vælges til position nul. Desuden fremhævede opdateringen betydningen af præpositioner og små bindeord, der tidligere blev overset; indhold skal nu bruge disse ord naturligt og korrekt, da BERT forstår deres betydning for meningen. Long-tail-nøgleord og samtalefraser blev mere værdifulde, da BERT er særligt god til at forstå disse naturlige sprogmønstre. Det er dog vigtigt at bemærke, at BERT ikke erstatter traditionelle SEO-grundelementer—backlinks, sidehastighed, mobiloptimering og teknisk SEO er fortsat kritiske rangeringsfaktorer. BERT betyder blot, at indholdskvalitet, klarhed og semantisk relevans er vigtigere end nogensinde.

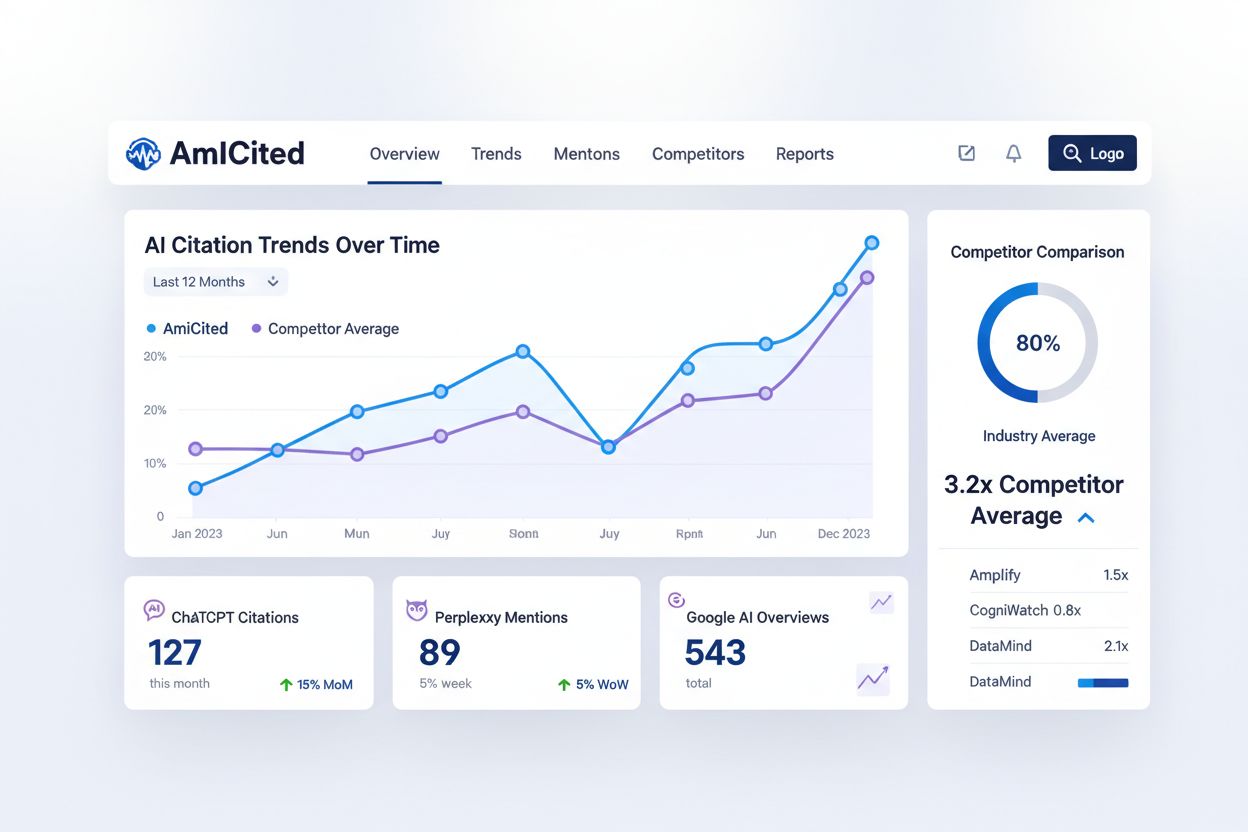

Selvom BERT specifikt blev udviklet til Google Søgning, har dets principper og underliggende teknologi påvirket, hvordan andre AI-systemer behandler naturligt sprog. ChatGPT, Claude, Perplexity og Google AI Overviews bruger alle lignende transformerbaserede arkitekturer og bidirektionelle behandlingsmetoder til at forstå brugerforespørgsler og generere svar. Forståelse af BERT’s tilgang til naturlig sprogbehandling er derfor relevant for alle, der vil følge med i, hvordan deres indhold vises på tværs af flere AI-platforme. For Google AI Overviews (tidligere SGE—Search Generative Experience) hjælper BERT’s kontekstuelle forståelse med at afgøre, hvilke kilder der citeres, og hvordan indholdet opsummeres i AI-genererede svar. Algoritmens evne til at forstå semantisk betydning betyder, at indhold ikke behøver matche forespørgsler ordret for at blive udvalgt; i stedet er det indhold, der adresserer den underliggende brugerhensigt, mere tilbøjeligt til at blive vist. For Perplexity AI, som lægger vægt på kildehenvisning og samtalebaseret søgning, hjælper BERT-lignende behandling systemet med at forstå, hvilke kilder der bedst besvarer komplekse, sammensatte spørgsmål. ChatGPT og Claude bruger transformerarkitekturer, der minder om BERT’s, men i langt større skala, hvilket gør dem i stand til at forstå nuancerede brugeranmodninger og generere kontekstuelt passende svar. Det betyder, at indhold optimeret efter BERT-principper—klart, kontekstuelt relevant, naturligt skrevet materiale, der adresserer brugerens hensigt—med større sandsynlighed bliver citeret og fremhævet på disse AI-platforme. For brands og indholdsskabere, der bruger AmICited til at overvåge deres tilstedeværelse i AI-søgeresultater, er forståelse af BERT’s vægt på semantisk relevans og kontekstuel betydning afgørende for at optimere indhold, der bliver udvalgt af disse AI-systemer.

Siden introduktionen i 2019 har BERT fortsat med at udvikle sig og påvirke udviklingen af Googles søgealgoritme. Teknologien dannede grundlaget for MUM (Multitask Unified Model), der blev annonceret i maj 2021, og som Google beskriver som 1.000 gange kraftigere end BERT. MUM udvider BERT’s kapabiliteter ved at håndtere flere typer indhold (tekst, billeder, video) samtidigt og forstå information på tværs af forskellige sprog uden at kræve særskilt træning for hvert sprog. Dette repræsenterer et stort spring fremad i AIs evne til at forstå og behandle information omfattende. Fremadrettet tyder udviklingen inden for naturlig sprogbehandling i søgning på fortsat fokus på semantisk forståelse, brugertilpasning og kontekstuel relevans. Efterhånden som AI-systemer bliver mere sofistikerede, vil forskellen mellem nøgleords-matchning og semantisk forståelse blive endnu mere markant. Indholdsskabere og SEO-folk bør forvente, at fremtidige algoritmeopdateringer i endnu højere grad belønner indhold af høj kvalitet, der er naturligt skrevet og reelt adresserer brugerens behov. Fremkomsten af generativ AI i søgeresultater betyder, at forståelsen af, hvordan algoritmer som BERT fortolker indhold, bliver stadig vigtigere for korrekt kreditering og synlighed. Desuden vil BERT’s styrke i at behandle naturligt sprog fortsat være relevant, efterhånden som stemmesøgning og samtalebaseret AI vokser. Teknologien har også konsekvenser ud over søgning—BERT-principper anvendes på indholdsmoderation, sentimentanalyse og andre opgaver inden for naturlig sprogbehandling. For organisationer, der overvåger deres brandtilstedeværelse i AI-systemer, hjælper viden om BERT og relaterede teknologier med at forklare, hvorfor visse indholdstyper udvælges til AI-svar, mens andet ikke gør. Fremtiden for søgning vil sandsynligvis indebære endnu mere sofistikeret forståelse af brugerhensigt, kontekst og semantisk betydning, direkte bygget på det fundament, BERT har lagt.

For at optimere indhold til BERT og bevare synlighed i moderne søgeresultater bør indholdsskabere følge en række evidensbaserede praksisser. Skriv naturligt og samtalebaseret: Brug et sprog, der lyder menneskeligt og naturligt i stedet for kunstigt optimeret til nøgleord. BERT belønner indhold, der læses godt og kommunikerer klart. Fokusér på brugerens hensigt: Forstå, hvad brugerne faktisk ønsker at finde, når de søger på et bestemt emne, og skab indhold, der direkte adresserer denne hensigt. Dæk emnet grundigt: I stedet for at målrette enkelte nøgleord, lav dybdegående indhold, der belyser emnet fra flere vinkler og naturligt inddrager relaterede begreber og terminologi. Strukturer indholdet klart: Brug overskrifter, underoverskrifter, punktlister og logisk struktur for at hjælpe både læsere og søgemaskiner med at forstå organisering og mening. Svar direkte på spørgsmål: Inkluder FAQ-sektioner og klare svar på almindelige spørgsmål om dit emne, da BERT er særligt god til at matche spørgsmål til relevante svar. Oprethold grammatisk korrekthed: BERT kan nu skelne mellem grammatisk korrekt og ukorrekt indhold, så korrekt grammatik og syntaks betyder mere end nogensinde. Brug præpositioner og bindeord naturligt: Undgå ikke små ord som “for”, “til”, “by” og “med”—brug dem naturligt, da de bidrager til den semantiske betydning. Lav indhold til mennesker først: Husk, at BERT er designet til at belønne indhold, der reelt hjælper brugeren, ikke indhold, der er optimeret til algoritmer. Den bedste SEO-strategi er at skabe værdifuldt, hjælpsomt indhold, der imødekommer din målgruppes behov. Implementér strukturerede data: Brug schema markup for at hjælpe søgemaskiner med at forstå dit indholds betydning og kontekst og dermed supplere BERTs forståelse af naturligt sprog. Overvåg long-tail og samtalebaserede nøgleord: Følg med i, hvordan dit indhold klarer sig for længere, mere naturlige søgefraser, da det især er her, BERTs forbedringer er synlige.

+++

BERT står for Bidirectional Encoder Representations from Transformers. Google-forskere introducerede BERT som et open source-maskinlæringsframework i oktober 2018, og Google begyndte officielt at bruge det i søgerangeringer den 25. oktober 2019. Denne opdatering var en af de mest markante forbedringer af Google Søgning i fem år og ændrede grundlæggende, hvordan søgemaskinen behandler og forstår forespørgsler i naturligt sprog.

Mens RankBrain (2015) hjalp Google med at forstå nye søgeforespørgsler ved at matche dem med lignende, går BERT skridtet videre ved at læse teksten bidirektionelt—altså analysere ordene i forhold til alle omkringliggende ord samtidigt i stedet for sekventielt. BERT forstår kontekst, præpositioner og nuanceret betydning mere præcist end RankBrain, hvilket gør det særligt effektivt til længere, samtalebaserede forespørgsler, hvor små ord som 'for' og 'til' ændrer betydningen væsentligt.

Google har oplyst, at BERT påvirker cirka 10% af alle søgeforespørgsler i USA for engelsksprogede søgninger, svarende til omkring 560 millioner forespørgsler om dagen. Opdateringen påvirker også featured snippets i 24 lande på flere sprog, hvilket viser dens globale betydning for at forbedre relevans og nøjagtighed i søgeresultater.

Der findes ingen direkte BERT-optimeringsstrategi, som der gør for mobiloptimering. I stedet belønner BERT indhold af høj kvalitet, der er naturligt skrevet og klart besvarer brugerens spørgsmål. Fokuser på at skrive grammatisk korrekt og kontekstuelt relevant indhold, der dækker brugerens hensigt grundigt. Sørg for, at dit indhold bruger naturligt sprog, dækker emnet grundigt og tilfører reel værdi—disse praksisser stemmer overens med BERTs fokus på semantisk forståelse frem for nøgleords-matchning.

BERT bruger bidirektionel behandling, hvilket betyder, at den læser tekst både fra venstre mod højre og højre mod venstre samtidigt og forstår, hvordan hvert ord relaterer sig til alle andre ord i sætningen. Dette gør det muligt for BERT at opfatte hele konteksten og de finere nuancer i forespørgsler. For eksempel i 'Brazil traveler to USA needs visa' forstår BERT, at 'to' angiver retning fra Brasilien til USA, ikke omvendt, og leverer mere relevante resultater.

Google anvender BERT-modeller til både søgerangeringer og featured snippets. BERT forbedrer udvælgelsen af featured snippets ved bedre at forstå, hvilke afsnit i indholdet der mest præcist og kortfattet besvarer brugernes spørgsmål. Det betyder, at sider med klare, velstrukturerede svar på almindelige spørgsmål har større sandsynlighed for at blive valgt til position nul, da BERT nu mere præcist kan vurdere relevans og svar-kvalitet.

BERT forbedrer markant stemmesøgnings-oplevelsen, fordi stemmeforespørgsler typisk er mere samtalebaserede og naturlige end indtastede forespørgsler. Da BERT er særligt god til at forstå naturligt sprog, længere fraser og kontekstuel betydning, leverer den bedre resultater for stemmesøgning. Brugere kan nu stille spørgsmål på en naturlig, samtalebaseret måde uden at bruge 'keyword-ese', og BERT vil forstå deres hensigt mere præcist.

Nej, BERT supplerer snarere end erstatter traditionelle SEO-grundelementer. Backlinks, sidehastighed, mobiloptimering og teknisk SEO er fortsat vigtige rangeringsfaktorer. BERT forbedrer specifikt Googles forståelse af indholdets betydning og brugerens hensigt, så den arbejder sammen med de øvrige rangeringssignaler. En omfattende SEO-strategi skal tage højde for alle faktorer—BERT betyder blot, at indholdskvalitet og klarhed i naturligt sprog er blevet endnu vigtigere.

Begynd at spore, hvordan AI-chatbots nævner dit brand på tværs af ChatGPT, Perplexity og andre platforme. Få handlingsrettede indsigter til at forbedre din AI-tilstedeværelse.

Lær om BERT, dets arkitektur, anvendelser og aktuelle relevans. Forstå hvordan BERT sammenlignes med moderne alternativer, og hvorfor det fortsat er essentielt ...

Fællesskabsdiskussion om, hvorvidt BERT-optimering stadig er vigtig i GPT-4's tidsalder og andre store sprogmodeller. Forstå, hvad der har ændret sig for SEO og...

Lær, hvordan du optimerer spørgsmaalsbaseret indhold til konversationsbaserede AI-systemer som ChatGPT og Perplexity. Opdag struktur-, autoritets- og overvågnin...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.