Skal du blokere eller tillade AI-crawlere? Beslutningsramme

Lær at træffe strategiske beslutninger om blokering af AI-crawlere. Vurder indholdstype, trafikkilder, indtægtsmodeller og konkurrenceposition med vores omfatte...

En strategisk tilgang, der gør det muligt for webstedsejere selektivt at tillade visse AI-crawlere, mens andre blokeres baseret på forretningsmål, indholdslicensaftaler og værdiansættelse. I stedet for at implementere generelle politikker vurderer differentiel adgang hver crawler individuelt for at afgøre, om den skaber trafik, respekterer licensvilkår eller stemmer overens med indtjeningsmål. Udgivere bruger værktøjer som robots.txt, HTTP-headere og platformspecifikke kontroller til at implementere detaljerede adgangspolitikker. Denne metode balancerer innovationsmuligheder med indholdsbeskyttelse og retfærdig kompensation.

En strategisk tilgang, der gør det muligt for webstedsejere selektivt at tillade visse AI-crawlere, mens andre blokeres baseret på forretningsmål, indholdslicensaftaler og værdiansættelse. I stedet for at implementere generelle politikker vurderer differentiel adgang hver crawler individuelt for at afgøre, om den skaber trafik, respekterer licensvilkår eller stemmer overens med indtjeningsmål. Udgivere bruger værktøjer som robots.txt, HTTP-headere og platformspecifikke kontroller til at implementere detaljerede adgangspolitikker. Denne metode balancerer innovationsmuligheder med indholdsbeskyttelse og retfærdig kompensation.

Eksplosionen af AI-crawlere har fundamentalt forstyrret det årtier gamle forhold mellem webstedsejere og bots. I årevis fungerede internettet ud fra en simpel udveksling: søgemaskiner som Google indekserede indhold og sendte trafik tilbage til de oprindelige kilder, hvilket skabte et symbiotisk forhold, der belønnede kvalitetsindhold. I dag opererer en ny generation af AI-crawlere—including GPTBot, ClaudeBot, PerplexityBot og snesevis af andre—under andre regler. Disse bots skraber indhold ikke for at indeksere det til opdagelse, men for at fodre det direkte ind i AI-modeller, der genererer svar uden at sende brugere tilbage til den oprindelige kilde. Effekten er markant: ifølge Cloudflare-data opretholder OpenAIs GPTBot et crawl-til-henvisningsforhold på cirka 1.700:1, mens Anthropics ClaudeBot når 73.000:1, hvilket betyder, at for hver besøgende, der sendes tilbage til en udgivers side, bliver tusinder af sider crawlet til træningsdata. Denne brudte udveksling har tvunget udgivere til at gentænke deres crawler-adgangspolitikker og bevæge sig væk fra det binære valg “tillad alle” eller “blokér alle” mod en mere nuanceret strategi: differentiel crawler-adgang. I stedet for at indføre generelle politikker vurderer kloge udgivere nu hver crawler individuelt og stiller kritiske spørgsmål om værdi, licens og overensstemmelse med forretningsmål.

At forstå de forskellige typer AI-crawlere er afgørende for at implementere en effektiv strategi for differentiel adgang, da hver tjener forskellige formål med varierende indvirkning på din virksomhed. AI-crawlere falder i tre primære kategorier: træningscrawlere (GPTBot, ClaudeBot, anthropic-ai, CCBot, Bytespider), der indsamler indhold til modeltræning; søgecrawlere (OAI-SearchBot, PerplexityBot, Google-Extended), der indekserer indhold til AI-drevne søgeresultater; og brugerudløste agenter (ChatGPT-User, Claude-Web, Perplexity-User), der kun henter indhold, når brugere eksplicit anmoder om det. Værditilbuddet varierer dramatisk på tværs af disse kategorier. Træningscrawlere genererer typisk minimal trafik tilbage til dit site—de udtrækker værdi uden gensidig fordel—hvilket gør dem til oplagte kandidater til blokering. Søgecrawlere kan derimod skabe meningsfuld henvisningstrafik og abonnentkonverteringer, ligesom traditionelle søgemaskiner. Brugerudløste agenter placerer sig midt imellem og aktiveres kun, når brugere aktivt interagerer med AI-systemer. The Atlantic, en af de største digitale udgivere, implementerede en sofistikeret scorecard-tilgang til at evaluere crawlere, hvor både trafikvolumen og abonnentkonverteringer spores for hver bot. Deres analyse afslørede, at mens nogle crawlere skaber reel værdi, genererer andre reelt ingen trafik, men forbruger betydelig båndbredde. Denne datadrevne tilgang gør det muligt for udgivere at træffe informerede beslutninger fremfor at handle ud fra antagelser.

| Crawler-type | Eksempler | Primært formål | Typisk trafikværdi | Anbefalet adgang |

|---|---|---|---|---|

| Træning | GPTBot, ClaudeBot, anthropic-ai, CCBot, Bytespider | Modeltræningsdatasæt | Meget lav (1.700:1 til 73.000:1) | Ofte blokeret |

| Søgning | OAI-SearchBot, PerplexityBot, Google-Extended | AI-søgeindeksering | Medium til høj | Ofte tilladt |

| Brugerudløst | ChatGPT-User, Claude-Web, Perplexity-User | Direkte brugerforespørgsler | Variabel | Afhænger af situationen |

Implementering af differentiel crawler-adgang kræver en kombination af tekniske værktøjer og strategiske beslutninger, med flere metoder afhængigt af dine tekniske muligheder og forretningskrav. Det mest grundlæggende værktøj er robots.txt, en simpel tekstfil i rodmappen på dit website, der kommunikerer crawler-adgangspræferencer via User-agent-direktiver. Selvom robots.txt er frivillig og kun 40-60% af AI-bots respekterer den, forbliver det første forsvarslinje og koster intet at implementere. For udgivere, der ønsker stærkere håndhævelse, opretter og opdaterer Cloudflares managed robots.txt automatisk crawler-direktiver, tilføjer dem til din eksisterende fil og eliminerer behovet for manuel vedligeholdelse. Ud over robots.txt giver flere håndhævelsesmekanismer yderligere kontrol:

Den mest effektive tilgang kombinerer flere lag: robots.txt til kompatible crawlere, WAF-regler til håndhævelse og overvågningsværktøjer til at spore effektivitet og identificere nye trusler.

Implementering af differentiel crawler-adgang kræver mere end teknisk implementering; det handler om at udvikle en sammenhængende forretningsstrategi, der er afstemt med din indtjeningsmodel og konkurrenceposition. The Atlantics tilgang giver en praktisk ramme: de vurderer hver crawler ud fra to hovedparametre—trafikvolumen og abonnentkonverteringer—og spørger, om crawleren skaber tilstrækkelig værdi til at retfærdiggøre indholdsadgang. For en udgiver med en abonnentværdi på 80 USD årligt repræsenterer en crawler, der skaffer 1.000 abonnenter, 80.000 USD i årlig omsætning, hvilket fundamentalt ændrer adgangsbeslutningen. Men trafik og abonnenttal udgør kun en del af ligningen. Udgivere skal også overveje:

De mest strategiske udgivere implementerer trinvise adgangspolitikker: de tillader søgecrawlere, der skaber trafik, blokerer træningscrawlere der ikke gør, og forhandler licensaftaler med værdifulde AI-virksomheder. Denne tilgang maksimerer både synlighed og indtjening, samtidig med at intellektuelle rettigheder beskyttes.

Selvom differentiel crawler-adgang tilbyder betydelige fordele, er virkeligheden mere kompleks end teorien, med en række fundamentale udfordringer, der begrænser effektiviteten og kræver løbende håndtering. Den vigtigste begrænsning er, at robots.txt er frivillig—crawlere, der respekterer den, gør det af eget valg. Forskning viser, at robots.txt kun stopper 40-60% af AI-bots, mens yderligere 30-40% fanges af user-agent-blokering, hvilket efterlader 10-30% crawlere uden restriktioner. Nogle AI-virksomheder og ondsindede aktører vælger bevidst at ignorere robots.txt-direktiver, fordi indholdsadgang vurderes vigtigere end overholdelse. Derudover udvikles crawler-undvigelsesteknikker løbende: avancerede bots forfalsker user agents for at fremstå som legitime browsere, bruger distribuerede IP-adresser for at undgå detektion og benytter headless-browsere, der efterligner menneskelig adfærd. Google-Extended-dilemmaet eksemplificerer kompleksiteten: blokering af Google-Extended forhindrer dit indhold i at blive brugt til Gemini AI-træning, men Google AI Overviews (der vises i søgeresultater) bruger standard Googlebot-regler, så du kan ikke fravælge AI Overviews uden at miste søgesynlighed. Overvågning og håndhævelse kræver også betydelige ressourcer—det kræver løbende opmærksomhed at spore nye crawlere, opdatere politikker og validere effektivitet. Endelig er den juridiske situation usikker: selvom ophavsretloven teoretisk beskytter indhold, er håndhævelse mod AI-virksomheder dyr og udfaldet uforudsigeligt, hvilket efterlader udgivere med teknisk kontrol uden juridisk sikkerhed.

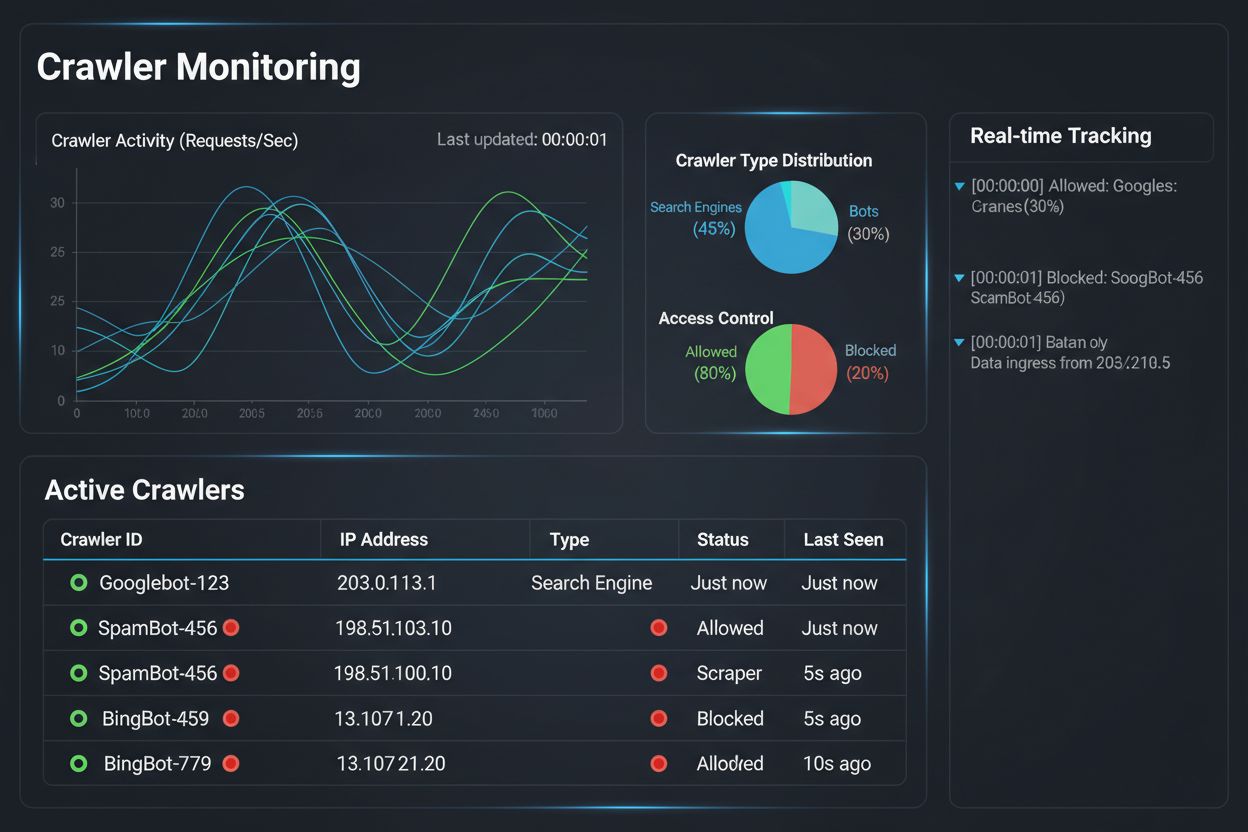

Implementering af en strategi for differentiel crawler-adgang er kun halvdelen af opgaven; den anden halvdel er at forstå den faktiske effekt af dine politikker gennem omfattende overvågning og måling. Her bliver AmICited.com afgørende for din crawler management-strategi. AmICited er specialiseret i at overvåge, hvordan AI-systemer refererer og citerer dit brand på tværs af GPT’er, Perplexity, Google AI Overviews og andre AI-platforme—og giver indblik i, hvilke crawlere der faktisk bruger dit indhold, og hvordan det vises i AI-genererede svar. I stedet for at stole på serverlogs og gætterier viser AmICiteds overvågnings-dashboard dig præcis, hvilke AI-systemer der har tilgået dit indhold, hvor ofte, og vigtigst af alt, om dit indhold bliver citeret eller blot absorberet i træningsdata uden attribution. Denne viden informerer direkte dine differentielle adgangsbeslutninger: hvis en crawler tilgår dit indhold men aldrig citerer det i AI-svar, bliver blokering en klar forretningsbeslutning. AmICited muliggør også konkurrencebenchmarking, hvor du kan se, hvordan din indholdssynlighed i AI-systemer sammenlignes med konkurrenters, så du kan vurdere, om dine adgangspolitikker er for restriktive eller for tilladende. Platformens realtidsalarmer giver besked, når nye AI-systemer begynder at referere til dit indhold, hvilket muliggør hurtige tilpasninger af politikker. Ved at kombinere AmICiteds overvågningsmuligheder med Cloudflares håndhævelsesværktøjer får udgivere fuldt overblik og kontrol: de kan se, hvilke crawlere der tilgår deres indhold, måle forretningseffekten og justere politikker derefter. Denne datadrevne tilgang gør crawler management til en strategisk forretningsfunktion frem for blot en teknisk afkrydsning.

Landskabet for differentiel crawler-adgang udvikler sig hurtigt, med nye standarder og forretningsmodeller, der ændrer, hvordan udgivere og AI-virksomheder interagerer omkring indhold. IETF AI-præferenceforslaget repræsenterer en væsentlig udvikling og etablerer standardiserede måder for websites at kommunikere deres præferencer vedrørende AI-træning, inferens og søgeanvendelse. I stedet for at stole på robots.txt—en 30 år gammel standard designet til søgemaskiner—giver denne nye ramme eksplicit, detaljeret kontrol over, hvordan AI-systemer kan bruge indhold. Samtidig vinder tilladelsesbaserede forretningsmodeller frem, hvor Cloudflares Pay Per Crawl-initiativ baner vejen for en ramme, hvor AI-virksomheder betaler udgivere for adgang til indhold, hvilket forvandler crawlere fra trusler til indtægtskilder. Dette skift fra blokering til licensering markerer et grundlæggende skifte i internettets økonomi: i stedet for at kæmpe om adgang forhandler udgivere og AI-virksomheder om rimelig kompensation. Crawlers autentificerings- og verifikationsstandarder er også i fremgang, hvor kryptografiske verifikationsmetoder gør det muligt for udgivere at bekræfte crawler-identitet og forhindre forfalskede forespørgsler. Fremadrettet kan vi forvente øgede reguleringstiltag omkring AI-træningsdata, der potentielt kræver eksplicit samtykke og kompensation for indholdsbrug. Sammenfaldet af disse tendenser—tekniske standarder, licensmodeller, autentificeringsmekanismer og regulatorisk pres—peger på, at differentiel crawler-adgang vil udvikle sig fra en defensiv strategi til en sofistikeret forretningsfunktion, hvor udgivere aktivt styrer, overvåger og tjener penge på AI-crawler-adgang. Udgivere, der allerede i dag implementerer omfattende overvågning og strategiske politikker, vil stå bedst til at drage fordel af disse nye muligheder.

At blokere alle crawlere fjerner dit indhold helt fra AI-systemer, hvilket eliminerer både risici og muligheder. Differentiel adgang gør det muligt at vurdere hver crawler individuelt, så du kan blokere dem, der ikke giver værdi, mens du tillader dem, der skaber trafik eller repræsenterer licensmuligheder. Denne nuancerede tilgang maksimerer både synlighed og indtjening, samtidig med at intellektuel ejendomsret beskyttes.

Du kan overvåge crawler-aktivitet via serverlogs, Cloudflares analyse-dashboard eller specialiserede overvågningsværktøjer som AmICited.com. AmICited sporer specifikt, hvilke AI-systemer der tilgår dit indhold, og hvordan dit brand vises i AI-genererede svar, hvilket giver forretningsniveau-indblik ud over tekniske logs.

Nej. Blokering af AI-træningscrawlere som GPTBot, ClaudeBot og CCBot påvirker ikke din Google- eller Bing-søgerangering. Traditionelle søgemaskiner bruger andre crawlere (Googlebot, Bingbot), som fungerer uafhængigt. Blokér kun disse, hvis du ønsker at forsvinde helt fra søgeresultater.

Ja, dette er den mest strategiske tilgang for mange udgivere. Du kan tillade søgeorienterede crawlere som OAI-SearchBot og PerplexityBot (som skaber trafik), mens du blokerer træningscrawlere som GPTBot og ClaudeBot (som typisk ikke gør). Dette bevarer synlighed i AI-søgeresultater, mens indholdet beskyttes mod at blive brugt i træningsdatasæt.

Mens store crawlere fra OpenAI, Anthropic og Google respekterer robots.txt, ignorerer nogle bots det bevidst. Hvis en crawler ikke respekterer din robots.txt, har du brug for yderligere håndhævelsesmetoder som WAF-regler, IP-blokering eller Cloudflares bot management-funktioner. Dette er grunden til, at overvågningsværktøjer som AmICited er essentielle—de viser dig, hvilke crawlere der faktisk respekterer dine politikker.

Gennemgå dine politikker mindst kvartalsvis, da AI-virksomheder regelmæssigt introducerer nye crawlere. Anthropic fusionerede deres 'anthropic-ai' og 'Claude-Web' bots til 'ClaudeBot', hvilket gav den nye bot midlertidig ubegrænset adgang til sites, der ikke havde opdateret deres regler. Regelmæssig overvågning med værktøjer som AmICited hjælper dig med at være på forkant med ændringer.

Googlebot er Googles søge-crawler, der indekserer indhold til søgeresultater. Google-Extended er et kontroltoken, der specifikt styrer, om dit indhold bruges til Gemini AI-træning. Du kan blokere Google-Extended uden at påvirke søgerangeringer, men bemærk, at Google AI Overviews (der vises i søgeresultater) bruger standard Googlebot-regler, så du kan ikke fravælge AI Overviews uden at opgive søgesynlighed.

Ja, nye licensmodeller som Cloudflares Pay Per Crawl gør det muligt for udgivere at opkræve AI-virksomheder for adgang til indhold. Dette forvandler crawlere fra trusler til indtægtskilder. Det kræver dog forhandling med AI-virksomheder og kan involvere juridiske aftaler. AmICiteds overvågning hjælper dig med at identificere, hvilke crawlere der repræsenterer de mest værdifulde licensmuligheder.

Følg hvilke AI-systemer, der tilgår dit indhold, og hvordan dit brand fremstår i AI-genererede svar. Få indblik i realtid i crawler-adfærd og mål forretningseffekten af dine differentielle adgangspolitikker.

Lær at træffe strategiske beslutninger om blokering af AI-crawlere. Vurder indholdstype, trafikkilder, indtægtsmodeller og konkurrenceposition med vores omfatte...

Lær hvordan webapplikationsfirewalls giver avanceret kontrol over AI-crawlere ud over robots.txt. Implementer WAF-regler for at beskytte dit indhold mod uautori...

Lær hvordan du bruger robots.txt til at kontrollere, hvilke AI-bots der får adgang til dit indhold. Komplet guide til blokering af GPTBot, ClaudeBot og andre AI...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.