AI Content Syndication

Lær hvordan AI-indholdsyndikering bruger maskinlæring til at distribuere indhold på tværs af platforme optimeret til AI-opdagelse, forbedrer synlighed i ChatGPT...

Edge AI-behandling refererer til implementeringen af kunstig intelligens-algoritmer direkte på lokale enheder eller edge-servere, hvilket muliggør realtidsdatabehandling og analyse uden konstant afhængighed af cloud-infrastruktur. Denne tilgang reducerer latenstid, forbedrer dataprivatliv og muliggør øjeblikkelig beslutningstagning for applikationer som brandovervågning, IoT-enheder og autonome systemer.

Edge AI-behandling refererer til implementeringen af kunstig intelligens-algoritmer direkte på lokale enheder eller edge-servere, hvilket muliggør realtidsdatabehandling og analyse uden konstant afhængighed af cloud-infrastruktur. Denne tilgang reducerer latenstid, forbedrer dataprivatliv og muliggør øjeblikkelig beslutningstagning for applikationer som brandovervågning, IoT-enheder og autonome systemer.

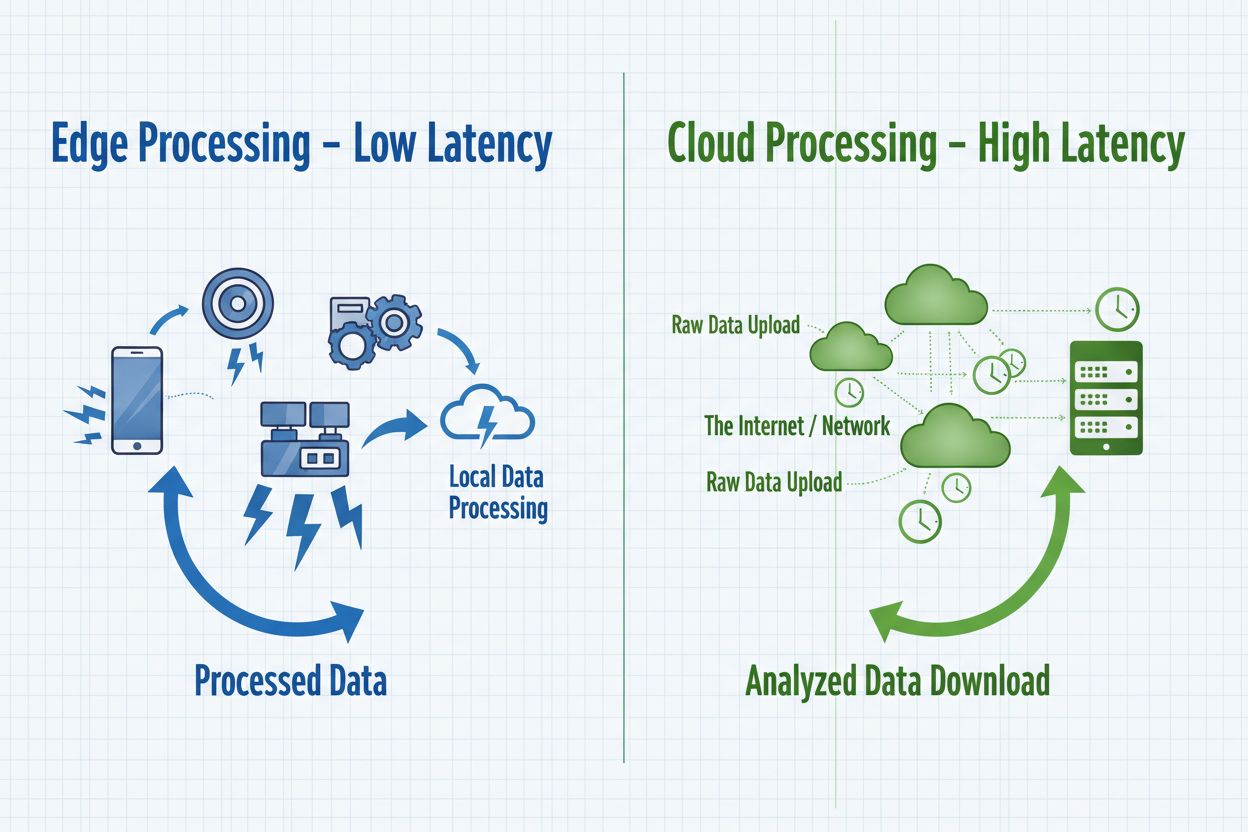

Edge AI-behandling repræsenterer et paradigmeskifte i implementering af kunstig intelligens, hvor beregningsopgaver udføres direkte på edge-enheder—såsom smartphones, IoT-sensorer, kameraer og indlejrede systemer—i stedet for udelukkende at være afhængige af centraliserede cloud-servere. Denne tilgang behandler data ved kilden, hvilket muliggør øjeblikkelig analyse og beslutningstagning uden at sende rå information til fjerntliggende datacentre. I modsætning til traditionel cloud AI, hvor data sendes til eksterne servere for behandling og resultater returneres efter netværksforsinkelse, bringer edge AI intelligensen ud til netværkets periferi, hvor dataene opstår. Behandlingen foregår på lokalt hardware med indlejrede maskinlæringsmodeller, så enheder kan fungere autonomt og træffe realtidsbeslutninger. Edge AI kombinerer letvægtsneurale netværk, optimerede algoritmer og specialiserede hardware-acceleratorer for at levere AI-kapaciteter inden for stramme ressourcebegrænsninger. Denne distribuerede intelligensmodel ændrer fundamentalt, hvordan organisationer håndterer dataprivatliv, systemresponsivitet og infrastrukturudgifter. Ved at behandle følsomme oplysninger lokalt eliminerer edge AI behovet for at sende potentielt fortrolige data over netværk, hvilket imødekommer stigende privatlivsbekymringer i regulerede brancher.

Edge AI og cloud AI repræsenterer komplementære tilgange til implementering af kunstig intelligens, hver med særskilte fordele egnet til forskellige brugsscenarier og organisatoriske behov. Cloud AI er fremragende til at håndtere enorme datamængder, træne komplekse modeller og udføre beregningstunge opgaver, der drager fordel af centraliseret computerkraft og ubegrænset skalerbarhed. Cloud-løsninger introducerer dog uundgåelig latenstid, da data skal transporteres over netværk, hvilket gør dem uegnede til applikationer, der kræver øjeblikkelige svar. Edge AI prioriterer hastighed og responsivitet ved at behandle information lokalt, hvilket muliggør beslutningstagning på under et millisekund—kritisk for autonome systemer og realtidsmonitoreringsapplikationer. Valget mellem disse tilgange afhænger af specifikke krav: cloud AI passer til batchbehandling, modeltræning og applikationer, hvor små forsinkelser er acceptable, mens edge AI er til realtidsapplikationer, privatlivsfølsomme operationer og scenarier med upålidelig netværksforbindelse. Organisationer anvender i stigende grad hybridarkitekturer, der udnytter begge paradigmer—hvor edge-enheder står for øjeblikkelig behandling, og cloud-infrastruktur bruges til modeltræning, analyse og langtidslagring. Forståelsen af disse grundlæggende forskelle hjælper organisationer med at designe løsninger, der balancerer ydeevne, sikkerhed og driftseffektivitet.

| Aspekt | Edge AI | Cloud AI |

|---|---|---|

| Latenstid | Svartider under ét millisekund; øjeblikkelig lokal behandling | 50-500 ms+ pga. netværkstransmission og serverbehandling |

| Båndbredde | Minimal datatransmission; behandles lokalt | Høje båndbreddekrav; transmitterer rå data kontinuerligt |

| Sikkerhed & Privatliv | Data forbliver lokalt; reduceret risiko for brud | Data rejser via netværk; central lagring giver enkelt fejlpunkt |

| Beregningsevne | Begrænset af enhedens hardware; optimerede letvægtsmodeller | Ubegrænset skalerbarhed; håndterer komplekse modeller og store datamængder |

| Skalerbarhed | Skalerer horisontalt på tværs af distribuerede enheder | Skalerer vertikalt med serverinfrastruktur; centraliseret styring |

Edge AI-systemer består af fire essentielle tekniske komponenter, der arbejder sammen for at levere intelligent behandling ved netværkskanten. Inferensmotoren udfører fortrænede maskinlæringsmodeller på edge-enheder og leverer forudsigelser og klassifikationer uden behov for cloud-forbindelse. Disse motorer bruger optimerede frameworks som TensorFlow Lite, ONNX Runtime og PyTorch Mobile, der komprimerer modeller, så de kan være i enhedens hukommelse og samtidig opretholde acceptabel nøjagtighed. Hardware-acceleratorerne—herunder GPU’er, TPU’er og specialiserede AI-chips—giver den nødvendige beregningskraft til at køre neurale netværk effektivt på ressourcebegrænsede enheder. Edge-enheder anvender modeloptimeringsteknikker som kvantisering, pruning og knowledge distillation for at reducere modelstørrelse og beregningskrav uden væsentlig forringelse af ydeevnen. Datamanagement-laget håndterer lokal dataindsamling, forbehandling og selektiv transmission af relevante indsigter til cloud-systemer for aggregering og langtidsanalyse. Endelig styrer forbindelsesmodulet ustabile netværksforbindelser, så enheder kan fungere offline og synkronisere data, når forbindelsen genoprettes.

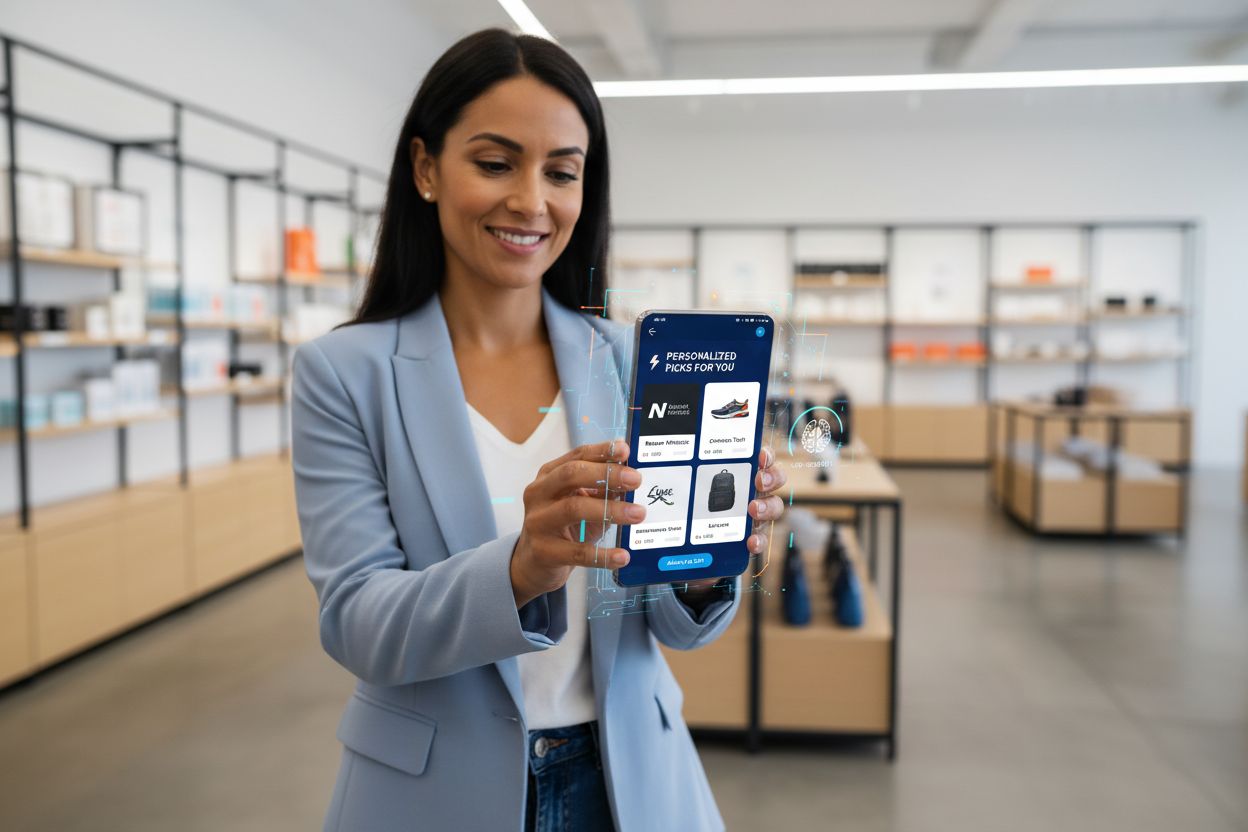

Edge AI-behandling muliggør hidtil usete muligheder for realtids brandanbefalinger og overvågning af AI-udgange, hvilket direkte understøtter organisationers behov for at spore og verificere AI-beslutninger ved selve udførelsespunktet. Detailapplikationer udnytter edge AI til at levere personlige produktanbefalinger øjeblikkeligt, mens kunder handler, idet adfærdsmønstre analyseres lokalt uden at sende følsomme indkøbsdata til eksterne servere. Realtidsovervågning af AI-udgange bliver mulig, når inferens foregår på edge-enheder, så organisationer straks kan opdage afvigelser, forudindtagede forudsigelser eller modeldrift, før anbefalinger når kunderne. Denne lokale behandling skaber revisionsspor og beslutningslogfiler, der understøtter overholdelseskrav og gør det muligt for brands at forstå præcis, hvorfor bestemte anbefalinger blev genereret. Edge AI-overvågningssystemer kan markere mistænkelige mønstre—såsom anbefalinger, der uforholdsmæssigt favoriserer visse produkter eller demografi—hvilket muliggør hurtig indgriben og modeljustering. For brandsikkerhed og omdømmestyring sikrer AI-overvågning på edge, at automatiserede systemer opererer inden for definerede parametre og stemmer overens med brandværdier, inden de tages i brug over for kunder. Evnen til at overvåge AI-udgange i realtid på kanten ændrer måden, organisationer opretholder kvalitetskontrol over algoritmisk beslutningstagning på, understøtter gennemsigtighedsinitiativer og styrker kundetillid gennem verificerbar AI-styring.

Edge AI-behandling giver betydelige fordele på flere områder, der adresserer centrale organisatoriske udfordringer i nutidens digitale miljøer. Reduceret latenstid er den primære fordel og muliggør applikationer, der kræver øjeblikkelige svar—autonome køretøjer, der træffer navigationsbeslutninger på splitsekunder, industrielle robotter, der reagerer på sikkerhedstrusler, eller medicinsk udstyr, der opdager kritiske tilstande hos patienter. Forbedret privatliv er en sekundær fordel, da følsomme data forbliver på lokale enheder i stedet for at blive sendt over netværk eller gemt i centraliseret cloud, hvilket imødekommer GDPR-, HIPAA- og andre regulatoriske krav. Båndbreddeoptimering reducerer netværksoverbelastning og tilhørende omkostninger ved at behandle data lokalt og kun transmittere relevante indsigter frem for rå datastrømme. Offlinefunktionalitet gør det muligt for edge-enheder at fortsætte drift og træffe intelligente beslutninger, selv når netværksforbindelsen svigter—afgørende for fjerntliggende områder og kritiske applikationer. Forbedret pålidelighed opnås gennem distribueret behandling—systemfejl på enkelte edge-enheder påvirker ikke hele infrastrukturen, og lokal behandling fortsætter uanset cloud-tjenestens tilgængelighed. Omkostningseffektivitet opnås ved reducerede cloud-udgifter, da organisationer behandler data lokalt i stedet for at betale for løbende cloud-infrastruktur og datatransmission. Skalerbarhed adskiller sig fra cloud-systemer; edge AI skalerer horisontalt på tværs af distribuerede enheder uden behov for centraliseret infrastrukturudvidelse, hvilket gør det ideelt til IoT-udrulninger med tusindvis af enheder.

Edge AI-behandling revolutionerer driften på tværs af forskellige brancher ved at muliggøre intelligente beslutninger der, hvor data opstår. Produktionsfaciliteter bruger edge AI til prædiktivt vedligehold, hvor udstyrsvibrationer og termiske mønstre analyseres lokalt for at forudsige fejl, før de opstår, hvilket reducerer nedetid og vedligeholdelsesomkostninger. Sundhedsudbydere anvender edge AI i medicinske billedbehandlingsenheder, der udfører foreløbige analyser lokalt, hvilket muliggør hurtigere diagnose og beskytter patientprivatliv ved at holde følsomme sundhedsdata på stedet. Detailmiljøer implementerer edge AI til lagerstyring, kundeanalysemønstre og personlige anbefalinger leveret øjeblikkeligt uden cloud-latenstid. Autonome køretøjer er fuldstændig afhængige af edge AI, idet sensordata fra kameraer, lidar og radar behandles lokalt for at træffe realtidsbeslutninger om navigation og sikkerhed på få millisekunder. Smart home-systemer udnytter edge AI til at genkende stemmekommandoer, opdage sikkerhedstrusler og automatisere rutiner uden at sende lyd eller video til cloud-servere. Sikkerheds- og overvågningsapplikationer bruger edge AI til at opdage afvigelser, identificere trusler og udløse alarmer lokalt, hvilket reducerer falske positiver gennem intelligent filtrering, før alarmer sendes til overvågningscentraler. Landbrugsdrift anvender edge AI på IoT-sensorer til at overvåge jordforhold, vejr og afgrødesundhed, så beslutninger om vanding og gødning tages lokalt, mens datatransmissionsomkostninger minimeres i områder med begrænset forbindelse.

På trods af betydelige fordele står Edge AI-behandling over for væsentlige tekniske og operationelle udfordringer, som organisationer skal adressere under implementeringen. Strømforbrug er en vigtig begrænsning, fordi kørsel af neurale netværk på batteridrevne enheder hurtigt dræner energi, hvilket begrænser driftsvarigheden og kræver omhyggelig modeloptimering for at balancere nøjagtighed og effektivitet. Begrænsninger i beregningsevne begrænser kompleksiteten af de modeller, der kan implementeres på edge-enheder; organisationer må vælge mellem forenklede modeller med lavere nøjagtighed eller acceptere længere inferenstider på ressourcebegrænsede hardware. Modelstyringens kompleksitet stiger betydeligt i distribuerede miljøer, da opdatering af modeller på tusindvis af edge-enheder kræver robust versionsstyring, rollback-muligheder og mekanismer til at sikre konsistens på tværs af flåden. Dataheterogenitet udgør udfordringer, når edge-enheder arbejder i forskellige miljøer med varierende datakarakteristika, hvilket kan føre til, at modeller trænet på centraliserede datasæt præsterer dårligt på lokale datasæt. Fejlfinding og monitorering er vanskeligt på grund af systemernes distribuerede karakter, hvilket gør det udfordrende at diagnosticere fejl, forstå modeladfærd og indsamle omfattende ydeevnemetrikker på tværs af geografisk spredte enheder. Sikkerhedssårbarheder på edge-enheder skaber angrebsflader, da kompromitterede enheder kan køre ondsindet kode eller manipulere lokale modeller, hvilket kræver robuste sikkerhedsforanstaltninger og regelmæssige opdateringer. Integrationskompleksitet med eksisterende cloud-infrastruktur kræver omhyggelig arkitekturplanlægning for at sikre, at edge-systemer effektivt kommunikerer med centraliseret analyse og modeltræningspipelines.

Krydset mellem Edge AI-behandling og AI-overvågning skaber stærke muligheder for organisationer, der ønsker at opretholde indsigt i algoritmisk beslutningstagning i stor skala. Traditionelle AI-overvågningsmetoder har svært ved cloud-baserede systemer, hvor latenstid og datatransmissionsomkostninger begrænser realtidsindsigt i modeludgange; edge AI-overvågning løser dette ved at muliggøre lokal analyse af forudsigelser, før de påvirker kunderne. Verifikationssystemer for output implementeret på edge-enheder kan straks validere forudsigelser mod forretningsregler, opdage afvigelser og markere beslutninger, der kræver menneskelig gennemgang, før de eksekveres. Denne lokale overvågningsmetode understøtter brandsikkerhedsinitiativer ved at sikre, at AI-genererede anbefalinger, indholdsbeslutninger og kundeinteraktioner stemmer overens med organisationens værdier og overholdelseskrav. Edge-baserede overvågningssystemer genererer detaljerede revisionsspor, der dokumenterer, hvorfor bestemte beslutninger blev truffet, hvilket understøtter gennemsigtighedskrav og gør det muligt at analysere algoritmeadfærd efterfølgende. Bias-detekteringsmekanismer på kanten kan identificere, når modeller producerer uforholdsmæssige resultater på tværs af demografiske grupper, hvilket muliggør hurtig indgriben, før forudindtagede anbefalinger når kunderne. Kombinationen af edge AI og overvågning skaber et feedback-loop, hvor lokale beslutningslogs informerer modelgenoptræning, så systemer løbende forbedres, mens deres adfærd overvåges. Organisationer, der implementerer edge AI-overvågning, får hidtil uset indsigt i algoritmisk beslutningstagning og omdanner AI fra en black box til et gennemsigtigt, reviderbart system, der understøtter både ydeevneoptimering og ansvarlig AI-styring.

Edge AI-behandling står i spidsen for teknologisk udvikling, med nye tendenser, der omformer måden, organisationer implementerer og håndterer distribueret intelligens på. Fødereret læring udgør en transformerende tilgang, hvor edge-enheder træner modeller i fællesskab uden at transmittere rå data til centraliserede servere, hvilket muliggør privatlivsbevarende maskinlæring i stor skala. 5G-netværksudrulning vil markant accelerere edge AI-adoption ved at levere pålidelig, lav-latenstid-forbindelse, der muliggør sømløs synkronisering mellem edge-enheder og cloud-infrastruktur, samtidig med at lokale behandlingsfordele bevares. Udvikling af specialiseret hardware fortsætter, hvor producenter skaber stadig mere effektive AI-chips optimeret til specifikke edge-applikationer, hvilket forbedrer ydeevne pr. watt—afgørende for batteridrevne enheder. Markedsfremskrivninger peger på eksplosiv vækst, hvor det globale edge AI-marked forventes at nå 15,7 mia. USD i 2030, med en årlig vækstrate på 38,3% fra 2023 til 2030. TinyML (maskinlæring på mikrocontrollere) opstår som en vigtig trend og muliggør AI på enheder med minimal hukommelse og processorkraft, hvilket udvider edge AI-anvendelser til hidtil umulige områder. Containerisering og orkestreringsteknologier som Kubernetes tilpasses edge-miljøer, så organisationer kan styre distribuerede edge-udrulninger med samme værktøjer og processer som til cloud-infrastruktur. Sammenløbet af disse tendenser peger på en fremtid, hvor intelligent behandling foregår sømløst på tværs af distribuerede netværk, hvor edge-enheder håndterer realtidsbeslutninger, mens cloud-systemer står for træning, aggregering og langtidsanalyse.

Succesfuld implementering af Edge AI-behandling kræver omhyggelig planlægning på flere områder for at sikre, at systemerne leverer forventet ydeevne og forretningsværdi. Modelvalg er det første kritiske skridt, hvor organisationer skal evaluere tilgængelige fortrænede modeller, vurdere deres nøjagtighed til de ønskede brugsscenarier og afgøre, om udvikling af egne modeller er nødvendig. Optimeringsstrategier skal balancere modelnøjagtighed mod enhedens begrænsninger ved at anvende kvantisering, pruning og arkitektursøgning for at skabe modeller, der passer til hardwarebegrænsninger uden at gå væsentligt på kompromis med ydeevnen. Hardwarevalg afhænger af de specifikke applikationskrav, beregningsbehov og strømforbrug; organisationer skal vurdere alt fra generelle processorer til specialiserede AI-acceleratorer. Udrulningsmekanismer kræver robuste processer til distribution af modeller til edge-enheder, versionsstyring og mulighed for at rulle tilbage til tidligere versioner ved problemer. Monitorerings- og observationssystemer skal spore modelpræstation, opdage datadrift, identificere afvigelser og generere alarmer, når systemer afviger fra forventet adfærd. Sikkerhedshærdning beskytter edge-enheder mod uautoriseret adgang, modeltyveri og ondsindet manipulation gennem kryptering, autentificering og regelmæssige sikkerhedsopdateringer. Integrationsplanlægning sikrer, at edge-systemer effektivt kommunikerer med cloud-infrastruktur for modelopdateringer, analyser og langtidslagring, så der skabes sammenhængende hybridarkitekturer, der udnytter begge paradigmer. Organisationer, der implementerer edge AI, bør fastlægge klare succeskriterier, gennemføre pilotprojekter i begrænset omfang før fuld udrulning og bevare fleksibilitet til at justere strategier baseret på præstationer i den virkelige verden.

Edge AI behandler data lokalt på enheder med øjeblikkelige svartider (sub-millisekund-latenstid), mens Cloud AI sender data til eksterne servere for behandling, hvilket medfører netværksforsinkelser. Edge AI prioriterer hastighed og privatliv, mens Cloud AI tilbyder ubegrænset computerkraft til komplekse opgaver.

Edge AI holder følsomme data på lokale enheder i stedet for at transmittere dem over netværk eller lagre dem i centraliserede cloud-servere. Denne tilgang reducerer eksponering for brud, understøtter GDPR- og HIPAA-overholdelse og sikrer, at personlige oplysninger forbliver under organisatorisk kontrol.

Edge AI opnår svartider under ét millisekund ved at behandle data lokalt, sammenlignet med 50-500 ms eller mere for cloud-baserede systemer. Denne markante reduktion af latenstid muliggør realtidsapplikationer som autonome køretøjer, industrielle robotter og medicinsk udstyr, der kræver øjeblikkelig beslutningstagning.

Ja, Edge AI-systemer kan fungere helt offline, da behandlingen foregår lokalt på enhederne. Denne offline-funktionalitet er afgørende for fjerntliggende områder med upålidelig forbindelse og missionkritiske applikationer, hvor netværksfejl ikke må afbryde driften.

Edge AI kører på forskellige enheder, herunder smartphones, IoT-sensorer, industrielt udstyr, overvågningskameraer, smartwatches, autonome køretøjer og indlejrede systemer. Moderne edge-enheder spænder fra mikrocontrollere med minimale ressourcer til kraftfulde single-board-computere med specialiserede AI-acceleratorer.

Edge AI behandler data lokalt og transmitterer kun relevante indsigter i stedet for rå informationsstrømme. Denne selektive transmission reducerer markant båndbreddeforbruget, sænker netværksomkostningerne og forbedrer systemets ydeevne ved at minimere datatransmission over netværk.

Edge AI muliggør realtidsmonitorering af AI-genererede anbefalinger og beslutninger på udførelsesstedet, så organisationer straks kan opdage afvigelser, verificere brandsikkerhed og sikre, at algoritmiske udgange stemmer overens med organisationens værdier, inden de når kunderne.

Nøgleudfordringer omfatter strømforbrug på batteridrevne enheder, computerbegrænsninger der kræver modeloptimering, kompleksiteten ved at styre distribuerede systemer, sikkerhedssårbarheder på edge-enheder og integrationsudfordringer med eksisterende cloud-infrastruktur.

Edge AI-behandling muliggør øjeblikkelig analyse af AI-udgange og brandhenvisninger. AmICited sporer, hvordan dit brand optræder i AI-genereret indhold på tværs af GPT'er, Perplexity og Google AI Overviews med realtidspræcision.

Lær hvordan AI-indholdsyndikering bruger maskinlæring til at distribuere indhold på tværs af platforme optimeret til AI-opdagelse, forbedrer synlighed i ChatGPT...

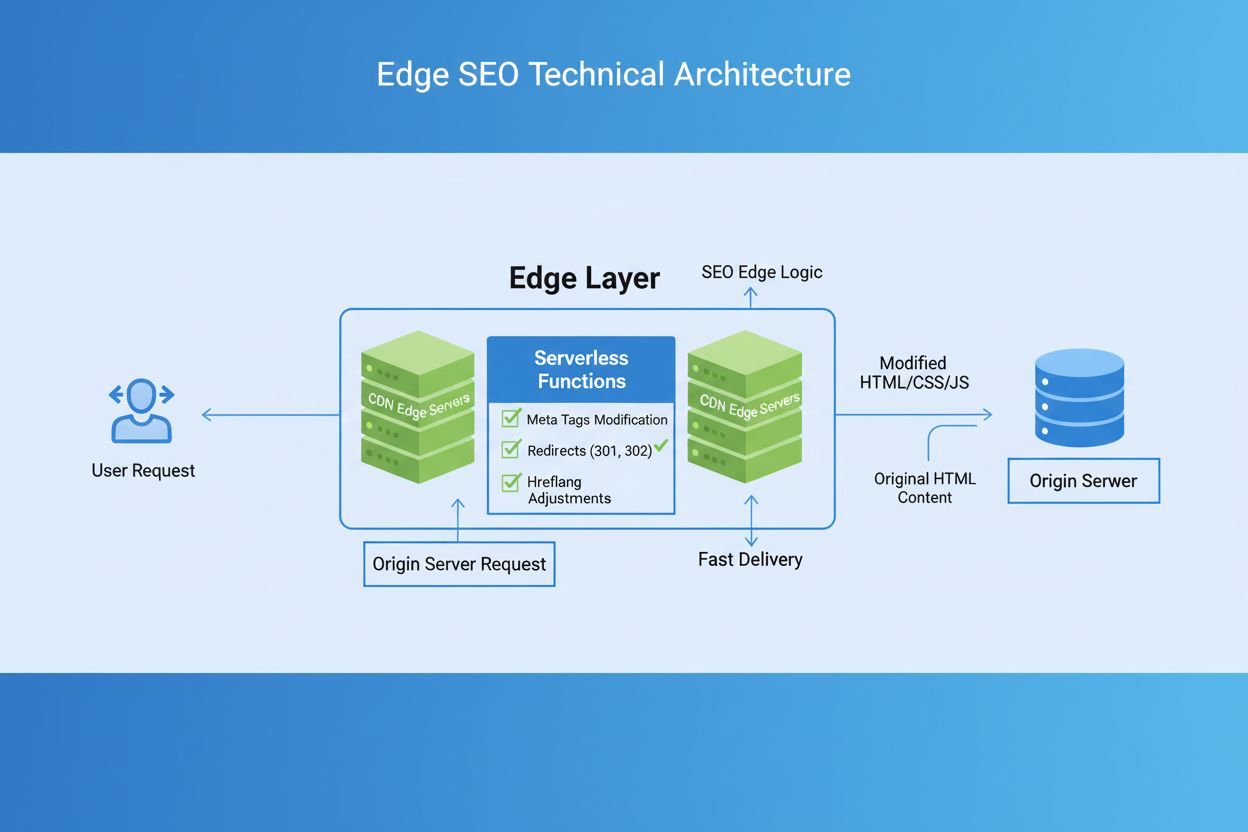

Edge SEO er praksissen med at implementere tekniske SEO-ændringer på netværkets edge ved hjælp af serverløse funktioner på CDNs. Lær, hvordan det forbedrer ydee...

Lær om de essentielle komponenter, frameworks og værktøjer, der kræves for at bygge en moderne AI-søgeteknologisk stack. Opdag retrieval-systemer, vektordatabas...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.