AI-genereret billede

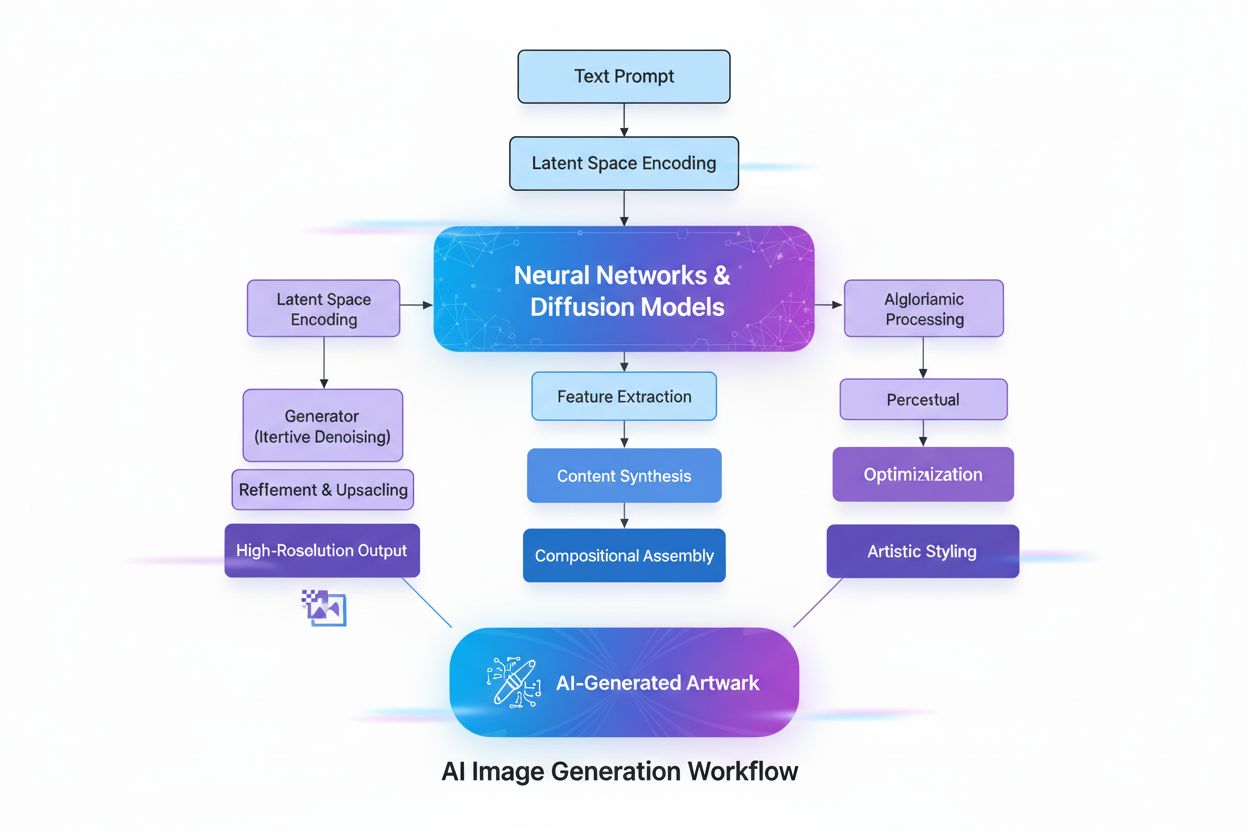

Lær hvad AI-genererede billeder er, hvordan de skabes med diffusionsmodeller og neurale netværk, deres anvendelser i markedsføring og design, samt de etiske ove...

Generativ AI er kunstig intelligens, der skaber nyt, originalt indhold såsom tekst, billeder, videoer, kode og lyd baseret på mønstre, der er lært fra træningsdata. Den bruger dybe læringsmodeller som transformere og diffusionsmodeller til at generere forskellige outputs som svar på brugerens forespørgsler eller anmodninger.

Generativ AI er kunstig intelligens, der skaber nyt, originalt indhold såsom tekst, billeder, videoer, kode og lyd baseret på mønstre, der er lært fra træningsdata. Den bruger dybe læringsmodeller som transformere og diffusionsmodeller til at generere forskellige outputs som svar på brugerens forespørgsler eller anmodninger.

Generativ AI er en kategori af kunstig intelligens, der skaber nyt, originalt indhold baseret på mønstre lært fra træningsdata. I modsætning til traditionelle AI-systemer, der klassificerer eller forudsiger information, producerer generative AI-modeller autonomt nye outputs såsom tekst, billeder, videoer, lyd, kode og andre datatyper som svar på brugerens forespørgsler eller anmodninger. Disse systemer udnytter sofistikerede dybe læringsmodeller og neurale netværk til at identificere komplekse mønstre og relationer i enorme datasæt og bruger derefter denne viden til at generere indhold, der ligner, men er forskelligt fra træningsdataene. Udtrykket “generativ” understreger modellens evne til at generere—at skabe noget nyt i stedet for blot at analysere eller kategorisere eksisterende information. Siden offentliggørelsen af ChatGPT i november 2022 er generativ AI blevet en af de mest transformerende teknologier inden for computing og har fundamentalt ændret måden, organisationer arbejder med indholdsskabelse, problemløsning og beslutningstagning på tværs af stort set alle brancher.

Grundlaget for generativ AI går årtier tilbage, selvom teknologien har udviklet sig dramatisk i de senere år. Tidlige statistiske modeller i det 20. århundrede lagde grundlaget for forståelsen af datadistributioner, men ægte generativ AI opstod med fremskridt inden for dyb læring og neurale netværk i 2010’erne. Introduktionen af Variational Autoencoders (VAEs) i 2013 markerede et betydeligt gennembrud, da modeller kunne generere realistiske variationer af data såsom billeder og tale. I 2014 opstod Generative Adversarial Networks (GANs) og diffusionsmodeller, hvilket yderligere forbedrede kvaliteten og realismen af genereret indhold. Det afgørende øjeblik kom i 2017, da forskere udgav “Attention is All You Need” og introducerede transformer-arkitekturen—et gennembrud, der fundamentalt ændrede, hvordan generative AI-modeller behandler og genererer sekventielle data. Denne innovation muliggjorde udviklingen af store sprogmodeller (LLMs) som OpenAI’s GPT-serie, der demonstrerede hidtil usete evner til at forstå og generere menneskelig sprog. Ifølge McKinsey-undersøgelser brugte en tredjedel af organisationerne allerede generativ AI regelmæssigt i mindst én forretningsfunktion i 2023, og Gartner forudser, at mere end 80% af virksomhederne vil have implementeret generative AI-applikationer eller brugt generative AI-API’er i 2026. Den hurtige udvikling fra forskningsprojekt til forretningsnødvendighed repræsenterer en af de hurtigste teknologiadoptionscyklusser i historien.

Generativ AI opererer gennem en flerfaset proces, der starter med træning på enorme datasæt, efterfulgt af tilpasning til specifikke anvendelser og kontinuerlige cyklusser af generering, evaluering og genjustering. I træningsfasen fodrer praktikere dybe læringsalgoritmer med terabyte af rå, ustrukturerede data—såsom internettekst, billeder eller koderepositorier—og algoritmen udfører millioner af “udfyld det tomme felt”-opgaver, hvor den forudsiger det næste element i en sekvens og justerer sig selv for at minimere forudsigelsesfejl. Denne proces skaber et neuralt netværk af parametre, der koder de mønstre, entiteter og relationer, der opdages i træningsdataene. Resultatet er en fundamentmodel—en stor, fortrænet model, der kan udføre flere opgaver på tværs af forskellige domæner. Fundamentmodeller som GPT-3, GPT-4 og Stable Diffusion fungerer som grundlag for adskillige specialiserede anvendelser. Tilpasningsfasen indebærer finjustering af fundamentmodellen med mærkede data, der er specifikke for en bestemt opgave, eller brug af forstærkningslæring med menneskelig feedback (RLHF), hvor menneskelige evaluatorer vurderer forskellige outputs for at guide modellen mod større nøjagtighed og relevans. Udviklere og brugere vurderer løbende outputs og finjusterer modeller—nogle gange ugentligt—for at forbedre ydeevnen. En anden optimeringsteknik er Retrieval Augmented Generation (RAG), som udvider fundamentmodellen til at få adgang til relevante eksterne kilder, så modellen altid har adgang til opdateret information og sikrer gennemsigtighed omkring dens kilder.

| Modeltype | Træningsmetode | Genereringshastighed | Outputkvalitet | Diversitet | Bedste anvendelser |

|---|---|---|---|---|---|

| Diffusionsmodeller | Iterativ støjfjerning fra tilfældige data | Langsom (flere iterationer) | Meget høj (fotorealistisk) | Høj | Billedgenerering, syntese i høj opløsning |

| Generative Adversarial Networks (GANs) | Konkurrence mellem generator og discriminator | Hurtig | Høj | Lavere | Domænespecifik generering, stiloverførsel |

| Variational Autoencoders (VAEs) | Encoder-decoder med latent rum | Moderat | Moderat | Moderat | Datakomprimering, anomali-detektion |

| Transformer-modeller | Self-attention på sekventielle data | Moderat til hurtig | Meget høj (tekst/kode) | Meget høj | Sprog- og kodegenerering, LLMs |

| Hybride tilgange | Kombination af flere arkitekturer | Variabel | Meget høj | Meget høj | Multimodal generering, komplekse opgaver |

Transformer-arkitekturen er den mest indflydelsesrige teknologi bag moderne generativ AI. Transformere bruger self-attention-mekanismer til at afgøre, hvilke dele af inputdataene der er vigtigst, når hver del behandles, hvilket gør det muligt for modellen at fange langtrækkende afhængigheder og kontekst. Positionel kodning repræsenterer rækkefølgen af inputelementer, så transformere forstår sekvensstrukturen uden sekventiel behandling. Denne parallelle proces fremskynder træningen dramatisk sammenlignet med tidligere rekursive neurale netværk (RNNs). Transformernes encoder-decoder-struktur, kombineret med flere lag af attention-heads, gør det muligt for modellen at overveje forskellige aspekter af dataene samtidigt og raffinere kontekstuelle indlejringer i hvert lag. Disse indlejringer indfanger alt fra grammatik og syntaks til komplekse semantiske betydninger. Store sprogmodeller (LLMs) som ChatGPT, Claude og Gemini er bygget på transformer-arkitekturer og indeholder milliarder af parametre—kodede repræsentationer af lærte mønstre. Skalaen på disse modeller, kombineret med træning på internet-skala data, gør dem i stand til at udføre forskellige opgaver fra oversættelse og opsummering til kreativ skrivning og kodegenerering. Diffusionsmodeller, en anden kritisk arkitektur, fungerer ved først at tilføje støj til træningsdata, indtil det bliver tilfældigt, og derefter træne algoritmen til iterativt at fjerne støjen for at afsløre ønskede outputs. Selvom diffusionsmodeller kræver mere træningstid end VAEs eller GANs, tilbyder de overlegen kontrol over outputkvaliteten, især for værktøjer til billedgenerering i høj kvalitet som DALL-E og Stable Diffusion.

Forretningscasen for generativ AI har vist sig overbevisende, idet virksomheder oplever målbare produktivitetsgevinster og omkostningsreduktioner. Ifølge OpenAI’s enterprise AI-rapport fra 2025 rapporterer brugere, at de sparer 40–60 minutter om dagen gennem generative AI-applikationer, hvilket giver betydelige produktivitetsforbedringer på tværs af organisationer. Markedet for generativ AI blev vurderet til 16,87 milliarder USD i 2024 og forventes at nå 109,37 milliarder USD i 2030 med en CAGR på 37,6%—en af de hurtigste vækstrater i virksomhedssystemernes historie. Virksomheders forbrug på generativ AI nåede 37 milliarder USD i 2025, op fra 11,5 milliarder USD i 2024, hvilket svarer til en 3,2 gange årlig stigning. Denne acceleration afspejler stigende tillid til ROI, hvor AI-købere konverterer med 47% sammenlignet med SaaS’ traditionelle konverteringsrate på 25%, hvilket indikerer, at generativ AI leverer tilstrækkelig øjeblikkelig værdi til at retfærdiggøre hurtig adoption. Organisationer implementerer generativ AI på tværs af flere funktioner: kundeserviceteams bruger AI-chatbots til personaliserede svar og førstegangsløsning; marketingafdelinger benytter indholdsgenerering til blogs, e-mails og sociale medier; udviklingsteams anvender kodegenereringsværktøjer til at fremskynde udviklingscyklusser; og forskningsteams bruger generative modeller til at analysere komplekse datasæt og foreslå nye løsninger. Finansielle virksomheder bruger generativ AI til bedrageridetektion og personlig rådgivning, mens sundhedsorganisationer anvender det til lægemiddeludvikling og analyse af medicinske billeder. Teknologiens alsidighed på tværs af brancher viser dens transformative potentiale for forretningsdrift.

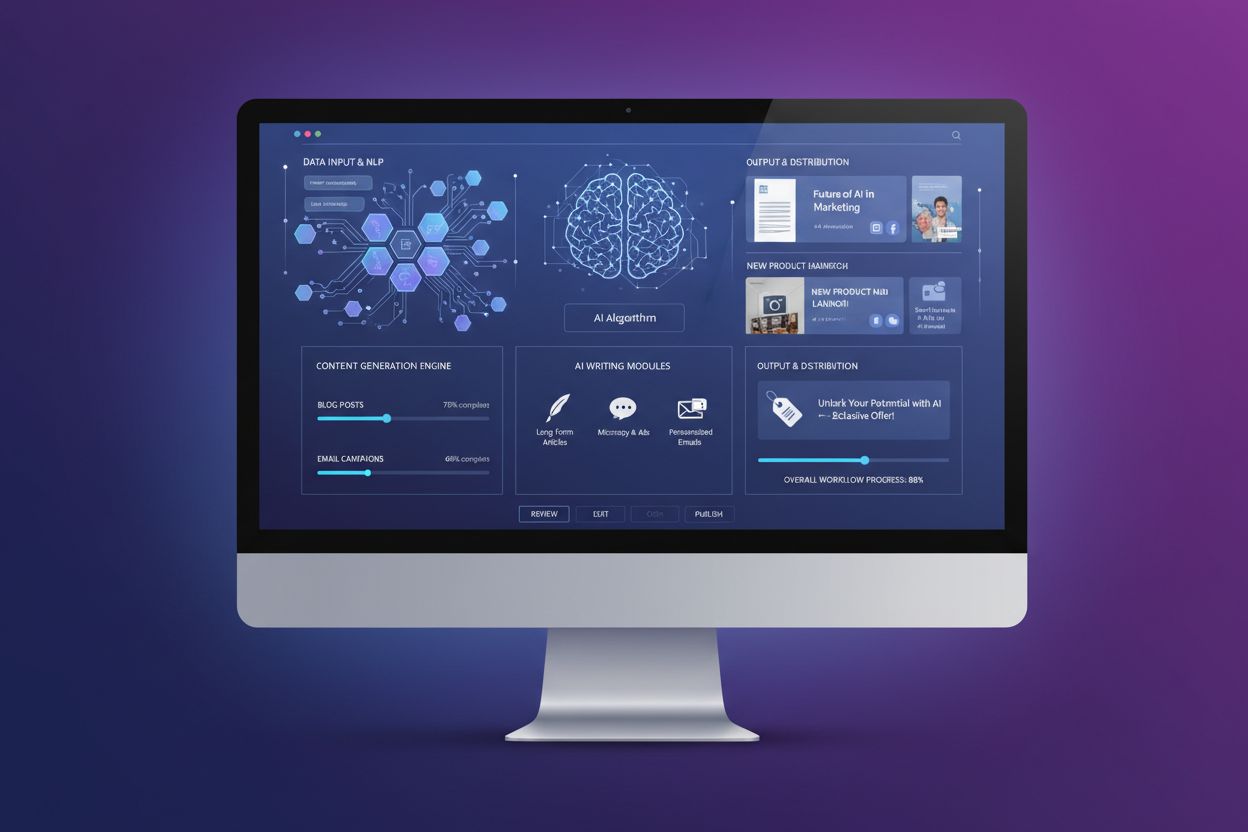

Generativ AI’s anvendelser spænder over stort set alle sektorer og funktioner. Inden for tekstgenerering producerer modeller sammenhængende, kontekstuelt relevant indhold, herunder dokumentation, marketingtekst, blogindlæg, forskningsartikler og kreativ skrivning. De udmærker sig i at automatisere kedelige skriveopgaver som dokumentsummering og metadata-generering, så mennesker kan fokusere på mere værdiskabende, kreativt arbejde. Billedgenereringsværktøjer som DALL-E, Midjourney og Stable Diffusion skaber fotorealistiske billeder, original kunst og udfører stiloverførsel og billedredigering. Videogenerering muliggør animering ud fra tekstinput og hurtigere anvendelse af specialeffekter end traditionelle metoder. Lyd- og musikgenerering syntetiserer naturligt lydende tale til chatbots og digitale assistenter, skaber lydbogsindlæsning og genererer original musik, der efterligner professionelle kompositioner. Kodegenerering giver udviklere mulighed for at skrive original kode, autoudfylde snippets, oversætte mellem programmeringssprog og fejlfinde applikationer. I sundhedssektoren fremskynder generativ AI lægemiddeludvikling ved at generere nye proteinsekvenser og molekylære strukturer med ønskede egenskaber. Syntetisk datagenerering skaber mærkede træningsdata til maskinlæringsmodeller, særligt værdifuldt når ægte data er begrænsede, utilgængelige eller utilstrækkelige for edge-cases. I automotive skaber generativ AI 3D-simuleringer til køretøjsudvikling og genererer syntetiske data til træning af autonome køretøjer. Medie- og underholdningsbranchen bruger generativ AI til at skabe animationer, manuskripter, spilmiljøer og personlige anbefalinger. Energiselskaber anvender generative modeller til netstyring, optimering af driftsikkerhed og prognoser for energiproduktion. Bredden af anvendelser demonstrerer generativ AI’s rolle som en grundlæggende teknologi, der omformer måden, organisationer skaber, analyserer og innoverer på.

På trods af bemærkelsesværdige evner præsenterer generativ AI betydelige udfordringer, som organisationer skal håndtere. AI-hallucinationer—troværdigt lydende men faktuelt forkerte outputs—opstår, fordi generative modeller forudsiger det næste element ud fra mønstre frem for at verificere faktuel korrekthed. En advokat brugte berømt ChatGPT til juridisk research og modtog fuldstændig opdigtede domsreferencer, inklusive citater og kilder. Bias og fairness-udfordringer opstår, når træningsdata indeholder samfundsmæssige skævheder, hvilket kan føre til, at modeller genererer biased, uretfærdigt eller stødende indhold. Inkonsistente outputs skyldes de probabilistiske modeller, hvor identiske input kan give forskellige resultater—problem for applikationer, der kræver konsistens, som kundeservice-chatbots. Manglende forklarbarhed gør det vanskeligt at forstå, hvordan modeller når frem til deres outputs; selv ingeniører har svært ved at forklare beslutningsprocesserne i disse “black box”-modeller. Sikkerheds- og privathedstrusler opstår, når proprietære data bruges til modeltræning, eller når modeller genererer indhold, der afslører eller krænker andres IP-rettigheder. Deepfakes—AI-genererede eller manipulerede billeder, video eller lyd designet til at bedrage—repræsenterer en af de mest bekymrende anvendelser, hvor cyberkriminelle bruger deepfakes i voice-phishing og økonomisk svindel. Computationsomkostninger er fortsat betydelige, da træning af store fundamentmodeller kræver tusindvis af GPU’er og uger med processering til millioner af dollars. Organisationer håndterer disse risici gennem sikkerhedsmekanismer, der begrænser modeller til betroede datakilder, kontinuerlig evaluering og tuning for at reducere hallucinationer, diverse træningsdata for at minimere bias, prompt engineering for at opnå ensartede outputs og sikkerhedsprotokoller til beskyttelse af forretningshemmeligheder. Gennemsigtighed om AI-brug og menneskelig kontrol med kritiske beslutninger er fortsat bedste praksis.

Efterhånden som generative AI-systemer bliver primære informationskilder for millioner af brugere, skal organisationer forstå, hvordan deres brands, produkter og indhold fremstår i AI-genererede svar. AI-synlighedsmonitorering indebærer systematisk at spore, hvordan store generative AI-platforme—herunder ChatGPT, Perplexity, Google AI Overviews og Claude—beskriver brands, produkter og konkurrenter. Denne monitorering er kritisk, fordi AI-systemer ofte citerer kilder og refererer information uden traditionelle søgemaskinesynligheds-målinger. Brands, der ikke fremgår af AI-svar, går glip af synlighed og indflydelse i det AI-drevne søgeresultatlandskab. Værktøjer som AmICited gør det muligt for organisationer at spore brandomtaler, overvåge citatnøjagtighed, identificere hvilke domæner og URL’er der nævnes i AI-svar og forstå, hvordan AI-systemer repræsenterer deres konkurrencepositionering. Disse data hjælper organisationer med at optimere deres indhold til AI-citering, identificere misinformation eller forkerte repræsentationer og opretholde konkurrencemæssig synlighed, efterhånden som AI bliver det primære interface mellem brugere og information. Praksissen GEO (Generative Engine Optimization) fokuserer på at optimere indhold specifikt til AI-citering og synlighed og supplerer traditionelle SEO-strategier. Organisationer, der proaktivt overvåger og optimerer deres AI-synlighed, opnår konkurrencemæssige fordele i det fremvoksende AI-informationsøkosystem.

Generativ AI-landskabet udvikler sig hurtigt, og flere vigtige trends former fremtiden. Multimodale AI-systemer, der sømløst integrerer tekst, billeder, video og lyd, bliver stadig mere avancerede og muliggør mere kompleks og nuanceret indholdsskabelse. Agentisk AI—autonome AI-systemer, der kan udføre opgaver og nå mål uden menneskelig indgriben—repræsenterer næste skridt efter generativ AI, hvor AI-agenter bruger genereret indhold til at interagere med værktøjer og træffe beslutninger. Mindre, mere effektive modeller dukker op som alternativer til massive fundamentmodeller, hvilket gør det muligt for organisationer at implementere generativ AI med lavere beregningsomkostninger og hurtigere svartider. Retrieval Augmented Generation (RAG) udvikler sig fortsat, så modeller kan få adgang til opdateret information og eksterne videnskilder og dermed imødegå hallucinations- og nøjagtighedsproblemer. Reguleringsrammer udvikles globalt, idet regeringer fastsætter retningslinjer for ansvarlig AI-udvikling og -implementering. Virksomhedstilpasning via finjustering og domænespecifikke modeller accelererer, da organisationer ønsker at tilpasse generativ AI til deres unikke forretningskontekster. Etisk AI-praksis bliver en konkurrencefordel, når organisationer prioriterer gennemsigtighed, fairness og ansvarlig implementering. Sammenfaldet af disse trends antyder, at generativ AI vil blive stadig mere integreret i forretningsdriften, mere effektiv og tilgængelig for organisationer af alle størrelser og underlagt stærkere styring og etiske standarder. Organisationer, der investerer i at forstå generativ AI, overvåger deres AI-synlighed og implementerer ansvarlige praksisser, vil være bedst positioneret til at udnytte denne transformerende teknologi og samtidig håndtere de forbundne risici.

Generativ AI skaber nyt indhold ved at lære fordelingen af data og generere nye outputs, mens diskriminativ AI fokuserer på klassificerings- og forudsigelsesopgaver ved at lære beslutningsgrænser mellem kategorier. Generative AI-modeller som GPT-3 og DALL-E producerer kreativt indhold, hvorimod diskriminative modeller egner sig bedre til opgaver som billedgenkendelse eller spamdetektion. Begge tilgange har forskellige anvendelser afhængigt af, om målet er indholdsskabelse eller dataklassificering.

Transformer-modeller bruger self-attention-mekanismer og positionel kodning til at behandle sekventielle data som tekst uden behov for sekventiel behandling. Denne arkitektur gør det muligt for transformere at fange langtrækkende afhængigheder mellem ord og forstå kontekst mere effektivt end tidligere modeller. Transformermodellens evne til at behandle hele sekvenser samtidigt og lære komplekse relationer har gjort den til fundamentet for de fleste moderne generative AI-systemer, herunder ChatGPT og GPT-4.

Fundamentmodeller er dybe læringsmodeller i stor skala, der er fortrænet på enorme mængder uetiketterede data og kan udføre flere opgaver på tværs af forskellige domæner. Eksempler inkluderer GPT-3, GPT-4 og Stable Diffusion. Disse modeller fungerer som base for forskellige generative AI-applikationer og kan finjusteres til specifikke anvendelser, hvilket gør dem meget alsidige og omkostningseffektive sammenlignet med at træne modeller fra bunden.

Efterhånden som generative AI-systemer som ChatGPT, Perplexity og Google AI Overviews bliver primære informationskilder, skal brands følge med i, hvordan de fremstår i AI-genererede svar. Overvågning af AI-synlighed hjælper organisationer med at forstå brandopfattelse, sikre korrekt informationsrepræsentation og opretholde en konkurrencedygtig positionering i det AI-drevne søgeresultatlandskab. Værktøjer som AmICited gør det muligt for brands at spore omtaler og citater på tværs af flere AI-platforme.

Generative AI-systemer kan skabe 'hallucinationer'—troværdigt lydende, men faktuelt forkerte outputs—på grund af deres mønsterbaserede læringsmetode. Disse modeller kan også afspejle bias fra træningsdata, generere inkonsistente outputs for identiske input og mangle gennemsigtighed i deres beslutningsprocesser. Håndtering af disse udfordringer kræver forskellige træningsdata, løbende evaluering og implementering af sikkerhedsforanstaltninger for at begrænse modeller til betroede datakilder.

Diffusionsmodeller genererer indhold ved iterativt at fjerne støj fra tilfældige data, hvilket giver outputs i høj kvalitet, men med langsommere genereringshastigheder. GANs bruger to konkurrerende neurale netværk (generator og discriminator) til hurtigt at producere realistisk indhold, men med lavere diversitet. Diffusionsmodeller foretrækkes i øjeblikket til billedgenerering med høj troværdighed, mens GANs stadig er effektive til domænespecifikke opgaver, der kræver en balance mellem hastighed og kvalitet.

Markedet for generativ AI blev vurderet til 16,87 milliarder USD i 2024 og forventes at nå 109,37 milliarder USD i 2030 med en årlig vækstrate (CAGR) på 37,6% fra 2025 til 2030. Virksomheders forbrug på generativ AI nåede 37 milliarder USD i 2025, hvilket svarer til en 3,2 gange stigning fra 11,5 milliarder USD i 2024, hvilket demonstrerer hurtig udbredelse på tværs af brancher.

Ansvarlig implementering af generativ AI kræver, at man starter med interne anvendelser for at teste resultater i kontrollerede omgivelser, sikrer gennemsigtighed ved tydeligt at kommunikere, når AI bruges, implementerer sikkerhedsmekanismer for at forhindre uautoriseret datatilgang og udfører omfattende test i forskellige scenarier. Organisationer bør også etablere klare governance-rammer, overvåge outputs for bias og nøjagtighed og opretholde menneskelig kontrol med kritiske beslutninger.

Begynd at spore, hvordan AI-chatbots nævner dit brand på tværs af ChatGPT, Perplexity og andre platforme. Få handlingsrettede indsigter til at forbedre din AI-tilstedeværelse.

Lær hvad AI-genererede billeder er, hvordan de skabes med diffusionsmodeller og neurale netværk, deres anvendelser i markedsføring og design, samt de etiske ove...

Fællesskabsdiskussion, der forklarer generative søgemaskiner. Klare forklaringer på, hvordan ChatGPT, Perplexity og andre AI-systemer adskiller sig fra traditio...

Lær hvad AI-indholdsgenerering er, hvordan det fungerer, dets fordele og udfordringer, og bedste praksis for at bruge AI-værktøjer til at skabe marketingindhold...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.