AI-indholdsdetektion

Lær hvad AI-indholdsdetektion er, hvordan detektionsværktøjer fungerer med maskinlæring og NLP, og hvorfor de er vigtige for brandovervågning, uddannelse og ver...

Inferens er den proces, hvor en trænet AI-model genererer output, forudsigelser eller konklusioner ud fra nye inputdata ved at anvende mønstre og viden, der er indlært under træningen. Det repræsenterer den operationelle fase, hvor AI-systemer anvender deres indlærte intelligens på virkelige problemer i produktionsmiljøer.

Inferens er den proces, hvor en trænet AI-model genererer output, forudsigelser eller konklusioner ud fra nye inputdata ved at anvende mønstre og viden, der er indlært under træningen. Det repræsenterer den operationelle fase, hvor AI-systemer anvender deres indlærte intelligens på virkelige problemer i produktionsmiljøer.

Inferens er den proces, hvor en trænet kunstig intelligensmodel genererer output, forudsigelser eller konklusioner ud fra nye inputdata ved at anvende mønstre og viden indlært under træningsfasen. I AI-systemers kontekst repræsenterer inferens den operationelle fase, hvor maskinlæringsmodeller går fra laboratoriet til produktionsmiljøer for at løse virkelige problemer. Når du interagerer med ChatGPT, Perplexity, Google AI Overviews eller Claude, oplever du AI-inferens i aktion—modellen tager dit input og genererer intelligente svar baseret på mønstre, den har lært fra enorme træningsdatasæt. Inferens adskiller sig grundlæggende fra træning; hvor træning lærer modellen, hvad den skal gøre, er det under inferens, at modellen faktisk udfører det, den har lært, på data, den aldrig har set før.

Distinktionen mellem AI-træning og AI-inferens er afgørende for at forstå, hvordan moderne kunstige intelligenssystemer fungerer. Under træningsfasen fodrer data scientists enorme, kuraterede datasæt ind i neurale netværk, så modellen kan lære mønstre, relationer og beslutningsregler gennem iterativ optimering. Denne proces er beregningsmæssigt krævende og kan tage uger eller måneder på specialiseret hardware som GPU’er og TPU’er. Når træningen er færdig, og modellen har fundet optimale vægte og parametre, går modellen ind i inferensfasen. På dette tidspunkt er modellen låst—den lærer ikke længere af nye data—og anvender i stedet sine indlærte mønstre til at generere forudsigelser eller output på hidtil usete input. Ifølge forskning fra IBM og Oracle realiseres den egentlige forretningsværdi af AI under inferens, da det muliggør udrulning af AI-kapaciteter i stor skala på tværs af produktionssystemer. AI-inferensmarkedet blev vurderet til 106,15 milliarder USD i 2025 og forventes at vokse til 254,98 milliarder USD i 2030, hvilket afspejler den eksplosive efterspørgsel på inferenskapaciteter på tværs af brancher.

AI-inferens fungerer gennem en flertrinsproces, der omdanner rå inputdata til intelligente output. Når en bruger sender en forespørgsel til en stor sprogmodel som ChatGPT, starter inferens-pipelinen med inputkodning, hvor tekst omdannes til numeriske tokens, som det neurale netværk kan bearbejde. Modellen går derefter ind i prefill-fasen, hvor alle input-tokens bearbejdes samtidig gennem alle lag af det neurale netværk, så modellen kan forstå kontekst og relationer i brugerens forespørgsel. Denne fase er beregningsmæssigt tung, men nødvendig for forståelse. Efter prefill-fasen går modellen ind i decode-fasen, hvor den genererer output-tokens sekventielt, én ad gangen, hvor hvert nyt token afhænger af alle tidligere tokens i sekvensen. Denne sekventielle generering skaber den karakteristiske streaming-effekt, brugere oplever ved interaktion med AI-chatbots. Til sidst omdanner outputkonverteringsstadiet de forudsagte tokens tilbage til menneskelæsbar tekst, billeder eller andre formater, som brugerne kan forstå og interagere med. Hele denne proces skal foregå på millisekunder for realtidsapplikationer, hvilket gør optimering af inferenslatens til en kritisk faktor for AI-tjenesteudbydere.

Organisationer, der implementerer AI-systemer, skal vælge mellem tre primære inferensarkitekturer, som hver især er optimeret til forskellige brugsscenarier og ydelseskrav. Batch-inferens behandler store datamængder offline på planlagte tidspunkter og er ideel til scenarier, hvor realtidsrespons ikke er påkrævet, såsom generering af daglige analyse-dashboard, ugentlige risikovurderinger eller natlige anbefalingsopdateringer. Denne tilgang er meget effektiv og omkostningseffektiv, da den kan behandle tusindvis af forudsigelser samtidigt og fordele beregningsomkostninger på mange forespørgsler. Online-inferens, også kaldet dynamisk inferens, genererer forudsigelser øjeblikkeligt ved forespørgsel med minimal latenstid og er essentiel til interaktive applikationer som chatbots, søgemaskiner og realtidssystemer til svindelopdagelse. Online-inferens kræver avanceret infrastruktur for at opretholde lav latenstid og høj tilgængelighed og benytter ofte caching-strategier og modeloptimering for at sikre svar på millisekunder. Streaming-inferens behandler kontinuerligt data, der strømmer fra sensorer, IoT-enheder eller realtidsdatapipelines, og genererer forudsigelser for hvert datapunkt, så snart det ankommer. Denne type driver applikationer som prædiktivt vedligehold af industriudstyr, autonome køretøjer, der behandler sensordata i realtid, og smarte bysystemer, der løbende analyserer trafikmønstre. Hver inferenstype stiller forskellige krav til arkitektur, hardware og optimeringsstrategier.

| Aspekt | Batch-inferens | Online-inferens | Streaming-inferens |

|---|---|---|---|

| Krav til latenstid | Sekunder til minutter | Millisekunder | Realtid (under et sekund) |

| Databehandling | Store datasæt offline | Enkeltforespørgsler on-demand | Kontinuerlig datatilførsel |

| Anvendelsestilfælde | Analyse, rapportering, anbefalinger | Chatbots, søgning, svindelopdagelse | IoT-overvågning, autonome systemer |

| Omkostningseffektivitet | Høj (fordelt på mange forudsigelser) | Medium (kræver altid tændt infrastruktur) | Medium til høj (afhænger af datamængde) |

| Skalerbarhed | Fremragende (behandler i bulk) | God (kræver load balancing) | Fremragende (distribueret behandling) |

| Prioritet for modeloptimering | Gennemløb | Balance mellem latenstid og gennemløb | Balance mellem latenstid og nøjagtighed |

| Hardwarekrav | Standard GPU’er/CPU’er | High-performance GPU’er/TPU’er | Specialiseret edge-hardware eller distribuerede systemer |

Inferensoptimering er blevet en kritisk disciplin, efterhånden som organisationer ønsker at implementere AI-modeller mere effektivt og omkostningseffektivt. Kvantisering er en af de mest effektive optimeringsteknikker, der reducerer den numeriske præcision af modelvægtninger fra standard 32-bit flydende tal til 8-bit eller endda 4-bit heltal. Denne reduktion kan mindske modelstørrelsen med 75-90%, mens 95-99% af den oprindelige nøjagtighed bevares, hvilket resulterer i hurtigere inferens og lavere hukommelsesbehov. Modelbeskæring fjerner ikke-kritiske neuroner, forbindelser eller hele lag fra det neurale netværk og eliminerer overflødige parametre, der ikke bidrager væsentligt til forudsigelserne. Forskning viser, at beskæring kan reducere modelkompleksiteten med 50-80% uden betydeligt tab af nøjagtighed. Knowledge distillation træner en mindre, hurtigere “elevmodel” til at efterligne adfærden fra en større, mere nøjagtig “lærermodel”, hvilket muliggør implementering på enheder med begrænsede ressourcer, mens ydeevnen bibeholdes. Batch-behandlingsoptimering grupperer flere inferensforespørgsler for at maksimere udnyttelsen af GPU’er og gennemløb. Nøgle-værdi-caching gemmer mellemliggende beregningsresultater for at undgå overflødige beregninger under decode-fasen i sprogmodel-inferens. Ifølge NVIDIA-forskning kan kombinationen af flere optimeringsteknikker opnå 10x ydeevneforbedringer og reducere infrastrukturudgifter med 60-70%. Disse optimeringer er afgørende for at kunne implementere inferens i stor skala, især for organisationer, der håndterer tusindvis af samtidige inferensforespørgsler.

Hardwareacceleration er grundlæggende for at opnå de latenstids- og gennemløbskrav, moderne AI-inferensarbejdsbyrder kræver. Grafikprocessorer (GPU’er) er fortsat de mest udbredte inferensacceleratorer på grund af deres parallelle arkitektur, som naturligt egner sig til de matrixoperationer, der dominerer neurale netværksberegninger. NVIDIA GPU’er driver størstedelen af stor sprogmodel-inferens globalt, hvor deres specialiserede CUDA-kerner muliggør massiv parallelisering. Tensor Processing Units (TPU’er), udviklet af Google, er kundetilpassede ASIC’er, optimeret specifikt til neurale netværksoperationer og tilbyder bedre performance-per-watt end generiske GPU’er til visse arbejdsbyrder. Field-Programmable Gate Arrays (FPGA’er) giver mulighed for tilpasset hardware, der kan omprogrammeres til specifikke inferensopgaver og tilbyder fleksibilitet til specialiserede applikationer. Application-Specific Integrated Circuits (ASIC’er) som Googles TPU eller Cerebras’ WSE-3 er designet til bestemte inferensarbejdsbyrder og giver exceptionel ydeevne, men med begrænset fleksibilitet. Valget af hardware afhænger af flere faktorer: modelarkitektur, ønsket latenstid, krav til gennemløb, strømforbrug og totalomkostninger. Til edge-inferens på mobile enheder eller IoT-sensorer muliggør specialiserede edge-acceleratorer og neurale processorenheder (NPU’er) effektiv inferens med minimalt strømforbrug. Den globale overgang til AI-fabrikker—højt optimeret infrastruktur designet til at “producere” intelligens i stor skala—har drevet massive investeringer i inferenshardware, og virksomheder implementerer tusindvis af GPU’er og TPU’er i datacentre for at imødekomme den stigende efterspørgsel på AI-tjenester.

Generative AI-systemer som ChatGPT, Claude og Perplexity er fuldstændig afhængige af inferens for at generere menneskelignende tekst, kode, billeder og andet indhold. Når du sender en prompt til disse systemer, starter inferensprocessen med at tokenisere dit input til numeriske repræsentationer, som det neurale netværk kan bearbejde. Modellen udfører derefter prefill-fasen, hvor alle dine input-tokens behandles samtidig for at opbygge en omfattende forståelse af din forespørgsel, inklusive kontekst, hensigt og nuancer. Herefter går modellen ind i decode-fasen, hvor den genererer output-tokens sekventielt og forudsiger det mest sandsynlige næste token baseret på alle tidligere tokens og de mønstre, der er lært fra træningsdata. Denne token-for-token-generation er grunden til, at du ser tekst strømme frem i realtid, når du bruger disse tjenester. Inferensprocessen skal balancere flere konkurrerende mål: at generere nøjagtige, sammenhængende og kontekstuelle svar, samtidig med at latenstiden holdes lav for at fastholde brugeren. Speculativ dekodning, en avanceret inferensoptimeringsteknik, lader en mindre model forudsige flere fremtidige tokens, mens en større model validerer disse forudsigelser, hvilket markant reducerer latenstiden. Skalaen for inferens i store sprogmodeller er enorm—OpenAI’s ChatGPT håndterer millioner af inferensforespørgsler dagligt, hver med hundredvis eller tusindvis af tokens, hvilket kræver massiv beregningsinfrastruktur og avanceret optimering for at være økonomisk bæredygtig.

For organisationer, der er optaget af deres brands tilstedeværelse og indholdscitering i AI-genererede svar, er inferensovervågning blevet stadig vigtigere. Når AI-systemer som Perplexity, Google AI Overviews eller Claude genererer svar, udfører de inferens på deres trænede modeller for at producere output, der kan referere til eller citere dit domæne, brand eller indhold. Forståelse af, hvordan inferenssystemer fungerer, hjælper organisationer med at optimere deres indholdsstrategi for at sikre korrekt repræsentation i AI-genererede svar. AmICited er specialiseret i at overvåge, hvor brands og domæner optræder i AI-inferensoutput på tværs af flere platforme, hvilket giver indsigt i, hvordan AI-systemer citerer og refererer til dit indhold. Denne overvågning er afgørende, fordi inferenssystemer kan generere svar, der inkluderer eller udelader dit brand baseret på træningsdatas kvalitet, relevanssignaler og modeloptimeringsvalg. Organisationer kan bruge inferensovervågningsdata til at forstå, hvilket indhold der bliver citeret, hvor ofte deres brand optræder i AI-svar, og om deres domæne bliver korrekt tilskrevet. Denne indsigt muliggør databaserede beslutninger om indholdsoptimering, SEO-strategi og brandpositionering i det nye AI-drevne søgelandskab. Efterhånden som inferens bliver den primære grænseflade for informationssøgning, er overvågning af din tilstedeværelse i AI-genereret output lige så vigtig som traditionel søgemaskineoptimering.

Implementering af inferenssystemer i stor skala medfører adskillige tekniske, operationelle og strategiske udfordringer, som organisationer skal forholde sig til. Håndtering af latenstid forbliver en vedvarende udfordring, da brugere forventer svartider på under et sekund fra interaktive AI-applikationer, selvom komplekse modeller med milliarder af parametre kræver betydelig beregningstid. Optimering af gennemløb er lige så vigtigt—organisationer skal kunne håndtere tusindvis eller millioner af samtidige inferensforespørgsler, mens der opretholdes acceptabel latenstid og nøjagtighed. Modeldrift opstår, når inferensydelsen forværres over tid, fordi virkelige datadistributioner ændrer sig i forhold til træningsdata, hvilket kræver løbende overvågning og periodisk gen-træning. Fortolkelighed og forklarbarhed bliver stadigt vigtigere, efterhånden som AI-inferenssystemer træffer beslutninger, der påvirker brugere, hvilket kræver, at organisationer kan forstå og forklare, hvordan modeller når frem til specifikke forudsigelser. Reguleringsoverholdelse medfører flere udfordringer, da regler som EU’s AI Act stiller krav til transparens, bias-detektion og menneskelig overvågning i AI-inferenssystemer. Datakvalitet er fundamentalt—inferenssystemer kan kun være så gode som de data, de er trænet på, og dårlige træningsdata fører til biased, unøjagtige eller skadelige inferensoutput. Infrastrukturudgifter kan være betydelige, da storskala inferens kræver betydelige investeringer i GPU’er, TPU’er, netværk og køleinfrastruktur. Mangel på talent betyder, at organisationer har svært ved at finde ingeniører og data scientists med ekspertise i inferensoptimering, modeludrulning og MLOps, hvilket øger ansættelsesomkostninger og forlænger implementeringstid.

Fremtiden for AI-inferens udvikler sig hurtigt i flere transformative retninger, der vil forandre, hvordan organisationer implementerer og udnytter AI-systemer. Edge-inferens—at køre inferens på lokale enheder frem for cloud-datacentre—accelererer, drevet af fremskridt inden for modelkomprimering, specialiseret edge-hardware og bekymringer om privatliv. Dette skift muliggør realtids-AI på smartphones, IoT-enheder og autonome systemer uden afhængighed af cloud-forbindelse. Multimodal inferens, hvor modeller bearbejder og genererer tekst, billeder, lyd og video samtidigt, bliver mere udbredt og kræver nye optimeringsstrategier og hardwareovervejelser. Reasoning-modeller, der udfører multi-step inferens for at løse komplekse problemer, er på vej, og systemer som OpenAI’s o1 viser, at selve inferens kan skaleres med mere beregningstid og flere tokens, ikke kun modelstørrelse. Disaggregated serving-arkitekturer vinder indpas, hvor adskilte hardwareklynger håndterer prefill- og decode-faserne af inferens, hvilket optimerer ressourceudnyttelsen til forskellige beregningsmønstre. Speculativ dekodning og andre avancerede inferensteknikker bliver standardpraksis og muliggør 2-3x latenstreduktion. Inferens på kanten kombineret med federated learning vil gøre det muligt for organisationer at implementere AI lokalt og samtidig bevare privatliv og reducere båndbreddebehov. AI-inferensmarkedet forventes at vokse med en årlig vækstrate på 19,2% frem til 2030, drevet af øget virksomhedsadoption, nye anvendelser og det økonomiske behov for at optimere inferensomkostninger. Efterhånden som inferens bliver den dominerende arbejdsbyrde i AI-infrastruktur, vil optimeringsteknikker, specialiseret hardware og inferensspecifikke software-rammer blive stadig mere avancerede og afgørende for konkurrenceevnen.

AI-træning er processen, hvor en model lærer at genkende mønstre ved hjælp af store datasæt, mens AI-inferens er, når den trænede model anvender det, den har lært, til at generere forudsigelser eller output på nye data. Træning er beregningsmæssigt krævende og sker én gang, hvorimod inferens typisk er hurtigere, mindre ressourcekrævende og foregår løbende i produktionsmiljøer. Tænk på træning som at læse til en eksamen og inferens som at tage selve eksamenen.

Inferenslatens—tiden det tager for en model at generere et output—er afgørende for brugeroplevelsen og realtidsapplikationer. Lav latenstid muliggør øjeblikkelige svar i chatbots, realtidsoversættelse, autonome køretøjer og systemer til svindelopdagelse. Høj latenstid kan gøre applikationer ubrugelige til tidssensitive opgaver. Virksomheder optimerer latenstid via teknikker som kvantisering, modelbeskæring og specialiseret hardware som GPU'er og TPU'er for at opfylde serviceaftaler.

De tre primære typer er batch-inferens (behandling af store datasæt offline), online-inferens (generering af forudsigelser øjeblikkeligt ved forespørgsel) og streaming-inferens (kontinuerlig behandling af data fra sensorer eller IoT-enheder). Batch-inferens egner sig til scenarier som daglige analyse-dashboard, online-inferens driver chatbots og søgemaskiner, og streaming-inferens muliggør realtids overvågningssystemer. Hver type har forskellige latenstidskrav og anvendelsesområder.

Kvantisering reducerer den numeriske præcision af modelvægtninger fra 32-bit til 8-bit eller lavere, hvilket væsentligt reducerer modelstørrelse og beregningsbehov samtidig med at nøjagtigheden bevares. Beskæring fjerner ikke-kritiske neuroner eller forbindelser fra det neurale netværk og reducerer kompleksiteten. Begge teknikker kan reducere inferenslatens med 50-80% og sænke hardwareomkostninger. Disse optimeringsmetoder er essentielle til at implementere modeller på edge-enheder og mobile platforme.

Inferens er den centrale mekanisme, der gør det muligt for generative AI-systemer at producere tekst, billeder og kode. Når du giver ChatGPT en prompt, tokeniserer inferensprocessen dit input, bearbejder det gennem de trænede neurale netværkslag og genererer output-tokens én ad gangen. Prefill-fasen behandler alle input-tokens på én gang, mens decode-fasen genererer output sekventielt. Denne inferensevne gør store sprogmodeller responsive og praktiske til virkelige anvendelser.

Inferensovervågning sporer, hvordan AI-modeller præsterer i produktion, inklusive nøjagtighed, latenstid og outputkvalitet. Platforme som AmICited overvåger, hvor brands og domæner optræder i AI-genererede svar på tværs af systemer som ChatGPT, Perplexity og Google AI Overviews. Forståelse af inferensadfærd hjælper organisationer med at sikre, at deres indhold bliver korrekt citeret og repræsenteret, når AI-systemer genererer output, der refererer til deres domæner eller brandinformation.

Almindelige inferensacceleratorer omfatter GPU'er (grafikprocessorer) til parallel behandling, TPU'er (Tensor Processing Units) optimeret til neurale netværk, FPGA'er (Field-Programmable Gate Arrays) til tilpassede arbejdsbyrder og ASIC'er (Application-Specific Integrated Circuits) designet til specifikke opgaver. GPU'er er mest udbredte på grund af deres balance mellem ydeevne og pris, mens TPU'er er stærke til storskala inferens. Valget afhænger af krav til throughput, latenstid og budget.

Det globale AI-inferensmarked blev vurderet til 106,15 milliarder USD i 2025 og forventes at nå 254,98 milliarder USD i 2030, hvilket svarer til en årlig vækstrate (CAGR) på 19,2%. Denne hurtige vækst afspejler øget virksomhedsadoption af AI-applikationer, hvor 78% af organisationerne brugte AI i 2024, op fra 55% i 2023. Udvidelsen drives af efterspørgslen efter realtids-AI på tværs af brancher som sundhed, finans, detailhandel og autonome systemer.

Begynd at spore, hvordan AI-chatbots nævner dit brand på tværs af ChatGPT, Perplexity og andre platforme. Få handlingsrettede indsigter til at forbedre din AI-tilstedeværelse.

Lær hvad AI-indholdsdetektion er, hvordan detektionsværktøjer fungerer med maskinlæring og NLP, og hvorfor de er vigtige for brandovervågning, uddannelse og ver...

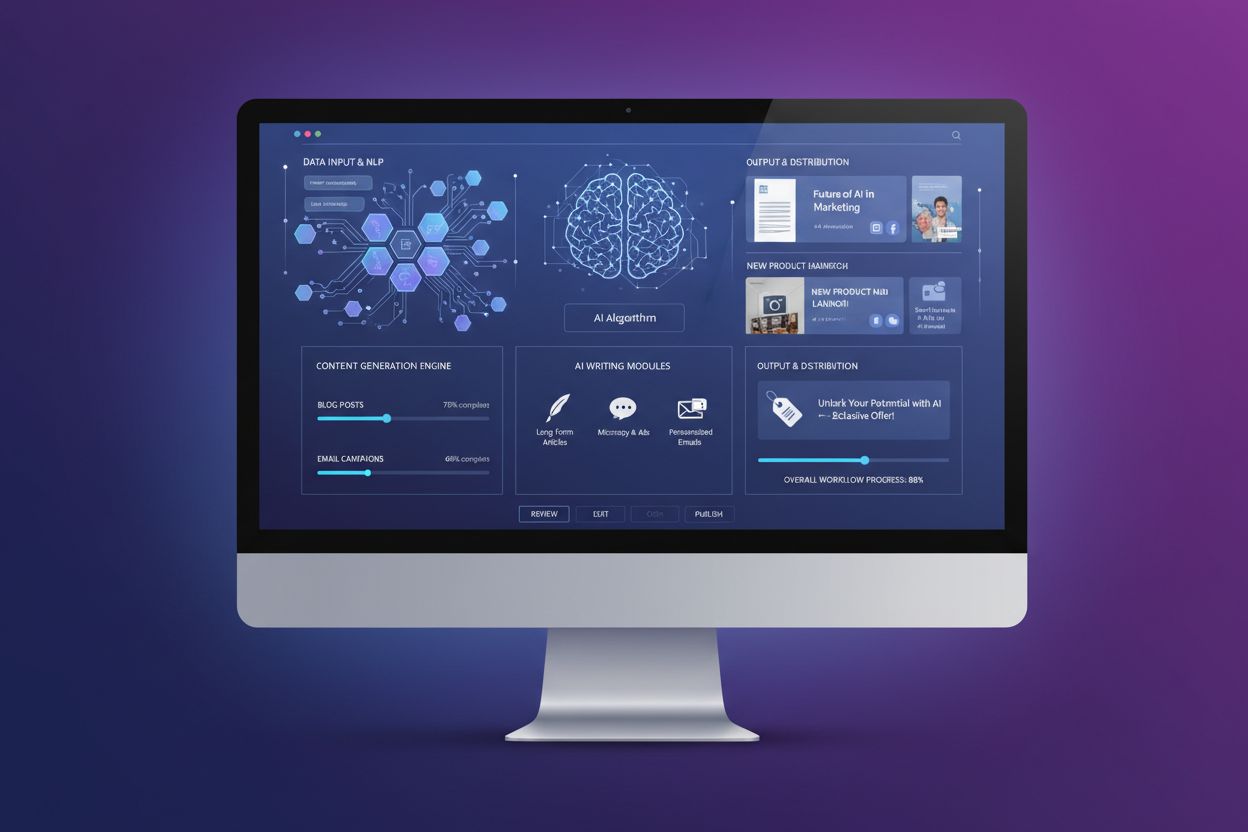

Lær hvad AI-indholdsgenerering er, hvordan det fungerer, dets fordele og udfordringer, og bedste praksis for at bruge AI-værktøjer til at skabe marketingindhold...

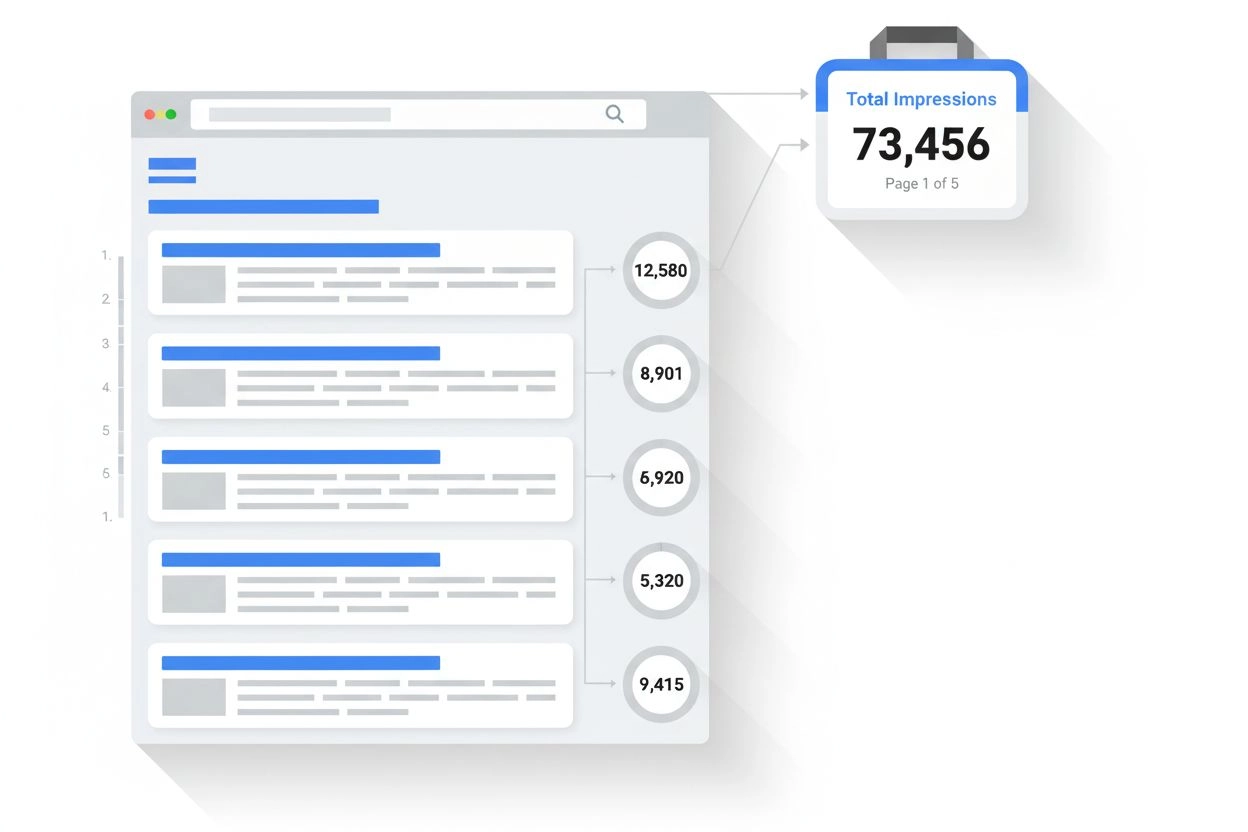

Lær hvad en impression er i søgeresultater og AI-overvågning. Forstå hvordan impressions tælles på tværs af Google Søgning, Perplexity, ChatGPT og andre platfor...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.