Prerendering for AI Crawlers: Gør JavaScript-indhold tilgængeligt

Lær hvordan prerendering gør JavaScript-indhold synligt for AI-crawlere som ChatGPT, Claude og Perplexity. Opdag de bedste tekniske løsninger til AI-søgeoptimer...

JavaScript-rendering til AI refererer til processen med at sikre, at dynamisk indhold oprettet af JavaScript er tilgængeligt for AI-crawlere, der ikke kan afvikle JavaScript-kode. Da store AI-systemer som ChatGPT, Perplexity og Claude ikke afvikler JavaScript, skal indholdet leveres som statisk HTML for at være synligt i AI-genererede svar. Løsninger som prerendering konverterer JavaScript-tunge sider til statiske HTML-snapshots, som AI-crawlere straks kan få adgang til og forstå.

JavaScript-rendering til AI refererer til processen med at sikre, at dynamisk indhold oprettet af JavaScript er tilgængeligt for AI-crawlere, der ikke kan afvikle JavaScript-kode. Da store AI-systemer som ChatGPT, Perplexity og Claude ikke afvikler JavaScript, skal indholdet leveres som statisk HTML for at være synligt i AI-genererede svar. Løsninger som prerendering konverterer JavaScript-tunge sider til statiske HTML-snapshots, som AI-crawlere straks kan få adgang til og forstå.

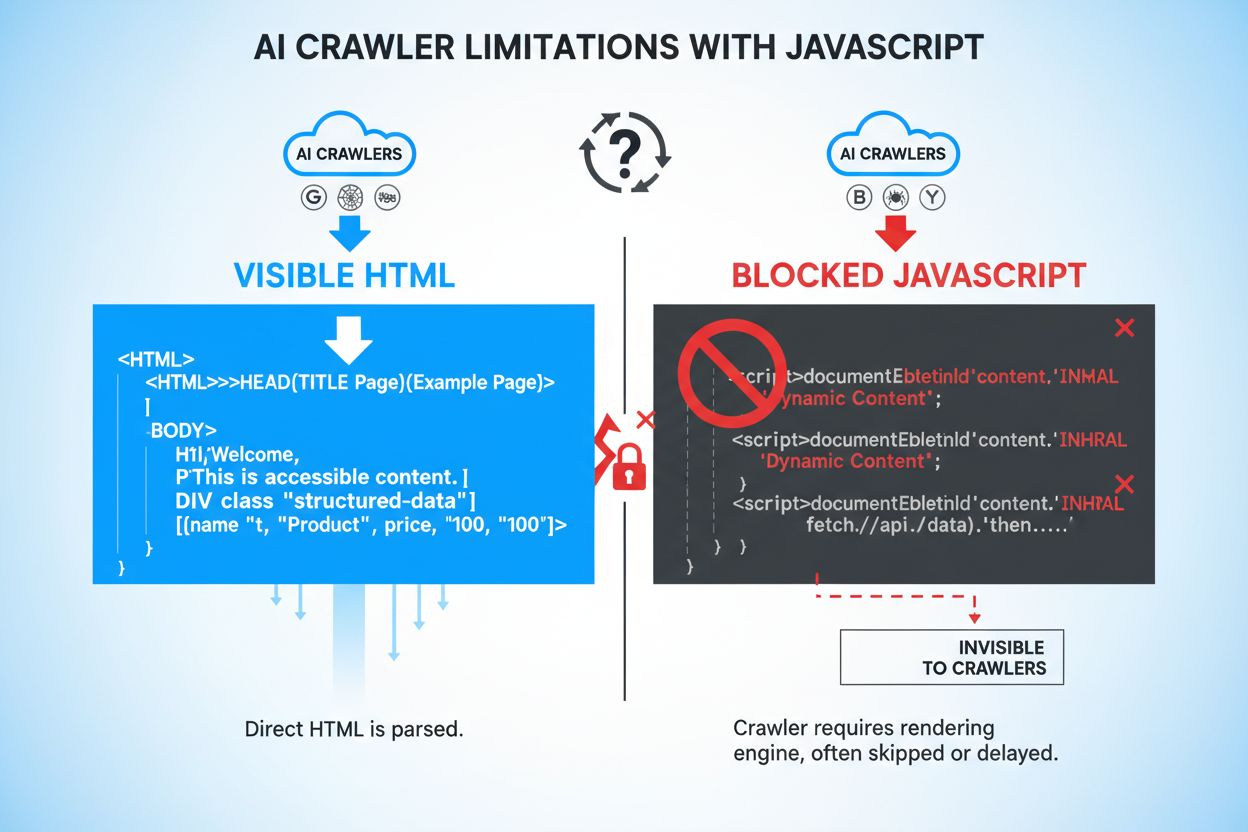

JavaScript er et programmeringssprog, der muliggør dynamiske, interaktive weboplevelser ved at køre kode direkte i brugernes browsere. Websites bruger JavaScript til at skabe responsive grænseflader, indlæse indhold on-demand og levere personlige brugeroplevelser. Men AI-crawlere som GPTBot, ChatGPT-User og OAI-SearchBot fungerer fundamentalt anderledes end traditionelle webcrawlere—de prioriterer hastighed og effektivitet over renderingsmuligheder. Hvor Googlebot og andre søgemaskinecrawlere kan afvikle JavaScript (dog med begrænsninger), gør AI-crawlere det typisk ikke, fordi rendering af JavaScript kræver betydelige computerressourcer og tid. Disse AI-systemer arbejder under strenge timeout-begrænsninger, ofte mellem 1-5 sekunder pr. side, hvilket gør fuld JavaScript-afvikling upraktisk. Derudover er AI-crawlere designet til hurtigt at udtrække information fremfor at simulere et komplet browsermiljø, hvilket betyder, at de kun indfanger den indledende HTML, som din server leverer, ikke det dynamisk renderede indhold, der vises efter JavaScript-afvikling.

Når AI-crawlere besøger dit website, går de glip af vigtigt indhold, der først vises efter JavaScript-afvikling. Produktinformation som priser, tilgængelighedsstatus og variantvalg skjules ofte bag JavaScript-rendering og bliver dermed usynlige for AI-systemer. Lazy-loaded indhold—billeder, kundeanmeldelser, kommentarer og yderligere produktdetaljer, der indlæses, når brugeren scroller—er helt utilgængelige for AI-crawlere, der ikke afvikler JavaScript. Interaktive elementer som faner, karruseller, accordeons og modale vinduer indeholder værdifuld information, som AI-systemer ikke kan tilgå uden rendering. Klient-side renderet tekst og dynamisk genererede metadata er ligeledes usynlige, hvilket skaber betydelige huller i, hvad AI-systemer kan forstå om dit indhold.

| Indholdstype | Synlighed for AI-crawlere | Effekt |

|---|---|---|

| Statisk HTML-tekst | ✓ Synlig | Høj tilgængelighed |

| JavaScript-renderet tekst | ✗ Skjult | Går fuldstændigt tabt |

| Lazy-loaded billeder | ✗ Skjult | Produktvisning går tabt |

| Produktpriser/tilgængelighed | ✗ Skjult (hvis JS-renderet) | Kritisk forretningsdata mangler |

| Kundeanmeldelser | ✗ Skjult (hvis lazy-loaded) | Social proof utilgængelig |

| Fanebladindhold | ✗ Skjult | Vigtig information utilgængelig |

| Schema markup i HTML | ✓ Synlig | Struktureret data indfanges |

| Dynamiske metabeskrivelser | ✗ Skjult | SEO-effekt reduceret |

AI-crawleres manglende adgang til JavaScript-renderet indhold skaber betydelige forretningsmæssige konsekvenser i et stadigt mere AI-drevet søgelandskab. Når din produktinformation, prissætning og tilgængelighed forbliver skjult for AI-systemer, mister du synlighed i AI-genererede søgeresultater og AI-drevne svarmotorer som Perplexity, Google AI Overblik og ChatGPT’s browserfunktion. Denne usynlighed fører direkte til mindre trafik fra AI-platforme, som hurtigt bliver primære opdagelseskanaler for forbrugere. E-handelsvirksomheder rammes særligt hårdt—når produktpriser og tilgængelighed ikke vises i AI-svar, får potentielle kunder ufuldstændig information og handler måske hos konkurrenten. SaaS-virksomheder står over for lignende udfordringer, da funktionsbeskrivelser, pristabeller og integrationsdetaljer, der skjules bag JavaScript, aldrig når AI-systemer, der kunne anbefale deres løsninger. Ud over tabt trafik skaber skjult indhold manglende kundetillid; når brugere ser ufuldstændig eller forældet information i AI-genererede svar, tvivler de på både AI-systemets og dit brands troværdighed. Det samlede resultat er en betydelig konkurrenceulempe, mens AI-bevidste konkurrenter sikrer, at deres indhold er fuldt tilgængeligt i disse nye opdagelseskanaler.

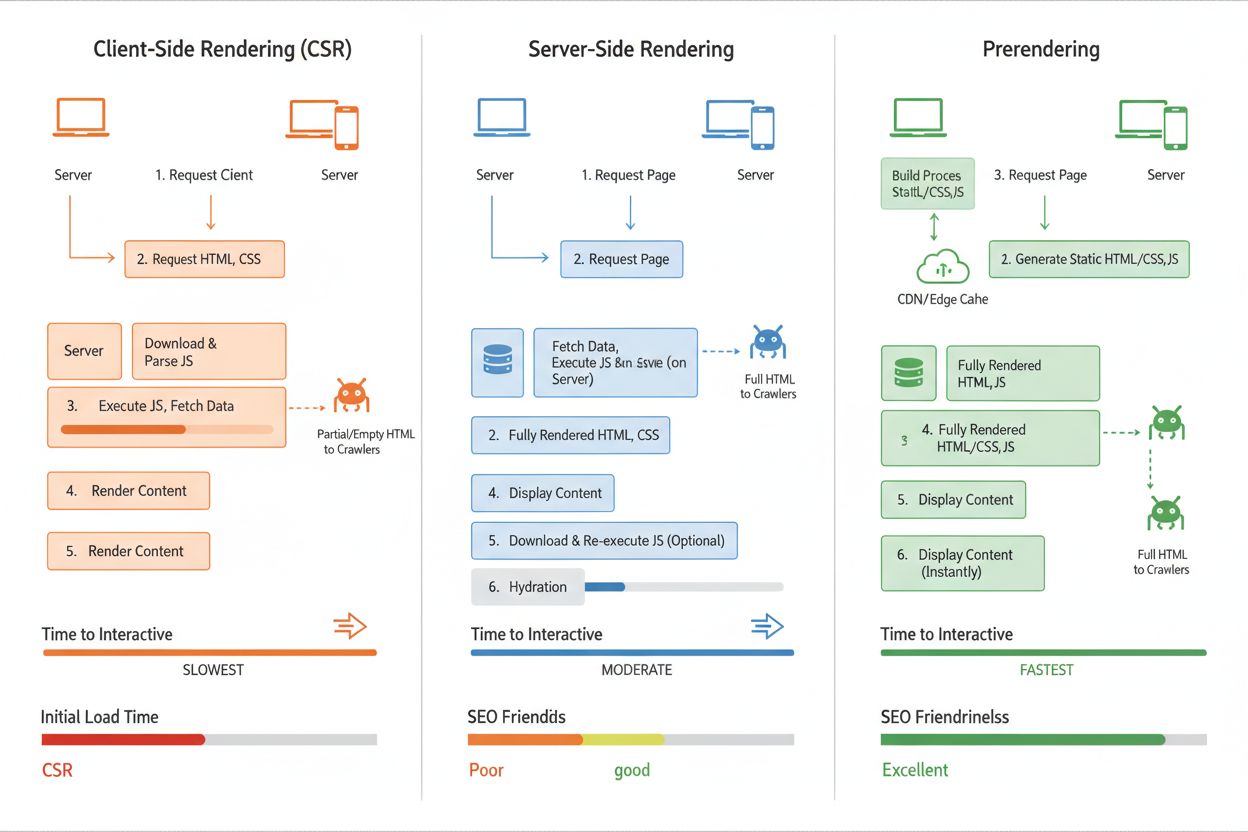

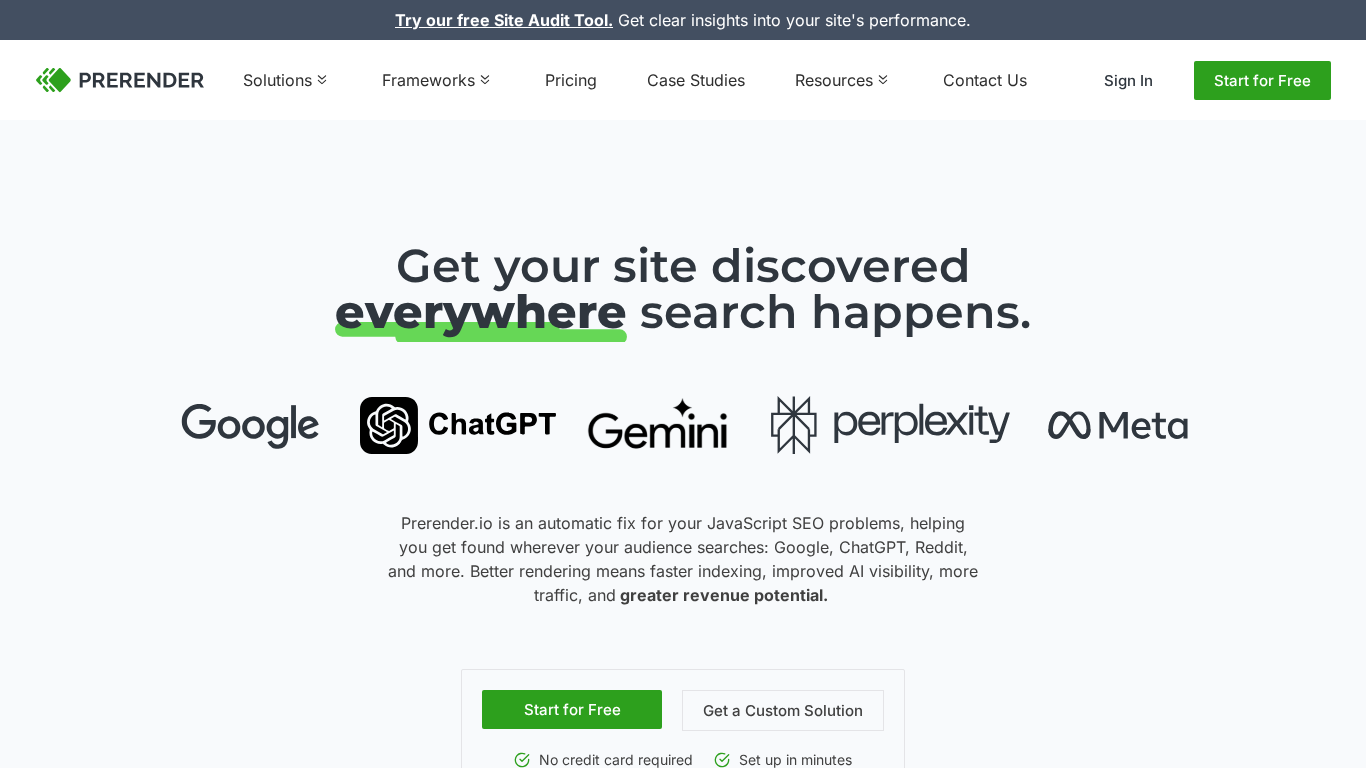

Prerendering er en server-side teknik, der løser JavaScript-synlighedsproblemet ved at generere statiske HTML-snapshots af dine sider, før de anmodes af crawlere. I modsætning til Client-Side Rendering (CSR), hvor indhold genereres i brugerens browser, afvikler prerendering JavaScript på din server og indfanger det fuldt renderede HTML-output. Denne statiske HTML serveres derefter til AI-crawlere, hvilket sikrer, at de modtager komplet, fuldt renderet indhold uden selv at skulle afvikle JavaScript. Prerender.io er et eksempel på denne tilgang—det fungerer som en middleware-service, der opfanger forespørgsler fra AI-crawlere, serverer dem prerenderede HTML-versioner af dine sider og samtidig leverer normale JavaScript-tunge sider til almindelige brugere. Den store fordel for AI-crawlere er, at de modtager indhold i det format, de forventer og kan behandle—ren HTML, hvor alt dynamisk indhold allerede er inkluderet. Dette adskiller sig fra Server-Side Rendering (SSR), som renderer indhold ved hver forespørgsel og kræver flere serverressourcer, hvilket gør det mindre effektivt for trafik-tunge sites. Prerendering er særligt elegant, fordi det kræver minimale ændringer i din eksisterende kodebase, men dramatisk forbedrer AI-crawleres adgang.

Client-Side Rendering (CSR) er den mest almindelige tilgang for moderne webapplikationer, hvor JavaScript kører i browseren for dynamisk at bygge siden. Men CSR skaber kernen i problemet: AI-crawlere modtager tom eller minimal HTML og går glip af alt JavaScript-renderet indhold, hvilket giver ringe AI-synlighed. Server-Side Rendering (SSR) løser dette ved at renderere sider på din server, før de sendes til klienten, så alt indhold er i den indledende HTML, som AI-crawlere modtager. Ulempen er, at SSR kræver betydelige serverressourcer, øger latenstiden for hver sideforespørgsel og bliver dyrt i stor skala—særligt problematisk for trafik-tunge sites. Prerendering giver den bedste balance for AI-synlighed: det renderer sider én gang og cacher den statiske HTML, som serveres til AI-crawlere, mens almindelige brugere stadig får dynamiske JavaScript-oplevelser. Denne tilgang minimerer serverbelastningen, bevarer hurtig sideindlæsning for brugere og sikrer, at AI-crawlere altid får komplet, fuldt renderet indhold. For de fleste organisationer er prerendering den optimale løsning, der balancerer omkostninger, ydeevne og AI-tilgængelighed uden fundamentale arkitektoniske ændringer.

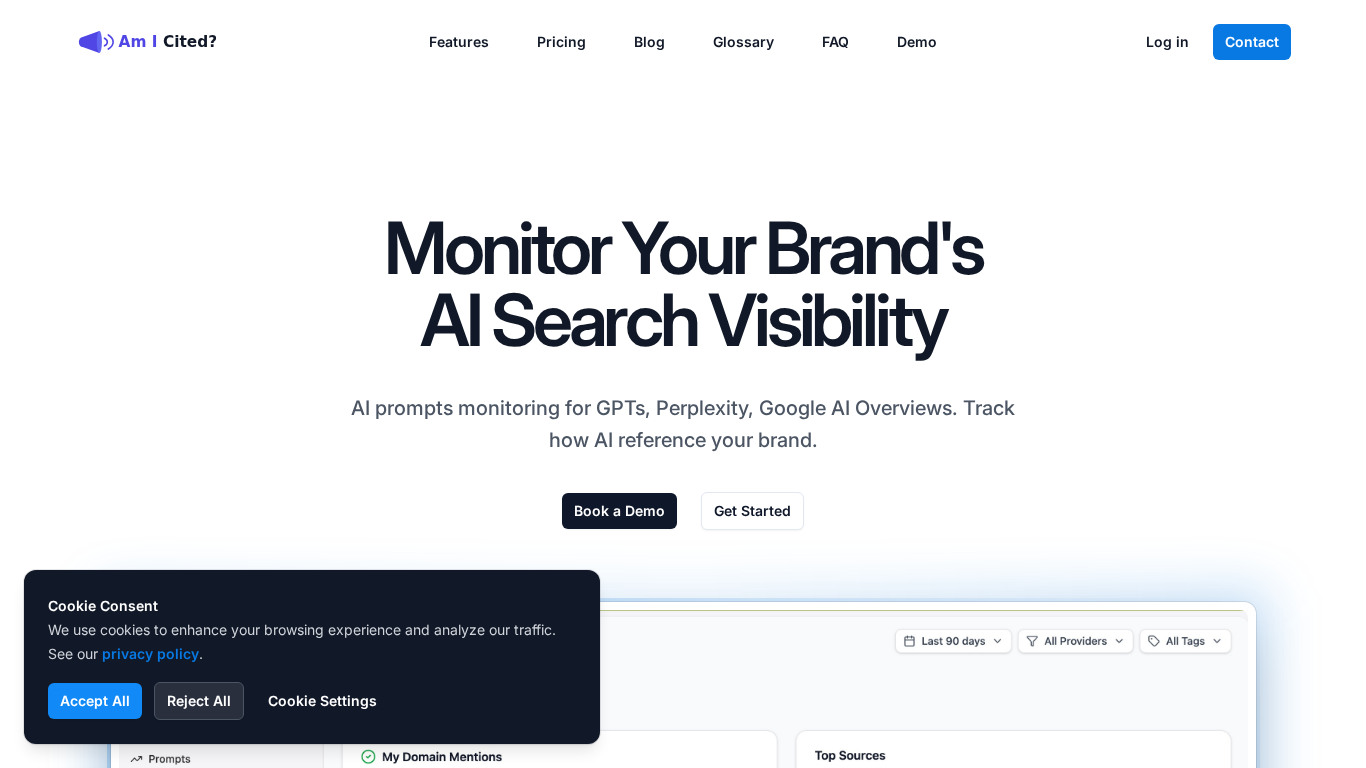

Prerender.io er branchens førende prerenderingstjeneste, der tilbyder middleware, som automatisk registrerer AI-crawlers forespørgsler og serverer dem prerenderede HTML-versioner af dine sider. AmICited.com giver omfattende AI-synlighedsovervågning og følger, hvordan dit brand vises i svar fra ChatGPT, Perplexity, Google AI Overblik og andre store AI-systemer—hvilket er essentielt for at forstå den reelle effekt af din JavaScript-renderingsstrategi. Ud over prerendering kan værktøjer som Screaming Frog og Lighthouse auditere, hvilket JavaScript-indhold der fortsat er skjult for crawlere, og hjælpe med at identificere problemområder. Når du vælger en løsning, bør du overveje dit trafikniveau, tekniske infrastruktur og de specifikke AI-platforme, du vil ramme; prerendering fungerer bedst for indholdstunge sites med moderat til høj trafik, mens SSR kan passe til mindre applikationer med enklere renderingbehov. Integration er typisk ligetil—de fleste prerenderingstjenester fungerer som transparent middleware, der kræver minimale kodeændringer. For en komplet AI-synlighedsstrategi sikrer en kombination af prerendering og AmICited.com’s overvågning, at du ikke blot gør indhold tilgængeligt for AI-crawlere, men også måler den faktiske forretningsmæssige effekt af forbedringerne.

Overvågning af, hvor effektiv din JavaScript-renderingsstrategi er, kræver, at du følger både crawler-aktivitet og forretningsmæssige resultater. AI-crawler adgangslogs viser, hvor ofte GPTBot, ChatGPT-User og OAI-SearchBot besøger dit site, og hvilke sider de anmoder om—stigende hyppighed indikerer typisk forbedret tilgængelighed. Indholdssynligheds-metrics via værktøjer som AmICited.com viser, om dit brand, dine produkter og information faktisk optræder i AI-genererede svar og giver direkte bevis på rendering-succes. Prerendering-verifikationsværktøjer kan bekræfte, at AI-crawlere får fuldt renderet HTML ved at sammenligne, hvad de ser, med hvad almindelige brugere ser. Forventede forbedringer inkluderer øget omtale i AI-søgeresultater, mere nøjagtig produktinformation i AI-svar og højere klikrater fra AI-platforme til dit website. Trafikattribution fra AI-kilder bør stige målbart inden for 2-4 uger efter implementering af prerendering, især for værdifulde nøgleord og produktforespørgsler. ROI-beregning bør inkludere øget AI-drevet trafik, forbedrede konverteringsrater fra mere komplet produktinformation i AI-svar og færre kundesupporthenvendelser som følge af informationshuller. Løbende overvågning med AmICited.com sikrer, at du bevarer synligheden i takt med, at AI-systemer udvikler sig, og hjælper dig med at identificere nye muligheder for at optimere dit indhold til AI-tilgængelighed.

AI-crawlere som GPTBot og ChatGPT-User prioriterer hastighed og effektivitet over renderingsmuligheder. Afvikling af JavaScript kræver betydelige computerressourcer og tid, hvilket er i konflikt med deres design om hurtigt informationsudtræk. Disse systemer arbejder under strenge timeout-begrænsninger (typisk 1-5 sekunder pr. side), hvilket gør fuld JavaScript-afvikling upraktisk. De er designet til kun at indfange den indledende HTML, som din server leverer, ikke dynamisk renderet indhold.

Produktinformation (priser, tilgængelighed, varianter), lazy-loaded indhold (billeder, anmeldelser, kommentarer), interaktive elementer (faner, karruseller, modaler) og klient-side renderet tekst er mest påvirket. E-handelssider oplever særligt store konsekvenser, da produktdetaljer og priser ofte er afhængige af JavaScript. SaaS-virksomheder står også over for udfordringer, når funktionsbeskrivelser og pristabeller er skjult bag JavaScript-afvikling.

Client-Side Rendering (CSR) genererer indhold i brugerens browser med JavaScript, hvilket AI-crawlere ikke kan få adgang til. Server-Side Rendering (SSR) renderer sider på din server ved hver forespørgsel, så indholdet er i den indledende HTML, men kræver betydelige serverressourcer. Prerendering genererer statiske HTML-snapshots én gang og cacher dem, så de kan serveres til AI-crawlere, mens brugere får dynamiske oplevelser—det giver den bedste balance mellem ydeevne og AI-tilgængelighed.

Brug overvågningsværktøjer som AmICited.com til at følge AI-crawlers aktivitet og se, hvordan dit indhold vises i AI-genererede svar. Du kan også simulere AI-crawlers forespørgsler med browserudviklerværktøjer eller services, der tester med GPTBot og ChatGPT-User user agents. Prerenderingstjenester inkluderer ofte verifikationsværktøjer, der viser, hvad AI-crawlere faktisk modtager sammenlignet med almindelige brugere.

Ja, JavaScript-rendering påvirker begge dele. Selvom Googlebot kan afvikle JavaScript (med begrænsninger), tager det stadig længere tid at crawle og indeksere JavaScript-tunge sider. Server-side rendering eller prerendering forbedrer både traditionel SEO og AI-synlighed ved at sikre, at indholdet straks er tilgængeligt i HTML, hvilket reducerer crawl-tid og øger indekseringshastigheden.

Prerenderingstjenester som Prerender.io opkræver typisk betaling baseret på antal renderede sider, med priser fra ca. 50-100 USD/måned for små sider. Server-side rendering kræver flere udviklingsressourcer, men har ingen løbende serviceomkostninger. ROI er typisk positiv inden for få uger gennem øget AI-drevet trafik og bedre konverteringsrater fra mere komplet produktinformation i AI-svar.

AI-crawlere kan opfange nyt prerenderet indhold inden for 24 timer, og nogle systemer besøger sider flere gange dagligt. Du bør se målbare stigninger i AI-drevet trafik inden for 2-4 uger efter implementering. Brug af AmICited.com til at overvåge din synlighed hjælper dig med at følge forbedringerne i realtid, efterhånden som dit indhold bliver tilgængeligt for AI-systemer.

Fokuser prerendering på værdifulde sider: produktsider, servicesider, vigtige blogindlæg, FAQ-sider og lokationssider. Disse sider skaber størst synlighed og konverteringer, når de vises i AI-genererede svar. Undgå at prerenderere 404-sider eller lavværdi-indhold. Denne tilgang optimerer dit prerenderingsbudget og maksimerer effekten på sider, der mest sandsynligt driver AI-drevet trafik og konverteringer.

Følg hvordan dit brand vises i ChatGPT, Perplexity, Google AI Overblik og andre AI-systemer. Få realtidsindsigt i din AI-søgesynlighed og optimer din indholdsstrategi.

Lær hvordan prerendering gør JavaScript-indhold synligt for AI-crawlere som ChatGPT, Claude og Perplexity. Opdag de bedste tekniske løsninger til AI-søgeoptimer...

Lær, hvordan JavaScript-rendering påvirker din hjemmesides synlighed i AI-søgemaskiner som ChatGPT, Perplexity og Claude. Opdag hvorfor AI-crawlere har svært ve...

Opdag hvordan SSR- og CSR-renderingstrategier påvirker AI-crawleres synlighed, brandcitater i ChatGPT og Perplexity samt din samlede AI-søgepræsentation.

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.