Content SEO

Content SEO er den strategiske skabelse og optimering af indhold af høj kvalitet for at forbedre søgerangeringer og organisk synlighed. Lær, hvordan du optimere...

JavaScript SEO er processen med at optimere JavaScript-renderede websites for at sikre, at søgemaskiner effektivt kan crawle, gengive og indeksere indhold. Det omfatter bedste praksis for at gøre JavaScript-drevne webapplikationer synlige og rangerbare i søgeresultater, samtidig med at optimal ydeevne og brugeroplevelse opretholdes.

JavaScript SEO er processen med at optimere JavaScript-renderede websites for at sikre, at søgemaskiner effektivt kan crawle, gengive og indeksere indhold. Det omfatter bedste praksis for at gøre JavaScript-drevne webapplikationer synlige og rangerbare i søgeresultater, samtidig med at optimal ydeevne og brugeroplevelse opretholdes.

JavaScript SEO er den specialiserede praksis med at optimere JavaScript-renderede websites for at sikre, at søgemaskiner effektivt kan crawle, gengive og indeksere indhold. Det omfatter et omfattende sæt tekniske strategier, bedste praksisser og implementeringsmetoder designet til at gøre JavaScript-drevne webapplikationer fuldt ud synlige og rangerbare i søgeresultater. I modsætning til traditionelle HTML-baserede websites, hvor indholdet straks er tilgængeligt i serversvaret, kræver JavaScript-renderet indhold yderligere behandlingsskridt, der kan have stor indflydelse på, hvordan søgemaskiner forstår og rangerer dine sider. Disciplinen kombinerer teknisk SEO-ekspertise med forståelsen af, hvordan moderne web-frameworks som React, Vue og Angular interagerer med søgemaskinecrawlere. JavaScript SEO er blevet stadig mere kritisk, da 98,7% af websites nu inkorporerer en eller anden form for JavaScript, hvilket gør det til essentiel viden for enhver SEO-professionel, der arbejder med moderne webteknologier.

Fremkomsten af JavaScript-frameworks har fundamentalt ændret, hvordan websites bygges, og hvordan søgemaskiner skal behandle dem. I internettets tidlige dage parsede Googlebot blot HTML-svar fra servere, hvilket gjorde SEO ligetil – indhold i HTML blev indekseret. Men efterhånden som udviklere tog client-side rendering til sig for at skabe mere interaktive og dynamiske brugeroplevelser, stod søgemaskiner over for en kritisk udfordring: Indholdet var ikke længere til stede i det indledende HTML-svar, men blev i stedet genereret af JavaScript-eksekvering i browseren. Dette skabte en betydelig kløft mellem, hvad brugerne så, og hvad søgemaskiner oprindeligt havde adgang til. Google reagerede ved at udvikle headless Chromium-renderingsfunktionalitet, som gjorde det muligt for Googlebot at eksekvere JavaScript og behandle det gengivne DOM. Denne renderingsproces er dog ressourcekrævende – cirka 100 gange dyrere end blot at parse HTML – hvilket betyder, at Google ikke kan gengive alle sider med det samme. Denne ressourcebegrænsning skabte konceptet om et render budget, hvor sider sættes i kø til rendering baseret på forventet vigtighed og søgetrafikpotentiale. At forstå denne udvikling er afgørende, fordi det forklarer, hvorfor JavaScript SEO ikke er valgfrit, men et grundlæggende element i moderne teknisk SEO-strategi.

Googles tilgang til JavaScript-renderet indhold følger en sofistikeret tre-faset proces, som grundlæggende adskiller sig fra traditionel HTML-crawling. I crawling-fasen anmoder Googlebot om en URL og modtager det indledende HTML-svar. Det parses straks for at udtrække links og tjekke for indekseringsdirektiver som robots meta-tags og noindex-deklarationer. Vigtigt: Hvis en side indeholder et noindex-tag i det indledende HTML, vil Google ikke fortsætte til rendering – en vigtig detalje, som mange SEO-specialister overser. Samtidig sættes URL’en i kø til rendering-fasen, hvor Web Rendering Service (WRS) bruger headless Chromium til at eksekvere JavaScript, opbygge DOM og generere det fuldt gengivne HTML. Dette renderingsskridt kan tage sekunder eller længere afhængigt af JavaScript-kompleksiteten, og sider kan vente i renderkøen i længere tid, hvis Googles ressourcer er begrænsede. Endelig, i indekseringsfasen, behandler Google det gengivne HTML for at udtrække indhold, links og metadata til optagelse i søgeindekset. Den væsentlige indsigt her er, at Google indekserer baseret på rendered HTML, ikke det indledende HTML-svar – hvilket betyder, at JavaScript fuldstændig kan ændre, hvad der bliver indekseret. Denne tre-fasede proces forklarer, hvorfor JavaScript-sider ofte oplever langsommere indeksering, hvorfor renderforsinkelser betyder noget, og hvorfor det er essentielt at sammenligne response HTML med rendered HTML for at diagnosticere JavaScript SEO-problemer.

| Renderingsmetode | Sådan fungerer det | SEO-fordele | SEO-ulemper | Bedst til |

|---|---|---|---|---|

| Server-Side Rendering (SSR) | Indhold fuldt gengivet på serveren før levering til klienten | Indhold straks tilgængeligt i indledende HTML; hurtig indeksering; ingen renderforsinkelser; understøtter alle crawlere | Højere serverbelastning; langsommere Time to First Byte (TTFB); kompleks implementering | SEO-kritiske sites, e-handel, indholdstunge sider, nyhedsmedier |

| Client-Side Rendering (CSR) | Server sender minimal HTML; JavaScript gengiver indhold i browseren | Mindre serverbelastning; bedre skalerbarhed; hurtigere sideovergange for brugere | Forsinket indeksering; kræver rendering; usynligt for LLM-crawlere; langsommere initial indlæsning; bruger crawl-budget | Webapplikationer, dashboards, indhold bag login, ikke-SEO-afhængige sites |

| Dynamisk rendering | Serveren detekterer crawlere og serverer forudgengivet HTML; brugere får CSR | Indhold straks tilgængeligt for crawlere; balancerer bot- og brugeroplevelse; lettere end SSR | Kompleks opsætning; afhængighed af værktøjer; potentielle cloaking-risici; kræver botdetektion; midlertidig løsning | Store JavaScript-tunge sites, SPAs med behov for søgesynlighed, overgangsløsning |

| Static Site Generation (SSG) | Indhold forudgengivet ved build-tidspunkt; serveres som statisk HTML | Hurtigste ydeevne; optimal SEO; ingen renderforsinkelser; fremragende Core Web Vitals | Begrænset dynamisk indhold; genopbygning krævet ved opdateringer; ikke egnet til realtidsdata | Blogs, dokumentation, marketingsites, indhold der sjældent ændres |

JavaScript-renderede websites præsenterer flere tekniske forhindringer, der direkte påvirker SEO-ydeevne og søgesynlighed. Den mest grundlæggende udfordring er renderforsinkelse – da rendering er ressourcekrævende, kan Google udskyde rendering af sider i timer eller endda dage, hvilket betyder, at dit indhold ikke straks bliver indekseret efter udgivelse. Dette er især problematisk for tidssensitivt indhold som nyhedsartikler eller produktlanceringer. Et andet kritisk problem er soft 404-fejl, som opstår, når single-page applications returnerer en 200 HTTP-statuskode selv for ikke-eksisterende sider, hvilket forvirrer søgemaskiner om, hvilke sider der skal indekseres. JavaScript-ændringer til kritiske elementer udgør en anden stor forhindring: Når JavaScript ændrer titler, canonical-tags, meta robots-direktiver eller interne links efter det indledende HTML-svar, kan søgemaskiner indeksere forkerte versioner eller overse vigtige SEO-signaler. Problemet med crawl-budgetforbrug er særligt alvorligt for store sites – JavaScript-filer er store og ressourcekrævende, hvilket betyder, at Google bruger flere ressourcer på at gengive færre sider og dermed begrænser, hvor dybt dit site kan crawles. Derudover afvikler LLM-crawlere og AI-søgeværktøjer ikke JavaScript, hvilket gør JavaScript-only-indhold usynligt for nye AI-søgeplatforme som Perplexity, Claude og andre. Statistikker viser, at 31,9% af SEO-specialister ikke er sikre på, hvordan man afgør, om et website er væsentligt JavaScript-afhængigt, og 30,9% ikke er trygge ved at undersøge JavaScript-forårsagede SEO-problemer, hvilket understreger videnskløften i branchen.

Optimering af JavaScript-renderet indhold kræver en flerstrenget tilgang, der adresserer både teknisk implementering og strategiske beslutninger. Den første og vigtigste bedste praksis er at inkludere væsentligt indhold i det indledende HTML-svar – titler, metabeskrivelser, canonical-tags og kritisk brødtekst bør være til stede i serversvaret, før JavaScript eksekveres. Dette sikrer, at søgemaskiner får et komplet førstehåndsindtryk af din side og ikke skal vente på rendering for at forstå sidens indhold. Undgå at blokere JavaScript-filer i robots.txt, da dette forhindrer Google i at gengive dine sider korrekt; tillad i stedet adgang til alle JavaScript-ressourcer, der er nødvendige for rendering. Implementér korrekte HTTP-statuskoder – brug 404 for ikke-eksisterende sider og 301 redirects for flyttet indhold i stedet for at lade JavaScript håndtere disse scenarier. For single-page applications bør du bruge History API i stedet for URL-fragmenter for at sikre, at hver visning har en unik, crawlbar URL; fragmenter som #/produkter er upålidelige for søgemaskiner. Minimer og udskyd ikke-kritisk JavaScript for at reducere renderingstiden og forbedre Core Web Vitals – brug kodeopdeling til kun at indlæse nødvendigt JavaScript pr. side. Implementér lazy loading af billeder med det native loading="lazy"-attribut i stedet for JavaScript-baserede løsninger, så søgemaskiner kan opdage billeder uden rendering. Brug indholdshashing i JavaScript-filnavne (fx main.2a846fa617c3361f.js), så Google ved, hvornår koden er ændret og skal genhentes. Test din implementering grundigt med Google Search Consoles URL-inspektionsværktøj, Screaming Frog med rendering aktiveret eller Sitebulbs Response vs Render-rapport for at sammenligne indledende HTML med rendered HTML og identificere uoverensstemmelser.

Valget af den rigtige renderingsmetode er en af de mest afgørende beslutninger for JavaScript SEO. Server-Side Rendering (SSR) er guldstandarden for SEO-kritiske websites, fordi indholdet er fuldt gengivet på serveren før levering, hvilket eliminerer renderforsinkelser og sikrer, at alle crawlere kan tilgå indholdet. Frameworks som Next.js og Nuxt.js gør SSR-implementering lettere for moderne udviklingsteams. SSR kræver dog flere serverressourcer og kan medføre langsommere Time to First Byte (TTFB), hvilket påvirker brugeroplevelsen. Client-Side Rendering (CSR) er passende for webapplikationer, hvor SEO ikke er hovedfokus, såsom dashboards, værktøjer bag loginmure eller interne applikationer. CSR reducerer serverbelastningen og muliggør meget interaktive brugeroplevelser, men giver indekseringsforsinkelser og gør indhold usynligt for LLM-crawlere. Dynamisk rendering fungerer som et pragmatisk kompromis: Den detekterer søgemaskinecrawlere og serverer dem forudgengivet HTML, mens brugere får den interaktive CSR-oplevelse. Værktøjer som Prerender.io håndterer dette automatisk, men Google udtaler eksplicit, at dette er en midlertidig løsning og anbefaler at skifte til SSR på længere sigt. Static Site Generation (SSG) er optimal for indhold, der sjældent ændres – indholdet forudgengives ved build-tidspunkt og serveres som statisk HTML, hvilket giver den bedste ydeevne og SEO-karakteristika. Beslutningen bør baseres på dit websites SEO-prioriteter, tekniske ressourcer og indholdsopdateringsfrekvens. Data viser, at 60% af SEO-specialister nu bruger JavaScript-crawlere til audits, hvilket indikerer en voksende bevidsthed om, at rendering skal indgå i teknisk SEO-analyse.

Effektiv JavaScript SEO kræver løbende overvågning af specifikke målinger og indikatorer, der viser, hvordan søgemaskiner interagerer med dit JavaScript-renderede indhold. Sammenligning af response og rendered HTML er grundlæggende – ved hjælp af værktøjer som Sitebulbs Response vs Render-rapport kan du præcist identificere, hvad JavaScript ændrer på dine sider, herunder ændringer i titler, metabeskrivelser, canonical-tags, interne links og robots-direktiver. Statistikker viser, at 18,26% af JavaScript-crawls kun har H1-tags i rendered HTML (ikke i det indledende svar), og kritisk nok viser 4,60% af JavaScript-audits noindex-tags kun i response HTML – et mareridtsscenarie, hvor Google ser noindex og aldrig gengiver siden, hvilket forhindrer indeksering af indhold, du ønsker indekseret. Forbrug af render budget bør overvåges via Google Search Consoles Dækningsrapport, som viser, hvor mange sider der er i kø til rendering versus allerede gengivet. Core Web Vitals er særligt vigtige for JavaScript-sites, da JavaScript-eksekvering direkte påvirker Largest Contentful Paint (LCP), First Input Delay (FID) og Cumulative Layout Shift (CLS). Overvåg indekseringslatens – hvor længe efter udgivelse dit indhold optræder i Googles indeks – da JavaScript-sites typisk oplever længere forsinkelser end HTML-sites. Spor crawl-effektivitet ved at sammenligne antallet af crawlede sider med det samlede antal sider på dit site; JavaScript-sites har ofte lavere crawl-effektivitet pga. ressourcebegrænsninger. Brug Google Search Consoles URL-inspektionsværktøj til at verificere, at kritisk indhold optræder i det rendered HTML, Google behandler, ikke kun i det indledende svar.

Fremkomsten af AI-drevne søgeplatforme som Perplexity, ChatGPT, Claude og Google AI Overviews har skabt en ny dimension til JavaScript SEO, der rækker ud over traditionelle søgemaskiner. De fleste LLM-crawlere afvikler ikke JavaScript – de indtager rå HTML og DOM-indhold, som det præsenteres i det indledende serversvar. Det betyder, at hvis dit kritiske indhold, produktinformation eller brandbudskab kun vises efter JavaScript-eksekvering, er det fuldstændig usynligt for AI-søgeværktøjer. Dette skaber et dobbelt synlighedsproblem: Indhold, der er usynligt for LLM-crawlere, bliver ikke citeret i AI-svar, og brugere, der søger via AI-platforme, finder ikke dit indhold. For AmICited-brugere, der overvåger brand- og domæneoptræden i AI-svar, er dette særligt kritisk – hvis dit JavaScript-renderede indhold ikke er tilgængeligt for LLM-crawlere, optræder du slet ikke i AI-citater. Løsningen er at sikre, at væsentligt indhold findes i det indledende HTML-svar, så det er tilgængeligt for både traditionelle søgemaskiner og AI-crawlere. Derfor bliver Server-Side Rendering eller Dynamisk Rendering endnu vigtigere i AI-søgningsæraen – du skal have dit indhold synligt ikke kun for Googlebot, men også for det voksende økosystem af AI-søgeværktøjer, der ikke afvikler JavaScript.

Landskabet for JavaScript SEO udvikler sig fortsat i takt med, at både søgemaskiner og webteknologier forbedres. Google har investeret massivt i at forbedre JavaScript-renderingsfunktionalitet, og er gået fra en tofaseproces (crawl og indeks) til en trefaseproces (crawl, render og indeks), der bedre håndterer moderne webapplikationer. Rendering er dog stadig ressourcebegrænset, og der er ingen indikation på, at Google vil gengive alle sider med det samme, eller at render budgets forsvinder. Branchen ser et skift mod hybride renderingsmetoder, hvor kritisk indhold server-renderes, mens interaktive elementer client-renderes, hvilket balancerer SEO-behov med brugeroplevelse. Web Components og Shadow DOM bliver mere udbredte, hvilket kræver, at SEO-specialister forstår, hvordan disse teknologier interagerer med søgemaskinernes rendering. Fremkomsten af AI-søgning skaber nyt pres for at sikre, at indhold er tilgængeligt uden JavaScript-eksekvering, hvilket kan drive adoption af SSR og SSG. Core Web Vitals er fortsat en rangeringsfaktor, og JavaScripts påvirkning af disse målinger betyder, at ydeevneoptimering er uløseligt forbundet med JavaScript SEO. Branchedata viser, at kun 10,6% af SEO-specialister fuldt ud forstår, hvordan Google crawler, gengiver og indekserer JavaScript, hvilket indikerer et stort behov for uddannelse og kompetenceudvikling. Efterhånden som JavaScript-frameworks bliver mere avancerede, og AI-søgeplatforme vinder frem, vil JavaScript SEO-ekspertise blive stadig mere værdifuld og essentiel for konkurrencedygtig organisk synlighed.

main.2a846fa617c3361f.js), så Google ved, hvornår kode er ændret og skal genhentesloading="lazy") fremfor JavaScript-baserede løsninger for bedre crawler-kompatibilitetJavaScript SEO er gået fra at være et nicheområde til at være et grundlæggende element i moderne søgemaskineoptimering. Med 98,7% af websites, der inkorporerer JavaScript, og 88% af SEO-specialister, der regelmæssigt arbejder med JavaScript-afhængige sites, er evnen til at optimere JavaScript-renderet indhold ikke længere valgfri – det er essentielt. Kompleksiteten i den tre-fasede renderingspipeline, render budget-begrænsninger og fremkomsten af AI-søgeplatforme har skabt en multifacetteret udfordring, der kræver både teknisk viden og strategisk beslutningstagning. Statistikkerne er tankevækkende: 41,6% af SEO-specialister har ikke læst Googles JavaScript-dokumentation, 31,9% er ikke sikre på, hvordan man identificerer JavaScript-afhængige sites, og 30,9% er ikke trygge ved at undersøge JavaScript-forårsagede problemer. Alligevel er konsekvenserne betydelige – 4,60% af JavaScript-audits viser kritiske problemer som noindex-tags kun i response HTML, hvilket helt forhindrer indeksering. Vejen frem kræver investering i uddannelse, valg af de rette renderingsstrategier og implementering af bedste praksis, der sikrer, at indhold er tilgængeligt for både søgemaskiner og AI-crawlere. Uanset om det er gennem Server-Side Rendering, Dynamisk Rendering eller omhyggelig optimering af Client-Side Rendering, forbliver målet det samme: Gør dit JavaScript-drevne indhold fuldt ud synligt, indekserbart og tilgængeligt på alle søgeplatforme – fra traditionel Google-søgning til fremtidens AI-søgeværktøjer. For organisationer, der bruger AmICited til at overvåge brandsynlighed i AI-svar, bliver JavaScript SEO endnu vigtigere, da uoptimeret JavaScript-renderet indhold vil være usynligt for LLM-crawlere og ikke skabe citater i AI-søgeresultater.

Ja, Google gengiver og indekserer JavaScript-indhold ved hjælp af headless Chromium. Dog er gengivelse ressourcekrævende og udsat, indtil Google har tilgængelige ressourcer. Google behandler sider i tre faser: crawling, rendering og indeksering. Sider markeret med noindex-tags bliver ikke gengivet, og renderforsinkelser kan sænke indekseringen. Det vigtigste er, at det gengivne HTML – ikke det indledende HTML-svar – er det, Google bruger til indekseringsbeslutninger.

Ifølge data fra 2024 har 98,7% af websites nu en eller anden grad af JavaScript-afhængighed. Derudover bruger 62,3% af udviklere JavaScript som deres primære programmeringssprog, og 88% af SEO-specialister arbejder med JavaScript-afhængige sider enten nogle gange eller hele tiden. Denne udbredte anvendelse gør JavaScript SEO-kundskab essentielt for moderne SEO-folk.

Væsentlige udfordringer inkluderer renderforsinkelser, der sænker indekseringen, ressourcekrævende behandling, der bruger crawl-budgettet, potentielle soft 404-fejl i single-page applications, og JavaScript-ændringer til kritiske elementer såsom titler, canonical-tags og meta robots-tags. Derudover afvikler de fleste LLM-crawlere og AI-søgeværktøjer ikke JavaScript, hvilket gør indhold usynligt for AI-baserede søgeplatforme, hvis det kun vises efter rendering.

Response HTML er den indledende HTML, der sendes fra serveren (det du ser i 'Vis kilde'). Rendered HTML er det endelige DOM efter JavaScript-eksekvering (det du ser i browserens Inspector). JavaScript kan markant ændre DOM'en ved at indsætte indhold, ændre meta-tags, omskrive titler og tilføje eller fjerne links. Søgemaskiner indekserer baseret på rendered HTML, ikke response HTML.

Server-Side Rendering (SSR) er optimal for SEO, da indholdet er fuldt gengivet på serveren før levering. Client-Side Rendering (CSR) kræver, at søgemaskiner gengiver siderne, hvilket giver forsinkelser og indekseringsproblemer. Dynamisk rendering serverer forudgengivet HTML til crawlere, mens brugere får CSR, men Google anbefaler det kun som en midlertidig løsning. Vælg baseret på dit websites SEO-prioriteter og tekniske ressourcer.

Brug Google Search Consoles URL-inspektionsværktøj: gå til URL-inspektion, klik på 'Test live URL', og se derefter fanen 'HTML' for at se det gengivne HTML, Google har behandlet. Alternativt kan du bruge værktøjer som Screaming Frog med rendering aktiveret, Sitebulbs Response vs Render-rapport eller Chrome DevTools for at sammenligne indledende HTML med rendered DOM og identificere JavaScript-relaterede problemer.

Et render budget er den mængde ressourcer, Google tildeler til at gengive sider på dit site. Google prioriterer rendering for sider, der forventes at få mere søgetrafik. JavaScript-tunge sites med lavere prioritet kan opleve betydelige renderforsinkelser, hvilket sænker indekseringen. Derfor er det afgørende at optimere JavaScript for at reducere renderingstiden og sikre, at kritisk indhold findes i det indledende HTML-svar for at opnå god SEO-ydeevne.

De fleste LLM-crawlere og AI-baserede søgeværktøjer (som Perplexity, Claude og andre) afvikler ikke JavaScript – de læser rå HTML. Hvis dit kritiske indhold kun vises efter JavaScript-eksekvering, er det usynligt for både Googles indledende crawl og AI-søgeplatforme. Derfor er JavaScript SEO ikke kun essentielt for traditionel søgning, men også for synlighed og citationsmuligheder i den nye AI-søgeverden.

Begynd at spore, hvordan AI-chatbots nævner dit brand på tværs af ChatGPT, Perplexity og andre platforme. Få handlingsrettede indsigter til at forbedre din AI-tilstedeværelse.

Content SEO er den strategiske skabelse og optimering af indhold af høj kvalitet for at forbedre søgerangeringer og organisk synlighed. Lær, hvordan du optimere...

Enterprise SEO er praksissen med at optimere store, komplekse websites med tusindvis af sider til søgemaskiner. Lær strategier, udfordringer og bedste praksis f...

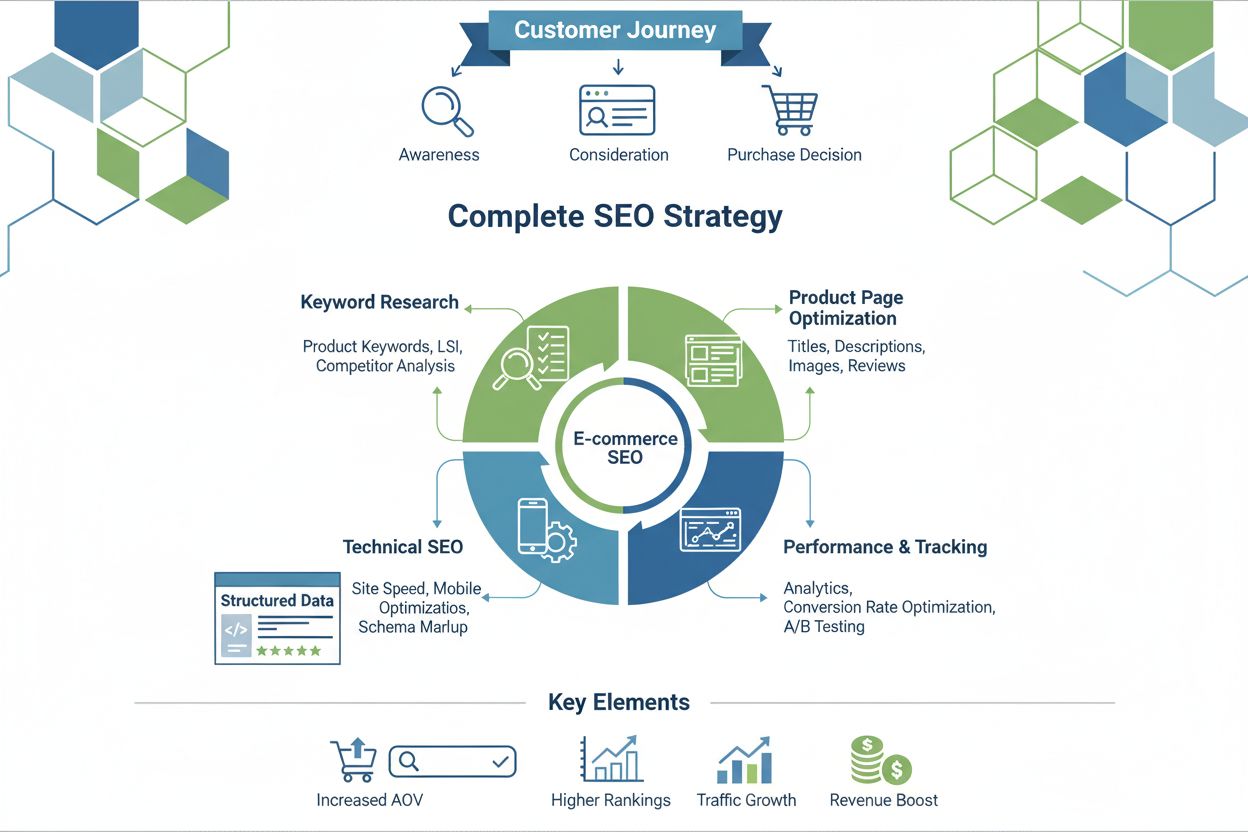

Ecommerce SEO er optimering af onlinebutikker for synlighed i søgninger. Lær søgeordsanalyse, produktsideoptimering, teknisk SEO og konverteringsstrategier for ...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.