AI Crawl Analytics

Lær hvad AI crawl analytics er, og hvordan serverloganalyse sporer AI-crawleres adfærd, adgangsmønstre til indhold og synlighed i AI-drevne søgeplatforme som Ch...

Logfilanalyse er processen med at undersøge serveradgangslogfiler for at forstå, hvordan søgemaskine-crawlere og AI-bots interagerer med et website, hvilket afslører crawlmønstre, tekniske problemer og optimeringsmuligheder for SEO-ydelse.

Logfilanalyse er processen med at undersøge serveradgangslogfiler for at forstå, hvordan søgemaskine-crawlere og AI-bots interagerer med et website, hvilket afslører crawlmønstre, tekniske problemer og optimeringsmuligheder for SEO-ydelse.

Logfilanalyse er den systematiske undersøgelse af serveradgangslogs for at forstå, hvordan søgemaskinecrawlere, AI-bots og brugere interagerer med et website. Disse logs genereres automatisk af webservere og indeholder detaljerede optegnelser over alle HTTP-anmodninger til dit site, herunder anmoderens IP-adresse, tidsstempel, anmodet URL, HTTP-statuskode og user-agent-streng. For SEO-specialister fungerer logfilanalyse som den endelige sandhedskilde om crawler-adfærd og afslører mønstre, som overfladiske værktøjer som Google Search Console eller traditionelle crawlere ikke kan opfange. I modsætning til simulerede crawls eller aggregerede analysedata leverer serverlogs ufiltreret, førstegangsevidens for præcis, hvad søgemaskiner og AI-systemer foretager sig på dit website i realtid.

Vigtigheden af logfilanalyse er vokset eksponentielt i takt med den digitale udvikling. Med over 51% af den globale internettrafik nu genereret af bots (ACS, 2025), og AI-crawlere som GPTBot, ClaudeBot og PerplexityBot som faste gæster på websites, er forståelse af crawler-adfærd ikke længere valgfrit—det er essentielt for at bevare synlighed på både traditionelle søgeplatforme og nye AI-drevne søgeplatforme. Logfilanalyse bygger bro mellem, hvad du tror, der sker på dit site, og hvad der faktisk sker, og muliggør datadrevne beslutninger, der direkte påvirker søgerangeringer, indekseringshastighed og den samlede organiske performance.

Logfilanalyse har været et fundament i teknisk SEO i årtier, men dens relevans er steget dramatisk i de senere år. Historisk set har SEO-specialister primært været afhængige af Google Search Console og tredjeparts-crawlere for at forstå søgemaskineadfærd. Disse værktøjer har dog betydelige begrænsninger: Google Search Console leverer kun aggregerede, samplede data fra Googles crawlere; tredjeparts-crawlere simulerer crawler-adfærd frem for at opfange faktiske interaktioner; og ingen af værktøjerne sporer effektivt ikke-Google søgemaskiner eller AI-bots.

Fremkomsten af AI-drevne søgeplatforme har fundamentalt ændret landskabet. Ifølge Cloudflares forskning fra 2024 udgør Googlebot 39% af al AI- og søgecrawlertrafik, mens AI-specifikke crawlere nu udgør det hurtigst voksende segment. Metas AI-bots genererer alene 52% af AI-crawlertrafikken, mere end dobbelt så meget som Google (23%) eller OpenAI (20%). Denne udvikling betyder, at websites nu modtager besøg fra dusinvis af forskellige bottyper, hvoraf mange ikke følger traditionelle SEO-protokoller eller respekterer standard robots.txt-regler. Logfilanalyse er den eneste metode, der opfanger dette komplette billede, hvilket gør den uundværlig for moderne SEO-strategi.

Det globale marked for loghåndtering forventes at vokse fra $3.228,5 millioner i 2025 til markant højere værdiansættelser i 2029, med en årlig vækstrate (CAGR) på 14,6%. Denne vækst afspejler en stigende erkendelse blandt virksomheder af, at loganalyse er kritisk for sikkerhed, performance-overvågning og SEO-optimering. Organisationer investerer kraftigt i automatiserede loganalysetools og AI-drevne platforme, der kan behandle millioner af logposter i realtid og omdanne rådata til handlingsorienteret indsigt, der driver forretningsresultater.

Når en bruger eller bot anmoder om en side på dit website, behandler webserveren denne anmodning og logger detaljeret information om interaktionen. Denne proces sker automatisk og kontinuerligt, hvilket skaber en omfattende revisionssti over al serveraktivitet. Forståelse af denne proces er essentiel for korrekt fortolkning af logfildata.

Det typiske flow begynder, når en crawler (uanset om det er Googlebot, en AI-bot eller en brugers browser) sender en HTTP GET-anmodning til din server, inklusive en user-agent-streng, der identificerer anmoderen. Din server modtager anmodningen, behandler den og returnerer en HTTP-statuskode (200 for succes, 404 for ikke fundet, 301 for permanent redirect osv.) sammen med det ønskede indhold. Hver af disse interaktioner registreres i serverens access log-fil og skaber en tidsstemplet post, der indeholder IP-adresse, anmodet URL, HTTP-metode, statuskode, svartid, henviser og user-agent-streng.

HTTP-statuskoder er særligt vigtige for SEO-analyse. En 200-statuskode indikerer vellykket sidelevering; 3xx-koder indikerer redirects; 4xx-koder indikerer klientfejl (som 404 Ikke fundet); og 5xx-koder indikerer serverfejl. Ved at analysere fordelingen af disse statuskoder i dine logs kan du identificere tekniske problemer, der forhindrer crawlere i at tilgå dit indhold. Hvis en crawler for eksempel modtager flere 404-svar, når den forsøger at tilgå vigtige sider, signalerer det et problem med døde links eller manglende indhold, der kræver øjeblikkelig handling.

User-agent-strenge er lige så afgørende for at identificere, hvilke bots der besøger dit site. Hver crawler har en unik user-agent-streng, der identificerer den. Googlebots user-agent inkluderer “Googlebot/2.1”, mens GPTBot bruger “GPTBot/1.0”, og ClaudeBot bruger “ClaudeBot.” Ved at analysere disse strenge kan du segmentere dine logdata for at analysere adfærd efter specifik crawlertype og se, hvilke bots der prioriterer hvilket indhold og hvordan deres crawl-mønstre adskiller sig. Denne granulære analyse muliggør målrettede optimeringsstrategier for forskellige søgeplatforme og AI-systemer.

| Aspekt | Logfilanalyse | Google Search Console | Tredjeparts-crawlere | Analysetools |

|---|---|---|---|---|

| Datakilde | Serverlogs (førsteparts) | Googles crawl-data | Simulerede crawls | Brugeradfærds-tracking |

| Fuldstændighed | 100% af alle anmodninger | Samplede, aggregerede data | Kun simuleret | Kun menneskelig trafik |

| Bot-dækning | Alle crawlere (Google, Bing, AI-bots) | Kun Google | Simulerede crawlere | Ingen botdata |

| Historiske data | Fuld historik (opbevaring varierer) | Begrænset tidsramme | Enkelt crawl-snapshot | Historik tilgængelig |

| Indblik i realtid | Ja (med automatisering) | Forsinket rapportering | Nej | Forsinket rapportering |

| Crawlbudget-synlighed | Præcise crawl-mønstre | Overordnet oversigt | Estimeret | Ikke relevant |

| Tekniske problemer | Detaljeret (statuskoder, svartider) | Begrænset indblik | Simulerede problemer | Ikke relevant |

| AI-bot-overvågning | Ja (GPTBot, ClaudeBot, osv.) | Nej | Nej | Nej |

| Pris | Gratis (serverlogs) | Gratis | Betalte værktøjer | Gratis/Betalt |

| Opsætningskompleksitet | Moderat til høj | Simpel | Simpel | Simpel |

Logfilanalyse er blevet uundværlig for at forstå, hvordan søgemaskiner og AI-systemer interagerer med dit website. I modsætning til Google Search Console, der kun giver Googles perspektiv og aggregerede data, opfanger logfiler det komplette billede af al crawleraktivitet. Dette omfattende overblik er essentielt for at identificere spildt crawlbudget, hvor søgemaskiner bruger ressourcer på at crawle lavværdissider i stedet for vigtigt indhold. Forskning viser, at store websites ofte spilder 30-50% af deres crawlbudget på ikke-essentielle URLs som paginerede arkiver, facetteret navigation eller forældet indhold.

Fremkomsten af AI-drevet søgning har gjort logfilanalyse endnu mere kritisk. Efterhånden som AI-bots som GPTBot, ClaudeBot og PerplexityBot bliver faste besøgende på websites, er det nødvendigt at forstå deres adfærd for at optimere synligheden i AI-genererede svar. Disse bots opfører sig ofte anderledes end traditionelle søgecrawlere—de ignorerer måske robots.txt-regler, crawler mere aggressivt eller fokuserer på bestemte indholdstyper. Logfilanalyse er den eneste metode, der afslører disse mønstre, så du kan optimere dit site til AI-opdagelse og samtidig styre bot-adgang via målrettede regler.

Tekniske SEO-problemer, der ellers ville gå ubemærket hen, kan identificeres gennem loganalyse. Redirect-kæder, 5xx-serverfejl, langsom sideindlæsning og problemer med JavaScript-rendering efterlader alle spor i serverlogs. Ved at analysere disse mønstre kan du prioritere rettelser, der direkte påvirker søgemaskinernes adgang og indekseringshastighed. Hvis logs for eksempel viser, at Googlebot konsekvent modtager 503 Service Unavailable-fejl ved crawling af et bestemt afsnit af dit site, ved du præcis, hvor du skal fokusere dine tekniske indsatser.

At få fat i dine serverlogs er det første skridt i logfilanalyse, men processen varierer afhængigt af dit hostingmiljø. For selvhostede servere med Apache eller NGINX er logs typisk gemt i henholdsvis /var/log/apache2/access.log eller /var/log/nginx/access.log. Du kan tilgå disse filer direkte via SSH eller gennem serverens filhåndtering. For managed WordPress-hosting som WP Engine eller Kinsta kan logs være tilgængelige via hosting-dashboardet eller SFTP, selvom nogle udbydere begrænser adgangen for at beskytte serverens ydeevne.

Content Delivery Networks (CDN’er) som Cloudflare, AWS CloudFront og Akamai kræver særlig konfiguration for at tilgå logs. Cloudflare tilbyder Logpush, som sender HTTP-anmodningslogs til udpegede storage-buckets (AWS S3, Google Cloud Storage, Azure Blob Storage) til hentning og analyse. AWS CloudFront tilbyder standardlogging, der kan konfigureres til at gemme logs i S3-buckets. Disse CDN-logs er essentielle for at forstå, hvordan bots interagerer med dit site, når indhold leveres via et CDN, da de opfanger anmodninger ved kanten i stedet for på din origin-server.

Shared hosting-miljøer har ofte begrænset logadgang. Udbydere som Bluehost og GoDaddy tilbyder måske delvise logs via cPanel, men disse logs roterer typisk hyppigt og kan mangle vigtige felter. Hvis du er på shared hosting og har brug for omfattende loganalyse, bør du overveje at opgradere til VPS eller managed hosting, der giver fuld logadgang.

Når du har hentet dine logs, er dataklargøring essentiel. Rå logfiler indeholder anmodninger fra alle kilder—brugere, bots, scrapers og ondsindede aktører. Til SEO-analyse bør du filtrere ikke-relevant trafik fra og fokusere på søgemaskine- og AI-bot-aktivitet. Dette indebærer typisk:

Logfilanalyse afdækker indsigter, der er usynlige for andre SEO-værktøjer, og giver grundlag for strategiske optimeringsbeslutninger. En af de mest værdifulde indsigter er analyse af crawl-mønstre, som viser præcist, hvilke sider søgemaskiner besøger, og hvor ofte. Ved at spore crawl-frekvens over tid kan du se, om Google øger eller mindsker opmærksomheden på bestemte dele af dit site. Pludselige fald i crawl-frekvens kan indikere tekniske problemer eller ændringer i sidens vigtighed, mens stigninger antyder, at Google reagerer positivt på dine optimeringsindsatser.

Effektivitet af crawlbudget er en anden kritisk indsigt. Ved at analysere forholdet mellem succesfulde (2xx) svar og fejlbesvarelser (4xx, 5xx) kan du identificere områder på dit site, hvor crawlere støder på problemer. Hvis et bestemt bibliotek konsekvent returnerer 404-fejl, spildes crawlbudget på døde links. Hvis crawlere bruger uforholdsmæssigt meget tid på paginerede URLs eller facetteret navigation, spilder du budget på lavværdissider. Loganalyse kvantificerer dette spild, så du kan beregne den potentielle effekt af dine optimeringsindsatser.

Opdagelse af forældreløse sider er en unik fordel ved logfilanalyse. Forældreløse sider er URLs uden interne links, der eksisterer uden for dit sites struktur. Traditionelle crawlere overser ofte disse sider, fordi de ikke kan opdage dem via intern linking. Logfiler afslører dog, at søgemaskiner stadig crawler dem—ofte fordi de er linket eksternt eller findes i gamle sitemaps. Ved at identificere disse forældreløse sider kan du beslutte, om de skal integreres på ny, omdirigeres eller fjernes helt.

Analyse af AI-bot-adfærd bliver stadig vigtigere. Ved at segmentere logdata på AI-bot-user-agents kan du se, hvilket indhold disse bots prioriterer, hvor ofte de besøger, og om de støder på tekniske barrierer. Hvis GPTBot for eksempel konsekvent crawler dine FAQ-sider, men sjældent besøger bloggen, antyder det, at AI-systemer finder FAQ-indhold mere værdifuldt til træningsdata. Denne indsigt kan informere din content-strategi og hjælpe dig med at optimere for AI-synlighed.

Succesfuld logfilanalyse kræver både de rette værktøjer og en strategisk tilgang. Screaming Frog’s Log File Analyzer er et af de mest populære dedikerede værktøjer og tilbyder brugervenlige interfaces til behandling af store logfiler, identifikation af botmønstre og visualisering af crawl-data. Botify leverer loganalyse på enterprise-niveau integreret med SEO-metrics, så du kan korrelere botaktivitet med rangeringer og trafik. seoClarity’s Bot Clarity integrerer loganalyse direkte i SEO-platformen, så det er nemt at forbinde crawl-data med andre SEO-metrics.

For organisationer med høj trafik eller kompleks infrastruktur tilbyder AI-drevne loganalyseplatforme som Splunk, Sumo Logic og Elastic Stack avancerede funktioner som automatiseret mønstergenkendelse, anomali-detektion og prædiktiv analyse. Disse platforme kan behandle millioner af logposter i realtid og identificerer automatisk nye bottyper og markerer usædvanlig aktivitet, der kan indikere sikkerhedstrusler eller tekniske problemer.

Best practices for logfilanalyse inkluderer:

Efterhånden som AI-drevet søgning bliver stadig vigtigere, er AI-bot-overvågning gennem logfilanalyse blevet en kritisk SEO-funktion. Ved at spore, hvilke AI-bots der besøger dit site, hvilket indhold de tilgår, og hvor ofte de crawler, kan du forstå, hvordan dit indhold indgår i AI-drevne søgeværktøjer og generative AI-modeller. Disse data gør det muligt at træffe informerede beslutninger om, hvorvidt du vil tillade, blokere eller begrænse specifikke AI-bots via robots.txt-regler eller HTTP-headere.

Crawlbudget-optimering er måske den mest indflydelsesrige anvendelse af logfilanalyse. For store websites med tusindvis eller millioner af sider er crawlbudget en begrænset ressource. Ved at analysere logfiler kan du identificere sider, der bliver over-crawlet i forhold til deres vigtighed, og sider, der burde crawles oftere, men ikke bliver det. Almindelige scenarier for spildt crawlbudget inkluderer:

Ved at adressere disse problemer—gennem robots.txt-regler, canonical-tags, noindex-tags eller tekniske rettelser—kan du dirigere crawlbudgettet mod indhold af høj værdi og forbedre indekseringshastighed og synlighed for de sider, der betyder mest for din forretning.

Logfilanalysens fremtid formes af den hastige udvikling inden for AI-drevet søgning. Efterhånden som flere AI-bots kommer til, og deres adfærd bliver mere sofistikeret, vil logfilanalyse blive endnu mere kritisk for at forstå, hvordan dit indhold opdages, tilgås og bruges af AI-systemer. Fremspirende trends inkluderer:

Realtids-loganalyse drevet af maskinlæring vil gøre det muligt for SEO-specialister at opdage og reagere på crawl-problemer inden for minutter frem for dage. Automatiserede systemer vil identificere nye bottyper, markere usædvanlige mønstre og foreslå optimeringstiltag uden manuel indgriben. Dette skift fra reaktiv til proaktiv analyse vil gøre det muligt for SEO-specialister løbende at opretholde optimal crawlbarhed og indeksering.

Integration med AI-synlighedssporing vil forbinde logfildata med AI-søgeperformance-metrics. I stedet for at analysere logs isoleret vil SEO-specialister korrelere crawleradfærd med faktisk synlighed i AI-genererede svar og forstå præcist, hvordan crawl-mønstre påvirker AI-søgerangeringer. Denne integration vil give hidtil uset indblik i, hvordan indhold bevæger sig fra crawl til AI-træningsdata til brugerrettede AI-svar.

Etisk botstyring vil blive stadig vigtigere, efterhånden som organisationer skal tage stilling til, hvilke AI-bots der skal have adgang til deres indhold. Logfilanalyse muliggør detaljeret styring af botadgang, så udgivere kan tillade gavnlige AI-crawlere, mens de blokerer dem, der ikke tilfører værdi eller attribution. Standarder som det nye LLMs.txt-protokol vil give strukturerede måder at kommunikere botadgangspolitikker på, og loganalyse vil verificere overholdelse.

Privatlivsbevarende analyse vil udvikle sig for at balancere behovet for detaljeret crawlindsigt med privatlivsreguleringer som GDPR. Avancerede anonymiseringsteknikker og privatlivsfokuserede analysetools vil gøre det muligt for organisationer at udtrække værdifuld indsigt fra logs uden at lagre eller eksponere personhenførbare oplysninger. Dette bliver særligt vigtigt, efterhånden som loganalyse bliver mere udbredt, og databeskyttelsesregler bliver skrappere.

Konvergensen mellem traditionel SEO og AI-søgeoptimering betyder, at logfilanalyse vil forblive et grundelement i teknisk SEO-strategi i mange år fremover. Organisationer, der mestrer logfilanalyse i dag, vil have de bedste forudsætninger for at opretholde synlighed og performance, efterhånden som søgning fortsat udvikler sig.

Logfilanalyse giver komplette, usamplede data fra din server, der registrerer enhver anmodning fra alle crawlere, mens Google Search Console's crawlstatistik kun viser aggregerede, samplede data fra Googles crawlere. Logfiler tilbyder granulære historiske data og indblik i ikke-Google bot-adfærd, herunder AI-crawlere som GPTBot og ClaudeBot, hvilket gør dem mere omfattende til at forstå den reelle crawler-adfærd og identificere tekniske problemer, som GSC kan overse.

For højtrafikerede sites anbefales ugentlig logfilanalyse for at fange problemer tidligt og overvåge ændringer i crawlmønstre. Mindre sites får udbytte af månedlige gennemgange for at etablere trends og identificere ny bot-aktivitet. Uanset site-størrelse hjælper implementering af kontinuerlig overvågning via automatiserede værktøjer med at opdage anomalier i realtid, så du hurtigt kan reagere på spildt crawlbudget eller tekniske problemer, der påvirker synligheden i søgning.

Ja, logfilanalyse er en af de mest effektive måder at spore AI-bottrafik på. Ved at undersøge user-agent-strenge og IP-adresser i dine serverlogs kan du identificere, hvilke AI-bots der besøger dit site, hvilket indhold de tilgår, og hvor ofte de crawler. Disse data er afgørende for at forstå, hvordan dit indhold indgår i AI-drevne søgeværktøjer og generative AI-modeller, så du kan optimere for AI-synlighed og styre bot-adgang via robots.txt-regler.

Logfilanalyse afslører adskillige tekniske SEO-problemer, herunder crawlfejl (4xx- og 5xx-statuskoder), redirect-kæder, langsom sideindlæsning, forældreløse sider uden interne links, spildt crawlbudget på lavværdissider, JavaScript-renderingsproblemer og problemer med duplikeret indhold. Den identificerer også forfalsket botaktivitet og hjælper med at opdage, når legitime crawlere støder på tilgængelighedsbarrierer, hvilket gør det muligt at prioritere rettelser, der direkte påvirker søgemaskinesynlighed og indeksering.

Logfilanalyse viser præcis, hvilke sider søgemaskiner crawler, og hvor ofte, hvilket afslører, hvor crawlbudget spildes på lavværdissider som paginerede arkiver, facetteret navigation eller forældede URLs. Ved at identificere disse ineffektiviteter kan du justere din robots.txt-fil, forbedre intern linking til prioriterede sider og implementere canonical-tags for at dirigere crawl-opmærksomhed mod indhold af høj værdi, så søgemaskiner fokuserer på de vigtigste sider for din forretning.

Serverlogfiler registrerer typisk IP-adresser (identificerer anmodningskilder), tidsstempler (hvornår anmodninger fandt sted), HTTP-metoder (normalt GET eller POST), anmodede URLs (præcise sider adganget), HTTP-statuskoder (200, 404, 301 osv.), svartider i bytes, henvisningsinformation og user-agent-strenge (identificerer crawler eller browser). Disse omfattende data gør det muligt for SEO-specialister at rekonstruere præcis, hvad der skete under hver serverinteraktion og identificere mønstre, der påvirker crawlbarhed og indeksering.

Forfalskede bots hævder at være legitime søgemaskinecrawlere, men har IP-adresser, der ikke matcher søgemaskinens offentliggjorte IP-intervaller. For at identificere dem skal du krydstjekke user-agent-strenge (som 'Googlebot') mod officielle IP-intervaller offentliggjort af Google, Bing og andre søgemaskiner. Værktøjer som Screaming Frog's Log File Analyzer validerer automatisk bot-autenticitet. Forfalskede bots spilder crawlbudget og kan belaste din server, så det anbefales at blokere dem via robots.txt eller firewall-regler.

Begynd at spore, hvordan AI-chatbots nævner dit brand på tværs af ChatGPT, Perplexity og andre platforme. Få handlingsrettede indsigter til at forbedre din AI-tilstedeværelse.

Lær hvad AI crawl analytics er, og hvordan serverloganalyse sporer AI-crawleres adfærd, adgangsmønstre til indhold og synlighed i AI-drevne søgeplatforme som Ch...

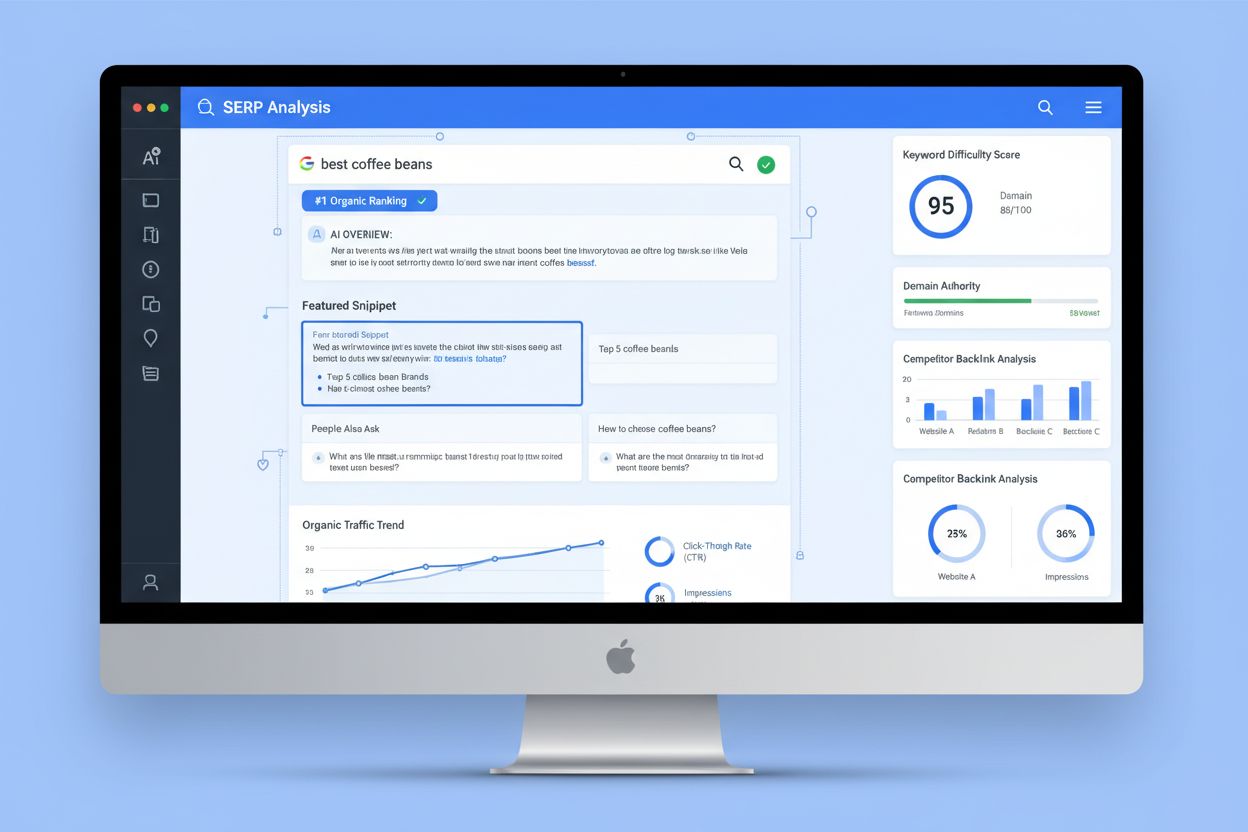

SERP-analyse er processen med at undersøge søgeresultatsider for at forstå rangordningssværhedsgrad, søgehensigt og konkurrentstrategier. Lær hvordan du analyse...

Gap-analyse identificerer muligheder for manglende indhold ved at sammenligne dit site med konkurrenter og publikums behov. Essentiel for SEO og synlighed i AI-...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.