Finjustering af AI-model

Lær, hvordan AI-model finjustering tilpasser fortrænede modeller til specifikke branche- og brandrelaterede opgaver, forbedrer nøjagtigheden og reducerer omkost...

Modelparametre er lærbare variable i AI-modeller, såsom vægte og bias, der automatisk justeres under træning for at optimere modellens evne til at lave præcise forudsigelser og definere, hvordan modellen behandler inputdata for at generere output.

Modelparametre er lærbare variable i AI-modeller, såsom vægte og bias, der automatisk justeres under træning for at optimere modellens evne til at lave præcise forudsigelser og definere, hvordan modellen behandler inputdata for at generere output.

Modelparametre er lærbare variable i kunstige intelligens-modeller, som automatisk justeres under træningsprocessen for at optimere modellens evne til at lave præcise forudsigelser og definere, hvordan modellen behandler inputdata for at generere output. Disse parametre fungerer som de grundlæggende “kontrolknapper” i maskinlæringssystemer og bestemmer den præcise adfærd og beslutningsmønstre i AI-modeller. I konteksten af deep learning og neurale netværk består parametre primært af vægte og bias—numeriske værdier, der styrer, hvordan information flyder gennem netværket, og hvor stærkt forskellige egenskaber påvirker forudsigelser. Formålet med træningen er at finde de optimale værdier for disse parametre, der minimerer forudsigelsesfejl og gør det muligt for modellen at generalisere godt til nye, usete data. Forståelse af modelparametre er afgørende for at forstå, hvordan moderne AI-systemer som ChatGPT, Claude, Perplexity og Google AI Overviews fungerer, og hvorfor de producerer forskellige output til samme input.

Konceptet med lærbare parametre i maskinlæring går tilbage til de tidlige dage med kunstige neurale netværk i 1950’erne og 1960’erne, hvor forskere først indså, at netværk kunne justere interne værdier for at lære af data. Den praktiske anvendelse af parametre var dog begrænset indtil fremkomsten af backpropagation i 1980’erne, som leverede en effektiv algoritme til at beregne, hvordan parametre skulle justeres for at reducere fejl. Eksplosionen i antallet af parametre accelererede dramatisk med fremkomsten af deep learning i 2010’erne. Tidlige konvolutionsneurale netværk til billedgenkendelse indeholdt millioner af parametre, mens moderne store sprogmodeller (LLM’er) indeholder hundredvis af milliarder eller endda billioner af parametre. Ifølge forskning fra Our World in Data og Epoch AI er antallet af parametre i markante AI-systemer vokset eksponentielt, hvor GPT-3 indeholder 175 milliarder parametre, GPT-4o cirka 200 milliarder parametre, og nogle estimater antyder, at GPT-4 kan indeholde op til 1,8 billioner parametre, når man medregner mixture-of-experts-arkitekturer. Denne dramatiske opskalering har fundamentalt ændret, hvad AI-systemer kan opnå, og gjort det muligt at opfange stadig mere komplekse mønstre i sprog, vision og ræsonnement.

Modelparametre fungerer gennem en matematisk ramme, hvor hver parameter repræsenterer en numerisk værdi, der påvirker, hvordan modellen transformerer input til output. I en simpel lineær regressionsmodel består parametrene af hældning (m) og skæring (b) i ligningen y = mx + b, hvor disse to værdier bestemmer den linje, der bedst passer til dataene. I neurale netværk bliver situationen eksponentielt mere kompleks. Hver neuron i et lag modtager input fra det forrige lag, multiplicerer hvert input med en tilsvarende vægt-parameter, summerer disse vægtede input, lægger en bias-parameter til og sender resultatet gennem en aktiveringsfunktion for at producere et output. Dette output bliver derefter input til neuroner i næste lag, hvilket skaber en kaskade af parameterstyrede transformationer. Under træning bruger modellen gradientnedstigning og relaterede optimeringsalgoritmer til at beregne, hvordan hver parameter skal justeres for at reducere tabfunktionen—et matematisk mål for forudsigelsesfejl. Gradienterne af tabet ift. hver parameter viser retningen og størrelsen af den nødvendige justering. Gennem backpropagation flyder disse gradienter baglæns gennem netværket, så optimizer kan opdatere alle parametre simultant på en koordineret måde. Denne iterative proces fortsætter over flere træningsepochs, indtil parametrene konvergerer til værdier, der minimerer tabet på træningsdata, samtidig med at de bevarer god generalisering til nye data.

| Aspekt | Modelparametre | Hyperparametre | Features |

|---|---|---|---|

| Definition | Lærbare variable, der justeres under træning | Konfigurationsindstillinger, der fastsættes før træning | Inputdata-egenskaber, som modellen bruger |

| Hvornår sat | Automatisk lært gennem optimering | Manuel konfigureret af praktikere | Udtrukket eller konstrueret fra rådata |

| Eksempler | Vægte, bias i neurale netværk | Læringsrate, batchstørrelse, antal lag | Pixelværdier i billeder, word embeddings i tekst |

| Indvirkning på model | Bestemmer, hvordan model kortlægger input til output | Styrer træningsprocessen og modelstruktur | Giver rå information, modellen lærer fra |

| Optimeringsmetode | Gradientnedstigning, Adam, AdaGrad | Grid search, random search, Bayesian optimization | Feature engineering, feature selection |

| Antal i store modeller | Milliarder til billioner (fx 200 mia. i GPT-4o) | Typisk 5-20 nøglehyperparametre | Tusinder til millioner afhængigt af data |

| Beregningsomkostning | Høj under træning; påvirker inferenshastighed | Minimal omkostning at sætte | Afhænger af dataindsamling og forbehandling |

| Overførbarhed | Kan overføres via finjustering og transfer learning | Skal justeres for nye opgaver | Kan kræve gen-konstruering for nye domæner |

Modelparametre tager forskellige former afhængigt af arkitekturen og typen af maskinlæringsmodel. I konvolutionsneurale netværk (CNNs) til billedgenkendelse omfatter parametrene vægte i konvolutionsfiltre (også kaldet kerner), der opfanger rumlige mønstre som kanter, teksturer og former på forskellige skalaer. Rekurrente neurale netværk (RNNs) og long short-term memory (LSTM)-netværk indeholder parametre, der styrer informationsflow over tid, herunder gate-parametre, der bestemmer, hvilken information der skal huskes eller glemmes. Transformer-modeller, som driver moderne store sprogmodeller, indeholder parametre i flere komponenter: attention-vægte, der bestemmer, hvilke dele af inputtet der skal fokuseres på, feed-forward-netværksvægte og lag-normaliseringsparametre. I probabilistiske modeller som Naive Bayes definerer parametrene betingede sandsynlighedsfordelinger. Support vector machines bruger parametre, der placerer og orienterer beslutningsgrænser i feature-rummet. Mixture of Experts (MoE)-modeller, som bruges i nogle versioner af GPT-4, indeholder parametre for flere specialiserede subnetværk samt routing-parametre, der bestemmer, hvilke eksperter der behandler hvert input. Denne arkitektoniske diversitet betyder, at karakteren og antallet af parametre varierer betydeligt på tværs af modeltyper, men det grundlæggende princip forbliver det samme: parametre er de lærte værdier, der gør det muligt for modellen at løse sin opgave.

Vægte og bias udgør de to fundamentale typer af parametre i neurale netværk og danner grundlaget for, hvordan disse modeller lærer. Vægte er numeriske værdier tildelt forbindelser mellem neuroner, der bestemmer styrken og retningen af indflydelsen, én neurons output har på næste neurons input. I et fuldt forbundet lag med 1.000 inputneuroner og 500 outputneuroner vil der være 500.000 vægtparametre—én for hver forbindelse. Under træning justeres vægte for at øge eller mindske bestemte egenskabers indflydelse på forudsigelser. En stor positiv vægt betyder, at egenskaben kraftigt aktiverer næste neuron, mens en negativ vægt hæmmer den. Bias er yderligere parametre, én pr. neuron i et lag, der giver et konstant offset til neuronens inputsum, før aktiveringsfunktionen anvendes. Matematisk, hvis en neuron modtager vægtede input, der summerer til nul, gør bias det muligt for neuronen stadig at producere et ikke-nul output, hvilket giver afgørende fleksibilitet. Denne fleksibilitet gør det muligt for neurale netværk at lære komplekse beslutningsgrænser og opfange mønstre, der ikke ville være mulige med vægte alene. I en model med 200 milliarder parametre som GPT-4o udgør langt de fleste vægte i attention-mekanismer og feed-forward-netværk, mens bias udgør en mindre, men stadig betydelig del. Sammen gør vægte og bias det muligt for modellen at lære de indviklede mønstre i sprog, vision eller andre domæner, der gør moderne AI-systemer så kraftfulde.

Antallet af parametre i en model har en dybtgående indvirkning på dens evne til at lære komplekse mønstre og dens samlede ydeevne. Forskning viser konsekvent, at skalalove styrer forholdet mellem parameterantal, træningsdatas størrelse og modelpræstation. Modeller med flere parametre kan repræsentere mere komplekse funktioner og opfange flere nuancerede mønstre i data, hvilket generelt fører til bedre præstation på udfordrende opgaver. GPT-3 med 175 milliarder parametre viste bemærkelsesværdige few-shot learning-evner, som mindre modeller ikke kunne matche. GPT-4o med 200 milliarder parametre giver yderligere forbedringer i ræsonnement, kodegenerering og multimodal forståelse. Forholdet mellem parametre og ydeevne er dog ikke lineært og afhænger kritisk af mængden og kvaliteten af træningsdata. En model med for mange parametre i forhold til træningsdata vil overfitte og huske specifikke eksempler frem for at lære generaliserbare mønstre, hvilket resulterer i dårlig ydeevne på nye data. Omvendt kan en model med for få parametre underfitte og ikke opfange vigtige mønstre, hvilket giver suboptimal ydeevne selv på træningsdata. Det optimale parameterantal for en given opgave afhænger af faktorer som opgavens kompleksitet, træningsdatasættets størrelse og diversitet samt beregningsmæssige begrænsninger. Forskning fra Epoch AI viser, at moderne AI-systemer har opnået bemærkelsesværdige resultater gennem massiv opskalering, hvor nogle modeller indeholder billioner af parametre, når man medregner mixture-of-experts-arkitekturer, hvor ikke alle parametre er aktive for hvert input.

Selvom store modeller med milliarder af parametre opnår imponerende resultater, er de beregningsmæssige omkostninger ved at træne og implementere sådanne modeller betydelige. Dette har drevet forskning i parametereffektive finjusteringsmetoder, der gør det muligt for praktikere at tilpasse fortrænede modeller til nye opgaver uden at opdatere alle parametre. LoRA (Low-Rank Adaptation) er en fremtrædende teknik, der fryser de fleste fortrænede parametre og kun træner et lille sæt ekstra low-rank matricer, hvilket reducerer antallet af trænbare parametre med flere størrelsesordener, mens ydeevnen bevares. For eksempel kan finjustering af en 7 milliarder parametre stor model med LoRA indebære kun at træne 1-2 millioner ekstra parametre i stedet for alle 7 milliarder. Adaptermoduler indsætter små trænbar netværk mellem lagene i en fastfrosset fortrænet model og tilføjer kun en lille procentdel af parametre, mens de muliggør opgavespecifik tilpasning. Prompt engineering og in-context learning er alternative tilgange, der slet ikke ændrer parametre, men i stedet udnytter modellens eksisterende parametre mere effektivt gennem nøje udformede input. Disse parametereffektive tilgange har demokratiseret adgangen til store sprogmodeller og gør det muligt for organisationer med begrænsede ressourcer at tilpasse avancerede modeller til deres specifikke behov. Afvejningen mellem parametereffektivitet og præstation er fortsat et aktivt forskningsområde, hvor praktikere balancerer ønsket om beregningsmæssig effektivitet mod behovet for opgavespecifik nøjagtighed.

Forståelse af modelparametre er afgørende for platforme som AmICited, der overvåger, hvordan brands og domæner fremtræder i AI-genererede svar på tværs af systemer som ChatGPT, Perplexity, Claude og Google AI Overviews. Forskellige AI-modeller med forskellige parameterkonfigurationer producerer forskellige output til samme forespørgsel, hvilket påvirker hvor og hvordan brands nævnes. De 200 milliarder parametre i GPT-4o er konfigureret anderledes end parametrene i Claude 3.5 Sonnet eller Perplexitys modeller, hvilket fører til variationer i svar. Parametre, der er lært under træning på forskellige datasæt og med forskellige træningsmål, får modeller til at have forskellige viden, ræsonnement og citationsmønstre. Når man overvåger brandnævnelse i AI-svar, hjælper forståelse af, at disse forskelle stammer fra parameterforskelle, med at forklare, hvorfor et brand kan være fremhævet i ét AI-svar, men knap nævnt i et andet. Parametrene, der styrer attention-mekanismer, afgør, hvilke dele af modellens træningsdata der er mest relevante for en forespørgsel, og påvirker citationsmønstre. Parametre i outputgenereringslagene bestemmer, hvordan modellen strukturerer og præsenterer information. Ved at spore, hvordan forskellige AI-systemer med forskellige parameterkonfigurationer nævner brands, giver AmICited indsigt i, hvordan parameterstyret modeladfærd påvirker brandets synlighed i det AI-drevne søgelandskab.

Modelparametres fremtid formes af flere sammenfaldende tendenser, der fundamentalt vil ændre, hvordan AI-systemer designes og implementeres. Mixture of Experts (MoE)-arkitekturer udgør en væsentlig udvikling, hvor modeller indeholder flere specialiserede subnetværk (eksperter) med separate parametre, og en routingmekanisme afgør, hvilke eksperter der behandler hvert input. Denne tilgang gør det muligt for modeller at skalere til billioner af parametre, mens de bevarer beregningsmæssig effektivitet under inferens, da ikke alle parametre er aktive for hvert input. GPT-4 bruger angiveligt en MoE-arkitektur med 16 eksperter, hver med 110 milliarder parametre, hvilket giver i alt 1,8 billioner parametre, men kun en brøkdel anvendes under inferens. Spredte parametre og pruning-teknikker udvikles til at identificere og fjerne mindre vigtige parametre, hvilket reducerer modelstørrelsen uden at gå på kompromis med ydeevnen. Kontinuerlig læring sigter mod at opdatere parametre effektivt, efterhånden som nye data bliver tilgængelige, så modeller kan tilpasse sig uden fuld gen-træning. Fødereret læring distribuerer parametertræning over flere enheder og bevarer privatliv, så organisationer kan drage fordel af træning i stor skala uden at centralisere følsomme data. Fremkomsten af små sprogmodeller (SLM’er) med milliarder i stedet for hundreder af milliarder af parametre peger på en fremtid, hvor parametereffektivitet bliver lige så vigtig som selve parameterantallet. Efterhånden som AI-systemer integreres mere i kritiske anvendelser, bliver forståelse og kontrol af modelparametre stadig vigtigere for at sikre sikkerhed, retfærdighed og overensstemmelse med menneskelige værdier. Forholdet mellem parameterantal og modeladfærd vil fortsat være et centralt fokus i AI-forskning, med implikationer for alt fra bæredygtighed til fortolkelighed og tillid til AI-systemer.

Modelparametre er interne variable, der læres under træning gennem optimeringsalgoritmer som gradientnedstigning, mens hyperparametre er eksterne indstillinger, der konfigureres før træningen starter. Parametre bestemmer, hvordan modellen oversætter input til output, mens hyperparametre styrer selve træningsprocessen, såsom læringsrate og antal epoker. For eksempel er vægte og bias i neurale netværk parametre, mens læringsraten er en hyperparameter.

Moderne store sprogmodeller indeholder milliarder til billioner af parametre. GPT-4o indeholder cirka 200 milliarder parametre, mens GPT-4o-mini har omkring 8 milliarder parametre. Claude 3.5 Sonnet arbejder også med hundredvis af milliarder parametre. Disse enorme mængder af parametre gør det muligt for modellerne at opfange komplekse mønstre i sprog og generere sofistikerede, kontekstuelt relevante svar på tværs af forskellige emner.

Flere parametre øger en models kapacitet til at lære komplekse mønstre og relationer i data. Med flere parametre kan modeller repræsentere mere nuancerede egenskaber og interaktioner, hvilket giver højere nøjagtighed på træningsdata. Dog er der en kritisk balance: for mange parametre i forhold til træningsdata kan føre til overfitting, hvor modellen husker støj fremfor at lære generaliserbare mønstre, hvilket resulterer i dårlig ydeevne på nye, usete data.

Modelparametre opdateres gennem backpropagation og optimeringsalgoritmer som gradientnedstigning. Under træning laver modellen forudsigelser, beregner tabet (fejlen) mellem forudsigelser og faktiske værdier og beregner derefter gradienter, der viser, hvordan hver parameter har bidraget til fejlen. Optimizer justerer så parametrene i den retning, der reducerer tabet, og denne proces gentages gennem flere træningsiterationer, indtil modellen konvergerer til optimale værdier.

Vægte bestemmer styrken af forbindelser mellem neuroner i neurale netværk og styrer, hvor meget inputegenskaber påvirker output. Bias fungerer som tærskeljusteringer, der gør det muligt for neuroner at aktivere, selv når vægtede input er nul, hvilket giver fleksibilitet og gør det muligt for modellen at lære grundmønstre. Sammen udgør vægte og bias de centrale lærbare parametre, der gør det muligt for neurale netværk at tilnærme komplekse funktioner og lave præcise forudsigelser.

Modelparametre påvirker direkte, hvordan AI-systemer som ChatGPT, Perplexity og Claude behandler og besvarer forespørgsler. Forståelse af parameterantal og konfigurationer hjælper med at forklare, hvorfor forskellige AI-modeller producerer forskellige output til samme prompt. For brandovervågningsplatforme som AmICited er det afgørende at spore, hvordan parametre påvirker modeladfærd, for at kunne forudsige, hvor brands dukker op i AI-svar, og forstå konsistensen på tværs af forskellige AI-systemer.

Ja, gennem transfer learning kan parametre fra en fortrænet model tilpasses til nye opgaver. Denne tilgang, kaldet finjustering, indebærer at tage en model med lærte parametre og justere dem på nye data til specifikke anvendelser. Parameter-effektive finjusteringsmetoder som LoRA (Low-Rank Adaptation) gør det muligt selektivt at opdatere parametre, hvilket reducerer beregningsomkostningerne, mens ydeevnen bevares. Denne teknik bruges bredt til at tilpasse store sprogmodeller til specialiserede domæner.

Modelparametre påvirker direkte de beregningsmæssige krav både under træning og inferens. Flere parametre kræver mere hukommelse, processorkraft og tid at træne og implementere. En model med 175 milliarder parametre (som GPT-3) kræver markant flere ressourcer end en model med 7 milliarder parametre. Dette forhold er afgørende for organisationer, der implementerer AI-systemer, da antallet af parametre påvirker infrastrukturens omkostninger, latenstid og energiforbrug i produktionsmiljøer.

Begynd at spore, hvordan AI-chatbots nævner dit brand på tværs af ChatGPT, Perplexity og andre platforme. Få handlingsrettede indsigter til at forbedre din AI-tilstedeværelse.

Lær, hvordan AI-model finjustering tilpasser fortrænede modeller til specifikke branche- og brandrelaterede opgaver, forbedrer nøjagtigheden og reducerer omkost...

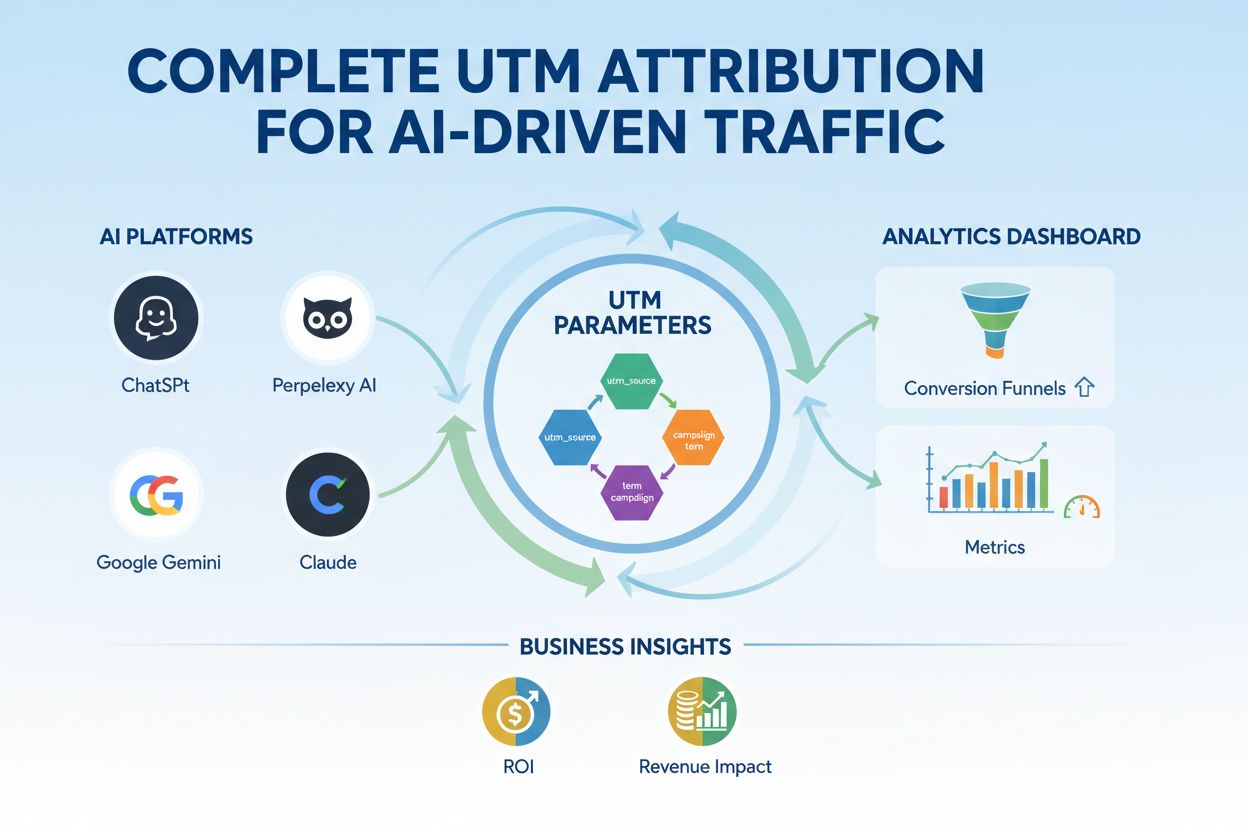

Bliv ekspert i UTM-tracking for AI-platforme som ChatGPT, Perplexity og Google Gemini. Lær opsætning, best practices og hvordan du korrekt attribuerer AI-trafik...

Sammenlign optimering af træningsdata og realtids-hentningsstrategier for AI. Lær hvornår du skal bruge finjustering vs. RAG, omkostningsimplikationer og hybrid...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.