Hvad er Prompt Engineering for AI-søgning - Komplet Guide

Lær hvad prompt engineering er, hvordan det fungerer med AI-søgemaskiner som ChatGPT og Perplexity, og opdag essentielle teknikker til at optimere dine AI-søger...

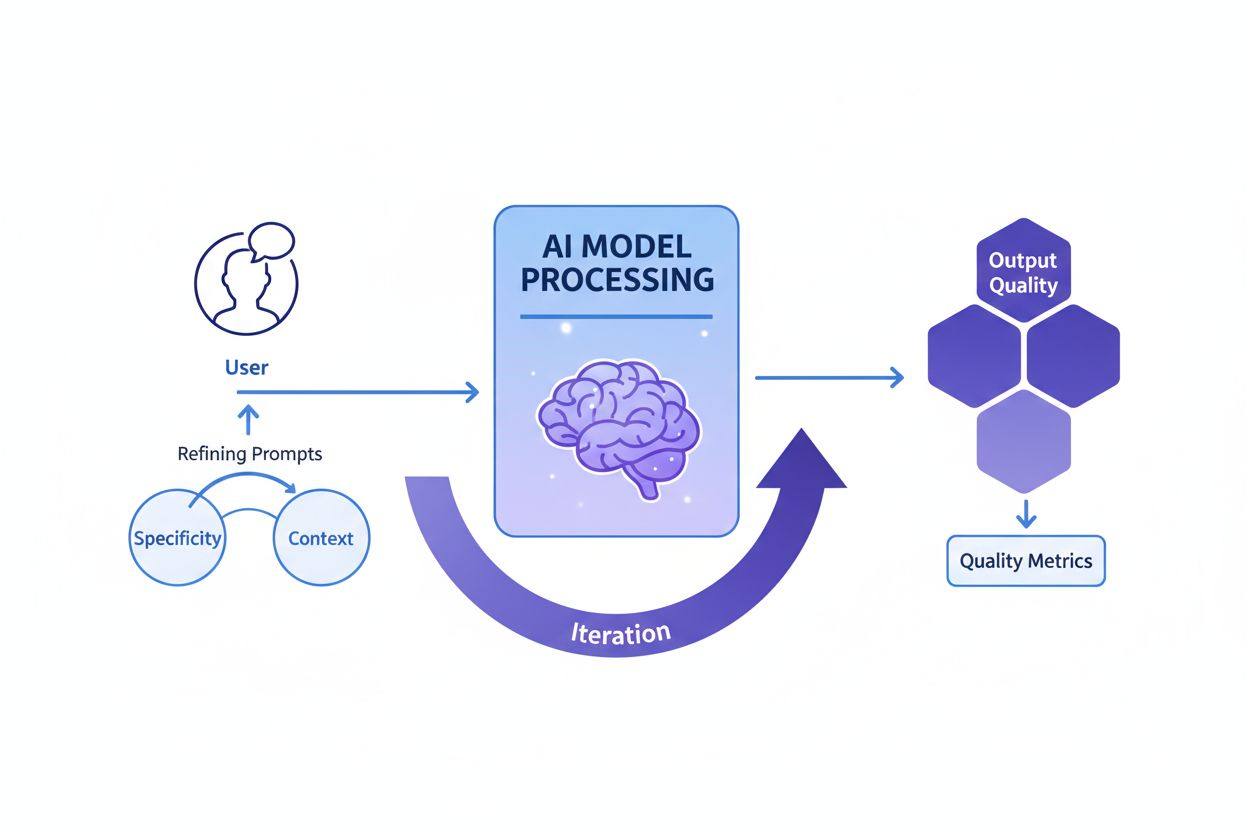

Prompt engineering er processen med at udforme, forfine og optimere naturlige sprog-instruktioner for at guide generative AI-modeller mod at producere ønskede, præcise og relevante resultater. Det indebærer iterativ eksperimentering med formulering, kontekst og struktur for at maksimere AI’ens ydeevne uden at ændre den underliggende model.

Prompt engineering er processen med at udforme, forfine og optimere naturlige sprog-instruktioner for at guide generative AI-modeller mod at producere ønskede, præcise og relevante resultater. Det indebærer iterativ eksperimentering med formulering, kontekst og struktur for at maksimere AI'ens ydeevne uden at ændre den underliggende model.

Prompt engineering er den systematiske proces med at designe, forfine og optimere naturlige sprog-instruktioner—kaldet prompts—til at guide generative AI-modeller mod at producere ønskede, præcise og kontekstuelt relevante outputs. I stedet for at ændre den underliggende AI-model arbejder prompt-ingeniører med modellens eksisterende kapaciteter ved nøje at strukturere deres input for at påvirke, hvordan modellen behandler information og genererer svar. Denne disciplin opstod som en afgørende kompetence under generativ AI-boomet 2023-2025, hvor organisationer indså, at adgang til kraftfulde AI-værktøjer som ChatGPT, Claude, Perplexity og Google AI ikke var tilstrækkeligt uden ekspertise i effektiv kommunikation med disse systemer. Prompt engineering bygger bro mellem menneskelig hensigt og AI-kapacitet og omsætter uklare forretningsmål til handlingsrettede, høj-kvalitets AI-outputs. Praksissen er grundlæggende iterativ og kræver kontinuerlig eksperimentering, test og forfining for at opnå optimale resultater for specifikke brugsscenarier.

Begrebet prompt engineering opstod organisk efter den offentlige lancering af ChatGPT i november 2022, hvor millioner af brugere begyndte at eksperimentere med at få bedre resultater fra store sprogmodeller. Tidlige brugere opdagede, at kvaliteten af AI-outputs varierede dramatisk afhængigt af, hvordan spørgsmål blev formuleret, hvilken kontekst der blev givet, og hvor specifikke instruktionerne var. Denne observation førte til formaliseringen af prompt engineering som en særskilt disciplin. Allerede i 2023 begyndte store teknologivirksomheder som OpenAI, Google, Microsoft og Anthropic at ansætte dedikerede prompt-ingeniører, hvor nogle stillinger tilbød lønninger på over $300.000. Det globale prompt engineering-marked blev vurderet til cirka $222,1 millioner i 2023 og forventes at nå $2,06 milliarder i 2030, hvilket repræsenterer en betydelig årlig vækstrate (CAGR). Denne hurtige markedsudvikling afspejler den stigende erkendelse af, at prompt engineering ikke er en forbigående trend, men en grundlæggende kompetence for organisationer, der anvender AI i stor skala. Disciplinen har udviklet sig fra simpel trial-and-error til en sofistikeret praksis, der inkorporerer etablerede teknikker, evalueringsrammer og bedste praksisser dokumenteret af ledende AI-forskningsinstitutioner og branchefolk.

Effektiv prompt engineering bygger på flere fundamentale principper, der adskiller højkvalitets-prompter fra ineffektive. Specificitet er altafgørende—jo mere detaljeret og beskrivende en prompt er, desto bedre kan AI-modellen forstå de præcise krav og generere tilpassede outputs. I stedet for at bede en AI om at “skrive om hunde”, kan en specifik prompt være: “lav en 300-ords veterinærguide om golden retrievers sundhedsproblemer, skrevet til hundeejere på 8. klasses læseniveau med fokus på forebyggende pleje.” Kontekstgivning er lige så kritisk; at give relevant baggrundsinformation, eksempler eller begrænsninger hjælper modellen med at fokusere og levere mere relevante svar. Klarhed sikrer, at instruktionerne er utvetydige og direkte kommunikerer den ønskede opgave uden at overlade det til modellen at tolke vag formulering. Iterativ forfining anerkender, at den første prompt sjældent giver optimale resultater; succesfulde prompt-ingeniører tester løbende variationer, analyserer outputs og tilpasser deres tilgang baseret på resultaterne. Tone- og stilmæssig tilpasning indebærer at specificere ønsket stemme, formalitetsniveau og præsentationsformat for at sikre, at outputs matcher organisationens eller brugerens forventninger. Disse principper gælder på tværs af alle AI-platforme, uanset om brugerne udformer prompts til ChatGPT, Perplexity, Claude eller Google AI Overviews, hvilket gør dem universelt værdifulde for alle, der søger at optimere AI-interaktioner.

Feltet for prompt engineering har udviklet adskillige sofistikerede teknikker til at håndtere forskellige opgavetyper og kompleksitetsniveauer. Zero-shot prompting er den mest direkte tilgang, hvor AI’en får en klar instruktion eller et spørgsmål uden yderligere eksempler eller kontekst. Denne metode fungerer godt til simple opgaver, men kan have vanskeligt ved kompleks ræsonnement. Few-shot prompting forbedrer ydeevnen ved at give modellen et eller flere eksempler, som demonstrerer det ønskede outputformat eller ræsonnementsmønster og derved lærer modellen gennem demonstration. Chain-of-thought (CoT) prompting opdeler komplekse problemer i mellemregninger, opmuntrer modellen til at vise sit arbejde og forbedrer nøjagtigheden på flertrinsopgaver. Prompt chaining deler en kompleks opgave op i mindre, sekventielle delopgaver, hvor outputtet fra én prompt bruges som input til den næste, hvilket øger pålideligheden og konsistensen i komplekse workflows. Tree-of-thought prompting generaliserer chain-of-thought ved at udforske flere mulige ræsonnementsspor samtidig, så modellen kan evaluere forskellige tilgange, før den vælger den mest lovende. Maieutic prompting involverer at bede modellen forklare sin ræsonnement, hvorefter opfølgende spørgsmål stilles til specifikke dele af forklaringen for at identificere og rette inkonsistenser. Generated knowledge prompting instruerer modellen i at generere relevante fakta eller baggrundsinformation, før den forsøger hovedopgaven, hvilket giver modellen brugbar kontekst. Self-refine prompting lader modellen løse et problem, kritisere sin egen løsning og derefter revidere på baggrund af kritikken indtil tilfredsstillende resultater opnås. Hver teknik har sine formål, og den mest effektive prompt engineering kombinerer ofte flere teknikker strategisk tilpasset den aktuelle opgave.

| Teknik | Bedst til | Kompleksitet | Typisk brugsscenarie | Effektivitet |

|---|---|---|---|---|

| Zero-shot Prompting | Simple, direkte opgaver | Lav | Basale spørgsmål, ligefremme instruktioner | God til simple opgaver, begrænset ved komplekst ræsonnement |

| Few-shot Prompting | Opgaver, der kræver formatkonsistens | Mellem | Indholdsgenerering, klassifikation, formatering | Fremragende til at demonstrere ønskede outputmønstre |

| Chain-of-Thought | Problemer med flere trin | Mellem-høj | Matematikopgaver, logisk deduktion, analyse | Forbedrer nøjagtighed væsentligt på komplekse opgaver |

| Prompt Chaining | Komplekse workflows med afhængigheder | Høj | Flertrins indholdsskabelse, databehandling | Fremragende til at nedbryde komplekse problemer |

| Tree-of-Thought | Problemer med flere løsningsveje | Høj | Strategisk planlægning, kreativ problemløsning | Suveræn til at udforske alternative tilgange |

| Generated Knowledge | Opgaver med behov for baggrundskontekst | Mellem | Domænespecifikke spørgsmål, tekniske forklaringer | Forbedrer relevans og nøjagtighed via kontekst |

| Self-Refine | Kvalitetskritiske anvendelser | Høj | Faglig skrivning, teknisk dokumentation | Giver højest kvalitet gennem iteration |

At forstå hvordan prompts påvirker AI-modellers adfærd kræver grundlæggende kendskab til, hvordan store sprogmodeller (LLMs) fungerer. Disse modeller behandler tekst ved at opdele den i tokens (små tekst-enheder) og forudsige det mest sandsynlige næste token baseret på mønstre lært under træning. Prompten fungerer som den indledende kontekst, der former alle efterfølgende forudsigelser. Når en prompt indeholder specifikke instruktioner, eksempler eller begrænsninger, indsnævrer den effektivt sandsynlighedsfordelingen for mulige outputs og guider modellen mod svar, der matcher promptens intention. Temperature- og top-p sampling-parametre påvirker yderligere outputvariationen—lav temperatur giver mere deterministiske, fokuserede svar, mens høj temperatur øger kreativitet og diversitet. Kontekstvinduet (den mængde tekst modellen kan tage i betragtning) begrænser, hvor meget information man kan inkludere i en prompt; længere prompts fylder mere i vinduet og reducerer pladsen til selve opgaven. Effektive prompt-ingeniører forstår disse tekniske begrænsninger og designer prompts, der fungerer inden for dem. For organisationer, der overvåger brandsynlighed på tværs af AI-platforme via værktøjer som AmICited, er forståelse af disse mekanismer afgørende, fordi de prompts brugerne indtaster bestemmer, hvilke informationer AI-systemer finder og citerer. En veludført prompt, der beder AI’en om at “nævn de tre førende virksomheder inden for cloud computing”, vil give andre resultater end “nævn innovative cloud computing-virksomheder grundlagt efter 2015”, hvilket kan påvirke, hvilke brands får synlighed i AI-genererede svar.

Implementering af effektiv prompt engineering i organisatoriske sammenhænge kræver, at man følger etablerede bedste praksisser, som er opstået gennem både akademisk forskning og brancheerfaring. Start simpelt og iterer er grundprincippet—begynd med en basal prompt og tilføj gradvist kompleksitet, mens du tester undervejs for at se, hvilke ændringer der forbedrer resultaterne. Vær eksplicit om krav ved tydeligt at angive ønsket outputformat, længde, tone og eventuelle begrænsninger; vage prompts giver vage resultater. Giv relevant kontekst uden at overvælde modellen; tilføj baggrund, der hjælper modellen med at forstå opgaven, men undgå unødvendige detaljer, der fylder i kontekstvinduet. Brug klare separatorer som “###” eller “—” for at skelne forskellige afsnit i en prompt (instruktioner, kontekst, eksempler), så modellen lettere kan afkode strukturen. Undgå negationer ved at sige, hvad du ønsker, frem for hvad du ikke ønsker; i stedet for “vær ikke for formel”, sig “brug en samtaletone”. Test flere variationer systematisk, så kun ét element ændres ad gangen for at se, hvad der giver bedre resultater. Dokumentér succesfulde prompts i et centralt bibliotek, så teams kan genbruge og tilpasse afprøvede skabeloner. Overvåg performancemetrikker som nøjagtighed, relevans, konsistens og brugertilfredshed for objektivt at vurdere, om prompts opfylder deres mål. Indfør feedbackloops, hvor brugerfeedback direkte informerer prompt-forfiningen og skaber en kontinuerlig forbedringscyklus. Organisationer, der implementerer disse praksisser, rapporterer markante forbedringer i AI-outputkvalitet og konsistens og reducerer tiden brugt på manuelle rettelser og revisioner.

Sammenhængen mellem prompt engineering og AI-synlighedsovervågning bliver stadig vigtigere for organisationer, der ønsker at forstå, hvordan deres brands, produkter og indhold fremstår i AI-genererede svar. Platforme som AmICited sporer brandomtaler på tværs af ChatGPT, Perplexity, Google AI Overviews og Claude, men de prompts brugerne indtaster i disse systemer afgør direkte, hvilke informationer AI’en henter og citerer. Organisationer, der forstår prompt engineering, kan udforme strategiske forespørgsler for at se, hvordan deres brand repræsenteres, hvilke konkurrenter der nævnes, og om deres indhold bliver korrekt citeret. For eksempel kan en virksomhed udforme prompts som “Hvad er de bedste løsninger til enterprise data management?” for at se, hvordan AI-systemer positionerer deres tilbud i forhold til konkurrenter. Ved at analysere hvilke prompts, der giver fordelagtige eller ufordelagtige brandomtaler, kan organisationer udvikle indholdsstrategier, der forbedrer deres synlighed i AI-svar. Dette repræsenterer en ny grænse for søgemaskineoptimering (SEO) og brand management, hvor forståelse af AI-kommunikation bliver lige så vigtig som traditionel søgeordsoptimering. Virksomheder, der investerer i prompt engineering-kompetencer, opnår strategiske fordele i det AI-drevne informationslandskab og sikrer, at deres brands får passende synlighed og korrekt repræsentation.

At måle, om en prompt er virkelig effektiv, kræver, at der opstilles klare, objektive kriterier, der stemmer overens med forretningsmålene. Nøjagtighed måler, om outputs er faktuelt korrekte, hvilket er særligt vigtigt for brancher som sundhed, finans og jura, hvor fejl har store konsekvenser. Relevans vurderer, hvor tæt outputtet matcher brugerens oprindelige hensigt, ofte målt med semantiske lighedsscorer eller manuel evaluering. Konsistens vurderer, om identiske prompts giver lignende svar på tværs af flere forsøg, hvilket er vigtigt for pålidelige applikationer. Fuldstændighed afgør, om svarene dækker alle nødvendige elementer eller informationer, målt som forholdet mellem dækkede og samlede krav. Specificitet vurderer detaljegraden i svarene, vigtigt for teknisk dokumentation og specialiserede områder. Læsbarhed og sammenhæng måler klarhed og logisk flow, vurderet gennem læsbarhedsformler eller menneskelig evaluering. Brugertilfredshed afspejler, hvor tilfredse slutbrugerne er med outputs, typisk indsamlet via spørgeskemaer eller indlejrede feedback-mekanismer. Organisationer, der implementerer omfattende evalueringsrammer, rapporterer, at prompt-effektivitet forbedres med 40-60% gennem systematisk måling og forfining. Værktøjer som Portkey, DSPy og Hugging Face’s Evaluate Library tilbyder automatiserede metrikker til vurdering af disse dimensioner, mens A/B-testplatforme muliggør side-om-side-sammenligning af forskellige prompt-versioner. De mest avancerede organisationer kombinerer flere evalueringsmetoder og vægter metrikker i forhold til deres prioriteter for at skabe en samlet promptkvalitetsscore.

Jobmarkedet for prompt engineering har oplevet eksplosiv vækst, hvilket afspejler vigtigheden af denne kompetence i AI-tidsalderen. Pr. 2025 rapporterer Glassdoor en gennemsnitlig grundløn på ca. 123.274 USD årligt for prompt-ingeniører, med stillinger fra $90.000 på 25-percentilen til over $335.000 for specialiserede roller hos førende AI-virksomheder som Anthropic. Indeed har over 110.000 åbne prompt engineer-stillinger, hvilket indikerer fortsat efterspørgsel på tværs af brancher. Store teknologivirksomheder som Google, Microsoft, Amazon og Meta rekrutterer aktivt prompt-ingeniører med lønintervaller på $110.000-$250.000. AI-fokuserede virksomheder som OpenAI, Anthropic, Cohere og Midjourney tilbyder udfordringer på forkant med teknologien, fjernarbejde og betydelige aktiepakker. Virksomheder i finans, sundhed, forsikring og andre regulerede sektorer ansætter prompt-ingeniører til AI-integration, ofte under titler som “AI Solutions Architect.” Konsulenthuse inklusiv Big Four og specialiserede firmaer som Booz Allen Hamilton annoncerer stillinger op til $212.000 til offentlige og erhvervsprojekter. Freelance-muligheder på platforme som Upwork og Toptal giver $100-$300 i timen for erfarne professionelle. Karrierevejen kræver typisk en bachelorgrad i datalogi eller beslægtede områder, men personer med baggrund i bl.a. skrivning, journalistik og kreative fag har også haft succes med at skifte til prompt engineering. Succes i feltet afhænger især af dokumenterede færdigheder med AI-værktøjer, en portefølje med eksempler på prompt engineering og løbende læring.

Prompt engineering står over for betydelig udvikling i takt med, at AI-teknologien skrider frem, og organisatoriske praksisser modnes. Multimodal prompting vil i stigende grad kombinere tekst, kode, billeder og andre datatyper i enkelt-prompter, hvilket kræver indsigt i, hvordan forskellige modaliteter interagerer i AI-systemer. Adaptive prompts der automatisk tilpasser sig kontekst, brugeradfærd og realtids-feedback bliver mere sofistikerede, og feltet bevæger sig fra statiske skabeloner mod dynamiske, responsive systemer. Context engineering vokser frem som en videreudvikling af prompt engineering og lægger vægt på den bredere kontekst, prompterne indgår i, frem for kun selve prompt-teksten. Etisk og fairness-fokuseret prompting får større betydning, i takt med at organisationer prioriterer ansvarlig AI med prompts, der minimerer bias, sikrer gennemsigtighed og overholder regulativer. Integration med AI-agenter vil udviske grænsen mellem prompt engineering og bredere AI-orchestration, idet prompts bliver komponenter i større autonome systemer. Rollen som “prompt engineer” kan udvikle sig eller fusionere med beslægtede roller som “AI-strateg”, “context engineer” eller “AI product manager”, hvilket afspejler feltets modning. Organisationer, der investerer i prompt engineering-kompetencer i dag, vil være godt positioneret til at føre an i den AI-drevne økonomi, da evnen til effektivt at kommunikere med og guide AI-systemer bliver stadig mere central for at opnå konkurrencemæssige fordele. For virksomheder, der bruger AmICited til at overvåge brandsynlighed i AI-svar, vil viden om prompt engineering blive afgørende for at optimere deres tilstedeværelse i AI-søgelandskabet og sikre korrekt repræsentation på tværs af platforme som ChatGPT, Perplexity, Google AI og Claude.

Prompt engineering adskiller sig fundamentalt fra traditionel programmering: i stedet for at skrive eksplicit kode, der direkte styrer adfærd, guider prompt-ingeniører AI-modeller gennem naturlige sprog-instruktioner. Traditionel programmering kræver præcis syntaks og logik, mens prompt engineering bygger på iterativ forfining, kontekst og strategisk formulering for at styre AI-resultater mod ønskede mål. Begge kræver problemløsningsevner, men prompt engineering lægger vægt på kommunikation og eksperimentering frem for streng kode-syntaks.

Prompt engineering påvirker direkte, hvordan brands fremstår i AI-genererede svar på tværs af platforme som ChatGPT, Perplexity, Google AI Overviews og Claude. Veludførte prompter kan afgøre, om og hvordan AI-systemer citerer, nævner eller anbefaler brands. For organisationer, der bruger værktøjer som AmICited til at overvåge AI-synlighed, hjælper forståelse af prompt engineering med at forudsige og optimere, hvordan deres brand fremstår i AI-svar og sikrer korrekt repræsentation og konkurrencedygtig positionering i AI-søgelandskabet.

Vigtige teknikker inkluderer chain-of-thought prompting (opdeling af komplekse problemer i trin), few-shot prompting (at give eksempler), zero-shot prompting (direkte instruktioner), prompt chaining (opdeling af opgaver i delopgaver) og tree-of-thought prompting (udforskning af flere ræsonnementspor). Effektiviteten af hver teknik afhænger af opgavens kompleksitet, modellens evner og den ønskede output-type. De mest succesfulde implementeringer kombinerer flere teknikker tilpasset den specifikke anvendelse.

Prompt-effektivitet måles ved hjælp af metrikker som nøjagtighed (faktuel korrekthed), relevans (overensstemmelse med hensigt), konsistens (reproducerbarhed), fuldstændighed (dækning af påkrævede elementer) og brugertilfredshed. Evalueringsmetoder omfatter manuel gennemgang, automatiseret vurdering med værktøjer som BLEU og ROUGE, A/B-test af forskellige prompt-versioner og indsamling af direkte brugerfeedback. Organisationer kombinerer ofte flere metrikker i en vægtet score, der afspejler deres specifikke prioriteter.

Prompt-ingeniører skal have stærke kommunikations- og skrivefærdigheder, forståelse for hvordan store sprogmodeller fungerer, kendskab til AI-begreber som tokenisering og kontekst-vinduer og kreative problemløsningsevner. Tekniske færdigheder i Python, SQL eller JavaScript er ofte foretrukket, men ikke altid nødvendige. Domæneekspertise inden for specifikke brancher (sundhed, finans, jura) honoreres særligt. Allervigtigst demonstrerer succesfulde prompt-ingeniører kontinuerlig læring og eksperimentering.

Prompt engineering er afgørende for AI-overvågning, fordi de prompts brugere indtaster i AI-systemer bestemmer, hvilke informationer systemerne henter og citerer. Ved at forstå prompt engineering kan organisationer udforme forespørgsler, der hjælper dem med at opdage, hvordan deres brand, indhold eller domæne fremstår i AI-svar. AmICited sporer disse forekomster på tværs af flere AI-platforme, hvilket gør prompt engineering viden essentiel for at optimere brandsynlighed i AI-genereret indhold.

Jobmarkedet for prompt engineering forbliver robust med gennemsnitlige lønninger omkring 123.274 USD årligt ifølge Glassdoor, med stillinger fra 90.000 til over 335.000 USD afhængigt af erfaring og virksomhed. Over 110.000 prompt engineer-stillinger er i øjeblikket åbne på jobportaler. Feltet udvikler sig fra en specialiseret rolle mod bredere AI-integrationsansvar med muligheder på tværs af teknologivirksomheder, virksomheder, konsulenthuse og freelanceplatforme. Fjernarbejde er udbredt, hvilket gør geografisk placering mindre restriktiv.

Prompt engineering forventes at udvikle sig mod multimodal prompting (kombination af tekst, kode og billeder), adaptive prompts der tilpasser sig kontekst, og øget fokus på AI-etik og fairness. Efterhånden som AI-modeller bliver mere avancerede, kan prompt engineering smelte sammen med bredere AI-strategi- og kontekst-engineering-roller. Feltet vil sandsynligvis lægge vægt på ansvarlig AI-praksis, bias-reduktion og sikring af gennemsigtighed i AI-genererede outputs på tværs af platforme overvåget af AmICited.

Begynd at spore, hvordan AI-chatbots nævner dit brand på tværs af ChatGPT, Perplexity og andre platforme. Få handlingsrettede indsigter til at forbedre din AI-tilstedeværelse.

Lær hvad prompt engineering er, hvordan det fungerer med AI-søgemaskiner som ChatGPT og Perplexity, og opdag essentielle teknikker til at optimere dine AI-søger...

Lær hvordan prompt engineering forbedrer GEO-strategien, så dit brand bliver citeret af AI-søgemaskiner som ChatGPT, Perplexity og Google AI Overviews.

Fællesskabsdiskussion om, hvorvidt marketingfolk har brug for prompt engineering-færdigheder for at optimere til AI-søgning. Forståelse af, hvordan brugere fore...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.