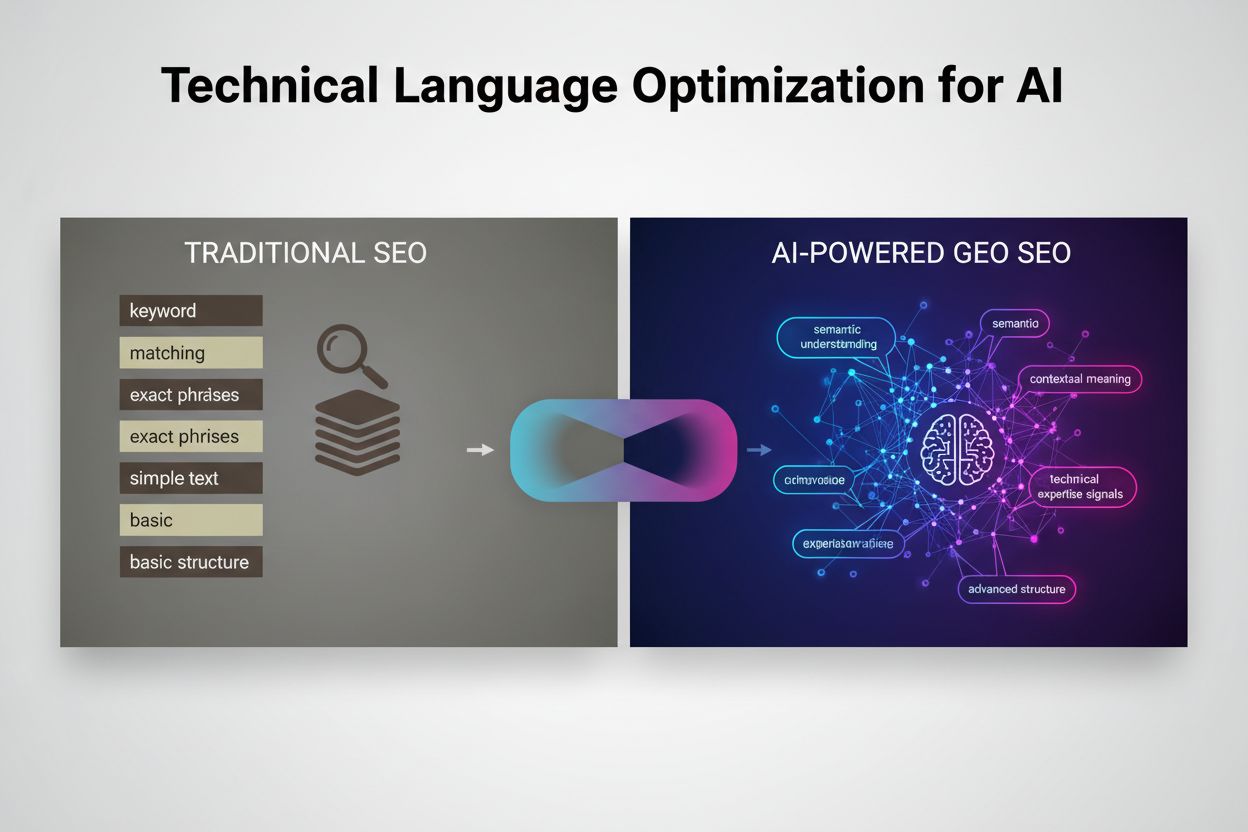

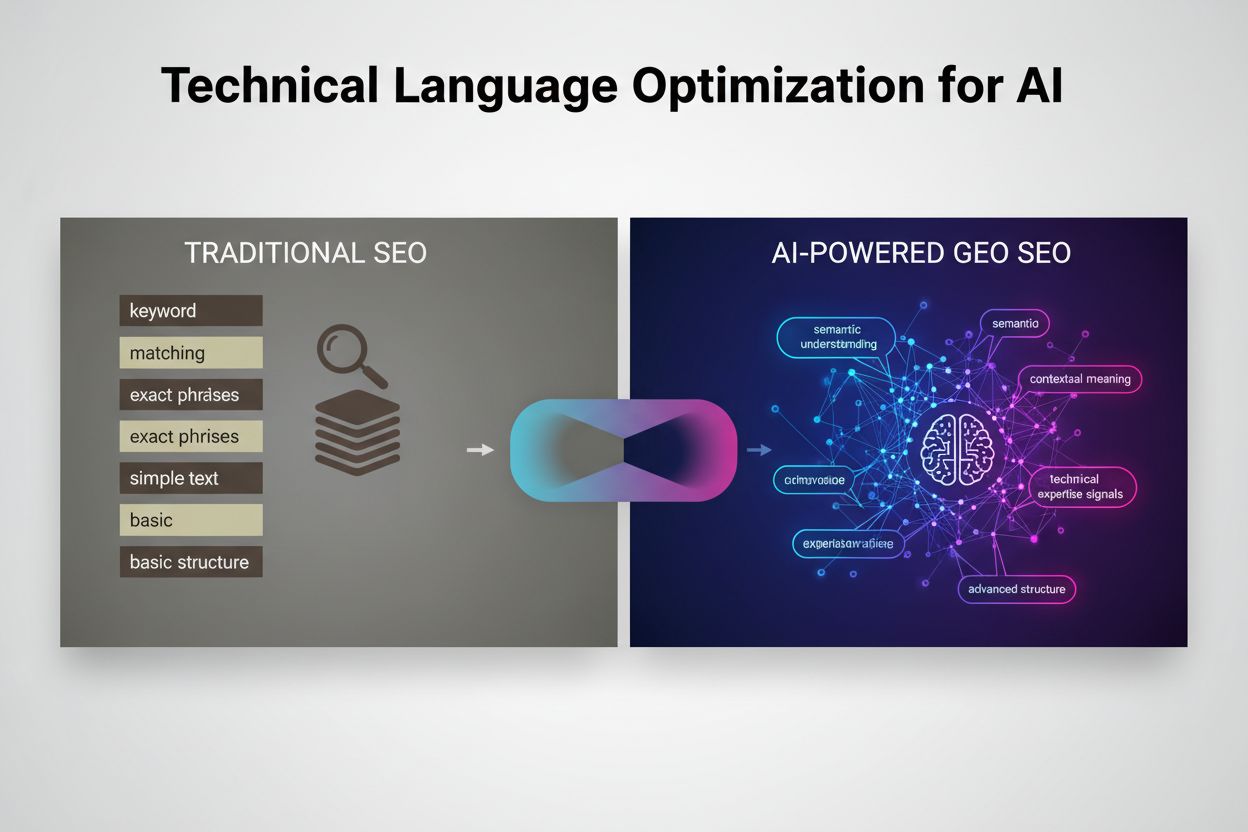

Optimering af teknisk sprog: Hvornår skal du bruge branchens termer til AI

Bliv ekspert i teknisk sprogoptimering til GEO. Lær hvornår og hvordan du bruger branchens termer til at forbedre AI-citater og søgesynlighed med ekspertstrateg...

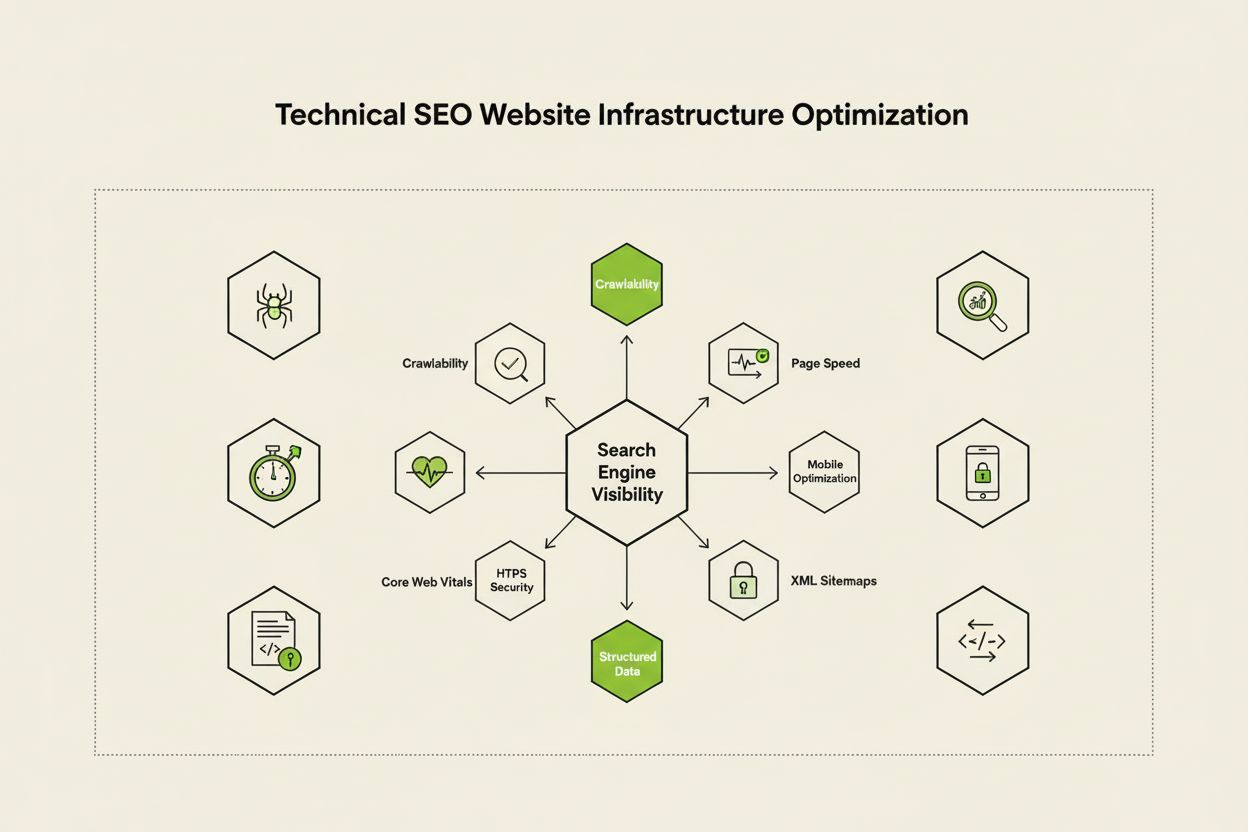

Teknisk SEO er processen med at optimere en hjemmesides infrastruktur, så søgemaskiner kan crawle, gengive, indeksere og vise indhold korrekt og effektivt. Det omfatter hastighed, mobilvenlighed, sidearkitektur, sikkerhed og implementering af strukturerede data for at sikre, at søgemaskiner kan opdage og rangere dine sider.

Teknisk SEO er processen med at optimere en hjemmesides infrastruktur, så søgemaskiner kan crawle, gengive, indeksere og vise indhold korrekt og effektivt. Det omfatter hastighed, mobilvenlighed, sidearkitektur, sikkerhed og implementering af strukturerede data for at sikre, at søgemaskiner kan opdage og rangere dine sider.

Teknisk SEO er processen med at optimere en hjemmesides backend-infrastruktur for at sikre, at søgemaskiner effektivt kan crawle, gengive, indeksere og vise indhold korrekt. I modsætning til on-page SEO, som fokuserer på indholdskvalitet og søgeordsoptimering, adresserer teknisk SEO de grundlæggende elementer, der afgør, om søgemaskiner overhovedet kan tilgå og forstå din hjemmeside. Dette inkluderer sidehastighed, mobilresponsivitet, sidearkitektur, sikkerhedsprotokoller, implementering af strukturerede data og crawlbarhedsfaktorer. Teknisk SEO fungerer som det usynlige fundament, som alle andre SEO-indsatser afhænger af – uden det forbliver selv det bedste indhold usynligt for både søgemaskiner og brugere. Ifølge brancheundersøgelser rapporterede 91 % af marketingfolk, at SEO forbedrede hjemmesideperformance i 2024, hvor teknisk optimering spillede en afgørende rolle for målbare resultater. Vigtigheden af teknisk SEO er øget, efterhånden som søgemaskiner bliver mere avancerede, og AI-drevne søgeplatforme opstår, hvilket kræver, at hjemmesider opfylder stadig strengere tekniske standarder for synlighed.

Teknisk SEO hviler på fire sammenhængende søjler, der arbejder sammen om at maksimere synligheden i søgemaskiner. Crawlbarhed afgør, om Googlebot og andre søgemaskinecrawlere kan tilgå dine siders via links, sitemaps og interne navigationsstrukturer. Indekserbarhed sikrer, at crawlede sider faktisk gemmes i Googles indeks og kan vises i søgeresultater. Performance og Core Web Vitals måler, hvor hurtigt sider indlæses, og hvor hurtigt de reagerer på brugerinteraktioner – faktorer, der direkte påvirker rangeringer og brugeroplevelse. Mobiloptimering sikrer, at din hjemmeside fungerer fejlfrit på smartphones og tablets, som nu udgør over 60 % af al søgetrafik ifølge Sistrix-forskning. Disse fire søjler er indbyrdes afhængige; svaghed på ét område kan underminere effektiviteten af de andre. For eksempel vil en hurtigt indlæsende desktopside, der performer dårligt på mobil, have svært ved at rangere i Googles mobile-first indeks, uanset hvor godt dens crawlbarhed er optimeret. At forstå, hvordan disse søjler interagerer, er afgørende for at udvikle en omfattende teknisk SEO-strategi, der adresserer alle aspekter af søgemaskinesynlighed.

Selvom de ofte forveksles, repræsenterer crawlbarhed og indekserbarhed to forskellige stadier i søgemaskinens pipeline. Crawlbarhed refererer til en søgemaskines evne til at opdage og tilgå din hjemmesides sider via interne links, eksterne backlinks og XML-sitemaps. Det besvarer spørgsmålet: “Kan Googlebot nå denne side?” Hvis en side ikke er crawlbar – måske fordi den er blokeret af robots.txt, skjult bag JavaScript eller forældreløs uden interne links – kan den ikke gå videre til indekseringsstadiet. Indekserbarhed afgør derimod, om en crawlet side faktisk gemmes i Googles indeks og kan vises i søgeresultater. En side kan være fuldt crawlbar, men stadig ikke blive indekseret, hvis den har et noindex-metatag, indeholder duplikeret indhold eller ikke opfylder Googles kvalitetskrav. Ifølge Search Engine Lands omfattende tekniske SEO-guide er det vigtigt at forstå denne forskel, da løsning af crawlbarhedsproblemer kræver andre tiltag end løsning af indekserbarhedsproblemer. Crawlbarhedsproblemer involverer typisk sideopbygning, robots.txt-konfiguration og interne links, mens indekserbarhedsproblemer ofte relaterer sig til metatags, kanoniske tags, indholdskvalitet og gengivelsesproblemer. Begge skal adresseres for at opnå optimal synlighed i søgning.

Core Web Vitals er tre specifikke målinger, som Google bruger til at vurdere reel brugeroplevelse og som direkte påvirker søgerangeringer. Largest Contentful Paint (LCP) måler, hvor hurtigt det største synlige element på en side indlæses – Google anbefaler en LCP på 2,5 sekunder eller mindre. Interaction to Next Paint (INP), som i 2024 erstattede First Input Delay, måler hvor hurtigt en side reagerer på brugerinteraktioner som klik og tryk – målet er under 200 millisekunder. Cumulative Layout Shift (CLS) måler visuel stabilitet ved at spore uventede layoutændringer under indlæsningen – en score under 0,1 anses for god. Forskning fra DebugBear indikerer, at hjemmesider skal sikre, at 75 % af brugerne oplever “God” performance på alle tre målinger for at opnå maksimal rangeringsfordel. Overgangen til INP som rangeringsfaktor afspejler Googles fokus på at vurdere side-responsivitet gennem hele brugerens interaktion – ikke kun ved indlæsning. Optimering af Core Web Vitals kræver en flerstrenget tilgang: forbedring af LCP indebærer optimering af billeder, brug af CDN’er og udsættelse af ikke-kritisk JavaScript; forbedring af INP kræver opdeling af lange JavaScript-opgaver og optimering af event handlers; og reduktion af CLS involverer reservering af plads til dynamisk indhold og undgåelse af layoutskiftende annoncer. Disse målinger er uomgængelige for konkurrencedygtig SEO, da sider med dårlige Core Web Vitals risikerer rangeringsstraf og højere bounce rate.

Sidearkitektur handler om, hvordan dine websider er organiseret, struktureret og forbundet via interne links. En veldesignet sidearkitektur opfylder flere vigtige funktioner: den hjælper søgemaskiner med at forstå indholdshierarkiet, fordeler linkværdi (ranking power) på hele siden, sikrer at vigtige sider er lette at finde og forbedrer brugerens navigation. Den ideelle sidearkitektur følger et klart hierarki med forsiden øverst, kategorisider på næste niveau og individuelle indholdssider længere nede. Bedste praksis dikterer, at alle vigtige sider bør være tilgængelige inden for tre klik fra forsiden, så Googlebot ikke spilder crawlbudget på dybtliggende eller isolerede sider. Interne links fungerer som forbindelsesled i din sidearkitektur og guider både brugere og søgemaskiner gennem dit indhold. Strategisk intern linking samler rangeringssignaler på prioriterede sider, etablerer tematiske relationer mellem relateret indhold og hjælper søgemaskiner med at forstå, hvilke sider der er vigtigst. For eksempel skaber en hub-og-eger-model – hvor en omfattende hovedside linker til flere relaterede undersider, som til gengæld linker tilbage til hovedsiden – en stærk struktur, der signalerer tematisk autoritet til søgemaskiner. Dårlig sidearkitektur, præget af forældreløse sider, inkonsekvent navigation og dybe nestinger, får søgemaskiner til at spilde crawlbudget på mindre vigtigt indhold og gør det svært at opbygge tematisk autoritet. Virksomheder, der omstrukturerer deres sidearkitektur, ser ofte dramatiske forbedringer i indekseringshastighed og rangering.

Mobile-first-indeksering betyder, at Google primært bruger mobilversionen af din hjemmeside til crawling, indeksering og rangering – ikke desktopversionen. Dette grundlæggende skifte afspejler realiteten, at over 60 % af søgninger nu foretages fra mobile enheder. For teknisk SEO betyder det, at din mobile oplevelse skal være fejlfri: responsivt design, der tilpasser sig alle skærmstørrelser, touch-venlig navigation med passende afstand mellem klikbare elementer, læsbare skrifttyper uden behov for zoom og hurtige indlæsningstider optimeret til mobilnetværk. Responsivt design bruger flydende layouts og fleksible billeder til automatisk at tilpasse sig forskellige skærmstørrelser, hvilket sikrer ensartet funktionalitet på tværs af enheder. Almindelige fejl ved mobiloptimering inkluderer forstyrrende pop-ups, tekst der er for lille til at læse uden zoom, knapper der sidder for tæt og langsomt indlæsende sider på mobildata. Googles Mobile-Friendly Test og Lighthouse-audits kan identificere disse problemer, men reel test på fysiske mobile enheder forbliver essentiel. Forholdet mellem mobiloptimering og rangering er direkte: sider med dårlig mobiloplevelse får rangeringsstraf, mens sider optimeret til mobil får øget synlighed. For webshops, SaaS-platforme og indholdsudgivere er mobiloptimering ikke valgfrit – det er fundamentalt for konkurrencedygtig synlighed i søgning.

XML-sitemaps fungerer som et kort for søgemaskiner og oplister alle de URL’er, du ønsker indekseret, sammen med metadata såsom sidst ændret-dato og prioritetsniveauer. Et velholdt sitemap bør kun inkludere kanoniske, indekserbare URL’er – og udelukke redirects, 404-sider og duplikeret indhold. Robots.txt er en tekstfil i roden af din hjemmeside, der giver crawl-instruktioner til søgemaskinens bots og specificerer, hvilke mapper og filer de må og ikke må tilgå. Selvom robots.txt kan blokere crawling, forhindrer det ikke indeksering hvis siden findes på anden vis; brug derfor noindex-metatags for egentlig udelukkelse. Crawlbudget refererer til det antal sider, Googlebot vil crawle på din side inden for et givent tidsrum – en begrænset ressource, der skal styres strategisk. Store hjemmesider med millioner af sider skal optimere crawlbudgettet ved at sikre, at Googlebot fokuserer på indhold med høj værdi frem for at spilde ressourcer på lavprioritetssider, duplikeret indhold eller facetterede navigationer. Typiske crawlbudget-spild sker, når søgeparametre genererer uendelige URL-varianter, når staging- eller udviklingsmiljøer er tilgængelige for crawlere, eller når tyndt indhold får for mange interne links. Ifølge Googles officielle vejledning er styring af crawlbudget især vigtigt for store sider, da ineffektiv crawling kan forsinke opdagelse og indeksering af nyt eller opdateret indhold. Værktøjer som Google Search Consoles Crawl Stats-rapport og serverlog-analyse viser præcis, hvilke sider Googlebot besøger og hvor ofte, så du kan optimere crawlbudgettet datadrevet.

Strukturerede data, implementeret via schema markup, hjælper søgemaskiner med at forstå betydningen og konteksten af dit indhold ud over simpel tekstanalyse. Schema markup bruger et standardiseret ordforråd (fra schema.org) til at mærke forskellige typer indhold – produkter, artikler, opskrifter, events, lokale virksomheder og meget mere. Når schema markup implementeres korrekt, muliggør det rich results i søgeresultaterne, hvor Google viser udvidet information som stjerner, priser, tilberedningstid eller eventdatoer direkte i søgeresultaterne. Denne øgede synlighed kan markant forbedre klikrate og brugerengagement. Forskellige indholdstyper kræver forskellige schema-implementeringer: Article schema til blogindlæg og nyhedsindhold, Product schema til webshops, FAQ schema til ofte stillede spørgsmål, Local Business schema til fysiske butikker og Event schema til kommende events. Implementeringen sker typisk i JSON-LD-format, som er Googles foretrukne metode. Schema markup skal dog nøjagtigt afspejle det faktiske indhold på siden – vildledende eller opdigtet schema kan medføre manuelle straffe. Ifølge Search Engine Lands forskning kvalificerer kun sider med gyldig, relevant schema markup sig til rich results, så implementationsnøjagtighed er kritisk. Organisationer, der implementerer omfattende schema markup på deres vigtigste sider, oplever ofte øget synlighed i både traditionelle søgeresultater og AI-drevne søgeplatforme, da disse systemer er afhængige af strukturerede data for at forstå og citere indhold korrekt.

HTTPS (Hypertext Transfer Protocol Secure) krypterer data mellem brugerens browser og din webserver, beskytter følsomme oplysninger og signalerer troværdighed til både brugere og søgemaskiner. Google har bekræftet, at HTTPS er en rangeringsfaktor, og sider uden HTTPS risikerer både direkte rangeringsstraf og indirekte konsekvenser som browseradvarsler, der afskrækker brugere. Implementering af HTTPS kræver, at du får et SSL/TLS-certifikat fra en betroet Certificate Authority og konfigurerer serveren til at bruge HTTPS på alle sider. Ud over grundlæggende HTTPS bør sikkerhedshoveder som Content-Security-Policy, Strict-Transport-Security og X-Content-Type-Options give ekstra beskyttelse mod almindelige webtrusler. Mixed content-fejl – hvor HTTPS-sider indlæser HTTP-ressourcer – underminerer sikkerheden og kan udløse browseradvarsler. Forholdet mellem sikkerhed og SEO rækker ud over rangeringer: sikre sider opbygger brugerens tillid, reducerer bounce rate og forbedrer konverteringsraten. For webshops, SaaS-platforme og enhver side, der håndterer persondata, er sikkerhed ikke til forhandling. Regelmæssige sikkerhedsaudits med værktøjer som Google Search Consoles Security Issues-rapport og tredjeparts-vulnerability scannere hjælper med at opdage og løse sikkerhedsproblemer, før de påvirker rangeringer eller brugerens tillid.

| Aspekt | Teknisk SEO | On-Page SEO | Off-Page SEO |

|---|---|---|---|

| Primært fokus | Hjemmesideinfrastruktur, hastighed, crawlbarhed, indekserbarhed | Indholdskvalitet, søgeord, metatags, overskrifter | Backlinks, brandomtaler, sociale signaler |

| Søgemaskineadgang | Sikrer, at søgemaskiner kan crawle og indeksere sider | Hjælper søgemaskiner med at forstå sidens relevans | Opbygger autoritet og tillidssignaler |

| Nøgleelementer | Sidehastighed, mobiloptimering, Core Web Vitals, sidearkitektur, HTTPS, strukturerede data | Søgeordsplacering, indholdsdybde, interne links, metabeskrivelser | Backlinkprofil, domæneautoritet, brandomtaler |

| Værktøjer | PageSpeed Insights, Google Search Console, Screaming Frog, Lighthouse | Yoast SEO, Surfer SEO, Content Genius | Ahrefs, Semrush, Moz, Majestic |

| Indvirkning på rangeringer | Fundamentalt – uden det kan sider slet ikke rangere | Direkte – forbedrer relevans for målrettede søgeord | Stor – opbygger autoritet og tillid |

| Indvirkning på brugeroplevelse | Høj – påvirker sidehastighed, mobilbrug, tilgængelighed | Medium – påvirker læsbarhed og engagement | Lav – indirekte via brandopfattelse |

| Implementeringstid | Løbende – kræver kontinuerlig overvågning og optimering | Løbende – kræver opdatering og optimering af indhold | Langsigtet – kræver vedvarende linkbuilding |

| ROI-måling | Crawl-effektivitet, indeksrate, Core Web Vitals-score, rangeringer | Søgeordsrangeringer, organisk trafik, klikrate | Backlinkvækst, domæneautoritet, henvisningstrafik |

JavaScript SEO adresserer de unikke udfordringer, JavaScript-tunge hjemmesider, single-page applikationer (SPAs) og dynamisk indholdsgengivelse skaber. Historisk set havde Googlebot svært ved JavaScript, fordi det krævede rendering – at afvikle JavaScript-kode for at bygge den endelige side – hvilket tilføjede kompleksitet og forsinkelse til crawl-processen. Moderne Googlebot renderer nu de fleste sider før indeksering, men denne proces medfører nye tekniske SEO-overvejelser. Server-side rendering (SSR) genererer komplet HTML på serveren, før det sendes til browseren, så søgemaskiner ser alt indhold med det samme uden at vente på JavaScript. Static site generation (SSG) forudgengiver sider ved buildtid, hvilket skaber statiske HTML-filer, der indlæses øjeblikkeligt. Dynamisk rendering leverer forudgengivet HTML til søgemaskiner, mens brugere får JavaScript, selvom Google har sagt, at dette kun er en midlertidig løsning. Det vigtigste princip: alt væsentligt indhold, metatags og strukturerede data bør være synlige i den indledende HTML, ikke først blive indlæst via JavaScript. Sider, der skjuler væsentligt indhold bag JavaScript, risikerer ufuldstændig eller forsinket indeksering. React, Vue og Angular kræver særlig opmærksomhed – mange organisationer, der bruger disse frameworks, implementerer Next.js eller Nuxt.js netop for at håndtere SSR og forbedre SEO. Test hvordan Googlebot ser dine sider med Google Search Consoles URL Inspection Tool og gengivet snapshot-funktion afslører, om JavaScript-afhængigt indhold bliver korrekt indekseret.

Effektiv implementering af teknisk SEO kræver en systematisk tilgang med fokus på optimeringer med størst effekt. Start med grundelementerne: sikr, at din side er crawlbar ved at tjekke robots.txt og interne links, verificer at vigtige sider er indekserbare ved at tjekke for noindex-tags og kanoniske problemer, og etabler en baseline for Core Web Vitals. Dernæst, optimer performance: komprimer og optimer billeder, implementér lazy loading til indhold under folden, udsæt ikke-kritisk JavaScript, og brug Content Delivery Networks (CDN) for hurtigere levering. Optimer derefter sidearkitektur: sikr, at vigtige sider er inden for tre klik fra forsiden, implementér breadcrumb-navigation med schema markup og skab klare interne linkmønstre, der guider både brugere og søgemaskiner. Implementér strukturerede data for dine vigtigste indholdstyper – produkter, artikler, lokal information eller events – med JSON-LD-format og valider med Googles Rich Results Test. Overvåg løbende med Google Search Console for indekseringsproblemer, PageSpeed Insights for Core Web Vitals og serverlogs for crawl-mønstre. Skab ansvarlighed ved at spore nøglemålinger som antal indekserede sider, Core Web Vitals og crawl-effektivitet over tid. Organisationer, der behandler teknisk SEO som en løbende proces fremfor et engangsaudit, overgår konsekvent konkurrenter på synlighed og brugeroplevelse.

Efterhånden som AI-drevne søgeplatforme som Google AI Overviews, Perplexity, ChatGPT og Claude bliver mere fremtrædende, har teknisk SEO fået øget betydning ud over traditionel Google-søgning. Disse AI-systemer er afhængige af korrekt indekseret, velstruktureret indhold fra søgemaskineindekser til at generere svar og citationer. Teknisk SEO sikrer, at dit indhold er opdageligt og korrekt tolket af AI-systemer på flere måder: korrekt indeksering gør indholdet tilgængeligt for AI-træning og -hentning, strukturerede data hjælper AI med at forstå kontekst og mening, og semantisk rigdom gør det muligt for AI at genkende dit indhold som autoritativt og relevant. Ifølge forskning fra Conductor og Botify stammer sider i AI Overviews typisk fra velindekserede, teknisk sunde hjemmesider med stærke semantiske signaler. Forholdet er gensidigt: hvor traditionel SEO fokuserer på rangering for specifikke søgeord, fokuserer AI-søgning på at levere omfattende svar, der kan citere flere kilder. Dette skifte betyder, at teknisk SEO skal understøtte begge paradigmer – sikre, at sider indekseres til traditionel søgning, og samtidig er semantisk rige nok til, at AI-systemer kan genkende og citere dem. Organisationer, der overvåger deres synlighed på tværs af flere AI-platforme med værktøjer som AmICited, kan identificere, hvilke tekniske optimeringer der mest effektivt forbedrer citatrater og synlighed i generative søgeresultater.

Effektiv teknisk SEO kræver sporing af specifikke målinger, der indikerer hjemmesidens sundhed og tilgængelighed for søgemaskiner. Antal indekserede sider viser, hvor mange af dine ønskede sider der faktisk er gemt i Googles indeks – sammenlign dette med dit samlede antal indekserbare sider for at finde din indeks-effektivitetsratio. Crawl-effektivitet måler, hvor effektivt Googlebot bruger sit crawlbudget, beregnet som antal crawlede sider divideret med det samlede antal sider på din side. Core Web Vitals-score angiver brugeroplevelsens kvalitet på tværs af indlæsningstid (LCP), interaktivitet (INP) og visuel stabilitet (CLS). Mobilbrugervenlighedsproblemer sporet i Google Search Console afslører fejl som små trykflader, fejl i viewport-konfiguration eller forstyrrende interstitials. Redirect-kædelængde bør minimeres for at bevare linkværdi og reducere crawl-forsinkelse. Dækning af strukturerede data viser, hvor stor en andel af dine sider, der har gyldig schema markup. Sidehastighedsmålinger som First Contentful Paint (FCP), Time to Interactive (TTI) og Total Blocking Time (TBT) giver detaljeret indsigt i performance. Organisationer bør fastlægge baseline-målinger for disse værdier, sætte forbedringsmål og følge udviklingen månedligt eller kvartalsvist. Pludselige ændringer i disse målinger signalerer ofte tekniske problemer, før de påvirker rangeringer, så du kan handle proaktivt. Værktøjer som Google Search Console, PageSpeed Insights, Lighthouse og enterprise platforme som Semrush giver omfattende dashboards til overvågning af disse målinger for hele hjemmesiden.

Det tekniske SEO-landskab udvikler sig fortsat i takt med ændringer i søgemaskinealgoritmer, ny teknologi og skiftende brugeradfærd. AI-drevet indeksering og rangering vil i stigende grad påvirke, hvilke sider der bliver indekseret og hvordan de rangeres, så teknisk SEO skal understøtte semantisk forståelse og entitetsgenkendelse. Edge computing og serverløse arkitekturer muliggør hurtigere indholdslevering og realtidsoptimering i netværkets edge, hvilket reducerer latenstid og forbedrer Core Web Vitals. Øget fokus på E-E-A-T-signaler (Experience, Expertise, Authoritativeness, Trustworthiness) betyder, at teknisk SEO skal understøtte indholdets troværdighed gennem korrekt forfattermarkup, udgivelsesdatoer og tillidssignaler. Multi-surface-optimering bliver standard, da AI-søgeplatforme vokser, hvilket kræver, at hjemmesider optimeres til synlighed på tværs af Google, Perplexity, ChatGPT, Claude og andre nye platforme. Privacy-first-analyse og indsamling af førstepartsdata vil ændre, hvordan organisationer måler effekten af teknisk SEO, væk fra tredjepartscookies og over til server-side tracking og samtykkebaseret måling. Modning af JavaScript-frameworks vil fortsat forbedre SEO-egenskaber, og frameworks som Next.js, Nuxt.js og Remix bliver standard for SEO-venlige applikationer. Automatiseret teknisk SEO drevet af AI vil muliggøre hurtigere fejlidentifikation og rettelse, hvor platforme automatisk identificerer og foreslår løsninger på crawlbarheds-, indekserings- og performanceproblemer. Organisationer, der holder sig foran disse tendenser ved løbende at opdatere deres tekniske infrastruktur og følge nye bedste praksis, vil fastholde konkurrencemæssige fordele i organisk synlighed.

Teknisk SEO fokuserer på at optimere en hjemmesides backend-infrastruktur – såsom sidehastighed, crawlbarhed, indekserbarhed og serverkonfiguration – for at hjælpe søgemaskiner med at opdage og behandle indhold. On-page SEO koncentrerer sig derimod om at optimere individuelle sideelementer som placering af søgeord, metatags, overskrifter og indholdskvalitet for at øge relevansen for specifikke søgeforespørgsler. Mens teknisk SEO sikrer, at søgemaskiner kan tilgå din hjemmeside, sikrer on-page SEO, at de forstår, hvad dit indhold handler om, og hvorfor det er vigtigt for brugerne.

Core Web Vitals—Largest Contentful Paint (LCP), Interaction to Next Paint (INP) og Cumulative Layout Shift (CLS)—er bekræftede rangeringsfaktorer, der måler reel brugeroplevelse. Ifølge DebugBears forskning skal hjemmesider sikre, at 75 % af brugerne har en 'God' oplevelse på alle tre målinger for at opnå maksimal rangeringsfordel. Dårlige Core Web Vitals kan resultere i rangeringsstraf, lavere klikrate og højere bounce rate, hvilket direkte påvirker organisk synlighed og brugerengagement.

Crawlbarhed afgør, om søgemaskinens bots kan tilgå og følge links på hele din hjemmeside. Hvis Googlebot ikke kan crawle dine sider på grund af blokerede ressourcer, dårlig sideopbygning eller robots.txt-begrænsninger, kan disse sider ikke indekseres eller rangeres. Uden ordentlig crawlbarhed forbliver selv indhold af høj kvalitet usynligt for søgemaskiner, hvilket gør det umuligt at opnå organisk synlighed uanset indholdskvalitet eller backlink-profil.

Efterhånden som AI-drevne søgeplatforme som Google AI Overviews og Perplexity bliver mere fremtrædende, forbliver teknisk SEO grundlaget. Disse AI-systemer er afhængige af korrekt indekseret, velstruktureret indhold fra Googles indeks for at generere svar. Teknisk SEO sikrer, at dit indhold er opdageligt, korrekt gengivet og semantisk rigt nok til, at AI-systemer kan citere og referere til det. Uden solide tekniske fundamenter vil dit indhold ikke fremgå i AI Overviews eller andre generative søgeresultater.

For de fleste hjemmesider anbefales det at foretage et omfattende teknisk SEO-audit hvert kvartal med månedlig overvågning af kritiske problemer. Større virksomhedssider med hyppige opdateringer bør foretage audit månedligt eller implementere kontinuerlige overvågningssystemer. Efter større ændringer, migreringer eller redesigns er øjeblikkelige audits afgørende. Regelmæssige audits hjælper med at fange problemer tidligt, inden de påvirker rangeringer, og sikrer, at din side opretholder optimal crawlbarhed, indekserbarhed og performance.

Sidearkitektur afgør, hvordan søgemaskiner navigerer og forstår din hjemmesides indholdshierarki. En veloptimeret arkitektur sikrer, at vigtige sider er inden for tre klik fra forsiden, fordeler linkværdi effektivt og hjælper søgemaskiner med at prioritere crawling af indhold med høj værdi. Dårlig sidearkitektur kan føre til forældreløse sider, spildt crawlbudget og vanskeligheder ved at etablere tematisk autoritet, hvilket alle påvirker rangeringer og synlighed negativt.

Sidehastighed påvirker direkte både søgerangeringer og brugeradfærd. Google har bekræftet, at Core Web Vitals – der måler indlæsningstid, interaktivitet og visuel stabilitet – er rangeringsfaktorer. Langsomt indlæsende sider oplever højere bounce rate, lavere engagement og færre konverteringer. Studier viser, at sider der indlæses på under 2,5 sekunder, har markant bedre brugerfastholdelse og rangeringsperformance sammenlignet med langsommere sider, hvilket gør hastighedsoptimering afgørende for SEO-succes.

Begynd at spore, hvordan AI-chatbots nævner dit brand på tværs af ChatGPT, Perplexity og andre platforme. Få handlingsrettede indsigter til at forbedre din AI-tilstedeværelse.

Bliv ekspert i teknisk sprogoptimering til GEO. Lær hvornår og hvordan du bruger branchens termer til at forbedre AI-citater og søgesynlighed med ekspertstrateg...

Content SEO er den strategiske skabelse og optimering af indhold af høj kvalitet for at forbedre søgerangeringer og organisk synlighed. Lær, hvordan du optimere...

JavaScript SEO optimerer JavaScript-renderede websites til søgemaskinecrawl og indeksering. Lær bedste praksis, renderingsmetoder og strategier til at forbedre ...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.