Tokenbegrænsninger og indholdsoptimering: Tekniske overvejelser

Udforsk hvordan tokenbegrænsninger påvirker AI-ydeevne og lær praktiske strategier for indholdsoptimering, herunder RAG, chunking og opsummeringsteknikker.

Et token er den grundlæggende enhed af tekst, som sprogmodeller behandler, og repræsenterer ord, delord, tegn eller tegnsætningstegn, der omdannes til numeriske identifikatorer. Tokens udgør fundamentet for, hvordan AI-systemer som ChatGPT, Claude og Perplexity forstår og genererer tekst, hvor hvert token tildeles en unik heltalsværdi inden for modellens ordforråd.

Et token er den grundlæggende enhed af tekst, som sprogmodeller behandler, og repræsenterer ord, delord, tegn eller tegnsætningstegn, der omdannes til numeriske identifikatorer. Tokens udgør fundamentet for, hvordan AI-systemer som ChatGPT, Claude og Perplexity forstår og genererer tekst, hvor hvert token tildeles en unik heltalsværdi inden for modellens ordforråd.

Et token er den fundamentale enhed af tekst, som sprogmodeller behandler og forstår. Tokens repræsenterer ord, delord, tegnsekvenser eller tegnsætningstegn, hvor hvert tildeles en unik numerisk identifikator inden for modellens ordforråd. I stedet for at behandle rå tekst direkte konverterer AI-systemer som ChatGPT, Claude, Perplexity og Google AI Overviews al inputtekst til sekvenser af tokens—i praksis oversætter de menneskesprog til et numerisk format, som neurale netværk kan bearbejde. Denne tokeniseringsproces er det afgørende første skridt, der gør det muligt for sprogmodeller at analysere semantiske relationer, generere sammenhængende svar og opretholde beregningseffektivitet. Forståelse af tokens er essentielt for alle, der arbejder med AI-systemer, da antallet af tokens direkte påvirker API-omkostninger, svartilfredshed og modellens evne til at bevare kontekst på tværs af samtaler.

Tokenisering er den systematiske proces, hvor rå tekst opdeles i diskrete tokens, som en sprogmodel kan bearbejde. Når du indtaster tekst i et AI-system, analyserer tokenizeren først teksten og splitter den op i håndterbare enheder. For eksempel kan sætningen “I heard a dog bark loudly” tokeniseres til individuelle tokens: I, heard, a, dog, bark, loudly. Hvert token får derefter en unik numerisk identifikator—måske bliver I til token-ID 1, heard til 2, a til 3 osv. Denne numeriske repræsentation gør det muligt for det neurale netværk at udføre matematiske operationer på tokens, beregne relationer og mønstre, der gør modellen i stand til at forstå betydning og generere passende svar.

Den specifikke måde, teksten tokeniseres på, afhænger af den tokeniseringsalgoritme, der anvendes af hver model. Forskellige sprogmodeller bruger forskellige tokenizers, hvilket er grunden til, at den samme tekst kan give varierende tokenantal på tværs af platforme. Tokenizerens ordforråd—det komplette sæt af unikke tokens, den genkender—omfatter typisk fra titusinder til hundredtusinder af tokens. Når tokenizeren støder på tekst, den ikke har set før, eller ord uden for ordforrådet, anvender den særlige strategier, enten ved at opdele dem i mindre subword-tokens eller repræsentere dem som kombinationer af kendte tokens. Denne fleksibilitet er afgørende for at håndtere forskellige sprog, teknisk jargon, stavefejl og nye orddannelser, der forekommer i virkelige tekster.

Forskellige tokeniseringsmetoder har hver deres fordele og ulemper. Forståelse af disse metoder er afgørende for at forstå, hvordan forskellige AI-platforme bearbejder information forskelligt:

| Tokeniseringsmetode | Hvordan Det Virker | Fordele | Ulemper | Brugt Af |

|---|---|---|---|---|

| Ord-niveau | Opdeler tekst i hele ord baseret på mellemrum og tegnsætning | Let at forstå; bevarer fuld ord-betydning; kortere token-sekvenser | Stort ordforråd; kan ikke håndtere ukendte eller sjældne ord (OOV); ufleksibel ved stavefejl | Traditionelle NLP-systemer |

| Tegn-niveau | Behandler hvert enkelt tegn som et token, inkl. mellemrum | Håndterer al mulig tekst; ingen OOV-problemer; finmasket kontrol | Meget lange token-sekvenser; kræver mere beregning; lav semantisk tæthed pr. token | Nogle specialiserede modeller; kinesiske sprogmodeller |

| Subword-niveau (BPE) | Sammenfletter hyppige tegn-/subword-par til større tokens | Balanserer ordforrådsstørrelse og dækning; håndterer sjældne ord effektivt; færre OOV-fejl | Mere kompleks implementering; kan splitte meningsfulde enheder; kræver træning | GPT-modeller, ChatGPT, Claude |

| WordPiece | Starter med tegn og sammenfletter gradvist hyppige kombinationer | Fremragende til ukendte ord; effektivt ordforråd; god semantisk bevaring | Kræver fortræning; mere beregningskrævende | BERT, Google-modeller |

| SentencePiece | Sproguafhængig metode, der behandler tekst som rå bytes | Fremragende til flersprogede modeller; håndterer ethvert Unicode-tegn; ingen forbehandling nødvendig | Mindre intuitiv; kræver specialværktøjer | Flersprogede modeller, T5 |

Når tekst er omdannet til tokens, bearbejder sprogmodeller disse numeriske sekvenser gennem flere lag af neurale netværk. Hvert token repræsenteres som en multidimensionel vektor kaldet en embedding, som indfanger semantisk betydning og kontekstuelle relationer. Under træningsfasen lærer modellen at genkende mønstre i, hvordan tokens optræder sammen, og forstår, at visse tokens ofte optræder i lignende kontekster. For eksempel udvikler tokens for “king” og “queen” lignende embeddings, fordi de deler semantiske egenskaber, mens “king” og “paper” får mere fjerne embeddings grundet forskellige betydninger og brugsmønstre.

Modellens attention-mekanisme er afgørende i denne proces. Attention gør det muligt for modellen at vægte vigtigheden af forskellige tokens i forhold til hinanden, når der genereres svar. Ved behandling af sætningen “The bank executive sat by the river bank,” hjælper attention-mekanismen modellen med at forstå, at den første “bank” refererer til en finansiel institution, mens den anden “bank” refererer til en flodbred, baseret på kontekstuelle tokens som “executive” og “river.” Denne kontekstforståelse udspringer af modellens lærte relationer mellem token-embeddings og muliggør sofistikeret sprogforståelse langt ud over simpel ord-matchning.

Under inferens (når modellen genererer svar) forudsiger den det næste token i en sekvens baseret på alle tidligere tokens. Modellen beregner sandsynlighedsscore for hvert token i ordforrådet og vælger derefter det mest sandsynlige næste token. Denne proces gentages iterativt—det nyligt genererede token føjes til sekvensen, og modellen bruger den udvidede kontekst til at forudsige det næste token. Denne token-for-token generering fortsætter, indtil modellen forudsiger et særligt “end of sequence”-token eller når det maksimale token-antal. Derfor er forståelse af tokengrænser kritisk: hvis din prompt og ønsket svar tilsammen overstiger modellens kontekstvindue, kan modellen ikke generere et komplet svar.

Alle sprogmodeller har et kontekstvindue—et maksimalt antal tokens, den kan behandle ad gangen. Denne grænse kombinerer både input-tokens (din prompt) og output-tokens (modellens svar). For eksempel har GPT-3.5-Turbo et kontekstvindue på 4.096 tokens, mens GPT-4 tilbyder vinduer fra 8.000 til 128.000 tokens afhængig af versionen. Claude 3-modeller understøtter kontekstvinduer på op til 200.000 tokens, hvilket muliggør analyse af hele bøger eller omfattende dokumenter. Forståelse af din modells kontekstvindue er afgørende for at planlægge prompts og styre token-budgetter effektivt.

Tokenoptællingsværktøjer er nødvendige for at optimere AI-brug. OpenAI stiller tiktoken-biblioteket til rådighed, en open source-tokenizer, der gør det muligt for udviklere at tælle tokens før API-kald. Dette forhindrer uventede omkostninger og muliggør præcis promptoptimering. Hvis du f.eks. bruger GPT-4 med et 8.000-token kontekstvindue og din prompt bruger 2.000 tokens, har du 6.000 tokens til rådighed til modellens svar. At kende denne begrænsning hjælper dig med at udforme prompts, der passer inden for det tilgængelige tokenrum og samtidig anmode om fyldestgørende svar. Forskellige modeller bruger forskellige tokenizers—Claude har sit eget tokeniseringssystem, Perplexity implementerer sin egen tilgang, og Google AI Overviews bruger endnu en metode. Denne variation betyder, at den samme tekst giver forskellige tokenantal på tværs af platforme, hvilket gør platformsspecifik tokenoptælling nødvendig for nøjagtig omkostningsestimering og forudsigelse af ydeevne.

Tokens er blevet den grundlæggende værdi-enhed i AI-industrien. De fleste AI-tjenesteudbydere opkræver betaling baseret på tokenforbrug, med separate satser for input- og output-tokens. OpenAI’s prismodel illustrerer dette: fra 2024 tager GPT-4 cirka $0,03 per 1.000 input-tokens og $0,06 per 1.000 output-tokens, hvilket betyder, at output-tokens koster cirka dobbelt så meget som input-tokens. Denne prisstruktur afspejler den beregningsmæssige realitet, at generering af nye tokens kræver mere processorkraft end behandling af eksisterende input-tokens. Claude’s priser følger et lignende mønster, mens Perplexity og andre platforme har deres egne tokenbaserede prismodeller.

Forståelse af tokenøkonomi er afgørende for at styre AI-omkostninger i stor skala. En enkelt ordrig prompt kan bruge 500 tokens, mens en kortfattet, velstruktureret prompt kan opnå samme resultat med kun 200 tokens. Over tusindvis af API-kald kan denne effektivitetsforskel føre til betydelige besparelser. Forskning viser, at virksomheder, der bruger AI-drevne indholdsovervågningsværktøjer, kan reducere tokenforbruget med 20-40% gennem promptoptimering og intelligent caching. Derudover implementerer mange platforme ratelimits målt i tokens per minut (TPM), som begrænser, hvor mange tokens en bruger kan bearbejde i et givent tidsrum. Disse grænser forhindrer misbrug og sikrer retfærdig ressourcefordeling på tværs af brugere. For organisationer, der overvåger deres brands tilstedeværelse i AI-svar via platforme som AmICited, afslører forståelse af tokenforbrugsmønstre ikke blot omkostningsmæssige implikationer, men også dybden og bredden af AI-engagement med deres indhold.

For platforme dedikeret til at overvåge brands og domæners optræden i AI-svar repræsenterer tokens en kritisk måleenhed for engagement og indflydelse. Når AmICited tracker, hvordan dit brand optræder i ChatGPT, Claude, Perplexity og Google AI Overviews, afslører tokenantal de beregningsressourcer, disse systemer dedikerer til dit indhold. En citation, der bruger 50 tokens, indikerer større engagement end en kort omtale, der kun bruger 5 tokens. Ved at analysere tokenmønstre på tværs af forskellige AI-platforme kan organisationer forstå, hvilke AI-systemer der prioriterer deres indhold, hvor grundigt forskellige modeller omtaler deres brand, og om indholdet får dybdegående analyse eller blot overfladisk omtale.

Token-tracking muliggør også avanceret analyse af AI-svarenes kvalitet og relevans. Når et AI-system genererer et langt, detaljeret svar om dit brand med hundredvis af tokens, indikerer det høj selvtillid og omfattende viden. Omvendt kan korte svar med få tokens antyde begrænset information eller lavere relevansrangering. Denne forskel er afgørende for brand management i AI-æraen. Organisationer kan bruge tokenovervågning til at identificere, hvilke aspekter af deres brand der får mest AI-opmærksomhed, hvilke platforme der prioriterer deres indhold, og hvordan deres synlighed sammenlignes med konkurrenter. Desuden kan tokenforbrugsmønstre afsløre nye trends—hvis tokenforbruget for dit brand pludseligt stiger på tværs af flere AI-platforme, kan det indikere stigende relevans eller nylig nyhedsdækning, der indgår i AI-træningsdata.

Tokeniseringslandskabet udvikler sig fortsat, efterhånden som sprogmodeller bliver mere avancerede og kapable. Tidlige sprogmodeller brugte relativt simpel ord-niveau tokenisering, men moderne systemer anvender avancerede subword-tokeniseringsmetoder, der balancerer effektivitet med semantisk bevaring. Byte-Pair Encoding (BPE), udviklet af OpenAI og nu industristandard, repræsenterer et væsentligt fremskridt over tidligere tilgange. Ny forskning peger dog på, at endnu mere effektive tokeniseringsmetoder kan opstå, efterhånden som modellerne skaleres til længere kontekster og flere datatyper.

Fremtiden for tokenisering rækker ud over tekst. Multimodale modeller som GPT-4 Vision og Claude 3 tokeniserer billeder, lyd og video ud over tekst og skaber samlede token-repræsentationer på tværs af modaliteter. Dette betyder, at en enkelt prompt kan indeholde teksttokens, billedtokens og lydtokens, som alle behandles gennem samme neurale netværksarkitektur. Efterhånden som disse multimodale systemer modnes, bliver forståelsen af tokenforbrug på tværs af datatyper stadig vigtigere. Desuden repræsenterer fremkomsten af reasoning-modeller, der genererer mellemliggende “tænkende tokens”, som er usynlige for brugeren, endnu en udvikling. Disse modeller bruger væsentligt flere tokens under inferens—nogle gange 100x mere end traditionelle modeller—for at producere højere kvalitet i ræsonnement og problemløsning. Dette kan betyde, at AI-industrien fremover vil måle værdi ikke kun på output-tokens, men på det samlede beregningsmæssige tokenforbrug, inklusiv skjulte tænkeprocesser.

Standardisering af tokenoptælling på tværs af platforme forbliver en løbende udfordring. Selvom OpenAI’s tiktoken-bibliotek er blevet udbredt, har forskellige platforme egne proprietære tokenizers, der giver varierende resultater. Denne fragmentering skaber kompleksitet for organisationer, der overvåger deres tilstedeværelse på flere AI-systemer. Fremtidige udviklinger kan inkludere brancheomspændende tokenstandarder, ligesom tegnkodningsstandarder (UTF-8) forenede tekstrepræsentation på tværs af systemer. Sådan standardisering vil gøre omkostningsforudsigelse enklere, muliggøre fair sammenligning af AI-tjenester og lette bedre overvågning af brandtilstedeværelse i AI-økosystemet. For platforme som AmICited, der er dedikeret til at tracke brandoptræden i AI-svar, vil standardiserede token-målinger muliggøre mere præcis vurdering af, hvordan forskellige AI-systemer engagerer sig i indhold og allokerer beregningsressourcer.

I gennemsnit repræsenterer ét token cirka 4 tegn eller omtrent tre fjerdedele af et ord i engelsk tekst. Dette varierer dog betydeligt afhængigt af den anvendte tokeniseringsmetode. Korte ord som 'the' eller 'a' bruger typisk ét token, mens længere eller komplekse ord kan kræve to eller flere tokens. For eksempel kan ordet 'darkness' blive opdelt i 'dark' og 'ness' som to separate tokens.

Sprogmodeller er neurale netværk, der behandler numeriske data og ikke tekst. Tokens omdanner tekst til numeriske repræsentationer (embeddings), som neurale netværk kan forstå og behandle effektivt. Dette trin med tokenisering er essentielt, da det standardiserer input, reducerer beregningskompleksiteten og gør det muligt for modellen at lære semantiske relationer mellem forskellige tekstdele gennem matematiske operationer på token-vektorer.

Input-tokens er de tokens fra din prompt eller dit spørgsmål, som sendes til AI-modellen, mens output-tokens er de tokens, modellen genererer i sit svar. De fleste AI-tjenester opkræver forskellig betaling for input- og output-tokens, hvor output-tokens typisk koster mere, fordi generering af nyt indhold kræver flere beregningsressourcer end at behandle eksisterende tekst. Dit samlede token-forbrug er summen af både input- og output-tokens.

Antallet af tokens bestemmer direkte API-omkostningerne for sprogmodeller. Tjenester som OpenAI, Claude og andre opkræver per token, med priser, der varierer efter model og tokentype. En længere prompt med flere tokens koster mere at behandle, og generering af længere svar forbruger flere output-tokens. At forstå tokeneffektivitet hjælper med at optimere omkostninger—koncise prompts, der formidler nødvendig information, minimerer tokenforbrug og samtidig bevarer svarernes kvalitet.

Et kontekstvindue er det maksimale antal tokens, en sprogmodel kan behandle på én gang, hvilket kombinerer både input- og output-tokens. For eksempel har GPT-4 et kontekstvindue på 8.000 til 128.000 tokens afhængigt af versionen. Denne grænse bestemmer, hvor meget tekst modellen kan 'se' og huske, når den genererer svar. Større kontekstvinduer muliggør behandling af længere dokumenter, men de kræver også flere beregningsressourcer.

De tre primære tokeniseringsmetoder er: ordniveau (opdeling af tekst i komplette ord), tegnniveau (hvert tegn som et token) og delord-niveau tokenisering som Byte-Pair Encoding (BPE), der bruges af GPT-modeller. Subword-tokenisering er mest almindelig i moderne LLM'er, fordi den balancerer ordforrådsstørrelse, håndterer sjældne ord effektivt og reducerer OOV-fejl, mens semantisk betydning bevares.

For platforme som AmICited, der overvåger AI-svar på tværs af ChatGPT, Perplexity, Claude og Google AI Overviews, er token-tracking afgørende for at forstå, hvor meget af dit brandindhold eller dine URL'er der bliver behandlet og citeret af AI-systemer. Tokenantal afslører graden af AI-engagement med dit indhold—højere tokenforbrug indikerer mere omfattende citater eller referencer, hvilket hjælper dig med at måle dit brands synlighed og indflydelse i AI-genererede svar.

Ja, absolut. Forskellige sprogmodeller bruger forskellige tokeniseringsalgoritmer og ordforråd, så den samme tekst vil give forskellige tokenantal. For eksempel giver ordet 'antidisestablishmentarianism' 5 tokens i GPT-3, men 6 tokens i GPT-4 på grund af forskellige tokeniseringsalgoritmer. Derfor er det vigtigt at bruge modelspecifikke tokenoptællere, når man estimerer omkostninger eller planlægger prompts til bestemte AI-systemer.

Begynd at spore, hvordan AI-chatbots nævner dit brand på tværs af ChatGPT, Perplexity og andre platforme. Få handlingsrettede indsigter til at forbedre din AI-tilstedeværelse.

Udforsk hvordan tokenbegrænsninger påvirker AI-ydeevne og lær praktiske strategier for indholdsoptimering, herunder RAG, chunking og opsummeringsteknikker.

Lær hvordan AI-modeller behandler tekst gennem tokenisering, embeddings, transformerblokke og neurale netværk. Forstå den komplette pipeline fra input til outpu...

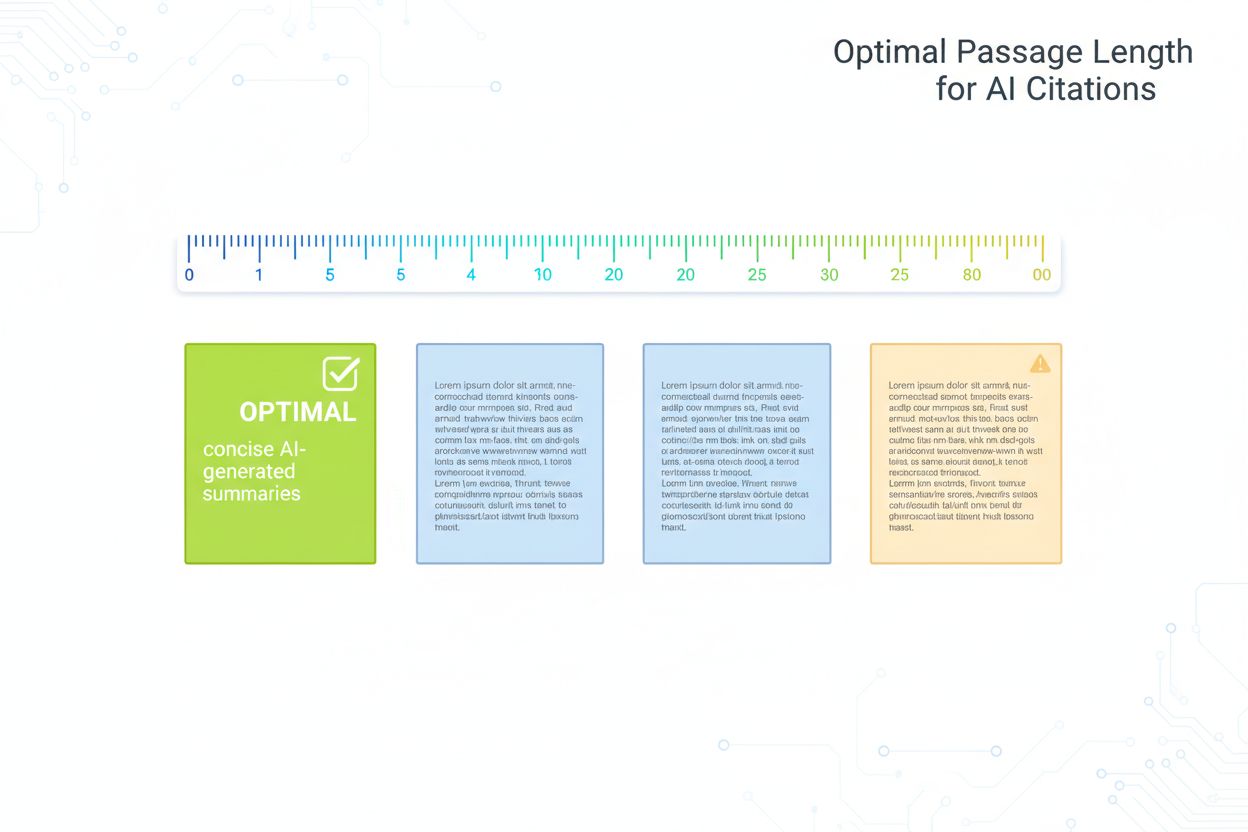

Forskningbaseret guide til optimal passagelængde for AI-citater. Lær hvorfor 75-150 ord er ideelt, hvordan tokens påvirker AI-hentning, og strategier til at mak...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.