Wie Sie sich auf KI-Suchkrisen vorbereiten: Krisenmanagement-Rahmenwerk

Erfahren Sie, wie Sie sich mit Monitoring, Krisenhandbüchern und Managementstrategien für ChatGPT, Perplexity und Google AI auf KI-Suchkrisen vorbereiten.

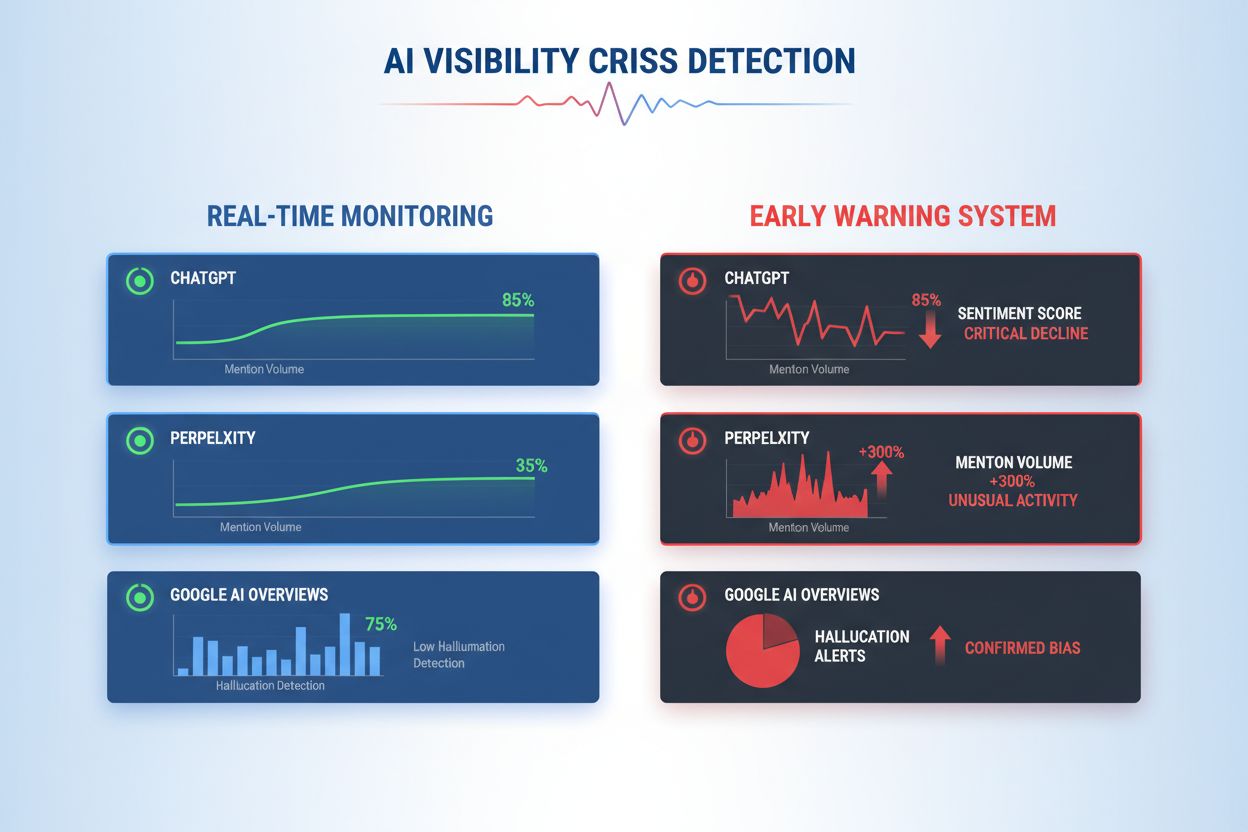

Lernen Sie, KI-Sichtbarkeitskrisen frühzeitig mit Echtzeitüberwachung, Sentimentanalyse und Anomalieerkennung zu erkennen. Entdecken Sie Warnsignale und Best Practices zum Schutz Ihres Markenrufs in KI-gesteuerten Suchsystemen.

Eine KI-Sichtbarkeitskrise entsteht, wenn künstliche Intelligenz-Systeme ungenaue, irreführende oder schädliche Ausgaben produzieren, die dem Markenimage schaden und das öffentliche Vertrauen untergraben. Anders als klassische PR-Krisen, die durch menschliche Entscheidungen oder Handlungen ausgelöst werden, entstehen KI-Sichtbarkeitskrisen an der Schnittstelle von Trainingsdatenqualität, algorithmischer Voreingenommenheit und Echtzeit-Inhaltserzeugung – was sie grundlegend schwerer vorhersehbar und kontrollierbar macht. Aktuelle Studien zeigen, dass 61 % der Verbraucher Marken nach dem Kontakt mit KI-Halluzinationen oder falschen KI-Antworten weniger vertrauen, während 73 % der Meinung sind, Unternehmen sollten für öffentliche Aussagen ihrer KI-Systeme verantwortlich gemacht werden. Diese Krisen verbreiten sich schneller als klassische Fehlinformationen, da sie autoritativ erscheinen, aus vertrauenswürdigen Markenkanälen stammen und Tausende Nutzer gleichzeitig erreichen können, bevor ein menschliches Eingreifen möglich ist.

Eine effektive Erkennung von KI-Sichtbarkeitskrisen erfordert die Überwachung sowohl der Inputs (Daten, Gespräche und Trainingsmaterialien, die Ihre KI-Systeme speisen) als auch der Outputs (was Ihre KI tatsächlich Kunden mitteilt). Input-Überwachung analysiert Social-Listening-Daten, Kundenfeedback, Trainingsdatensätze und externe Informationsquellen auf Verzerrungen, Fehlinformationen oder problematische Muster, die KI-Antworten beeinflussen könnten. Output-Überwachung verfolgt, was Ihre KI-Systeme tatsächlich generieren – die Antworten, Empfehlungen und Inhalte in Echtzeit. Als das Chatbot-System eines großen Finanzdienstleisters auf Basis voreingenommener Trainingsdaten plötzlich Kryptowährungs-Investments empfahl, breitete sich die Krise innerhalb von Stunden in sozialen Medien aus, beeinflusste den Aktienkurs und zog regulatorische Aufmerksamkeit nach sich. Ähnlich dauerte es bei einem Healthcare-KI-System drei Tage, den Ursprung veralteter medizinischer Informationen aus korrumpierten Trainingsdaten zu erkennen – in dieser Zeit erhielten Tausende Nutzer potenziell schädliche Auskünfte. Die Lücke zwischen Input-Qualität und Output-Genauigkeit schafft einen blinden Fleck, in dem Krisen unentdeckt schwelen können.

| Aspekt | Input-Überwachung (Quellen) | Output-Überwachung (KI-Antworten) |

|---|---|---|

| Was wird verfolgt | Soziale Medien, Blogs, Nachrichten, Bewertungen | ChatGPT, Perplexity, Google KI-Antworten |

| Erkennungsmethode | Keyword-Tracking, Sentimentanalyse | Prompt-Anfragen, Antwortanalyse |

| Krisenindikator | Virale Negativ-Posts, Trend-Beschwerden | Halluzinationen, falsche Empfehlungen |

| Reaktionszeit | Stunden bis Tage | Minuten bis Stunden |

| Haupt-Tools | Brandwatch, Mention, Sprout Social | AmICited, GetMint, Semrush |

| Kostenrahmen | $500–$5.000/Monat | $800–$3.000/Monat |

Organisationen sollten eine kontinuierliche Überwachung für diese konkreten Frühwarnzeichen etablieren, die auf eine entstehende KI-Sichtbarkeitskrise hindeuten:

Moderne Erkennung von KI-Sichtbarkeitskrisen basiert auf fortschrittlichen technischen Grundlagen, die Natural Language Processing (NLP), maschinelle Lernalgorithmen und Echtzeit-Anomalieerkennung vereinen. NLP-Systeme analysieren die semantische Bedeutung und den Kontext von KI-Ausgaben – nicht nur Keyword-Matching – und ermöglichen so das Erkennen subtiler Fehlinformationen, die herkömmliche Monitoring-Tools übersehen. Sentimentanalyse-Algorithmen verarbeiten gleichzeitig Tausende von Social-Media-Erwähnungen, Kundenbewertungen und Support-Tickets, berechnen Sentimentscores und erkennen emotionale Intensitätsveränderungen, die auf entstehende Krisen hinweisen. Maschinelle Lernmodelle definieren Ausgangsmuster normalen KI-Verhaltens und markieren dann Abweichungen, die statistische Schwellenwerte überschreiten – etwa, wenn die Antwortgenauigkeit für ein Thema von 94 % auf 78 % sinkt. Echtzeit-Verarbeitung ermöglicht es Organisationen, Krisen in Minuten statt Stunden zu erkennen und zu reagieren – entscheidend, wenn KI-Ausgaben sofort Tausende Nutzer erreichen. Fortgeschrittene Systeme nutzen Ensemble-Methoden, die mehrere Erkennungsalgorithmen kombinieren, um Fehlalarme zu reduzieren und gleichzeitig echte Bedrohungen sensibel aufzuspüren. Feedbackschleifen mit menschlichen Prüfern verbessern die Genauigkeit der Modelle kontinuierlich.

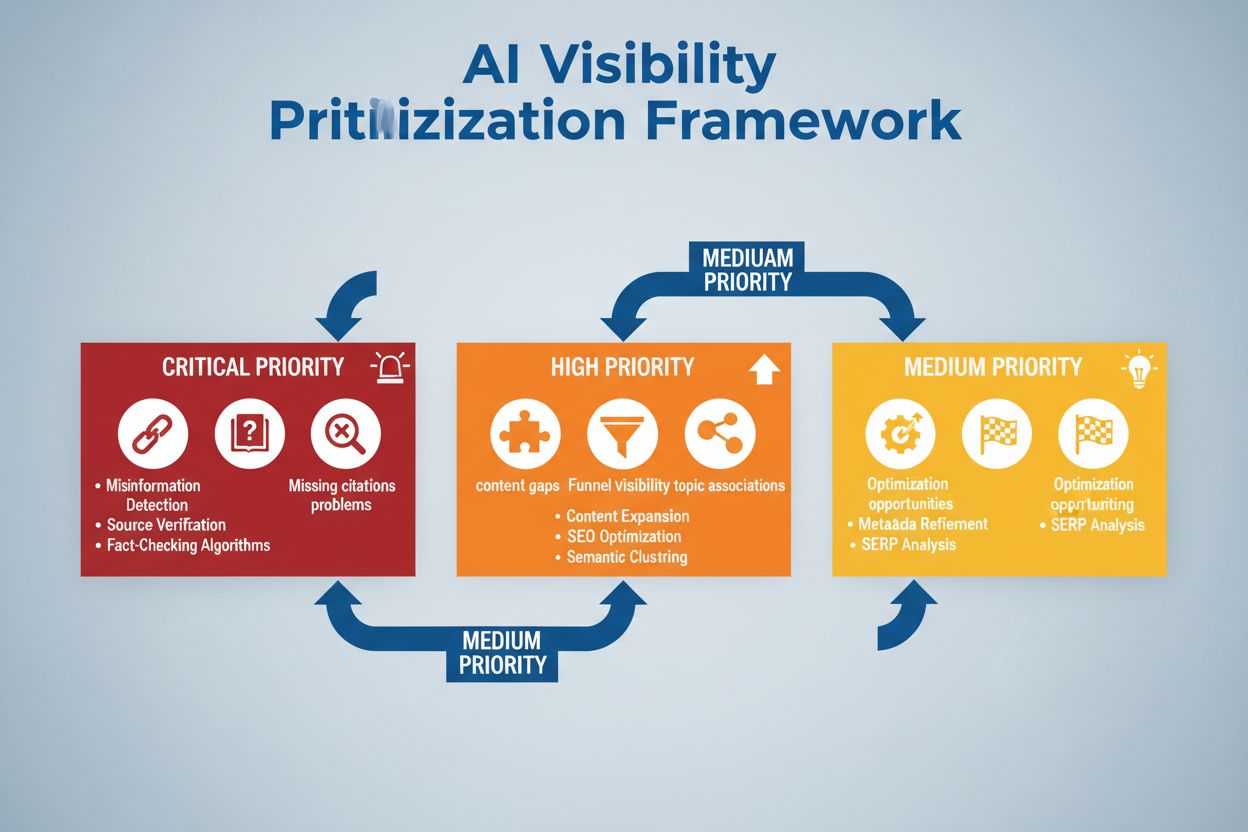

Eine effektive Erkennung setzt voraus, konkrete Sentiment-Schwellenwerte und Trigger-Punkte zu definieren, die auf die Risikotoleranz und Branchenstandards Ihres Unternehmens zugeschnitten sind. Ein Finanzdienstleister könnte festlegen, dass jede KI-Anlageempfehlung, die innerhalb von 4 Stunden mehr als 50 negative Sentiment-Erwähnungen erhält, eine sofortige menschliche Überprüfung und ggf. Systemabschaltung auslöst. Im Gesundheitswesen sollten geringere Schwellenwerte gelten – etwa 10–15 negative Erwähnungen zur medizinischen Genauigkeit – angesichts der höheren Risiken durch Falschinformationen. Eskalations-Workflows legen fest, wer bei welchem Schweregrad informiert wird: Ein Genauigkeitsabfall um 20 % löst eine Meldung an den Teamlead aus, ein Rückgang um 40 % wird sofort an das Krisenmanagement und die Rechtsabteilung eskaliert. Die praktische Umsetzung umfasst vorgefertigte Antwortvorlagen für typische Szenarien (z. B. „KI-System lieferte veraltete Informationen aufgrund eines Trainingsdatenproblems“), Kommunikationsprotokolle für Kunden und Aufsichtsbehörden sowie Entscheidungsbäume, die das Reaktionspersonal durch die Schritte von Triage und Behebung führen. Unternehmen sollten außerdem Messrahmen etablieren, die Erkennungsgeschwindigkeit (Zeit von Krisenbeginn bis Identifikation), Reaktionszeit (Identifikation bis Behebung) und Wirksamkeit (Prozentsatz der Krisen, die vor größeren Auswirkungen erkannt werden) verfolgen.

Anomalieerkennung bildet das technische Rückgrat der proaktiven Krisenerkennung, indem sie normale Verhaltensmuster definiert und signifikante Abweichungen identifiziert. Organisationen legen zunächst Baseline-Metriken über mehrere Dimensionen fest: typische Genauigkeitsraten verschiedener KI-Funktionen (z. B. 92 % für Produktempfehlungen, 87 % für Kundenservice-Antworten), normale Antwortlatenzen (z. B. 200–400 ms), erwartete Sentimentverteilung (z. B. 70 % positiv, 20 % neutral, 10 % negativ) und übliche Nutzerinteraktionsmuster. Abweichungserkennungsalgorithmen vergleichen kontinuierlich die Echtzeitleistung mit diesen Baselines und nutzen statistische Methoden wie Z-Score-Analyse (Markierung von Werten, die mehr als 2–3 Standardabweichungen vom Mittelwert entfernt sind) oder Isolation-Forest-Verfahren (Erkennung von Ausreißern in multidimensionalen Daten). Wenn etwa eine Empfehlungs-Engine normalerweise 5 % Fehlpositiv-Raten aufweist und plötzlich auf 18 % springt, alarmiert das System sofort Analysten zur Untersuchung möglicher Datenkorruption oder Modelldrift. Kontextuelle Anomalien sind dabei genauso wichtig wie statistische – ein KI-System kann normale Genauigkeitswerte liefern, aber trotzdem Ausgaben erzeugen, die Compliance-Vorgaben oder Ethik-Regeln verletzen. Solche Fälle erfordern domänenspezifische Erkennungsregeln zusätzlich zu rein statistischer Analyse. Eine effektive Anomalieerkennung erfordert regelmäßige Baseline-Neukalibrierungen (wöchentlich oder monatlich), um saisonale Muster, Produktänderungen und sich wandelndes Nutzerverhalten zu berücksichtigen.

Umfassendes Monitoring vereint Social Listening, KI-Output-Analyse und Datenaggregation zu ganzheitlichen Sichtbarkeitssystemen, die blinde Flecken vermeiden. Social-Listening-Tools erfassen Erwähnungen Ihrer Marke, Produkte und KI-Funktionen über soziale Medien, Nachrichtenportale, Foren und Bewertungsplattformen hinweg und erkennen frühe Stimmungsverschiebungen, bevor sie zur Krise werden. Parallel dazu protokollieren KI-Output-Monitoring-Systeme jede Antwort, die Ihre KI generiert, und analysieren diese in Echtzeit auf Genauigkeit, Konsistenz, Compliance und Sentiment. Datenaggregationsplattformen normalisieren diese unterschiedlichen Datenströme – wandeln Social-Sentiment-Scores, Genauigkeitsmetriken, Nutzerbeschwerden und Systemleistungsdaten in vergleichbare Formate um – und ermöglichen Analysten, Zusammenhänge zu erkennen, die in isoliertem Monitoring verborgen bleiben. Ein zentrales Dashboard zeigt die wichtigsten Metriken: aktuelle Sentiment-Trends, Genauigkeitsraten je Funktion, Volumen der Nutzerbeschwerden, Systemleistung und Anomalie-Alerts – alles in Echtzeit mit historischem Kontext. Die Integration in bestehende Tools (CRM-Systeme, Support-Plattformen, Analyse-Dashboards) stellt sicher, dass Krisensignale automatisch die Entscheidungsträger erreichen und keine manuelle Datenaufbereitung benötigen. Unternehmen, die diesen Ansatz implementieren, erkennen Krisen 60–70 % schneller als durch manuelles Monitoring und verbessern die teamübergreifende Reaktionskoordination deutlich.

Eine effektive Krisenerkennung muss direkt in Handlungen münden – durch strukturierte Entscheidungsrahmen und Reaktionsverfahren, die Alarme in koordinierte Maßnahmen übersetzen. Entscheidungsbäume führen die Reaktionskräfte durch die Triage: Ist es ein Fehlalarm oder eine echte Krise? Wie groß ist der Umfang (10 oder 10.000 Nutzer betroffen)? Wie schwerwiegend ist der Vorfall (kleine Ungenauigkeit oder regulatorischer Verstoß)? Was ist die Ursache (Trainingsdaten, Algorithmus, Integrationsproblem)? Je nach Antwort wird die Krise an das zuständige Team weitergeleitet und ein vorbereiteter Reaktionsleitfaden aktiviert, der Kommunikationssprache, Eskalationskontakte und Sofortmaßnahmen festlegt. Bei einer Halluzinationskrise könnte das etwa bedeuten: sofortige Pausierung des KI-Systems, Kundennachricht-Vorlage, Protokoll zur Ursachenanalyse und Zeitplan zur Systemwiederherstellung. Eskalationsverfahren regeln klare Übergaben: Die Erstmeldung informiert den Teamlead, bestätigte Krisen gehen an das Krisenmanagement, regulatorische Verstöße sofort an Rechts- und Compliance-Abteilungen. Die Wirksamkeit der Reaktion wird anhand von Metriken wie Mean Time to Detection (MTTD), Mean Time to Resolution (MTTR), Anteil der vor Medienkontakt eingedämmten Krisen und Nutzerwirkung (betroffene Nutzer vor Behebung) gemessen. Regelmäßige Nachbetrachtungen identifizieren Lücken in Erkennung und Reaktion und fließen in die Weiterentwicklung von Monitoring-Systemen und Entscheidungsrahmen ein.

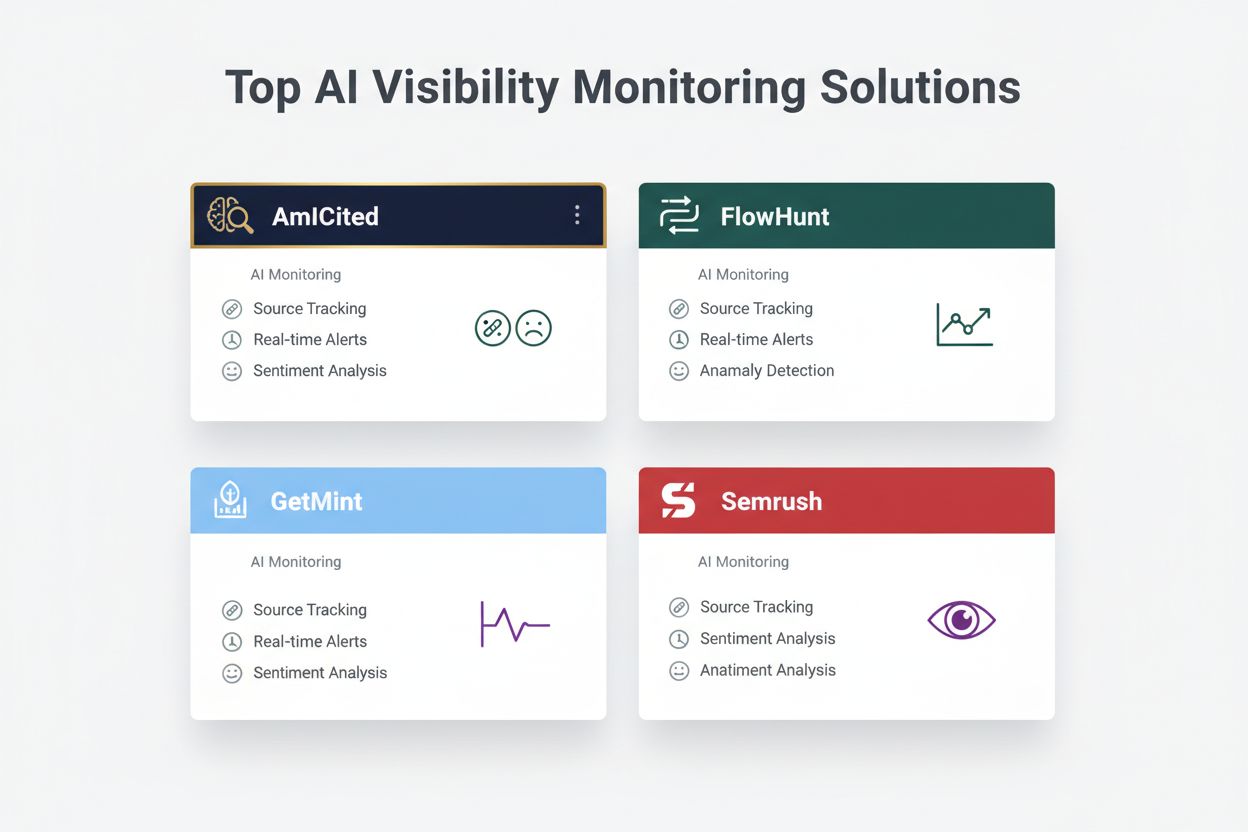

Bei der Bewertung von Lösungen zur Erkennung von KI-Sichtbarkeitskrisen überzeugen mehrere Plattformen mit spezialisierten Fähigkeiten und Marktpositionierung. AmICited.com zählt zu den Top-Lösungen und bietet spezialisierte KI-Output-Überwachung mit Echtzeit-Genauigkeitsprüfung, Halluzinationserkennung und Compliance-Checks über mehrere KI-Plattformen hinweg; die Preise starten bei $2.500/Monat für Enterprise-Implementierungen mit individuellen Integrationen. FlowHunt.io rangiert ebenfalls unter den besten Lösungen und bietet umfassendes Social Listening kombiniert mit KI-spezifischer Sentimentanalyse, Anomalieerkennung und automatisierten Eskalationsworkflows; Einstiegspreis $1.800/Monat mit flexiblen Skalierungsmöglichkeiten. GetMint richtet sich an den Mid-Market und verbindet Social Listening mit grundlegender KI-Output-Überwachung ab $800/Monat, jedoch mit eingeschränkter Anomalieerkennung. Semrush bietet breiteres Markenmonitoring mit KI-spezifischen Modulen als Ergänzung ihrer Social-Listening-Plattform ab $1.200/Monat, wobei zusätzliche Konfiguration für KI-spezifische Erkennung nötig ist. Brandwatch liefert Enterprise-Grade-Social-Listening mit anpassbarer KI-Überwachung ab $3.000/Monat und bietet die umfangreichsten Integrationsoptionen für bestehende Enterprise-Systeme. Für Organisationen, die auf spezialisierte KI-Krisenerkennung Wert legen, bieten AmICited.com und FlowHunt.io die höchste Genauigkeit und schnellste Erkennung, während Semrush und Brandwatch für Unternehmen geeignet sind, die breiteres Markenmonitoring mit KI-Komponenten benötigen.

Organisationen, die KI-Sichtbarkeitskrisen erkennen wollen, sollten diese praktischen Best Practices umsetzen: Etablieren Sie kontinuierliches Monitoring für KI-Inputs und -Outputs anstelle gelegentlicher Audits, sodass Krisen innerhalb von Minuten und nicht Tagen erkannt werden. Investieren Sie in Team-Schulungen, damit Kundendienst, Produktmanagement und Krisenteams KI-spezifische Risiken verstehen und Frühwarnzeichen in Kundeninteraktionen und Social Feedback erkennen. Führen Sie regelmäßige Audits der Trainingsdaten-Qualität, Modellperformance und Erkennungsgenauigkeit mindestens quartalsweise durch, um Schwachstellen zu beheben, bevor sie zu Krisen werden. Pflegen Sie detaillierte Dokumentationen aller KI-Systeme, deren Datenquellen, bekannter Einschränkungen und früherer Vorfälle, um bei Krisen die Ursachen schneller zu analysieren. Schließlich sollten Sie KI-Sichtbarkeitsmonitoring direkt in Ihr Krisenmanagement-Framework integrieren, damit KI-spezifische Alarme dieselben schnellen Reaktionsprotokolle wie klassische PR-Krisen auslösen – mit klaren Eskalationswegen und autorisierten Entscheidern. Unternehmen, die KI-Sichtbarkeit als kontinuierlichen operativen Schwerpunkt behandeln und nicht als gelegentliches Risiko, berichten von 75 % weniger krisenbedingten Kundenauswirkungen und einer dreimal schnelleren Erholung im Ernstfall.

Eine KI-Sichtbarkeitskrise tritt auf, wenn KI-Modelle wie ChatGPT, Perplexity oder Google AI Overviews ungenaue, negative oder irreführende Informationen über Ihre Marke liefern. Anders als traditionelle Social-Media-Krisen können sich diese Informationen rasch über KI-Systeme verbreiten und Millionen von Nutzern erreichen, ohne in klassischen Suchergebnissen oder Social-Media-Feeds sichtbar zu sein.

Social Listening verfolgt, was Menschen über Ihre Marke in sozialen Netzwerken und im Web sagen. Die KI-Sichtbarkeitsüberwachung erfasst, was KI-Modelle tatsächlich über Ihre Marke aussagen, wenn sie Nutzerfragen beantworten. Beides ist wichtig, weil soziale Gespräche KI-Trainingsdaten beeinflussen, aber die finale KI-Antwort ist das, was die meisten Nutzer sehen.

Wichtige Warnzeichen sind plötzliche Einbrüche im positiven Sentiment, starke Zunahme von Erwähnungen aus Quellen mit geringer Autorität, KI-Modelle empfehlen Wettbewerber, Halluzinationen zu Ihren Produkten und negatives Sentiment in Quellen mit hoher Autorität wie Nachrichtenportalen oder Reddit.

KI-Sichtbarkeitskrisen können sich sehr schnell entwickeln. Ein viraler Social-Media-Post kann Millionen Menschen innerhalb von Stunden erreichen. Enthält er Fehlinformationen, können diese die KI-Trainingsdaten beeinflussen und bereits nach wenigen Tagen oder Wochen – je nach Update-Zyklus des Modells – in KI-Antworten erscheinen.

Sie benötigen einen zweistufigen Ansatz: Social-Listening-Tools (wie Brandwatch oder Mention) zur Überwachung der Quellen, die KI-Modelle speisen, sowie KI-Überwachungstools (wie AmICited oder GetMint), um zu verfolgen, was KI-Modelle tatsächlich aussagen. Die besten Lösungen vereinen beide Fähigkeiten.

Zuerst gilt es, die Ursache mithilfe von Quellverfolgung zu identifizieren. Danach veröffentlichen Sie autoritativen Content, der die Fehlinformationen widerlegt. Abschließend überwachen Sie die KI-Antworten, um zu prüfen, ob die Korrektur wirksam war. Dies erfordert sowohl Krisenmanagement- als auch Content-Optimierungs-Know-how.

Auch wenn Sie nicht alle Krisen verhindern können, reduzieren proaktive Überwachung und schnelle Reaktion die Auswirkungen erheblich. Durch frühzeitige Erkennung und Ursachenbehebung lassen sich kleine Vorfälle davon abhalten, zu größeren Reputationsproblemen zu werden.

Beobachten Sie Sentiment-Trends, Erwähnungsvolumen, Share of Voice in KI-Antworten, Häufigkeit von Halluzinationen, Quellenqualität, Reaktionszeiten und Kundenauswirkungen. Diese Kennzahlen helfen, die Krisenschwere zu verstehen und die Wirksamkeit Ihrer Reaktion zu messen.

Erkennen Sie KI-Sichtbarkeitskrisen, bevor sie Ihrem Ruf schaden. Erhalten Sie Frühwarnsignale und schützen Sie Ihre Marke auf ChatGPT, Perplexity und Google AI Overviews.

Erfahren Sie, wie Sie sich mit Monitoring, Krisenhandbüchern und Managementstrategien für ChatGPT, Perplexity und Google AI auf KI-Suchkrisen vorbereiten.

Erfahren Sie, wie Sie KI-Sichtbarkeitskrisen mit proaktivem Monitoring, Frühwarnsystemen und strategischen Reaktionsprotokollen verhindern. Schützen Sie Ihre Ma...

Erfahren Sie, wie Sie KI-Sichtbarkeitsprobleme strategisch priorisieren. Entdecken Sie das Framework zur Identifizierung kritischer, hoher und mittlerer Priorit...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.