Fluency-Optimierung

Erfahren Sie, wie die Fluency-Optimierung die Sichtbarkeit von Inhalten in KI-Suchergebnissen verbessert. Entdecken Sie Schreibtechniken, die KI-Systemen helfen...

Meistern Sie die Fluency-Optimierung, um LLM-freundliche Inhalte zu erstellen, die häufiger zitiert werden. Lernen Sie, wie Sie natürlich fließende Inhalte verfassen, die von KI-Systemen bevorzugt zitiert und referenziert werden.

Fluency-Optimierung ist die Praxis, Inhalte so zu gestalten, dass sie natürlich lesbar sind und gleichzeitig von großen Sprachmodellen leicht zitiert werden können. Im Gegensatz zum traditionellen SEO, das auf Keyword-Platzierung und -Dichte setzt, priorisiert die Fluency-Optimierung semantische Klarheit, logischen Fluss und Informationsdichte. Es geht darum, menschzentriert zu schreiben und dennoch maschinell auffindbar zu bleiben. LLMs scannen nicht nur nach Keywords – sie verstehen Kontext, Zusammenhänge und die Gesamt-Kohärenz Ihrer Botschaft. Wenn Ihre Inhalte natürlich fließen und Ideen klar präsentieren, werden sie von LLMs deutlich öfter als Quelle in Antworten zitiert.

Moderne Sprachmodelle verarbeiten Inhalte semantisch statt rein syntaktisch – sie verstehen Bedeutung und Kontext statt nur Keyword-Übereinstimmungen. Diese grundlegende Veränderung hat die Art, wie Inhalte von KI-Systemen gefunden und zitiert werden, revolutioniert. Studien zeigen, dass fluency-optimierte Inhalte in LLM-Antworten 15-30% mehr Sichtbarkeit erzielen als klassisch SEO-optimierte. Der Grund ist einfach: LLMs sind darauf trainiert, hochwertige, autoritative Quellen zu erkennen, und flüssiges Schreiben signalisiert Qualität und Fachkompetenz. Wenn Sie den natürlichen Sprachfluss über Keyword-Dichte stellen, machen Sie Ihre Inhalte tatsächlich auffindbarer für die Systeme, die zunehmend Traffic und Sichtbarkeit steuern.

| Aspekt | Fokus traditionelles SEO | Fokus Fluency-Optimierung |

|---|---|---|

| Sprachstil | Keyword-lastig, mitunter holprig | Natürlich, konversationell, fließend |

| Keyword-Ansatz | Dichteziele (1-2%), exakte Treffer | Semantische Varianten, kontextuelle Relevanz |

| Satzstruktur | Auf Lesbarkeits-Scores optimiert | Auf Ideen-Klarheit und Rhythmus optimiert |

| Leseerlebnis | Nachrangig zu Ranking-Signalen | Haupttreiber für Inhaltsqualität |

| KI-Zitatrate | Niedriger (nur Keyword-Matching) | Höher (30-40% mehr Zitate mit Quotes) |

Flüssige Inhalte vereinen mehrere Schlüsselelemente, die gemeinsam natürlich zitierbares Material erschaffen. Es geht nicht darum, Algorithmen auszutricksen – sondern effektiv mit Menschen und Maschinen zu kommunizieren. Wenn Sie diese Grundlagen meistern, werden Ihre Inhalte zu Quellen, die LLMs gerne aufgreifen.

Klarheit ist das Fundament der Fluency-Optimierung. Wenn Ihre Inhalte schwer verständlich sind, können LLMs keine sinnvollen Informationen extrahieren und Menschen springen ab. Klarheit bedeutet, dass Ihre Hauptaussagen sofort ersichtlich sind, Ihre Erklärungen vollständig und Ihre Sprache präzise ist. Es geht nicht darum, Inhalte zu vereinfachen – sondern darum, die Zeit und Intelligenz der Lesenden zu respektieren. Schreiben Sie klar, beseitigen Sie die Reibung, die Mensch und Maschine vom Mitdenken abhält.

So macht Klarheit Inhalte zitierfähiger:

UNKLAR:

"Die Implementierung fortschrittlicher technologischer Lösungen kann potenziell

Verbesserungen bei Effizienzkennzahlen in verschiedenen organisatorischen Kontexten erleichtern."

KLAR:

"Mit den richtigen Tools arbeiten Teams schneller und schaffen mehr mit weniger Ressourcen."

UNKLAR:

"Verschiedene Forscher haben angedeutet, dass Verbraucherverhalten durch viele Faktoren beeinflusst werden kann."

KLAR:

"Drei Faktoren bestimmen das Verbraucherverhalten: Preis, Bequemlichkeit und Markentrust.

Studien zeigen: Preis beeinflusst 45% der Kaufentscheidungen, Bequemlichkeit und Vertrauen jeweils rund 30%."

Die zweite Version jedes Beispiels ist zitierfähiger, weil sie spezifisch, umsetzbar und sofort verständlich ist. LLMs erkennen diese Klarheit und zitieren sie wahrscheinlicher.

Der Rhythmus Ihrer Sprache beeinflusst direkt, wie LLMs Ihre Inhalte verarbeiten und zitieren. Unterschiedlich lange Sätze schaffen einen natürlichen Takt, der zum Lesen einlädt und von Sprachmodellen leichter analysiert werden kann. Kurze Sätze setzen Akzente. Mittlere transportieren Informationen. Lange Sätze erlauben Komplexität. Durch gezieltes Variieren entsteht ein natürlicher Fluss – im Gegensatz zu monotonen, roboterhaften Texten.

Wiederholte Satzmuster sind ein zentraler Fluency-Killer. Wenn jeder Satz nach dem gleichen Muster – Subjekt, Verb, Objekt, Punkt – aufgebaut ist, wirkt Ihr Text monoton und weniger zitierfähig. Variieren Sie also! Beginnen Sie Sätze auch mal mit Nebensätzen. Stellen Sie Fragen, um Lesende zu aktivieren. Teilen Sie komplexe Gedanken auf mehrere Sätze auf. Diese Vielfalt ist nicht nur Stil, sondern Funktion: Sie hilft LLMs, die Wichtigkeit einzelner Aussagen zu erkennen und erhöht die Wahrscheinlichkeit, als Zitat gewählt zu werden.

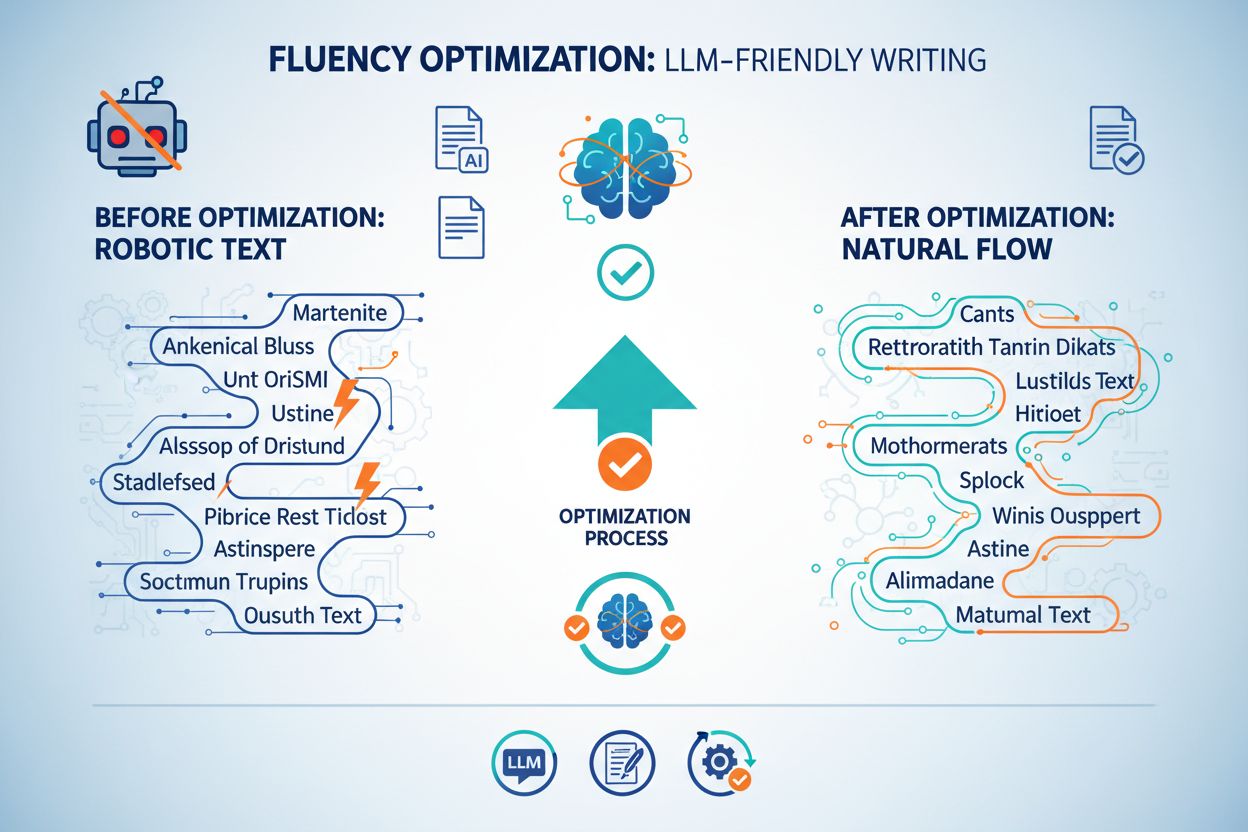

Ironischerweise werden Inhalte, die wie von KI geschrieben klingen, von LLMs weniger gern zitiert. Sprachmodelle sind auf menschliche Texte trainiert und erkennen Muster, die auf geringe Qualität oder Unauthentizität hindeuten. Bestimmte Formulierungen und Strukturen sind Warnsignale und mindern die Zitierbarkeit. Diese Fluency-Killer lassen Ihren Text generisch, bürokratisch oder maschinell wirken – genau das Gegenteil Ihres Ziels.

Typische Fluency-Killer und wie Sie sie vermeiden:

Killer: Übermäßige Absicherungen

Killer: Vages Unternehmensjargon

Killer: Wiederholte Übergangsphrasen

Semantische Keyword-Integration heißt, verwandte Begriffe, Synonyme und kontextuelle Varianten natürlich einzubinden. Statt das genaue Keyword immer wieder zu erzwingen, weben Sie Variationen ein, die das Thema umfassend abdecken. Das erhöht Ihre Sichtbarkeit bei LLMs, weil es die thematische Tiefe signalisiert. Studien zeigen: Keyword-Stuffing senkt die Sichtbarkeit um ca. 10%, semantische Integration erhöht die Zitatrate um 30-40%.

Denken Sie dabei an das thematische Ökosystem, nicht an einzelne Keywords. Schreiben Sie z.B. über „Content Marketing“, tauchen automatisch Begriffe wie „Audience Engagement“, „Brand Storytelling“, „Content-Strategie“, „Redaktionsplan“ und „Leser-Insights“ auf. Diese Varianten passen, weil sie relevant sind, nicht weil Sie sie erzwingen. LLMs erkennen diese semantischen Cluster als Zeichen für Autorität und Vollständigkeit. Auch Leser profitieren, weil das Thema aus mehreren Blickwinkeln beleuchtet wird.

LLMs zitieren konkrete, datenbasierte Inhalte viel häufiger als generische Aussagen. Mit Zahlen, echten Beispielen und spezifischen Erkenntnissen schaffen Sie Material, das von Natur aus zitierbar ist. Der Unterschied ist frappierend: Spezifische Inhalte erhalten 30-40% mehr Zitate, weil sie echten Wert bieten, den LLMs weitergeben können.

Zum Vergleich:

Generisch: “Viele Unternehmen haben Probleme mit Content Marketing.” Spezifisch: “73% der B2B-Websites verloren im letzten Jahr an Traffic – vor allem wegen ineffizienter Content-Strategien und mangelnder Optimierung für KI-Sichtbarkeit.”

Generisch: “KI verändert, wie Menschen Informationen finden.” Spezifisch: “LLM-Traffic wächst monatlich um 40%, und 86% aller KI-Zitate stammen aus markengesteuerten Quellen – Unternehmen mit optimierten Inhalten steuern ihre KI-Sichtbarkeit direkt.”

Die spezifischen Versionen sind zitierfähig, weil sie konkrete Daten liefern, auf die sich Lesende und LLMs beziehen können. Mit dieser Präzision schaffen Sie Inhalte, die nicht nur zitiert werden könnten – sondern es werden. Nicht jeder Satz braucht eine Statistik, aber strategisch platzierte Daten steigern die Zitierbarkeit deutlich.

Wie Ihre Inhalte strukturiert sind, beeinflusst Lesbarkeit und LLM-Verarbeitung. Überschriften, Absatzlänge, Listen und Weißraum führen Leser und helfen Sprachmodellen, die Hierarchie und Organisation Ihres Contents zu erkennen. Kurze Absätze (2-4 Sätze) lassen sich leichter scannen und zitieren. Überschriften gliedern und signalisieren Themenwechsel. Aufzählungen und Nummerierungen machen Informationen leicht verdaulich und zitierbar. Tabellen ordnen komplexe Fakten für Mensch und Maschine übersichtlich.

Weißraum ist in der Fluency-Optimierung unterschätzt. Dichte Textblöcke wirken abschreckend und sind schwerer für LLMs zu analysieren. Mit Überschriften, kurzen Absätzen und Listen erleichtern Sie Sprachmodellen das Extrahieren bedeutungsvoller Abschnitte. Diese Struktur-Klarheit steigert die Zitatwahrscheinlichkeit, weil LLMs gezielt und einfach auf gut organisierte Inhalte zugreifen können.

Ihr Ton sollte authentisch und konversationell, zugleich professionell und autoritativ sein. Diese Balance ist für Fluency-Optimierung entscheidend, denn sie signalisiert LLMs: Hier schreibt ein kompetenter Mensch, keine Maschine. Ein gesprächiger Ton funktioniert bei beiden Zielgruppen besser, weil er vertrauenswürdiger und einladender wirkt. Ziel: Klingen Sie wie ein Experte, der einem Kollegen etwas erklärt – nicht wie ein Memo oder Lehrbuch.

Tonalität, die funktioniert:

Tonalität, die nicht funktioniert:

Der Unterschied ist subtil, aber entscheidend. Eine gesprächige, selbstbewusste Tonalität signalisiert Expertise und steigert die Zitierbarkeit. Formeller, unsicherer Ton hingegen mindert die Wahrscheinlichkeit, als Quelle gewählt zu werden.

Für Fluency-Optimierung muss nicht Ihre ganze Content-Strategie umgebaut werden. Wenden Sie die Prinzipien zunächst auf zentrale Inhalte an und integrieren Sie sie Schritt für Schritt ins Tagesgeschäft. Mit dieser Checkliste prüfen und verbessern Sie die Fluency vor der Veröffentlichung.

Fluency-Optimierungs-Checkliste:

Den Effekt der Fluency-Optimierung erkennen Sie nicht nur an klassischen Metriken. Neben organischem Traffic und Rankings sollten Sie im Blick haben, wie oft Ihre Inhalte von LLMs zitiert werden und in welchem Kontext. Tools zur KI-Zitat-Verfolgung werden immer wichtiger, um Ihre Sichtbarkeit im KI-getriebenen Suchumfeld zu verstehen. Sie können die Fluency-Wirkung messen, indem Sie Zitatraten vor und nach der Optimierung vergleichen, das Wachstum KI-getriebenen Traffics verfolgen und analysieren, welche Texte am häufigsten zitiert werden.

Der Zusammenhang zwischen Fluency und Zitaten ist stark und messbar. Inhalte mit hoher Fluency – also Klarheit, Spezifität, semantischer Breite und natürlichem Flow – erzielen regelmäßig 30-40% mehr Zitate. Das ist kein Zufall: LLMs sind darauf trainiert, hochwertige Quellen zu erkennen und zu nutzen. Mit Fokus auf Fluency steigern Sie direkt den Wert Ihrer Inhalte für die KI-Systeme, die Sichtbarkeit und Traffic immer stärker bestimmen. Tracken Sie diese Kennzahlen monatlich, um zu verstehen, welche Fluency-Elemente für Ihr Publikum und Ihre Inhalte am wichtigsten sind.

Ein B2B-SaaS-Unternehmen optimierte seine Produktdokumentation nach Fluency-Prinzipien. Vorher war die Dokumentation technisch korrekt, aber dicht und jargonlastig. Nach Umstrukturierung für Klarheit, Einbau konkreter Beispiele und abwechslungsreicher Satzstruktur wurde sie 35% öfter in LLM-Antworten zitiert. Die Schlüsseländerungen: Lange Absätze in 2-3-Satz-Sequenzen aufteilen, Fachjargon durch klare Erklärungen ersetzen und spezifische Anwendungsbeispiele ergänzen. Nach drei Monaten stieg der KI-getriebene Traffic auf die Doku-Seiten um 28%.

Eine Content-Marketing-Agentur wandte Fluency-Optimierung auf den Blog ihres Kunden an. Die ursprünglichen Texte waren keyword-optimiert, lasen sich aber wie eine Checkliste. Die optimierte Version behielt die Keywords bei, schrieb aber mit natürlichem Flow, ergänzte konkrete Datenpunkte und variierte die Satzstruktur. Ergebnis: Die Zitatrate stieg von 12% auf 38% der veröffentlichten Artikel, die in LLM-Antworten zitiert wurden. Der Kunde stellte zudem ein Plus von 22% beim organischen Traffic fest, da die gesteigerte Fluency auch menschliche Leser stärker ansprach. Das Fazit: Von Fluency-Optimierung profitieren beide Zielgruppen zugleich.

Mit dem anhaltenden LLM-Traffic-Wachstum von 40% pro Monat wird Fluency-Optimierung von “nice-to-have” zur Kernkompetenz. Unternehmen, die Fluency beherrschen, steuern ihre Sichtbarkeit in KI-getriebenen Suchergebnissen, während andere zunehmend übersehen werden. Der Wettbewerbsvorteil liegt bei denen, die verstehen: Für LLMs zu schreiben heißt nicht, Algorithmen auszutricksen – sondern bessere Inhalte zu liefern, die Mensch und Maschine gleichermaßen dienen.

Die Zukunft der Content-Strategie ist fluency-first. Das heißt nicht, klassisches SEO oder Nutzererlebnis zu vernachlässigen. Es heißt, dass die besten Inhalte für alle Zielgruppen – Menschen, Suchmaschinen und Sprachmodelle – von Natur aus optimiert sind. Wer Klarheit, Spezifität und natürlichen Flow priorisiert, schafft Inhalte, die wertvoll, auffindbar, teilbar und zitierfähig sind. Unternehmen, die jetzt auf Fluency-Optimierung setzen, etablieren sich als Autorität im KI-Zeitalter – wer zögert, wird in den Systemen, die moderne Reichweite und Traffic bestimmen, immer unsichtbarer.

Fluency-Optimierung ist die Praxis, Inhalte mit natürlichem, klarem Sprachfluss zu verfassen, die LLMs leicht verstehen und zitieren können. Im Fokus stehen semantische Klarheit, abwechslungsreiche Satzstrukturen und Lesbarkeit statt Keyword-Dichte, was zu 15-30% mehr Sichtbarkeit in KI-generierten Antworten führt.

Traditionelles SEO betont Keyword-Matching und Backlinks, während Fluency-Optimierung semantisches Verständnis und natürlichen Sprachfluss priorisiert. LLMs verarbeiten Inhalte semantisch – daher erzielen flüssig geschriebene, klar strukturierte Texte, die Fragen direkt beantworten, bei KI-Zitaten bessere Ergebnisse als keyword-optimierte Inhalte.

Nein. Fluency-Optimierung ergänzt traditionelles SEO sogar. Klar und gut geschriebene Inhalte, die in LLM-Antworten gut abschneiden, sind meist auch in der Google-Suche erfolgreich. Der Fokus auf Klarheit und Struktur kommt sowohl Lesern als auch Suchalgorithmen zugute.

Häufige Fluency-Killer sind wiederholte Satzstrukturen, übermäßiger Einsatz von Gedankenstrichen, zu formeller Ton, Keyword-Stuffing, vage Sprache und inkonsistente Begriffe. Solche Muster signalisieren LLMs KI-erstellte oder minderwertige Inhalte und verringern die Zitatwahrscheinlichkeit.

Verfolgen Sie Kennzahlen wie LLM-Referral-Traffic, Markenerwähnungen in KI-Antworten, Zitatfrequenz auf Plattformen wie ChatGPT und Perplexity sowie Engagement-Metriken von KI-vermittelten Besuchern. Tools wie Profound und Semrush helfen, KI-Sichtbarkeit und Zitatmuster zu überwachen.

Nein. Fluency-Optimierung gilt für alle Inhaltstypen – Produktbeschreibungen, FAQs, Blogbeiträge und Social Media. Prinzipien wie Klarheit, natürlicher Flow und semantische Kohärenz steigern die Performance aller Formate in klassischer wie KI-Suche.

AmICited überwacht, wie Ihre Marke auf KI-Plattformen wie ChatGPT, Perplexity und Google AI Overviews zitiert und referenziert wird. Fluency-Optimierung verbessert Ihre Zitatraten direkt, indem Ihre Inhalte für LLMs attraktiver werden, was AmICited dann nachverfolgt und berichtet.

Entity Clarity – also die konsistente Nennung und Positionierung Ihrer Marke über Plattformen hinweg – geht Hand in Hand mit Fluency. Flüssige Inhalte, die den Wert Ihrer Marke klar erklären, kombiniert mit konsistenten Entity-Signalen, steigern die Zitatrate von LLMs und die Markenpräsenz in KI-Antworten erheblich.

AmICited verfolgt, wie Ihre Marke in ChatGPT, Perplexity und Google AI Overviews zitiert wird. Entdecken Sie, welche Inhalte KI-Zitate generieren, und optimieren Sie Ihre Fluency-Strategie auf Basis echter Daten.

Erfahren Sie, wie die Fluency-Optimierung die Sichtbarkeit von Inhalten in KI-Suchergebnissen verbessert. Entdecken Sie Schreibtechniken, die KI-Systemen helfen...

Erfahren Sie, was LLMO ist, wie es funktioniert und warum es für die Sichtbarkeit im Bereich KI wichtig ist. Entdecken Sie Optimierungstechniken, um Ihre Marke ...

Erfahren Sie, wie Sie Keywords für KI-Suchmaschinen optimieren. Entdecken Sie Strategien, mit denen Ihre Marke in ChatGPT-, Perplexity- und Google-AI-Antworten ...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.