YMYL (Your Money Your Life)

YMYL-Inhalte erfordern hohe E-E-A-T-Standards. Erfahren Sie, was als Your Money Your Life-Inhalt gilt, warum dies für SEO und KI-Sichtbarkeit wichtig ist und wi...

Erfahren Sie, wie Gesundheitsorganisationen medizinische Inhalte für die Sichtbarkeit bei LLMs optimieren, YMYL-Anforderungen erfüllen und KI-Zitationen mit der KI-Überwachungsplattform von AmICited.com überwachen können.

Your Money or Your Life (YMYL)-Inhalte umfassen Themen, die das Wohlbefinden der Nutzer direkt beeinflussen, darunter Gesundheit, Finanzen, Sicherheit und Bürgerinformationen – und das Gesundheitswesen steht an der Spitze von Googles Überprüfungshierarchie. Nach Googles Core-Update im März 2024 reduzierte der Suchgigant die Sichtbarkeit minderwertiger Inhalte um 40 %, was auf ein beispielloses Vorgehen gegen unzuverlässige medizinische Informationen hindeutet. Die Herausforderung für Gesundheitsorganisationen hat sich jedoch grundlegend verschoben: Inhalte müssen nun nicht nur für Suchmaschinen, sondern auch für Large Language Models (LLMs) sichtbar sein, die zunehmend die erste Anlaufstelle für Gesundheitssuchende werden. Mit 5 % aller Google-Suchanfragen, die gesundheitsbezogen sind, und 58 % der Patienten, die nun KI-Tools für Gesundheitsinformationen nutzen, stehen Gesundheitsdienstleister vor einer kritischen Sichtbarkeitslücke – ihre Inhalte können in der klassischen Suche gut ranken, bleiben aber für die KI-Systeme, die Patienten tatsächlich konsultieren, unsichtbar. Diese Doppelanforderung an Sichtbarkeit stellt eine völlig neue Grenze in der Content-Strategie des Gesundheitswesens dar.

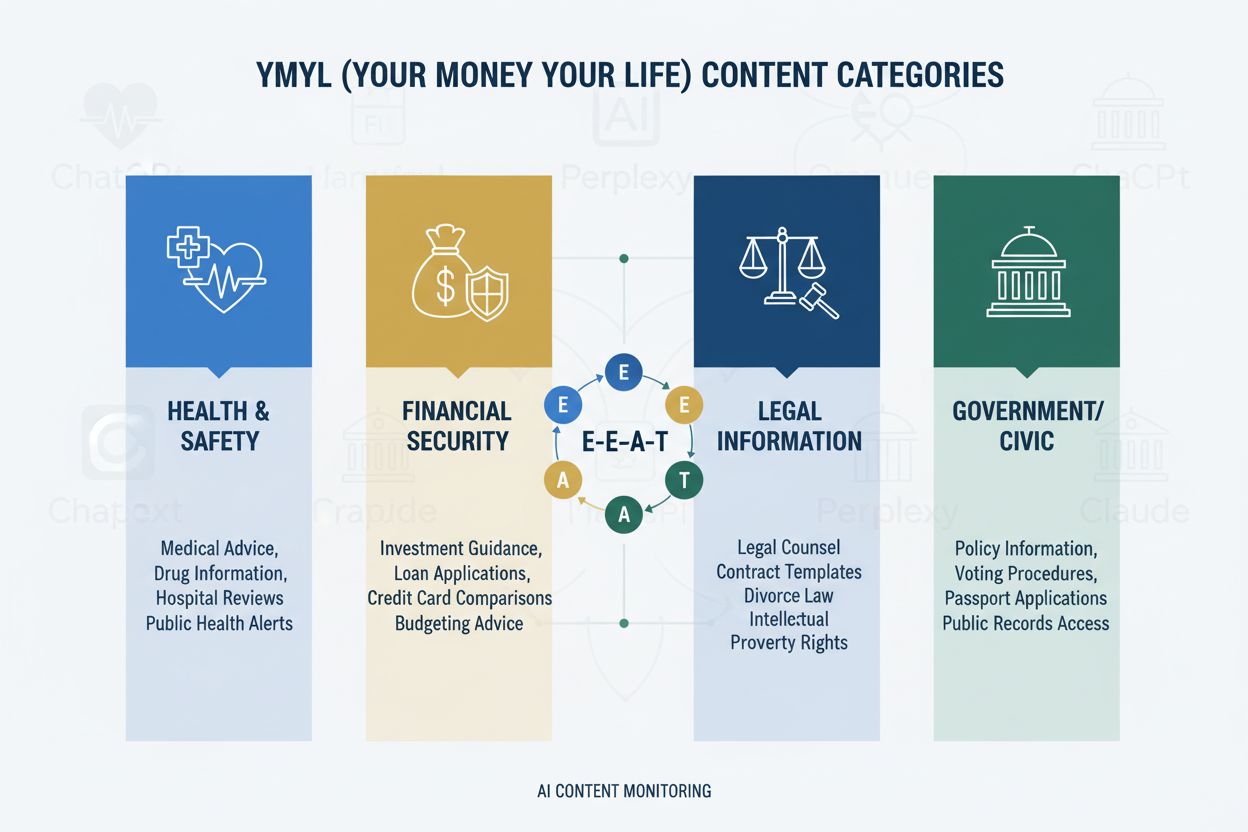

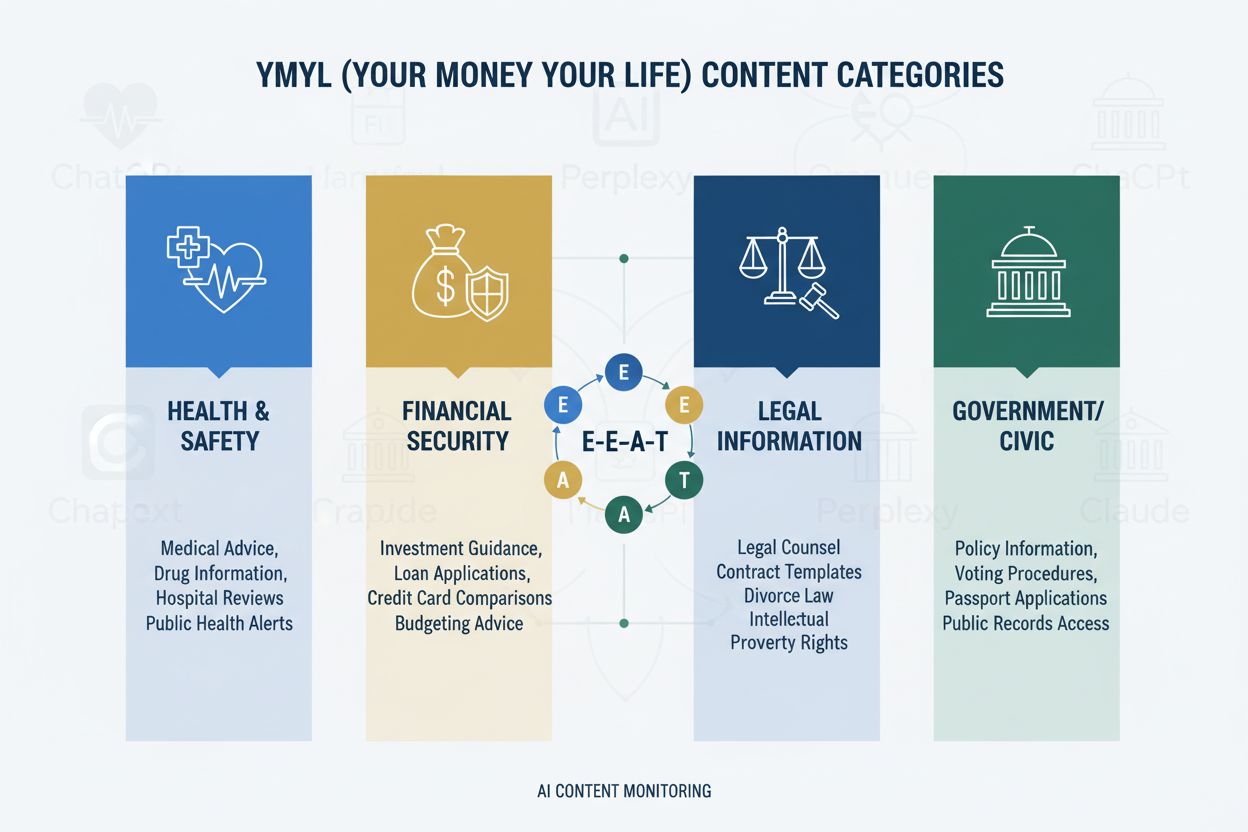

Das YMYL-Rahmenwerk kategorisiert Inhalte in vier kritische Bereiche: Gesundheit (medizinische Zustände, Behandlungen, Wohlbefinden), Finanzen (Anlageberatung, Finanzplanung), Sicherheit (Notfallverfahren, Sicherheit) und Bürgerliches (Wahlen, Rechtsangelegenheiten) – wobei das Gesundheitswesen aufgrund seines direkten Einflusses auf das menschliche Wohlbefinden die höchste Prüfungsstufe einnimmt. Googles E-E-A-T-Rahmenwerk (Erfahrung, Fachwissen, Autorität, Vertrauenswürdigkeit) dient als Bewertungsstandard und verlangt, dass Gesundheitsinhalte echtes medizinisches Wissen, berufliche Qualifikationen und überprüfbare Genauigkeit nachweisen. Die Quality Rater Guidelines betonen ausdrücklich, dass Gesundheitsinhalte von qualifizierten medizinischen Fachkräften erstellt oder überprüft werden müssen, mit klaren Autorenangaben und institutioneller Rückendeckung. Gesundheitsorganisationen müssen verstehen, dass E-E-A-T keine Option ist – es ist die Grundvoraussetzung sowohl für Suchmaschinen-Sichtbarkeit als auch für die Aufnahme in LLMs. Nachfolgend die Wirkungshierarchie der YMYL-Kategorien:

| YMYL-Kategorie | Auswirkungsgrad | Prüfungsintensität | Relevanz im Gesundheitswesen |

|---|---|---|---|

| Gesundheit | Kritisch | Höchste | Direkte Patientensicherheit |

| Finanzen | Hoch | Hoch | Versicherung, Kosten |

| Sicherheit | Hoch | Hoch | Notfallprotokolle |

| Bürgerliches | Mittel | Mittel | Gesundheitspolitik |

Trotz ihrer Raffinesse weisen LLMs alarmierende Fehlerraten bei der Verarbeitung medizinischer Informationen auf. Stanford HAI-Forschung dokumentiert 30–50 % nicht gestützte Aussagen in Gesundheitsantworten. GPT-4 mit Retrieval-Augmented Generation (RAG) erzeugt immer noch Antworten, bei denen 50 % nicht überprüfbare Behauptungen enthalten, selbst wenn sie mit autoritativen Quellen trainiert wurden – ein Phänomen, das als Halluzination bezeichnet wird und sich darin äußern kann, dass etwa nicht existierende medizinische Geräte empfohlen, falsche Behandlungsprotokolle vorgeschlagen oder Arzneimittelinteraktionen erfunden werden. Ein bemerkenswerter Fall war, als die Men’s Journal einen KI-generierten Artikel veröffentlichte, der 18 spezifische medizinische Fehler enthielt, darunter gefährliche Behandlungsempfehlungen, die Lesern schaden könnten. Das Grundproblem ist, dass KI “Erfahrung” fehlt – das klinische Wissen aus erster Hand, das erfahrene Ärzte von statistischen Mustersystemen unterscheidet. Diese Lücke bedeutet, dass LLMs ohne richtig strukturierte, autoritative Inhalte von verifizierten medizinischen Fachleuten selbstbewusst plausibel klingende, aber potenziell gefährliche medizinische Ratschläge generieren.

KI-Überblicke und ähnliche LLM-basierte Antwortsysteme verändern grundlegend, wie Patienten Gesundheitsinformationen entdecken, indem sie direkte Antworten liefern, ohne dass ein Website-Besuch erforderlich ist – das beseitigt praktisch den traditionellen Klick, der den Web-Traffic im Gesundheitswesen jahrzehntelang angetrieben hat. Die Sichtbarkeit von Inhalten hängt nun von der Zitation in KI-Antworten ab, nicht von der Rankingposition. Das bedeutet, dass ein Artikel eines Gesundheitsdienstleisters in eine KI-Antwort einfließen kann, ohne jemals Traffic oder Attribution zu erhalten. LLMs fassen gleichzeitig Informationen aus mehreren Quellen zusammen und schaffen so eine neue Informationsarchitektur, in der einzelne Websites um die Aufnahme in KI-generierte Zusammenfassungen konkurrieren, nicht um die Top-Suchpositionen. Gesundheitsdienstleister müssen erkennen, dass Share of Model (SOM) – der Prozentsatz der KI-Antworten, die ihre Inhalte zitieren – zur zentralen Sichtbarkeitskennzahl geworden ist und die klassischen Klickraten ersetzt. Dieser Paradigmenwechsel erfordert ein Umdenken in der Content-Strategie: Anstatt für Klicks zu optimieren, müssen Gesundheitsorganisationen für Zitationsqualität, Genauigkeit und strukturelle Klarheit optimieren, damit ihre Inhalte die bevorzugte Quelle für LLM-Synthese werden.

LLMs verarbeiten medizinische Inhalte am effektivsten, wenn sie mit klarer hierarchischer Struktur organisiert sind, die dem klinischen Entscheidungsprozess entspricht: Krankheitsdefinition → Symptomdarstellung → Diagnosekriterien → Behandlungsoptionen → Prognose. Architektur der progressiven Offenlegung – einfache Konzepte werden vor komplexen präsentiert – ermöglicht LLMs den Aufbau korrekter mentaler Modelle, anstatt verwandte, aber unterschiedliche Zustände zu vermischen. Question-first-Content-Design (zuerst „Was ist Erkrankung X?“ beantworten, dann „Wie wird sie behandelt?“) entspricht der Art, wie LLMs Informationen aus mehreren Dokumenten abrufen und zusammenfassen. Semantische Tiefe und vernetzte Konzepte – das explizite Verknüpfen verwandter Erkrankungen, Behandlungen und Risikofaktoren – hilft LLMs, Beziehungen zu erkennen, die sonst implizit blieben. Die Implementierung von Schema.org-Medical-Markup (MedicalCondition, MedicalProcedure, MedicalTreatment) liefert strukturierte Daten, die LLMs zuverlässig parsen und zitieren können. Natürliche Sprache, die einer Experten-Erklärung ähnelt – mit Begriffen, die Ärzte verwenden würden, aber dennoch verständlich bleibt – signalisiert Authentizität sowohl für LLMs als auch für menschliche Leser. Gesundheitsorganisationen sollten bestehende Inhalte anhand dieser Strukturkriterien prüfen, denn traditionell SEO-optimierte Inhalte fehlen oft die hierarchische Klarheit und semantische Tiefe, die LLMs für korrekte Synthese benötigen.

Plattformübergreifende Präsenz verstärkt Autoritätssignale auf eine Weise, wie es Einzelwebseiten-Strategien nicht können, da LLMs konsequente Expertise über mehrere autoritative Kanäle hinweg erkennen. Medizinische Q&A-Plattformen wie HealthTap und Figure 1 bieten direkte Interaktion zwischen Ärzten und Patienten, die LLMs als authentische Expertise anerkennen – mit verifizierten Qualifikationen und Echtzeit-Engagement. Professionelle Netzwerke wie Doximity und medizinisch fokussierte LinkedIn-Communities schaffen Peer-Recognition und berufliches Ansehen, das LLMs bei der Bewertung von Autorität stark gewichten. Beiträge zu medizinischen Wikipedia-Artikeln und ähnlichen kollaborativen Wissensdatenbanken signalisieren die Bereitschaft, zum öffentlichen medizinischen Wissen beizutragen, ohne kommerzielles Interesse – ein Vertrauenssignal, das LLMs erkennen. Umfassende Autoren-Credibility-Pages – mit Facharztanerkennungen, Veröffentlichungen, klinischer Erfahrung und institutionellen Zugehörigkeiten – müssen auf der Hauptwebsite vorhanden und plattformübergreifend verlinkt sein. Plattformübergreifende Konsistenz in Qualifikationen, Fachgebieten und klinischen Perspektiven verstärkt Authentizität; Widersprüche zwischen Plattformen machen LLMs skeptisch. Gesundheitsorganisationen sollten eine plattforübergreifende Autoritätsstrategie entwickeln, die jede Plattform als verstärkendes Signal und nicht als separaten Kanal betrachtet und dafür sorgt, dass ärztliche Expertise im gesamten digitalen Ökosystem sichtbar und überprüfbar ist.

Traditionelle Analysen im Gesundheitswesen – wie organischer Traffic, Klickraten und Suchrankings – erfassen die KI-Sichtbarkeit überhaupt nicht und schaffen so einen gefährlichen blinden Fleck, in dem Inhalte nach alten Kennzahlen erfolgreich erscheinen, aber für LLMs unsichtbar bleiben. Share of Model (SOM) wird zur entscheidenden neuen Kennzahl: Sie misst, wie viel Prozent der KI-generierten Antworten zu einem bestimmten Thema auf die Inhalte Ihrer Organisation verweisen. Effektives Monitoring erfordert systematische Tests auf mehreren LLM-Plattformen (ChatGPT, Claude, Perplexity und aufstrebende Wettbewerber) mit konsistenten Anfragen zu Ihren Fachgebieten und die Dokumentation von Zitierhäufigkeit und Platzierung in den Antworten. Zitationsqualität ist genauso wichtig wie Häufigkeit – als Hauptquelle zitiert zu werden wiegt mehr als als zweitrangige Referenz zu erscheinen, und LLMs erkennen, ob Inhalte für spezifische Expertise oder für allgemeine Informationen zitiert werden. Monitoring-Tools reichen von manuellen Tests (Anfragen stellen und Ergebnisse dokumentieren) bis zu Automatisierungsplattformen, die SOM-Veränderungen im Zeitverlauf verfolgen und auf Sichtbarkeitsverschiebungen hinweisen. Indirekte Indikatoren wie gebrandetes Suchvolumen, Patientenrückmeldungen mit KI-Empfehlungsbezug und Zuweisungen von KI-Plattformen liefern ergänzende Daten, die SOM-Trends validieren. Gesundheitsorganisationen sollten sofort Baseline-SOM-Messwerte etablieren, denn das Wettbewerbsumfeld verschiebt sich rasant und frühe Sichtbarkeitsvorteile verstärken sich mit der Zeit.

Gesundheitsorganisationen sollten mit einem einzelnen Fachgebiet beginnen, anstatt eine organisationsweite Transformation gleichzeitig anzustreben, so dass Teams Erfahrung sammeln und Prozesse verfeinern können, bevor sie skalieren. Content-Audits aus LLM-Perspektive erfordern die Bewertung bestehender Artikel auf hierarchische Klarheit, semantische Tiefe, Question-first-Architektur und Autoren-Credibility – oft zeigt sich, dass gut rankende Inhalte nicht die Struktur aufweisen, die LLMs benötigen. Sichtbarkeitstests auf KI-Plattformen mittels fachspezifischer Anfragen schaffen einen Baseline-SOM und machen sichtbar, welche Erkrankungen und Behandlungen aktuell sichtbar oder unsichtbar sind. Die Einführung von Question-first-Architektur beinhaltet die Umstrukturierung bestehender Inhalte oder das Erstellen neuer Inhalte, die mit Patientenfragen („Warum habe ich dieses Symptom?“) beginnen, bevor klinische Erklärungen folgen. Autoren-Credibility-Pages sollten für jeden ärztlichen Beitragenden erstellt werden, mit Angaben zu Facharztanerkennungen, Fachgebieten, Publikationen und klinischer Erfahrung, und konsistent von allen Autoreninhalten aus verlinkt werden. Content-Clustering rund um Erkrankungen – also die Erstellung vernetzter Inhalte zu Symptomen, Diagnose, Behandlungsoptionen und Prognose – hilft LLMs, umfassende Krankheitsinformationen statt isolierter Artikel zu erfassen. Dieser phasenweise Ansatz ermöglicht es Gesundheitsorganisationen, Wirkung zu messen, Strategien zu verfeinern und interne Kompetenz aufzubauen, bevor auf weitere Fachgebiete ausgeweitet wird.

HIPAA-Konformität bleibt entscheidend, auch wenn Inhalte für LLMs sichtbar werden; Datenschutz für Patienten gilt unabhängig davon, ob Informationen über Suchmaschinen oder KI-Systeme abgerufen werden, und verlangt sorgfältige Anonymisierung und De-Identifizierung von Fallbeispielen. Medizinische Disclaimer und Genauigkeitsanforderungen müssen explizit und deutlich sein, mit klaren Aussagen, dass KI-synthetisierte Informationen keine professionelle medizinische Beratung ersetzen und individuelle Umstände von allgemeinen Empfehlungen abweichen können. Faktenprüfung und Quellennennung werden zentrale Compliance-Elemente, da Gesundheitsorganisationen für die Richtigkeit der von ihnen veröffentlichten Informationen haften und LLMs Fehler tausendfach verstärken. Die regulatorische Prüfung von KI-generierten medizinischen Inhalten nimmt zu; FDA und FTC prüfen verstärkt, wie KI-Systeme medizinische Informationen präsentieren. Gesundheitsorganisationen müssen sicherstellen, dass alle Inhalte – ob von Menschen verfasst oder KI-unterstützt – regulatorischen Standards entsprechen. Menschliche medizinische Überprüfung durch qualifizierte Ärzte bleibt für alle Gesundheitsinhalte obligatorisch, mit dokumentierten Prozessen, die Engagement für Genauigkeit und Sicherheit belegen. Haftungsfragen gehen über klassische ärztliche Kunstfehler hinaus und umfassen potenzielle Haftung für Informationen, die LLMs synthetisieren und Patienten präsentieren; Gesundheitsorganisationen sollten rechtlichen Rat zu ihrer Verantwortung für die Nutzung ihrer Inhalte in KI-Systemen einholen. Compliance und Sicherheit dürfen im Streben nach KI-Sichtbarkeit niemals zweitrangig behandelt werden.

KI wird die Entdeckung von Gesundheitsinformationen weiter in rasantem Tempo verändern, LLMs werden immer besser im medizinischen Schlussfolgern und immer zentraler für die Recherche von Patienten zu Gesundheitszuständen. Gesundheitsorganisationen, die ihre Content-Strategie jetzt anpassen, positionieren sich als vertrauenswürdige Quellen im entstehenden Ökosystem, während diejenigen, die zögern, Gefahr laufen, für die KI-Systeme, die ihre Patienten tatsächlich nutzen, unsichtbar zu werden. Frühe Anwender sichern sich Wettbewerbsvorteile durch etablierte Autoritätssignale, höhere Share-of-Model-Werte und Patient:innenvertrauen durch konsistente Sichtbarkeit in KI-Antworten – Vorteile, die sich verstärken, je besser LLMs zuverlässige Quellen erkennen und priorisieren. Die Integration von traditionellem SEO und LLM-Optimierung ist keine Entweder-oder-Entscheidung, sondern eine ergänzende Strategie, da Suchmaschinen zunehmend LLM-Technologie einbinden und Patienten weiterhin mehrere Informationsquellen nutzen. Langfristige Nachhaltigkeit hängt von echter Expertise ab statt von Optimierungstricks; Gesundheitsorganisationen, die in authentisches medizinisches Wissen, transparente Qualifikationen und präzise Informationen investieren, werden unabhängig von den sich wandelnden Discovery-Mechanismen erfolgreich sein. Die Landschaft für Gesundheitsinhalte hat sich grundlegend verschoben, und Organisationen, die diesen Wandel als Chance begreifen, werden die Zukunft der Patient:inneninformation prägen.

YMYL (Your Money Your Life) bezieht sich auf Inhalte, die sich erheblich auf die Gesundheit, finanzielle Stabilität oder Sicherheit von Menschen auswirken können. Das Gesundheitswesen ist die Kategorie mit der höchsten Prüfung, da medizinische Fehlinformationen ernsthaften Schaden oder Tod verursachen können. Google wendet strengere algorithmische Standards auf YMYL-Inhalte an, und LLMs werden zunehmend von Patienten zur Recherche von Gesundheitsinformationen genutzt, wodurch YMYL-Konformität für die Sichtbarkeit entscheidend wird.

LLMs fassen Informationen aus mehreren Quellen zusammen, um direkte Antworten zu liefern, während Suchmaschinen einzelne Seiten ranken. Gesundheitsinhalte müssen jetzt so strukturiert sein, dass sie von KI-Systemen zitiert werden können, nicht nur für Google-Rankings. Das bedeutet, dass Ihre Inhalte Tausende durch KI-Antworten aufklären könnten, ohne direkten Website-Traffic zu erhalten, was einen grundlegend anderen Optimierungsansatz erfordert.

E-E-A-T steht für Erfahrung, Fachwissen, Autorität und Vertrauenswürdigkeit. Für Gesundheitsinhalte gelten die höchsten E-E-A-T-Standards, wobei besonderes Augenmerk auf medizinische Erfahrung aus erster Hand und verifizierte Qualifikationen gelegt wird. Googles Quality Rater Guidelines erwähnen E-E-A-T 137 Mal, was die entscheidende Bedeutung für die Sichtbarkeit von Gesundheitsinhalten sowohl in der Suche als auch in LLM-Systemen widerspiegelt.

Studien zeigen, dass KI 30-50 % der Zeit nicht gestützte medizinische Aussagen produziert und medizinische Informationen halluziniert. KI fehlt die reale medizinische Erfahrung und sie kann Informationen nicht mit aktuellen medizinischen Standards abgleichen. Deshalb bleiben menschliche medizinische Überprüfung und Expertenautorschaft unerlässlich – KI sollte Gesundheitsfachkräfte unterstützen, nicht ersetzen.

Testen Sie Ihre Inhalte in ChatGPT, Claude und Perplexity mit häufigen Patientenfragen in Ihrem Fachgebiet. Verfolgen Sie Share of Model (SOM)-Metriken – den Prozentsatz der KI-Antworten, die Ihre Inhalte zitieren. AmICited.com automatisiert diese Überwachung und bietet Echtzeit-Einblicke, wie Ihre Gesundheitsmarke auf mehreren LLM-Plattformen erscheint.

Traditionelles SEO konzentriert sich darauf, einzelne Seiten für Keywords zu ranken. LLM-Optimierung betont umfassende Abdeckung, semantische Tiefe und strukturierte Inhalte, die von KI-Systemen verstanden und zitiert werden können. Beide Ansätze sind komplementär – Gesundheitsorganisationen benötigen integrierte Strategien, die sowohl für Suchmaschinen als auch für LLMs optimieren.

KI sollte nur als Werkzeug zur Unterstützung menschlicher medizinischer Experten eingesetzt werden, nicht um sie zu ersetzen. Alle Gesundheitsinhalte müssen vor der Veröffentlichung von qualifizierten medizinischen Fachkräften überprüft und freigegeben werden. Das Risiko ist zu hoch, um sich bei Gesundheitsinhalten auf KI-Generierung ohne Expertenaufsicht und -prüfung zu verlassen.

AmICited.com überwacht, wie Gesundheitsmarken und medizinische Inhalte in KI-Antworten über ChatGPT, Perplexity, Google KI-Überblicke und andere LLM-Plattformen erscheinen. Es liefert Sichtbarkeitsmetriken, verfolgt den Share of Model (SOM) und bietet Optimierungsempfehlungen, damit Gesundheitsorganisationen sicherstellen können, dass ihre Expertise durch KI-gestützte Patientenrecherche auffindbar ist.

Verfolgen Sie, wie Ihre medizinischen Inhalte in ChatGPT, Perplexity, Google KI-Überblicken und anderen LLM-Plattformen erscheinen. Erhalten Sie Echtzeit-Einblicke in Ihren Share of Model (SOM) und optimieren Sie für KI-gesteuerte Patientengewinnung.

YMYL-Inhalte erfordern hohe E-E-A-T-Standards. Erfahren Sie, was als Your Money Your Life-Inhalt gilt, warum dies für SEO und KI-Sichtbarkeit wichtig ist und wi...

Erfahren Sie, was YMYL-Themen in der KI-Suche sind, wie sie die Sichtbarkeit Ihrer Marke in ChatGPT, Perplexity und den Google KI-Übersichten beeinflussen und w...

Erfahren Sie, wie Sie Your Money or Your Life (YMYL)-Inhalte für KI-Suchmaschinen wie ChatGPT, Perplexity und Googles KI-Übersichten optimieren. Beherrschen Sie...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.