JavaScript-Rendering für KI

Erfahren Sie, wie JavaScript-Rendering die Sichtbarkeit in KI-Systemen beeinflusst. Entdecken Sie, warum KI-Crawler kein JavaScript ausführen können, welche Inh...

Erfahren Sie, wie Prerendering JavaScript-Inhalte für KI-Crawler wie ChatGPT, Claude und Perplexity sichtbar macht. Entdecken Sie die besten technischen Lösungen für KI-Suchmaschinen-Optimierung und verbessern Sie Ihre Sichtbarkeit in KI-gestützten Suchergebnissen.

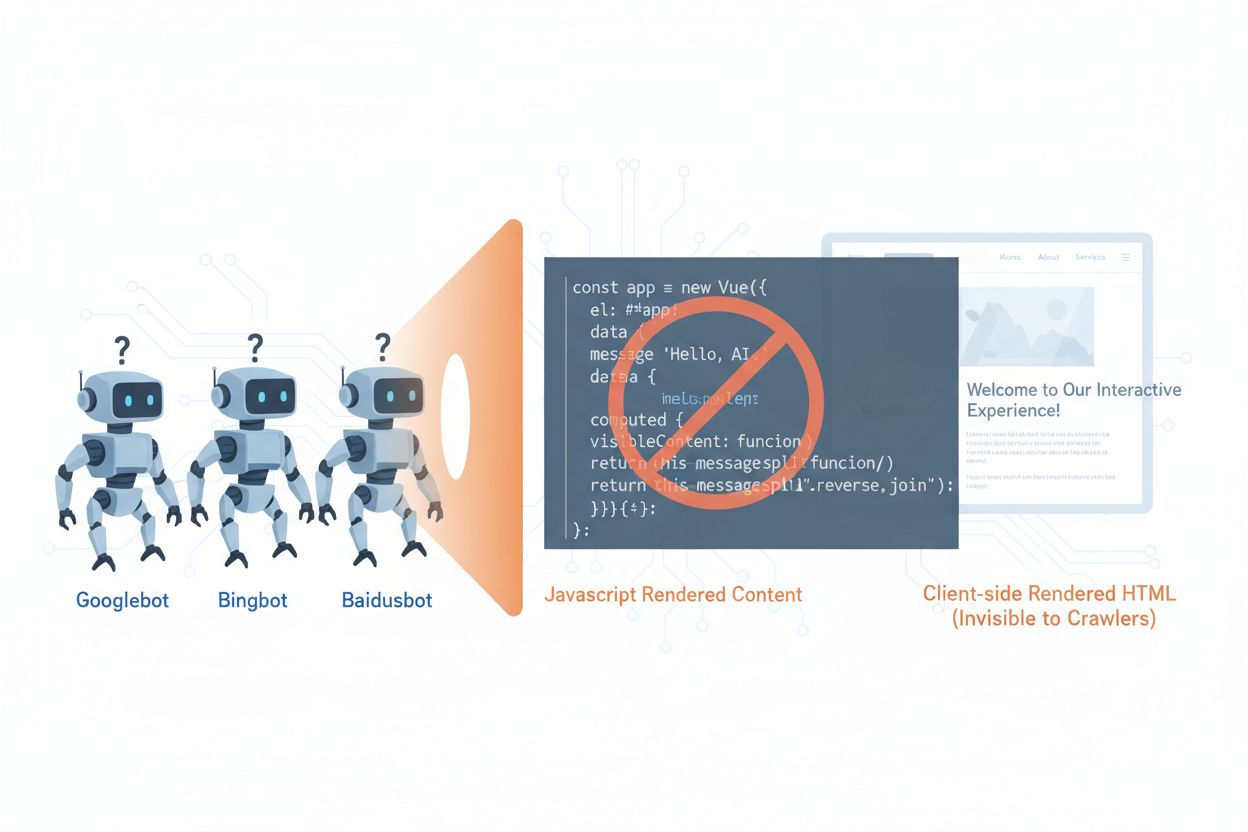

KI-Crawler wie GPTBot, ClaudeBot und PerplexityBot haben die Art und Weise, wie Inhalte im Web entdeckt und indexiert werden, grundlegend verändert. Sie stehen jedoch vor einer entscheidenden Einschränkung: Sie können kein JavaScript ausführen. Das bedeutet, dass alle Inhalte, die dynamisch durch JavaScript gerendert werden – also moderne Single-Page-Applications (SPAs), dynamische Produktseiten und interaktive Dashboards – für diese Crawler komplett unsichtbar bleiben. Laut aktuellen Daten machen KI-Crawler mittlerweile ca. 28 % des Googlebot-Traffics aus, was sie zu einem bedeutenden Teil des Crawl-Budgets Ihrer Website und zu einem entscheidenden Faktor für die Inhaltszugänglichkeit macht. Wenn ein KI-Crawler eine Seite anfordert, erhält er nur das initiale HTML-Gerüst ohne den gerenderten Inhalt und sieht effektiv eine leere oder unvollständige Version Ihrer Seite. Das erzeugt ein Paradoxon: Ihre Inhalte sind für menschliche Nutzer mit JavaScript-fähigen Browsern perfekt sichtbar, aber für die KI-Systeme, die zunehmend die Inhaltserkennung, Zusammenfassung und das Ranking in KI-gestützten Suchmaschinen und Anwendungen bestimmen, unsichtbar.

Die technischen Gründe für die JavaScript-Einschränkungen von KI-Crawlern liegen in grundlegenden architektonischen Unterschieden zwischen Browsern und Crawlern bei der Verarbeitung von Webinhalten. Browser verfügen über eine vollständige JavaScript-Engine, die Code ausführt, das DOM (Document Object Model) manipuliert und die finale visuelle Darstellung erzeugt, während KI-Crawler meist nur minimale oder gar keine JavaScript-Funktionen haben – aus Ressourcengründen und wegen Sicherheitsaspekten. Asynchrones Nachladen – wenn Inhalte erst nach dem initialen Seitenladen per API geholt werden – stellt ein weiteres großes Problem dar, da Crawler nur das initiale HTML erhalten, bevor der eigentliche Inhalt erscheint. Single-Page-Applications (SPAs) verschärfen das Problem, weil sie vollständig auf clientseitiges Routing und Rendering setzen und Crawlern letztlich nur ein JavaScript-Bundle liefern. So unterscheiden sich die Rendering-Methoden im Hinblick auf die Sichtbarkeit für KI-Crawler:

| Rendering-Methode | Funktionsweise | KI-Crawler-Sichtbarkeit | Performance | Kosten |

|---|---|---|---|---|

| CSR (Client-Side Rendering) | Browser führt JavaScript zur Inhaltsdarstellung aus | ❌ Schlecht | Schnell für Nutzer | Geringe Infrastruktur |

| SSR (Server-Side Rendering) | Server rendert HTML bei jeder Anfrage | ✅ Hervorragend | Langsamer Initial-Load | Hohe Infrastruktur |

| SSG (Static Site Generation) | Inhalte beim Build vorgeneriert | ✅ Hervorragend | Schnellste Ladezeit | Mittel (Buildzeit) |

| Prerendering | Statisches HTML bei Bedarf gecached | ✅ Hervorragend | Schnell | Mittel (ausgeglichen) |

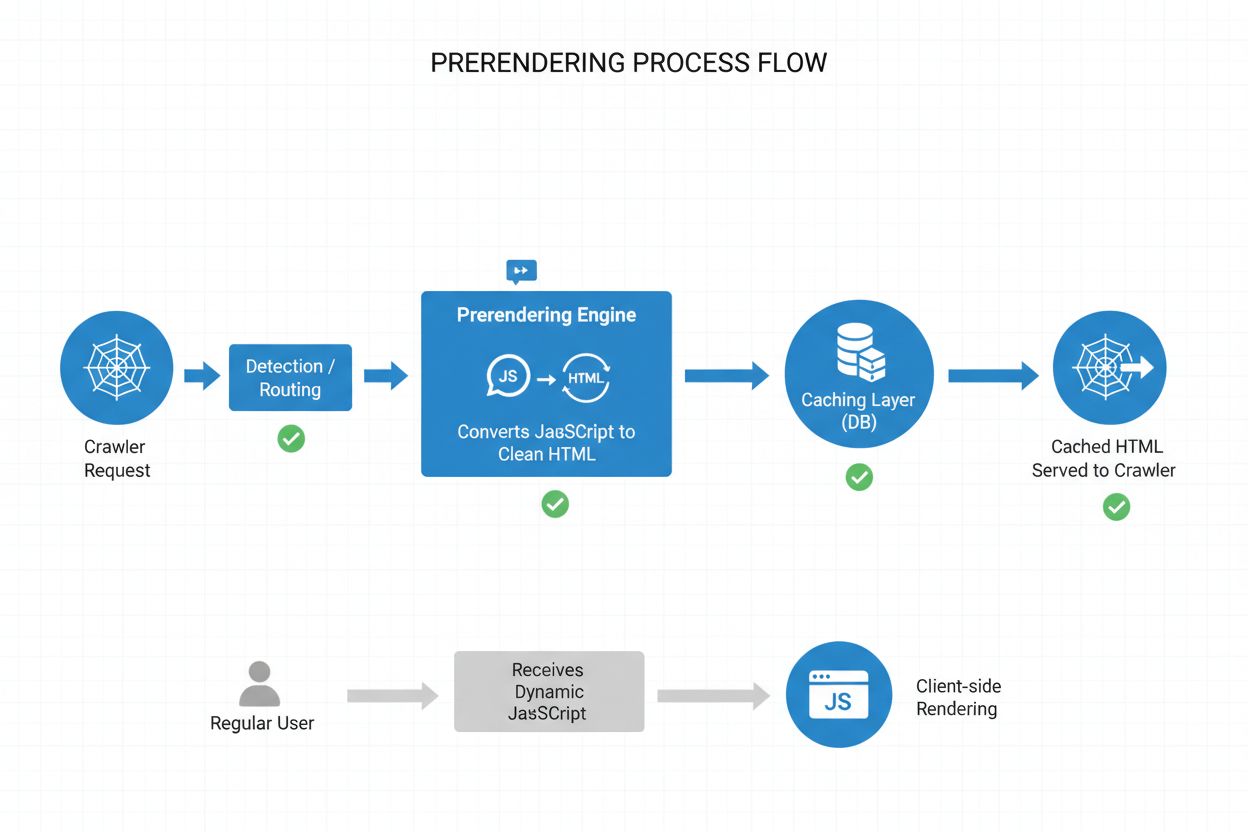

Prerendering bietet einen eleganten Mittelweg zwischen den ressourcenintensiven Anforderungen des Server-Side Renderings und den Build-Time-Limitierungen der statischen Seitengenerierung. Statt Inhalte bei jeder Anfrage (SSR) oder beim Build (SSG) zu rendern, erzeugt Prerendering statische HTML-Snapshots bei Bedarf, wenn ein Crawler oder Bot eine Seite anfordert, und cached diese Version für weitere Anfragen. So erhalten KI-Crawler vollständig gerendertes, statisches HTML mit allen Inhalten, die normalerweise durch JavaScript erzeugt würden, während reguläre Nutzer weiterhin die dynamische, interaktive Version Ihrer Website erhalten – ohne dass sich an deren Erlebnis etwas ändert. Prerendering ist besonders kosteneffizient, weil nur tatsächlich von Crawlern angeforderte Seiten gerendert werden und Sie nicht Ihre gesamte Seite vorab rendern oder teure SSR-Infrastruktur betreiben müssen. Der Wartungsaufwand ist minimal – Ihr Anwendungscode bleibt unverändert, die Prerendering-Schicht läuft transparent im Hintergrund und macht Prerendering zur idealen Lösung für Teams, die KI-Crawler-Zugänglichkeit ohne Architekturumbau erreichen möchten.

Der Prerendering-Prozess folgt einem ausgeklügelten, aber einfachen Workflow, der KI-Crawlern optimierte Inhalte liefert, während Nutzer keinerlei Beeinträchtigung erfahren. Wenn eine Anfrage auf Ihrem Server eingeht, wird zunächst der User-Agent erkannt, um zu bestimmen, ob es sich um einen KI-Crawler (GPTBot, ClaudeBot, PerplexityBot) oder einen regulären Browser handelt. Wird ein KI-Crawler erkannt, wird die Anfrage an die Prerendering-Engine weitergeleitet, die einen Headless-Browser startet, sämtliches JavaScript ausführt, auf asynchrone Daten wartet und einen vollständigen statischen HTML-Snapshot der Seite erzeugt. Dieses HTML wird anschließend gecached (typischerweise für 24–48 Stunden) und direkt an den Crawler ausgeliefert, wodurch Ihre Anwendung entlastet wird. Reguläre Browseranfragen umgehen das Prerendering komplett und erhalten wie gewohnt Ihre dynamische Anwendung mit allen interaktiven Features und Live-Updates. Der gesamte Prozess läuft transparent ab – Crawler sehen vollständig gerenderte Inhalte, Nutzer Ihre Anwendung unverändert, und Ihre Infrastruktur bleibt effizient, weil Prerendering nur bei Bot-Traffic aktiviert wird.

Sowohl Prerendering als auch Server-Side Rendering (SSR) lösen das JavaScript-Problem für Crawler, unterscheiden sich jedoch deutlich in Umsetzung, Kosten und Skalierbarkeit. SSR rendert Inhalte bei jeder einzelnen Anfrage, Ihr Server muss also jedes Mal eine JavaScript-Laufzeitumgebung starten, den gesamten Anwendungscode ausführen und für jeden Besucher ein HTML erzeugen – ein Prozess, der bei großem Traffic sehr teuer wird und die Time to First Byte (TTFB) für alle Nutzer erhöhen kann. Prerendering dagegen cached gerenderte Seiten und generiert sie nur neu, wenn sich Inhalte ändern oder der Cache abläuft, was die Serverlast drastisch reduziert und sowohl für Crawler als auch Nutzer schnellere Antwortzeiten bietet. SSR ist sinnvoll für stark personalisierte oder sich häufig ändernde Inhalte, bei denen jeder Nutzer ein individuelles HTML benötigt, während Prerendering bei eher statischen oder selten aktualisierten Inhalten – Produktseiten, Blogposts, Dokumentationen, Marketing-Inhalten – ideal ist. Viele fortschrittliche Implementierungen nutzen einen hybriden Ansatz: Prerendering für KI-Crawler und statische Inhalte, SSR für personalisierte Nutzererlebnisse und Client-Side Rendering für interaktive Features. Diese gestaffelte Strategie vereint die Vorteile aller Methoden – hervorragende KI-Crawler-Zugänglichkeit, schnelle Performance für Nutzer und überschaubare Infrastrukturkosten.

Strukturierte Daten im JSON-LD-Format sind entscheidend, damit KI-Crawler den Sinn und Kontext Ihrer Inhalte erkennen. Dennoch berücksichtigen viele Implementierungen die Einschränkungen von KI-Crawlern nicht. Werden strukturierte Daten per JavaScript in die Seite injiziert – ein häufiger Anwendungsfall mit Google Tag Manager oder ähnlichen Systemen – sehen KI-Crawler diese Informationen nie, weil sie das JavaScript zur Erzeugung dieser Datenstrukturen nicht ausführen. Das bedeutet, dass Rich Snippets, Produktinformationen, Organisationsdaten und anderes semantisches Markup für KI-Systeme unsichtbar bleiben, obwohl herkömmliche Suchmaschinen längst gelernt haben, JavaScript zu verarbeiten. Die Lösung ist einfach: Alle wichtigen strukturierten Daten müssen im servergerenderten HTML enthalten sein, nicht per JavaScript eingefügt werden. Das kann bedeuten, JSON-LD-Blöcke aus dem Tag Manager in das serverseitige Template Ihrer Anwendung zu verschieben oder Prerendering zu nutzen, um JavaScript-injizierte strukturierte Daten als statisches HTML für Crawler bereitzustellen. KI-Crawler sind stark auf strukturierte Daten angewiesen, um Fakten, Zusammenhänge und Entitäten zu extrahieren – eine serverseitige Implementierung ist daher essenziell für KI-gestützte Suchmaschinen und Knowledge-Graph-Integration.

Die Einführung von Prerendering erfordert eine strategische Herangehensweise, die Abdeckung, Kosten und Wartung ins Gleichgewicht bringt. Gehen Sie folgendermaßen vor:

JavaScript-lastige Seiten identifizieren: Prüfen Sie Ihre Website auf Seiten, bei denen wichtige Inhalte durch JavaScript gerendert werden – typischerweise SPAs, dynamische Produktseiten und Dashboards. Tools wie Lighthouse oder manuelle Prüfung helfen, Seiten zu erkennen, bei denen initiales HTML und gerenderte Version stark abweichen.

Prerendering-Dienst wählen: Entscheiden Sie sich für einen Anbieter wie Prerender.io, der Headless-Browser-Rendering, Caching und Crawler-Erkennung übernimmt. Bewerten Sie Preise, Cache-Dauer, API-Zuverlässigkeit und die Unterstützung Ihres Tech-Stacks.

User-Agent-Erkennung konfigurieren: Richten Sie Ihren Server oder CDN so ein, dass KI-Crawler-User-Agents (GPTBot, ClaudeBot, PerplexityBot, Bingbot, Googlebot) erkannt und an den Prerendering-Dienst weitergeleitet werden, während normale Browser wie gewohnt bedient werden.

Testen und validieren: Nutzen Sie Tools wie curl mit benutzerdefinierten User-Agents, um zu prüfen, ob Crawler vollständig gerendertes HTML erhalten. Testen Sie mit echten KI-Crawler-User-Agents, ob Inhalte sichtbar und strukturierte Daten vorhanden sind.

Ergebnisse überwachen: Richten Sie Logging und Analysen ein, um die Wirksamkeit des Prerenderings, Cache-Trefferquoten und etwaige Fehler beim Rendering zu überwachen. Nutzen Sie die Dashboards Ihres Prerendering-Dienstes für Performance-Metriken und Fehleranalysen.

Effektives Monitoring ist unerlässlich, damit Ihr Prerendering dauerhaft korrekt funktioniert und KI-Crawler auf Ihre Inhalte zugreifen können. Log-Analyse ist dabei Ihr wichtigstes Werkzeug – werten Sie Ihre Server-Logs aus, um Anfragen von KI-Crawler-User-Agents zu erkennen, sehen Sie, welche Seiten sie aufrufen, und identifizieren Sie Muster oder Fehler beim Crawling. Die meisten Prerendering-Dienste wie Prerender.io bieten Dashboards mit Cache-Trefferquoten, Erfolgs- und Fehlermetriken sowie Performance-Statistiken, damit Sie nachvollziehen können, wie effektiv Ihre prerenderten Inhalte ausgeliefert werden. Zu den wichtigsten Kennzahlen zählen Cache-Trefferquote (Anteil der Anfragen aus dem Cache), Rendering-Erfolgsrate (Anteil erfolgreich gerenderter Seiten), durchschnittliche Renderzeit und Crawler-Traffic-Volumen. Richten Sie Alarme für Rendering-Fehler oder ungewöhnliche Crawl-Muster ein, die auf JavaScript-Probleme oder fehlerhafte dynamische Inhalte hinweisen können. Durch die Verknüpfung von Prerendering-Metriken mit Ihren KI-Suchmaschinentraffic- und Sichtbarkeitsdaten können Sie die Wirkung Ihrer Prerendering-Implementierung messen und Optimierungspotenziale identifizieren.

Für erfolgreiches Prerendering sind Sorgfalt und laufende Wartung erforderlich. Vermeiden Sie diese typischen Fehler:

Keine 404-Seiten prerendern: Konfigurieren Sie Ihren Prerendering-Dienst so, dass Seiten mit 404-Status nicht gerendert werden – das Cachen von Fehlerseiten verschwendet Ressourcen und verwirrt Crawler hinsichtlich der Seitenstruktur.

Inhaltsaktualität sicherstellen: Legen Sie Cache-Ablaufzeiten entsprechend der Änderungsfrequenz Ihrer Inhalte fest. Seiten mit viel Traffic und häufigen Änderungen benötigen kürzere (12–24 Stunden), statische Inhalte können länger gecached werden.

Kontinuierlich überwachen: Prerendering ist kein einmaliges Setup – prüfen Sie regelmäßig, ob Seiten korrekt gerendert werden, strukturierte Daten vorhanden sind und Crawler die erwarteten Inhalte erhalten.

Kein Cloaking betreiben: Zeigen Sie Crawlern niemals andere Inhalte als den Nutzern – das verstößt gegen Suchmaschinen-Richtlinien und schadet Ihrer Glaubwürdigkeit. Prerendering sollte Crawlern exakt das zeigen, was Nutzer sehen – nur eben als statisches HTML.

Mit echten Crawlern testen: Verwenden Sie bei Tests die tatsächlichen KI-Crawler-User-Agents, nicht nur generische Bot-Kennungen. Verschiedene Crawler haben teils unterschiedliche Anforderungen oder Einschränkungen beim Rendering.

Inhalte aktuell halten: Wenn prerenderte Inhalte veralten, indexieren Crawler veraltete Informationen. Setzen Sie Cache-Invalidierungsstrategien um, die prerenderte Seiten bei Inhaltsänderungen aktualisieren.

Die Bedeutung der KI-Crawler-Optimierung wird weiter zunehmen, da diese Systeme immer zentraler für die Inhaltsentdeckung und das Wissensmanagement werden. Während heutige KI-Crawler JavaScript nur eingeschränkt ausführen können, deuten neue Technologien wie Comet und Atlas Browser darauf hin, dass künftige Crawler komplexere Rendering-Fähigkeiten besitzen könnten – doch Prerendering wird aus Performance- und Zuverlässigkeitsgründen weiterhin wertvoll sein. Mit einer Prerendering-Implementierung lösen Sie nicht nur das aktuelle KI-Crawler-Problem, sondern machen Ihre Inhalte zukunftssicher gegenüber künftigen Crawler-Fähigkeiten und stellen sicher, dass Ihre Website unabhängig von der Entwicklung der KI-Systeme zugänglich bleibt. Die Annäherung von klassischem SEO und KI-Crawler-Optimierung erfordert einen umfassenden Ansatz: Optimieren Sie sowohl für menschliche Nutzer als auch für KI-Systeme, stellen Sie Ihre Inhalte in mehreren Formaten bereit und bleiben Sie flexibel, um sich an den Wandel anzupassen. Prerendering ist eine pragmatische, skalierbare Lösung, die die Lücke zwischen modernen JavaScript-lastigen Anwendungen und den Zugänglichkeitsanforderungen von KI-gestützter Suche und Discovery schließt – und damit ein unverzichtbarer Bestandteil jeder zukunftsorientierten SEO- und Content-Strategie.

Prerendering erzeugt statische HTML-Snapshots bei Bedarf und cached diese, während Server-Side Rendering (SSR) den Inhalt bei jeder einzelnen Anfrage rendert. Prerendering ist für die meisten Anwendungsfälle kostengünstiger und skalierbarer, während SSR besser für stark personalisierte oder häufig wechselnde Inhalte geeignet ist, die für jeden Nutzer ein einzigartiges HTML benötigen.

Nein, Prerendering betrifft nur, wie Crawler Ihre Inhalte sehen. Normale Nutzer erhalten weiterhin Ihre dynamische, interaktive JavaScript-Anwendung wie zuvor. Prerendering läuft transparent im Hintergrund und hat keinen Einfluss auf die Nutzerfunktionalität oder Performance.

Ablaufzeiten des Caches hängen davon ab, wie häufig sich Ihre Inhalte ändern. Seiten mit viel Traffic und häufigen Änderungen benötigen möglicherweise Cache-Zeiten von 12-24 Stunden, während statische Inhalte längere Zeitspannen nutzen können. Die meisten Prerendering-Dienste ermöglichen es, Cachezeiten pro Seite oder Template festzulegen.

Ja, Prerendering funktioniert auch bei dynamischen Inhalten gut. Sie können für häufig wechselnde Seiten eine kürzere Cache-Ablaufzeit setzen oder Strategien zur Cache-Invalidierung implementieren, die prerenderte Seiten bei Inhaltsänderungen aktualisieren. So sehen Crawler immer relativ frische Inhalte.

Die wichtigsten KI-Crawler sind GPTBot (ChatGPT), ClaudeBot (Claude) und PerplexityBot (Perplexity). Sie sollten auch weiterhin für traditionelle Crawler wie Googlebot und Bingbot optimieren. Die meisten Prerendering-Dienste unterstützen Konfigurationen für alle großen KI- und Such-Crawler.

Wenn Sie bereits SSR nutzen, ist Ihre Seite gut für KI-Crawler zugänglich. Prerendering kann trotzdem Vorteile bringen, indem es die Serverlast reduziert, die Performance verbessert und eine Caching-Schicht bietet, die Ihre Infrastruktur effizienter und skalierbarer macht.

Überwachen Sie das Dashboard Ihres Prerendering-Dienstes auf Cache-Trefferquoten, Render-Erfolgsmetriken und Leistungsstatistiken. Prüfen Sie Ihre Server-Logs auf Anfragen von KI-Crawlern und vergewissern Sie sich, dass diese vollständig gerendertes HTML erhalten. Verfolgen Sie Veränderungen Ihrer KI-Sichtbarkeit und Zitate im Zeitverlauf.

Die Kosten für Prerendering variieren je nach Dienst und Nutzungsvolumen. Die meisten Anbieter bieten gestaffelte Preise basierend auf der Anzahl der pro Monat gerenderten Seiten. Die Kosten sind in der Regel deutlich niedriger als der Betrieb einer Server-Side Rendering-Infrastruktur und machen Prerendering für die meisten Websites zu einer kosteneffizienten Lösung.

Verfolgen Sie mit AmICited, wie KI-Plattformen wie ChatGPT, Claude und Perplexity auf Ihre Inhalte verweisen. Erhalten Sie Echtzeit-Einblicke in Ihre KI-Sichtbarkeit und optimieren Sie Ihre Content-Strategie.

Erfahren Sie, wie JavaScript-Rendering die Sichtbarkeit in KI-Systemen beeinflusst. Entdecken Sie, warum KI-Crawler kein JavaScript ausführen können, welche Inh...

Erfahren Sie, wie Sie Ihre Inhalte für KI-Crawler wie ChatGPT, Perplexity und Googles KI sichtbar machen. Entdecken Sie technische Anforderungen, Best Practices...

Erfahren Sie, wie JavaScript die Sichtbarkeit für KI-Crawler beeinflusst. Entdecken Sie, warum KI-Bots kein JavaScript rendern können, welche Inhalte dadurch ve...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.