Wie Sie sicherstellen, dass KI-Crawler alle Ihre Inhalte sehen

Erfahren Sie, wie Sie Ihre Inhalte für KI-Crawler wie ChatGPT, Perplexity und Googles KI sichtbar machen. Entdecken Sie technische Anforderungen, Best Practices...

Erfahren Sie, wie SSR- und CSR-Rendering-Strategien die Sichtbarkeit für KI-Crawler, Markenzitate in ChatGPT und Perplexity sowie Ihre gesamte Präsenz in der KI-Suche beeinflussen.

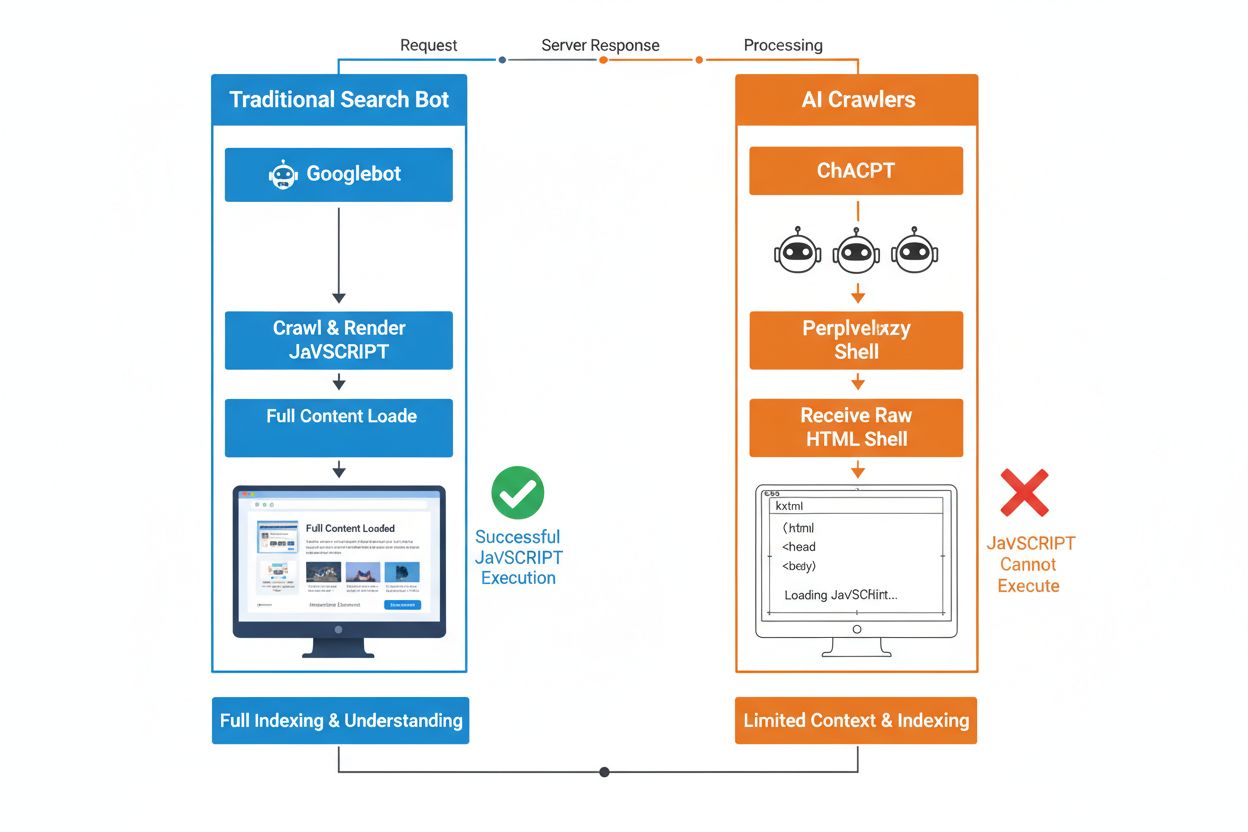

Der grundlegende Unterschied zwischen traditionellen Suchbots und KI-Crawlern liegt in ihrem Umgang mit der Ausführung von JavaScript. Während Googlebot und andere traditionelle Suchmaschinen JavaScript rendern können (wenn auch mit Ressourcenbeschränkungen), führen KI-Crawler wie GPTBot, ChatGPT-User und OAI-SearchBot überhaupt kein JavaScript aus – sie sehen nur das rohe HTML, das beim ersten Laden der Seite ausgeliefert wird. Diese entscheidende Unterscheidung bedeutet: Wenn der Inhalt Ihrer Website vom client-seitigen JavaScript-Rendering abhängt, erhalten KI-Systeme nur eine unvollständige oder leere Version Ihrer Seiten – Produktdetails, Preisinformationen, Bewertungen und andere dynamische Inhalte, die Nutzer im Browser sehen, fehlen. Das Verständnis dieser Lücke ist essenziell, da KI-gestützte Suchergebnisse rasant zu einem primären Entdeckungskanal für informationssuchende Nutzer werden.

Server-seitiges Rendering (SSR) verbessert die KI-Sichtbarkeit grundlegend, indem es beim ersten Request vollständig gerendertes HTML direkt vom Server liefert und die Notwendigkeit der JavaScript-Ausführung für KI-Crawler eliminiert. Bei SSR sind alle wichtigen Inhalte – Überschriften, Fließtext, Produktinformationen, Metadaten und strukturierte Daten – bereits im HTML enthalten, das Bots erhalten. So kann dieses sofort in KI-Trainingskorpora und Suchindizes aufgenommen werden. Dieser Ansatz garantiert konsistente Inhaltsauslieferung an alle Crawler, schnellere Indexierung und vollständige Metadaten-Sichtbarkeit, auf die KI-Systeme angewiesen sind, um Ihre Inhalte korrekt zu verstehen und zu zitieren. Die folgende Tabelle zeigt, wie verschiedene Rendering-Strategien die KI-Crawler-Sichtbarkeit beeinflussen:

| Rendering-Typ | Was KI-Crawler sehen | Indexierungsgeschwindigkeit | Inhaltsvollständigkeit | Metadaten-Sichtbarkeit |

|---|---|---|---|---|

| Server-seitiges Rendering (SSR) | Vollständig gerendertes HTML mit allen Inhalten | Schnell (sofort) | Vollständig | Exzellent |

| Client-seitiges Rendering (CSR) | Minimales HTML-Gerüst, dynamische Inhalte fehlen | Langsam (wenn überhaupt gerendert) | Unvollständig | Schlecht |

| Static Site Generation (SSG) | Vorgefertigtes, gecachtes HTML | Sehr schnell | Vollständig | Exzellent |

| Hybrid/Inkremetell | Mischung aus statischen und dynamischen Routen | Mittel bis schnell | Gut (wenn wichtige Seiten vorgerendert) | Gut |

Client-seitiges Rendering (CSR) stellt erhebliche Herausforderungen für die KI-Sichtbarkeit dar, da es Crawler zwingt, auf die Ausführung von JavaScript zu warten – was KI-Bots aufgrund von Ressourcenbeschränkungen und engen Timeouts schlichtweg nicht tun. Beim Laden einer CSR-basierten Seite enthält die initiale HTML-Antwort lediglich ein minimales Gerüst mit Ladespinnern und Platzhaltern, während der eigentliche Inhalt asynchron über JavaScript nachgeladen wird. KI-Crawler setzen strenge Timeouts von 1–5 Sekunden und führen keine Skripte aus – sie erfassen also nur einen leeren oder nahezu leeren Seitensnapshot, dem Produktbeschreibungen, Preise, Bewertungen und andere wichtige Informationen fehlen. Das verursacht ein Kaskadenproblem: Unvollständige Seitensnapshots führen zu schlechter Chunking- und Embedding-Qualität, wodurch die Wahrscheinlichkeit sinkt, dass Ihre Seiten für KI-generierte Antworten ausgewählt werden. Für E-Commerce-Seiten, SaaS-Plattformen und inhaltsreiche Anwendungen, die auf CSR setzen, bedeutet das verlorene Sichtbarkeit in AI Overviews, ChatGPT-Antworten und Perplexity-Ergebnissen – also genau in den Kanälen, die im KI-Zeitalter für Reichweite sorgen.

Der technische Grund, warum KI-Bots kein JavaScript ausführen können, liegt in den grundlegenden Skalierbarkeits- und Ressourcenbeschränkungen ihrer Architektur. KI-Crawler priorisieren Geschwindigkeit und Effizienz vor Vollständigkeit und arbeiten unter strengen Timeouts, weil sie Milliarden von Seiten für das Training und die Aktualisierung von Sprachmodellen verarbeiten müssen. Die Ausführung von JavaScript erfordert das Starten von Headless-Browsern, Speicherzuweisung und das Warten auf asynchrone Abläufe – ein Luxus, der sich bei den für LLM-Training nötigen Crawl-Volumina nicht skalieren lässt. KI-Systeme konzentrieren sich daher auf die Extraktion von sauberem, semantisch strukturiertem HTML, das sofort verfügbar ist, und behandeln statische Inhalte als kanonische Version Ihrer Website. Diese Designentscheidung spiegelt eine grundlegende Wahrheit wider: KI-Systeme sind für die Auslieferung von statischem HTML optimiert, nicht für das Rendern komplexer JavaScript-Frameworks wie React, Vue oder Angular.

Die Auswirkungen auf KI-generierte Antworten und Marken-Sichtbarkeit sind tiefgreifend und betreffen direkt Ihre Geschäftsergebnisse. Wenn KI-Crawler Ihre Inhalte wegen JavaScript-Rendering nicht erfassen können, wird Ihre Marke in KI-Overviews unsichtbar, in Zitaten ausgelassen und in LLM-basierten Suchergebnissen nicht gefunden – selbst wenn Sie in der klassischen Google-Suche gut ranken. Für E-Commerce bedeutet das, dass Produktdetails, Preise und Verfügbarkeiten die KI-Systeme nie erreichen – mit der Folge, dass Produktempfehlungen unvollständig oder fehlerhaft sind und Umsatzchancen verloren gehen. SaaS-Unternehmen verlieren Sichtbarkeit bei Feature-Vergleichen und Preisübersichten, die sonst qualifizierte Leads über KI-gestützte Recherchetools bringen würden. News- und Content-Seiten sehen ihre Artikel in KI-Zusammenfassungen außen vor, was den Referral-Traffic von Plattformen wie ChatGPT und Perplexity reduziert. Die Lücke zwischen dem, was Menschen sehen, und dem, was KI-Systeme sehen, erzeugt ein Zwei-Klassen-Sichtbarkeitsproblem: Ihre Seite erscheint nach klassischen SEO-Kennzahlen gesund, ist aber gleichzeitig im am stärksten wachsenden Entdeckungskanal unsichtbar.

Vor-Rendering und hybride Lösungen bieten praktische Wege, die Vorteile beider Rendering-Ansätze zu kombinieren, ohne die Architektur komplett umstellen zu müssen. Anstatt sich zwischen der Interaktivität von CSR und der Crawlability von SSR entscheiden zu müssen, gehen moderne Teams strategisch vor und kombinieren verschiedene Ansätze:

So können Sie weiterhin reichhaltige, interaktive Nutzererlebnisse bieten und gleichzeitig sicherstellen, dass KI-Crawler vollständiges, fertig gerendertes HTML erhalten. Frameworks wie Next.js, Nuxt und SvelteKit machen hybrides Rendering ohne großen Entwicklungsaufwand möglich. Entscheidend ist, jene Seiten zu identifizieren, die Akquise, Umsatz oder Support-Entlastung treiben – diese sollten immer vor- oder server-seitig gerendert werden, um KI-Sichtbarkeit zu garantieren.

Die Rendering-Strategie beeinflusst direkt, wie KI-Systeme Ihre Marke referenzieren und zitieren, weshalb Sie Ihre Sichtbarkeit auf KI-Plattformen unbedingt überwachen sollten. Tools wie AmICited.com tracken, wie KI-Systeme Ihre Marke in ChatGPT, Perplexity, Google AI Overviews und anderen LLM-basierten Plattformen zitieren und zeigen, ob Ihre Inhalte diese Systeme tatsächlich erreichen. Nutzt Ihre Seite CSR ohne Vor-Rendering, zeigt die AmICited-Datenbasis oft einen deutlichen Unterschied: Sie ranken vielleicht in der klassischen Suche, erhalten aber keine Zitate in KI-generierten Antworten. Dieses Monitoring macht die tatsächlichen Kosten von JavaScript-Rendering sichtbar – nicht nur beim Crawl-Effizienz, sondern vor allem bei verlorener Marken-Sichtbarkeit und Zitatchancen. Durch die Implementierung von SSR oder Vor-Rendering und die anschließende Erfolgsmessung mit AmICited können Sie den direkten Einfluss von Rendering-Entscheidungen auf die KI-Sichtbarkeit quantifizieren – und so Investitionen gegenüber Stakeholdern argumentieren, die auf Traffic und Conversions achten.

Die Prüfung und Optimierung Ihrer Rendering-Strategie für KI-Sichtbarkeit erfordert ein systematisches, schrittweises Vorgehen. Identifizieren Sie zunächst die Seiten, die den größten Wert bringen: Produktseiten, Preisübersichten, zentrale Dokumentation und stark frequentierte Blogposts sollten Priorität haben. Nutzen Sie Tools wie Screaming Frog (im “Nur-Text”-Modus) oder Chrome DevTools, um zu vergleichen, was Bots gegenüber Nutzern sehen – fehlen wichtige Inhalte im Quelltext, sind sie JavaScript-abhängig und für KI-Crawler unsichtbar. Wählen Sie dann die passende Rendering-Strategie nach Aktualitätsanforderung: Statische Seiten können SSG nutzen, häufig aktualisierte Inhalte profitieren von SSR oder ISR, und interaktive Features lassen sich per JavaScript über server-gerendertes HTML legen. Anschließend testen Sie mit echten KI-Bots, indem Sie Ihre Seiten an ChatGPT, Perplexity und Claude übermitteln, um zu prüfen, ob die Inhalte erreichbar sind. Schließlich überwachen Sie die Crawling-Logs auf KI-User-Agents (GPTBot, ChatGPT-User, OAI-SearchBot), um sicherzustellen, dass diese Bots Ihre vor- oder server-gerenderten Seiten erfolgreich crawlen. Dieser iterative Ansatz macht Rendering von einer technischen Randnotiz zu einem messbaren Sichtbarkeitshebel.

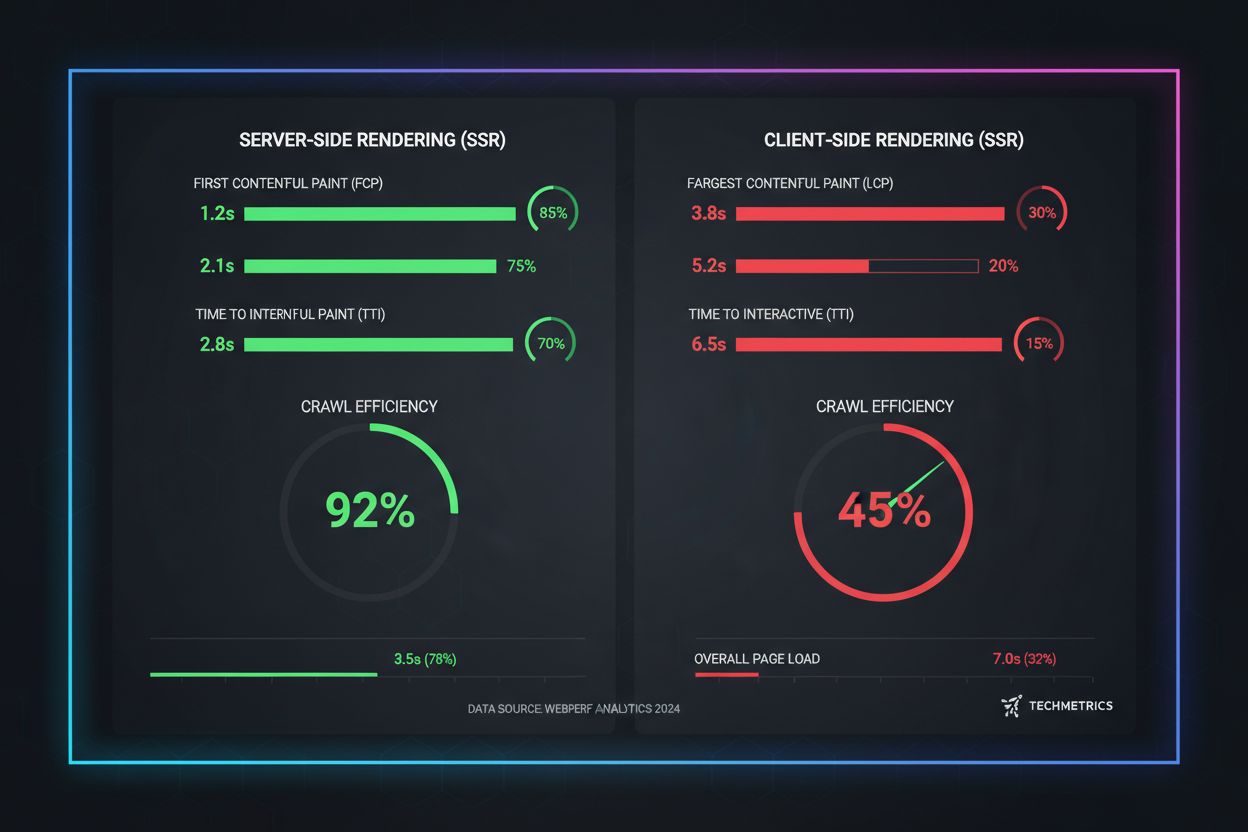

Echte Leistungsmetriken zeigen die dramatischen Unterschiede der Rendering-Ansätze in Bezug auf KI-Crawlability. SSR- und vorgerenderte Seiten erreichen First Contentful Paint (FCP) in 0,5–1,5 Sekunden, während CSR-Seiten oft 2–4 Sekunden oder mehr benötigen, da JavaScript erst heruntergeladen und ausgeführt werden muss. Für KI-Crawler mit 1–5 Sekunden Timeouts entscheidet dieser Unterschied über vollständige Sichtbarkeit oder totale Unsichtbarkeit. Crawl-Effizienz steigt mit SSR drastisch: Eine vorgerenderte E-Commerce-Seite kann in Stunden vollständig gecrawlt und indexiert sein, während eine CSR-Variante Wochen benötigt, weil die Crawler an JavaScript-Rendering scheitern. Auch die Indexierungsgeschwindigkeit ist signifikant: SSR-Seiten tauchen binnen 24–48 Stunden im Index auf, CSR-Seiten erleben oft Verzögerungen von 7–14 Tagen. Für zeitkritische Inhalte wie News, Produktlaunches oder limitierte Angebote wird diese Verzögerung direkt zu verlorener Sichtbarkeit genau dann, wenn Nutzer aktiv suchen.

Die Zukunft der SEO ist untrennbar mit der KI-Sichtbarkeit verbunden – Rendering ist daher eine entscheidende langfristige Investition und kein technisches Randthema. KI-basierte Suche wächst exponentiell: 13,14 % aller Google-Suchergebnisse enthalten mittlerweile AI Overviews, und Plattformen wie ChatGPT verzeichnen monatlich über vier Milliarden Besuche, während Perplexity und Claude rasant an Bedeutung gewinnen. Da KI-Systeme für immer mehr Nutzer zum primären Entdeckungskanal werden, entscheidet Ihre heutige Rendering-Strategie über die Sichtbarkeit von morgen. Kontinuierliches Monitoring ist unerlässlich, denn das Verhalten von KI-Crawlern, Timeout-Schwellen und JavaScript-Support wandeln sich mit der Reife der Systeme. Wer Rendering als einmalige Migration behandelt, riskiert binnen Monaten erneut Unsichtbarkeit, sobald KI-Plattformen ihre Crawl-Strategien ändern. Bauen Sie Rendering-Optimierung daher fest in Ihren Quartalsplan ein, prüfen Sie die KI-Sichtbarkeit regelmäßig in Ihren Regressionstests und nutzen Sie Tools wie AmICited, um zu tracken, ob Ihre Marke bei KI-Entwicklungen sichtbar bleibt. Die Gewinner im KI-Suchmarkt sind jene Marken, die Rendering-Strategie als zentralen Wettbewerbsvorteil und nicht als technischen Schuldenberg betrachten.

KI-Crawler wie GPTBot und ChatGPT-User arbeiten unter strengen Ressourcenbeschränkungen und engen Timeouts (1-5 Sekunden), da sie Milliarden von Seiten verarbeiten müssen, um Sprachmodelle zu trainieren. Die Ausführung von JavaScript erfordert das Starten von Headless-Browsern und das Warten auf asynchrone Vorgänge – ein Luxus, der sich bei dem für LLM-Training nötigen Umfang nicht skalieren lässt. KI-Systeme konzentrieren sich daher auf die Extraktion von sauberem, statischem HTML, das sofort verfügbar ist.

Server-seitiges Rendering liefert bereits beim ersten Request vollständig gerendertes HTML, sodass sämtliche Inhalte für KI-Crawler sofort zugänglich sind, ohne dass JavaScript ausgeführt werden muss. So erreichen Produktdetails, Preise, Bewertungen und Metadaten zuverlässig die KI-Systeme, wodurch die Wahrscheinlichkeit steigt, dass Ihre Marke in KI-generierten Antworten genannt und in AI Overviews angezeigt wird.

Server-seitiges Rendering (SSR) rendert Seiten bedarfsorientiert, sobald eine Anfrage eintrifft, während Vor-Rendering statische HTML-Dateien beim Build erzeugt. Vor-Rendering eignet sich am besten für Inhalte, die sich selten ändern, SSR für regelmäßig aktualisierte Inhalte. Beide Ansätze stellen sicher, dass KI-Crawler vollständiges HTML ohne JavaScript-Ausführung erhalten.

Ja, aber mit erheblichen Einschränkungen. Sie können Vor-Rendering-Tools einsetzen, um statische HTML-Snapshots Ihrer CSR-Seiten zu erzeugen, oder ein hybrides Rendering implementieren, bei dem wichtige Seiten server-seitig gerendert werden, während weniger wichtige client-seitig bleiben. Ohne diese Optimierungen sind CSR-Seiten für KI-Crawler jedoch weitgehend unsichtbar.

Nutzen Sie Tools wie Screaming Frog (Nur-Text-Modus), Chrome DevTools oder die Google Search Console, um zu vergleichen, was Bots im Gegensatz zu Nutzern sehen. Fehlen wichtige Inhalte im Seitenquelltext, sind sie JavaScript-abhängig und für KI-Crawler unsichtbar. Sie können auch direkt mit ChatGPT, Perplexity und Claude testen, ob diese Systeme auf Ihre Inhalte zugreifen können.

SSR- und vorgerenderte Seiten erreichen typischerweise First Contentful Paint (FCP) in 0,5–1,5 Sekunden, während CSR-Seiten oft 2–4+ Sekunden benötigen. Da KI-Crawler mit 1–5 Sekunden Timeouts arbeiten, führt schnelleres Rendering direkt zu besserer KI-Crawlability. Verbesserte Core Web Vitals kommen außerdem der User Experience und klassischen SEO-Rankings zugute.

AmICited überwacht, wie KI-Systeme Ihre Marke in ChatGPT, Perplexity und Google AI Overviews zitieren. Durch das Tracking Ihrer KI-Sichtbarkeit vor und nach der Implementierung von SSR oder Vor-Rendering können Sie den direkten Einfluss von Rendering-Entscheidungen auf Marken-Zitate und KI-Suchpräsenz messen.

Das hängt von Ihren Anforderungen an die Aktualität der Inhalte und Ihren Geschäftsprioritäten ab. Statische Inhalte profitieren von SSG, häufig aktualisierte Inhalte von SSR, und interaktive Funktionen können per JavaScript auf server-gerendertes HTML aufgesetzt werden. Identifizieren Sie zunächst hochwertige Seiten (Produktseiten, Preise, Dokumentation) und priorisieren Sie diese für SSR oder Vor-Rendering.

Verfolgen Sie, wie ChatGPT, Perplexity und Google AI Overviews auf Ihre Marke Bezug nehmen. Verstehen Sie die tatsächlichen Auswirkungen Ihrer Rendering-Strategie auf KI-Zitate.

Erfahren Sie, wie Sie Ihre Inhalte für KI-Crawler wie ChatGPT, Perplexity und Googles KI sichtbar machen. Entdecken Sie technische Anforderungen, Best Practices...

Erfahren Sie, wie JavaScript-Rendering die Sichtbarkeit in KI-Systemen beeinflusst. Entdecken Sie, warum KI-Crawler kein JavaScript ausführen können, welche Inh...

Erfahren Sie, wie Prerendering JavaScript-Inhalte für KI-Crawler wie ChatGPT, Claude und Perplexity sichtbar macht. Entdecken Sie die besten technischen Lösunge...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.