Autorennennung und KI: Verbessert Autorschaft die Zitierhäufigkeit?

Entdecken Sie, wie Autorennennungen die Zitierungen durch KI beeinflussen. Erfahren Sie, warum namentliche Autorschaft 1,9-mal mehr Zitierungen von ChatGPT und ...

Erfahren Sie, wie proprietäre Umfragedaten und originale Statistiken zu Zitationsmagneten für LLMs werden. Entdecken Sie Strategien zur Verbesserung der KI-Sichtbarkeit und erhalten Sie mehr Zitate von ChatGPT, Perplexity und Google AI Overviews.

Große Sprachmodelle erfinden keine Daten – sie beziehen sie aus verifizierbaren Quellen. Wenn Ihr Team einzigartige Statistiken oder originelle Methoden veröffentlicht, besitzen Sie dieses Wissen temporär und geben LLMs einen Grund, Sie zur Validierung ihrer Antworten zu zitieren. Das ist die Grundlage dessen, was IDX das “Authority Flywheel” nennt – ein System, in dem proprietäre Forschung Ihr stärkster Zitationsmagnet wird.

Die Mechanik ist einfach: KI-Modelle bewerten Quellen danach, ob sie Behauptungen über mehrere Kanäle hinweg verifizieren können. Wenn Sie originelle Forschung veröffentlichen, erschaffen Sie ein Wissensgut, das sonst nirgendwo im Web existiert. Diese Einzigartigkeit zwingt LLMs dazu, Ihre Quelle zu zitieren, wenn sie diese Daten in Antworten aufnehmen wollen. Eine Kampagne für The Zebra, eine Versicherungsplattform, zeigt dieses Prinzip perfekt: Die Kombination aus proprietärer Forschung und Digital-PR brachte mehr als 1.580 hochwertige Medienlinks und führte zu einem organischen Traffic-Anstieg von 354 %.

Laut aktueller Studien sehen 48,6 % der SEO-Expert:innen Digital-PR als effektivste Linkbuilding-Taktik für 2025. Die eigentliche Stärke zeigt sich jedoch danach: Wenn Ihre proprietären Daten über verschiedene, hochwertige Domains via Digital-PR verbreitet werden, bestätigen sie Ihre Autorität gleichzeitig in mehreren Wissensnetzwerken. Diese Multi-Channel-Validierung ist genau das, wonach LLMs suchen, wenn sie entscheiden, ob sie Ihre Marke zitieren.

Der zentrale Punkt: Proprietäre Daten schaffen das, was Forscher “temporären Wissensbesitz” nennen. Im Gegensatz zu generischen Inhalten, die mit Tausenden ähnlichen Artikeln konkurrieren, ist Ihre Originalforschung die einzige Quelle für diese spezifischen Daten. Dieses Knappheitsprinzip erhöht die Wahrscheinlichkeit einer LLM-Zitation, denn Sie zu zitieren ist der einzige Weg, diese Information zu integrieren.

Zu verstehen, wie LLMs tatsächlich Quellen abrufen und auswählen, ist entscheidend für die Optimierung auf Zitate. Diese Systeme funktionieren nicht wie klassische Suchmaschinen. Stattdessen operieren sie über zwei getrennte Wissenspfade: parametrisches Gedächtnis (Wissen aus dem Training) und abgerufene Informationen (Realtime-Informationen via Retrieval-Augmented Generation, kurz RAG).

Parametrisches Wissen umfasst alles, was ein LLM aus dem Pre-Training „weiß“. Dieses Wissen ist statisch und am Trainingszeitpunkt eingefroren. Etwa 60 % der ChatGPT-Anfragen werden ausschließlich aus parametrischem Wissen beantwortet, ohne Websuche. Entitäten, die während des Trainings häufig in autoritativen Quellen genannt werden, erhalten stärkere neuronale Repräsentationen und werden eher abgerufen. Wikipedia-Inhalte machen etwa 22 % der Trainingsdaten großer LLMs aus – daher erscheinen Wikipedia-Zitate so oft in KI-Antworten.

Abgerufenes Wissen funktioniert anders. Wenn ein LLM aktuelle Informationen benötigt, nutzt es RAG-Systeme, die semantische Suche (dichte Vektoren) mit Keyword-Matching (BM25) via Reciprocal Rank Fusion kombinieren. Untersuchungen zeigen, dass hybrides Retrieval eine 48%ige Verbesserung gegenüber Einzelmethoden bringt. Anschließend werden die Ergebnisse mit Cross-Encoder-Modellen neu bewertet, bevor die Top 5-10 Chunks als Kontext in den LLM-Prompt eingefügt werden.

| Signal | Traditionelle SEO-Priorität | LLM-Zitationspriorität | Warum es wichtig ist |

|---|---|---|---|

| Domain Authority | Hoch (Kernfaktor) | Schwach/Neutral | LLMs priorisieren Inhaltsstruktur vor Domain-Power |

| Backlink-Anzahl | Hoch (Hauptsignal) | Schwach/Neutral | LLMs bewerten Quellglaubwürdigkeit anders |

| Inhaltsstruktur | Mittel | Kritisch | Klare Überschriften & Antwortblöcke sind für die Extraktion essenziell |

| Proprietäre Daten | Niedrig | Sehr hoch | Einzigartige Information erzwingt Zitation |

| Marken-Suchvolumen | Niedrig | Höchste (0,334 Korrelation) | Zeigt reale Autorität und Nachfrage |

| Aktualität | Mittel | Hoch | LLMs bevorzugen aktuelle Inhalte |

| E-E-A-T-Signale | Mittel | Hoch | Autorenangaben und Transparenz zählen |

Der entscheidende Unterschied: LLMs ranken keine Seiten – sie extrahieren semantische Chunks. Eine Seite mit schlechten SEO-Metriken, aber kristallklarer Struktur und proprietären Daten, kann eine hochautoritäre Seite mit vager Positionierung übertreffen. Diese Verschiebung bedeutet: Ihre Zitationsstrategie muss auf Maschinenlesbarkeit und Inhaltsklarheit statt klassische Linkbuilding-Metriken setzen.

Die relevanten Metriken für KI-Sichtbarkeit haben sich grundlegend von klassischen SEO-Signalen entfernt. Zwei Jahrzehnte lang definierten Domain Authority, Backlinks und Keyword-Rankings den Erfolg. 2025 sind diese Metriken für LLM-Zitate fast irrelevant. Stattdessen dominiert eine neue Hierarchie, basierend darauf, wie KI-Systeme tatsächlich Quellen bewerten und auswählen.

Marken-Suchvolumen ist heute der stärkste Prädiktor für LLM-Zitate, mit einem Korrelationskoeffizienten von 0,334 – deutlich höher als jeder klassische SEO-Wert. Das ist logisch: Wenn Millionen Menschen nach Ihrem Markennamen suchen, signalisiert das reale Autorität und Nachfrage. LLMs erkennen dieses Signal und gewichten es stark bei der Zitationsentscheidung. Backlinks hingegen zeigen nur schwache oder neutrale Korrelation – entgegen jahrzehntelanger SEO-Weisheiten.

Auch die Inhaltsevaluation hat sich verschoben. Statistiken im Inhalt erhöhen die KI-Sichtbarkeit um 22 %. Zitate bringen ein Plus von 37 %. Originalforschung wird dreimal so oft zitiert wie generische Inhalte. Das sind keine Randverbesserungen – sondern fundamentale Änderungen in der Qualitätsbewertung durch LLMs.

| Metrik | Fokus früher (vor 2024) | Neuer Fokus (2025+) | Auswirkung auf LLM-Zitate |

|---|---|---|---|

| Linkqualität | Domain-Authority-Score (DA/DR) | Themenrelevanz & Redaktioneller Kontext | Verankerung und Quellvielfalt |

| Ankertext-Strategie | Exakte Keywords | Marken-/Entitätsnennung | Entitätserkennung und Konsistenz |

| Inhaltstyp | Gastbeiträge (Menge) | Originalforschung/Datenjournalismus | 3x höhere Zitationswahrscheinlichkeit |

| Zielmessung | Ranking-Position | Zitationsrate in AI Overviews | Vertrauens- und Autoritätsvalidierung |

| Outreach-Ansatz | Link-Akquise | Beziehungen/Wert schaffen | Höhere redaktionelle Qualität |

Die Matrix zeigt: Die Gewinner bei KI-Sichtbarkeit sind nicht unbedingt die mit den meisten Backlinks oder der höchsten Domain Authority. Es sind die Marken, die original forschen, konsistente Markensignale senden und Inhalte maschinenoptimiert strukturieren. Der Wettbewerbsvorteil verlagert sich von Linkmenge zu Qualität und Einzigartigkeit der Inhalte.

Proprietäre Umfragedaten spielen eine besondere Rolle in der KI-Sichtbarkeitsstrategie. Im Unterschied zu generischen Branchenberichten, die LLMs aus vielen Quellen abrufen können, sind Ihre originalen Umfragedaten nur über Ihre Website zitierbar. Das verschafft Ihnen einen Zitationsvorteil, den Wettbewerber nicht kopieren können – egal wie stark deren Backlink-Profil ist.

Umfragedaten wirken, weil sie das bieten, was LLMs „Grounding“ nennen – prüfbare Evidenz, die Behauptungen stützt. Wenn Sie sagen „78 % der Marketing-Leiter priorisieren KI-Sichtbarkeit“, können LLMs Ihre Umfrage als Nachweis zitieren. Ohne proprietäre Daten wäre diese Aussage spekulativ – LLMs würden die Aussage überspringen oder auf die Forschung eines Mitbewerbers verweisen.

Die effektivsten Umfragedaten beantworten gezielte Fragen Ihrer Zielgruppe:

Die Auswirkungen sind messbar. Studien zeigen: Statistiken erhöhen KI-Sichtbarkeit um 22 %, Zitate um 37 %. Originalforschung wird dreimal so häufig zitiert wie generische Inhalte. Diese Multiplikatoren verstärken sich, wenn Sie mehrere proprietäre Datentypen in einem Content-Asset kombinieren.

Entscheidend ist Transparenz. LLMs bewerten die Methodik ebenso sorgfältig wie die Ergebnisse. Wenn Ihre Umfragemethodik solide, die Stichprobengröße ausreichend und die Ergebnisse ehrlich präsentiert sind (inklusive Limitationen), werden Sie zuverlässig zitiert. Vage Methoden oder selektive Darstellung führen dazu, dass LLMs transparentere Wettbewerber bevorzugen.

Proprietäre Daten zu veröffentlichen ist nur die halbe Miete. Die andere Hälfte ist, die Daten so zu strukturieren, dass LLMs sie leicht extrahieren und zitieren können. Die Content-Architektur ist dabei ebenso wichtig wie die Daten selbst.

Starten Sie mit direkten Antworten. LLMs bevorzugen Inhalte, die mit der Antwort beginnen – nicht mit dem Weg dorthin. Statt „Wir haben eine Umfrage durchgeführt, um Marketing-Prioritäten zu verstehen, und das haben wir herausgefunden“, schreiben Sie: „78 % der Marketing-Leiter priorisieren 2025 KI-Sichtbarkeit.“ Diese direkte Struktur erleichtert die Extraktion und erhöht die Zitationswahrscheinlichkeit.

Die optimale Absatzlänge für LLM-Extraktion liegt bei 40-60 Wörtern. Bei dieser Länge können LLMs einen vollständigen Gedanken erfassen. Längere Absätze werden gechunkt und verlieren Kontext, zu kurze Absätze enthalten womöglich zu wenig Information.

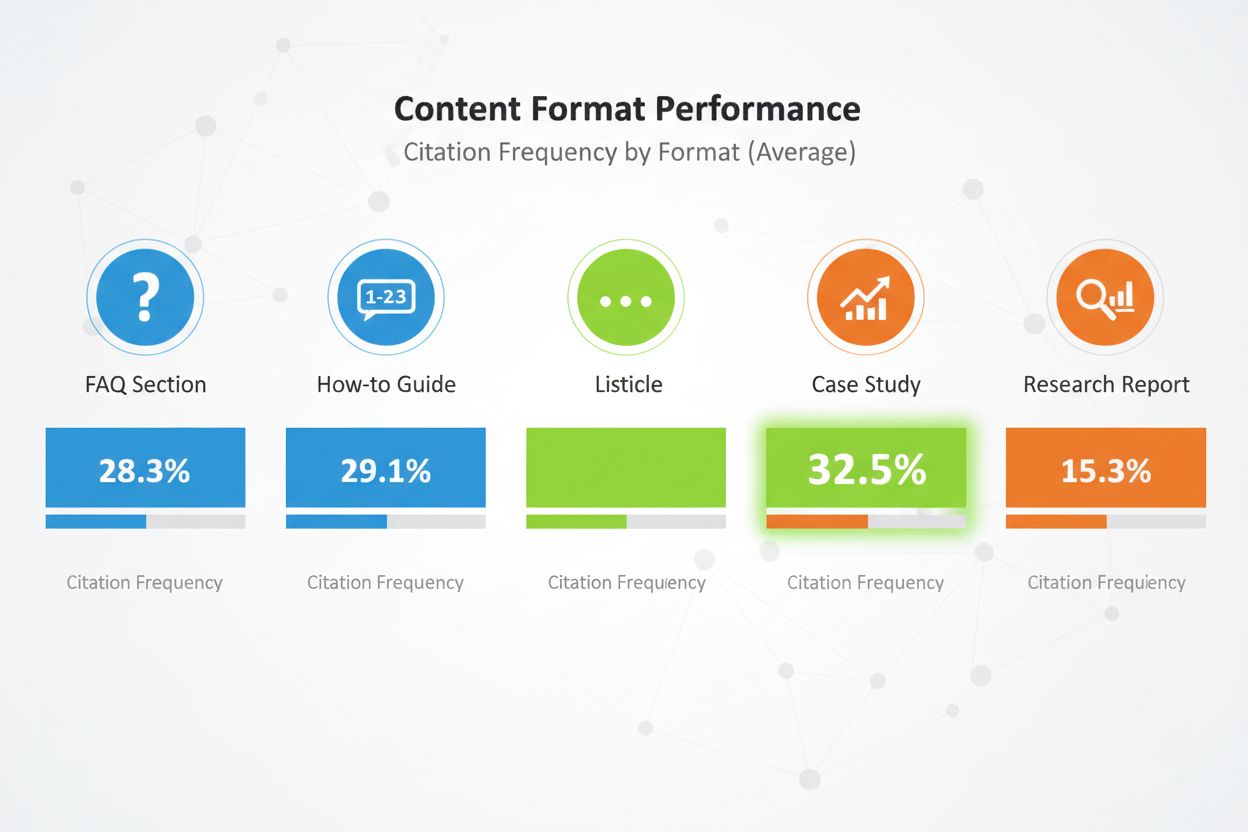

Content-Formate sind entscheidend. Vergleichs-Listicles erhalten 32,5 % aller KI-Zitate – der höchste Wert für jedes Format. FAQ-Sektionen performen besonders gut, weil sie dem Frage-Antwort-Muster von KI-Anfragen entsprechen. How-to-Guides, Fallstudien und Forschungsberichte funktionieren ebenfalls, aber Listicles schneiden konstant am besten ab.

Strukturieren Sie den Content mit klarer Überschriftenhierarchie. Verwenden Sie H2-Überschriften, die häufige Suchanfragen abbilden. Unter jedem H2 ordnen Sie H3 für Unterthemen an. Diese Hierarchie hilft LLMs, die Struktur zu erkennen und relevante Bereiche zu extrahieren.

Implementieren Sie E-E-A-T-Signale überall. Fügen Sie Autoren-Bios mit Qualifikationen und Praxiserfahrung ein. Verlinken Sie auf Drittvalidierungen. Erläutern Sie die Methodik transparent. Zitieren Sie Ihre Quellen. Diese Signale zeigen LLMs, dass Ihr Content vertrauenswürdig und zitierwürdig ist.

Nutzen Sie semantisches HTML. Strukturieren Sie Daten mit echten <table>, <ul>, und <ol>-Tags statt CSS-divs. So lassen sich Inhalte leichter von KI parsen und zusammenfassen. Fügen Sie Schema-Markup (Article, FAQPage, HowTo) hinzu, um den Inhaltstyp weiter zu präzisieren.

Aktualisieren Sie Ihre Inhalte regelmäßig. LLMs bevorzugen besonders aktuelle Inhalte, vor allem bei zeitkritischen Daten. Ist Ihre Umfrage von 2024, aktualisieren Sie sie 2025. Fügen Sie „Zuletzt aktualisiert“-Zeitstempel hinzu, um Pflegebereitschaft zu signalisieren. Das zeigt LLMs die Aktualität und Zuverlässigkeit Ihrer Daten.

Proprietäre Daten nur auf Ihrer Website zu veröffentlichen reicht nicht. LLMs entdecken Inhalte über viele Kanäle – Ihre Distributionsstrategie entscheidet, wie viele davon Ihre Daten aufgreifen.

Digital-PR ist der effektivste Distributionskanal für proprietäre Daten. Wenn Ihre Forschung in Branchenmedien, Nachrichten und Autoritätsblogs erscheint, entstehen zahlreiche Zitationsmöglichkeiten. LLMs indexieren diese Drittquellen und nutzen sie zur Validierung Ihres Originals. Marken, die auf 4+ Plattformen erscheinen, werden 2,8-mal häufiger in ChatGPT zitiert als Marken mit begrenzter Präsenz.

Effektive Kanäle sind:

Jeder Kanal hat einen Zweck: Pressemitteilungen schaffen Aufmerksamkeit, Fachmedien Reichweite und Glaubwürdigkeit, LinkedIn skaliert den Zugang zu Professionals, Reddit demonstriert Community-Vertrauen, Bewertungsplattformen liefern strukturierte, leicht auslesbare Daten.

Der Multiplikatoreffekt ist enorm. Erscheinen Ihre proprietären Daten in mehreren Autoritätsquellen, erkennen LLMs ein konsistentes Signal im Web. Diese Konsistenz erhöht das Vertrauen und die Zitationswahrscheinlichkeit. Ein einzelner Website-Hinweis kann übersehen werden. Dieselben Daten auf Ihrer Website, einer Pressemitteilung, einer Branchenpublikation und einer Bewertungsplattform sind nicht mehr zu ignorieren.

Das Timing zählt ebenfalls. Verteilen Sie Ihre Daten strategisch: Zuerst Veröffentlichung auf der eigenen Website mit Pressemitteilung, dann Platzierung in Fachmedien, dann Social- und Community-Verstärkung. So entsteht eine Sichtbarkeitswelle statt eines kurzen Peaks.

Proprietäre Daten ohne Impact-Messung zu veröffentlichen ist wie Werbung zu schalten ohne Conversion-Tracking. Sie brauchen Einsicht, ob Ihre Daten wirklich Zitate generieren und die KI-Sichtbarkeit verbessern.

Starten Sie mit Zitationshäufigkeitstracking. Identifizieren Sie 20-50 relevante Buyer-Fragen, die Ihre Daten beantworten. Stellen Sie diese monatlich an große KI-Plattformen (ChatGPT, Perplexity, Claude, Google AI Overviews). Dokumentieren Sie, ob Ihre Marke erscheint, an welcher Stelle und ob ein Link zu Ihrer Website enthalten ist.

Berechnen Sie die Zitationsfrequenz als Prozentsatz: (Prompts mit Erwähnung) / (Gesamtanzahl Prompts) × 100. Ziel sind 30 % + Zitationsfrequenz für Ihre Kernfragen. Top-Marken in Wettbewerbsbranchen erreichen 50 % +.

Tracken Sie den AI Share of Voice (AI SOV), indem Sie identische Prompts stellen und Ihren Anteil an allen Marken-Erwähnungen berechnen. Taucht Ihre Marke in 3 von 10 AI-Antworten auf, Mitbewerber je 2-mal, liegt Ihr AI SOV bei 30 %. Im Wettbewerb sollten Sie einen AI SOV anstreben, der Ihren klassischen Marktanteil um 10-20 % übersteigt.

Überwachen Sie Sentiment-Analysen. Tracken Sie nicht nur Erwähnungen, sondern auch den Tonfall: positiv, neutral oder negativ. Nutzen Sie Tools wie Profound AI zur Halluzinationserkennung – also der Identifizierung falscher oder veralteter KI-Aussagen zu Ihrer Marke. Ziel: 70 % + positives Sentiment.

Richten Sie ein Knowledge-Based Indicator (KBI)-Dashboard ein für:

Aktualisieren Sie die Metriken monatlich. Achten Sie auf Trends, nicht Einzelwerte. Ein Monat mit wenig Zitaten kann Zufall sein. Drei Monate Rückgang erfordern Analyse und Reaktion.

Manuelles Tracking proprietärer Datenzitate ist zeitaufwendig und fehleranfällig. AmICited.com bietet die Infrastruktur, Ihre KI-Sichtbarkeit im großen Stil zu überwachen – speziell für Marken, die auf proprietäre Daten als Zitationsstrategie setzen.

Die Plattform überwacht, wie KI-Systeme Ihre Forschung in ChatGPT, Perplexity, Google AI Overviews, Claude, Gemini und neuen KI-Plattformen zitieren. Statt monatlich jede Plattform manuell abzufragen, automatisiert AmICited den Prozess, fährt Ihre Ziel-Prompts kontinuierlich und trackt Zitationsmuster in Echtzeit.

Zu den Kernfunktionen zählen:

Die Plattform integriert sich in Ihren bestehenden Analytics-Stack und liefert KI-Zitationsdaten direkt in Ihre Marketing-Dashboards – zusammen mit klassischen SEO-Metriken. So erhalten Sie einen vollständigen Überblick über den Einfluss Ihrer proprietären Datenstrategie auf Markenbekanntheit und Pipeline.

Für Marken, die KI-Sichtbarkeit ernst nehmen, liefert AmICited die Messinfrastruktur, die Optimierung erst möglich macht. Sie können nur verbessern, was Sie messen – klassische Analytics-Tools wurden nie für LLM-Zitate entwickelt. AmICited schließt diese Lücke und maximiert Ihren ROI auf proprietäre Dateninvestitionen.

Selbst gut gemeinte proprietäre Datenstrategien scheitern oft an vermeidbaren Fehlern. Wer sie kennt, kann sie vermeiden.

Der häufigste Fehler: Daten hinter „Kontakt Vertrieb“-Formularen verstecken. LLMs können auf geschützte Inhalte nicht zugreifen und greifen dann auf unvollständige oder spekulative Foreninhalte zurück. Sind Ihre Umfrageergebnisse verborgen, wird ein Reddit-Thread über Ihr Produkt zitiert – nicht Ihre offizielle Forschung. Veröffentlichen Sie zentrale Erkenntnisse und Methoden transparent. Ausführliche Berichte können Sie weiterhin schützen, aber Zusammenfassungen und Einblicke sollten öffentlich sein.

Inkonsistente Terminologie zwischen Plattformen sorgt für Verwirrung. Nennen Sie Ihr Produkt auf der Website „Marketing-Automation-Plattform“ und auf LinkedIn „CRM-Software“, können LLMs Ihr Geschäftsmodell schwer erfassen. Nutzen Sie überall dieselbe Kategorisierung. Legen Sie ein Terminologie-Glossar an und wenden Sie es auf Website, LinkedIn, Crunchbase & Co. konsequent an.

Fehlende Autorenangaben untergraben Vertrauen. LLMs prüfen E-E-A-T-Signale genau. Fehlen Autoren-Bios mit echten Qualifikationen, wird Ihre Umfrage abgewertet. Ergänzen Sie detaillierte Autorenprofile mit Erfahrung, Zertifikaten, Publikationen und Links zu LinkedIn & Co.

Veraltete Statistiken schaden der Glaubwürdigkeit. Ist Ihre Umfrage von 2023, Sie zitieren sie aber 2025, fällt das auf. Aktualisieren Sie Ihre Forschung regelmäßig, fügen Sie „Zuletzt aktualisiert“-Stempel hinzu, führen Sie jährlich neue Umfragen durch. LLMs bevorzugen aktuelle Daten.

Vage Methodik senkt die Zitationswahrscheinlichkeit. Ist Ihre Methodik nicht transparent, stellen LLMs die Ergebnisse infrage. Veröffentlichen Sie die Methodik offen: Stichprobengröße, Auswahlverfahren, Zeitraum, Limitationen. Transparenz schafft Vertrauen.

Keyword-Stuffing wirkt sich bei KI-Systemen schlechter aus als bei klassischen Suchmaschinen. LLMs erkennen und bestrafen gekünstelte Sprache. Schreiben Sie natürlich, klar und präzise statt auf Keyworddichte zu achten. Ihre proprietären Daten sollten wie echte Forschung, nicht wie Werbetexte klingen.

Dünne Inhalte rund um Ihre proprietären Daten werden aktiv abgestraft. Ein einzelner Absatz mit Umfrageergebnis reicht nicht. Erstellen Sie umfassende Inhalte zu jeder Studie – mit Kontext, Implikationen, Antworten auf Folgefragen. Ziel: 2.000+ substanzielle Wörter pro Daten-Asset.

Echte Beispiele belegen die Wirkung proprietärer Daten für KI-Sichtbarkeit. Diese Marken investierten in Originalforschung und erzielten messbare Resultate.

The Zebras Digital-PR-Erfolg: The Zebra, eine Versicherungsvergleichsplattform, kombinierte proprietäre Forschung mit Digital-PR und generierte über 1.580 hochwertige Medienlinks sowie einen 354%igen Anstieg beim organischen Traffic. Durch die Veröffentlichung eigener Versicherungsstudien und deren Distribution via Earned Media wurde The Zebra zur Referenzquelle für Branchendaten. LLMs zitieren The Zebras Forschung bei Fragen zu Versicherungstrends und -preisen.

Tallys Community-Engagement-Strategie: Tally, ein Online-Formular-Builder, verbesserte seine KI-Sichtbarkeit durch aktive Forenbeteiligung und das Teilen seiner Produkt-Roadmap. Statt nur Studien zu veröffentlichen, wurde Tally zur vertrauenswürdigen Stimme in den Communities seiner Nutzer. Dieses authentische Engagement machte ChatGPT zur Top-Traffic-Quelle und steigerte die Anmeldungen signifikant. Durch gezielte Kontext-Anreicherung stieg die Fakten-Genauigkeit bei GPT-4 von 56 % auf 89 %.

HubSpots kontinuierliches Forschungsprogramm: HubSpot publiziert regelmäßig Studien zu Marketingtrends, Vertriebserfolg und Kundenservice-Best-Practices. Diese Berichte sind Branchenstandards, die LLMs häufig zitieren. HubSpots Engagement für kontinuierliche Forschung macht die Marke zum Synonym für Marketingdaten. LLMs greifen bei Trendfragen regelmäßig auf HubSpot-Ergebnisse zurück.

Allen Fallstudien gemein: Originalforschung, transparente Methodik, konsistente Distribution und kontinuierliche Updates. Keine der Marken setzte auf ein einzelnes Projekt – alle bauten Programme, die laufend neue Daten liefern und so einen nachhaltigen Zitationsvorteil schaffen.

Das Fazit: Proprietäre Daten sind keine einmalige Taktik, sondern eine strategische Investition, um zur maßgeblichen Quelle der eigenen Branche zu werden. Wer auf regelmäßige Forschung, transparente Methodik und gezielte Distribution setzt, erhält dauerhafte LLM-Zitate und einen nachhaltigen Wettbewerbsvorteil bei der KI-Sichtbarkeit.

Sie brauchen keine riesigen Datensätze. Selbst eine gezielte Umfrage mit 100-500 Teilnehmern kann wertvolle proprietäre Einblicke liefern, die von LLMs zitiert werden. Entscheidend ist, dass die Daten originell, die Methodik transparent und die Ergebnisse umsetzbar sind. Qualität und Einzigartigkeit sind wichtiger als Quantität.

Kundenzufriedenheitsumfragen, Branchentrendforschung, Wettbewerbsanalysen, Nutzerverhaltensstudien und Marktforschungen zur Größenbestimmung funktionieren alle gut. Die besten Daten beantworten spezifische Fragen Ihrer Zielgruppe und liefern Erkenntnisse, die Wettbewerber nicht haben.

Echtzeit-Plattformen wie Perplexity können aktuelle Daten innerhalb von Wochen zitieren. ChatGPT und andere Modelle mit selteneren Updates benötigen möglicherweise 2-3 Monate. Konsistente, hochwertige proprietäre Daten zeigen in der Regel innerhalb von 3-6 Monaten messbare Zitationssteigerungen.

Nein. LLMs können auf geschützte Inhalte nicht zugreifen und verlassen sich stattdessen auf unvollständige oder spekulative Informationen aus Foren. Veröffentlichen Sie die wichtigsten Erkenntnisse öffentlich mit transparenter Methodik. Detaillierte Berichte können Sie nur zugänglich machen, während Zusammenfassungen und Einblicke öffentlich bleiben.

Verwenden Sie klare, konsistente Terminologie auf allen Plattformen. Fügen Sie Ihrer Forschung eine transparente Methodik hinzu. Ergänzen Sie Autorenangaben und Zertifizierungen. Verlinken Sie auf Drittanbieter-Bestätigungen. Nutzen Sie Schema-Markup, um Ihre Daten zu strukturieren. Überwachen Sie Zitate monatlich und korrigieren Sie Ungenauigkeiten schnell.

Ja. Originalforschung erhält typischerweise Backlinks und Medienberichterstattung, was das traditionelle Ranking verbessert. Außerdem schafft proprietäre Forschung Inhalte, die umfassender und autoritativer sind, was sowohl dem traditionellen SEO als auch der KI-Sichtbarkeit zugutekommt.

Proprietäre Daten sind eigene, von Ihnen durchgeführte Studien. Generische Berichte sind weit verbreitet. LLMs bevorzugen proprietäre Daten, weil sie einzigartig sind und nur aus Ihrer Quelle zitiert werden können. Das schafft einen Zitationsvorteil, den Wettbewerber nicht einfach nachbilden können.

Verfolgen Sie Zitationshäufigkeit, KI-Share of Voice, Marken-Suchvolumen und Traffic von KI-Plattformen. Vergleichen Sie diese Metriken vor und nach der Veröffentlichung proprietärer Daten. Berechnen Sie den Wert des von KI zugeführten Traffics (typischerweise 4,4x höhere Conversion-Rate als traditionell organisch), um den ROI zu bestimmen.

Überwachen Sie, wie KI-Systeme Ihre proprietären Daten in ChatGPT, Perplexity, Google AI Overviews und mehr zitieren. Erhalten Sie Echtzeit-Einblicke in Ihre KI-Sichtbarkeit und Ihre Wettbewerbspositionierung.

Entdecken Sie, wie Autorennennungen die Zitierungen durch KI beeinflussen. Erfahren Sie, warum namentliche Autorschaft 1,9-mal mehr Zitierungen von ChatGPT und ...

Erfahren Sie, wie Sie Originalforschung und datengetriebene PR-Inhalte erstellen, die von KI-Systemen aktiv zitiert werden. Entdecken Sie die 5 Merkmale zitierw...

Erfahren Sie, wie Expertenzitate die Sichtbarkeit Ihrer Marke in KI-Suchmaschinen wie ChatGPT und Perplexity steigern. Entdecken Sie Strategien, um Zitate zu er...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.