Suchintention

Suchintention ist der Zweck hinter einer Suchanfrage eines Nutzers. Erfahren Sie die vier Typen der Suchintention, wie Sie diese identifizieren und Inhalte für ...

Erfahren Sie, wie große Sprachmodelle die Nutzerintention über Schlüsselwörter hinaus interpretieren. Entdecken Sie Query Expansion, semantisches Verständnis und wie KI-Systeme entscheiden, welche Inhalte in Antworten zitiert werden.

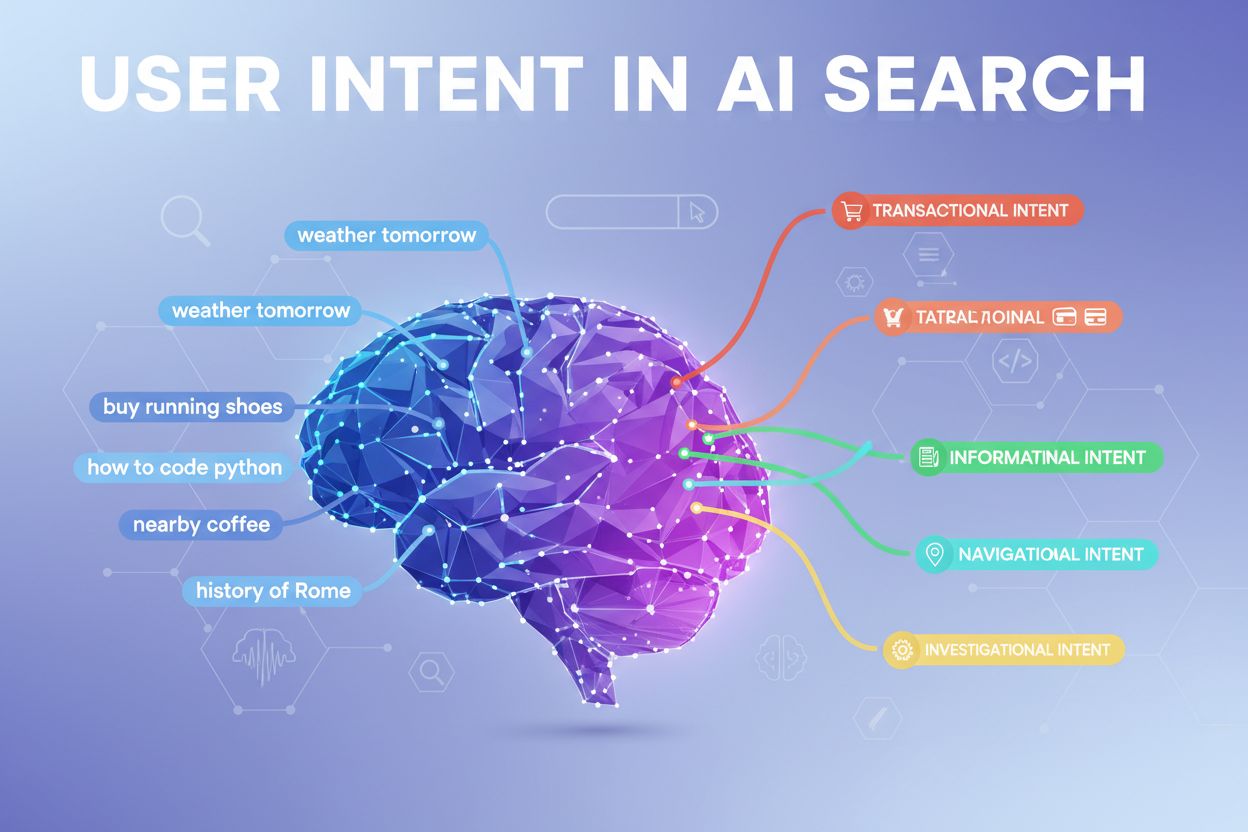

Nutzerintention in der KI-Suche bezeichnet das zugrunde liegende Ziel oder den Zweck hinter einer Anfrage – nicht bloß die eingegebenen Schlüsselwörter. Wenn Sie nach „beste Projektmanagement-Tools“ suchen, könnten Sie einen schnellen Vergleich, Preisinformationen oder Integrationsmöglichkeiten meinen – und große Sprachmodelle (LLMs) wie ChatGPT, Perplexity und Googles Gemini versuchen zu erkennen, welches Ziel Sie tatsächlich verfolgen. Im Gegensatz zu klassischen Suchmaschinen, die Schlüsselwörter mit Seiten abgleichen, interpretieren LLMs die semantische Bedeutung Ihrer Anfrage, indem sie Kontext, Formulierung und verwandte Signale analysieren, um vorherzusagen, was Sie wirklich erreichen möchten. Dieser Wandel vom Keyword-Matching hin zum Verständnis der Intention ist grundlegend für die Funktionsweise moderner KI-Suchsysteme – und bestimmt direkt, welche Quellen in KI-generierten Antworten zitiert werden. Das Verständnis der Nutzerintention ist entscheidend für Marken, die in KI-Suchergebnissen sichtbar sein wollen, da Tools wie AmICited heute überwachen, wie KI-Systeme Ihre Inhalte anhand der Intention referenzieren.

Wenn Sie eine einzige Anfrage in ein KI-Suchsystem eingeben, passiert im Hintergrund etwas Bemerkenswertes: Das Modell beantwortet Ihre Frage nicht einfach direkt. Stattdessen erweitert es Ihre Anfrage um Dutzende verwandte Mikrofragen – ein Prozess, den Forscher als „Query Fan-out“ bezeichnen. Eine einfache Suche wie „Notion vs Trello“ kann Unteranfragen wie „Welches ist besser für die Teamzusammenarbeit?“, „Wie unterscheiden sich die Preise?“, „Welches integriert sich besser mit Slack?“ und „Was ist für Einsteiger einfacher?“ auslösen. Diese Erweiterung ermöglicht es LLMs, verschiedene Aspekte Ihrer Intention zu erkunden und umfassendere Informationen zu sammeln, bevor eine Antwort generiert wird. Das System bewertet dann Abschnitte aus verschiedenen Quellen auf sehr granularer Ebene, anstatt ganze Seiten zu ranken – ein einzelner Absatz aus Ihren Inhalten kann ausgewählt werden, während der Rest ignoriert wird. Diese Passage-Ebene-Analyse macht Klarheit und Präzision in jedem Abschnitt wichtiger denn je – eine gut strukturierte Antwort auf eine spezifische Unterintention kann der Grund sein, warum Ihre Inhalte in einer KI-generierten Antwort erscheinen.

| Ursprüngliche Anfrage | Unterintention 1 | Unterintention 2 | Unterintention 3 | Unterintention 4 |

|---|---|---|---|---|

| “Beste Projektmanagement-Tools” | “Welches eignet sich am besten für Remote-Teams?” | “Wie ist die Preisgestaltung?” | “Welche Lösung integriert sich mit Slack?” | “Was ist am einfachsten für Einsteiger?” |

| “Wie kann ich die Produktivität steigern” | “Welche Tools helfen beim Zeitmanagement?” | “Was sind bewährte Produktivitätsmethoden?” | “Wie lassen sich Ablenkungen reduzieren?” | “Welche Gewohnheiten fördern Fokus?” |

| “KI-Suchmaschinen erklärt” | “Wie unterscheiden sie sich von Google?” | “Welche KI-Suche ist am genauesten?” | “Wie gehen sie mit Datenschutz um?” | “Wie sieht die Zukunft der KI-Suche aus?” |

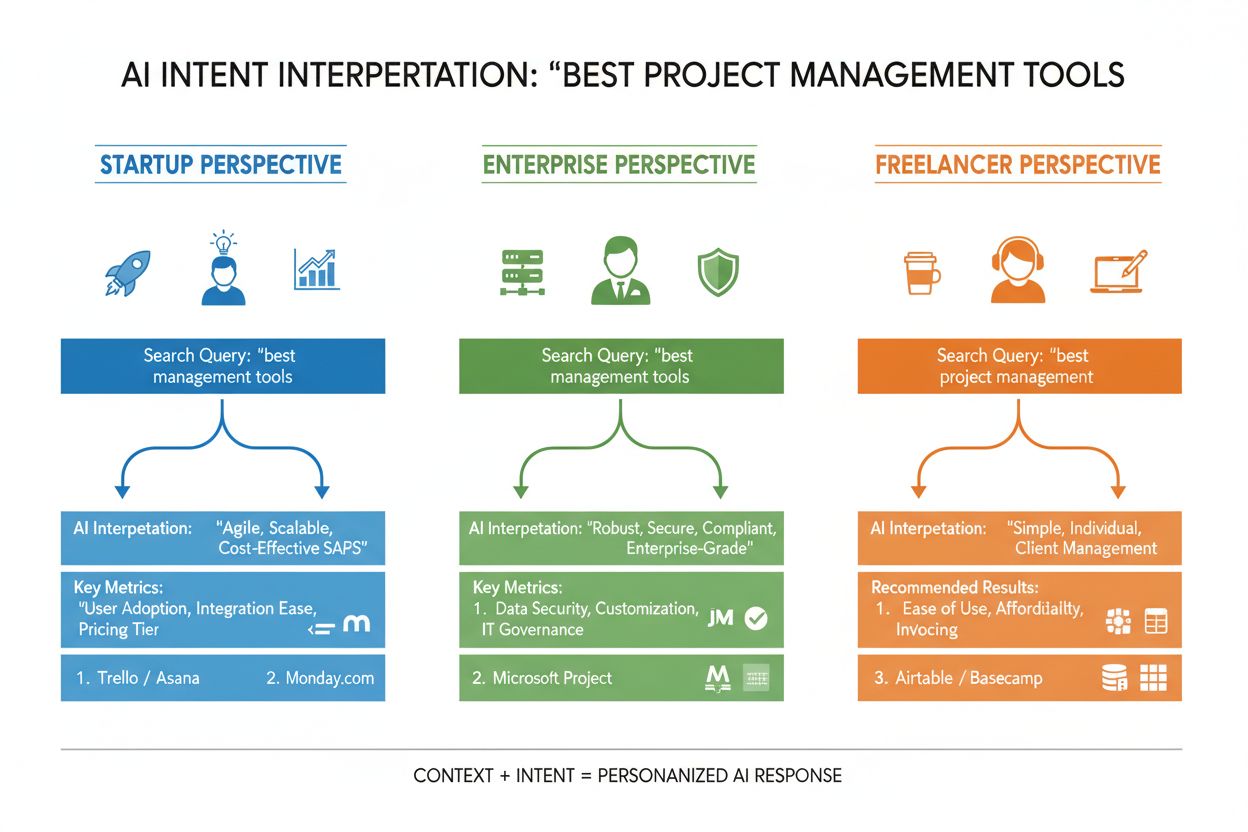

LLMs bewerten Ihre Anfrage nicht isoliert – sie erstellen, was Forscher als „User Embedding“ bezeichnen: ein vektor-basiertes Profil, das Ihre sich entwickelnde Intention anhand von Suchverlauf, Standort, Gerätetyp, Tageszeit und sogar vorherigen Unterhaltungen abbildet. Dieses kontextuelle Verständnis ermöglicht eine drastische Personalisierung der Ergebnisse: Zwei Nutzer, die nach „beste CRM-Tools“ suchen, könnten völlig unterschiedliche Empfehlungen erhalten, wenn einer Gründer eines Startups ist und der andere ein Enterprise-Manager. Echtzeit-Neu-Rankings verfeinern die Ergebnisse zusätzlich basierend auf Ihrem Interaktionsverhalten – wenn Sie auf bestimmte Resultate klicken, bestimmte Abschnitte lesen oder Folgefragen stellen, passt das System sein Verständnis Ihrer Intention an und aktualisiert künftige Empfehlungen entsprechend. Diese Feedback-Schleife bedeutet, dass KI-Systeme fortlaufend lernen, was Nutzer tatsächlich wollen – nicht bloß, was sie ursprünglich getippt haben. Für Content-Ersteller und Marketer unterstreicht dies die Bedeutung von Inhalten, die Intentionen in verschiedenen Nutzerkontexten und Entscheidungsphasen erfüllen.

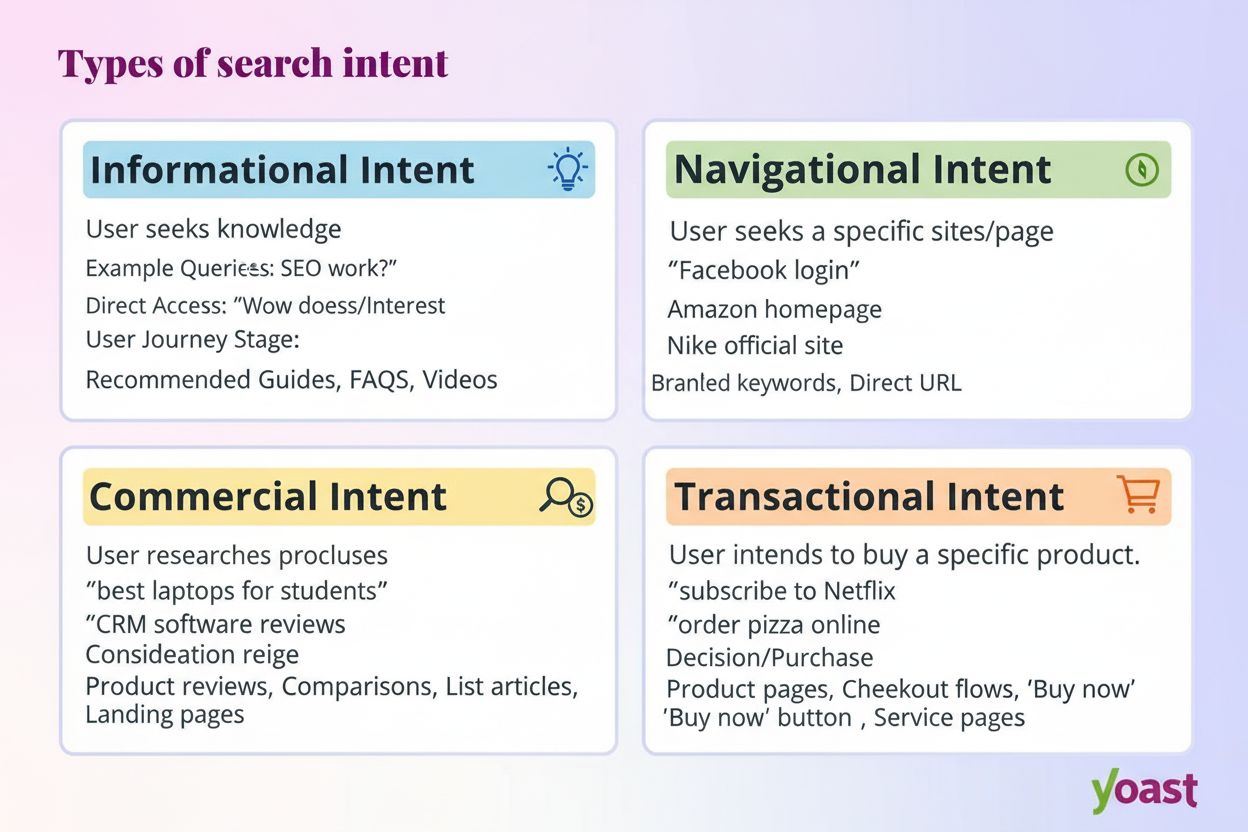

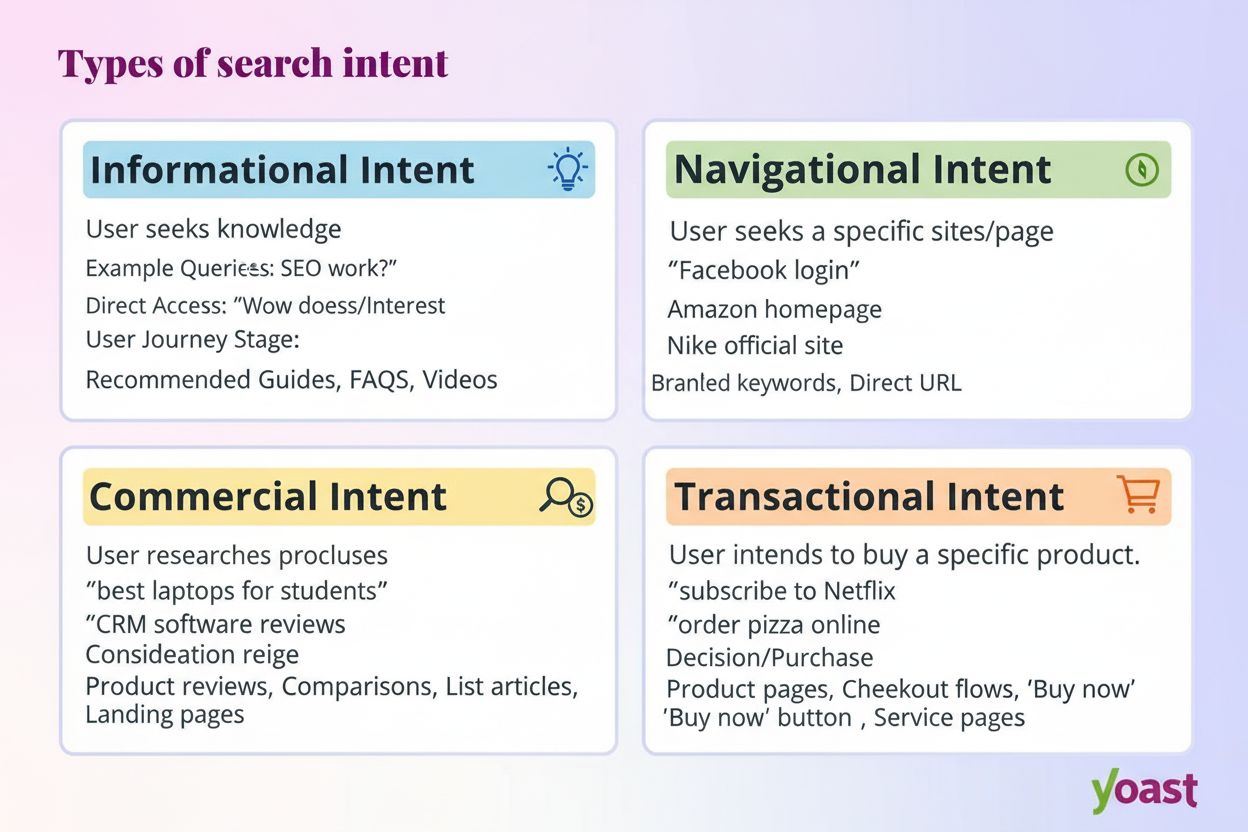

Moderne KI-Systeme klassifizieren Nutzerintentionen in mehrere unterschiedliche Kategorien, die jeweils verschiedene Inhalte und Antwortarten erfordern:

LLMs klassifizieren diese Intentionen automatisch, indem sie Anfrage-Struktur, Schlüsselwörter und kontextuelle Signale analysieren und dann Inhalte auswählen, die am besten zur erkannten Intention passen. Das Verständnis dieser Kategorien hilft Content-Erstellern, ihre Seiten so zu strukturieren, dass sie die spezifische Intention der Nutzer in der Suche bedienen.

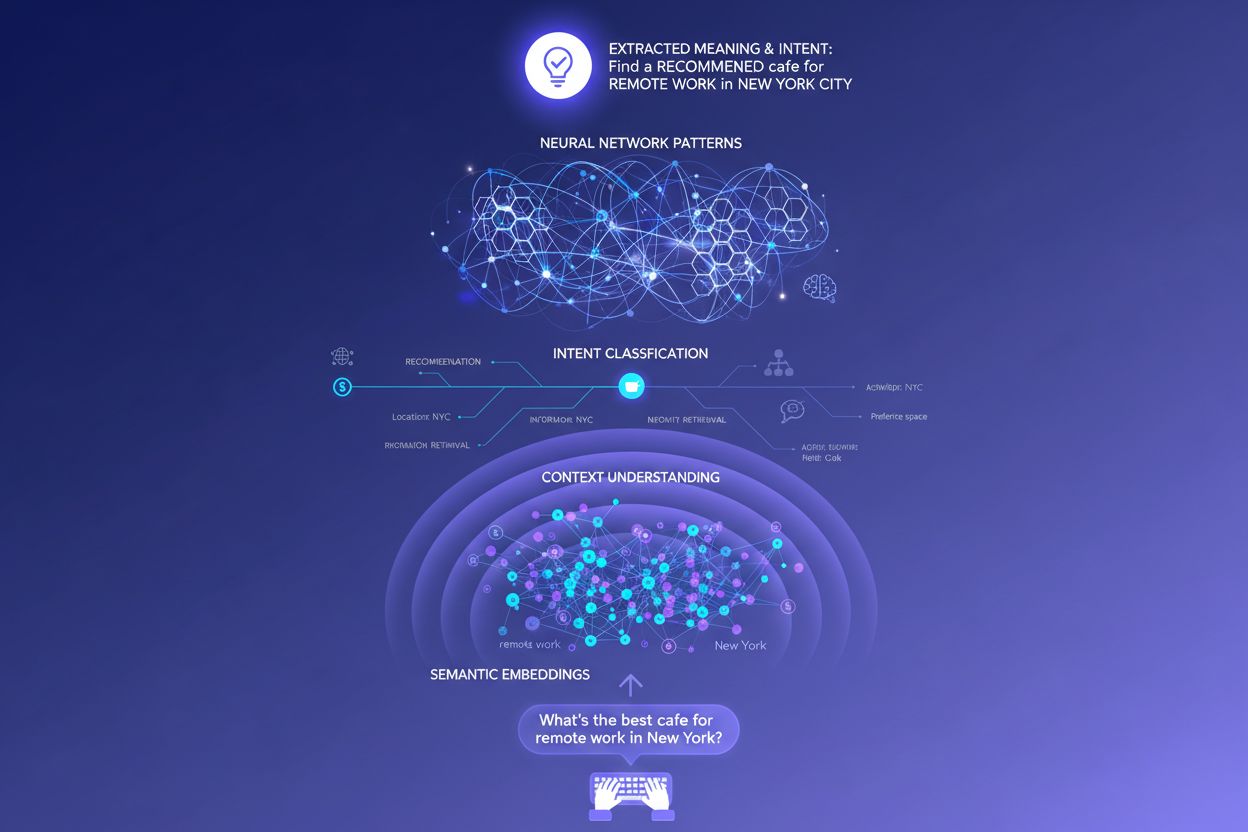

Traditionelle, keyword-basierte Suchmaschinen arbeiten mit einfachem Zeichenfolgen-Abgleich – enthält Ihre Seite genau die Wörter, die jemand sucht, kann sie ranken. Dieses Verfahren versagt bei Synonymen, Paraphrasen und Kontext jedoch völlig. Sucht jemand nach „preiswerte Projektmanagement-Software“ und Ihre Seite spricht von einer „budgetfreundlichen Aufgabenkoordination“, erkennt die klassische Suche die Verbindung oft gar nicht. Semantische Einbettungen lösen dieses Problem, indem sie Wörter und Phrasen in mathematische Vektoren umwandeln, die Bedeutung statt nur Text abbilden. Diese Vektoren existieren in einem hochdimensionalen Raum, in dem semantisch ähnliche Konzepte zusammenliegen – so erkennen LLMs, dass „preiswert“, „budgetfreundlich“, „günstig“ und „kostengünstig“ dieselbe Intention ausdrücken. Dieser Ansatz bewältigt auch lange und konversationelle Anfragen weit besser als Keyword-Matching – eine Anfrage wie „Ich bin Freelancer und brauche etwas Einfaches, aber Leistungsstarkes“ kann relevanten Inhalten zugeordnet werden, obwohl klassische Schlüsselwörter fehlen. Der praktische Effekt: KI-Systeme liefern relevante Antworten selbst auf vage, komplexe oder unkonventionelle Anfragen und sind damit klassischen Verfahren weit überlegen.

Im technischen Kern der Intentionsinterpretation steht die Transformer-Architektur – ein neuronales Netz, das Sprache analysiert, indem es die Beziehungen zwischen Wörtern mit Hilfe eines Mechanismus namens „Attention“ bewertet. Anstatt Text wie ein Mensch sequentiell zu lesen, prüfen Transformer, wie jedes Wort zu jedem anderen in der Anfrage steht, und erfassen so feine Bedeutungen und Kontexte. Semantische Einbettungen sind die Zahlenvektoren, die aus diesem Prozess entstehen – jedes Wort, jede Phrase, jedes Konzept wird zu einem Zahlenvektor, der Bedeutung kodiert. Modelle wie BERT (Bidirectional Encoder Representations from Transformers) und RankBrain nutzen diese Einbettungen, um zu verstehen, dass „bestes CRM für Startups“ und „Top-Kundenmanagement-Plattform für neue Unternehmen“ dieselbe Intention ausdrücken, auch wenn völlig andere Wörter verwendet werden. Der Attention-Mechanismus ist besonders mächtig, weil das Modell damit die relevantesten Teile einer Anfrage fokussieren kann – bei „beste Projektmanagement-Tools für Remote-Teams mit begrenztem Budget“ gewichtet das System „Remote-Teams“ und „begrenztes Budget“ als entscheidende Signale. Diese technische Raffinesse erklärt, warum moderne KI-Suche so viel intelligenter wirkt als klassische Keyword-basierte Systeme.

Das Verständnis, wie LLMs Intention interpretieren, verändert die Content-Strategie grundlegend. Statt einen umfassenden Leitfaden zu schreiben, der für ein einziges Schlüsselwort ranken soll, sind erfolgreiche Inhalte heute so aufgebaut, dass sie mehrere Unterintentionen in modularen, eigenständigen Abschnitten adressieren. Schreiben Sie beispielsweise über Projektmanagement-Tools, so erstellen Sie besser einzelne Abschnitte zu „Welches ist am besten für Remote-Teams?“, „Was ist die günstigste Option?“ und „Welche Lösung integriert sich mit Slack?“ – jeder Abschnitt wird so zu einer potenziellen Antwortkarte, die LLMs extrahieren und zitieren können. Zitierfähiges Format ist entscheidend: Verwenden Sie Fakten statt vager Aussagen, nennen Sie konkrete Zahlen und Daten und strukturieren Sie Informationen so, dass KI-Systeme sie leicht zitieren oder zusammenfassen können. Aufzählungen, klare Überschriften und kurze Absätze helfen LLMs, Inhalte besser zu erkennen als dichter Fließtext. Tools wie AmICited ermöglichen es Marketern inzwischen, nachzuverfolgen, wie ihre Inhalte in ChatGPT, Perplexity und Google AI referenziert werden – und so zu erkennen, welche Intentionen funktionieren und wo Lücken bestehen. Dieser datengetriebene Ansatz – optimiert auf die tatsächliche Interpretation und Zitation durch KI-Systeme – bedeutet einen grundlegenden Wandel gegenüber klassischem SEO.

Ein E-Commerce-Beispiel: Sucht jemand nach „wasserdichte Jacke unter 200 €“, äußert er mehrere Intentionen zugleich – es geht um Haltbarkeit, Preisinformation und Produktempfehlungen. Ein KI-System könnte dies zu Unteranfragen zu Wasserdichtigkeit, Preisvergleichen, Markenbewertungen und Garantieinformationen erweitern. Eine Marke, die all diese Aspekte in modularen, gut strukturierten Inhalten anspricht, wird in der KI-Antwort eher zitiert als ein Wettbewerber mit einer generischen Produktseite. Im SaaS-Bereich taucht die Anfrage „Wie lade ich mein Team in diesen Workspace ein?“ hunderte Male in Support-Logs auf und signalisiert eine kritische Content-Lücke. Ein KI-Assistent, der auf Ihrer Dokumentation trainiert ist, hat möglicherweise Schwierigkeiten, diese Frage klar zu beantworten – was die Nutzererfahrung verschlechtert und die Sichtbarkeit in KI-generierten Support-Antworten mindert. Im Nachrichten- und Informationsbereich wird eine Anfrage wie „Was passiert bei der KI-Regulierung?“ je nach Nutzerkontext unterschiedlich interpretiert: Ein Politiker braucht Gesetzesdetails, ein Unternehmer Wettbewerbsimplikationen, ein Technologe technische Standards. Erfolgreiche Inhalte bedienen diese verschiedenen Intentionen explizit.

Trotz aller Raffinesse stoßen LLMs bei der Interpretation der Intention auf echte Herausforderungen. Mehrdeutige Anfragen wie „Java“ können sich auf Programmiersprache, Insel oder Kaffee beziehen – selbst mit Kontext kann die Intention falsch klassifiziert werden. Gemischte oder verschachtelte Intentionen erschweren die Sache zusätzlich: „Ist dieses CRM besser als Salesforce und wo kann ich es kostenlos testen?“ kombiniert Vergleichs-, Bewertungs- und Transaktionsintention in einer Anfrage. Kontextfenster-Beschränkungen bedeuten, dass LLMs immer nur einen begrenzten Teil der Konversationshistorie berücksichtigen können – in langen Dialogen gehen frühere Intentionen verloren. Halluzinationen und Faktenfehler sind nach wie vor ein Problem, besonders in Bereichen mit hohen Anforderungen an Genauigkeit wie Gesundheit, Finanzen oder Recht. Datenschutzaspekte spielen ebenfalls eine Rolle: Je mehr Verhaltensdaten zur Personalisierung gesammelt werden, desto sorgfältiger muss zwischen Präzision und Privatsphäre abgewogen werden. Das Bewusstsein für diese Grenzen hilft Content-Erstellern und Marketern, realistische Erwartungen für die Sichtbarkeit in der KI-Suche zu formulieren und zu akzeptieren, dass nicht jede Anfrage perfekt interpretiert werden kann.

Intentbasierte Suche entwickelt sich rasant zu einem immer tieferen Verständnis und natürlicheren Interaktionen. Konversationelle KI wird immer natürlicher, mit Systemen, die Kontext über längere, komplexe Dialoge erhalten, in denen sich die Intention fortlaufend verändert. Multimodale Intentionserkennung wird Text, Bilder, Sprache und sogar Video kombinieren, um Nutzerziele ganzheitlich zu interpretieren – stellen Sie sich vor, Sie bitten einen KI-Assistenten „Finde mir so etwas wie das hier“ und zeigen ein Foto. Zero-Query-Suche ist ein kommender Trend, bei dem KI-Systeme Nutzerbedürfnisse antizipieren, bevor sie explizit formuliert werden, indem sie Verhalten und Kontext nutzen, um proaktiv relevante Informationen bereitzustellen. Verbesserte Personalisierung wird die Ergebnisse immer stärker auf individuelle Profile, Entscheidungsphasen und Situationen zuschneiden. Integration mit Empfehlungssystemen wird die Grenze zwischen Suche und Entdeckung verwischen, da KI-Systeme relevante Inhalte vorschlagen, nach denen Nutzer nicht aktiv suchen. Mit dem Fortschritt dieser Fähigkeiten gewinnen Marken und Creator, die Intentionen tief verstehen und Inhalte für verschiedene Kontexte und Nutzertypen umfassend strukturieren, den entscheidenden Wettbewerbsvorteil.

Nutzerintention bezieht sich auf das zugrunde liegende Ziel oder den Zweck hinter einer Anfrage, nicht nur auf die eingegebenen Schlüsselwörter. LLMs interpretieren die semantische Bedeutung, indem sie Kontext, Formulierung und verwandte Signale analysieren, um vorherzusagen, was Nutzer wirklich erreichen möchten. Deshalb kann die gleiche Anfrage je nach Nutzerkontext und Entscheidungsphase unterschiedliche Ergebnisse liefern.

LLMs nutzen einen Prozess namens 'Query Fan-out', um eine einzelne Anfrage in Dutzende verwandte Mikrofragen zu zerlegen. Zum Beispiel kann 'Notion vs Trello' in Unteranfragen zu Teamzusammenarbeit, Preisgestaltung, Integrationen und Benutzerfreundlichkeit aufgeteilt werden. So können KI-Systeme verschiedene Facetten der Intention erkunden und umfassende Informationen sammeln.

Das Verständnis der Intention hilft Content-Erstellern dabei, Inhalte so zu optimieren, wie KI-Systeme diese tatsächlich interpretieren und zitieren. Inhalte, die mehrere Unterintentionen in modularen Abschnitten abdecken, werden eher von LLMs ausgewählt. Dies beeinflusst direkt die Sichtbarkeit in KI-generierten Antworten bei ChatGPT, Perplexity und Google AI.

Semantische Einbettungen wandeln Wörter und Phrasen in mathematische Vektoren um, die Bedeutung statt nur den Text auf der Oberfläche erfassen. Dadurch erkennen LLMs, dass 'preiswert', 'budgetfreundlich' und 'günstig' die gleiche Intention ausdrücken, auch wenn unterschiedliche Begriffe verwendet werden. Dieser semantische Ansatz bewältigt Synonyme, Paraphrasen und Kontext deutlich besser als herkömmliches Keyword-Matching.

Ja, LLMs stoßen bei mehrdeutigen Anfragen, gemischten Intentionen und Kontextbeschränkungen auf Herausforderungen. Anfragen wie 'Java' können sich auf Programmiersprache, Geografie oder Kaffee beziehen. Lange Gespräche können den Kontextbereich überschreiten, wodurch frühere Intentionen vergessen werden. Das Verständnis dieser Grenzen hilft, realistische Erwartungen an die Sichtbarkeit in der KI-Suche zu setzen.

Marken sollten modulare Inhalte erstellen, die mehrere Unterintentionen in separaten Abschnitten abdecken. Verwenden Sie zitierfähige Formate mit Fakten, konkreten Zahlen und klarer Struktur. Überwachen Sie mit Tools wie AmICited, wie KI-Systeme Ihre Inhalte referenzieren, um Lücken bei der Intentionserfüllung zu erkennen und gezielt zu optimieren.

Intention ist auf eine Aufgabe fokussiert – was Nutzer jetzt erreichen möchten. Interesse ist breiteres, allgemeines Interesse. KI-Systeme priorisieren die Intention, da sie direkt bestimmt, welche Inhalte für Antworten ausgewählt werden. Ein Nutzer kann sich für Produktivitätstools im Allgemeinen interessieren, seine Intention könnte aber sein, ein Tool speziell für die Zusammenarbeit im Remote-Team zu finden.

KI-Systeme zitieren Quellen, die am besten zur erkannten Intention passen. Wenn Ihr Inhalt eine bestimmte Unterintention klar mit gut strukturierten, faktenbasierten Informationen beantwortet, wird er mit größerer Wahrscheinlichkeit ausgewählt. Tools wie AmICited verfolgen diese Zitationsmuster und zeigen, welche Intentionserfüllungen Sichtbarkeit in KI-generierten Antworten bewirken.

Verstehen Sie, wie LLMs Ihre Inhalte in ChatGPT, Perplexity und Google AI referenzieren. Verfolgen Sie die Ausrichtung der Intention und optimieren Sie für KI-Sichtbarkeit mit AmICited.

Suchintention ist der Zweck hinter einer Suchanfrage eines Nutzers. Erfahren Sie die vier Typen der Suchintention, wie Sie diese identifizieren und Inhalte für ...

Erfahren Sie, was informationale Suchintention für KI-Systeme bedeutet, wie KI diese Anfragen erkennt und warum es für die Sichtbarkeit von Inhalten in KI-gestü...

Erfahren Sie, wie Sie Suchintentionen in KI-Suchmaschinen identifizieren und optimieren. Entdecken Sie Methoden zur Klassifizierung von Nutzeranfragen, Analyse ...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.