Cloudflare und KI-Bots: Zugriffsmanagement am Edge

Erfahren Sie, wie Cloudflares Edge-basierte KI-Crawl Control Ihnen hilft, den Zugriff von KI-Crawlern auf Ihre Inhalte mit granularen Richtlinien und Echtzeit-A...

Erfahren Sie, wie Web Application Firewalls fortschrittliche Kontrolle über KI-Crawler bieten – weit über robots.txt hinaus. Implementieren Sie WAF-Regeln, um Ihre Inhalte vor unbefugtem KI-Scraping zu schützen und mit AmICited KI-Zitationen zu überwachen.

Die Unzulänglichkeit von robots.txt als alleinige Schutzmaßnahme tritt im Zeitalter der KI-basierten Inhaltsnutzung immer deutlicher zutage. Während traditionelle Suchmaschinen robots.txt-Vorgaben meist respektieren, verfolgen moderne KI-Crawler völlig andere Anreize und setzen andere Mechanismen ein, sodass einfache textbasierte Richtlinien nicht mehr ausreichen, um Inhalte zu schützen. Laut einer Cloudflare-Analyse machen KI-Crawler mittlerweile fast 80 % des gesamten Bot-Traffics auf Websites aus; Trainings-Crawler konsumieren enorme Mengen an Inhalten und liefern dabei kaum Referral-Traffic zurück – OpenAIs Crawler erreichen ein Verhältnis von 400:1 zwischen Crawls und Referral-Traffic, bei Anthropic liegt es sogar bei 38.000:1. Für Publisher und Rechteinhaber bedeutet dieses Ungleichgewicht eine erhebliche wirtschaftliche Bedrohung, denn KI-Modelle, die auf ihren Inhalten trainiert werden, können den organischen Traffic direkt reduzieren und den Wert ihres geistigen Eigentums schmälern.

Eine Web Application Firewall (WAF) fungiert als Reverse Proxy zwischen Nutzern und Webservern und prüft alle HTTP-Anfragen in Echtzeit, um unerwünschten Traffic anhand konfigurierbarer Regeln herauszufiltern. Im Gegensatz zu robots.txt, das auf freiwillige Crawler-Compliance setzt, erzwingen WAFs den Schutz auf Infrastrukturebene – sie sind daher viel effektiver, um KI-Crawler zu kontrollieren. Der folgende Vergleich zeigt die Unterschiede zu traditionellen Sicherheitsansätzen:

| Merkmal | Robots.txt | Traditionelle Firewall | Moderne WAF |

|---|---|---|---|

| Durchsetzungsebene | Empfehlend/freiwillig | IP-basierte Blockierung | Applikationsspezifische Prüfung |

| KI-Crawler-Erkennung | Nur User-Agent-Abgleich | Begrenzte Bot-Erkennung | Verhaltensanalyse + Fingerprinting |

| Echtzeit-Anpassung | Statische Datei | Manuelle Updates erforderlich | Kontinuierliche Threat Intelligence |

| Granularität der Kontrolle | Nur auf Pfad-Ebene | Breite IP-Bereiche | Richtlinien auf Anfrage-Ebene |

| Maschinelles Lernen | Keine | Keine | Fortschrittliche Bot-Klassifikation |

WAFs ermöglichen eine granulare Bot-Klassifikation durch Device Fingerprinting, Verhaltensanalyse und maschinelles Lernen, um Bots nach Absicht und Komplexität zu profilieren – und bieten dadurch weit mehr Kontrolle als einfache Allow/Deny-Regeln.

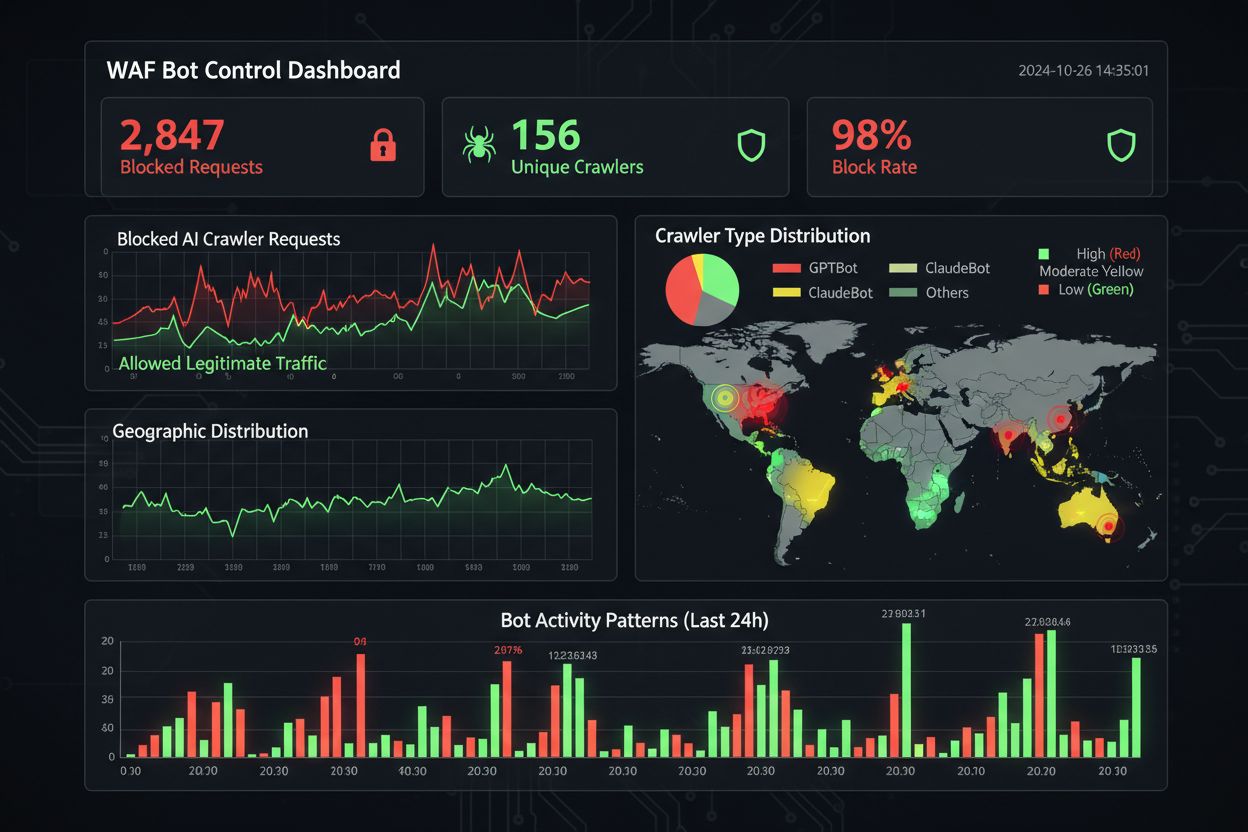

KI-Crawler lassen sich in drei Kategorien einteilen, die jeweils unterschiedliche Risiken bergen und unterschiedliche Abwehrmaßnahmen erfordern: Trainings-Crawler wie GPTBot, ClaudeBot und Google-Extended sammeln systematisch Webinhalte, um Datensätze für große Sprachmodelle zu erstellen; sie verursachen etwa 80 % des gesamten KI-Crawler-Traffics und liefern Publishern keinerlei Referral-Wert. Such- und Zitations-Crawler wie OAI-SearchBot und PerplexityBot indexieren Inhalte für KI-basierte Sucherlebnisse und können über Zitate etwas Referral-Traffic bringen, allerdings in deutlich geringerem Umfang als klassische Suchmaschinen. User-triggered Fetcher werden nur aktiv, wenn Nutzer gezielt Inhalte über KI-Assistenten anfordern – sie agieren mit sehr geringem Volumen und nicht systematisch. Die Bedrohungslage umfasst:

Moderne WAFs nutzen ausgefeilte technische Erkennungsverfahren, die weit über den Abgleich von User-Agent-Strings hinausgehen, um KI-Crawler mit hoher Genauigkeit zu identifizieren und zu klassifizieren. Sie setzen Verhaltensanalysen ein, um Anfrage-Muster zu untersuchen – etwa Crawl-Geschwindigkeit, Reihenfolge der Requests und Antwortverhalten –, die Bots von menschlichen Nutzern unterscheiden. Device Fingerprinting analysiert HTTP-Header, TLS-Signaturen und Browser-Merkmale, um gefälschte User-Agents zu erkennen, die klassische Abwehrmaßnahmen umgehen wollen. Maschinelle Lernmodelle, trainiert auf Millionen von Anfragen, erkennen neue Crawler-Signaturen und Bot-Taktiken in Echtzeit und passen sich neuen Bedrohungen an, ohne manuelle Regelupdates zu benötigen. Zudem können WAFs die Legitimität von Crawlern prüfen, indem sie die anfragenden IP-Adressen mit offiziellen IP-Listen großer KI-Anbieter abgleichen – OpenAI veröffentlicht verifizierte IPs unter https://openai.com/gptbot.json, Amazon unter https://developer.amazon.com/amazonbot/ip-addresses/ – und so sicherstellen, dass nur authentifizierte Crawler zugelassen werden.

Die effektive Umsetzung von WAF-Regeln für KI-Crawler erfordert einen mehrschichtigen Ansatz aus User-Agent-Blockierung, IP-Verifizierung und Verhaltensrichtlinien. Das folgende Beispiel zeigt eine grundlegende WAF-Regelkonfiguration, die bekannte Trainings-Crawler blockiert und legitime Suchfunktionalität zulässt:

# WAF-Regel: Blockiere KI-Trainings-Crawler

Regelname: Block-AI-Training-Crawlers

Bedingung 1: HTTP User-Agent entspricht (GPTBot|ClaudeBot|anthropic-ai|Google-Extended|Meta-ExternalAgent|Amazonbot|CCBot|Bytespider)

Aktion: Blockieren (403 Forbidden zurückgeben)

# WAF-Regel: Erlaube verifizierte Such-Crawler

Regelname: Allow-Verified-Search-Crawlers

Bedingung 1: HTTP User-Agent entspricht (OAI-SearchBot|PerplexityBot)

Bedingung 2: Quell-IP in verifiziertem IP-Bereich

Aktion: Erlauben

# WAF-Regel: Rate-Limit für verdächtigen Bot-Traffic

Regelname: Rate-Limit-Suspicious-Bots

Bedingung 1: Anfrage-Rate übersteigt 100 Anfragen/Minute

Bedingung 2: User-Agent enthält Bot-Indikatoren

Bedingung 3: Keine verifizierte IP

Aktion: Challenge (CAPTCHA) oder Blockieren

Organisationen sollten die Reihenfolge der Regeln sorgfältig festlegen, sodass spezifischere Regeln (wie IP-Verifizierung für legitime Crawler) vor allgemeinen Blockierregeln ausgeführt werden. Die regelmäßige Überprüfung und das Monitoring der Regelwirksamkeit sind essenziell, da sich Crawler-User-Agents und IP-Bereiche häufig ändern. Viele WAF-Anbieter bieten vorgefertigte Regelsets speziell für das KI-Crawler-Management an, wodurch die Umsetzung vereinfacht wird und dennoch umfassender Schutz besteht.

IP-Verifizierung und Allowlisting sind die zuverlässigste Methode, um legitime KI-Crawler von gefälschten Anfragen zu unterscheiden, denn User-Agent-Strings lassen sich leicht fälschen, IP-Adressen hingegen nur schwer massenhaft. Große KI-Anbieter veröffentlichen offizielle IP-Bereiche im JSON-Format, wodurch eine automatisierte Prüfung ohne manuellen Pflegeaufwand möglich ist – OpenAI bietet separate IP-Listen für GPTBot, OAI-SearchBot und ChatGPT-User, Amazon pflegt eine umfassende Liste für Amazonbot. WAF-Regeln können so konfiguriert werden, dass ausschließlich Anfragen aus diesen verifizierten IP-Bereichen erlaubt sind und Angreifer nicht einfach über einen manipulierten User-Agent-Header an den Schutzmaßnahmen vorbei gelangen. Wer auf Server-Ebene (z. B. über .htaccess oder Firewall-Regeln) blockiert, kombiniert idealerweise IP-Prüfung und User-Agent-Abgleich für einen mehrschichtigen Schutz, der unabhängig von der WAF funktioniert. Einige Crawler respektieren zudem HTML-Meta-Tags wie <meta name="robots" content="noarchive">, das konformen Crawlern signalisiert, den Inhalt nicht für Modelltraining zu verwenden – ein ergänzender Kontrollmechanismus für Publisher, die granulare, seitenbasierte Steuerung wünschen.

Effektive Überwachung und Compliance erfordern kontinuierliche Sichtbarkeit über die Crawler-Aktivitäten und die Verifizierung, dass Blockierregeln wie gewünscht greifen. Organisationen sollten regelmäßig Server-Access-Logs analysieren, um festzustellen, welche Crawler auf ihre Seiten zugreifen und ob geblockte Crawler weiterhin Anfragen stellen – Apache-Logs liegen meist unter /var/log/apache2/access.log, Nginx-Logs unter /var/log/nginx/access.log; mit grep lassen sich verdächtige Muster schnell filtern. Analyseplattformen unterscheiden zunehmend Bot-Traffic von menschlichen Besuchern, sodass Teams die Auswirkungen von Blockierungen auf legitime Metriken wie Bounce Rate, Conversion-Tracking und SEO-Leistung messen können. Tools wie Cloudflare Radar liefern globale Einblicke in das KI-Bot-Traffic-Muster und helfen, neue Crawler zu erkennen, die noch nicht auf der Blockliste stehen. Aus Compliance-Sicht generieren WAF-Logs Prüfnachweise, dass angemessene Sicherheitsmaßnahmen zum Schutz von Kundendaten und geistigem Eigentum umgesetzt wurden – was für DSGVO, CCPA und andere Datenschutzrichtlinien immer wichtiger wird. Vierteljährliche Überprüfungen der Crawler-Blockliste sind unerlässlich, da regelmäßig neue KI-Crawler auftauchen und bestehende ihre User-Agents ändern – das Community-Projekt ai.robots.txt auf GitHub

ist hierfür eine wertvolle Ressource.

Content-Schutz und Geschäftsziele müssen sorgsam abgewogen werden, denn zu striktes Blockieren kann die Sichtbarkeit in neuen KI-Discovery-Kanälen verringern. Das Blockieren von Trainings-Crawlern wie GPTBot und ClaudeBot schützt das geistige Eigentum, hat aber keine direkten Auswirkungen auf den Traffic, da diese Crawler keinen Referral-Traffic senden. Das Blockieren von Such-Crawlern wie OAI-SearchBot und PerplexityBot kann hingegen die Sichtbarkeit in KI-Suchergebnissen reduzieren, wo Nutzer aktiv Zitate und Quellen suchen – hier ist eine Abwägung je nach Content-Strategie und Zielgruppe nötig. Manche Publisher verfolgen Alternativen wie das Zulassen von Such-Crawlern bei gleichzeitigem Blockieren von Trainings-Crawlern oder setzen auf Pay-per-Crawl-Modelle, bei denen KI-Anbieter für den Zugriff auf Inhalte bezahlen. Tools wie AmICited.com helfen Publishern zu überprüfen, ob ihre Inhalte in KI-generierten Antworten zitiert werden, und liefern Daten für Blockierentscheidungen. Die optimale WAF-Konfiguration hängt vom Geschäftsmodell ab: Nachrichtenseiten priorisieren oft das Blockieren von Trainings-Crawlern, um Inhalte zu schützen, und lassen Such-Crawler für die Sichtbarkeit zu; SaaS-Anbieter blockieren möglicherweise alle KI-Crawler, um Wettbewerbsanalysen zu verhindern. Durch regelmäßiges Monitoring von Traffic-Mustern und Umsätzen nach der Einführung von WAF-Regeln lässt sich sicherstellen, dass die Schutzstrategie zu den Geschäftszielen passt.

Beim Vergleich von WAF-Lösungen für das Management von KI-Crawlern sollten Unternehmen auf mehrere zentrale Fähigkeiten achten, die professionelle Plattformen von Basisschutz unterscheiden. Cloudflares AI Crawl Control integriert sich in die WAF und bietet vorgefertigte Regeln für bekannte KI-Crawler sowie die Möglichkeit, einzelne Crawler zu blockieren, zuzulassen oder Pay-per-Crawl-Monetarisierung umzusetzen – die Reihenfolge der Regeln garantiert, dass WAF-Regeln vor anderen Sicherheits-Layern greifen. AWS WAF Bot Control bietet Basis- und gezielte Schutzstufen; letztere nutzt Browser-Befragungen, Fingerprinting und Verhaltensheuristiken zur Erkennung fortschrittlicher Bots, die sich nicht selbst identifizieren, sowie optional maschinelle Analyse von Traffic-Statistiken. Azure WAF bietet ähnliche Funktionen über verwaltete Regelsets, hat aber weniger KI-Spezialisierung als Cloudflare oder AWS. Darüber hinaus gibt es spezialisierte Bot-Management-Lösungen wie DataDome mit fortschrittlichen Machine-Learning-Modellen, die speziell auf KI-Crawler trainiert sind – allerdings zu höheren Kosten. Die Wahl der Lösung hängt von vorhandener Infrastruktur, Budget und gewünschtem Funktionsumfang ab: Wer bereits Cloudflare nutzt, profitiert von nahtloser Integration, AWS-Kunden können Bot Control ins bestehende WAF-Setup einbinden.

Best Practices für das Management von KI-Crawlern setzen auf einen Defense-in-Depth-Ansatz, der mehrere Steuerungsmechanismen kombiniert, statt sich auf eine Einzelmaßnahme zu verlassen. Unternehmen sollten vierteljährliche Blocklisten-Reviews durchführen, um neue Crawler und aktualisierte User-Agents zu erfassen, Server-Log-Analysen pflegen, um zu prüfen, ob geblockte Crawler die Regeln umgehen, und WAF-Konfigurationen regelmäßig testen, um die korrekte Reihenfolge der Regelanwendung zu gewährleisten. Die Zukunft der WAF-Technologie wird zunehmend KI-basierte Bedrohungserkennung integrieren, die sich in Echtzeit an neue Crawler-Taktiken anpasst – eingebettet in umfassende Sicherheitssysteme für kontextbezogenen Schutz. Mit zunehmender Regulierung rund um Datenscraping und KI-Trainingsdaten werden WAFs unverzichtbare Compliance-Tools, nicht mehr nur optionale Sicherheitsfeatures. Unternehmen sollten jetzt umfassende WAF-Regeln für KI-Crawler implementieren, bevor neue Bedrohungen wie browserbasierte KI-Agenten und Headless-Browser-Crawler zum Massenphänomen werden – die Kosten der Untätigkeit, gemessen an Traffic-Verlusten, verfälschter Analyse und möglicher rechtlicher Risiken, übersteigen die Investition in eine robuste Schutzinfrastruktur bei weitem.

Robots.txt ist eine Empfehlung, die darauf beruht, dass Crawler Ihre Vorgaben freiwillig respektieren, während WAF-Regeln auf Infrastrukturebene durchgesetzt werden und für alle Anfragen unabhängig von der Crawler-Compliance gelten. WAFs ermöglichen Echtzeiterkennung und -blockierung, während robots.txt statisch und von nicht-konformen Crawlern leicht umgangen werden kann.

Ja, viele KI-Crawler ignorieren robots.txt-Vorgaben, da sie darauf ausgelegt sind, möglichst viele Trainingsdaten zu sammeln. Während sich gutartige Crawler großer Unternehmen meist an robots.txt halten, tun dies böswillige Akteure und einige neue Crawler nicht. Deshalb bieten WAF-Regeln einen zuverlässigeren Schutz.

Überprüfen Sie Ihre Server-Access-Logs (typischerweise unter /var/log/apache2/access.log oder /var/log/nginx/access.log) auf User-Agent-Strings mit Bot-Kennungen. Tools wie Cloudflare Radar bieten globale Einblicke in das KI-Crawler-Traffic-Muster, und Analyseplattformen unterscheiden zunehmend Bot-Traffic von menschlichen Besuchern.

Das Blockieren von Trainings-Crawlern wie GPTBot hat keinen direkten Einfluss auf SEO, da sie keinen Referral-Traffic senden. Das Blockieren von Such-Crawlern wie OAI-SearchBot kann jedoch die Sichtbarkeit in KI-gesteuerten Suchergebnissen verringern. Googles AI Overviews folgen den Standard-Googlebot-Regeln – das Blockieren von Google-Extended beeinträchtigt also nicht das reguläre Suchmaschinen-Indexing.

Cloudflares AI Crawl Control, AWS WAF Bot Control und Azure WAF bieten effektive Lösungen. Cloudflare stellt die meisten KI-spezifischen Funktionen mit vorgefertigten Regeln und Pay-per-Crawl-Optionen bereit. AWS bietet fortschrittliche maschinelle Lern-Erkennung, während Azure solide verwaltete Regelsets bereitstellt. Wählen Sie je nach vorhandener Infrastruktur und Budget.

Überprüfen und aktualisieren Sie Ihre WAF-Regeln mindestens vierteljährlich, da regelmäßig neue KI-Crawler auftauchen und bestehende Crawler ihre User-Agent-Strings ändern. Überwachen Sie das von der Community gepflegte ai.robots.txt-Projekt auf GitHub für neue Bedrohungen und prüfen Sie monatlich die Server-Logs, um neue Crawler zu erkennen.

Ja, das ist eine gängige Strategie. Sie können WAF-Regeln so konfigurieren, dass Trainings-Crawler wie GPTBot und ClaudeBot blockiert, Such-Crawler wie OAI-SearchBot und PerplexityBot jedoch zugelassen werden. So schützen Sie Ihre Inhalte vor Training, behalten aber die Sichtbarkeit in KI-Suchergebnissen.

Die WAF-Preise variieren je nach Anbieter. Cloudflare bietet WAF ab 20 $/Monat inklusive AI Crawl Control. AWS WAF berechnet pro Web-ACL und Regel, typischerweise 5-10 $/Monat für Basisschutz. Azure WAF ist im Application Gateway enthalten. Die Implementierungskosten sind im Vergleich zum Wert des Content-Schutzes und genauer Analysen gering.

AmICited verfolgt die Aktivität von KI-Crawlern und überwacht, wie Ihre Inhalte in ChatGPT, Perplexity, Google AI Overviews und anderen KI-Plattformen zitiert werden. Erhalten Sie Transparenz zu Ihrer KI-Präsenz und verstehen Sie, welche Crawler auf Ihre Inhalte zugreifen.

Erfahren Sie, wie Cloudflares Edge-basierte KI-Crawl Control Ihnen hilft, den Zugriff von KI-Crawlern auf Ihre Inhalte mit granularen Richtlinien und Echtzeit-A...

Erfahren Sie, wie Sie KI-Crawler selektiv je nach Geschäftszielen zulassen oder blockieren. Implementieren Sie differenziellen Crawler-Zugang, um Inhalte zu sch...

Erfahren Sie, wie Sie mit robots.txt steuern, welche KI-Bots auf Ihre Inhalte zugreifen. Vollständiger Leitfaden zum Blockieren von GPTBot, ClaudeBot und andere...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.