In Wikipedia-Artikeln zitiert werden: Ein nicht-manipulativer Ansatz

Erlernen Sie ethische Strategien, um Ihre Marke auf Wikipedia zitiert zu bekommen. Verstehen Sie Wikipedias Inhaltsrichtlinien, zuverlässige Quellen und wie Sie...

Entdecken Sie, wie Wikipedia-Zitate KI-Trainingsdaten formen und einen Welleneffekt auf LLMs auslösen. Erfahren Sie, warum Ihre Wikipedia-Präsenz für KI-Erwähnungen und Markenwahrnehmung entscheidend ist.

Wikipedia ist heute zum Grundpfeiler der Trainingsdatensätze für praktisch jedes große Large Language Model geworden – von OpenAI’s ChatGPT und Googles Gemini bis hin zu Anthropic’s Claude und Perplexity’s Suchmaschine. In vielen Fällen stellt Wikipedia die größte einzelne Quelle für strukturierte, hochwertige Texte innerhalb der Trainingsdatensätze dieser KI-Systeme dar und macht häufig 5-15% des gesamten Trainingskorpus aus, je nach Modell. Diese Dominanz beruht auf Wikipedias einzigartigen Eigenschaften: Die Neutralitätsrichtlinie, strenge gemeinschaftsgetriebene Faktenprüfung, strukturierte Formatierung und frei verfügbare Lizenzierung machen Wikipedia zu einer unvergleichlichen Ressource, um KI-Systemen beizubringen, wie man argumentiert, Quellen zitiert und präzise kommuniziert. Diese Beziehung hat die Rolle von Wikipedia im digitalen Ökosystem grundlegend verändert – sie ist nicht mehr nur ein Ziel für menschliche Leser auf Informationssuche, sondern das unsichtbare Rückgrat, das die Konversations-KI antreibt, mit der Millionen täglich interagieren. Das Verständnis dieser Verbindung offenbart einen entscheidenden Welleneffekt: Die Qualität, Vorurteile und Lücken in Wikipedia prägen direkt die Fähigkeiten und Grenzen der KI-Systeme, die heute vermitteln, wie Milliarden Menschen auf Informationen zugreifen und sie verstehen.

Wenn Large Language Models während des Trainings Informationen verarbeiten, behandeln sie nicht alle Quellen gleich – Wikipedia nimmt eine einzigartig privilegierte Position in ihrer Entscheidungsfindung ein. Während des Entity-Recognition-Prozesses identifizieren LLMs wichtige Fakten und Konzepte und gleichen sie dann mit mehreren Quellen ab, um Glaubwürdigkeitswerte zuzuweisen. Wikipedia fungiert dabei als „primärer Autoritäts-Check“, weil seine transparente Bearbeitungshistorie, gemeinschaftliche Verifizierungsmechanismen und die Neutralitätsrichtlinie gemeinsam Zuverlässigkeit für KI-Systeme signalisieren. Der Glaubwürdigkeits-Multiplikatoreffekt verstärkt diesen Vorteil: Wenn Informationen konsistent in Wikipedia, in strukturierten Wissensgraphen wie Google Knowledge Graph und Wikidata sowie in akademischen Quellen erscheinen, vergeben LLMs exponentiell mehr Vertrauen an diese Information. Dieses Gewichtungssystem erklärt, warum Wikipedia im Training eine Sonderstellung einnimmt – es dient sowohl als direkte Wissensquelle als auch als Validierungsebene für Fakten aus anderen Quellen. Das Ergebnis: LLMs haben gelernt, Wikipedia nicht bloß als einen Datenpunkt unter vielen zu behandeln, sondern als grundlegende Referenz, die Informationen weniger geprüfter Quellen bestätigt oder in Frage stellt.

| Quellentyp | Glaubwürdigkeitsgewicht | Begründung | KI-Behandlung |

|---|---|---|---|

| Wikipedia | Sehr hoch | Neutral, gemeinschaftlich bearbeitet, verifiziert | Primäre Referenz |

| Firmenwebsite | Mittel | Eigenwerbung | Sekundärquelle |

| Nachrichtenartikel | Hoch | Drittanbieter, aber potenziell voreingenommen | Bestätigungsquelle |

| Wissensgraphen | Sehr hoch | Strukturiert, aggregiert | Autoritätsmultiplikator |

| Soziale Medien | Niedrig | Ungeprüft, werblich | Minimales Gewicht |

| Akademische Quellen | Sehr hoch | Peer-reviewed, autoritativ | Hohes Vertrauen |

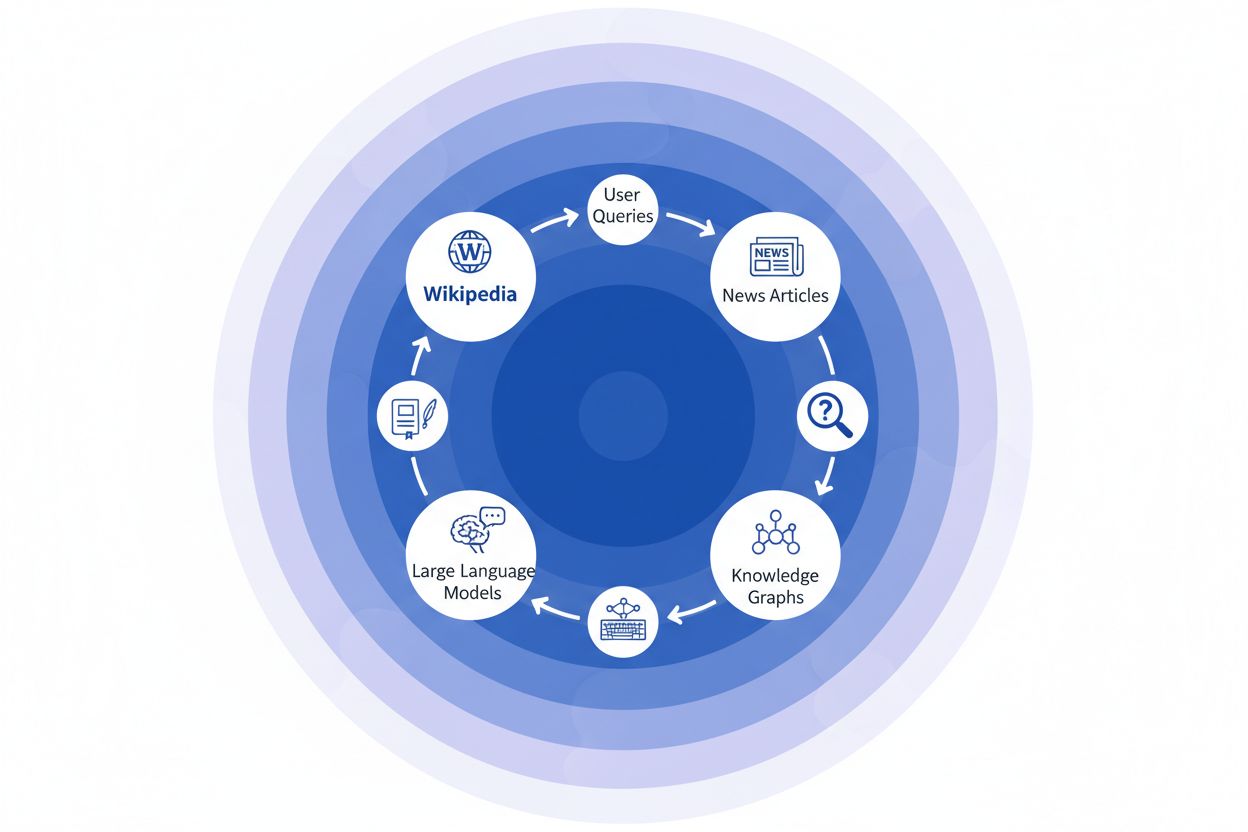

Wenn eine Nachrichtenorganisation Wikipedia als Quelle zitiert, entsteht die sogenannte „Zitationskette“ – ein Kaskadenmechanismus, bei dem sich Glaubwürdigkeit über mehrere Ebenen der Informationsinfrastruktur hinweg vervielfacht. Ein Journalist, der über Klimawissenschaft schreibt, könnte einen Wikipedia-Artikel über globale Erwärmung referenzieren, der seinerseits auf peer-reviewte Studien verweist; dieser Nachrichtenartikel wird dann von Suchmaschinen indexiert und in Wissensgraphen aufgenommen, die wiederum Large Language Models trainieren, die täglich von Millionen Menschen abgefragt werden. So entsteht eine mächtige Rückkopplungsschleife: Wikipedia → Wissensgraph → LLM → Nutzer, wobei die ursprüngliche Wikipedia-Darstellung und Schwerpunktsetzung subtil beeinflusst, wie KI-Systeme Informationen für Endnutzer präsentieren – oft ohne dass diesen bewusst ist, dass die Informationen auf einer Crowdsourcing-Enzyklopädie basieren. Ein konkretes Beispiel: Wenn der Wikipedia-Artikel zu einer pharmazeutischen Behandlung bestimmte klinische Studien hervorhebt und andere herunterspielt, wirkt sich diese redaktionelle Entscheidung auf die Berichterstattung aus, fließt in Wissensgraphen ein und bestimmt letztlich, wie ChatGPT oder ähnliche Modelle Patientenfragen zu Behandlungsmöglichkeiten beantworten. Dieser „Welleneffekt“ bedeutet, dass redaktionelle Entscheidungen auf Wikipedia nicht nur Leser beeinflussen, die die Seite direkt besuchen – sie prägen das Informationsumfeld, aus dem KI-Systeme lernen, und spiegeln dies Milliarden von Nutzern wider. Die Zitationskette macht Wikipedia im Grunde von einem Referenzziel zu einer unsichtbaren, aber einflussreichen Schicht der KI-Trainingspipeline, in der Genauigkeit und Verzerrung an der Quelle sich auf das gesamte Ökosystem auswirken können.

Der Welleneffekt im Wikipedia-zu-KI-Ökosystem ist wahrscheinlich die folgenreichste Dynamik, die Marken und Organisationen verstehen sollten. Eine einzelne Änderung auf Wikipedia verändert nicht nur eine Quelle – sie zieht sich durch ein vernetztes Netzwerk von KI-Systemen, die alle daraus Informationen ziehen und sie auf eine Weise verstärken, die ihre Wirkung exponentiell vervielfacht. Erscheint eine Ungenauigkeit auf einer Wikipedia-Seite, bleibt sie nicht isoliert; stattdessen verbreitet sie sich über die gesamte KI-Landschaft und beeinflusst, wie Ihre Marke Millionen Nutzern täglich beschrieben, verstanden und präsentiert wird. Dieser Multiplikatoreffekt bedeutet, dass Investitionen in die Genauigkeit von Wikipedia nicht nur eine Plattform betreffen – sie steuern Ihre Darstellung im gesamten generativen KI-Ökosystem. Für digitale PR- und Markenverantwortliche verändert diese Realität grundlegend die Überlegung, wo Ressourcen und Aufmerksamkeit eingesetzt werden sollten.

Wichtige Welleneffekte, die Sie im Auge behalten sollten:

Neue Forschungsergebnisse der IUP-Studie von Vetter et al. haben eine kritische Schwachstelle unserer KI-Infrastruktur aufgezeigt: Die Nachhaltigkeit von Wikipedia als Trainingsressource ist zunehmend durch genau die Technologie bedroht, die sie mitgestaltet. Während Large Language Models sich vervielfachen und auf immer größeren Datensätzen, die auch LLM-generierte Inhalte enthalten, trainiert werden, entsteht ein sich verstärkendes „Model Collapse“-Problem: Künstliche Ausgaben beginnen, den Trainingsdatenpool zu kontaminieren und verschlechtern die Modellqualität über Generationen hinweg. Dieses Phänomen ist besonders gravierend, da Wikipedia – eine Crowdsourcing-Enzyklopädie, gestützt auf menschliche Expertise und ehrenamtliche Arbeit – zu einer tragenden Säule für das Training fortgeschrittener KI-Systeme geworden ist, meist ohne explizite Nennung oder Entlohnung der Beitragenden. Die ethischen Implikationen sind tiefgreifend: Während KI-Unternehmen den Wert von Wikipedias frei beigetragenem Wissen abschöpfen und gleichzeitig das Informationsökosystem mit synthetischen Inhalten fluten, geraten die Anreizstrukturen, die die Wikipedia-Community über zwei Jahrzehnte getragen haben, unter beispiellosen Druck. Ohne gezielte Maßnahmen, um menschlich generierte Inhalte als separate, geschützte Ressource zu erhalten, riskieren wir eine Rückkopplungsschleife, bei der KI-generierter Text nach und nach authentisches menschliches Wissen ersetzt – und so die Grundlage zerstört, auf der moderne Sprachmodelle beruhen. Die Nachhaltigkeit von Wikipedia ist daher nicht nur ein Thema für die Enzyklopädie selbst, sondern eine kritische Frage für das gesamte Informationsökosystem und die zukünftige Funktionsfähigkeit KI-gestützter Systeme, die von authentischem menschlichen Wissen abhängen.

Da KI-Systeme zunehmend auf Wikipedia als grundlegende Wissensquelle setzen, ist die Überwachung, wie Ihre Marke in KI-generierten Antworten erscheint, für moderne Organisationen unerlässlich geworden. AmICited.com ist darauf spezialisiert, Wikipedia-Zitate auf ihrem Weg durch KI-Systeme zu verfolgen und Marken Einblick zu geben, wie ihre Wikipedia-Präsenz in KI-Erwähnungen und Empfehlungen übersetzt wird. Während alternative Tools wie FlowHunt.io allgemeine Web-Monitoring-Funktionen bieten, konzentriert sich AmICited gezielt auf die Wikipedia-zu-KI-Zitationspipeline – also auf genau den Moment, in dem KI-Systeme auf Ihren Wikipedia-Eintrag zugreifen und wie das ihre Antworten beeinflusst. Dieses Verständnis ist entscheidend, weil Wikipedia-Zitate in KI-Trainingsdaten und Antwortgenerierung ein enormes Gewicht tragen – eine gepflegte Wikipedia-Präsenz informiert nicht nur menschliche Leser, sondern prägt, wie KI-Systeme Ihre Marke Millionen von Nutzern präsentieren. Durch die Überwachung Ihrer Wikipedia-Erwähnungen mit AmICited erhalten Sie umsetzbare Einblicke in Ihren KI-Fußabdruck und können Ihre Wikipedia-Präsenz gezielt optimieren – mit voller Transparenz über ihre Auswirkungen auf KI-gestützte Entdeckung und Markenwahrnehmung.

Ja, jedes große LLM einschließlich ChatGPT, Gemini, Claude und Perplexity nutzt Wikipedia als Trainingsdatenquelle. Wikipedia ist oft die größte einzelne Quelle für strukturierte, verifizierte Informationen in LLM-Trainingsdatensätzen und macht typischerweise 5-15% des gesamten Trainingskorpus aus.

Wikipedia dient KI-Systemen als Glaubwürdigkeits-Checkpoint. Wenn ein LLM Informationen über Ihre Marke generiert, gewichtet es die Beschreibung von Wikipedia stärker als andere Quellen, wodurch Ihre Wikipedia-Seite entscheidenden Einfluss darauf hat, wie KI-Systeme Sie über ChatGPT, Gemini, Claude und andere Plattformen darstellen.

Der Welleneffekt beschreibt, wie ein einzelner Wikipedia-Eintrag oder eine Bearbeitung nachgelagerte Folgen im gesamten KI-Ökosystem erzeugt. Eine Änderung auf Wikipedia kann Wissensgraphen beeinflussen, die wiederum KI-Übersichten beeinflussen, die schließlich bestimmen, wie verschiedene KI-Systeme Ihre Marke Millionen von Nutzern beschreiben.

Ja. Da LLMs Wikipedia als sehr glaubwürdig einstufen, werden ungenaue Informationen auf Ihrer Wikipedia-Seite durch KI-Systeme weiterverbreitet. Dies kann beeinflussen, wie ChatGPT, Gemini und andere KI-Plattformen Ihr Unternehmen beschreiben und somit Ihre Markenwahrnehmung schädigen.

Tools wie AmICited.com verfolgen, wie Ihre Marke in KI-Systemen wie ChatGPT, Perplexity und Google AI Overviews zitiert und erwähnt wird. Das hilft Ihnen, den Welleneffekt Ihrer Wikipedia-Präsenz zu verstehen und gezielt zu optimieren.

Wikipedia hat strenge Richtlinien gegen Eigenwerbung. Alle Bearbeitungen sollten Wikipedias Richtlinien folgen und auf zuverlässigen, unabhängigen Quellen basieren. Viele Organisationen arbeiten mit Wikipedia-Spezialisten zusammen, um die Einhaltung zu gewährleisten und zugleich eine korrekte Präsenz zu behalten.

LLMs werden auf Daten-Snapshots trainiert, daher benötigen Änderungen Zeit, um sich durchzusetzen. Wissensgraphen werden jedoch häufiger aktualisiert, sodass der Welleneffekt je nach KI-System und Zeitpunkt des Retrainings innerhalb von Wochen bis Monaten beginnen kann.

Wikipedia ist eine primäre Quelle, die direkt für das LLM-Training verwendet wird. Wissensgraphen wie Googles Knowledge Graph aggregieren Informationen aus mehreren Quellen, einschließlich Wikipedia, und speisen diese in KI-Systeme ein. Dadurch entsteht eine zusätzliche Ebene, wie KI-Systeme Informationen verstehen und darstellen.

Verfolgen Sie, wie sich Wikipedia-Zitate durch ChatGPT, Gemini, Claude und andere KI-Systeme ausbreiten. Verstehen Sie Ihren KI-Fußabdruck und optimieren Sie Ihre Wikipedia-Präsenz mit AmICited.

Erlernen Sie ethische Strategien, um Ihre Marke auf Wikipedia zitiert zu bekommen. Verstehen Sie Wikipedias Inhaltsrichtlinien, zuverlässige Quellen und wie Sie...

Erfahren Sie, wie Wikipedia als entscheidender KI-Trainingsdatensatz dient, wie sich dies auf die Modellgenauigkeit auswirkt, welche Lizenzvereinbarungen besteh...

Entdecken Sie, wie Wikipedia KI-Zitate in ChatGPT, Perplexity und Google AI beeinflusst. Erfahren Sie, warum Wikipedia die vertrauenswürdigste Quelle für KI-Tra...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.