Die Auswirkungen von Prompts auf KI-Antworten verstehen

Benutzer-Prompts sind der primäre Mechanismus, über den Menschen mit künstlichen Intelligenzsystemen kommunizieren, und ihre Qualität bestimmt direkt die Nützlichkeit und Genauigkeit von KI-generierten Antworten. Wenn Sie mit KI-Systemen wie ChatGPT, Perplexity oder anderen Sprachmodellen interagieren, bestimmt die Art und Weise, wie Sie Ihre Frage formulieren, grundlegend, was die KI über Ihre Absicht versteht und welche Art von Antwort sie generiert. Die Beziehung zwischen Prompt- und Antwortqualität ist kein Zufall – sie ist ein direktes Ursache-Wirkungs-Verhältnis, das in der KI-Forschung ausführlich untersucht wurde. Diese Beziehung zu verstehen, ist für jeden, der KI effektiv nutzen möchte – sei es für Geschäftsprozesse, Content-Erstellung oder Informationsbeschaffung – unerlässlich.

Die Auswirkungen von Prompts gehen über die bloße Wortwahl hinaus. Klarheit, Spezifität, Kontext und Tonfall arbeiten zusammen, um das KI-Modell zu lenken und Antworten zu erzeugen, die Ihren tatsächlichen Bedürfnissen entsprechen. Ein vager Prompt liefert möglicherweise generische, oberflächliche Antworten, denen es an Tiefe oder Relevanz fehlt. Ein gut formulierter Prompt mit klaren Anweisungen und angemessenem Kontext hingegen kann tiefere Einblicke und gezieltere Informationen freisetzen. Dieses Prinzip gilt für alle KI-Systeme, von allgemeinen Modellen bis hin zu spezialisierten Antwortmaschinen. Die Präzision, die Sie in Ihren Prompt investieren, spiegelt sich direkt in der Präzision der Ausgabe wider, die Sie erhalten.

Wie die Klarheit des Prompts die Antwortqualität beeinflusst

Klarheit in Prompts ist grundlegend, um nützliche KI-Antworten zu erhalten. Wenn Sie mehrdeutige oder unklare Anweisungen geben, muss das KI-Modell Annahmen über Ihre Anfrage treffen, was häufig zu Fehlinterpretationen und irrelevanten Antworten führt. Das KI-System kann keine Rückfragen stellen wie ein Mensch, sondern stützt sich ausschließlich auf die Informationen in Ihrem Prompt, um Ihre Absicht zu verstehen. Das bedeutet, dass die Verringerung von Mehrdeutigkeiten in Ihrer Sprache eine der wirksamsten Methoden ist, um die Antwortqualität zu verbessern.

Vergleichen Sie beispielsweise die Anfrage “Erzähl mir etwas über Marketing” mit “Was sind drei innovative digitale Marketingstrategien für kleine Unternehmen, die auf Millennials abzielen?” Der erste Prompt ist vage und könnte zu einer allgemeinen Übersicht über Marketingprinzipien führen. Der zweite Prompt liefert spezifischen Kontext – die Zielgruppe (kleine Unternehmen), die Zielgruppe (Millennials) und das gewünschte Format (drei Strategien) – was die KI anleitet, eine fokussiertere und umsetzbare Antwort zu geben. Die zusätzliche Spezifität verbessert nicht nur die Antwort, sondern verändert grundlegend die Art dessen, was die KI generiert. Dieses Prinzip gilt unabhängig davon, ob Sie ChatGPT zum Brainstorming, Perplexity zur Recherche oder ein anderes KI-System zur Informationssuche nutzen.

| Prompt-Typ | Beispiel | Erwartete Antwortqualität |

|---|

| Vage | “Erzähl mir etwas über KI” | Generischer, breit gefasster Überblick |

| Spezifisch | “Was sind die Haupt-Herausforderungen bei der Implementierung von KI im Gesundheitswesen?” | Fokussiert, detailliert, branchenspezifisch |

| Kontextualisiert | “Für ein 50-Personen-Startup: Was sind die Top 5 KI-Tools zur Verbesserung des Kundenservice?” | Maßgeschneidert, umsetzbar, geschäftsrelevant |

| Detailliert | “Erkläre, wie Prompt Engineering die Antwortgenauigkeit von KIs verbessert, mit Beispielen” | Umfassend, gut strukturiert, beispielreich |

Ready to Monitor Your AI Visibility?

Track how AI chatbots mention your brand across ChatGPT, Perplexity, and other platforms.

Die Rolle der Spezifität im Prompt Engineering

Spezifität ist einer der stärksten Hebel, um KI-Antworten zu verbessern. Wenn Sie spezifische Details, Einschränkungen und Kontext in Ihre Prompts einbinden, schaffen Sie im Grunde Leitplanken, die die KI genau auf das fokussieren, was Sie benötigen. Vage Prompts lassen die KI zu Randthemen abschweifen oder Informationen liefern, die zwar korrekt, aber nicht relevant für Ihren Anwendungsfall sind. Spezifische Prompts hingegen schaffen ein enges Ziel, das die KI mit Präzision treffen kann.

Der Einfluss der Spezifität wird noch deutlicher, wenn Sie mit komplexen Themen arbeiten oder spezifische Geschäftsergebnisse erzielen möchten. Anstatt zu fragen “Wie kann ich meine Website verbessern?”, könnten Sie fragen: “Was sind die fünf wichtigsten Onpage-SEO-Optimierungstechniken, um das Suchranking für ein B2B SaaS-Unternehmen im Bereich Projektmanagement-Software zu verbessern?” Der zweite Prompt enthält mehrere Ebenen der Spezifität: die Geschäftsart (B2B SaaS), die Branche (Projektmanagement), das spezifische Ziel (Suchranking) und den Fokusbereich (Onpage-SEO). Jedes dieser Details hilft dem KI-Modell, seine Antwort auf für Sie tatsächlich nützliche Informationen einzugrenzen. Forschung zum Prompt Engineering zeigt, dass schon kleine Anpassungen bei der Spezifität zu deutlich anderen – und signifikant besseren – Antworten führen können.

Wie Tonfall und Stil KI-Antworten beeinflussen

Der Tonfall und Stil Ihres Prompts können die Tonalität und den Stil der KI-Antwort subtil, aber deutlich beeinflussen. Sprachmodelle sind darauf trainiert, Muster in der Sprache zu erkennen und nachzubilden – auch stilistische Muster. Verwenden Sie eine formelle Sprache, antwortet die KI meist ebenfalls formell. Nutzen Sie eine umgangssprachliche Formulierung, wird die Antwort lockerer. Das geht über reine Förmlichkeit hinaus und umfasst auch Höflichkeit, Kreativität, technische Tiefe und weitere Stil-Dimensionen.

Forschungen zeigen, dass selbst scheinbar kleine Anpassungen im Tonfall die Antwortqualität beeinflussen können. So führen Prompts mit höflicher Sprache (“Könnten Sie bitte erklären…”) meist zu qualitativ hochwertigeren Antworten als abrupte oder fordernde Prompts. Das liegt nicht daran, dass die KI beleidigt wäre, sondern daran, dass Höflichkeit oft mit Klarheit und Überlegtheit in der Fragestellung einhergeht. Wer sich Zeit für eine höfliche Formulierung nimmt, ist meist auch spezifischer und klarer in seinen Anforderungen. Zudem signalisiert der Stil Ihres Prompts der KI, welches Antwortformat Sie erwarten – ob Sie eine technische Erklärung, eine kreative Erörterung, eine Schritt-für-Schritt-Anleitung oder eine Zusammenfassung wünschen.

Stay Updated on AI Visibility Trends

Get the latest insights on AI mentions, brand monitoring, and optimization strategies.

Kontext und Hintergrundinformationen in Prompts

Das Bereitstellen von Kontext und Hintergrundinformationen in Ihren Prompts verbessert die Fähigkeit der KI, relevante und präzise Antworten zu generieren, erheblich. Kontext hilft der KI zu verstehen, was Sie fragen, warum Sie es fragen und was Sie mit der Antwort vorhaben. So kann die KI ihre Antwort auf Ihre spezifische Situation zuschneiden, anstatt allgemeine Informationen zu liefern, die möglicherweise nicht passen.

Fragen Sie beispielsweise nach Marketingstrategien, unterscheidet sich die Antwort der KI erheblich, je nachdem, ob Sie ein Startup mit 5.000 € Budget, ein etabliertes Unternehmen mit 500.000 € Budget oder eine Non-Profit-Organisation mit wenigen Ressourcen sind. Geben Sie diesen Kontext von Anfang an an, kann die KI Ratschläge liefern, die tatsächlich auf Ihre Situation zutreffen. Ebenso hilft es bei technischen Fragen, wenn Sie Informationen zu Ihrer aktuellen Technologielandschaft, Teamgröße und Zeitrahmen liefern – so kann die KI Empfehlungen geben, die zu Ihren Gegebenheiten passen. Kontext verwandelt generische Ratschläge in personalisierte Empfehlungen, weshalb erfahrene KI-Nutzer immer Zeit investieren, relevante Hintergrundinfos in ihre Prompts einzubringen.

Iterative Verbesserung und Testen von Prompts

Die effektivste Methode, mit KI zu arbeiten, ist, Prompt-Entwicklung als iterativen Prozess statt als einmalige Interaktion zu betrachten. Sie beginnen mit einem ersten Prompt, bewerten die Antwort, identifizieren, was funktioniert hat und was nicht, und verfeinern dann Ihren Prompt anhand dieser Einsichten. Durch dieses iterative Vorgehen können Sie die Antwortqualität desselben KI-Systems schrittweise verbessern. Mit jeder Iteration kommen Sie dem optimalen Prompt für Ihren Anwendungsfall näher.

Der Prozess der iterativen Verbesserung umfasst mehrere Schritte: Erst erstellen Sie einen Anfangsprompt auf Grundlage Ihres besten Verständnisses. Dann analysieren Sie die Antwort, um Muster zu erkennen – hat die KI Ihre Absicht richtig verstanden? Hat sie das gewünschte Detailniveau geliefert? Hat sie die richtigen Aspekte des Themas fokussiert? Anschließend passen Sie Ihren Prompt basierend auf diesen Beobachtungen an: Sie fügen Spezifität hinzu, liefern mehr Kontext, ändern den Tonfall oder formulieren die Frage ganz neu. Danach testen Sie den überarbeiteten Prompt und bewerten die neue Antwort. Dieser Zyklus wiederholt sich, bis die Antworten Ihren Ansprüchen genügen. Organisationen und Einzelpersonen, die diesen iterativen Ansatz beherrschen, erzielen durchweg bessere Ergebnisse mit KI-Systemen als jene, die jeden Prompt als einzelne Interaktion betrachten.

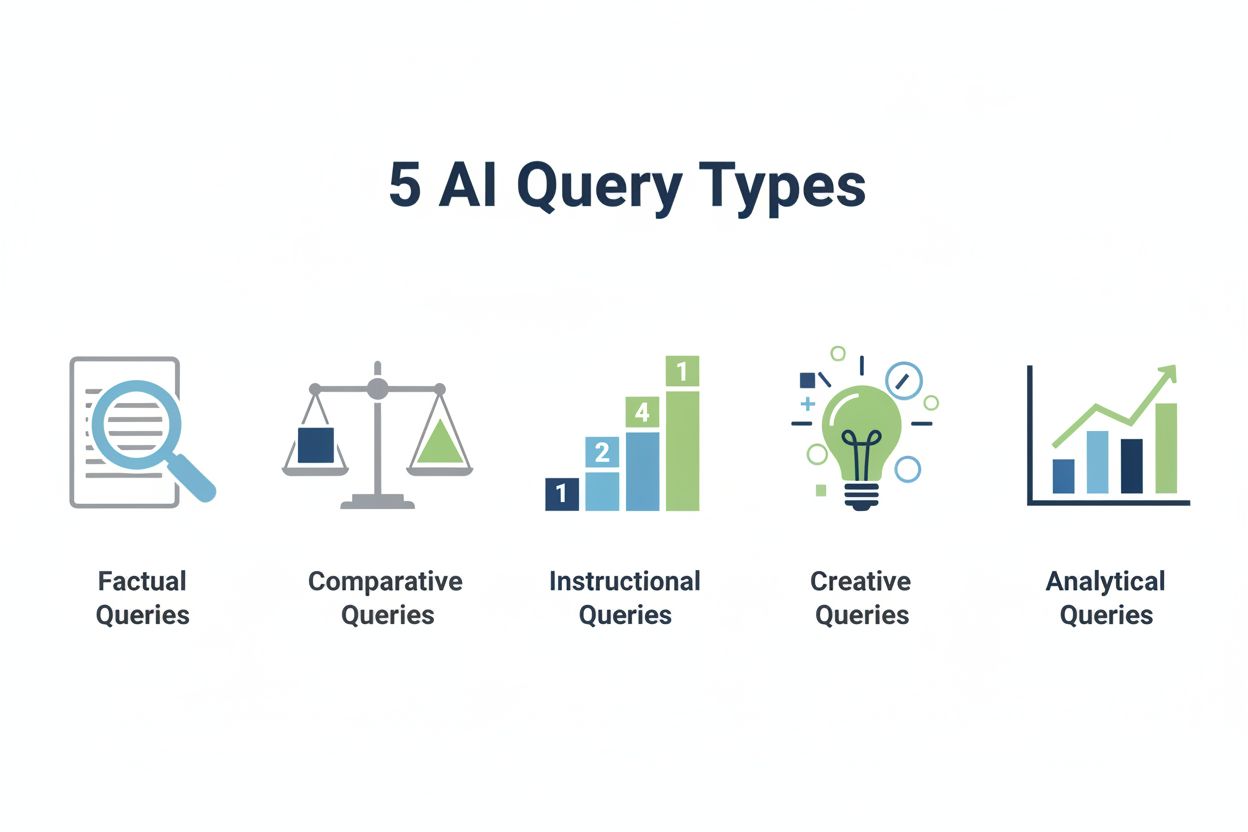

Verschiedene Prompt-Typen und ihre Effekte

Verschiedene Prompt-Typen sind darauf ausgelegt, unterschiedliche Ergebnisse zu erzielen. Es ist entscheidend zu wissen, welchen Typ Sie für Ihren speziellen Bedarf nutzen. Zero-Shot-Prompts fordern die KI auf, eine Aufgabe ohne Beispiele auszuführen, und verlassen sich dabei ganz auf das vortrainierte Wissen. Few-Shot-Prompts liefern ein oder mehrere Beispiele des gewünschten Ausgabeformats oder Ansatzes, damit die KI das gewünschte Muster erkennt. Chain-of-Thought-Prompts fordern die KI ausdrücklich auf, ihre Überlegungen Schritt für Schritt darzulegen – das ist besonders für komplexe Problemlösungen hilfreich. Meta-Prompts bitten die KI, über ihre eigenen Überlegungen oder Fähigkeiten zu reflektieren, was ihr helfen kann, ihre Vorgehensweise zu verbessern.

Jeder dieser Prompt-Typen erzeugt unterschiedliche Arten von Antworten. Ein Zero-Shot-Prompt ist geeignet, wenn Sie die KI etwa einen Satz übersetzen oder eine einfache Faktfrage beantworten lassen möchten. Ein Few-Shot-Prompt ist sinnvoll, wenn Sie möchten, dass die KI ein bestimmtes Format einhält – etwa, wenn Sie wollen, dass sie JIRA-Tickets in einer bestimmten Struktur generiert und dafür gut formatierte Beispiele angeben. Ein Chain-of-Thought-Prompt ist unerlässlich, wenn die KI ein komplexes mathematisches Problem lösen oder eine nuancierte Entscheidung treffen soll, bei der der Lösungsweg ebenso wichtig ist wie das Ergebnis. Die Auswahl des passenden Prompt-Typs für Ihre Aufgabe kann sowohl Qualität als auch Nützlichkeit der KI-Antwort deutlich steigern. Viele fortgeschrittene Nutzer kombinieren verschiedene Prompt-Typen in einem Prompt – zum Beispiel, indem sie Beispiele (Few-Shot), Schritt-für-Schritt-Erklärung (Chain-of-Thought) und Reflexion über die Vorgehensweise (Meta-Prompt) anfordern – um optimale Ergebnisse zu erzielen.

Praktische Beispiele für Prompt-Anpassungen

Praxisbeispiele zeigen, wie kleine Anpassungen am Prompt zu erheblichen Verbesserungen der KI-Antwortqualität führen können. Ein Unternehmer fragt etwa nach Marketingstrategien. Der erste, vage Prompt könnte lauten: “Erzähl mir etwas über Marketing.” Die KI antwortet wahrscheinlich mit einem allgemeinen Überblick über Marketing-Prinzipien, -Kanäle und -Taktiken. Diese Antwort ist zwar korrekt, aber wenig hilfreich, da sie die konkrete Situation nicht adressiert.

Eine verfeinerte Version könnte lauten: “Was sind die kosteneffektivsten digitalen Marketingstrategien für ein gebootstrapptes E-Commerce-Startup, das nachhaltige Modeprodukte an umweltbewusste Konsumenten im Alter von 25 bis 40 Jahren verkauft?” Hier liefert der Prompt spezifische Einschränkungen (gebootstrapped, kosteneffektiv), ein spezifisches Geschäftsmodell (E-Commerce), eine spezifische Produktkategorie (nachhaltige Mode) und eine spezifische Zielgruppe (umweltbewusst, 25-40 Jahre alt). Die KI-Antwort wird völlig anders ausfallen – sie fokussiert sich auf tatsächlich bezahlbare Strategien, die zu den Werten der Zielgruppe passen und für die Produktkategorie geeignet sind. Der Unterschied in der Nützlichkeit zwischen diesen beiden Antworten ist enorm – und dabei wurde lediglich der Prompt spezifischer und kontextbezogener gestaltet.

Ein weiteres Beispiel betrifft technische Fragen. Anstatt “Wie optimiere ich meine Website?” zu fragen, könnten Sie formulieren: “Was sind die fünf wichtigsten technischen SEO-Verbesserungen, die ich für einen WordPress-basierten Blog umsetzen sollte, der aktuell auf Seite 2 für meine Ziel-Keywords rankt, wobei ich grundlegende HTML-Kenntnisse habe, aber keinen Entwickler im Team?” Dieser verfeinerte Prompt liefert Informationen zur Plattform (WordPress), zur aktuellen Performance (Seite-2-Rankings), zur Zielgruppe (jemand mit Grundkenntnissen in HTML) und zu den Einschränkungen (kein Entwickler verfügbar). Die KI kann so Empfehlungen liefern, die tatsächlich für die fragende Person umsetzbar sind, statt allgemeiner Tipps, die einen Entwickler erfordern würden.

Konsistenz und Zuverlässigkeit bei KI-Antworten

Auch wenn die Prompt-Qualität die Antwortqualität maßgeblich beeinflusst, ist es wichtig zu verstehen, dass selbst perfekt formulierte Prompts nicht jedes Mal identische Antworten garantieren. Sprachmodelle arbeiten probabilistisch – das heißt, der gleiche Prompt kann zu leicht unterschiedlichen Antworten führen. Diese Variabilität ist ein Feature und kein Fehler, denn sie ermöglicht kreative und vielfältige Antworten. Wenn Sie jedoch konsistente, verlässliche Ausgaben benötigen – etwa in integrierten Systemen oder automatisierten Workflows – wird diese Variabilität zur Überlegung.

Um mehr Konsistenz zu erreichen, können Sie in vielen KI-Systemen die Temperatureinstellung anpassen (niedrigere Werte liefern konsistentere, fokussiertere Antworten), sehr spezifische Formatierungsanweisungen geben oder Few-Shot-Prompts mit Beispielen des gewünschten Formats nutzen. Das Ziel ist, Prompts so zu gestalten, dass wiederholbare Ausgaben mit minimaler Variation entstehen, ohne Qualität und Relevanz zu verlieren. Dieses Gleichgewicht zwischen Konsistenz und Qualität ist besonders für Unternehmen wichtig, die KI in ihren Betrieb integrieren und auf verlässliche, vorhersehbare Leistung angewiesen sind.

Grenzen und Überlegungen

Die Grenzen des Prompt Engineerings zu verstehen, ist ebenso wichtig wie dessen Möglichkeiten zu kennen. Selbst der bestmögliche Prompt kann fundamentale Beschränkungen der Trainingsdaten oder Fähigkeiten eines KI-Modells nicht überwinden. Wurde ein Modell mit Daten trainiert, in denen bestimmte Informationen fehlen, wird auch der beste Prompt keine korrekten Antworten zu diesem Thema liefern können. Ebenso kann ein Prompt keine Aufgaben ermöglichen, die grundsätzlich außerhalb der Modellfähigkeiten liegen.

Außerdem gilt: KI-Modelle können mitunter sehr überzeugend falsche Informationen liefern – ein Phänomen, das als “Halluzination” bezeichnet wird. Ein gut formulierter Prompt kann das Risiko solcher Halluzinationen reduzieren, aber nicht ganz beseitigen. Deshalb ist es wichtig, kritische Informationen aus KI-Antworten zu überprüfen – insbesondere, wenn diese für wichtige Entscheidungen genutzt werden. Manche Prompts funktionieren nur, weil ähnliche Beispiele in den Trainingsdaten des Modells enthalten waren – nicht, weil das Modell die zugrundeliegenden Konzepte tatsächlich versteht. Wer sich dieser Grenzen bewusst ist, kann KI effektiver einsetzen und vermeidet, sich bei kritischen Aufgaben zu sehr auf KI-Ausgaben zu verlassen.