Verständnis der Faktoren der KI-Indexierungsgeschwindigkeit

Die KI-Indexierungsgeschwindigkeit bestimmt, wie schnell Ihre Inhalte in KI-gestützten Suchmaschinen wie ChatGPT, Perplexity und den KI-Overviews von Google auffindbar werden. Im Gegensatz zu herkömmlichen Suchmaschinen, die einfach Schlüsselwörter mit Seiten abgleichen, müssen KI-Systeme Ihre Inhalte crawlen, verstehen und synthetisieren, um genaue Antworten zu generieren. Die Geschwindigkeit, mit der dies geschieht, hängt von zahlreichen miteinander verknüpften Faktoren ab, die Ihre Sichtbarkeit in KI-generierten Antworten und Ihre Fähigkeit, Traffic von KI-Suchplattformen zu gewinnen, direkt beeinflussen.

Website-Leistung und Seitenladegeschwindigkeit

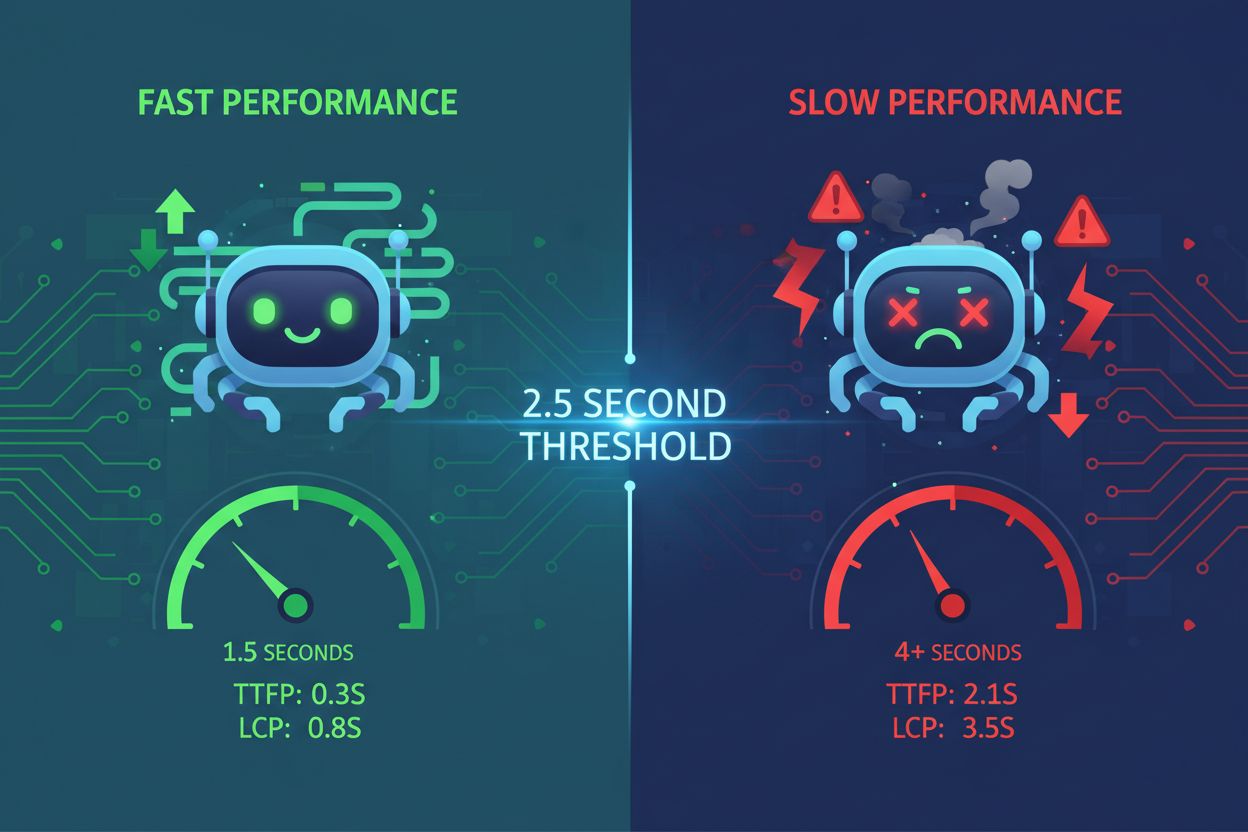

Die Seitenladegeschwindigkeit ist einer der entscheidendsten Faktoren für die KI-Indexierungsgeschwindigkeit. KI-Crawler arbeiten mit strikten Ressourcenbeschränkungen und Zeitlimits—typischerweise zwischen 1-5 Sekunden pro Seitenanfrage. Wenn Ihre Website langsam lädt, benötigen die Crawler mehr Zeit, um Inhalte abzurufen, was bedeutet, dass innerhalb des zugewiesenen Crawl-Zeitfensters weniger Seiten indexiert werden. Dies führt zu einem Kaskadeneffekt, bei dem eine langsame Leistung die Anzahl der von KI-Systemen verarbeiteten und indexierten Seiten direkt reduziert.

Langsam ladende Seiten signalisieren KI-Systemen mangelhafte Wartung. Wenn Seiten zu lange zum Rendern benötigen, laufen KI-Crawler möglicherweise ab, bevor sie auf Ihre tatsächlichen Inhalte zugreifen können, sodass nur das HTML-Grundgerüst indexiert wird. Dies ist besonders problematisch bei JavaScript-lastigen Websites, deren Inhalte dynamisch auf der Clientseite geladen werden. Der für JavaScript erforderliche zweistufige Rendering-Prozess erhöht die Latenz erheblich und erschwert es KI-Systemen, sinnvolle Informationen zu extrahieren. Die Komprimierung von Bildern, das Minifizieren von Code, die Implementierung von Lazy Loading und die Nutzung von Content Delivery Networks (CDNs) können die Ladezeiten erheblich verbessern und KI-Crawlern ermöglichen, effizient mehr Seiten zu verarbeiten.

| Leistungskennzahl | Zielwert | Einfluss auf die KI-Indexierung |

|---|

| Seitenladezeit | Unter 3 Sekunden | Erlaubt mehr Seiten pro Sitzung zu crawlen |

| Largest Contentful Paint (LCP) | Unter 2,5 Sekunden | Stellt sicher, dass KI schnell relevante Inhalte sieht |

| First Input Delay (FID) | Unter 100ms | Verbessert die Reaktionsfähigkeit des Crawlers |

| Cumulative Layout Shift (CLS) | Nah bei Null | Verhindert Fehler bei der Inhaltsauslese |

Ready to Monitor Your AI Visibility?

Track how AI chatbots mention your brand across ChatGPT, Perplexity, and other platforms.

Crawl-Budget-Beschränkungen

Das Crawl-Budget bezeichnet die begrenzte Anzahl an Seiten, die KI-Systeme innerhalb eines bestimmten Zeitraums besuchen können. Jede Website erhält von KI-Suchmaschinen ein begrenztes Crawl-Kontingent, ähnlich wie Google das Crawl-Budget zuteilt. Ist das Crawl-Budget aufgebraucht, hören KI-Systeme auf, neue Inhalte zu indexieren – unabhängig von deren Qualität. Diese Begrenzung ist besonders problematisch für große Websites mit Hunderten oder Tausenden von Seiten, die um limitierte Indexierungsressourcen konkurrieren.

Die Optimierung der Crawl-Budget-Zuteilung ist entscheidend für eine schnellere KI-Indexierung. Sie sollten hochwertige Seiten – solche, die Umsatz generieren, Traffic anziehen oder wichtige Informationen enthalten – gegenüber weniger wertvollen Seiten wie doppelten Kategoriefiltern oder redundanten Tag-Seiten priorisieren. Mit einer gezielten robots.txt-Konfiguration können Sie KI-Crawler den Zugriff auf Seiten verwehren, die nicht indexiert werden müssen, und so das Crawl-Budget für relevante Inhalte reservieren. Zudem helfen eine aktuelle XML-Sitemap und eine saubere interne Verlinkungsstruktur den KI-Systemen, Ihre wichtigsten Seiten schneller zu finden, sodass diese vor dem Ablauf des Crawl-Budgets indexiert werden.

Inhaltsqualität und Originalität

KI-Systeme bestrafen doppelte und dünne Inhalte stark, was die Indexierung erheblich verlangsamt. Wenn KI-Crawler auf Inhalte stoßen, denen es an Originalität oder Substanz mangelt, priorisieren sie das Crawlen ähnlicher Seiten auf Ihrer Website herab. Das liegt daran, dass KI-Systeme die Inhaltsqualität anhand von E-E-A-T-Signalen (Experience, Expertise, Authoritativeness, Trustworthiness) bewerten. Inhalte, die wenig Aufwand erkennen lassen, rein KI-generiert und nicht menschlich überprüft sind oder von anderen Quellen kopiert wurden, erhalten in der Indexierung geringere Priorität.

Hochwertige, umfassende Inhalte werden von KI-Systemen schneller indexiert. Inhalte mit über 3.000 Wörtern, die Nutzerfragen aus mehreren Perspektiven ausführlich beantworten, erhalten Priorität bei der Indexierung. KI-Systeme bevorzugen Inhalte, die unterstützende Daten, Statistiken, Praxisbeispiele und Fallstudien enthalten, da diese Elemente Fachwissen und Vertrauenswürdigkeit belegen. Wenn Sie originelle, gut recherchierte Inhalte mit echtem Mehrwert erstellen, stellen KI-Crawler mehr Ressourcen für die Indexierung Ihrer Seiten bereit, was zu einer schnelleren Auffindbarkeit und Aufnahme in KI-generierte Antworten führt.

Stay Updated on AI Visibility Trends

Get the latest insights on AI mentions, brand monitoring, and optimization strategies.

Technische SEO-Konfiguration

Eine fehlerhafte robots.txt-Konfiguration kann KI-Crawler versehentlich an der Indexierung Ihrer Inhalte hindern. Viele Websites verhindern unbeabsichtigt den Zugriff von KI-Suchbots auf ihre Seiten durch falsch konfigurierte robots.txt-Dateien. Verschiedene KI-Systeme verwenden unterschiedliche Crawler-Identifikatoren—ChatGPT nutzt OAI-SearchBot, Perplexity verwendet PerplexityBot, andere AndiBot oder ExaBot. Wenn Ihre robots.txt diese Crawler nicht explizit erlaubt, können sie Ihre Inhalte nicht indexieren, unabhängig von deren Qualität oder Relevanz.

Saubere HTML-Struktur und semantisches Markup beschleunigen die KI-Indexierung. KI-Crawler haben Schwierigkeiten mit JavaScript-lastigen Implementierungen und komplexen verschachtelten Strukturen. Die Verwendung semantischer HTML5-Tags (article, section, nav), korrekter Überschriftenhierarchien (H1-H6), beschreibender Linktexte und Alt-Texte für Bilder macht Ihre Inhalte für KI-Systeme sofort zugänglich. Server-Side-Rendering-(SSR-) Frameworks wie Next.js oder Gatsby prärendern Inhalte auf dem Server, sodass KI-Crawler vollständig aufgebaute Seiten erhalten, ohne dass JavaScript ausgeführt werden muss – was die Indexierung erheblich beschleunigt.

Datenbank-Indexierung und Infrastruktur

Übermäßige Indexierung in Ihrer Datenbank erzeugt Latenzen, die die KI-Indexierungsgeschwindigkeit verlangsamen. Wenn Datenbanken zu viele, redundante oder überschneidende Indizes enthalten, muss bei jedem Einfügen, Aktualisieren und Löschen jeder Index mitgeführt werden, was zu Performance-Engpässen beim Schreiben führt. Dieser Overhead wirkt sich direkt darauf aus, wie schnell Ihr Content-Management-System Seiten an KI-Crawler ausliefern kann. Redundante Indizes verbrauchen Speicherplatz, erhöhen die Latenz und zwingen Abfrageplaner zu suboptimalen Entscheidungen – all das verlangsamt die Auslieferung von Inhalten an KI-Systeme.

Die Optimierung von Datenbank-Indizes verbessert die Auslieferungsgeschwindigkeit von Inhalten an KI-Crawler. Überprüfen Sie regelmäßig Ihre Datenbank, um ungenutzte oder redundante Indizes mit Tools wie pg_stat_user_indexes (PostgreSQL) oder sys.schema_unused_indexes (MySQL) zu identifizieren. Entfernen Sie Indizes, die wochen- oder monatelang nicht genutzt wurden, konsolidieren Sie sich überschneidende Indizes und stellen Sie sicher, dass Ihr Datenbankschema den aktuellen Abfragemustern entspricht. Eine gut optimierte Datenbank liefert Inhalte schneller an KI-Crawler, wodurch eine schnellere Indexierung und Aufnahme in KI-generierte Antworten ermöglicht wird.

Schema-Markup-Implementierung

Fehlendes oder unvollständiges Schema-Markup verzögert das Verständnis und die Indexierung von Inhalten durch KI. Schema-Markup liefert strukturierte Daten, die KI-Systemen helfen, den Kontext, die Bedeutung und die Beziehungen Ihrer Inhalte schnell zu verstehen. Ohne korrektes Schema-Markup müssen KI-Crawler zusätzliche Verarbeitungszeit aufwenden, um die Inhaltsstruktur zu erschließen und Schlüsselinformationen zu extrahieren. Diese zusätzliche Verarbeitungszeit reduziert die Indexierungsgeschwindigkeit, da pro Seite mehr Ressourcen benötigt werden.

Die Implementierung umfassenden Schema-Markups beschleunigt die KI-Indexierung. FAQ-Schema, How-To-Schema, Artikel-Schema und Produkt-Schema liefern KI-Systemen vorstrukturierte Informationen, die sofort verstanden und indexiert werden können. Wenn Sie Autoreninformationen, Veröffentlichungsdaten, Bewertungen und andere strukturierte Daten einbinden, können KI-Systeme Ihre Inhalte schnell kategorisieren und indexieren, ohne zusätzliche Verarbeitung. Studien zeigen, dass 36,6 % der Suchanfragen Featured Snippets aus Schema-Markup auslösen – ein Beweis dafür, wie strukturierten Daten die KI-Sichtbarkeit und Indexierungsgeschwindigkeit direkt beeinflussen.

Interne Verlinkungsstruktur

Schwache interne Verlinkung verhindert, dass KI-Crawler Ihre Inhalte effizient entdecken. Interne Links dienen als Wegweiser, die KI-Crawler durch Ihre Website-Architektur führen. Ohne strategische interne Verlinkung könnten KI-Systeme Schwierigkeiten haben, wichtige Seiten zu finden – insbesondere neue Inhalte, die tief in Ihrer Seitenstruktur verborgen sind. Diese Verzögerung bei der Entdeckung führt direkt zu einer langsameren Indexierung, da Crawler mehr Zeit für das Auffinden von Seiten aufwenden müssen.

Strategische interne Verlinkung beschleunigt die Entdeckung und Indexierung von KI-Inhalten. Die Verlinkung neuer Inhalte von relevanten, bestehenden Seiten aus hilft KI-Crawlern, diese schneller zu finden und zu indexieren. Die Verwendung beschreibender Ankertexte, die klar anzeigen, was die verlinkte Seite enthält, erleichtert KI-Systemen das Verständnis von Inhaltsbeziehungen und Kontext. Eine saubere interne Verlinkungsstruktur stellt sicher, dass hochwertige Seiten mehr Aufmerksamkeit beim Crawlen erhalten, was zu einer schnelleren Indexierung und höheren Priorität in KI-generierten Antworten führt.

Nutzererlebnis und Inhaltszugänglichkeit

Schlechtes Nutzererlebnis signalisiert KI-Systemen, dass Ihre Inhalte möglicherweise nicht wertvoll sind. Hohe Absprungraten, kurze Sitzungsdauern und niedrige Engagement-Metriken zeigen KI-Crawlern, dass Ihre Inhalte die Bedürfnisse der Nutzer nicht erfüllen. KI-Systeme nutzen zunehmend Verhaltenssignale zur Bewertung der Inhaltsqualität, und Seiten mit schlechtem UX erhalten eine geringere Priorität bei der Indexierung. Wenn Nutzer Ihre Seiten schnell verlassen, interpretieren KI-Systeme dies als Hinweis auf mangelnden Mehrwert, was die Aufnahme in KI-generierte Antworten verlangsamt.

Eine leserfreundliche Inhaltsstruktur verbessert die KI-Indexierungsgeschwindigkeit. Inhalte, die mit kurzen Absätzen (2-3 Sätze), beschreibenden Zwischenüberschriften, Aufzählungen, nummerierten Listen und Tabellen formatiert sind, lassen sich sowohl von Nutzern als auch von KI-Systemen leichter verarbeiten. Diese bessere Scanbarkeit ermöglicht es KI-Crawlern, Schlüsselinformationen schnell zu extrahieren und die Inhaltsstruktur ohne aufwändige Verarbeitung zu erfassen. Wenn Ihre Inhalte gut organisiert und zugänglich sind, können KI-Systeme sie schneller und mit höherem Vertrauen in Qualität und Relevanz indexieren.

Hosting-Infrastruktur und Serverantwortzeit

Langsame Hosting-Infrastruktur erzeugt Engpässe, die die KI-Indexierung verzögern. Shared-Hosting-Umgebungen verfügen oft über begrenzte Ressourcen und langsamere Antwortzeiten, was dazu führt, dass KI-Crawler länger auf das Laden jeder Seite warten müssen. Diese Wartezeit verringert die Anzahl der Seiten, die innerhalb des zugewiesenen Crawl-Zeitfensters indexiert werden können. Die Serverantwortzeit wirkt sich direkt auf die Crawling-Effizienz aus—jede Millisekunde Verzögerung reduziert die insgesamt pro Sitzung indexierten Seiten.

Ein Upgrade auf schnelles, skalierbares Hosting beschleunigt die KI-Indexierung. Managed-WordPress-Hosts, VPS-Lösungen und Cloud-Plattformen wie Google Cloud oder AWS bieten schnellere Serverantwortzeiten und bessere Ressourcenzuteilung. CDNs wie Cloudflare cachen Inhalte weltweit und liefern Seiten schneller an Crawler, unabhängig von deren geografischem Standort. Wenn Ihre Hosting-Infrastruktur Seiten schnell ausliefert, können KI-Crawler pro Sitzung mehr Inhalte verarbeiten, was zu einer insgesamt schnelleren Indexierung und besserer Sichtbarkeit in KI-generierten Antworten führt.

Überwachung und Optimierung

Die kontinuierliche Überwachung der KI-Indexierungsleistung ermöglicht proaktive Optimierung. Tools wie die Google Search Console, SE Ranking’s AI Results Tracker und Peec.ai helfen Ihnen, zu verfolgen, wie schnell Ihre Inhalte in KI-Suchergebnissen erscheinen und welche Seiten nicht indexiert werden. Durch die Überwachung dieser Kennzahlen können Sie Engpässe identifizieren und gezielte Verbesserungen vornehmen, die die Indexierungsgeschwindigkeit direkt beeinflussen.

Regelmäßige Audits und Aktualisierungen erhalten eine optimale KI-Indexierungsgeschwindigkeit. Führen Sie regelmäßige Performance-Audits mit Tools wie Google PageSpeed Insights, GTmetrix und WebPageTest durch, um Geschwindigkeitshindernisse zu erkennen. Aktualisieren Sie Ihre XML-Sitemap regelmäßig, erneuern Sie Inhalte für Frischesignale und optimieren Sie kontinuierlich Ihre Datenbank und Infrastruktur. Konsequente Optimierung stellt sicher, dass Ihre KI-Indexierungsgeschwindigkeit wettbewerbsfähig bleibt und Ihre Inhalte weiterhin schnell in KI-generierten Antworten erscheinen.