Paginierung

Paginierung teilt große Inhaltssammlungen in handhabbare Seiten auf, um UX und SEO zu verbessern. Erfahren Sie, wie Paginierung funktioniert, welche Auswirkunge...

Erfahren Sie, wie sich Paginierung auf die Sichtbarkeit in der KI auswirkt. Lernen Sie, warum die klassische Seiteneinteilung KI-Systemen hilft, Ihre Inhalte zu finden, während Infinite Scroll sie verbirgt, und wie Sie die Paginierung für KI-Antwortgeneratoren optimieren.

Paginierung ist die Praxis, große Inhaltsmengen in mehrere verlinkte Seiten zu unterteilen. Ja, sie beeinflusst KI-Systeme erheblich—Paginierung erzeugt eindeutige, durchsuchbare URLs, die KI-Suchmaschinen wie ChatGPT, Perplexity und Googles SGE dabei helfen, Ihre Inhalte effektiver zu entdecken und zu indexieren, während Infinite-Scroll-Implementierungen Inhalte häufig vor KI-Crawlern verbergen.

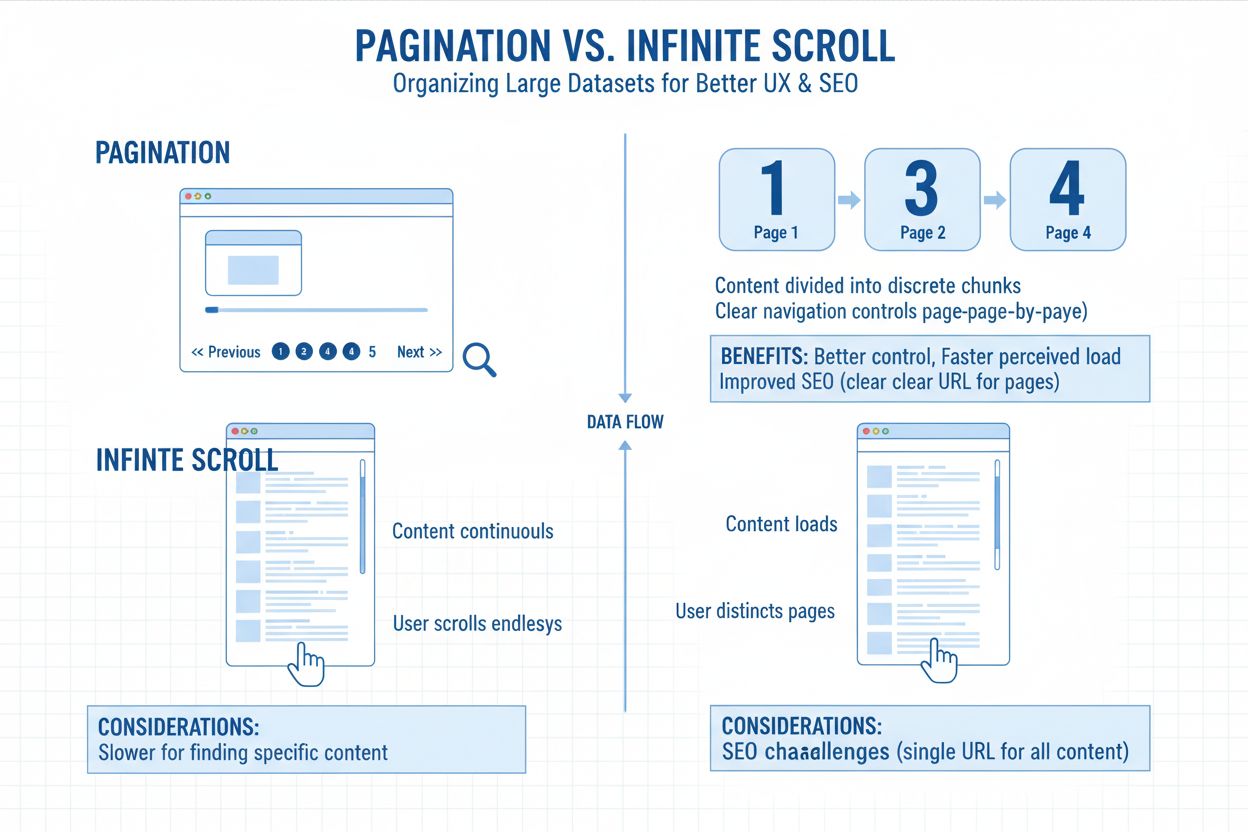

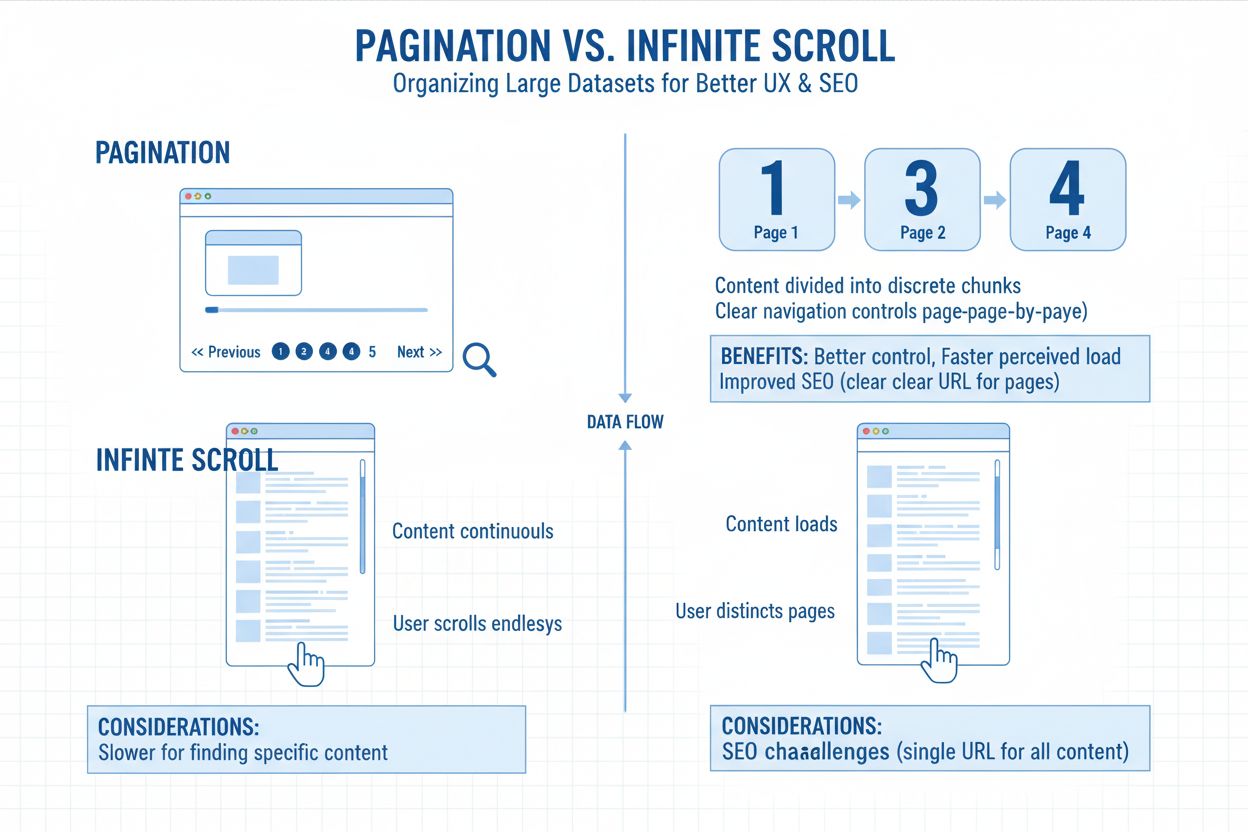

Paginierung bezeichnet die Praxis, große Inhaltsmengen in mehrere verlinkte Seiten zu unterteilen, anstatt alles auf einem einzigen endlosen Bildschirm anzuzeigen. Stellen Sie sich das wie Kapitel in einem Buch vor—jede Seite enthält einen überschaubaren Teil des Gesamtinhalts, der durch nummerierte Links oder „Weiter/Zurück“-Buttons verbunden ist. Dieser strukturelle Ansatz findet sich überall, von Produktlisten in Online-Shops bis hin zu Blog-Archiven, Forenthreads und Suchergebnissen. Die URL-Struktur spiegelt diese Aufteilung in der Regel durch Parameter wie ?page=2 oder saubere Pfade wie /kategorie/page/2/ wider, sodass sowohl Nutzer als auch Suchmaschinen ihre Position innerhalb der Inhaltsreihe verstehen können. Paginierung dient als grundlegendes Organisationswerkzeug, das Benutzerfreundlichkeit und technische Anforderungen an die Zugänglichkeit von Inhalten in Einklang bringt.

Websites setzen Paginierung in erster Linie zur Leistungsoptimierung und Inhaltsorganisation ein. Das gleichzeitige Laden von Hunderten oder Tausenden von Elementen würde Serverressourcen belasten und zu langsamen Ladezeiten führen, was sich besonders negativ auf Leistungskennzahlen auswirkt, die das Suchmaschinenranking beeinflussen. Nutzer schätzen die Möglichkeit, bestimmte Seiten zu speichern, direkt zu Seite 10 zu springen oder zu erkennen, wie viel Inhalt noch verfügbar ist. Aus technischer Sicht erzeugt die Aufteilung in Seiten eindeutige URLs, die Suchmaschinen einzeln indexieren können, wodurch die Verteilung des Link-Equity über die gesamte Seitenarchitektur erhalten bleibt. Diese strukturelle Klarheit gewinnt an Bedeutung, da sich KI-Systeme weiterentwickeln, um Inhaltsbeziehungen und Zugänglichkeitsmuster besser zu verstehen.

Die Beziehung zwischen Paginierung und KI-Sichtbarkeit ist eine der wichtigsten technischen SEO-Herausforderungen im modernen Suchumfeld. Klassische Suchmaschinen wie Google haben Paginierung seit langem verstanden, indem sie Links crawlen und aufeinanderfolgende Seitenmuster verfolgen. KI-gestützte Suchmaschinen und Antwortgeneratoren funktionieren jedoch grundlegend anders und erfordern einen nuancierteren Ansatz zur Inhaltsorganisation. Große Sprachmodelle wie die, die ChatGPT, Perplexity und Googles Search Generative Experience (SGE) antreiben, crawlen Seiten nicht unbedingt linear oder folgen traditionellen Navigationshierarchien. Stattdessen arbeiten sie, indem sie Texteingaben tokenisieren und zusammenfassen—oft aus öffentlichen Daten, APIs oder strukturierten Datenbanken, nicht aus Crawl-Tiefen-Hierarchien.

Wenn Ihre Inhalte auf mehrere, nur minimal strukturierte Seiten verteilt sind, können KI-Engines tiefere Einträge überspringen oder deren Zusammenhang zum Gesamtinhalt falsch interpretieren. Wenn Metadaten oder semantische Signale kaum variieren, erscheinen Ihre paginierten Inhalte redundant—oder werden ganz übergangen. Das führt zu einer entscheidenden Sichtbarkeitslücke: Inhalte, die im klassischen Google-Suchergebnis gut ranken, können bei KI-Antwortgeneratoren komplett unsichtbar bleiben. Das ist relevant, weil KI-Systeme strukturierte, vollständige und einfach auffindbare Daten bevorzugen. Sie „scrollen“ nicht wie ein Nutzer. Sie parsen Code, URLs und Metadaten, um Inhalte schnell und präzise zusammenzufassen oder zu zitieren. Wenn Ihre Seite Inhalte nicht über crawlbare URLs oder reichhaltige Metadaten bereitstellt, können KI-Engines sie nicht für generierte Antworten verwenden.

Die Wahl zwischen klassischer Paginierung und Infinite Scroll ist zu einem entscheidenden Faktor für die Auffindbarkeit von Inhalten durch KI geworden. Infinite-Scroll-Implementierungen laden Inhalte per JavaScript erst nach Nutzerinteraktion, was für KI-Crawler ein grundsätzliches Zugänglichkeitsproblem darstellt. Die meisten Infinite-Scroll-Setups geben Inhalte nicht über eigene URLs frei—stattdessen wird alles auf einer Seite durch dynamische JavaScript-Ausführung geladen. Das bedeutet, dass KI-Crawler, die kein echtes Nutzerverhalten wie Scrollen oder Klicken simulieren, meist alles außer der ersten Ansicht verpassen. Wenn Ihre Seite diese zusätzlichen Inhalte nicht über crawlbare URLs oder Metadaten bereitstellt, können KI-Engines sie nicht erfassen. Sie haben vielleicht 200 Artikel, 300 Produkte oder Dutzende von Fallstudien, aber wenn sie hinter per JavaScript ausgelösten Ladeereignissen versteckt sind, sieht die KI vielleicht nur 12 Elemente. Wenn überhaupt.

Klassische Paginierung gewinnt nach wie vor klar bei der KI-Indexierung, weil sie saubere, crawlbare URLs (z. B. /blog/page/4) erzeugt, sodass Engines Ihre Inhalte vollständig erfassen und segmentieren können. Sie signalisiert thematische Struktur durch interne Verlinkung und verwendet standardisierte Links wie „Nächste Seite“ oder „Vorherige Seite“, um Engines den Zusammenhang der Inhalte aufzuzeigen. Paginierung verringert die Abhängigkeit von JavaScript und stellt sicher, dass Ihre Inhalte für Crawler unabhängig davon geladen werden, wie ein Nutzer mit der Seite interagiert. Diese strukturelle Klarheit führt direkt zu besserer KI-Sichtbarkeit—wenn ChatGPT oder Perplexity Ihre Seite crawlt, können sie paginierte Inhalte weit effektiver entdecken und indexieren als Inhalte, die hinter Infinite-Scroll-Implementierungen verborgen sind.

| Aspekt | Paginierung | Infinite Scroll |

|---|---|---|

| Crawl-Zugänglichkeit | Eindeutige URLs ermöglichen tiefes Indexieren | Inhalte meist hinter JS-Ladevorgängen verborgen |

| KI-Auffindbarkeit | Mehrere Seiten können unabhängig ranken | Typischerweise nur eine Seite indexiert |

| Strukturierte Daten | Leicht einzelnen Seiten zuzuordnen | Oft fehlend oder verwässert |

| Direkte Verlinkung | Leicht auf spezifische Inhalte zu verlinken | Tiefenlinks schwer möglich |

| Sitemap-Kompatibilität | Kompatibel und vollständig | Tiefergehende Inhalte oft ausgeschlossen |

| URL-Struktur | Klare, eindeutige URLs je Seite | Einzel-URL mit dynamischem Laden |

| Inhaltssichtbarkeit | Alle Inhalte für Crawler zugänglich | Inhalte erfordern JS-Ausführung |

Die technische Architektur von Infinite Scroll schafft grundlegende Barrieren für die Inhaltsentdeckung durch KI. Wenn Inhalte ausschließlich per JavaScript geladen werden und keine URLs auf diese neuen Inhalte verweisen, sehen KI-Engines sie nie. Für einen Crawler existiert der Rest Ihrer Liste einfach nicht. Das ist keine Einschränkung der KI-Systeme—es ist eine Folge der typischen Infinite-Scroll-Umsetzung. Die meisten Infinite-Scroll-Setups stellen die Nutzererfahrung über die technische Zugänglichkeit, laden Inhalte dynamisch, ohne dazugehörige URLs oder Metadaten zu erzeugen, die KI-Systeme auslesen könnten.

Betrachten Sie ein reales Beispiel: Ein globaler Modehändler hat seine Website mit einer schicken Infinite-Scroll-Oberfläche neu gestaltet. Die Seitengeschwindigkeit stieg, die Engagement-Metriken sahen gut aus, aber der Traffic aus KI-Zusammenfassungen brach dramatisch ein. Ihre SKUs schienen in Konversationssuche-Tools zu verschwinden. Nach einer Analyse ihrer Architektur wurde das Problem klar: Ihr gesamter Katalog war hinter Infinite Scroll ohne crawlbare Alternativen verborgen. Keine sekundären Seiten-URLs. Keine ergänzende Verlinkung. Nur eine lange, unsichtbare Produktliste. Google SGE und ChatGPT konnten nichts jenseits der ersten Dutzend Produkte pro Kategorie erfassen. So schön die Seite auch aussah, ihre Auffindbarkeit war für KI-Systeme zerstört.

Eine korrekte Paginierungs-Implementierung erfordert Aufmerksamkeit für mehrere technische Faktoren, die gemeinsam bestimmen, ob KI-Systeme Ihre Inhalte entdecken und zitieren können. Die Basis sind saubere, logische URL-Strukturen, die sequentielle Beziehungen klar anzeigen. Ob Sie Query-Parameter (?page=2) oder pfadbasierte Strukturen (/page/2/) verwenden, spielt weniger eine Rolle als die Konsistenz. Beide Ansätze funktionieren für KI-Systeme gleichermaßen, wenn sie richtig umgesetzt sind. Wichtig ist, dass jede paginierte URL eigenständige Inhalte lädt und über Standard-HTML-Links erreichbar ist, die keine JavaScript-Ausführung erfordern.

Selbstreferenzierende Canonical-Tags sind ein entscheidender Punkt der Paginierungsstrategie. Jede paginierte Seite sollte einen Canonical-Tag auf sich selbst enthalten, um zu signalisieren, dass jede Seite die bevorzugte Version ihrer selbst ist. So bleibt die Eigenständigkeit sequentieller URLs erhalten, und jede kann basierend auf ihrem spezifischen Inhalt und ihrer Relevanz für verschiedene Suchanfragen um Rankings konkurrieren. Vermeiden Sie die veraltete Praxis, alle paginierten Seiten auf Seite eins zu kanonisieren—dadurch werden zwar Signale gebündelt, aber die Möglichkeit genommen, dass einzelne Seiten unabhängig in KI-Systemen ranken. Wenn Sie alles auf Seite eins kanonisieren, sagen Sie KI-Engines explizit, dass sie potenziell wertvolle Seiten mit einzigartigen Produkten, Inhalten oder Informationen ignorieren sollen.

Einzigartige Metadaten für jede Seite werden für die KI-Sichtbarkeit unerlässlich. Verwenden Sie keine generischen „Seite 2“-Titel oder doppelte Beschreibungen über die gesamte Sequenz. Schreiben Sie stattdessen seitenindividuelle, schlüsselwortreiche Metadaten, die den Fokus jeder Seite widerspiegeln. Beispiel: Statt „Produkte – Seite 2“ besser „Damen-Laufschuhe unter 100 € – Seite 2“ oder „KI-Trends im Einzelhandel – Fallstudienbibliothek (Seite 2)“. Diese Klarheit fördert die Sichtbarkeit, weil KI-Systeme den Kontext verstehen und besser bestimmen können, wann Ihre Inhalte für spezifische Suchanfragen relevant sind. Jedes Metadaten-Set muss den Prinzipien Klarheit, Einzigartigkeit und Keyword-Alignment folgen. Ziel ist, den Zweck jeder Seite sowohl für KI-Systeme als auch für menschliche Leser eindeutig zu machen.

Die interne Verlinkungsarchitektur bestimmt, ob KI-Systeme sequentielle Seiten entdecken und effizient navigieren können. Eine lineare Struktur (Seite 1 → 2 → 3) erzeugt lange Crawl-Pfade, bei denen tiefer liegende Seiten viele Klicks von der Startseite entfernt sind und wertvolle Inhalte möglicherweise ungesehen bleiben. Intelligente Umsetzungen beinhalten ergänzende Links wie „Alle anzeigen“-Optionen oder Kategorie-Hubs, die direkt auf wichtige Seiten verlinken und so die Crawl-Tiefe reduzieren und das Link-Equity gleichmäßiger verteilen. Das Zusammenspiel von facettierter Navigation und sequentiellen Seiten bringt Komplexität mit sich, da Filterkombinationen Tausende von URL-Variationen erzeugen können. Eine durchdachte interne Verlinkung stellt sicher, dass Prioritätsseiten ausreichend Crawler-Aufmerksamkeit erhalten, während weniger wichtige Kombinationen durch gezielten Einsatz von Noindex-Tags oder Canonical-Signalen abgewertet werden.

Strategische interne Verlinkungsketten von Pillar-Content zu spezifischen paginierten Seiten führen KI-Systeme durch Ihre Inhaltsstruktur. Verlinken Sie von Ihrer Hauptkategorieseite direkt auf bestimmte paginierte Seiten mit Ankertext, der das KI-Verständnis leitet. Beispiel: „Entdecken Sie weitere E-Commerce-Erfolgsgeschichten in unserer Fallstudienreihe – Seite 3.“ Machen Sie das Signal bedeutungsvoll und auffindbar. Dieser Ansatz zeigt KI-Systemen, wie Ihre Inhalte zusammenhängen und wie sie entdeckt werden sollen. Wenn KI-Crawler auf solche kontextuellen Links stoßen, verstehen sie die Beziehung zwischen den Seiten und können besser bestimmen, welche Inhalte für spezifische Suchanfragen am relevantesten sind.

Duplicate-Content-Probleme entstehen, wenn mehrere URLs identische oder weitgehend ähnliche Inhalte ohne ausreichende Unterscheidung anzeigen. Das passiert, wenn sequentielle Seiten keine einzigartigen Elemente abseits der aufgelisteten Artikel enthalten oder wenn URL-Parameter mehrere Pfade zu denselben Inhalten erzeugen. Suchmaschinen und KI-Systeme haben Schwierigkeiten, zu bestimmen, welche Version sie ranken sollen, was die Sichtbarkeit auf mehrere URLs fragmentieren kann. Enthalten paginierte Seiten zudem Standardtexte, Header und Footer mit wenig einzigartigem Inhalt, werden sie möglicherweise als „dünne Seiten“ mit geringem Mehrwert wahrgenommen. Abhilfe schaffen sorgfältige Verwendung von Canonical-Tags, einzigartige Meta-Beschreibungen pro Seite und der Nachweis, dass jede Seite über reine Navigationselemente und Template-Bausteine hinaus genügend eigenständigen Wert bietet.

Reine JavaScript-Implementierungen sind vermutlich der häufigste Fehler, der Inhalte vor KI-Systemen verbirgt. Wenn Ihre Seite Frameworks wie React oder Angular nutzt, um Seitensteuerungen ausschließlich clientseitig zu rendern (ohne serverseitiges Rendering), entdecken KI-Crawler möglicherweise keine Inhalte jenseits von Seite eins. Stellen Sie sicher, dass Navigationslinks im initialen HTML vorhanden sind, das die KI-Systeme erhalten, und nicht ausschließlich per JavaScript nachgeladen werden. Verwenden Sie progressive Enhancement—einfache HTML-Links, die durch JavaScript mit reibungsloseren Interaktionen und Animationen angereichert werden können. Testen Sie Ihre Umsetzung mit Tools, die zeigen, was Crawler tatsächlich sehen im Vergleich zur Ansicht in JavaScript-fähigen Browsern. So erkennen Sie Crawlability-Lücken, die Ihre KI-Sichtbarkeit kosten könnten.

Die Effektivität der Paginierung zu überwachen erfordert, zu verfolgen, wie KI-Systeme mit Ihren mehrseitigen Inhalten interagieren. Anders als im klassischen SEO, wo die Google Search Console direkte Einblicke bietet, sind für die KI-Sichtbarkeit andere Ansätze nötig. Tools wie Screaming Frog SEO Spider können Ihre Website ähnlich wie KI-Systeme crawlen, Seitenstrukturen abbilden und verwaiste Seiten oder Crawl-Tiefen-Probleme aufdecken. DeepCrawl und Sitebulk bieten erweiterte Analysen mit Visualisierung der Seitenbeziehungen. Die Google Search Console liefert Einblicke aus Googles Perspektive, zeigt, welche paginierten URLs indexiert werden und wie oft sie gecrawlt werden.

Zentrale Leistungskennzahlen für paginierte Inhalte sind, ob tiefer liegende Seiten in KI-generierten Antworten erscheinen, wie häufig KI-Systeme Ihre paginierten Inhalte zitieren und ob verschiedene Seiten für unterschiedliche Long-Tail-Suchanfragen ranken. Überwachen Sie Marken-Erwähnungen in KI-Antworten—wenn KI-Systeme konsequent nur Ihre Seite eins zitieren, aber nie tiefere Seiten, sollte Ihre Paginierungsstruktur optimiert werden. Analysieren Sie, welche paginierten Seiten den meisten Traffic aus KI-Quellen bringen. Diese Daten zeigen, ob Ihre Paginierungsstrategie Inhalte effektiv für KI-Systeme sichtbar macht oder eine Umstrukturierung nötig ist. Regelmäßige Audits erkennen Probleme, bevor sie die Sichtbarkeit beeinträchtigen, besonders nach Site-Updates oder Framework-Migrationen.

Das Feld der KI-gestützten Suche entwickelt sich rasant weiter, und regelmäßig entstehen neue Systeme und Möglichkeiten. Paginierungsstrategien, die heute funktionieren, sollten auch in Zukunft wirksam bleiben, wenn KI-Systeme immer ausgefeilter werden—wer vorn bleiben will, muss jedoch neueste Trends verstehen. KI-gestützte Suchalgorithmen sind zunehmend besser darin, Inhaltsbeziehungen zu erkennen und zu bestimmen, welche paginierten Seiten eine Indexierungspriorität verdienen. Googles Neural Matching und BERT-basierte Verarbeitung helfen Suchmaschinen zu erkennen, dass Seite zwei einer Kategorie andere Produkte enthält als Seite eins, auch wenn der umgebende Text ähnlich ist. Diese verbesserte Erkennung bedeutet: Gut strukturierte Seitenteilungen mit sinnvollen Unterschieden zwischen den Seiten profitieren mehr denn je von unabhängiger Indexierung.

Gleichzeitig erkennt KI auch immer besser wirklich dünne oder doppelte Inhalte auf paginierten Seiten, sodass rein mechanische Teilungen mit kaum unterscheidbaren Seiten nicht mehr funktionieren. Machine-Learning-Algorithmen erfassen Nutzerintentionen genauer und können tiefe Paginierungen für spezifische Long-Tail-Anfragen anzeigen, wenn diese Seiten die Suchintention am besten treffen. Praktisch heißt das: Jede paginierte Seite muss echten Mehrwert bieten—unterschiedliche Produkte, abweichende Inhalte oder sinnvolle Varianten—statt nur mechanischer Teilung identischer Informationen. Während sich KI-Systeme weiterentwickeln, bleiben die Kernprinzipien konstant: eindeutige URLs, crawlbare Links, einzigartiger Mehrwert pro Seite und klare Metadaten werden auch künftig die Wirksamkeit der Paginierung für KI-Sichtbarkeit bestimmen.

Verfolgen Sie, wie Ihre Inhalte in KI-generierten Antworten bei ChatGPT, Perplexity und anderen KI-Suchmaschinen erscheinen. Stellen Sie sicher, dass Ihre Marke zitiert wird, wenn KI-Systeme Fragen zu Ihrer Branche beantworten.

Paginierung teilt große Inhaltssammlungen in handhabbare Seiten auf, um UX und SEO zu verbessern. Erfahren Sie, wie Paginierung funktioniert, welche Auswirkunge...

Seiten pro Sitzung misst die durchschnittlich pro Besuch betrachteten Seiten. Erfahren Sie, wie sich diese Engagement-Kennzahl auf das Nutzerverhalten, die Conv...

Erfahren Sie, was ein Unterverzeichnis ist, wie es sich von Subdomains unterscheidet und warum es für SEO, Website-Organisation und die KI-Überwachung von Domai...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.