Welche Vertrauensfaktoren nutzen KI-Engines zur Bewertung von Quellen?

Erfahren Sie, wie KI-Engines wie ChatGPT, Perplexity und Google AI die Vertrauenswürdigkeit von Quellen bewerten. Lernen Sie E-E-A-T, Domain-Autorität, Zitierhä...

Entdecken Sie, welche Quellen von KI-Engines am häufigsten zitiert werden. Erfahren Sie, wie ChatGPT, Google AI Overviews und Perplexity die Glaubwürdigkeit von Quellen bewerten, und verstehen Sie Zitiermuster in verschiedenen Branchen, um Ihre Inhalte für KI-Sichtbarkeit zu optimieren.

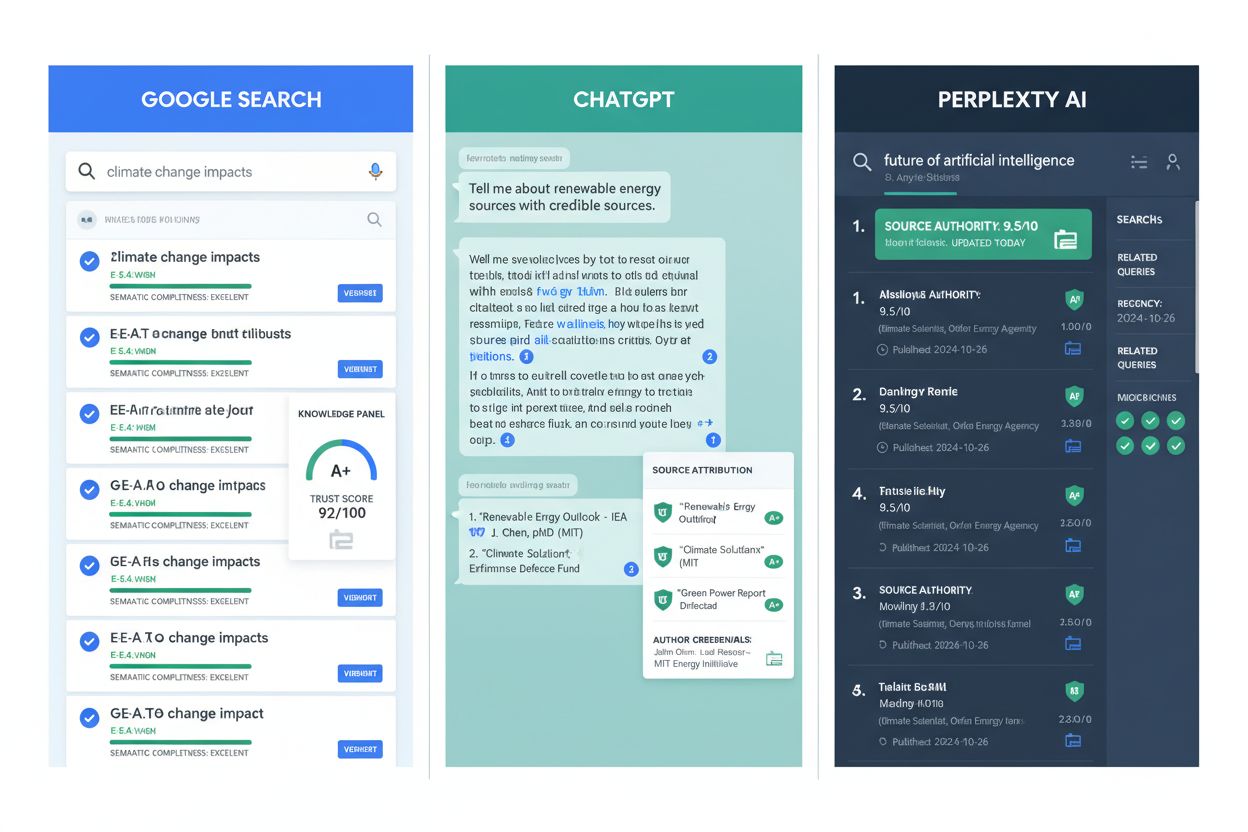

KI-Engines wie ChatGPT, Google AI Overviews und Perplexity vertrauen Quellen basierend auf Autorität, Genauigkeit und Transparenz. YouTube (~23%), Wikipedia (~18%) und Google.com (~16%) dominieren die Zitationen branchenübergreifend, während Reddit, LinkedIn und institutionelle Quellen wie das NIH je nach Plattform und Thema variieren. Jede KI-Engine hat ausgeprägte Präferenzen, geprägt durch ihre Trainingsdaten und Ranking-Algorithmen.

KI-Engines bewerten die Glaubwürdigkeit von Quellen anhand mehrerer Signale, die weit über die reine Domain-Autorität hinausgehen. Wenn ChatGPT, Perplexity, Google AI Overviews und andere KI-Antwortgeneratoren Anfragen verarbeiten, verlassen sie sich auf ein ausgefeiltes Rahmenwerk von Vertrauensindikatoren, das während des Trainings etabliert und durch Ranking-Logik in Echtzeit verfeinert wird. Diese Systeme wählen Quellen nicht zufällig aus – sie wenden algorithmische Filter an, die Genauigkeit, Autorität, Transparenz und Konsistenz priorisieren, um zu bestimmen, welche Informationen in ihren Antworten hervorgehoben werden. Das Verständnis dieser Vertrauensmechanismen ist entscheidend für alle, die die Sichtbarkeit ihrer Marke in KI-generierten Antworten erhöhen möchten.

Die Grundlage der Vertrauensbewertung durch KI beginnt mit der Kurierung der Trainingsdaten. Die meisten großen Sprachmodelle werden mit riesigen Datensätzen trainiert, die begutachtete wissenschaftliche Fachzeitschriften, etablierte Nachrichtenarchive, enzyklopädische Referenzen und staatliche Publikationen umfassen. Gleichzeitig filtern Entwickler Spam-Seiten, Content-Farmen und bekannte Desinformationsnetzwerke heraus. Dieser Vorverarbeitungsschritt legt die Basis dafür, welche Quellentypen ein KI-System als glaubwürdig erkennen kann. Nach der Bereitstellung wenden KI-Engines zusätzliche Ranking-Logikschichten an, die Zitierhäufigkeit, Domain-Reputation, Aktualität und Kontextrelevanz berücksichtigen, um zu entscheiden, welche Quellen in Echtzeit-Antworten erscheinen.

Die Daten zeigen deutliche Unterschiede darin, wie jede KI-Engine Quellen priorisiert. YouTube dominiert mit etwa 23,3 % der Zitationen in nahezu jeder Branche und ist damit die insgesamt am häufigsten zitierte Quelle. Dies spiegelt die Präferenz von KI-Engines für visuelle, praxisorientierte Erklärungen wider, die komplexe Themen vereinfachen. Wikipedia folgt dicht mit 18,4 %, liefert strukturierte, neutrale Definitionen und ist ideal zur Zusammenfassung. Google.com selbst macht 16,4 % der Zitationen aus und unterstreicht die Bedeutung des eigenen Ökosystems von Google, einschließlich Support-Seiten und Entwicklerdokumentation.

Diese aggregierten Zahlen verbergen jedoch wichtige plattformspezifische Unterschiede. ChatGPT zeigt eine ausgeprägte Präferenz für Wikipedia mit 7,8 % aller Zitationen und demonstriert damit den Fokus der Plattform auf enzyklopädische, faktenbasierte Inhalte. Im Gegensatz dazu bevorzugt Perplexity Reddit mit 6,6 % der Zitationen, was die Designphilosophie widerspiegelt, die Community-getriebene Informationen und Peer-Insights priorisiert. Google AI Overviews verfolgt einen ausgewogeneren Ansatz, verteilt Zitationen auf Reddit (2,2 %), YouTube (1,9 %) und Quora (1,5 %) und deutet damit auf eine Strategie hin, die professionellen Content mit sozialen Plattformen verbindet.

| KI-Plattform | Meistzitierte Quelle | Zitations-% | Zweite Quelle | Zitations-% | Dritte Quelle | Zitations-% |

|---|---|---|---|---|---|---|

| ChatGPT | Wikipedia | 7,8 % | 1,8 % | Forbes | 1,1 % | |

| Google AI Overviews | 2,2 % | YouTube | 1,9 % | Quora | 1,5 % | |

| Perplexity | 6,6 % | YouTube | 2,0 % | Gartner | 1,0 % | |

| Google AI Mode | Marken-/OEM-Seiten | 15,2 % | 2,2 % | YouTube | 1,9 % |

Vertrauenssignale variieren je nach Branche erheblich, was zeigt, dass KI-Engines eine kontextuelle Gewichtung anwenden, um die Glaubwürdigkeit abhängig von der Suchintention zu bewerten. Bei Gesundheits- und Medizin-Anfragen dominiert institutionelle Autorität absolut. Die National Institutes of Health (NIH) erhalten 39 % der Zitationen, gefolgt von Healthline (15 %), Mayo Clinic (14,8 %) und Cleveland Clinic (13,8 %). Diese Konzentration spiegelt wider, dass KI-Engines erkennen, dass Gesundheitsinformationen verifizierte klinische Expertise und begutachtete Evidenz erfordern. YouTube spielt mit 28 % weiterhin eine unterstützende Rolle für patientenfreundliche Erklärungen, aber soziale Plattformen tauchen bei Gesundheitszitaten kaum auf – was zeigt, dass KI-Systeme die Risiken medizinischer Fehlinformationen verstehen.

Finanzanfragen zeigen ein anderes Muster, bei dem YouTube mit 23 % dominiert, da Nutzer zugängliche Erklärvideos und Tutorials traditionellen Finanzinstituten vorziehen. Wikipedia (7,3 %), LinkedIn (6,8 %) und Investopedia (5,7 %) liefern Definitionen und professionelle Einblicke. Diese Verteilung legt nahe, dass KI-Engines erkennen, dass Finanzkompetenz sowohl autoritative Referenzmaterialien als auch zugänglichen, edukativen Content erfordert. Community-Plattformen wie Reddit und Quora sind ebenfalls vertreten, was zeigt, wie KI institutionelle Autorität mit Peer-basierten Ratschlägen für Finanzthemen kombiniert.

E-Commerce- und Shopping-Anfragen zeigen YouTube an der Spitze mit 32,4 %, gefolgt von Shopify (17,7 %), Amazon (13,3 %) und Reddit (11,3 %). Dieses Muster spiegelt das Verständnis der KI-Engines wider, dass Kaufentscheidungen sowohl edukative How-to-Inhalte als auch Produktvalidierung durch Rezensionen und Peer-Empfehlungen erfordern. SEO-bezogene Anfragen sind ein interessanter Spezialfall, bei dem YouTube (39,1 %) und Google.com (39,0 %) nahezu gleichauf liegen, was darauf hinweist, dass KI sowohl offizielle Leitlinien als auch praxisnahe Insights für technische Themen als gleichwertig wertvoll anerkennt.

KI-Engines bewerten Vertrauenswürdigkeit anhand von vier miteinander verbundenen Dimensionen, die gemeinsam die Glaubwürdigkeit einer Quelle bestimmen. Genauigkeit bildet die erste Säule – Inhalte müssen überprüfbare Fakten widerspiegeln, die durch Belege oder Daten gestützt werden, und unbegründete Behauptungen vermeiden. KI-Systeme prüfen die Genauigkeit, indem sie Informationen aus mehreren Quellen vergleichen und auf Konsistenz achten. Stimmen Quellen in einer Tatsache überein, steigt das Vertrauen; weichen sie ab, kann das System diese Aussagen abschwächen oder abwerten. Dieser Quervergleichsmechanismus bedeutet, dass Inhalte, die in mehreren vertrauenswürdigen Dokumenten erscheinen, zusätzliches Gewicht erhalten und so mit größerer Wahrscheinlichkeit zitiert oder zusammengefasst werden.

Autorität bildet die zweite Säule, arbeitet aber differenzierter als reine Domain-Erkennung. Während etablierte Verlage und anerkannte Institutionen Gewicht haben – große Medien werden mindestens 27 % der Zeit zitiert, bei aktuellen Anfragen steigt dies auf 49 % –, umfasst Autorität zunehmend auch direkte Expertise. KI-Engines erkennen Signale für Fachwissen, darunter Originalforschung, von verifizierten Experten erstellte Inhalte und von Individuen geteilte Erfahrungsberichte. Kleinere Marken und Nischen-Publisher mit nachweisbarer Expertise können genauso prominent erscheinen wie etablierte Outlets, manchmal sogar überzeugender. Google AI Overviews verlinken dreimal häufiger auf .gov-Websites als reguläre Suchergebnisse, was zeigt, dass institutionelle Autorität bei bestimmten Anfragen besonders gewichtet wird.

Transparenz ist die dritte Säule und verlangt, dass Quellen sich klar identifizieren, ordnungsgemäße Attribution bieten und es ermöglichen, Informationen bis zum Ursprung zurückzuverfolgen. KI-Systeme bevorzugen Inhalte mit expliziter Urheberschaft, Quellenangaben und Kontext. Diese Transparenz ermöglicht es sowohl Nutzern als auch KI-Systemen, Behauptungen zu überprüfen und die Argumentationsgrundlage zu verstehen. Die vierte Säule, Konsistenz über die Zeit, demonstriert Zuverlässigkeit durch mehrere Artikel oder Updates statt durch Einzelbeiträge. Inhalte, die über zahlreiche Veröffentlichungen und Aktualisierungen hinweg akkurat bleiben, signalisieren Vertrauenswürdigkeit effektiver als einzelne autoritative Stücke.

Nach Eingabe einer Anfrage wenden KI-Engines eine ausgefeilte Ranking-Logik an, die Glaubwürdigkeit mit Relevanz und Aktualität ausbalanciert. Zitierhäufigkeit und Verlinkungen spielen eine entscheidende Rolle – Inhalte, die in mehreren vertrauenswürdigen Dokumenten erscheinen, erhalten zusätzliches Gewicht. Dieses Prinzip erweitert das klassische PageRank-Konzept: So wie Google nicht manuell entscheidet, welche Seiten autoritativ sind, sondern Signale wie die Anzahl zuverlässiger Rückverlinkungen nutzt, verlassen sich generative Systeme auf quergestützte Glaubwürdigkeit, um bestimmte Quellen hervorzuheben. Wenn eine Tatsache in mehreren hochautoritativen Quellen erscheint, gilt sie für KI-Systeme als zuverlässiger und wird mit höherer Wahrscheinlichkeit zitiert.

Aktualität und Update-Frequenz beeinflussen das Ranking erheblich, insbesondere bei Google AI Overviews, die auf den Kern-Ranking-Systemen von Google aufbauen. Aktuell gepflegte oder kürzlich aktualisierte Inhalte werden eher angezeigt, besonders bei Anfragen zu sich schnell entwickelnden Themen wie Regulierungen, Nachrichten oder neuen Forschungsergebnissen. Dieses Aktualitätssignal stellt sicher, dass KI-generierte Antworten aktuelle Informationen widerspiegeln und keine veralteten Ansichten. Kontextuelle Gewichtung fügt eine weitere Ebene der Differenzierung hinzu – technische Fragen bevorzugen möglicherweise wissenschaftliche oder sitespezifische Quellen, während Nachrichtenanfragen sich stärker auf journalistische Inhalte stützen. Diese Anpassungsfähigkeit erlaubt es den Engines, Vertrauenssignale an die Nutzerintention anzupassen und differenzierte Gewichtungssysteme zu schaffen, die Glaubwürdigkeit mit Kontext verbinden.

Über Training und Ranking hinaus nutzen KI-Engines interne Vertrauensmetriken – Bewertungssysteme, die abschätzen, wie wahrscheinlich eine Aussage korrekt ist. Diese Vertrauenswerte beeinflussen, welche Quellen zitiert werden und ob ein Modell lieber mit Einschränkungen antwortet statt mit eindeutigen Aussagen. Modelle weisen den von ihnen generierten Aussagen interne Wahrscheinlichkeiten zu; hohe Werte deuten auf größere Sicherheit hin, während niedrige Werte Schutzmechanismen wie Disclaimer oder alternative Antworten auslösen können. Schwellenwerte sind nicht statisch – bei Anfragen mit wenigen oder minderwertigen Informationen senken die Engines ihre Bereitschaft, definitive Antworten zu liefern, oder sie zitieren externe Quellen deutlicher.

Übereinstimmung zwischen Quellen stärkt die Vertrauensbewertung erheblich. Wenn mehrere vertrauenswürdige Quellen eine Information bestätigen, steigt das Vertrauen signifikant. Weichen die Signale zwischen Quellen ab, neigen Systeme dazu, Aussagen abzuschwächen oder sie ganz abzuwerten. Dieses Vorgehen erklärt, warum Konsensinformationen aus mehreren autoritativen Quellen höhere Vertrauenswerte erhalten als Behauptungen, die nur in einer Quelle erscheinen – selbst wenn diese sehr autoritativ ist. Das Zusammenspiel dieser Vertrauensmechanismen und der Quellenauswahl erzeugt eine Rückkopplung, durch die die vertrauenswürdigsten Quellen in KI-Antworten zunehmend sichtbar werden.

Kommerzielle (.com) Domains dominieren KI-Zitationen mit über 80 % aller Nennungen und machen die Domain-Endung zu einem bedeutenden Vertrauenssignal. Non-Profit-Seiten (.org) belegen mit 11,29 % den zweiten Platz, was die Anerkennung institutioneller Glaubwürdigkeit durch KI-Engines widerspiegelt. Länderspezifische Domains (.uk, .au, .br, .ca) machen zusammen rund 3,5 % der Zitationen aus, was auf eine globale Informationsbeschaffung hindeutet. Interessanterweise zeigen technologieorientierte TLDs wie .io und .ai eine beachtliche Präsenz trotz ihrer Neuheit, was auf aufkommende Chancen für Tech-Brands zur Autoritätsbildung hindeutet.

Diese Domain-Verteilung zeigt, dass traditionelle kommerzielle Domains weiterhin erhebliche Glaubwürdigkeitsvorteile haben, aber neuere Domain-Endungen an Bedeutung gewinnen, da KI-Systeme Qualitätsinhalte unabhängig von der TLD anerkennen. Die Dominanz von .com- und .org-Domains spiegelt sowohl deren historische Verbreitung im Trainingsmaterial als auch ihre Verbindung zu etablierten, legitimen Organisationen wider. Doch die zunehmende Präsenz spezialisierter TLDs deutet darauf hin, dass KI-Engines Inhalte immer stärker unabhängig von der Domain-Endung bewerten und substanzieller Expertise Vorrang vor Domain-Abstammung geben.

Das Verständnis der unterschiedlichen Vertrauenspräferenzen jeder Plattform ermöglicht gezielte Optimierungsstrategien. Für Sichtbarkeit bei ChatGPT sollten Sie Präsenz in autoritativen Wissensdatenbanken und etablierten Medien aufbauen. Die Dominanz von Wikipedia in ChatGPT-Zitationen (47,9 % der Top-10-Quellen) deutet darauf hin, dass umfassende, gut strukturierte Referenzinhalte bevorzugt werden. Stellen Sie sicher, dass Ihre Marke in relevanten Wikipedia-Artikeln erscheint, tragen Sie zu etablierten Branchenpublikationen bei und pflegen Sie eine starke Einzelhandelspräsenz auf großen Marktplätzen, da ChatGPT Retail-/Marketplace-Domains stark bevorzugt (41,3 % der Zitationen).

Für die Optimierung bei Perplexity ist aktive Community-Beteiligung und die Bereitstellung umfassender, zitierbarer Ressourcen entscheidend. Die Dominanz von Reddit (46,7 % der Top-10-Quellen von Perplexity) zeigt, dass Community-getriebene Informationen und Peer-to-Peer-Diskussionen die Sichtbarkeit maßgeblich beeinflussen. Beteiligen Sie sich authentisch in relevanten Reddit-Communities, veröffentlichen Sie ausführliche Anleitungen und Forschungsergebnisse, auf die sich Community-Mitglieder beziehen, und bleiben Sie auf beruflichen Netzwerken wie LinkedIn präsent. Die Zitation von 8.027 einzigartigen Domains – der größten Vielfalt aller Plattformen – deutet darauf hin, dass Nischenkompetenz und spezialisierte Inhalte Anerkennung finden.

Für Google AI Overviews empfiehlt sich eine Mischung aus edukativem Content, Videos und regelmäßig aktualisierten Seiten. Die Bedeutung von YouTube (23,3 % der Zitationen) und die Präferenz der Plattform für ausgewogene Quellenverteilung sprechen für einen Multi-Channel-Ansatz. Veröffentlichen Sie edukative How-to-Inhalte, produzieren Sie verständliche Video-Erklärungen, pflegen Sie korrekte Informationen auf Ihrer Website und sorgen Sie für Präsenz auf relevanten Fachplattformen. Die dreifache Präferenz der Plattform für .gov-Websites zeigt, dass institutionelle Glaubwürdigkeit und nachgewiesene Expertise besonders gewichtet werden.

Trotz ausgefeilter Vertrauensmechanismen bleibt das Ungleichgewicht bei Quellen eine große Herausforderung. Autoritätssignale tendieren zu großen, englischsprachigen Publishern und westlichen Medien, wodurch lokales oder nicht-englisches Fachwissen möglicherweise übersehen wird, selbst wenn es genauer wäre. Diese Verzerrung kann die Bandbreite der dargestellten Perspektiven einschränken und blinde Flecken in KI-generierten Antworten erzeugen. Außerdem stellt sich durch sich wandelndes Wissen eine ständige Herausforderung – wissenschaftlicher Konsens ändert sich, Regelungen werden angepasst, neue Forschung kann frühere Annahmen widerlegen. Was heute als korrekt gilt, kann nächstes Jahr schon veraltet sein, sodass Engines ihre Vertrauensmarker laufend aktualisieren und neu justieren müssen.

Intransparenz in KI-Systemen erschwert die Strategieentwicklung. KI-Anbieter legen selten die vollständige Mischung der Trainingsdaten oder die genaue Gewichtung der Vertrauenssignale offen, was es Publishern schwer macht zu verstehen, warum bestimmte Quellen häufiger erscheinen. Diese Transparenzlücke betrifft sowohl Nutzer, die die KI-Logik nachvollziehen wollen, als auch Marketer, die ihre Content-Strategien auf tatsächliche Plattform-Prioritäten abstimmen möchten. Die Studie der Columbia University, wonach mehr als 60 % der KI-Ausgaben keine korrekten Zitationen enthielten, unterstreicht diese Herausforderungen und den fortlaufenden Optimierungsbedarf bei Quellenbewertung und Zitationsgenauigkeit.

Die Branche bewegt sich in Richtung größerer Transparenz und Verantwortlichkeit bei der Quellenbewertung. Künftig wird stärker darauf geachtet, dass Ausgaben direkt auf ihre Ursprünge zurückverfolgt werden können – etwa durch verlinkte Zitationen, Herkunftsnachweise und Quellenkennzeichnung. Diese Funktionen helfen Nutzern zu erkennen, ob Aussagen aus glaubwürdigen Dokumenten stammen und bieten die Möglichkeit, Fehlinformationen zu erkennen. Feedback-Mechanismen werden systematisch integriert, sodass Nutzerkorrekturen, Bewertungen und gemeldete Fehler in Modell-Updates einfließen. Dadurch entsteht ein Kreislauf, in dem Glaubwürdigkeit nicht nur algorithmisch bestimmt, sondern zudem durch reale Nutzung verfeinert wird.

Open-Source-Initiativen und Transparenzprojekte drängen auf mehr Einblick in die Anwendung von Vertrauenssignalen. Durch Transparenz bei Trainingsdaten oder Gewichtungssystemen erhalten Forscher und die Öffentlichkeit Einblick, warum bestimmte Quellen hervorgehoben werden. Diese Transparenz kann die Verantwortlichkeit in der Branche stärken und fundiertere Content-Strategien ermöglichen. Mit der Weiterentwicklung von KI-Systemen wird sich auch die Bewertung von Quellenglaubwürdigkeit weiterentwickeln – mit wachsendem Fokus auf überprüfbare Expertise, transparente Attribution und nachgewiesene Genauigkeit über die Zeit hinweg.

Verfolgen Sie, wo Ihre Domain in KI-generierten Antworten von ChatGPT, Perplexity, Google AI Overviews und anderen KI-Suchmaschinen erscheint. Erhalten Sie Echtzeit-Einblicke in Ihre KI-Zitierperformance.

Erfahren Sie, wie KI-Engines wie ChatGPT, Perplexity und Google AI die Vertrauenswürdigkeit von Quellen bewerten. Lernen Sie E-E-A-T, Domain-Autorität, Zitierhä...

Erfahren Sie, wie KI-Systeme die Glaubwürdigkeit von Quellen anhand von Autorenqualifikationen, Zitaten und Verifizierung bewerten. Verstehen Sie die technische...

Community-Diskussion darüber, welchen Quellen KI-Engines am meisten vertrauen. Echte Erfahrungen von Marketers, die Vertrauenssignale und Zitiermuster über KI-P...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.