Indexabdeckung

Die Indexabdeckung misst, welche Webseiten von Suchmaschinen indexiert werden. Erfahren Sie, was das bedeutet, warum es für SEO wichtig ist und wie Sie Indexier...

Der Prozentsatz der Website-Inhalte, der erfolgreich von KI-Systemen wie ChatGPT, Google AI Overviews und Perplexity indexiert und zugänglich ist. Eine starke KI-Index-Abdeckung stellt sicher, dass Ihre Inhalte in KI-generierten Antworten auffindbar sind und als Quelle zitiert werden können. Im Gegensatz zur traditionellen Suchmaschinenindexierung bestimmt die KI-Index-Abdeckung die Sichtbarkeit über mehrere KI-Plattformen und LLM-basierte Systeme hinweg.

Der Prozentsatz der Website-Inhalte, der erfolgreich von KI-Systemen wie ChatGPT, Google AI Overviews und Perplexity indexiert und zugänglich ist. Eine starke KI-Index-Abdeckung stellt sicher, dass Ihre Inhalte in KI-generierten Antworten auffindbar sind und als Quelle zitiert werden können. Im Gegensatz zur traditionellen Suchmaschinenindexierung bestimmt die KI-Index-Abdeckung die Sichtbarkeit über mehrere KI-Plattformen und LLM-basierte Systeme hinweg.

KI-Index-Abdeckung bezeichnet den Prozentsatz Ihrer Website-Inhalte, der erfolgreich von künstlichen Intelligenzsystemen wie ChatGPT, Google AI Overviews, Perplexity und anderen großen Sprachmodellen (LLMs) entdeckt, gecrawlt und indexiert wird. Im Gegensatz zur traditionellen Suchmaschinenindexierung, die darauf abzielt, Inhalte in Suchergebnissen sichtbar zu machen, bestimmt die KI-Index-Abdeckung, ob Ihre Inhalte für KI-Systeme zum Training, zur Zitation und zur Einbindung in KI-generierte Antworten zugänglich sind. Wenn Ihre Inhalte eine starke KI-Index-Abdeckung aufweisen, werden sie auf mehreren KI-Plattformen auffindbar, was die Wahrscheinlichkeit erhöht, dass Ihre Marke, Produkte oder Informationen erwähnt werden, wenn Nutzer diese Systeme anfragen. Eine geringe KI-Index-Abdeckung bedeutet, dass wertvolle Inhalte für KI-Systeme unsichtbar bleiben und damit entscheidende Chancen für Markenpräsenz im schnell wachsenden KI-gestützten Suchumfeld ungenutzt bleiben.

Die KI-Index-Abdeckung wirkt sich direkt auf die Sichtbarkeit Ihrer Marke in einem zunehmend KI-gesteuerten digitalen Ökosystem aus. Mit KI-gestützten Ergebnissen, die mittlerweile in über 91 % der produktbezogenen Suchanfragen erscheinen und KI-Plattformen wie ChatGPT, die wöchentlich über 1 Milliarde Suchanfragen bearbeiten, ist es für moderne Digital-Strategien unerlässlich, dass Ihre Inhalte von diesen Systemen indexiert werden. Die Auswirkungen auf das Geschäft sind erheblich: Inhalte mit starker KI-Index-Abdeckung können in KI-Antworten zitiert werden, was qualifizierten Traffic und Markenbekanntheit fördert, während blockierte oder schlecht indexierte Inhalte für diese mächtigen Kanäle völlig unsichtbar bleiben. Darüber hinaus zitieren KI-Systeme häufig Quellen, die in den traditionellen Suchergebnissen nicht ranken – tatsächlich erscheinen nur etwa 20 % der in KI-Antworten zitierten Seiten in den Top 10 der Google-Ergebnisse, sodass KI-Indexierung völlig neue Sichtbarkeitschancen schafft.

| Szenario | Auswirkung auf KI-Sichtbarkeit | Geschäftliches Ergebnis |

|---|---|---|

| Korrekt indexierte, hochwertige Inhalte | Häufige Zitation in KI-Antworten | Mehr Marken-Erwähnungen, qualifizierter Traffic, Autoritätsaufbau |

| Indexiert, aber selten zitiert | Wenige Erwähnungen in KI-Ergebnissen | Begrenzte Sichtbarkeit trotz technischer Erreichbarkeit |

| Blockiert oder nicht indexiert | Keine Sichtbarkeit in KI-Systemen | Verpasste Chancen, Wettbewerber gewinnen Anteil |

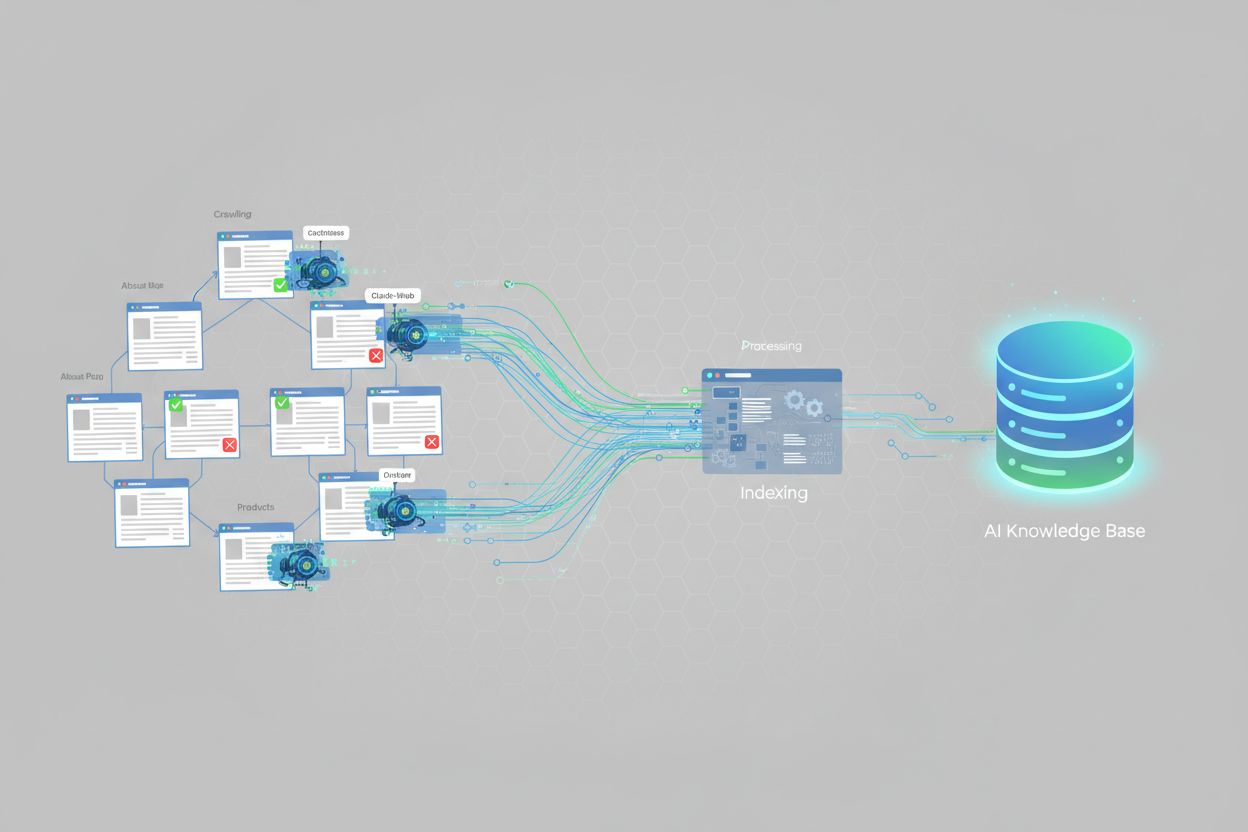

KI-Systeme indexieren Inhalte über spezialisierte Crawler, die darauf ausgelegt sind, Informationen für große Sprachmodelle zu erfassen und zu verstehen. ChatGPT verwendet beispielsweise Crawler wie GPTBot, um kontinuierlich das Web nach Trainingsdaten zu durchsuchen, wobei auch Echtzeit-Websuche für aktuelle Informationen genutzt wird. Google AI Overviews nutzt die bestehende Crawl-Infrastruktur von Google, wendet aber zusätzliche Verarbeitungsschritte an, um Inhaltsstruktur, Relevanz und Autorität für KI-generierte Zusammenfassungen zu bestimmen. Perplexity AI verfolgt einen anderen Ansatz, legt den Fokus auf Echtzeit-Websuche und zieht pro Anfrage über 20 Quellen heran – mit einer deutlichen Bevorzugung von Plattformen wie Reddit und Community-Inhalten. Jede KI-Plattform hat ihre eigenen Indexierungspräferenzen: Einige priorisieren strukturierte Daten und Schema-Markup, andere setzen auf umfassende, gut geschriebene Inhalte, wieder andere gewichten Drittquellen und Bewertungen stärker. Es ist entscheidend, diese Unterschiede zu verstehen, denn die Optimierung für ein KI-System bedeutet nicht automatisch die Optimierung für alle – Ihre Content-Strategie muss die spezifischen Indexierungsverhalten der für Ihre Zielgruppe relevanten Plattformen berücksichtigen.

Mehrere technische Faktoren beeinflussen direkt, ob KI-Systeme Ihre Inhalte erfolgreich indexieren können. Die wichtigsten sind:

<meta name="robots" content="noindex"> werden explizit von der KI-Indexierung ausgeschlossen. Solche Tags werden manchmal versehentlich auf Live-Seiten belassen.Die Behebung dieser technischen Faktoren ist die Grundlage zur Verbesserung der KI-Index-Abdeckung. Tools wie AmICited.com helfen dabei, zu überwachen, wie effektiv Ihre Inhalte auf verschiedenen KI-Plattformen indexiert werden, und liefern Einblicke, welche technischen Probleme Ihre Abdeckung einschränken könnten.

Um Ihre KI-Index-Abdeckung zu verfolgen, benötigen Sie eine Kombination aus traditionellen SEO-Tools und KI-spezifischen Monitoring-Lösungen. Google Search Console bietet Indexabdeckungsberichte, die zeigen, welche Seiten von Google indexiert sind – dies spiegelt jedoch die traditionelle Suchindexierung und nicht die KI-Systeme wider. Bing Webmaster Tools liefert ähnliche Funktionen für Bings Index. Für KI-spezifisches Monitoring ist AmICited.com darauf spezialisiert, zu verfolgen, wie Ihre Marke in ChatGPT, Google AI Overviews, Perplexity und anderen KI-Systemen erscheint, inklusive Zitierhäufigkeit, Stimmungsanalyse und Share of Voice. Drittanbieter-SEO-Plattformen wie Semrush, Ahrefs und Moz bieten zunehmend KI-Sichtbarkeitsmetriken zusätzlich zu klassischen SEO-Daten. Wichtige Messgrößen sind: der Prozentsatz Ihrer Seiten, die in KI-Antworten erscheinen, wie oft Ihre Marke im Vergleich zu Wettbewerbern zitiert wird, die Stimmung der KI-Erwähnungen und welche Inhaltstypen die meisten KI-Zitate generieren. Regelmäßiges Monitoring hilft, technische Probleme, Content-Lücken und Optimierungschancen zur Verbesserung Ihrer KI-Index-Abdeckung frühzeitig zu erkennen.

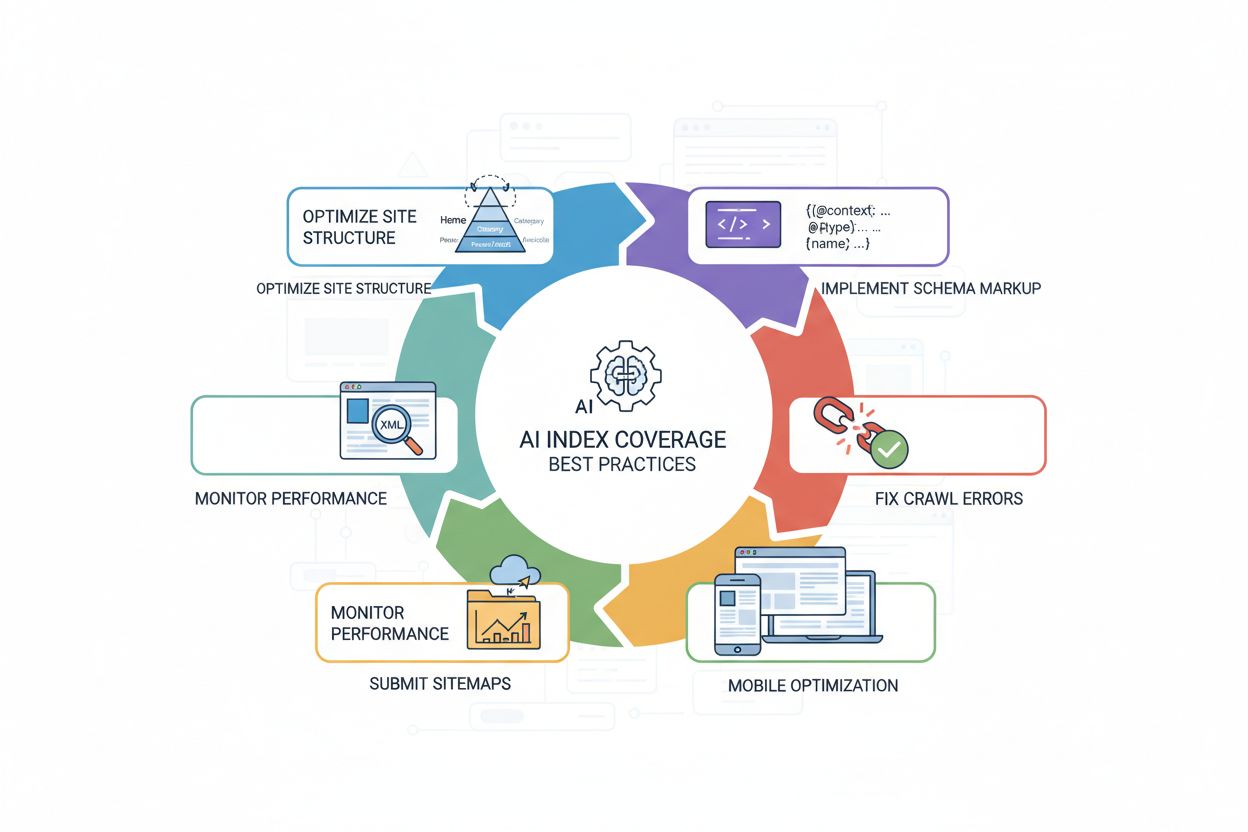

Die Verbesserung der KI-Index-Abdeckung erfordert einen strategischen Ansatz, der technische Optimierung und hochwertige Inhalte kombiniert. Die wirksamsten Maßnahmen sind:

<article>, <section>, <header>, <nav>), um KI-Systemen die Inhaltsstruktur und -bedeutung klar zu vermitteln.Diese Maßnahmen sorgen gemeinsam für eine KI-freundliche Website, die für Crawler gut zugänglich, verständlich und zitierbar ist. Das Ergebnis ist eine stärkere KI-Index-Abdeckung und erhöhte Sichtbarkeit auf KI-gestützten Plattformen.

KI-Index-Abdeckung und traditionelle Suchindex-Abdeckung sind verwandt, aber nicht identisch. Traditionelle Suchindexierung zielt darauf ab, Inhalte in den Suchergebnisseiten (SERPs) sichtbar zu machen, wobei das Ranking von Faktoren wie Backlinks, Keyword-Relevanz und Nutzersignalen abhängt. KI-Index-Abdeckung hingegen bestimmt, ob Inhalte für KI-Systeme zum Training und zur Echtzeit-Zitation zugänglich sind – mit ganz anderen Ranking-Faktoren. KI-Systeme zitieren oft Quellen, die in der traditionellen Suche schlecht ranken – die 20%ige Überschneidung zwischen KI-zitierten Seiten und den Top 10 der organischen Google-Ergebnisse verdeutlicht diesen Unterschied. Hinzu kommt, dass KI-Systeme andere Inhaltstypen priorisieren können: Während die traditionelle Suche domänenweite Autorität bevorzugt, gewichten KI-Systeme oft bestimmte Formate (FAQs, Listen, Vergleichsguides, Rezensionen) stärker. Eine Seite kann in Google gut ranken und trotzdem kaum von KI-Systemen zitiert werden – oder umgekehrt. Ihre Optimierungsstrategie muss daher beide Kanäle berücksichtigen: Traditionelle SEO-Praktiken erhöhen die Sichtbarkeit in der Suche, während KI-spezifische Optimierungen (Schema-Markup, Inhaltsstruktur, Zugänglichkeit) die KI-Index-Abdeckung und Zitationswahrscheinlichkeit verbessern.

Mehrere häufige Probleme verhindern, dass Websites eine starke KI-Index-Abdeckung erreichen. Zu restriktive robots.txt-Dateien gehören zu den häufigsten Ursachen – viele Seiten blockieren versehentlich KI-Crawler, während sie eigentlich nur traditionelle Suchbots ausschließen möchten, und verhindern damit die KI-Indexierung vollständig. Falsch platzierte noindex-Tags, die bei Entwicklung oder Migration versehentlich auf Live-Seiten verbleiben, können ganze Bereiche für KI-Systeme unsichtbar machen. Schlechte Inhaltsstruktur erschwert es KI-Crawlern, Informationen zu verstehen und zu extrahieren; Seiten ohne klare Überschriften, semantisches HTML oder logische Organisation werden seltener indexiert und zitiert. Fehlendes oder unvollständiges Schema-Markup nimmt KI-Systemen expliziten Kontext für Ihre Inhalte, was die Indexierung und Zitierwahrscheinlichkeit verringert. JavaScript-lastige Seiten ohne serverseitiges Rendering stellen ein großes Problem dar, da viele KI-Crawler kein JavaScript ausführen können – wichtige Inhalte bleiben verborgen. Doppelte Inhalte ohne korrekte Kanonisierung verwirren KI-Systeme hinsichtlich der maßgeblichen Version, was die Abdeckung verringern kann. Schließlich reduzieren langsames Laden und schlechte mobile Optimierung die Crawleffizienz und damit die Anzahl der indexierten Seiten. Die systematische Beseitigung dieser Probleme – beginnend mit robots.txt-Prüfung, Hinzufügen von Schema-Markup, Verbesserung der Seitenstruktur und Sicherstellung schneller, mobiler Seiten – kann Ihre KI-Index-Abdeckung und Sichtbarkeit auf KI-Plattformen deutlich steigern.

Derzeit gibt es keinen standardisierten Messwert für die KI-Index-Abdeckung über alle Websites hinweg, aber Untersuchungen zeigen, dass KI-gestützte Ergebnisse in über 91 % der produktbezogenen Suchanfragen erscheinen. Viele Websites haben jedoch aufgrund technischer Probleme wie robots.txt-Sperren, fehlender Schema-Auszeichnung oder JavaScript-Rendering-Problemen eine schlechte KI-Index-Abdeckung. Websites mit starker technischer SEO und strukturierten Daten erreichen in der Regel eine bessere KI-Index-Abdeckung.

Die traditionelle Google-Index-Abdeckung konzentriert sich darauf, Inhalte in den Suchergebnissen sichtbar zu machen, während die KI-Index-Abdeckung bestimmt, ob Inhalte für KI-Systeme zum Training und zur Zitation zugänglich sind. KI-Systeme zitieren häufig Quellen, die nicht in den Top 10 der Google-Ergebnisse gelistet sind – nur etwa 20 % der von KI zitierten Seiten erscheinen in den traditionellen Top 10 der organischen Ergebnisse. Verschiedene KI-Plattformen haben zudem unterschiedliche Indexierungspräferenzen und Gewichtungen von Quellen.

Ja, Sie können bestimmte KI-Crawler mit Ihrer robots.txt-Datei blockieren. Zum Beispiel können Sie GPTBot (OpenAI), CCBot (Common Crawl) oder Claude-Web (Anthropic) ausschließen. Das Blockieren von KI-Crawlern bedeutet jedoch, dass Ihre Inhalte von diesen Systemen nicht indexiert werden und nicht in KI-generierten Antworten erscheinen. Die meisten Unternehmen profitieren davon, KI-Crawler zuzulassen, um die Sichtbarkeit auf KI-Plattformen zu verbessern.

Die Indexierungszeiten variieren je nach KI-Plattform. Der GPTBot von ChatGPT crawlt kontinuierlich, kann aber Tage oder Wochen benötigen, um neue Inhalte zu entdecken. Google AI Overviews nutzt die bestehende Crawl-Infrastruktur von Google, daher kann die Indexierung innerhalb von Stunden bis Tagen erfolgen. Perplexity legt Wert auf Echtzeit-Websuche, sodass aktuelle Inhalte schnell in den Antworten erscheinen können. Die Verwendung von XML-Sitemaps und das Anfordern der Indexierung über Webmaster-Tools kann den Prozess beschleunigen.

KI-Index-Abdeckung und traditionelles Suchmaschinenranking hängen zusammen, sind aber unterschiedlich. Die Optimierung für die KI-Index-Abdeckung (über Schema-Markup, Seitenstruktur und Zugänglichkeit) verbessert auch die traditionelle SEO. Eine Seite kann jedoch in Google gut ranken und trotzdem selten von KI-Systemen zitiert werden – oder umgekehrt. Die beste Strategie ist die Optimierung für beides: Traditionelle SEO-Praktiken erhöhen die Sichtbarkeit in der Suche, während KI-spezifische Optimierungen die KI-Index-Abdeckung verbessern.

Die häufigsten Gründe sind: 1) Zu restriktive robots.txt-Dateien, die versehentlich KI-Crawler blockieren, 2) Fehlendes oder unvollständiges Schema-Markup, das KI-Systemen das Verständnis des Inhaltskontexts erschwert, 3) JavaScript-lastige Seiten ohne serverseitiges Rendering, die KI-Crawler nicht verarbeiten können, und 4) Schlechte Seitenstruktur, die es Crawlern schwer macht, Inhalte zu erfassen. Die Behebung dieser technischen Probleme verbessert die KI-Index-Abdeckung in der Regel erheblich.

Sie können die KI-Index-Abdeckung mit Tools wie AmICited.com überwachen, die zeigen, wie Ihre Marke in ChatGPT, Google AI Overviews, Perplexity und anderen KI-Systemen erscheint. Achten Sie auf Kennzahlen wie Zitierhäufigkeit, Share of Voice im Vergleich zu Wettbewerbern und die Stimmung der Erwähnungen. Sie können auch manuell testen, indem Sie in KI-Systemen nach Ihrer Marke und wichtigen Themen suchen und prüfen, ob Ihre Inhalte in den Antworten erscheinen.

Obwohl es nicht zwingend erforderlich ist, verbessert Schema-Markup die KI-Index-Abdeckung erheblich. Strukturierte Daten (JSON-LD) helfen KI-Systemen, den Inhaltskontext zu verstehen, Informationen genau zu extrahieren und die Relevanz zu bestimmen. Seiten mit korrektem Schema-Markup für Produkte, Artikel, FAQs und Organisationen werden mit größerer Wahrscheinlichkeit von KI-Systemen indexiert und zitiert. Es gilt als Best Practice zur Optimierung der KI-Index-Abdeckung.

Verfolgen Sie, wie KI-Systeme Ihre Marke in ChatGPT, Google AI Overviews, Perplexity und mehr entdecken und zitieren. Erhalten Sie Echtzeit-Einblicke in Ihre KI-Sichtbarkeit, Zitierhäufigkeit und Ihren Share of Voice in KI-generierten Antworten.

Die Indexabdeckung misst, welche Webseiten von Suchmaschinen indexiert werden. Erfahren Sie, was das bedeutet, warum es für SEO wichtig ist und wie Sie Indexier...

Erfahren Sie, wie KI-Suchindexierung Daten in durchsuchbare Vektoren umwandelt, sodass KI-Systeme wie ChatGPT und Perplexity relevante Informationen aus Ihren I...

Erfahren Sie, wie KI-Engines wie ChatGPT, Perplexity und Gemini Webinhalte mithilfe fortschrittlicher Crawler, NLP und maschinellem Lernen indexieren und verarb...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.