Kontextfenster

Kontextfenster erklärt: die maximale Anzahl an Tokens, die ein LLM auf einmal verarbeiten kann. Erfahren Sie, wie Kontextfenster die KI-Genauigkeit, Halluzinati...

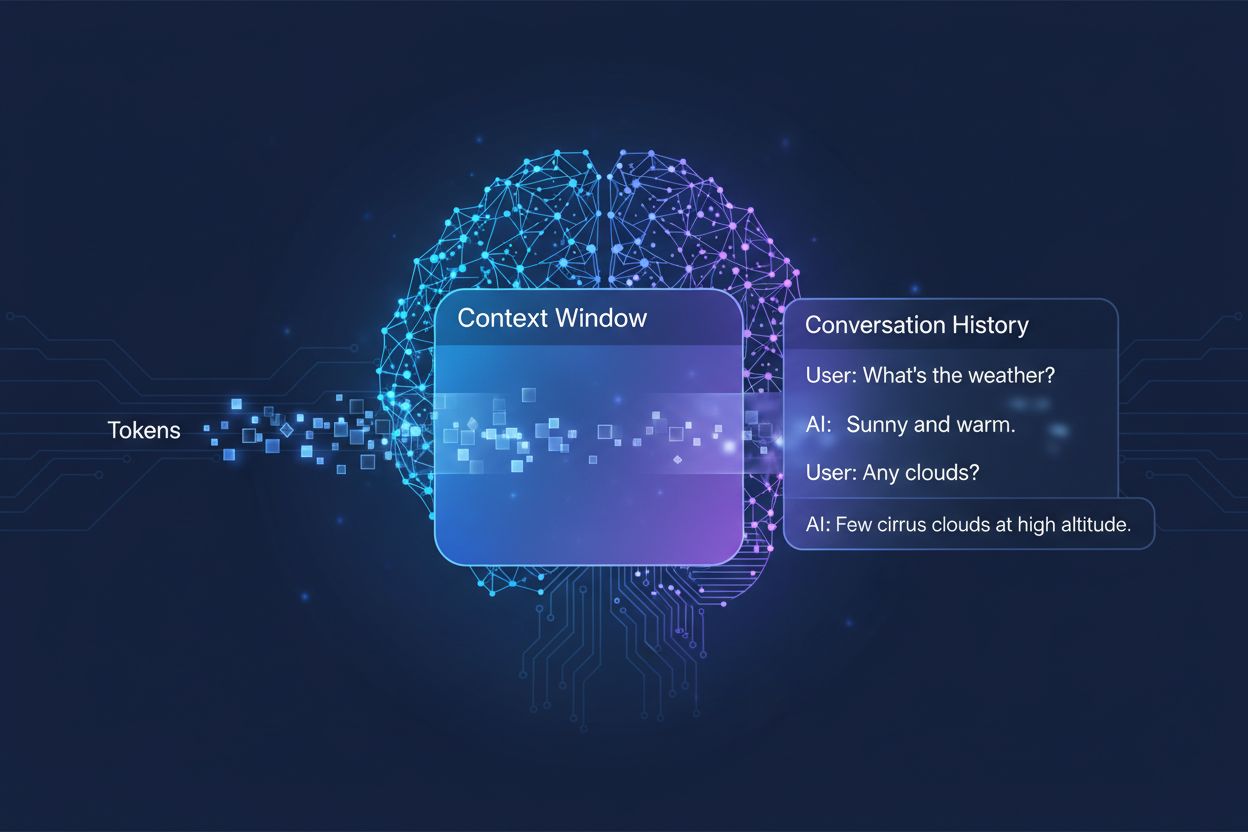

Die Menge an vorherigem Gespräch, die ein KI-System bei der Generierung von Antworten berücksichtigt, gemessen in Tokens. Sie bestimmt, wie viel Text eine KI gleichzeitig verarbeiten kann und wirkt sich direkt auf die Qualität und Kohärenz ihrer Ausgaben in mehrstufigen Konversationen aus.

Die Menge an vorherigem Gespräch, die ein KI-System bei der Generierung von Antworten berücksichtigt, gemessen in Tokens. Sie bestimmt, wie viel Text eine KI gleichzeitig verarbeiten kann und wirkt sich direkt auf die Qualität und Kohärenz ihrer Ausgaben in mehrstufigen Konversationen aus.

Ein Kontextfenster ist die maximale Menge an Text, die ein KI-Sprachmodell während eines Gesprächs oder einer Aufgabe gleichzeitig verarbeiten und referenzieren kann. Man kann es sich als das Arbeitsgedächtnis des Modells vorstellen – genauso wie Menschen nur eine begrenzte Informationsmenge im unmittelbaren Bewusstsein behalten können, kann eine KI nur eine bestimmte Menge Text vor und nach ihrer aktuellen Position „sehen“. Diese Kapazität wird in Tokens gemessen, das sind kleine Texteinheiten, die normalerweise Wörter oder Wortfragmente darstellen (im Durchschnitt entspricht ein englisches Wort etwa 1,5 Tokens). Das Verständnis für das Kontextfenster Ihres Modells ist entscheidend, da es direkt bestimmt, wie viele Informationen die KI bei der Generierung von Antworten berücksichtigen kann. Es ist also eine grundlegende Beschränkung dafür, wie effektiv das Modell mit komplexen, mehrstufigen Gesprächen oder langen Dokumenten umgehen kann.

Moderne Sprachmodelle, insbesondere transformerbasierte Architekturen, verarbeiten Text, indem sie ihn in Tokens umwandeln und dann die Beziehungen zwischen allen Tokens innerhalb des Kontextfensters gleichzeitig analysieren. Die Transformer-Architektur, eingeführt im wegweisenden Paper „Attention is All You Need“ von 2017, nutzt einen Mechanismus namens Self-Attention, um zu bestimmen, welche Teile des Inputs für einander am relevantesten sind. Dieser Attention-Mechanismus ermöglicht es dem Modell, die Bedeutung und Wichtigkeit verschiedener Tokens zueinander zu gewichten und so Kontext und Sinn über das gesamte Fenster hinweg zu verstehen. Dieser Prozess wird jedoch mit wachsendem Kontextfenster rechnerisch immer aufwändiger, da der Attention-Mechanismus die Beziehungen zwischen jedem Token und allen anderen Tokens berechnen muss – ein Problem mit quadratischer Skalierung. Die folgende Tabelle zeigt, wie verschiedene führende KI-Modelle in Bezug auf ihre Kontextfenster-Fähigkeiten abschneiden:

| Modell | Kontextfenster (Tokens) | Veröffentlichungsdatum |

|---|---|---|

| GPT-4 | 128.000 | März 2023 |

| Claude 3 Opus | 200.000 | März 2024 |

| Gemini 1.5 Pro | 1.000.000 | Mai 2024 |

| GPT-4 Turbo | 128.000 | November 2023 |

| Llama 2 | 4.096 | Juli 2023 |

Diese unterschiedlichen Kapazitäten spiegeln verschiedene Designentscheidungen und rechnerische Kompromisse der jeweiligen Organisationen wider. Größere Fenster ermöglichen anspruchsvollere Anwendungen, erfordern aber mehr Rechenleistung.

Der Weg zu größeren Kontextfenstern zählt zu den bedeutendsten Fortschritten der KI im letzten Jahrzehnt. Frühe rekurrente neuronale Netze (RNNs) und Long Short-Term Memory (LSTM)-Modelle hatten Schwierigkeiten mit dem Kontext, da sie Text sequentiell verarbeiteten und Informationen aus weiter zurückliegenden Teilen des Inputs nur schwer behalten konnten. Der Durchbruch kam 2017 mit der Einführung der Transformer-Architektur, die parallele Verarbeitung ganzer Sequenzen ermöglichte und die Fähigkeit des Modells, Kontext über längere Texte hinweg zu halten, dramatisch verbesserte. Darauf folgte GPT-2 (2019) mit einem Kontextfenster von 1.024 Tokens, GPT-3 (2020) mit 2.048 Tokens und schließlich GPT-4 (2023) mit 128.000 Tokens. Jeder Fortschritt war bedeutend, weil er neue Möglichkeiten eröffnete: Größere Fenster erlaubten es Modellen, längere Dokumente zu verarbeiten, Kohärenz über mehrstufige Gespräche hinweg zu wahren und komplexe Beziehungen zwischen weit entfernten Konzepten im Text zu verstehen. Das exponentielle Wachstum der Kontextfenstergrößen spiegelt sowohl architektonische Innovationen als auch die Zunahme an Rechenressourcen in führenden KI-Laboren wider.

Größere Kontextfenster erweitern grundlegend die Einsatzmöglichkeiten von KI-Modellen und ermöglichen Anwendungen, die zuvor unmöglich oder stark eingeschränkt waren. Hier die wichtigsten Vorteile:

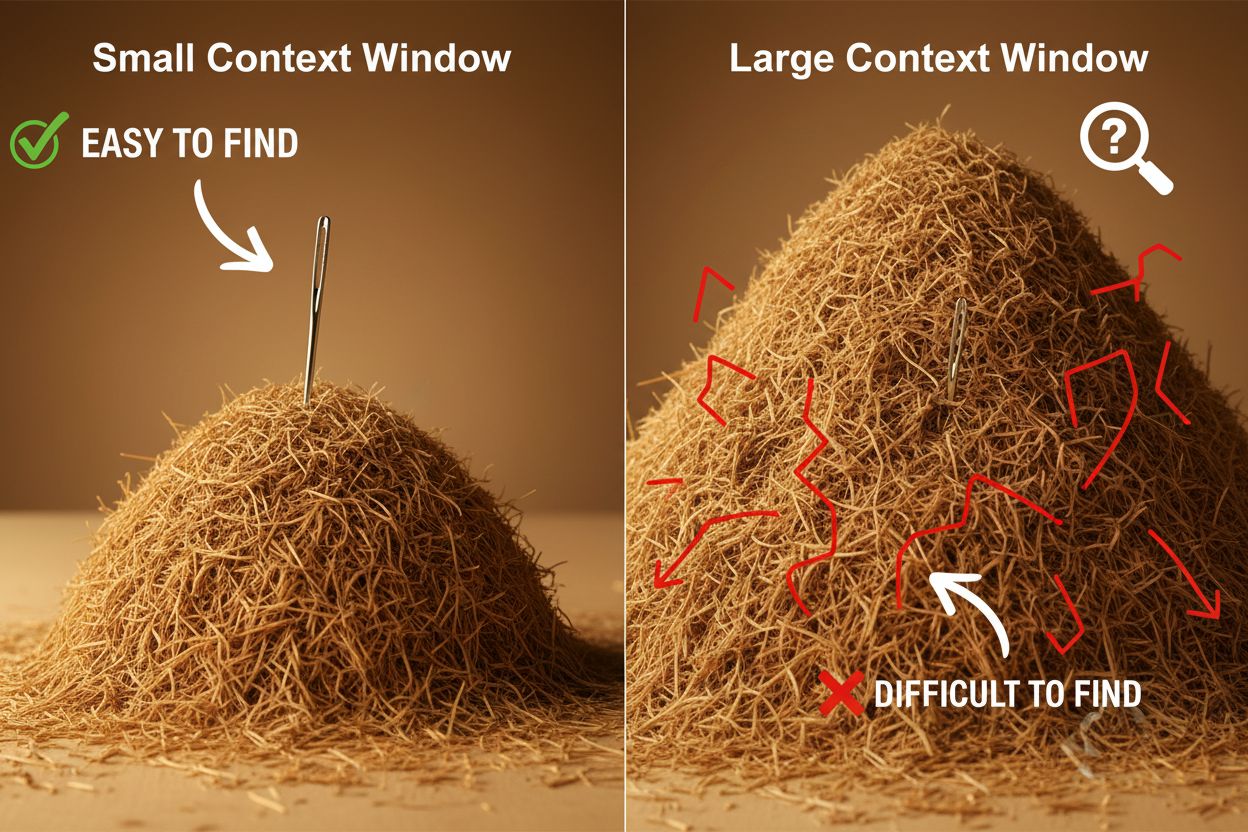

Trotz ihrer Vorteile bringen große Kontextfenster erhebliche technische und praktische Herausforderungen mit sich, die sorgfältig adressiert werden müssen. Die offensichtlichste Herausforderung sind die Rechenkosten: Die Verarbeitung längerer Sequenzen erfordert exponentiell mehr Speicher und Rechenleistung durch die quadratische Skalierung des Attention-Mechanismus. Größere Fenster sind daher deutlich teurer im Betrieb. Der erhöhte Rechenbedarf führt auch zu Latenzproblemen, da größere Kontextfenster längere Antwortzeiten bedeuten – ein kritischer Punkt für Anwendungen, die Echtzeitreaktionen erfordern. Ein weiteres, weniger offensichtliches, aber wichtiges Problem ist das „Nadel-im-Heuhaufen“-Phänomen: Modelle haben Schwierigkeiten, relevante Informationen zu finden und zu nutzen, wenn diese in einem sehr großen Kontextfenster verborgen sind, und schneiden manchmal schlechter ab als mit kleineren Fenstern. Zusätzlich tritt Kontextverfall auf, wenn Informationen vom Anfang eines langen Kontextfensters im Modelloutput weniger Einfluss haben, da der Attention-Mechanismus weiter entfernte Tokens zugunsten aktuellerer vernachlässigt. Daraus folgt: Die Vergrößerung des Kontextfensters ist nicht immer die beste Lösung für jeden Anwendungsfall.

Das Verständnis von Kontextverfall ist essenziell für den effektiven Umgang mit großen Kontextfenstern: Mit wachsender Sequenzlänge verlieren Tokens am Anfang des Kontexts zunehmend an Einfluss auf den Modelloutput – wichtige Informationen werden so praktisch „vergessen“, obwohl sie technisch noch im Fenster liegen. Das liegt daran, dass das Attention-Budget – also die Fähigkeit des Modells, allen Tokens sinnvoll Aufmerksamkeit zu schenken – sich mit zunehmender Textlänge immer weiter verteilt. Glücklicherweise gibt es inzwischen mehrere fortschrittliche Techniken, die diese Einschränkungen adressieren. Retrieval-Augmented Generation (RAG) speichert Informationen in externen Datenbanken und ruft bei Bedarf nur die relevantesten Abschnitte ab, sodass das Modell einen größeren effektiven Wissensstand hat, ohne ein riesiges Kontextfenster zu benötigen. Kontextverdichtung fasst weniger relevante Informationen zusammen oder komprimiert sie, um die wichtigsten Details bei geringerem Tokenverbrauch zu erhalten. Strukturiertes Notieren empfiehlt, Informationen hierarchisch zu organisieren, damit das Modell Schlüsselkonzepte leichter priorisieren und auffinden kann. All diese Lösungen setzen darauf, gezielt zu bestimmen, welche Informationen ins Kontextfenster gelangen und wie sie strukturiert werden – anstatt einfach alles ins Arbeitsgedächtnis zu laden.

Die erweiterten Kontextfenster moderner KI-Modelle haben zahlreiche reale Anwendungen ermöglicht, die zuvor undenkbar oder unpraktisch waren. Kundensupportsysteme können nun die gesamte Ticket-Historie und zugehörige Dokumentation in einer einzigen Anfrage überprüfen, um präzisere und kontextgerechtere Antworten zu geben, ohne dass Kunden ihre Situation wiederholt erklären müssen. Dokumentenanalyse und Forschung wurden durch Modelle revolutioniert, die ganze Forschungsarbeiten, Verträge oder technische Spezifikationen aufnehmen und daraus Schlüsselinformationen extrahieren sowie detaillierte Fragen beantworten können – Aufgaben, für die Menschen oft Stunden benötigen würden. Code-Review und Softwareentwicklung profitieren von Kontextfenstern, die groß genug sind, um ganze Dateien oder mehrere zusammenhängende Dateien zu erfassen, sodass die KI Architektur-Muster erkennt und intelligentere Vorschläge machen kann. Langform-Inhaltserstellung und iterative Schreibprozesse werden effizienter, wenn das Modell den gesamten Ton, Stil und Spannungsbogen eines Dokuments während der Bearbeitung im Blick behalten kann. Besprechungstranskription und Forschungssynthese nutzen große Kontextfenster, um aus stundenlangen Gesprächen oder Dutzenden von Quellen Erkenntnisse zu extrahieren, die manuell schwer aufzufinden wären. Diese Anwendungen zeigen: Die Größe des Kontextfensters übersetzt sich direkt in praktischen Mehrwert für Fachleute verschiedenster Branchen.

Die Entwicklungstrends bei Kontextfenstern deuten darauf hin, dass uns kurzfristig noch dramatischere Erweiterungen bevorstehen – Gemini 1.5 Pro demonstriert bereits ein Kontextfenster von 1.000.000 Tokens, und Forschungslabore arbeiten an noch größeren Kapazitäten. Über die reine Größe hinaus wird die Zukunft wahrscheinlich von dynamischen Kontextfenstern geprägt, die ihre Größe intelligent an die jeweilige Aufgabe anpassen: mehr Kapazität für komplexe Fragen, weniger für einfache – das steigert die Effizienz und senkt die Kosten. Auch bei effizienteren Attention-Mechanismen werden Fortschritte erzielt, die die rechnerische Belastung großer Fenster reduzieren und so die derzeitige Skalierungsgrenze möglicherweise überwinden. Sobald diese Technologien ausgereift sind, wird das Kontextfenster weniger Einschränkung und mehr gelöstes Problem sein – Entwickler können sich dann auf andere Aspekte der KI-Fähigkeiten und -Zuverlässigkeit konzentrieren. Die Kombination aus größeren Fenstern, besserer Effizienz und intelligenterem Kontextmanagement wird die nächste Generation von KI-Anwendungen bestimmen – und so Anwendungsfälle ermöglichen, die wir uns heute noch nicht vorstellen können.

Ein Kontextfenster ist die Gesamtmenge an Text (gemessen in Tokens), die ein KI-Modell gleichzeitig verarbeiten kann, während sich das Token-Limit auf die maximale Anzahl von Tokens bezieht, die das Modell verarbeiten kann. Diese Begriffe werden oft synonym verwendet, aber das Kontextfenster bezieht sich speziell auf den verfügbaren Arbeitsspeicher während einer einzelnen Inferenz, während das Token-Limit auch Ausgabebeschränkungen oder API-Nutzungsgrenzen umfassen kann.

Größere Kontextfenster verbessern in der Regel die Antwortqualität, da das Modell mehr relevante Informationen berücksichtigen und eine bessere Kontinuität im Gespräch aufrechterhalten kann. Allerdings können extrem große Fenster manchmal die Qualität beeinträchtigen, da es zu Kontextverfall kommt: Das Modell hat Schwierigkeiten, wichtige Informationen unter einer großen Menge Text zu priorisieren. Die optimale Größe des Kontextfensters hängt von der jeweiligen Aufgabe und der Organisation der Informationen ab.

Größere Kontextfenster erfordern mehr Rechenleistung aufgrund der quadratischen Skalierung des Attention-Mechanismus in Transformermodellen. Der Attention-Mechanismus muss die Beziehungen zwischen jedem Token und allen anderen Tokens berechnen. Wenn sich das Kontextfenster verdoppelt, vervierfachen sich die Rechenanforderungen etwa. Deshalb sind größere Kontextfenster teurer im Betrieb und führen zu langsameren Antwortzeiten.

Das 'Nadel im Heuhaufen'-Problem tritt auf, wenn ein KI-Modell Schwierigkeiten hat, relevante Informationen (die 'Nadel') zu finden und zu nutzen, wenn diese in einem sehr großen Kontextfenster (dem 'Heuhaufen') verborgen sind. Modelle schneiden manchmal mit extrem großen Kontextfenstern schlechter ab, weil der Attention-Mechanismus auf sehr viele Informationen verteilt wird, was es erschwert, das wirklich Wichtige zu erkennen.

Um die Effektivität des Kontextfensters zu maximieren, sollten Informationen klar und hierarchisch organisiert werden, die wichtigsten Informationen am Anfang oder Ende des Kontexts platziert, strukturierte Formate wie JSON oder Markdown verwendet und Retrieval-Augmented Generation (RAG) genutzt werden, um dynamisch nur die relevantesten Informationen zu laden. Vermeiden Sie es, das Modell mit irrelevanten Details zu überfrachten, die Tokens verbrauchen, ohne Mehrwert zu bieten.

Das Kontextfenster ist die technische Kapazität des Modells, Text auf einmal zu verarbeiten, während der Gesprächsverlauf den tatsächlichen Verlauf vorheriger Nachrichten in einer Unterhaltung darstellt. Der Gesprächsverlauf muss in das Kontextfenster passen, aber das Kontextfenster beinhaltet auch Platz für System-Prompts, Anweisungen und andere Metadaten. Ein Gesprächsverlauf kann länger als das Kontextfenster sein, was eine Zusammenfassung oder Kürzung erforderlich macht.

Derzeit gibt es keine KI-Modelle mit wirklich unbegrenzten Kontextfenstern, da alle Modelle architektonische und rechnerische Beschränkungen haben. Allerdings bieten einige Modelle wie Gemini 1.5 Pro extrem große Fenster (1.000.000 Tokens), und Techniken wie Retrieval-Augmented Generation (RAG) können den effektiven Wissensstand des Modells über sein Kontextfenster hinaus erweitern, indem bei Bedarf Informationen dynamisch abgerufen werden.

Die Größe des Kontextfensters wirkt sich direkt auf die API-Kosten aus, da größere Fenster mehr Rechenressourcen für die Verarbeitung benötigen. Die meisten KI-API-Anbieter berechnen nach Token-Nutzung, das heißt, ein größeres Kontextfenster bedeutet mehr verarbeitete Tokens und höhere Kosten. Einige Anbieter verlangen auch Premiumpreise für Modelle mit größeren Kontextfenstern, weshalb es wichtig ist, die richtige Modellgröße für Ihre spezifischen Anforderungen zu wählen.

AmICited verfolgt, wie KI-Systeme wie ChatGPT, Perplexity und Google AI Overviews Ihre Inhalte zitieren und referenzieren. Verstehen Sie Ihre KI-Sichtbarkeit und überwachen Sie Ihre Marken-Erwähnungen auf KI-Plattformen.

Kontextfenster erklärt: die maximale Anzahl an Tokens, die ein LLM auf einmal verarbeiten kann. Erfahren Sie, wie Kontextfenster die KI-Genauigkeit, Halluzinati...

Erfahren Sie, was Kontextfenster in KI-Sprachmodellen sind, wie sie funktionieren, welchen Einfluss sie auf die Modellleistung haben und warum sie für KI-gestüt...

Community-Diskussion über KI-Kontextfenster und deren Auswirkungen auf das Content-Marketing. Verstehen, wie Kontextgrenzen die KI-Verarbeitung Ihrer Inhalte be...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.