Panda-Update

Erfahren Sie mehr über Googles Panda-Update, die Algorithmus-Änderung von 2011, die auf minderwertige Inhalte abzielt. Verstehen Sie, wie es funktioniert, seine...

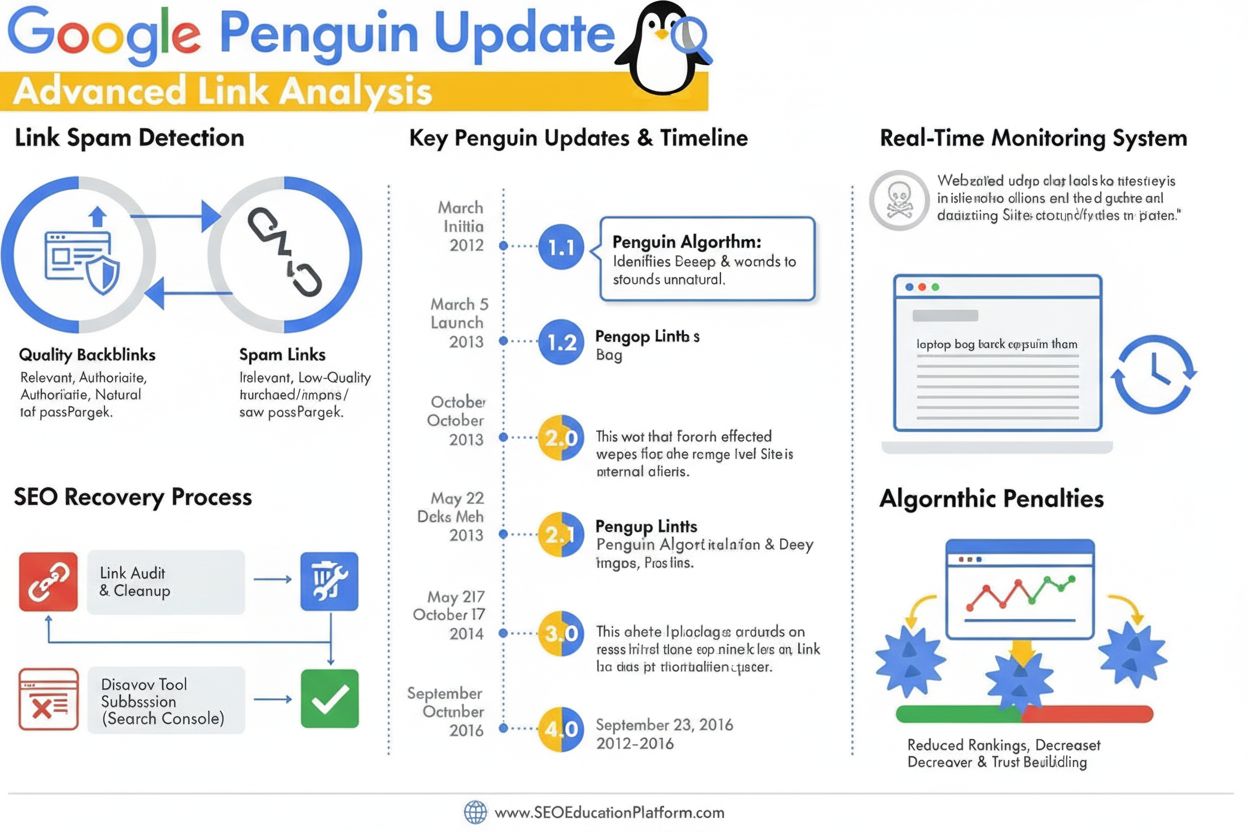

Das Penguin-Update ist ein Google-Algorithmus, der entwickelt wurde, um Link-Spam und manipulative Linkaufbaupraktiken zu bekämpfen, indem minderwertige, unnatürliche Backlinks erkannt und entwertet werden. Erstmals im April 2012 gestartet, wurde er 2016 zu einer Echtzeit-Komponente, die kontinuierlich Rankings anhand der Qualität der Backlinks und Mustern von Linknetzwerken überwacht und anpasst.

Das Penguin-Update ist ein Google-Algorithmus, der entwickelt wurde, um Link-Spam und manipulative Linkaufbaupraktiken zu bekämpfen, indem minderwertige, unnatürliche Backlinks erkannt und entwertet werden. Erstmals im April 2012 gestartet, wurde er 2016 zu einer Echtzeit-Komponente, die kontinuierlich Rankings anhand der Qualität der Backlinks und Mustern von Linknetzwerken überwacht und anpasst.

Das Penguin-Update ist ein Google-Algorithmus, der speziell entwickelt wurde, um Link-Spam und manipulative Linkaufbau-Praktiken zu bekämpfen, indem Websites mit unnatürlichen oder minderwertigen Backlink-Profilen identifiziert, entwertet und abgestraft werden. Erstmals am 24. April 2012 offiziell von Matt Cutts angekündigt, stellte der Penguin-Algorithmus Googles entschlossene Reaktion auf das wachsende Problem von Black-Hat-SEO-Techniken dar, mit denen Suchrankings durch gekaufte Links, Linktausch und andere irreführende Methoden künstlich erhöht wurden. Das Hauptziel des Algorithmus ist es, natürliche, autoritative und relevante Links zu belohnen, während manipulative und spammy Links herabgestuft oder vollständig ignoriert werden. Im Gegensatz zu inhaltsfokussierten Updates wie Panda, das auf minderwertige Inhalte abzielt, bewertet Penguin gezielt die Qualität und Authentizität des eingehenden Linkprofils einer Website und ist damit seit über einem Jahrzehnt ein zentrales Element im Google-Ranking-System.

Das Penguin-Update entstand in einer entscheidenden Phase der Suchmaschinenoptimierung, als das Linkvolumen eine überproportional große Rolle bei der Bestimmung von Suchrankings spielte. Vor der Einführung von Penguin konnten Webmaster ihre Rankings künstlich steigern, indem sie große Mengen minderwertiger Links von Linkfarmen, Private Blog Networks und anderen Spam-Quellen erwarben. Diese Praxis führte zu erheblichen Problemen in den Google-Suchergebnissen, da minderwertige Websites und Inhalte trotz fehlender Autorität oder Relevanz auf prominenten Positionen erschienen. Matt Cutts, damaliger Leiter des Google-Webspam-Teams, erklärte auf der SMX Advanced 2012: “Wir betrachten es als etwas, das auf minderwertige Inhalte abzielt. Es begann mit Panda, und dann stellten wir fest, dass immer noch viel Spam vorhanden war, und Penguin wurde entwickelt, um das zu bekämpfen.” Der erste Penguin-Launch betraf mehr als 3 % aller Suchanfragen und war damit eines der einflussreichsten Algorithmus-Updates in der Geschichte von Google. Diese enorme Auswirkung signalisierte der SEO-Branche, dass Google einen konsequenten Kurs gegen manipulative Linkpraktiken eingeschlagen hatte und seine Algorithmen weiterentwickeln würde, um die Suchqualität zu sichern.

Der Penguin-Algorithmus arbeitet mit ausgefeilten Machine-Learning- und Mustererkennungssystemen, die Backlink-Profile analysieren, um unnatürliche Linkmuster zu identifizieren. Der Algorithmus prüft verschiedene Faktoren bei der Bewertung der Linkqualität, darunter die Autorität und Relevanz der verlinkenden Domains, den Ankertext der Links, die Geschwindigkeit der Linkgewinnung und die thematische Relevanz zwischen der verlinkenden und der Zielseite. Penguin zielt gezielt auf Linknetzwerke ab, die eine breite Palette manipulativer Praktiken umfassen, darunter gekaufte Links, gegenseitige Linktauschaktionen, Links aus Private Blog Networks (PBNs), Links aus minderwertigen Verzeichnissen und Links mit übermäßig keyword-lastigem Ankertext. Der Algorithmus bewertet auch das Verhältnis von hochwertigen zu minderwertigen Links in einem Backlink-Profil und erkennt dabei an, dass auch seriöse Websites gelegentlich einige minderwertige Links erhalten. Wird jedoch der Anteil an Spam-Links unverhältnismäßig hoch, markiert Penguin die Seite für mögliche Ranking-Anpassungen. Ein entscheidender Aspekt des Penguin-Designs ist, dass ausschließlich eingehende Links zu einer Website bewertet werden; ausgehende Links von der Seite werden nicht analysiert – der Fokus liegt ausschließlich auf der Qualität der auf eine Domain verweisenden Backlinks.

Das Penguin-Update hat sich seit seiner Einführung über mehrere Iterationen hinweg erheblich weiterentwickelt, wobei die bedeutendste Veränderung im September 2016 mit der Veröffentlichung von Penguin 4.0 eintrat. Vor diesem Meilenstein arbeitete Penguin nach einem Batch-Update-Plan, bei dem Google periodisch Aktualisierungen ankündigte, die die Backlink-Profile der Websites neu bewerteten und die Rankings entsprechend anpassten. Penguin 1.1 (März 2012) und Penguin 1.2 (Oktober 2012) waren Datenaktualisierungen, die zuvor abgestrafte Seiten eine Erholung ermöglichten, sofern sie ihre Linkprofile bereinigt hatten. Penguin 2.0 (Mai 2013) war eine technisch fortschrittlichere Version, die etwa 2,3 % der englischsprachigen Suchanfragen betraf und erstmals über die Startseite und Top-Level-Kategorien hinaus ging, um auch tiefere Seitenstrukturen auf Link-Spam zu überprüfen. Penguin 2.1 (Oktober 2013) und Penguin 3.0 (Oktober 2014) setzten diese Entwicklung mit inkrementellen Verbesserungen der Erkennungsfähigkeiten fort. Mit Penguin 4.0 wurde der Algorithmus jedoch grundlegend verändert, indem er in den Google-Kernalgorithmus als Echtzeit-Komponente integriert wurde. Das bedeutet, dass Websites fortlaufend geprüft werden und Ranking-Anpassungen sofort erfolgen, sobald sich das Linkprofil ändert – ein Warten auf geplante Updates entfällt. Der Wechsel zur Echtzeitverarbeitung veränderte auch den Strafmechanismus: Statt vollständiger Ranking-Strafen werden nun Spam-Links einfach entwertet, anstatt zu einem Rankingverlust der gesamten Website zu führen.

| Bewertungsfaktor | Hochwertige Links | Minderwertige/Spam-Links | Penguin-Erkennung |

|---|---|---|---|

| Autorität der Linkquelle | Etablierte, vertrauenswürdige Domains mit hoher Domain-Autorität | Neue Domains, Seiten mit niedriger DA oder bekannte Spam-Netzwerke | Analysiert Domainhistorie, Vertrauenssignale und thematische Relevanz |

| Ankertext | Natürlich, variabel, thematisch passend | Exakte Keywords, sich wiederholend, überoptimiert | Markiert unnatürliche Ankertextmuster und Keyword-Stuffing |

| Link-Gewinnungsrate | Allmählich, organisch über die Zeit | Plötzliche Anstiege oder unnatürliche Muster | Überwacht Geschwindigkeit und Konsistenz der Linkgewinnung |

| Thematische Relevanz | Links aus thematisch verwandten, autoritativen Quellen | Links aus themenfremden oder minderwertigen Quellen | Bewertet semantische Relevanz zwischen Linkquelle und Zielseite |

| Linkplatzierung | Redaktionell im Content eingebettet, natürlicher Kontext | Footer-Links, Sidebar-Links oder Linkfarm-Platzierungen | Bewertet Linkplatzierung und Einbettung im Kontext |

| Qualität der verlinkenden Seite | Hochwertiger Content, seriöse Unternehmenspräsenz | Dünner Content, automatisch generierte Seiten, PBNs | Untersucht Gesamtqualität und Authentizität des Inhalts |

| Nofollow-Status | Korrekte Kennzeichnung, wenn angebracht | Missbräuchlich verwendet oder fehlt bei bezahlten/werblichen Links | Erkennt korrekten Einsatz von Nofollow bei nicht-redaktionellen Links |

Das Penguin-Update hat SEO-Praktiken grundlegend verändert, indem es die Linkqualität zu einem entscheidenden Rankingfaktor machte und die weitverbreitete Nutzung von Black-Hat-Linkbuilding-Techniken unterband. Vor Penguin betrieben viele SEO-Agenturen und Webmaster aggressive Linkkaufkampagnen, Linktausch und PBN-Aufbau ohne größere Konsequenzen. Die Einführung des Algorithmus führte zu unmittelbaren Marktverwerfungen, da tausende Websites starke Ranking- und Trafficverluste erlebten. Dadurch wurde die SEO-Branche gezwungen, ethischere, White-Hat-Praktiken zu übernehmen, die auf den Erwerb von Links durch hochwertigen Content und echte Beziehungen setzen. Die Penguin-Strafe wurde zu einer abschreckenden Geschichte, die Unternehmen dazu veranlasste, beim Linkaufbau verstärkt auf Content-Marketing, Public Relations und Markenaufbau zu setzen. Branchenstudien zeigen, dass das Verständnis und die Einhaltung der Penguin-Anforderungen für nachhaltigen SEO-Erfolg unerlässlich wurden, weshalb viele Unternehmen Backlink-Audits und Link-Monitoring als Standard etabliert haben. Der Algorithmus erhöhte zudem die Bedeutung von Domain-Autorität, thematischer Relevanz und Link-Gewinnungsrate als zentrale Kennzahlen, die SEO-Profis bei der Bewertung von Linkmöglichkeiten überwachen. Über 78 % der Unternehmen nutzen heute eine Form von KI-gestütztem Content-Monitoring oder Link-Analyse-Tools, um ihre Backlink-Profile zu überwachen und die Einhaltung der Google-Qualitätsrichtlinien sicherzustellen – eine direkte Folge des Einflusses von Penguin auf die Branchenstandards.

Die Erholung von einem Penguin-Downgrade erfordert einen systematischen Ansatz mit Backlink-Audits, Linkentfernung und dem gezielten Einsatz des Disavow-Tools von Google. Zunächst sollte ein umfassendes Audit aller eingehenden Links mit der Google Search Console und Drittanbieter-Tools wie Ahrefs, SEMrush oder Moz durchgeführt werden, die detaillierte Backlink-Profile und Qualitätsbewertungen liefern. Webmaster müssen dann jede verlinkende Domain einzeln bewerten, um zu entscheiden, ob der Link hochwertig und natürlich ist oder eine manipulative Praxis darstellt. Für eindeutig spammy oder minderwertige Links empfiehlt es sich, den Webmaster der verlinkenden Seite zu kontaktieren und um Entfernung zu bitten. Google rät ausdrücklich davon ab, für Linkentfernungen zu bezahlen, da dies das Link-Geschäft weiter fördert. Links, die nicht entfernt werden können, können mit dem Disavow-Tool in der Google Search Console eingereicht werden, sodass Google sie bei der Bewertung der Seite ignoriert. Es ist zu beachten, dass disavowte Links auch keinen positiven Wert mehr liefern, daher sollte das Tool nur bei wirklich schädlichen Links verwendet werden. Nach Einreichung der Disavow-Datei verarbeitet Google diese umgehend, die tatsächliche Auswirkung auf das Ranking hängt jedoch davon ab, wann Google die disavowten Links erneut crawlt. Da Penguin 4.0 in Echtzeit arbeitet, kann die Erholung relativ schnell erfolgen – manchmal innerhalb von Tagen oder Wochen –, sobald ausreichende Korrekturmaßnahmen ergriffen wurden. Webmaster sollten jedoch nicht erwarten, dass die Rankings auf das Niveau vor der Strafe zurückkehren, da einige dieser Platzierungen möglicherweise künstlich durch die entfernten minderwertigen Links erzielt wurden.

Da KI-Suchplattformen wie ChatGPT, Perplexity, Google AI Overviews und Claude für die Markenpräsenz immer wichtiger werden, sind die Penguin-Prinzipien auch über die klassischen Suchrankings hinaus relevant. Diese KI-Systeme zitieren häufig autoritative Quellen und hochwertige Websites, wenn sie Antworten generieren, und Websites mit starken Backlink-Profilen und sauberer Linkhistorie werden mit größerer Wahrscheinlichkeit von KI-Trainingsdaten und Retrieval-Systemen als autoritativ erkannt. Eine Website, die von Penguin wegen Link-Spam abgestraft wurde, kann nicht nur in den organischen Google-Suchergebnissen leiden, sondern auch von KI-Systemen, die Quellenbewertung betreiben, weniger beachtet werden. Umgekehrt werden Websites mit einem sauberen, hochwertigen Backlink-Profil eher als autoritative Quellen in KI-generierten Antworten genannt. Das schafft einen zusätzlichen Anreiz, die Penguin-Compliance auch jenseits traditioneller SEO-Kennzahlen einzuhalten. AmICited und ähnliche KI-Monitoring-Plattformen helfen Unternehmen dabei, zu überwachen, wie ihre Domains in KI-generierten Antworten erscheinen und ob ihre Autorität über verschiedene KI-Suchsysteme hinweg anerkannt wird. Die Schnittstelle von Penguin-Compliance und KI-Zitations-Tracking eröffnet eine neue Ära im digitalen Marketing, in der die Linkqualität sowohl die klassische Sichtbarkeit als auch die Präsenz in KI-Suchergebnissen beeinflusst.

Das Penguin-Update entwickelt sich stetig weiter, da Google sein Verständnis von Linkqualität und manipulativen Praktiken verfeinert. Der Wechsel zur Echtzeitverarbeitung 2016 war ein grundlegender Wandel in der Funktionsweise des Algorithmus, aber Google verbessert seine Erkennungsfähigkeiten weiterhin durch Machine Learning und Künstliche Intelligenz. Die jüngsten Entwicklungen am SpamBrain-System von Google, die 2022 bekannt gegeben wurden, markieren die nächste Evolutionsstufe der Spamerkennung, indem fortschrittliche KI sowohl Seiten erkennt, die Links kaufen, als auch solche, die Links verteilen. Es ist zu erwarten, dass zukünftige Versionen der Link-Spam-Erkennung noch ausgefeilter werden und manipulative Praktiken schwerer unentdeckt bleiben. Der Branchentrend zu White-Hat-SEO und Earned Media wird sich wahrscheinlich weiter beschleunigen, da Googles Algorithmen immer effektiver zwischen natürlichen und künstlichen Links unterscheiden. Mit dem Bedeutungsgewinn von KI-Suchplattformen reicht die Bedeutung eines sauberen Backlink-Profils über Googles Algorithmus hinaus und ist Voraussetzung, um als Autorität auch in mehreren KI-Systemen anerkannt zu werden. Unternehmen, die auf Linkqualität, Markenautorität und Content-Exzellenz setzen, werden sowohl im klassischen als auch im KI-Suchumfeld besser positioniert sein. Das Penguin-Update steht dabei nicht nur für einen einzelnen Algorithmus, sondern für einen grundlegenden Wandel darin, wie Suchmaschinen und KI-Systeme Website-Autorität bewerten – und macht die Linkqualität zu einem dauerhaften, immer wichtigeren Faktor für digitale Sichtbarkeit.

Ein Penguin-Downgrade ist algorithmisch und erfolgt automatisch, wenn Googles Penguin-Algorithmus Link-Spam-Muster erkennt, ohne dass ein manueller Eingriff erforderlich ist. Eine Penguin-Strafe (oder manuelle Maßnahme) wird vom Google-Webspam-Team nach einer manuellen Überprüfung verhängt und erfordert einen Antrag auf erneute Überprüfung, um aufgehoben zu werden. Seit Penguin 4.0 im Jahr 2016 in Echtzeit läuft, kann man sich von algorithmischen Abstufungen fast sofort erholen, sobald Korrekturmaßnahmen ergriffen wurden, während manuelle Strafen eine explizite Genehmigung von Google erfordern.

Das Penguin-Update verwendet maschinelles Lernen, um Backlink-Profile zu analysieren und Muster von manipulativen Linkaufbaupraktiken zu erkennen, darunter gekaufte Links, Linktausch, Private Blog Networks (PBNs) und unnatürliche Ankertextmuster. Der Algorithmus bewertet das Verhältnis von hochwertigen, natürlichen Links zu minderwertigen Spam-Links, die auf eine Website verweisen. Er prüft auch die Relevanz und Autorität der verlinkenden Domains, um festzustellen, ob Links eher künstlich beschafft als redaktionell verdient wurden.

Ja, eine Erholung ist durch einen mehrstufigen Prozess möglich, der Backlink-Audits, das Entfernen von Spam-Links und die Nutzung des Disavow-Tools von Google für nicht direkt entfernbare Links umfasst. Da Penguin 4.0 in Echtzeit arbeitet, kann die Erholung relativ schnell erfolgen, sobald Sie Ihr Linkprofil bereinigt haben und Google diese Seiten erneut gecrawlt hat. Allerdings ist eine Rückkehr zu den vorherigen Rankings nicht garantiert, da einige dieser Rankings möglicherweise künstlich durch die entfernten minderwertigen Links gestiegen waren.

Penguin bestraft Links von Linkfarmen, bezahlten Linknetzwerken, Private Blog Networks (PBNs), gegenseitigen Linktauschaktionen und Websites mit unnatürlichen Ankertextmustern. Ebenfalls betroffen sind Links aus minderwertigen Verzeichnissen, Kommentar-Spam, Forum-Spam und Links, die durch manipulative Praktiken erworben wurden. Zusätzlich werden Links von hochautoritativen Seiten markiert, wenn sie offensichtlich verkauft oder als Advertorials ohne korrektes Nofollow-Tag platziert wurden, da dies gegen Googles Richtlinien für Linknetzwerke verstößt.

Seit der Veröffentlichung von Penguin 4.0 im September 2016 läuft der Algorithmus kontinuierlich in Echtzeit als Teil des Google-Kernalgorithmus. Das bedeutet, dass Google Backlink-Profile laufend bewertet und Rankings anhand der Linkqualität anpasst, ohne auf geplante Updates zu warten. Zuvor arbeitete Penguin nach einem Batch-Update-Plan mit von Google angekündigten Aktualisierungen, aber die Echtzeitverarbeitung machte diese Ankündigungen überflüssig und ermöglicht eine schnellere Erholung bei Korrekturen.

Das Disavow-Tool ist eine Funktion der Google Search Console, mit der Webmaster Google mitteilen können, bestimmte Backlinks bei der Bewertung ihrer Website zu ignorieren. Es wird als letztes Mittel eingesetzt, wenn man Webmaster nicht direkt kontaktieren kann, um Spam-Links zu entfernen. Durch das Disavowen minderwertiger Links verhindert man, dass sie sich negativ auf das Ranking unter dem Penguin-Algorithmus auswirken. Allerdings liefern disavowte Links auch keinen positiven Wert mehr, daher sollte das Tool nur bei wirklich schädlichen Links eingesetzt werden.

Das ursprüngliche Penguin-Update, das im April 2012 eingeführt wurde, betraf laut Google-Schätzungen mehr als 3 % aller Suchanfragen. Nachfolgende Updates hatten unterschiedliche Auswirkungen: Penguin 2.0 beeinflusste etwa 2,3 % der englischsprachigen Suchanfragen, Penguin 2.1 etwa 1 % der Anfragen und Penguin 3.0 weniger als 1 % der englischen Suchanfragen. Diese Prozentsätze entsprechen weltweit Millionen von Websites und machen Penguin zu einem der bedeutendsten Algorithmus-Updates der Suchgeschichte.

Beginnen Sie zu verfolgen, wie KI-Chatbots Ihre Marke auf ChatGPT, Perplexity und anderen Plattformen erwähnen. Erhalten Sie umsetzbare Erkenntnisse zur Verbesserung Ihrer KI-Präsenz.

Erfahren Sie mehr über Googles Panda-Update, die Algorithmus-Änderung von 2011, die auf minderwertige Inhalte abzielt. Verstehen Sie, wie es funktioniert, seine...

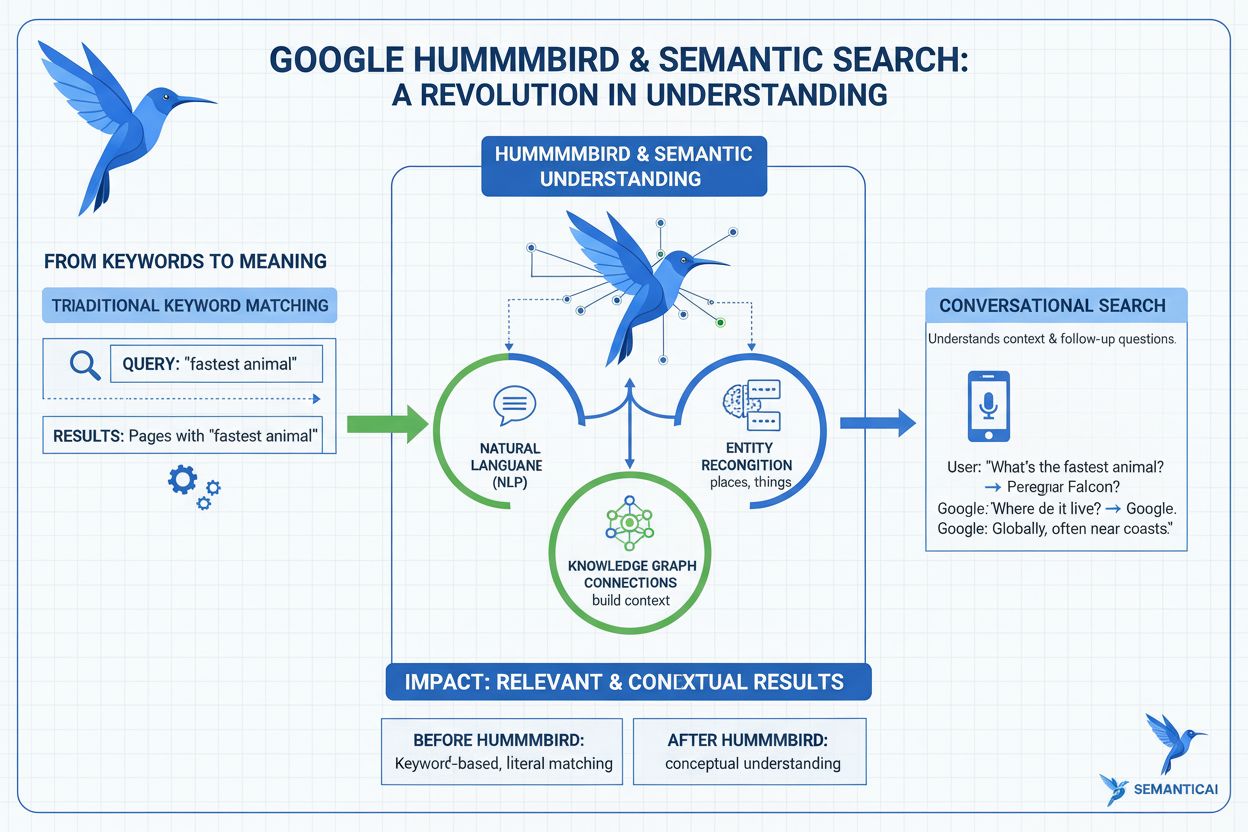

Erfahren Sie, was das Hummingbird-Update ist, wie es 2013 die semantische Suche revolutionierte und warum es für KI-Monitoring und Markenpräsenz über Suchplattf...

Erfahren Sie, was Google-Algorithmus-Updates sind, wie sie funktionieren und welche Auswirkungen sie auf SEO haben. Verstehen Sie Core-Updates, Spam-Updates und...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.