Query-Reformulierung

Erfahren Sie, wie die Query-Reformulierung KI-Systemen hilft, Benutzeranfragen zu interpretieren und zu verbessern, um die Informationsbeschaffung zu optimieren...

Query-Refinement ist der Prozess der Verbesserung und Optimierung von Suchanfragen durch iterative Anpassungen, Präzisierungen und Erweiterungen, um genauere, relevantere und umfassendere Ergebnisse aus KI-Suchmaschinen und Informationsabrufsystemen zu erzielen. Dabei werden komplexe Benutzeranfragen in Teilanfragen zerlegt, kontextuelle Details hinzugefügt und Feedbackschleifen genutzt, um die Suchleistung und die Qualität der Ergebnisse schrittweise zu steigern.

Query-Refinement ist der Prozess der Verbesserung und Optimierung von Suchanfragen durch iterative Anpassungen, Präzisierungen und Erweiterungen, um genauere, relevantere und umfassendere Ergebnisse aus KI-Suchmaschinen und Informationsabrufsystemen zu erzielen. Dabei werden komplexe Benutzeranfragen in Teilanfragen zerlegt, kontextuelle Details hinzugefügt und Feedbackschleifen genutzt, um die Suchleistung und die Qualität der Ergebnisse schrittweise zu steigern.

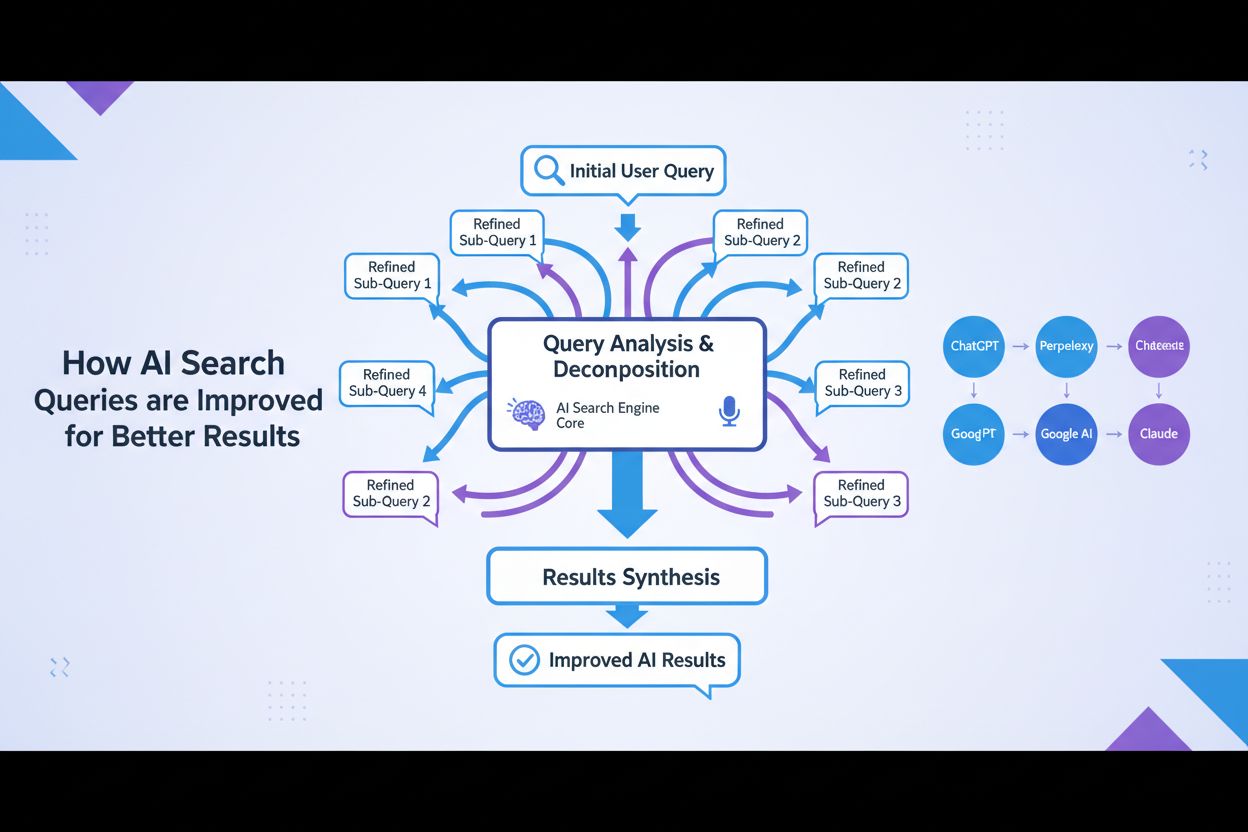

Query Refinement ist der iterative Prozess der Verbesserung und Optimierung von Suchanfragen durch systematische Anpassungen, Präzisierungen und Erweiterungen, um genauere, relevantere und umfassendere Ergebnisse aus Informationsabrufsystemen und KI-Suchmaschinen zu generieren. Anstatt die anfängliche Suche eines Nutzers als endgültig zu betrachten, erkennt Query Refinement, dass Nutzer ihre Anfragen oft modifizieren, erweitern oder präzisieren müssen, um genau das zu finden, wonach sie suchen. Dieser Prozess umfasst die Analyse, wie Nutzer ihre Suchen verändern, das Vorschlagen verbesserter Anfrageformulierungen und die Nutzung von Feedbackschleifen zur schrittweisen Leistungssteigerung der Suche. Im Kontext moderner KI-Suchplattformen wie ChatGPT, Perplexity, Google AI Overviews und Claude ist Query Refinement zu einem grundlegenden Mechanismus für umfassende, multi-quellenbasierte Antworten auf komplexe Nutzerfragen geworden. Die Technik verwandelt die Suche von einer einzelnen, statischen Interaktion in einen dynamischen, mehrstufigen Dialog, bei dem jede Verfeinerung die Nutzer näher an die gewünschte Information bringt.

Query Refinement ist kein neues Konzept im Informationsabruf, doch seine Anwendung hat sich mit dem Aufstieg von künstlicher Intelligenz und großen Sprachmodellen dramatisch weiterentwickelt. Ursprünglich setzten Suchmaschinen vor allem auf Schlüsselwort-Matching, bei dem die Anfrage eines Nutzers direkt mit indizierten Dokumenten verglichen wurde. Wenn Sie nach „Laufschuhe“ suchten, lieferte die Suchmaschine Dokumente mit diesen exakten Wörtern – unabhängig vom Kontext oder der Nutzerintention. Dieser Ansatz war starr und führte oft zu irrelevanten Ergebnissen, da er die Nuancen der Sprache und die Komplexität der Nutzerbedürfnisse ignorierte.

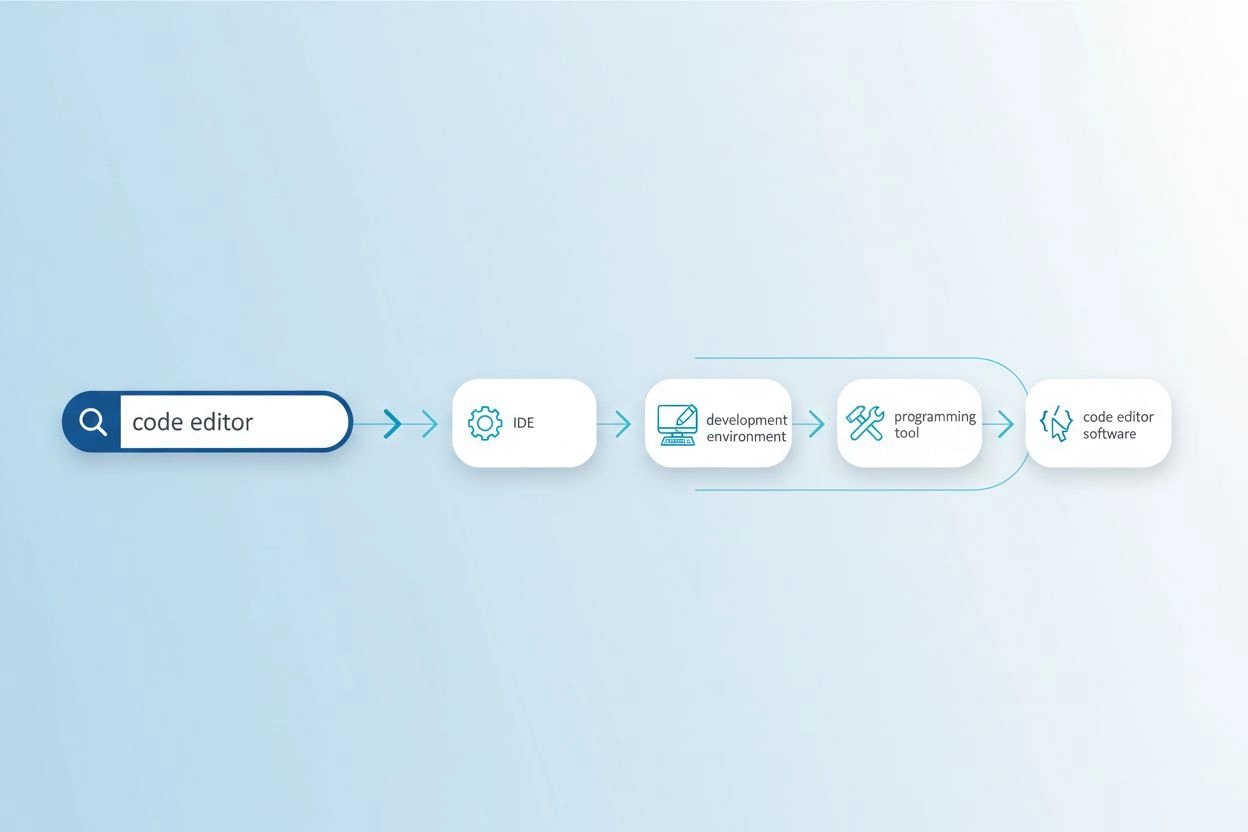

Die Entwicklung hin zu Query Refinement begann mit der Einführung von Query-Suggestion-Systemen in den frühen 2000ern, als Suchmaschinen begannen, Nutzerverhaltensmuster zu analysieren, um verwandte oder verfeinerte Suchanfragen vorzuschlagen. Googles „Meinten Sie?“ und Autocomplete-Vorschläge waren frühe Umsetzungen dieses Konzepts. Diese Systeme waren jedoch relativ einfach und basierten hauptsächlich auf historischen Abfragelogs und Frequenzanalysen. Es fehlte ihnen das semantische Verständnis, das nötig gewesen wäre, um wirklich die Nutzerabsicht oder die Beziehungen zwischen verschiedenen Anfrageformulierungen zu begreifen.

Die Einführung von Natural Language Processing (NLP) und Machine Learning hat Query Refinement grundlegend verändert. Moderne Systeme erkennen, dass „beste wasserdichte Laufschuhe“ und „top-bewertetes regenfestes Sport-Schuhwerk“ im Grunde dieselbe Anfrage sind, auch wenn sie ganz unterschiedliche Begriffe verwenden. Dieses semantische Verständnis ermöglicht es, Anfragevarianten zu erkennen, implizite Nutzerbedürfnisse zu identifizieren und Verfeinerungen vorzuschlagen, die Suchergebnisse tatsächlich verbessern. Laut Forschung der Kopp Online Marketing SEO Research Suite sind Query-Refinement-Methoden zunehmend ausgefeilt geworden – Systeme können heute synthetische Anfragen (künstlich erstellte Anfragen, die reale Nutzersuchen simulieren) generieren, um Trainingsdaten zu erweitern und die Retrieval-Genauigkeit zu steigern.

Das Aufkommen von generativer KI und großen Sprachmodellen hat diese Entwicklung weiter beschleunigt. Moderne KI-Suchmaschinen verfeinern nicht nur Anfragen, sondern zerlegen sie in mehrere Teilanfragen, führen diese parallel über verschiedene Datenquellen aus und synthetisieren die Ergebnisse zu umfassenden Antworten. Dies stellt einen grundlegenden Wandel dar: Query Refinement ist nicht mehr nur ein Vorschlags-Feature für Nutzer, sondern ein zentrales Architekturprinzip moderner KI-Suchsysteme.

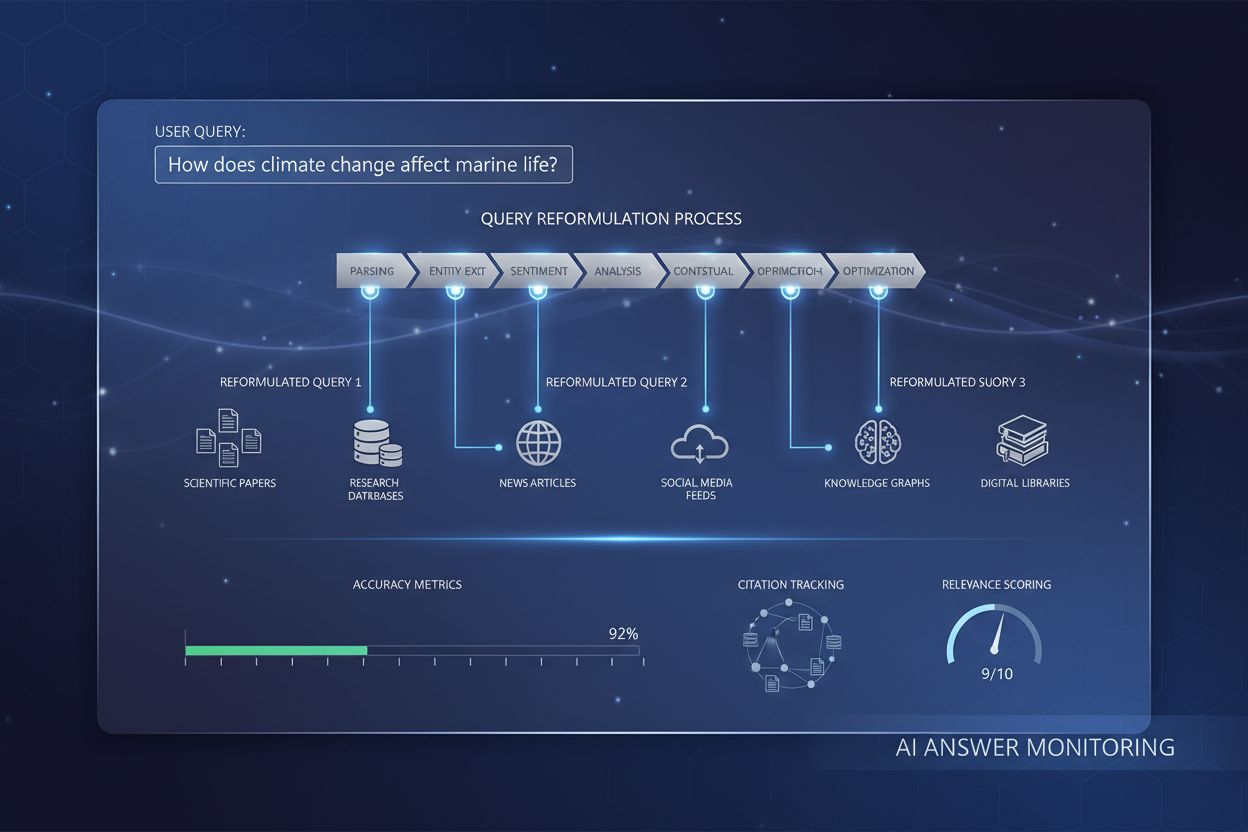

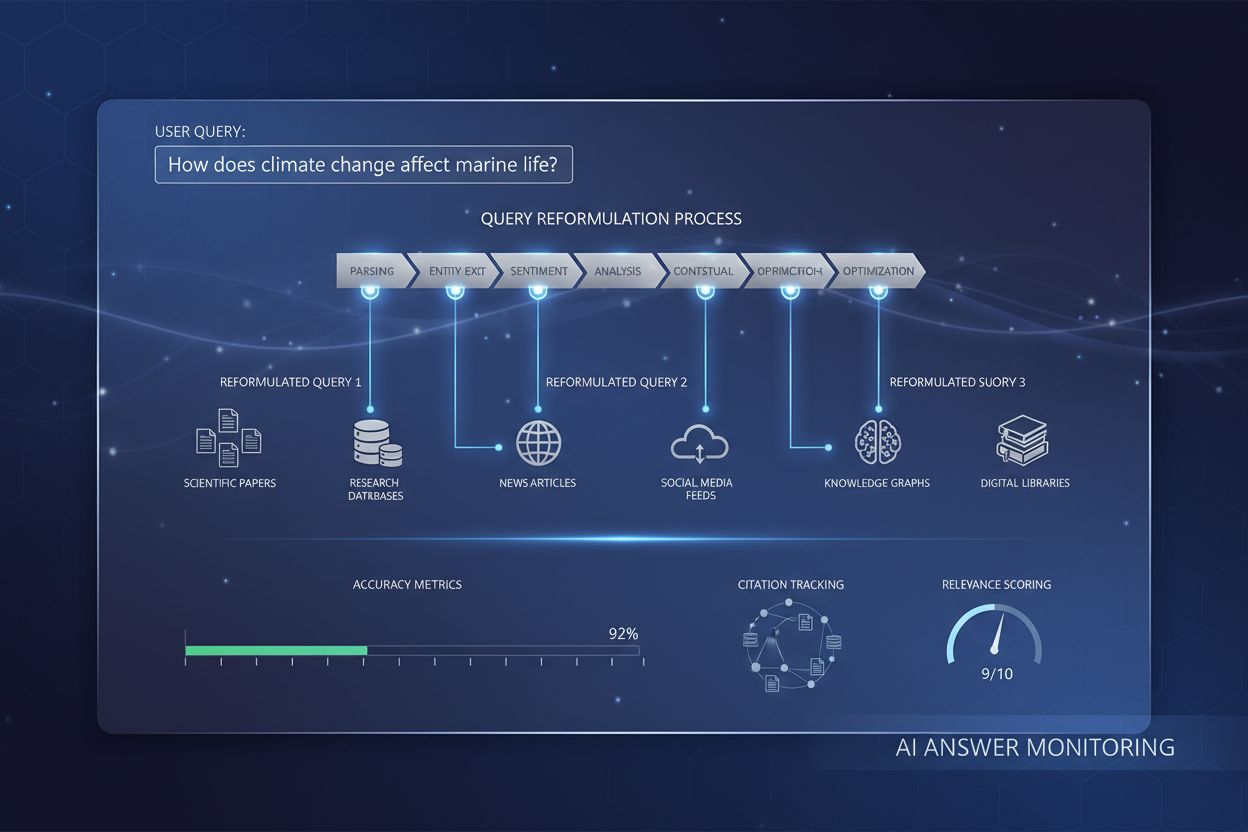

Query Refinement arbeitet über mehrere miteinander verbundene technische Mechanismen, die gemeinsam die Suchqualität verbessern. Der erste Mechanismus ist die Anfrageanalyse und Intent-Erkennung, bei der das System die Ausgangsanfrage verarbeitet, um die zugrunde liegende Absicht, den Komplexitätsgrad und die benötigte Antwortart zu erkennen. Fortschrittliche NLP-Modelle analysieren Aspekte wie Anfragelänge, Terminologiespezifität und Kontextsignale, um zu bestimmen, ob einfaches Schlüsselwort-Matching genügt oder ein ausgefeilteres Refinement notwendig ist. Eine einfache Faktenanfrage wie „Hauptstadt von Deutschland“ löst womöglich keine umfangreiche Verfeinerung aus, während eine komplexe Anfrage wie „Best Practices zur Optimierung von Inhalten für KI-Suchmaschinen“ umfassende Refinement-Prozesse aktiviert.

Der zweite Mechanismus ist die Anfragezerlegung und Fan-out, eine Technik, bei der komplexe Anfragen in mehrere Teilanfragen zerlegt werden. Dieser sogenannte Query Fan-out ist besonders wichtig in KI-Suchsystemen. Wenn ein Nutzer fragt: „Was sind die besten wasserdichten Laufschuhe für jemanden mit Plattfüßen, der auf Trails läuft?“, zerlegt das System dies in mehrere Teilanfragen: eine zu Produktlisten, eine zu Expertenbewertungen, eine zu Nutzererfahrungen und eine zu technischen Spezifikationen. Diese Teilanfragen werden gleichzeitig über verschiedene Datenquellen – etwa das Live-Web, Wissensdatenbanken oder spezialisierte Datenbanken – ausgeführt. Diese parallele Ausführung erweitert den verfügbaren Informationspool erheblich und ermöglicht der KI, umfassendere und differenziertere Antworten zu geben.

Der dritte Mechanismus ist die Anfrageerweiterung (Query Augmentation), bei der zusätzliche Anfragen generiert werden, um die Suchleistung zu verbessern. Laut der Kopp Online Marketing SEO Research Suite nutzt die Anfrageerweiterung verschiedene Methoden: Analyse historischer Daten (Auswertung früherer Refinements in Suchhistorien), N-Gramm-Substitution (Ändern von Anfragen durch Austausch zusammenhängender Begriffsfolgen), Entity Association (Erkennung von Entitäten aus Suchergebnissen und deren Kombination mit den ursprünglichen Suchbegriffen) und Sibling-Query-Identifikation (Auffinden verwandter Anfragen, die eine gemeinsame Elternanfrage haben). Diese Erweiterungstechniken stellen sicher, dass das System verschiedene Perspektiven und Ansätze für das Informationsbedürfnis des Nutzers auslotet.

Der vierte Mechanismus sind Feedbackschleifen und kontinuierliche Verbesserung, bei denen Nutzerinteraktionen mit Suchergebnissen den Refinement-Prozess beeinflussen. Wenn Nutzer bestimmte Ergebnisse anklicken, längere Zeit auf Seiten verweilen oder ihre Anfragen reformulieren, fließen diese Daten zurück ins System und verbessern zukünftige Verfeinerungen. Reinforcement-Learning-Techniken können eingesetzt werden, um generative Modelle zu optimieren – die Qualität der Anfragevarianten verbessert sich dadurch über die Zeit anhand zufriedenstellender Nutzerantworten. Es entsteht ein positiver Kreislauf, der das System mit jeder Interaktion intelligenter und effektiver macht.

| Aspekt | Google AI Overviews | ChatGPT | Perplexity | Claude |

|---|---|---|---|---|

| Primäre Refinement-Methode | Query Fan-out mit thematischer Suche | Konversationelle mehrstufige Verfeinerung | Interaktive Query-Vorschläge mit Folgefragen | Kontextuelle Klärung im Dialog |

| Teil-Anfragen-Generierung | Automatische Zerlegung nach Intention | Nutzergeführt im Gespräch | Vorgeschlagene Verfeinerungen als Vorschläge | Implizit durch Kontextverständnis |

| Datenquellen | Live-Web, Knowledge Graphs, Shopping Graphs | Trainingsdaten + Websuche (mit Plugins) | Echtzeit-Websuche über mehrere Quellen | Trainingsdaten mit Websuche-Funktion |

| Zitationsmechanismus | Direkte Quellenangabe im Überblick | Linkverweise in Antworten | Quellenkarten mit detaillierter Attribution | Inline-Zitate mit Quelllinks |

| Nutzerkontrolle | Gering (systemgesteuertes Refinement) | Hoch (Nutzer steuert Gespräch) | Mittel (Vorschläge + eigene Eingabe) | Hoch (Nutzer kann gezielt verfeinern) |

| Sichtbarkeit der Verfeinerung | Implizit (Nutzer sieht synthetisierte Antwort) | Explizit (Nutzer sieht Gesprächsverlauf) | Explizit (Verfeinerungsvorschläge sichtbar) | Implizit (Verfeinerung im Dialog) |

| Geschwindigkeit der Verfeinerung | Sofort (parallele Verarbeitung) | Sequenziell (Turn-by-Turn) | Sofort (Echtzeitsuche) | Sequenziell (Dialogbasiert) |

| Personalisierungsgrad | Hoch (Suchverlauf & Standort) | Mittel (Gesprächskontext) | Mittel (Session-Daten) | Mittel (Gesprächskontext) |

Der Query-Refinement-Prozess moderner KI-Suchmaschinen folgt einem ausgefeilten, mehrstufigen Ablauf, der sich deutlich von traditioneller Suche unterscheidet. Gibt ein Nutzer eine Suchanfrage in ein System wie Google AI Mode oder ChatGPT ein, sucht das System nicht sofort nach Ergebnissen. Es analysiert die Anfrage zunächst mit fortgeschrittener NLP, um zu verstehen, was der Nutzer wirklich wissen möchte. Dabei werden Aspekte wie Suchverlauf, Standort, Gerätetyp und die Komplexität der Anfrage berücksichtigt. Das System entscheidet, ob die Anfrage einfach (Schlüsselwort-Matching reicht) oder komplex (Zerlegung und Multi-Source-Synthese nötig) ist.

Bei komplexen Anfragen wird der Query Fan-out-Prozess aktiviert. Hierbei wird die ursprüngliche Anfrage in mehrere verwandte Teilanfragen zerlegt, die verschiedene Facetten des Informationsbedarfs beleuchten. Fragt ein Nutzer beispielsweise „Wie optimiere ich meine Website für KI-Suchmaschinen?“, könnten folgende Teilanfragen generiert werden: „Was sind die wichtigsten Ranking-Faktoren für KI-Suchmaschinen?“, „Wie bewerten KI-Systeme Content-Qualität?“, „Was ist E-E-A-T und warum ist es für KI wichtig?“, „Wie strukturiere ich Inhalte für KI-Zitation?“, und „Was sind Best Practices für KI-freundliche Content-Formate?“. Jede dieser Teilanfragen wird parallel über verschiedene Datenquellen ausgeführt und liefert vielfältige Informationen zu unterschiedlichen Aspekten der Ausgangsfrage.

Das System bewertet die erhaltenen Informationen anhand von Qualitätssignalen wie Domain-Autorität, Aktualität, thematischer Relevanz und Zitationsmustern. Die Informationen aus mehreren Quellen werden zu einer kohärenten, umfassenden Antwort zusammengeführt, die die ursprüngliche Anfrage direkt adressiert. Während dieses Prozesses identifiziert das System die maßgeblichsten und relevantesten Quellen, die dann als Zitate oder Referenzen in der finalen Antwort erscheinen. Deshalb ist das Verständnis von Query Refinement für AmICited-Nutzer so entscheidend – die Quellen, die in KI-Antworten genannt werden, werden maßgeblich durch die Übereinstimmung mit den verfeinerten Teilanfragen des KI-Systems bestimmt.

Der Zusammenhang zwischen Query Refinement und Suchsichtbarkeit in AI Overviews ist direkt und messbar. Studien zeigen, dass über 88 % der Suchen, die AI Overviews auslösen, informationsgetrieben sind, das heißt, Nutzer möchten etwas lernen und nicht kaufen oder gezielt auf eine bestimmte Seite navigieren. Genau diese Informationsanfragen werden besonders häufig verfeinert, da sie oft eine Synthese aus mehreren Quellen benötigen, um eine vollständige Antwort zu liefern. Passt Ihr Content zu den verfeinerten Teilanfragen, die ein KI-System generiert, hat Ihre Website eine deutlich höhere Chance, als Quelle zitiert zu werden.

Die Zahlen sind überzeugend: Wer als AI Overview-Quelle genannt wird, steigert die Klickrate von 0,6 % auf 1,08 %, also fast eine Verdopplung des Traffics im Vergleich zu einem reinen Ranking unterhalb des Overviews in den klassischen Suchergebnissen. Deshalb ist das Verständnis von Query Refinement für moderne SEO-Strategien unverzichtbar. Statt für ein einzelnes Schlüsselwort zu optimieren, müssen Content-Ersteller heute überlegen, wie ihr Content die verschiedenen verfeinerten Suchanfragen abdeckt, die ein KI-System generieren könnte. Schreiben Sie beispielsweise über „nachhaltige Mode“, sollten Sie einkalkulieren, dass ein KI-System dies in Teilanfragen wie „Umweltauswirkungen von Fast Fashion“, „ethische Produktionspraktiken“, „nachhaltige Materialien“, „Fairtrade-Zertifizierungen“ und „preisgünstige nachhaltige Marken“ verfeinert. Ihr Content sollte diese Perspektiven umfassend behandeln, um das Zitationspotenzial zu maximieren.

Außerdem zeigen Studien, dass etwa 70 % der Nutzer nur das erste Drittel von AI Overviews lesen – eine frühzeitige Zitierung im Antworttext ist also deutlich wertvoller als eine späte Nennung. Daraus ergibt sich für Content-Ersteller: Strukturieren Sie Ihre Inhalte so, dass die wichtigsten, zusammenfassenden Antworten ganz oben stehen und klar zitierbar sind. Das Ziel ist es, zur unverzichtbaren Quelle zu werden, die das KI-System zwingend zitieren muss, um eine glaubwürdige, umfassende Antwort auf die verfeinerten Anfragen zu liefern.

Effektives Query Refinement erfordert das Verständnis und die Anwendung mehrerer Schlüsseltechniken. Die erste Technik ist die kontextuelle Detailergänzung, bei der Nutzer oder Systeme spezifischen Kontext hinzufügen, um Anfragen präziser zu machen. Statt nur nach „Laufschuhe“ zu suchen, lautet eine verfeinerte Anfrage beispielsweise „beste wasserdichte Laufschuhe für Frauen mit hohem Fußgewölbe unter 150 €“. Dieser Kontext hilft KI-Systemen, relevante Einschränkungen und Präferenzen zu erkennen und gezielter Informationen zu liefern. Für Content-Ersteller bedeutet das: Antizipieren Sie diese kontextuellen Verfeinerungen und erstellen Sie Inhalte, die spezifische Anwendungsfälle, Zielgruppen und Einschränkungen adressieren.

Die zweite Technik ist die Angabe von Einschränkungen (Constraint Specification), bei der Nutzer Grenzen für die Suche definieren. Das können Preisspannen, geografische Standorte, Zeitrahmen oder Qualitätsstandards sein. KI-Systeme erkennen und berücksichtigen diese Constraints in der Verfeinerung. Eine Anfrage wie „beste Projektmanagement-Software für Remote-Teams mit weniger als 50 Mitarbeitern“ enthält mehrere Einschränkungen, die bei der Content-Erstellung bedacht werden sollten. Ihr Content sollte solche Szenarien explizit ansprechen, um die Zitationswahrscheinlichkeit zu erhöhen.

Die dritte Technik sind Rückfragen (Follow-up Questioning), bei denen Nutzer klärende Fragen stellen, um ihr Verständnis zu verfeinern. In konversationellen KI-Systemen wie ChatGPT könnte ein Nutzer fragen: „Können Sie das einfacher erklären?“ oder „Wie gilt das für kleine Unternehmen?“. Solche Rückfragen lösen Query Refinement aus, wobei das System seine Antwort anpasst. Daher sind inhaltliche Tiefe und die Fähigkeit, verschiedene Perspektiven eines Themas zu adressieren, für die Sichtbarkeit immer wichtiger.

Die vierte Technik ist die Anfragezerlegung (Query Decomposition), bei der komplexe Fragen in einfachere Teilfragen zerlegt werden. Besonders für KI-Systeme ist das wichtig, um ein Thema umfassend abzudecken. Fragt ein Nutzer zum Beispiel „Was sind Best Practices für die Optimierung von E-Commerce-Websites für KI-Suchmaschinen?“, könnte die KI Teilfragen generieren wie: „Was sind KI-Suchmaschinen?“, „Wie ranken KI-Systeme E-Commerce-Inhalte?“, „Welche technischen Optimierungen sind relevant?“, „Wie sollten Produktbeschreibungen aufgebaut sein?“ und „Welche Rolle spielt User Generated Content?“. Content, der diese Teilfragen abdeckt, wird mit höherer Wahrscheinlichkeit in mehreren verfeinerten Anfragen zitiert.

Generative Engine Optimization (GEO), auch bekannt als Large Language Model Optimization (LLMO), dreht sich grundlegend um das Verständnis und die Optimierung von Query-Refinement-Prozessen. Klassisches SEO fokussierte sich auf das Ranking für bestimmte Keywords; GEO zielt darauf ab, als zitierte Quelle in den verfeinerten Anfragen genannt zu werden, die KI-Systeme generieren. Das bedeutet einen Paradigmenwechsel für Content-Ersteller.

Im GEO-Kontext ist Query Refinement kein Prozess, der einfach nur „mit Ihren Inhalten passiert“ – Sie müssen ihn antizipieren und gezielt vorbereiten. Wenn Sie Content erstellen, sollten Sie alle möglichen Wege bedenken, auf denen ein KI-System Ihr Thema verfeinern oder in Teilanfragen zerlegen könnte. Schreiben Sie beispielsweise über „nachhaltige Mode“, sollten Sie Inhalte zu folgenden Aspekten bereitstellen: Umweltauswirkungen konventioneller Mode, nachhaltige Materialien und deren Eigenschaften, ethische Herstellung und Arbeitsbedingungen, Zertifizierungen und Standards, Kostenaspekte, Markenempfehlungen sowie Tipps für den Umstieg auf nachhaltige Mode. Je umfassender Sie diese Facetten abdecken, desto eher werden Ihre Inhalte in mehreren KI-generierten Antworten zitiert.

Forschung aus den 2026 AI SEO Statistics von Elementor zeigt, dass der KI-Suchtraffic innerhalb eines Jahres um 527 % gestiegen ist, und einige Seiten berichten inzwischen von mehr als 1 % aller Sitzungen aus Plattformen wie ChatGPT, Perplexity und Copilot. Dieses starke Wachstum unterstreicht die Bedeutung des Query-Refinement-Verständnisses. Der Traffic aus KI-Plattformen ist zudem viel wertvoller – KI-Referral-Besucher sind 4,4-mal mehr wert als klassische organische Suchbesucher, mit 27 % niedrigeren Absprungraten und 38 % längeren Sitzungsdauern im Einzelhandel. Die Optimierung für Query Refinement ist somit nicht nur Sichtbarkeits-, sondern auch ein Qualitäts- und Conversion-Thema.

Die Zukunft des Query Refinement bewegt sich in Richtung immer ausgefeilterer, personalisierter und autonomer Systeme. Synthetische Anfragegenerierung wird immer besser, und KI-Systeme können vielfältige, kontextuell passende Anfragen generieren, die reale Suchmuster simulieren. Diese synthetischen Anfragen sind entscheidend, um KI-Systeme für neuartige oder seltene Suchanfragen zu trainieren und dabei auf gelernte Muster und Kontextwissen zurückzugreifen. Mit zunehmenden Fähigkeiten werden KI-Systeme immer differenziertere und spezifischere Teilanfragen generieren, was Content-Ersteller zwingt, ihre Themen noch vielschichtiger zu betrachten.

Ein weiterer Trend ist das stateful Query Refinement, bei dem KI-Systeme Kontext über mehrere Gesprächsrunden hinweg behalten und dadurch ausgefeiltere Verfeinerungen entsprechend der fortschreitenden Nutzerbedürfnisse und Präferenzen ermöglichen. Anstatt jede Anfrage isoliert zu behandeln, erkennen diese Systeme Bezüge zu vorangegangenen Interaktionen – was zu noch persönlicheren und relevanteren Verfeinerungen führt. Für die Content-Strategie bedeutet das, Inhalte so zu strukturieren, dass sie auch in mehrstufigen Dialogen als zitierbare Quelle dienen.

Auch die Integration von Reinforcement Learning in Query-Refinement-Systemen ist von Bedeutung. Das System lernt aus Nutzerfeedback und verbessert so die Qualität der Verfeinerungen kontinuierlich. Wenn Nutzer regelmäßig bestimmte Quellen anklicken oder auf Seiten länger verweilen, lernt das System, diese Quellen künftig bevorzugt zu nennen. Wer regelmäßig hochwertige, autoritative Inhalte liefert, wird so zur bevorzugten Quelle, die KI-Systeme „lernen“ zu zitieren.

Nicht zuletzt werden mit dem Aufkommen von KI-Agenten und autonomen Suchsystemen Query-Refinement-Prozesse noch komplexer. Künftig werden nicht mehr nur Nutzer Anfragen verfeinern, sondern KI-Agenten übernehmen diese Aufgabe autonom und erkunden das Informationsuniversum, um komplexe Fragen bestmöglich zu beantworten. Für Content-Ersteller heißt das: Ihre Inhalte müssen nicht nur für menschliche Suchende auffindbar sein, sondern auch für autonome KI-Agenten, die systematisch und umfassend das Web nach Antworten durchsuchen.

Auch die Wettbewerbssituation verändert sich. Mit der Umsetzung von Query-Refinement-Funktionen auf immer mehr Plattformen wird die Sichtbarkeit in verfeinerten Anfragen zum entscheidenden Unterscheidungsmerkmal. AmICited-Nutzer, die ihre Präsenz in verfeinerten Anfragen verschiedener KI-Plattformen verstehen und überwachen, haben einen deutlichen Vorsprung gegenüber denen, die sich nur auf traditionelle Suchrankings fokussieren. Die Zukunft gehört jenen Content-Erstellern und Marken, die Query Refinement als zentrales Element der Suchsichtbarkeit begreifen und gezielt darauf optimieren.

Query Refinement konzentriert sich darauf, die Relevanz und Genauigkeit der Suchergebnisse zu erhöhen, indem Suchanfragen basierend auf Benutzerkontext und historischen Daten angepasst oder vorgeschlagen werden, um präzisere Informationen zu liefern. Query Expansion hingegen erzeugt zusätzliche Anfragen, um die Suchmaschinenleistung zu verbessern, indem Probleme wie schlecht formulierte Anfangsanfragen oder irrelevante Ergebnisse adressiert werden. Während das Refinement eine bestehende Anfrage verbessert, werden beim Expansion mehrere verwandte Anfragen erstellt, um den Suchbereich zu erweitern. Beide Techniken arbeiten in modernen KI-Suchsystemen zusammen, um die Qualität der Informationsbeschaffung zu erhöhen.

KI-Suchmaschinen verwenden Query Refinement durch einen Prozess namens Query Fan-out, bei dem eine einzelne Benutzeranfrage in mehrere Teilanfragen zerlegt wird, die gleichzeitig über verschiedene Datenquellen ausgeführt werden. Zum Beispiel könnte eine komplexe Frage wie 'beste wasserdichte Laufschuhe für Plattfüße' in Teilanfragen zu Produktlisten, Expertenbewertungen, Nutzererfahrungen und technischen Spezifikationen zerlegt werden. Diese parallele Informationsbeschaffung aus unterschiedlichen Quellen erweitert den verfügbaren Informationspool erheblich und ermöglicht es der KI, umfassendere und genauere Antworten zu liefern.

Natural Language Processing ist grundlegend für Query Refinement, da es KI-Systemen ermöglicht, Bedeutungen über einfaches Schlüsselwort-Matching hinaus zu interpretieren. NLP nutzt Muster und kontextuelle Beziehungen zwischen Wörtern, um zu verstehen, wie Menschen sprechen, und macht Suchanfragen damit intuitiver und präziser. Beispielsweise kann ein System mit NLP erkennen, dass 'offene Cafés' bedeutet, dass Betriebe aktuell geöffnet und in der Nähe sind – und nicht nur Dokumente, die genau diese Wörter enthalten. Dieses kontextuelle Verständnis ermöglicht es modernen KI-Systemen, Anfragen intelligent zu verfeinern und Ergebnisse zu liefern, die der Benutzerabsicht und nicht nur den exakten Schlüsselwörtern entsprechen.

Query Refinement verbessert die Suchsichtbarkeit in AI Overviews, indem es Content-Erstellern hilft, zu verstehen, wie Nutzer ihre Suchanfragen verändern, um bessere Ergebnisse zu erhalten. Indem sowohl anfängliche als auch verfeinerte Anfragen mit umfassenden Inhalten bedient werden, die den Nutzerbedarf und Folgefragen antizipieren, können Websites ihre Chancen erhöhen, als Quelle genannt zu werden. Studien zeigen, dass eine Nennung als AI Overview-Quelle die Klickrate von 0,6 % auf 1,08 % steigert, weshalb das Verständnis von Query Refinement für moderne SEO-Strategien und die KI-Zitationssichtbarkeit unerlässlich ist.

Synthetische Anfragen sind künstlich generierte Suchanfragen, die von großen Sprachmodellen erstellt werden und reale Benutzersuchanfragen simulieren. Sie sind für Query Refinement entscheidend, da sie annotierte Trainingsdaten erweitern, die Recall-Rate verbessern und generatives Retrieval auf große Datensätze skalieren, indem sie Datenlücken schließen. Synthetische Anfragen werden durch das Mining strukturierter Daten, die Analyse von Dokumenttiteln und Ankertexten sowie durch Regelwerke erzeugt. Sie helfen KI-Systemen, Anfragen zu verstehen und zu verfeinern, indem sie vielfältige Beispiele liefern, wie Nutzer ähnliche Informationsbedürfnisse formulieren – was letztlich die Fähigkeit des Systems verbessert, Benutzeranfragen effektiv zu verfeinern und zu erweitern.

Unternehmen können Query Refinement optimieren, indem sie Daten aus der Google Search Console analysieren, um verwandte Schlüsselwörter und Abfragevarianten zu identifizieren, die Nutzer nacheinander suchen. Sie sollten umfassende Inhalte erstellen, die sowohl breite Anfangsanfragen als auch spezifische, verfeinerte Varianten abdecken. Mit Tools wie seoClarity oder ähnlichen Plattformen können Unternehmen Query Refinements und Autosuggest-Daten auswerten, um relevante Abfragevarianten für die Keyword-Recherche zu finden. Zudem hilft das Monitoring von Rankings nach Query Refinement und die Nachverfolgung der Performance facettierter Seiten bei strategischen Entscheidungen über Content-Strategie und technische Umsetzung.

Query Refinement ist eng mit der Nutzerintention verbunden, da es aufzeigt, wie sich die Informationsbedürfnisse der Nutzer im Verlauf ihrer Suchreise entwickeln. Durch die Analyse von Query-Refinement-Mustern können Unternehmen verstehen, wonach Nutzer in den verschiedenen Phasen des Entscheidungsprozesses wirklich suchen. Beispielsweise kann ein Nutzer mit einer breiten Intention starten ('Laufschuhe') und diese schrittweise zu einer spezifischeren Absicht verfeinern ('beste wasserdichte Laufschuhe für Plattfüße'). Das Verständnis dieser Verfeinerungsmuster ermöglicht es Content-Erstellern, gezielte Inhalte für jede Phase der Nutzerreise zu entwickeln und so sowohl die Sichtbarkeit in der Suche als auch die Conversion-Rate zu verbessern.

Beginnen Sie zu verfolgen, wie KI-Chatbots Ihre Marke auf ChatGPT, Perplexity und anderen Plattformen erwähnen. Erhalten Sie umsetzbare Erkenntnisse zur Verbesserung Ihrer KI-Präsenz.

Erfahren Sie, wie die Query-Reformulierung KI-Systemen hilft, Benutzeranfragen zu interpretieren und zu verbessern, um die Informationsbeschaffung zu optimieren...

Erfahren Sie, wie die Optimierung der Abfrageerweiterung KI-Suchergebnisse verbessert, indem sie Wortschatzlücken überbrückt. Entdecken Sie Techniken, Herausfor...

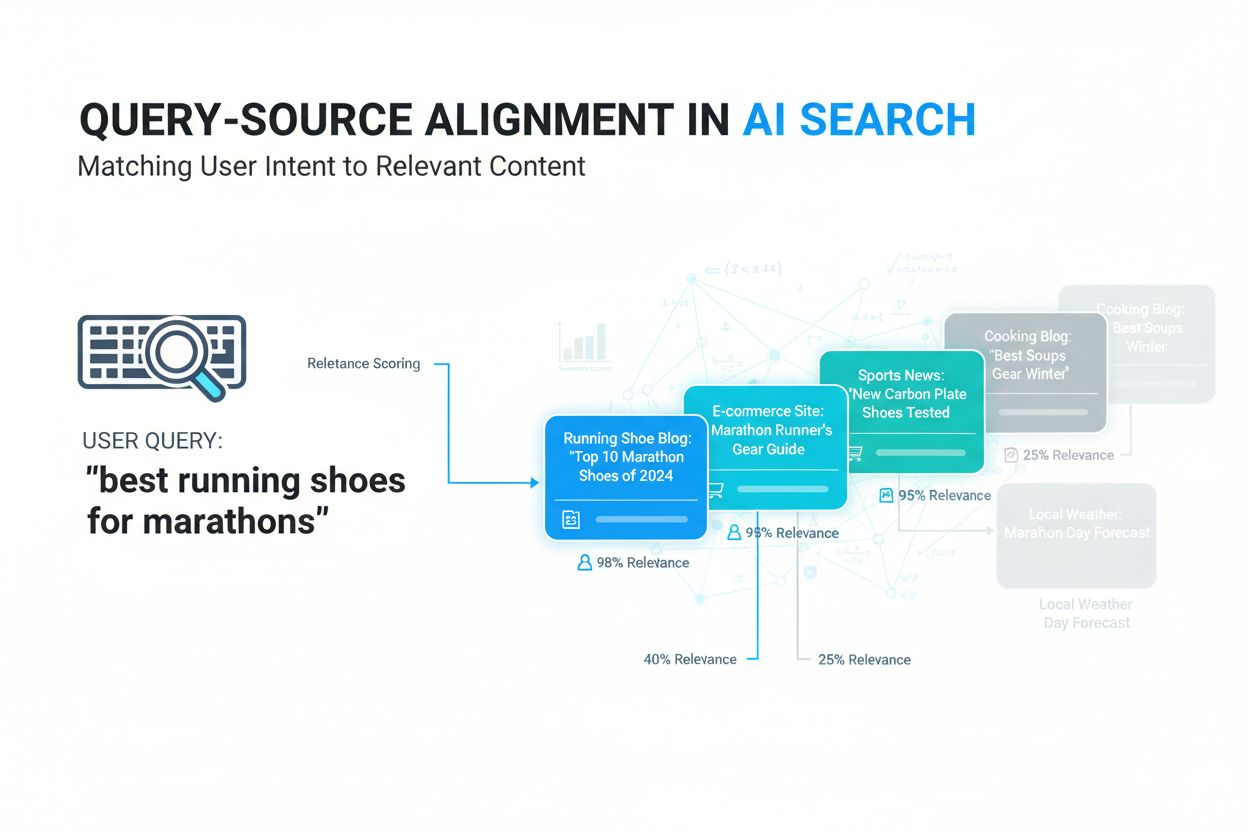

Erfahren Sie, was Query-Source-Alignment ist, wie KI-Systeme Benutzeranfragen mit relevanten Quellen abgleichen und warum das für die Sichtbarkeit von Inhalten ...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.