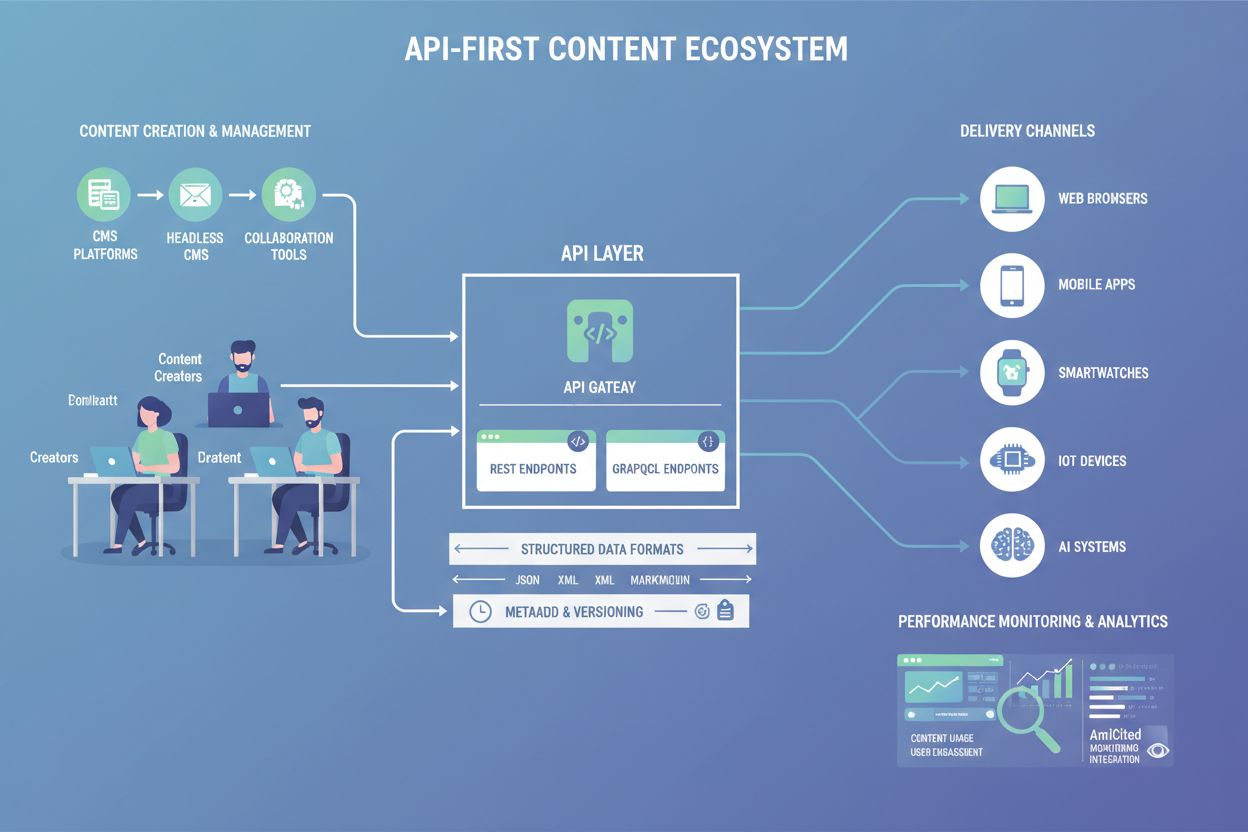

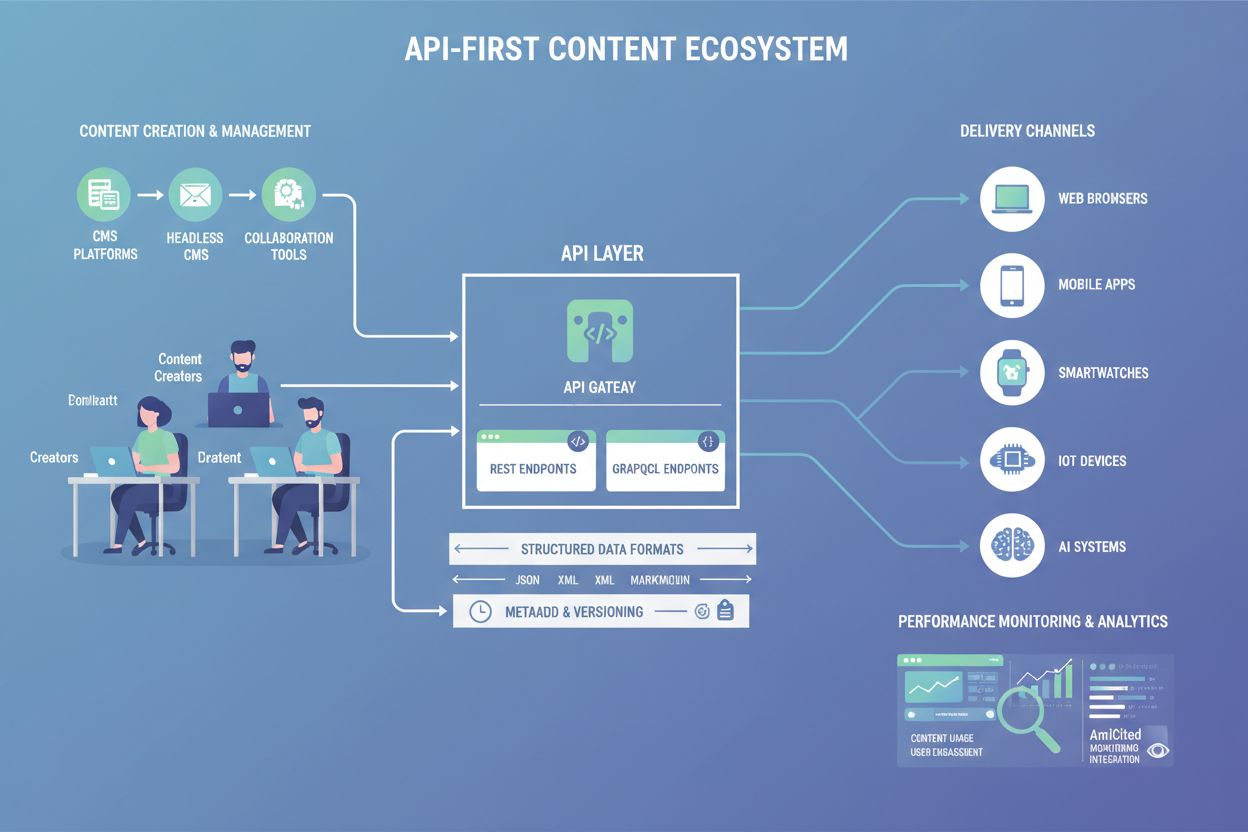

API-First Content

Erfahren Sie, was API-First Content ist, wie es KI-Sichtbarkeit ermöglicht und warum es für die Inhaltsarchitektur wichtig ist. Entdecken Sie, wie strukturierte...

APIs, die KI-Systemen aktuelle Inhaltsaktualisierungen für zeitkritische Informationen bereitstellen und so einen sofortigen Zugriff auf neue Daten durch persistente Streaming-Verbindungen ermöglichen. Diese APIs liefern Informationen in Millisekunden, anstatt periodisches Abfragen zu erfordern, sodass KI-Modelle stets über den aktuellsten Kontext für präzise Entscheidungsfindung und Antwortgenerierung verfügen.

APIs, die KI-Systemen aktuelle Inhaltsaktualisierungen für zeitkritische Informationen bereitstellen und so einen sofortigen Zugriff auf neue Daten durch persistente Streaming-Verbindungen ermöglichen. Diese APIs liefern Informationen in Millisekunden, anstatt periodisches Abfragen zu erfordern, sodass KI-Modelle stets über den aktuellsten Kontext für präzise Entscheidungsfindung und Antwortgenerierung verfügen.

Eine Echtzeit-Content-API ist eine Programmierschnittstelle, die KI-Systemen aktuelle Inhaltsaktualisierungen und Informationen bereitstellt, sobald sie verfügbar sind, und so einen unmittelbaren Zugriff auf zeitkritische Daten ohne Verzögerung ermöglicht. Im Gegensatz zu traditionellen Request-Response-APIs, bei denen Clients in Intervallen nach Updates fragen müssen, stellen Echtzeit-Content-APIs persistente Verbindungen her, die neue Informationen direkt an KI-Systeme senden, sobald sie generiert oder aktualisiert werden. Diese APIs sind grundlegend für moderne KI-Anwendungen, die aktuellen Kontext benötigen, wie große Sprachmodelle (LLMs), KI-Agenten und Retrieval-Augmented-Generation-(RAG)-Systeme. Durch die Lieferung frischer, relevanter Inhalte in Millisekunden stellen Echtzeit-Content-APIs sicher, dass KI-Systeme fundierte Entscheidungen auf Basis der neuesten verfügbaren Informationen treffen können, statt auf veraltete Daten zurückgreifen zu müssen.

Echtzeit-Content-APIs funktionieren nach grundlegend anderen Prinzipien als traditionelle REST-APIs und priorisieren kontinuierliche Datenlieferungen gegenüber diskreten Request-Response-Zyklen. Die Kernarchitektur basiert auf persistenten Verbindungen, die zwischen Client (KI-System) und Server offen bleiben und so einen bidirektionalen oder unidirektionalen Datenfluss je nach Protokoll ermöglichen. Diese APIs nutzen ereignisgesteuerte Architekturen, bei denen Updates sofort ausgelöst werden, sobald neue Inhalte verfügbar sind, statt auf geplante Batch-Prozesse zu warten. Die technische Umsetzung legt Wert auf niedrige Latenz, typischerweise im Millisekundenbereich, sodass KI-Systeme Informationen mit minimaler Verzögerung erhalten. Skalierbarkeit ist durch verteilte Streaming-Plattformen gegeben, die Millionen gleichzeitiger Verbindungen und riesige Datenmengen parallel verarbeiten können.

| Merkmal | Echtzeit-Content-API | Traditionelle REST-API | Batch-Verarbeitung |

|---|---|---|---|

| Verbindungstyp | Persistent/Streaming | Request-Response | Geplante Jobs |

| Datenlieferung | Push (Server-initiiert) | Pull (Client-initiiert) | Periodische Batches |

| Latenz | Millisekunden | Sekunden bis Minuten | Stunden bis Tage |

| Aktualität der Daten | Immer aktuell | Abhängig vom Polling | Stärker verzögert |

| Skalierbarkeit | Hohe Parallelität | Begrenzte Verbindungen | Batch-abhängig |

| Anwendungsfall | Echtzeit-KI, Live-Updates | Standard-Webdienste | Analytik, Reporting |

| Kostenmodell | Verbindungsbasiert | Anfragebasiert | Rechenbasiert |

Der Betriebsablauf einer Echtzeit-Content-API beginnt mit der Datenaufnahme, bei der Inhalte aus verschiedenen Quellen – Datenbanken, Nachrichtenwarteschlangen, externen APIs oder nutzergenerierten Ereignissen – erfasst und in ein standardisiertes Format überführt werden. Nach der Aufnahme gelangen die Daten in eine Verarbeitungspipeline, in der sie für KI-Systeme angereichert, gefiltert oder transformiert werden können, um Kontext und Relevanz zu erhöhen. Die verarbeiteten Inhalte werden anschließend über Streaming-Endpunkte bereitgestellt, die offene Verbindungen zu abonnierten KI-Clients aufrechterhalten. Sobald neue oder aktualisierte Inhalte eintreffen, überträgt die API sie unmittelbar über diese persistenten Verbindungen an alle interessierten Konsumenten. Diese Architektur macht es überflüssig, dass KI-Systeme ständig nach Updates fragen, reduziert die Netzwerkbelastung und stellt sicher, dass kritische Informationen KI-Modellen innerhalb von Millisekunden nach Verfügbarkeit erreichen. Der gesamte Prozess ist auf Fehlertoleranz ausgelegt, mit Mechanismen zur Behandlung von Verbindungsabbrüchen, Sicherstellung der Nachrichtenübermittlung und Wahrung der Datenkonsistenz über verteilte Systeme hinweg.

Die Bedeutung von Datenaktualität in KI-Systemen kann kaum überschätzt werden, da die Genauigkeit und Relevanz von KI-Ausgaben direkt von der Aktualität der dem Modell verfügbaren Informationen abhängt. Arbeiten KI-Systeme wie LLMs oder KI-Agenten mit veralteten Informationen, riskieren sie ungenaue Empfehlungen, das Übersehen wichtiger Kontexte oder falsche Entscheidungen auf Basis überholter Fakten. Echtzeit-Content-APIs lösen dieses Problem, indem sie sicherstellen, dass KI-Systeme stets auf die aktuellsten verfügbaren Informationen zugreifen können und so präzisere Antworten und bessere Entscheidungen ermöglichen. Bei Anwendungen wie Finanzhandel, Betrugserkennung oder personalisierten Empfehlungen kann selbst eine Verzögerung von Sekunden zu erheblichen Fehlern oder verpassten Chancen führen. Durch den kontinuierlichen Zugriff auf frische Daten ermöglichen Echtzeit-Content-APIs KI-Systemen, den aktuellen Stand der Welt zu erfassen, sich an veränderte Bedingungen anzupassen und Antworten zu liefern, die die neuesten Entwicklungen widerspiegeln. Diese Aktualität ist besonders kritisch für Retrieval-Augmented-Generation-(RAG)-Systeme, bei denen die Qualität des abgerufenen Kontexts die Qualität der generierten Antworten direkt beeinflusst.

Echtzeit-Content-APIs nutzen mehrere wichtige Streaming-Protokolle und Technologien, die jeweils für unterschiedliche Anwendungsfälle und Anforderungen optimiert sind:

WebSockets: Bieten Vollduplex-Kommunikation über eine einzelne TCP-Verbindung und ermöglichen so bidirektionalen Echtzeit-Datenaustausch. Ideal für interaktive Anwendungen, die eine niedrige Latenz und zweiseitige Kommunikation zwischen Client und Server erfordern.

Server-Sent Events (SSE): Ermöglichen es Servern, Daten über HTTP-Verbindungen unidirektional an Clients zu senden. Einfacher umzusetzen als WebSockets und gut geeignet für Szenarien, in denen nur Server-zu-Client-Updates notwendig sind.

gRPC: Ein leistungsstarkes RPC-Framework, das Protokollpuffer für effiziente Serialisierung nutzt. Unterstützt verschiedene Streaming-Modi und ist besonders effektiv für die Microservices-Kommunikation und das Bereitstellen von KI-Modellen.

Apache Kafka: Eine verteilte Streaming-Plattform, die als Nachrichtenbroker fungiert und zuverlässiges, skalierbares Event-Streaming ermöglicht. Häufig als Rückgrat für Echtzeit-Datenpipelines genutzt, die KI-Systeme versorgen.

MQTT: Ein leichtgewichtiges Publish-Subscribe-Protokoll, das für IoT- und mobile Anwendungen entwickelt wurde. Bietet effiziente Bandbreitennutzung und ist ideal für Szenarien mit begrenzten Netzwerkressourcen.

AMQP: Advanced Message Queuing Protocol mit zuverlässiger Nachrichtenübermittlung und Unterstützung komplexer Routing-Muster. Geeignet für Unternehmensanwendungen, die garantierte Nachrichtenübermittlung und Transaktionsunterstützung benötigen.

Echtzeit-Content-APIs ermöglichen eine Vielzahl von KI-Anwendungen, die auf aktuelle Informationen angewiesen sind. Retrieval-Augmented-Generation-(RAG)-Systeme nutzen Echtzeit-Content-APIs, um die neuesten Dokumente, Artikel oder Wissensdatenbankeinträge abzurufen und so sicherzustellen, dass generierte Antworten die aktuellsten verfügbaren Informationen enthalten. KI-Agenten greifen über Echtzeit-APIs auf aktuelle Marktdaten, Lagerbestände, Kundendaten und Betriebskennzahlen zu, um zeitnahe Entscheidungen treffen und Maßnahmen ergreifen zu können. Personalisierungs-Engines verwenden Echtzeit-Content-APIs, um Nutzerverhalten, Präferenzen und Kontext zu verfolgen, sodass KI-Systeme individualisierte Erlebnisse liefern, die sich an veränderte Nutzerbedürfnisse anpassen. Betrugserkennungssysteme verlassen sich auf Echtzeit-Content-APIs, um Transaktionsdaten, Nutzerprofile und historische Muster zu analysieren und so sofort verdächtige Aktivitäten zu erkennen. Empfehlungssysteme verwenden Echtzeit-APIs, um Trendinhalte, Nutzerinteraktionen und Kontextinformationen einzubeziehen, damit Empfehlungen stets relevant und aktuell bleiben. Chatbots und konversationelle KI profitieren vom Echtzeitzugriff auf Wissensdatenbanken, FAQs und Produktinformationen, sodass sie auf Nutzeranfragen präzise und aktuelle Antworten geben können.

Echtzeit-Content-APIs spielen eine entscheidende Rolle bei der Ermöglichung von KI-Transparenz und Überwachung und erlauben es Organisationen, nachzuvollziehen, wie KI-Systeme Inhalte abrufen, verarbeiten und nutzen. Durch die Instrumentierung von Echtzeit-Content-APIs mit Überwachungsfunktionen können Unternehmen beobachten, welche Inhalte KI-Systeme abrufen, wie häufig sie bestimmte Informationen anfordern und wie diese Inhalte die KI-Ergebnisse beeinflussen. Diese Transparenz ist unerlässlich, um das Verhalten von KIs zu verstehen, die Einhaltung von Datenrichtlinien zu gewährleisten und zu erkennen, wann KI-Systeme auf veraltete oder fehlerhafte Informationen zurückgreifen. Inhaltszuordnungs-Tracking über Echtzeit-APIs ermöglicht es Organisationen, zu verstehen, welche Quellen KI-Systeme für die Generierung von Antworten nutzen, und fördert so Transparenz und Verantwortlichkeit. Die Echtzeitüberwachung von API-Nutzungsmustern hilft, Leistungsengpässe zu identifizieren, die Datenlieferung zu optimieren und sicherzustellen, dass KI-Systeme Zugriff auf die benötigten Informationen haben. Für Organisationen, die Plattformen wie AmICited.com verwenden, bilden Echtzeit-Content-APIs die Grundlage, um zu überwachen, wie KI-Systeme wie ChatGPT, Perplexity und Google AI Overviews Markeninhalte referenzieren und zitieren und so Echtzeit-Einblicke in KI-generierte Erwähnungen und Zitate ermöglichen.

Die Unterscheidung zwischen Echtzeit-Content-APIs und Batch-Verarbeitung stellt einen grundlegenden Unterschied in der Datenbereitstellung für KI-Systeme dar. Batch-Verarbeitung sammelt Daten über einen Zeitraum und verarbeitet sie in geplanten Intervallen – typischerweise Stunden oder Tage später –, wodurch sie sich für historische Analysen und Reporting eignet, aber nicht für zeitkritische KI-Anwendungen. Echtzeit-Content-APIs hingegen liefern Daten unmittelbar nach ihrer Verfügbarkeit, sodass KI-Systeme auf aktuelle Bedingungen reagieren und Entscheidungen auf Basis der neuesten Informationen treffen können. Für KI-Anwendungen, die sofortige Reaktionen erfordern – wie Betrugserkennung, Handelssysteme oder Kundenservice-Chatbots – ist die Latenz der Batch-Verarbeitung nicht akzeptabel. Echtzeit-APIs ermöglichen zudem kontinuierliches Lernen und Anpassen, bei dem KI-Systeme ihr Verhalten auf Basis unmittelbaren Feedbacks und sich ändernder Bedingungen anpassen können. Während die Batch-Verarbeitung für die kosteneffiziente Verarbeitung großer Mengen historischer Daten geeignet ist, sind Echtzeit-Content-APIs entscheidend für Anwendungen, bei denen Aktualität und Präzision höchste Priorität genießen. Viele moderne KI-Architekturen setzen auf einen hybriden Ansatz, bei dem Echtzeit-APIs für unmittelbare Entscheidungen genutzt werden, während die Batch-Verarbeitung tiefere Analysen und Modelltraining auf historischen Daten übernimmt.

Die Implementierung von Echtzeit-Content-APIs für KI-Systeme bringt verschiedene technische und operative Herausforderungen mit sich. Skalierbarkeit bleibt ein zentrales Thema, denn das Aufrechterhalten von Millionen gleichzeitiger Verbindungen bei durchgehend hoher Performance erfordert ausgefeilte Infrastruktur und sorgfältiges Ressourcenmanagement. Datenkonsistenz über verteilte Systeme wird in Echtzeitumgebungen komplexer, da sichergestellt werden muss, dass alle KI-Systeme Updates in der richtigen Reihenfolge und ohne Duplikate erhalten. Fehlerbehandlung und Resilienz sind essenziell, da Netzwerkprobleme, Ausfälle oder Datenbeschädigungen die KI-Performance beeinträchtigen können; robuste Mechanismen für Verbindungswiederherstellung, Nachrichten-Wiederholung und Statussynchronisierung sind unerlässlich. Kostenaspekte können erheblich sein, da Echtzeit-Streaming-Infrastrukturen meist mehr Ressourcen erfordern als Batch-Verarbeitung, wobei der Mehrwert durch verbesserte KI-Präzision und Reaktionsfähigkeit häufig die Investition rechtfertigt. Sicherheit und Zugriffskontrolle müssen sorgfältig implementiert werden, um sicherzustellen, dass KI-Systeme nur autorisierte Inhalte abrufen und sensible Informationen während der Übertragung geschützt sind. Überwachung und Beobachtbarkeit gewinnen in Echtzeitsystemen an Bedeutung, da rasche Datenströme und komplexe Interaktionen eine umfassende Sichtbarkeit des Systemverhaltens und der Performance erfordern.

Mehrere ausgereifte Plattformen und Technologien ermöglichen es Organisationen, Echtzeit-Content-APIs für KI-Systeme zu entwickeln und bereitzustellen. Confluent bietet eine umfassende Data-Streaming-Plattform auf Basis von Apache Kafka und verwaltete Services zum Aufnehmen, Verarbeiten und Bereitstellen von Echtzeitdaten für KI-Anwendungen über seine Real-Time Context Engine und Confluent Intelligence. Tinybird ist auf die Echtzeitdatenverarbeitung und API-Generierung spezialisiert und ermöglicht es Organisationen, Streamingdaten aufzunehmen und sie sofort über APIs mit niedriger Latenz für KI-Anwendungen bereitzustellen. OpenAIs Realtime API ermöglicht die direkte Echtzeitkommunikation mit KI-Modellen und unterstützt Sprach-zu-Sprach-Interaktionen und multimodale Eingaben mit minimaler Latenz. Apache Kafka bleibt der Industriestandard für verteiltes Event-Streaming und bildet das Fundament für zahllose Echtzeitdatenpipelines. AmICited.com hebt sich als führende Plattform für KI-Überwachung und Transparenz hervor und nutzt Echtzeit-Content-APIs, um zu verfolgen, wie KI-Systeme Markeninhalte auf ChatGPT, Perplexity, Google AI Overviews und anderen KI-Plattformen referenzieren und zitieren. Diese Plattformen ermöglichen es Unternehmen, anspruchsvolle KI-Systeme zu entwickeln, die Echtzeit-Inhalte für bessere Präzision, Reaktionsfähigkeit und Entscheidungsqualität nutzen.

Echtzeit-Content-APIs stellen persistente Verbindungen her, die Daten an Clients senden, sobald sie verfügbar sind, während traditionelle REST-APIs erfordern, dass Clients Anfragen senden und auf Antworten warten. Echtzeit-Content-APIs liefern Informationen in Millisekunden mit kontinuierlichen Updates, während REST-APIs eine höhere Latenz aufweisen und regelmäßiges Abfragen für neue Daten benötigen. Dadurch eignen sich Echtzeit-APIs ideal für KI-Systeme, die aktuelle Informationen benötigen, während REST-APIs besser für Standard-Webdienste geeignet sind.

KI-Systeme wie LLMs und KI-Agenten treffen Entscheidungen auf Basis der ihnen zur Verfügung stehenden Informationen. Veraltete oder stagnierende Daten können zu ungenauen Antworten, verpassten Chancen und schlechter Entscheidungsfindung führen. Echtzeit-Content-APIs stellen sicher, dass KI-Systeme stets Zugriff auf die aktuellsten Informationen haben, sodass sie präzise Antworten geben, aktuelle Bedingungen verstehen und sich an veränderte Umstände anpassen können. Dies ist insbesondere für Anwendungen wie Betrugserkennung, Handel und personalisierte Empfehlungen kritisch, bei denen Verzögerungen zu erheblichen Fehlern führen können.

Übliche Protokolle sind WebSockets für bidirektionale Kommunikation, Server-Sent Events (SSE) für unidirektionale Server-zu-Client-Updates, gRPC für leistungsstarke Microservices-Kommunikation, Apache Kafka für verteiltes Event-Streaming, MQTT für IoT-Anwendungen und AMQP für Enterprise Messaging. Jedes Protokoll hat unterschiedliche Stärken und ist für spezifische Anwendungsfälle optimiert – von interaktiven Anwendungen bis hin zu groß angelegten Datenpipelines.

Echtzeit-Content-APIs verbessern die Genauigkeit, indem sie sicherstellen, dass KI-Modelle beim Generieren von Antworten Zugriff auf die aktuellsten und relevantesten Informationen haben. Dies ist besonders wichtig für Retrieval-Augmented-Generation-(RAG)-Systeme, bei denen die Qualität des abgerufenen Kontexts die Antwortqualität direkt beeinflusst. Mit aktuellen Daten können KI-Systeme präzisere Empfehlungen geben, Betrug effektiver erkennen und besser informierte Entscheidungen auf Basis aktueller Bedingungen anstelle veralteter Informationen treffen.

Wesentliche Herausforderungen umfassen das Skalieren für Millionen gleichzeitiger Verbindungen, das Sicherstellen von Datenkonsistenz über verteilte Systeme hinweg, die Implementierung robuster Fehlerbehandlungs- und Wiederherstellungsmechanismen, die Kostenkontrolle der Echtzeit-Infrastruktur, das Sichern sensibler Daten während der Übertragung und das Aufrechterhalten umfassender Überwachung und Beobachtbarkeit. Diese Herausforderungen erfordern eine ausgefeilte Infrastruktur, sorgfältige Architekturplanung und kontinuierliches Betriebsmanagement.

Echtzeit-Content-APIs ermöglichen es Organisationen zu verfolgen, auf welche Inhalte KI-Systeme zugreifen, wie häufig sie bestimmte Informationen abrufen und wie diese Inhalte die KI-Ausgaben beeinflussen. Durch die Instrumentierung von APIs mit Überwachungsfunktionen können Organisationen das Verhalten von KIs beobachten, die Einhaltung von Datenrichtlinien sicherstellen, Inhaltszuordnungen verfolgen und verstehen, auf welche Quellen sich KI-Systeme stützen. Diese Transparenz ist entscheidend für Nachvollziehbarkeit, Verantwortung und das Verständnis der KI-Systemleistung.

Echtzeit-Content-APIs benötigen in der Regel mehr Infrastrukturressourcen als Batch-Verarbeitung, da sie persistente Verbindungen aufrechterhalten und Daten mit minimaler Latenz liefern müssen. Der durch verbesserte KI-Genauigkeit, schnellere Entscheidungsfindung und bessere Nutzererfahrungen erzielte Mehrwert rechtfertigt jedoch oft die höheren Kosten. Viele Unternehmen verfolgen einen hybriden Ansatz, bei dem Echtzeit-APIs für sofortige Entscheidungen genutzt werden, während die Batch-Verarbeitung tiefere Analysen und das Training von Modellen auf historischen Daten übernimmt.

AmICited.com nutzt Echtzeit-Content-APIs, um zu überwachen, wie KI-Systeme wie ChatGPT, Perplexity und Google AI Overviews Markeninhalte referenzieren und zitieren. Die Plattform bietet Echtzeit-Transparenz in Bezug auf KI-generierte Erwähnungen, Zitate und Inhaltszuordnungen und ermöglicht es Organisationen, zu verfolgen, wie ihre Inhalte von KI-Systemen verwendet werden. Diese Echtzeit-Überwachung hilft Marken, ihre Präsenz in KI-Ausgaben zu verstehen und eine korrekte Darstellung über verschiedene KI-Plattformen hinweg sicherzustellen.

Verfolgen und überwachen Sie, wie KI-Systeme wie ChatGPT, Perplexity und Google AI Overviews Ihre Marke mit der Echtzeit-Inhaltsüberwachungsplattform von AmICited.com zitieren und referenzieren.

Erfahren Sie, was API-First Content ist, wie es KI-Sichtbarkeit ermöglicht und warum es für die Inhaltsarchitektur wichtig ist. Entdecken Sie, wie strukturierte...

Erfahren Sie, wie Echtzeitsuche in der KI funktioniert, welche Vorteile sie für Nutzer und Unternehmen bietet und wie sie sich von traditionellen Suchmaschinen ...

Entdecken Sie Echtzeit-KI-Adaptation – die Technologie, mit der KI-Systeme kontinuierlich aus aktuellen Ereignissen und Daten lernen. Erfahren Sie, wie adaptive...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.