Crawlability

Crawlability ist die Fähigkeit von Suchmaschinen, auf Website-Seiten zuzugreifen und sie zu navigieren. Erfahren Sie, wie Crawler arbeiten, was sie blockiert un...

Screaming Frog ist ein Website-Crawler-Tool, das für technische SEO-Audits entwickelt wurde. Es analysiert die Website-Struktur, identifiziert gängige SEO-Probleme und liefert detaillierte Einblicke in Onpage-Optimierungsmöglichkeiten. Das Tool ahmt nach, wie Suchmaschinen Websites crawlen und indexieren, und hilft SEO-Profis dabei, defekte Links, doppelte Inhalte, Metadata-Probleme und andere technische Fehler zu entdecken, die die Sichtbarkeit in Suchmaschinen beeinträchtigen.

Screaming Frog ist ein Website-Crawler-Tool, das für technische SEO-Audits entwickelt wurde. Es analysiert die Website-Struktur, identifiziert gängige SEO-Probleme und liefert detaillierte Einblicke in Onpage-Optimierungsmöglichkeiten. Das Tool ahmt nach, wie Suchmaschinen Websites crawlen und indexieren, und hilft SEO-Profis dabei, defekte Links, doppelte Inhalte, Metadata-Probleme und andere technische Fehler zu entdecken, die die Sichtbarkeit in Suchmaschinen beeinträchtigen.

Screaming Frog ist ein spezialisiertes Website-Crawler-Tool, das für umfassende technische SEO-Audits entwickelt wurde, indem es die Website-Struktur analysiert, gängige SEO-Probleme identifiziert und detaillierte Einblicke in Onpage-Optimierungsmöglichkeiten liefert. Das Tool ahmt nach, wie Suchmaschinen wie Google Websites crawlen und indexieren, sodass SEO-Profis defekte Links, doppelte Inhalte, Metadata-Probleme und andere technische Fehler entdecken können, die sich negativ auf die Sichtbarkeit in Suchmaschinen auswirken. Screaming Frog ist sowohl als kostenlose als auch als Premium-Softwarelösung verfügbar; die kostenlose Version erlaubt das Crawlen von bis zu 500 URLs, während die kostenpflichtige Version die Crawl-Beschränkungen basierend auf den verfügbaren Systemressourcen aufhebt. Die Plattform hat sich zum Branchenstandard bei SEO-Profis, Agenturen für digitales Marketing und Unternehmen entwickelt, die eine optimale Website-Gesundheit und Suchmaschinen-Performance anstreben.

Screaming Frog entwickelte sich Mitte der 2000er-Jahre zu einem wichtigen Tool in der SEO-Branche, als technische SEO für Suchmaschinen-Rankings immer wichtiger wurde. Das Tool wurde von einem britischen Unternehmen entwickelt und gehört heute zu den am weitesten verbreiteten Website-Crawlern in der SEO-Community. Laut Branchendaten nutzen etwa 10 % der Organisationen im Bereich SEO und KI-Intelligenz Screaming Frog (Stand 2025), was seine starke Marktpräsenz unterstreicht. Die Plattform hält hohe Nutzerzufriedenheitswerte, mit 4,7 von 5 Punkten auf G2 und 4,9 von 5 Punkten auf Capterra, was ihre Zuverlässigkeit und Effektivität bei technischer SEO-Analyse widerspiegelt. Die Langlebigkeit des Tools und regelmäßige Updates haben es zu einer vertrauenswürdigen Ressource für Profis gemacht, die verstehen müssen, wie Suchmaschinen ihre Websites im Detail wahrnehmen.

Screaming Frog arbeitet mit einem Breadth-First-Crawling-Algorithmus, der systematisch Webseiten entdeckt und analysiert, indem er Hyperlinks im HTML-Code folgt – ähnlich wie Googlebot das Internet crawlt. Das Tool nutzt eine konfigurierbare hybride Speicher-Engine, mit der Nutzer nahezu jeden Aspekt des Crawlings anpassen können, darunter Crawltiefe, Geschwindigkeit, User-Agent-Konfiguration und bestimmte URL-Muster, die in die Analyse ein- oder ausgeschlossen werden sollen. Beim Start eines Crawls besucht Screaming Frog systematisch jede Seite, extrahiert Metadaten, analysiert die Seitenstruktur, identifiziert Links und bewertet technische Elemente wie Header, Redirects und Canonical-Tags. Die Daten werden lokal auf dem Rechner des Nutzers gespeichert, was eine schnelle Analyse und Vergleiche ermöglicht, ohne auf Cloud-Infrastruktur angewiesen zu sein. Dieser lokale Verarbeitungsansatz bietet volle Datenhoheit und Datenschutz – ein wichtiger Vorteil für Unternehmen, die sensible Website-Informationen verarbeiten. Der Crawl-Prozess kann so konfiguriert werden, dass robots.txt beachtet, Crawl-Delay-Direktiven eingehalten und verschiedene User-Agents simuliert werden, um zu testen, wie Suchmaschinen und andere Bots mit der Website interagieren.

Screaming Frog bietet eine breite Palette an Funktionen, die nahezu jeden Aspekt der technischen SEO-Analyse abdecken. Die Plattform erkennt defekte Links (intern und extern), erkennt doppelte Inhalte durch exakten Abgleich und, bei Integration mit LLM-APIs, auch semantisch, prüft Redirect-Ketten und -Schleifen, analysiert Metadaten wie Titel und Beschreibungen, identifiziert nicht responsive Seiten und bewertet die Inhaltsqualität anhand von Lesbarkeitsmetriken. Das Tool erstellt detaillierte Berichte über XML-Sitemap-Erreichbarkeit und Fehler, prüft robots.txt-Konfiguration, erkennt Kanonisierungsprobleme und liefert Einblicke in die interne Verlinkungsstruktur. Nutzer können die Seitenarchitektur über interaktive Diagramme visualisieren, Daten in verschiedenen Formaten exportieren und Crawl-Ergebnisse über die Zeit vergleichen. Die Integration mit Large Language Model APIs von Anbietern wie OpenAI und Google Gemini ermöglicht fortschrittliche Funktionen wie semantische Duplikaterkennung und KI-gestützte Inhaltsanalyse, sodass Profis auch solche Content-Probleme entdecken, die mit klassischem Keyword-Matching nicht auffallen würden.

| Funktion | Screaming Frog | Lumar (Deepcrawl) | Sitebulb | seoClarity |

|---|---|---|---|---|

| Kostenlose Version verfügbar | ✓ (500 URLs) | ✗ | ✗ | ✓ (Eingeschränkt) |

| Jährlicher Preis | ca. 200 USD | Individuell Enterprise | ca. 300–500 USD | 3.000+ USD |

| Unbegrenzte URLs crawlen | ✓ (Paid) | ✓ | ✓ | ✓ |

| Geplante Crawls | ✓ (Paid) | ✓ | ✓ | ✓ |

| Semantische Duplikaterkennung | ✓ (mit LLM API) | ✓ | ✓ | ✓ |

| Interne Link-Analyse | ✓ | ✓ | ✓ | ✓ |

| Backlink-Analyse | ✗ | ✗ | ✗ | ✓ |

| Keyword-Recherche | ✗ | ✗ | ✗ | ✓ |

| Rank-Tracking | ✗ | ✗ | ✗ | ✓ |

| Bedienungskomplexität | Hoch | Mittel | Mittel | Mittel |

| G2-Bewertung | 4,7/5 | 4,5/5 | 4,6/5 | 4,8/5 |

| Am besten für | Technische Audits, detaillierte Analyse | Enterprise-Scale | Benutzerfreundliche Audits | Umfassende SEO-Plattform |

Screaming Frog ist besonders stark bei der Erkennung eines breiten Spektrums an technischen SEO-Problemen, die sich negativ auf die Sichtbarkeit in Suchmaschinen und das Nutzererlebnis auswirken. Das Tool findet defekte Links, die das Nutzererlebnis beeinträchtigen und Crawl-Budget verschwenden, erkennt doppelte Seitentitel und Metabeschreibungen, die Suchmaschinen bei der Seiteninterpretation verwirren, entdeckt fehlende oder doppelte H1-Überschriften, die gegen SEO-Best-Practices verstoßen, und markiert dünne Inhalte, die für ein gutes Ranking nicht ausreichen. Die Plattform analysiert Redirect-Ketten, die Crawl-Budget verschwenden und die Ladezeiten verlangsamen, identifiziert nicht responsive Seiten, prüft die Genauigkeit und Zugänglichkeit der XML-Sitemap und erkennt Kanonisierungsprobleme, bei denen verschiedene Versionen desselben Inhalts konkurrieren. Screaming Frog findet robots.txt-Fehler, die versehentlich wichtige Seiten vom Index ausschließen, und liefert Lesbarkeitsmetriken wie Flesch-Lesbarkeitswerte und durchschnittliche Wörter pro Satz. Darüber hinaus kann das Tool hreflang-Fehler für internationales SEO, Probleme mit strukturierten Daten (Schema Markup) und JavaScript-Rendering-Probleme erkennen, die Suchmaschinen daran hindern könnten, den Seiteninhalt vollständig zu erfassen.

Die Implementierung von Screaming Frog in einen technischen SEO-Workflow beginnt in der Regel mit dem Herunterladen und Installieren der Desktop-Anwendung, gefolgt von der Konfiguration der Crawl-Parameter entsprechend den Audit-Zielen. Nutzer starten einen Crawl, indem sie die Ziel-Domain eingeben und passende Einstellungen wie Crawltiefe, maximale Anzahl zu crawlender URLs und bestimmte einzuschließende oder auszuschließende URL-Muster wählen. Nach Abschluss des Crawls präsentiert das Tool die Daten in einer tabellarischen Benutzeroberfläche, die in verschiedene Reiter wie interne Links, externe Links, Redirects, Metadaten und Inhaltsanalyse unterteilt ist. SEO-Profis priorisieren die gefundenen Probleme nach Auswirkung und Aufwand, wobei sie die Filter- und Sortierfunktionen von Screaming Frog nutzen, um sich auf die kritischsten Themen zu konzentrieren. Über die Exportfunktion lassen sich detaillierte Berichte als CSV oder Excel herunterladen und an Entwicklungsteams, Kunden oder Stakeholder weitergeben. Viele Profis nutzen Screaming Frog als Teil eines größeren SEO-Toolkits, indem sie dessen technische Audit-Funktionen mit anderen Plattformen für Keyword-Recherche, Ranking-Tracking und Wettbewerbsanalyse kombinieren. Regelmäßige Crawls – oft monatlich oder quartalsweise – helfen dabei, Fortschritte bei technischen Optimierungen zu verfolgen und neue Probleme zu identifizieren, wenn sich die Website weiterentwickelt.

Während Screaming Frog sich hauptsächlich auf klassische Suchmaschinenoptimierung und technische Website-Gesundheit konzentriert, wird seine Rolle im erweiterten KI-Suchumfeld immer relevanter. Da KI-basierte Suchmaschinen wie ChatGPT, Perplexity, Google AI Overviews und Claude das Suchverhalten zunehmend prägen, bleibt eine starke technische SEO-Grundlage essenziell, damit KI-Systeme den Website-Content korrekt crawlen, verstehen und zitieren können. Screaming Frog unterstützt die KI-Auffindbarkeit durch die Erkennung technischer Probleme, Analyse der Inhaltsstruktur und die Sicherstellung korrekter Metadaten. Saubere technische Grundlagen – etwa richtige Kanonisierung, klare Seitenstruktur, korrekte Metadaten und zugängliche Inhalte – erleichtern es KI-Crawlern, die Informationen zu indexieren und die Wahrscheinlichkeit für Markenerwähnungen und Zitate in KI-generierten Antworten zu erhöhen. Die Lesbarkeitsanalyse und semantische Duplikaterkennung (bei Integration von LLM-APIs) helfen zudem, Inhalte so zu strukturieren, dass sowohl Suchmaschinen als auch KI-Systeme sie effektiv verarbeiten und referenzieren können.

Screaming Frog nutzt ein einfaches Freemium-Preismodell, das sowohl einzelnen Profis als auch Unternehmen gerecht wird. Die kostenlose Version erlaubt das Crawlen und Herunterladen von bis zu 500 URLs pro Website und eignet sich somit für kleine Seiten, erste Audits und zum Testen vor dem Kauf einer Lizenz. Die kostenpflichtige Lizenz kostet etwa £149.00 pro Jahr (ca. 200 USD) und hebt die URL-Beschränkung abhängig vom verfügbaren System-Speicher und Speicherplatz auf, sodass praktisch Websites jeder Größe auditiert werden können. Die Bezahlversion schaltet zudem erweiterte Funktionen frei, darunter Crawl-Planung für wiederkehrende Audits, das Speichern und erneute Hochladen von Crawls für Offline-Analysen sowie Crawl-Vergleiche zur Fortschrittskontrolle. Für Unternehmen, die mehrere Lizenzen erwerben, bietet Screaming Frog Mengenrabatte – ideal für Agenturen mit vielen Kundenprojekten. Lizenzen werden pro Nutzer vergeben, nicht pro Unternehmen, was es verschiedenen Teammitgliedern erlaubt, dieselbe Lizenz auf unterschiedlichen Rechnern zu verwenden – ein großer Vorteil für kollaborative Teams. Diese Preisstruktur trägt zur weiten Verbreitung von Screaming Frog bei, da die niedrigen jährlichen Kosten das Tool für Freelancer, kleine Agenturen und Großunternehmen gleichermaßen zugänglich machen.

Die Zukunft von Screaming Frog und technischen SEO-Tools generell entwickelt sich im Zuge des Aufkommens von KI-Suchmaschinen und veränderten Suchgewohnheiten weiter. Da Unternehmen die Bedeutung von KI-Sichtbarkeit neben klassischen Suchmaschinen-Rankings erkennen, werden Tools wie Screaming Frog ihre Fähigkeiten voraussichtlich um KI-spezifische Optimierungsfunktionen erweitern. Die Integration von Large Language Model APIs stellt bereits einen wichtigen Schritt in diese Richtung dar, indem sie semantische Analysen und KI-gestützte Inhaltsbewertungen ermöglicht. Künftige Entwicklungen könnten das Monitoring beinhalten, wie KIs Websites crawlen und zitieren, eine Anbindung an KI-Suchtracking-Plattformen wie AmICited sowie erweiterte Funktionen zur Optimierung von Inhalten speziell für KI-Verständlichkeit und -Zitation. Der Fokus des Tools auf technische Grundlagen – saubere Seitenstruktur, richtige Metadaten, zugängliche Inhalte und klare Verlinkung – bleibt unabhängig vom technischen Wandel essenziell. Da die SEO-Branche weiter reift und sich diversifiziert, ist Screaming Frog als spezialisiertes Audit-Tool gut für anhaltende Relevanz positioniert – insbesondere für Profis, die eine tiefe, detaillierte Analyse des technischen Website-Zustands benötigen. Die regelmäßigen Updates und Feature-Erweiterungen der Plattform lassen erwarten, dass sie sich auch künftig an neue SEO-Herausforderungen und Möglichkeiten im KI-getriebenen Suchumfeld anpasst.

Screaming Frog bleibt ein unverzichtbares Tool für SEO-Profis, Agenturen und Unternehmen, die auf eine starke technische SEO-Basis setzen. Die Kombination aus Erschwinglichkeit, detaillierten Analysefunktionen und benutzerfreundlicher Oberfläche macht es zur bevorzugten Wahl von Millionen Profis für Website-Audits und die Identifizierung von Optimierungspotenzialen. Egal, ob Sie eine kleine Unternehmenswebsite verwalten oder große Unternehmensauftritte prüfen: Screaming Frog liefert die technischen Einblicke, die nötig sind, damit Suchmaschinen und KI-Systeme Ihre Inhalte effektiv crawlen, verstehen und ranken können. Die Weiterentwicklung des Tools, etwa die LLM-API-Integration, unterstreicht das Bestreben, auch im zunehmend KI-getriebenen Suchumfeld relevant zu bleiben. Mit Screaming Frog-Audits identifizierte und behobene technische Probleme schaffen eine solide Grundlage für Sichtbarkeit in klassischen Suchmaschinen und neuen KI-Suchplattformen – und unterstützen so Ihre übergreifenden Digital-Marketing-Ziele sowie die Auffindbarkeit Ihrer Marke.

Screaming Frog wird hauptsächlich für umfassende technische SEO-Audits von Websites verwendet. Es crawlt Websites, um gängige SEO-Probleme wie defekte Links, doppelte Inhalte, fehlende Metadaten, Redirect-Ketten, nicht responsive Seiten und dünne Inhalte zu identifizieren. Das Tool hilft SEO-Profis zu verstehen, wie Suchmaschinen auf ihre Websites zugreifen und diese interpretieren, damit sie fundierte Entscheidungen zur Onpage-Optimierung und Verbesserung der Seitenstruktur treffen können.

Screaming Frog verwendet einen Breadth-First-Crawling-Algorithmus, der nachahmt, wie Googlebot Webseiten entdeckt und indexiert. Das Tool crawlt Websites, indem es Hyperlinks im HTML folgt, die Seitenstruktur, Metadaten und technische Elemente analysiert. Es setzt eine konfigurierbare hybride Speicher-Engine ein, die es Nutzern ermöglicht, die Crawl-Parameter wie Tiefe, Geschwindigkeit und spezifische URL-Muster für die Analyse individuell anzupassen.

Die kostenlose Version von Screaming Frog ermöglicht es Nutzern, bis zu 500 URLs pro Website zu crawlen und herunterzuladen – ideal für kleinere Seiten und erste Audits. Die kostenpflichtige Version (ca. 200 USD pro Jahr) entfernt die Crawl-Beschränkung, abhängig vom vorhandenen Speicher und Speicherplatz, und bietet Zugang zu erweiterten Funktionen wie Crawl-Planung, Speichern und erneutes Hochladen von Crawls, Crawl-Vergleichen und individuellen Crawl-Konfigurationen für detailliertere Analysen.

Ja, Screaming Frog kann doppelte Inhalte auf verschiedene Arten erkennen. Das Tool entdeckt exakte Duplikate durch Analyse der Metatags und Seiteninhalte. Mit der Integration von Large Language Model (LLM) APIs wie OpenAI kann Screaming Frog auch semantische Duplikate identifizieren – Seiten mit ähnlicher Bedeutung, aber unterschiedlicher Formulierung – und bietet so einen umfassenden Überblick über Duplikationsprobleme auf der Website.

Screaming Frog ist in erster Linie ein spezialisierter Website-Crawler für technische SEO-Audits, während Ahrefs eine umfassende All-in-One-SEO-Plattform ist. Screaming Frog überzeugt durch detaillierte Onpage-Analysen, interne Verlinkung und Struktur-Audits, verfügt jedoch nicht über Funktionen wie Keyword-Recherche, Ranking-Tracking und Backlink-Analysen. Ahrefs bietet einen breiteren Funktionsumfang, ist aber bei technischen Crawl-Analysen möglicherweise weniger detailliert. Viele SEO-Profis nutzen beide Tools ergänzend.

Screaming Frog kann zahlreiche technische SEO-Probleme identifizieren, darunter defekte interne und externe Links, doppelte Seitentitel und Metabeschreibungen, fehlende oder doppelte H1-Überschriften, dünne Inhalte, nicht responsive Seiten, Redirect-Ketten und -Schleifen, Fehler in der XML-Sitemap, robots.txt-Probleme, Kanonisierungskonflikte und Lesbarkeitsmetriken für Inhalte. Das Tool liefert zudem Flesch-Lesbarkeitswerte und analysiert die durchschnittliche Satzlänge, um die Inhaltsqualität zu beurteilen.

Während die kostenlose Version von Screaming Frog auf 500 URLs begrenzt ist, kann die kostenpflichtige Version Websites jeder Größe crawlen – abhängig vom verfügbaren System-Speicher und Speicherplatz. Für sehr große Unternehmenswebsites mit Millionen von Seiten können allerdings Performance-Einschränkungen auftreten. Unternehmenslösungen wie Lumar (ehemals Deepcrawl) oder seoClarity sind für sehr große Crawls optimiert, dennoch bleibt Screaming Frog bei Agenturen und Profis wegen seiner detaillierten Analysen und dem günstigen Preis beliebt.

Beginnen Sie zu verfolgen, wie KI-Chatbots Ihre Marke auf ChatGPT, Perplexity und anderen Plattformen erwähnen. Erhalten Sie umsetzbare Erkenntnisse zur Verbesserung Ihrer KI-Präsenz.

Crawlability ist die Fähigkeit von Suchmaschinen, auf Website-Seiten zuzugreifen und sie zu navigieren. Erfahren Sie, wie Crawler arbeiten, was sie blockiert un...

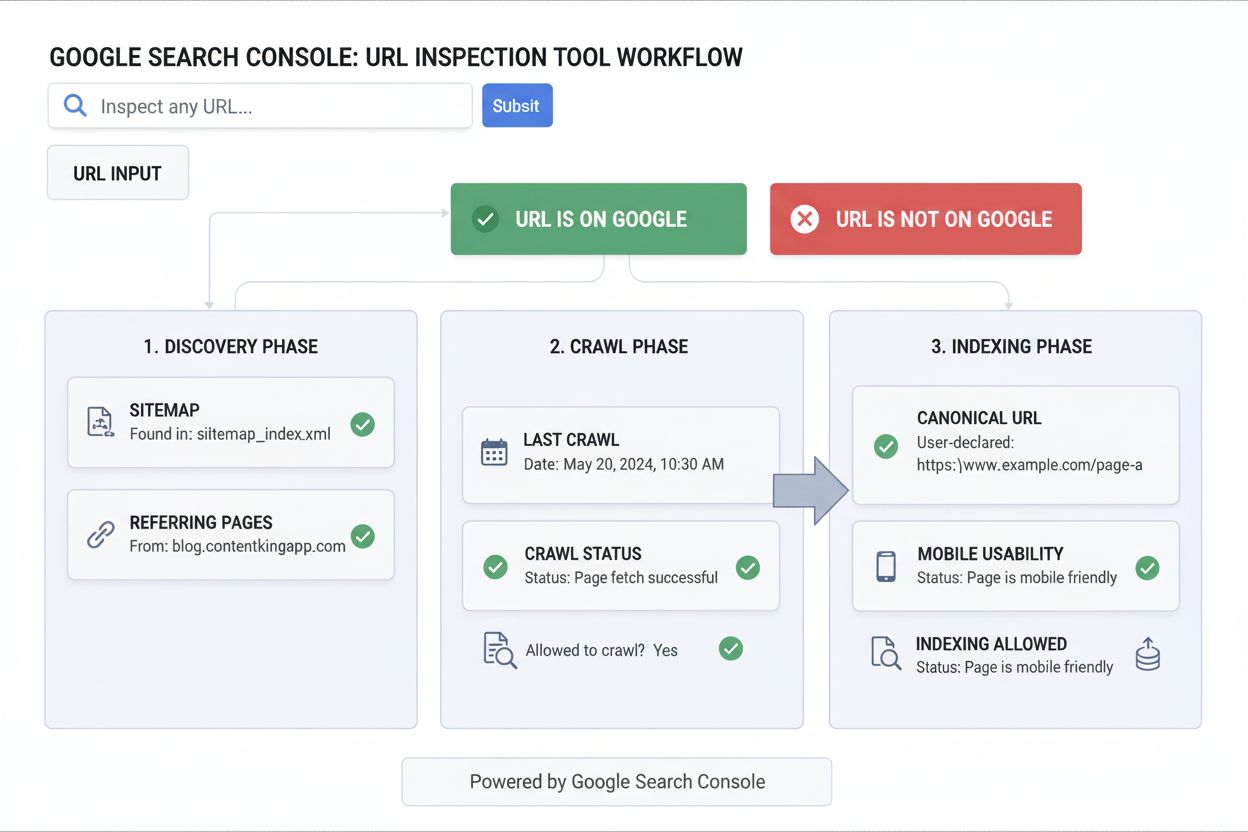

Erfahren Sie, was das URL-Inspektionstool ist, wie es funktioniert und warum es für die Überwachung des Seitenindexierungsstatus in der Google Search Console un...

Die Crawl-Rate ist die Geschwindigkeit, mit der Suchmaschinen Ihre Website crawlen. Erfahren Sie, wie sie die Indexierung, die SEO-Leistung und die Suchsichtbar...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.