Original Research - Eigene Daten und Studien

Originalforschung und First-Party-Daten sind proprietäre Studien und Kundendaten, die Marken direkt erheben. Erfahren Sie, wie sie Autorität aufbauen, KI-Zitate...

Sekundärforschung ist die Analyse und Interpretation bereits vorhandener Daten, die zuvor von anderen Forschern oder Organisationen zu unterschiedlichen Zwecken erhoben wurden. Sie beinhaltet das Zusammenführen veröffentlichter Datensätze, Berichte, wissenschaftlicher Zeitschriften und anderer Quellen, um neue Forschungsfragen zu beantworten oder Hypothesen zu überprüfen, ohne selbst neue Daten zu erheben.

Sekundärforschung ist die Analyse und Interpretation bereits vorhandener Daten, die zuvor von anderen Forschern oder Organisationen zu unterschiedlichen Zwecken erhoben wurden. Sie beinhaltet das Zusammenführen veröffentlichter Datensätze, Berichte, wissenschaftlicher Zeitschriften und anderer Quellen, um neue Forschungsfragen zu beantworten oder Hypothesen zu überprüfen, ohne selbst neue Daten zu erheben.

Sekundärforschung, auch bekannt als Schreibtischforschung, ist eine systematische Forschungsmethodik, bei der bereits erhobene Daten, die von anderen Forschenden, Organisationen oder Institutionen zu unterschiedlichen Zwecken gesammelt wurden, analysiert, zusammengeführt und interpretiert werden. Anstatt eigene Daten durch Umfragen, Interviews oder Experimente zu sammeln, nutzt die Sekundärforschung veröffentlichte Datensätze, Berichte, wissenschaftliche Zeitschriften, amtliche Statistiken und andere gesammelte Informationsquellen, um neue Forschungsfragen zu beantworten oder Hypothesen zu überprüfen. Dieser Ansatz stellt einen grundlegenden Wandel von der Datenerhebung zur Datenanalyse und Interpretation dar und ermöglicht es Organisationen, verwertbare Erkenntnisse aus bereits öffentlich zugänglichen Informationen oder internen Archiven zu gewinnen. Der Begriff „sekundär“ bezieht sich darauf, dass Forschende mit Daten arbeiten, die ursprünglich zu einem anderen Zweck erhoben wurden – Daten, die für ein Ziel gesammelt wurden, werden erneut analysiert, um andere Forschungsfragen oder geschäftliche Herausforderungen zu adressieren.

Die Praxis der Sekundärforschung hat sich im vergangenen Jahrhundert erheblich weiterentwickelt – von literaturbasierten Bibliotheksrecherchen hin zu anspruchsvoller digitaler Datenanalyse. Früher waren Forschende auf physische Bibliotheken, Archive und Publikationen angewiesen, was den Umfang und die Zugänglichkeit der Forschung einschränkte und zeitaufwändig war. Die digitale Revolution hat die Sekundärforschung grundlegend verändert, indem riesige Datensätze sofort über Online-Datenbanken, staatliche Portale und wissenschaftliche Repositorien zugänglich wurden. Heute erwirtschaftet die weltweite Marktforschungsbranche 140 Milliarden US-Dollar Jahresumsatz (Stand 2024), wobei die Sekundärforschung einen erheblichen Anteil daran hat. Das Wachstum ist beachtlich – von 102 Milliarden US-Dollar im Jahr 2021 auf 140 Milliarden US-Dollar in 2024, was einer Steigerung um 37,25 % in nur drei Jahren entspricht. Dieses Wachstum spiegelt die zunehmende datengetriebene Entscheidungsfindung in Organisationen und die Anerkennung der Sekundärforschung als kosteneffizienten Weg zu Marktkenntnissen wider. Das Aufkommen von KI-gestützten Datenanalysetools hat die Sekundärforschung weiter revolutioniert und ermöglicht es Forschenden, riesige Datensätze zu verarbeiten, Muster zu erkennen und Erkenntnisse in nie dagewesener Geschwindigkeit zu gewinnen. Jüngsten Studien zufolge haben 69 % der Marktforschungsprofis synthetische Daten und KI-Analysen in ihre Sekundärforschung integriert, was die rasante technologische Weiterentwicklung des Feldes unterstreicht.

Sekundärforschungsdaten stammen aus zwei Hauptkategorien: interne Quellen und externe Quellen. Interne Sekundärdaten umfassen Informationen, die bereits im Unternehmen gesammelt und gespeichert wurden, wie z. B. Verkaufsdatenbanken, Kundenhistorien, frühere Forschungsprojekte, Kampagnenkennzahlen und Website-Analysen. Diese internen Daten verschaffen Wettbewerbsvorteile, da sie exklusiv der Organisation zur Verfügung stehen und die tatsächliche Unternehmensleistung widerspiegeln. Externe Sekundärdaten umfassen öffentlich verfügbare oder käufliche Informationen von Behörden, wissenschaftlichen Institutionen, Marktforschungsunternehmen, Branchenverbänden und Medien. Staatliche Quellen liefern Zensusdaten, Wirtschaftsstatistiken und regulatorische Informationen; wissenschaftliche Quellen bieten begutachtete Forschung und Langzeitstudien; Marktforschungsagenturen publizieren Branchenberichte und Wettbewerbsanalysen; und Branchenverbände bündeln sektorspezifische Daten und Trends. Die Vielfalt der Sekundärquellen ermöglicht es Forschenden, Erkenntnisse durch Triangulation aus verschiedenen Perspektiven zu gewinnen und Schlussfolgerungen durch Quervergleich zu validieren.

| Aspekt | Sekundärforschung | Primärforschung |

|---|---|---|

| Datenerhebung | Analysiert bereits von anderen erhobene Daten | Sammelt eigene Daten direkt von Quellen |

| Zeitaufwand | Tage bis Wochen | Wochen bis Monate |

| Kosten | Gering bis minimal (oft kostenlos) | Hoch (Teilnehmergewinnung, Durchführung) |

| Datenkontrolle | Keine Kontrolle über Methodik oder Qualität | Volle Kontrolle über Studiendesign und Durchführung |

| Spezifität | Beantwortet ggf. nicht exakt spezifische Forschungsfragen | Maßgeschneidert auf exakte Forschungsziele |

| Forschungsbias | Unbekannte Verzerrung durch ursprüngliche Sammler | Mögliche Verzerrung durch aktuelle Forschende |

| Datenexklusivität | Nicht-exklusiv (Wettbewerber haben Zugriff) | Exklusive Eigentümerschaft der Ergebnisse |

| Stichprobengröße | Oft groß angelegte Datensätze | Variiert je nach Budget und Umfang |

| Relevanz | Muss ggf. an aktuelle Anforderungen angepasst werden | Direkt relevant für aktuelle Forschungsziele |

| Schnelligkeit zu Erkenntnissen | Sofortiger Zugriff auf kompilierte Informationen | Benötigt Zeit für Erhebung und Analyse |

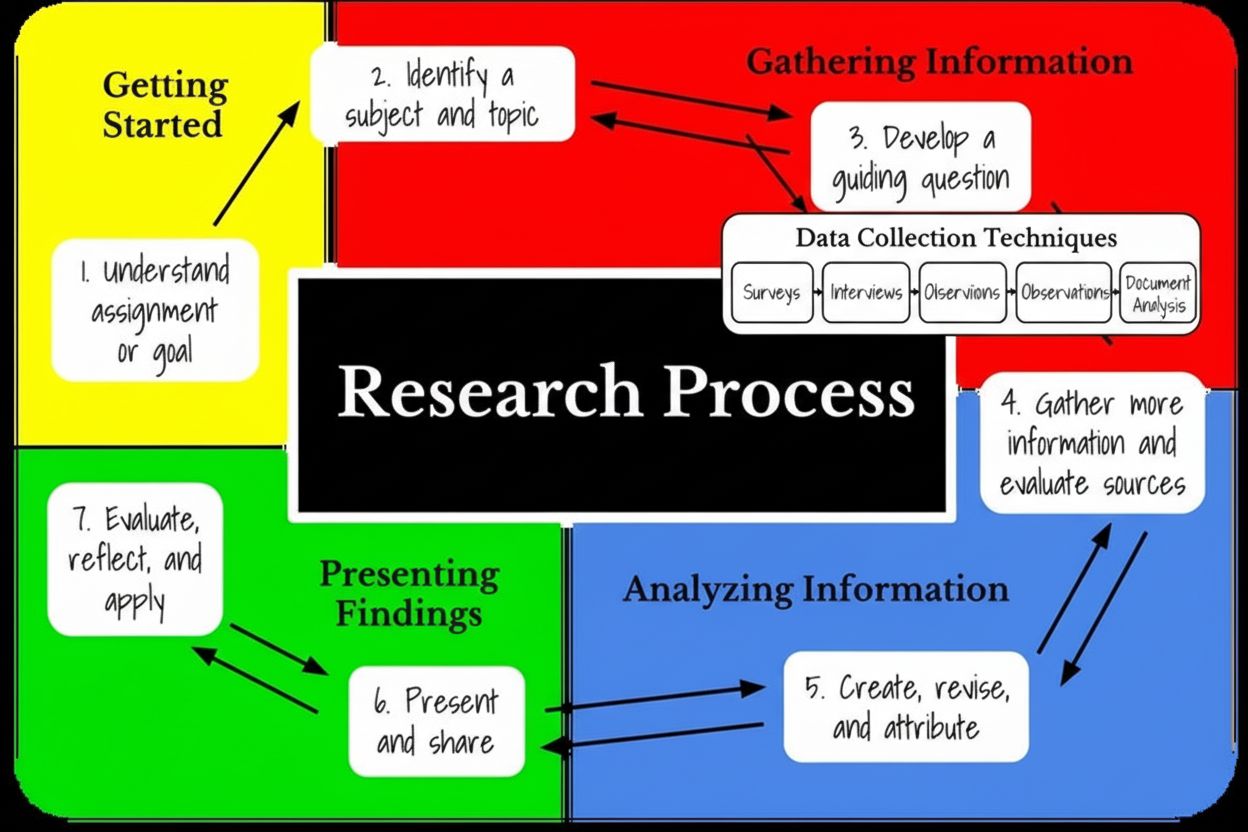

Die Methodik der Sekundärforschung folgt einem strukturierten Fünf-Schritte-Prozess, der eine fundierte Analyse und gültige Schlussfolgerungen gewährleistet. Zunächst wird das Forschungsthema klar definiert und spezifische Forschungsfragen formuliert, die mit Sekundärdaten beantwortet werden könnten. Forschende müssen ihr Ziel eindeutig benennen – ob explorativ (Ursachen verstehen) oder konfirmatorisch (Hypothesen überprüfen). Im zweiten Schritt werden geeignete Sekundärquellen identifiziert und ausgewählt, wobei Kriterien wie Datenrelevanz, Glaubwürdigkeit der Quelle, Veröffentlichungsdatum und geografischer Bezug berücksichtigt werden. Anschließend werden die Daten systematisch gesammelt und organisiert, was oft den Zugriff auf mehrere Datenbanken, die Prüfung der Quellenauthentizität und die Aufbereitung der Informationen in auswertbaren Formaten erfordert. In dieser Phase gilt es, die Datenqualität zu bewerten, die Transparenz der Methodik zu prüfen und festzustellen, ob der Erhebungszeitraum zu den eigenen Bedürfnissen passt. Im vierten Schritt werden Datensätze kombiniert und verglichen, Muster über verschiedene Quellen hinweg erkannt und Trends oder Auffälligkeiten aus der vergleichenden Analyse herausgearbeitet. Forschende müssen ggf. unbrauchbare Daten aussortieren, widersprüchliche Informationen abgleichen und die Ergebnisse in eine schlüssige Darstellung bringen. Im letzten Schritt erfolgt die umfassende Analyse und Interpretation, bei der überprüft wird, ob die Sekundärdaten die ursprünglichen Forschungsfragen ausreichend beantworten, Wissenslücken identifiziert und festgestellt wird, ob ergänzende Primärforschung notwendig ist. Diese strukturierte Herangehensweise gewährleistet, dass Sekundärforschung glaubwürdige, umsetzbare Erkenntnisse und keine oberflächlichen Ergebnisse liefert.

Einer der überzeugendsten Vorteile der Sekundärforschung ist ihre enorme Kosteneffizienz im Vergleich zu Primärmethoden. Die Analyse von Sekundärdaten ist fast immer günstiger als die Durchführung von Primärforschung, wobei Organisationen in der Regel 50–70 % ihrer Forschungskosten durch die Nutzung bestehender Datensätze sparen. Da die Datenerhebung den teuersten Teil der Primärforschung ausmacht – inklusive Teilnehmergewinnung, Anreizen, Fragebogenerstellung und Feldarbeit – entfallen diese Kosten in der Sekundärforschung komplett. Viele Sekundärdatenquellen sind kostenlos über Behörden, öffentliche Bibliotheken und wissenschaftliche Repositorien verfügbar oder können zu geringen Kosten über Abonnements bezogen werden. Auch der Zeitgewinn ist erheblich: Sekundärforschung kann in Tagen oder Wochen abgeschlossen werden, während Primärforschung meist Wochen bis Monate benötigt. Forschende können kompilierte Datensätze sofort über Online-Plattformen abrufen und so kurzfristige Geschäftsentscheidungen treffen. Hinzu kommt, dass Sekundärdaten meist bereits aufbereitet und elektronisch organisiert sind, wodurch der aufwendige Datenbereinigungsprozess, wie er in der Primärforschung erforderlich ist, entfällt. Für Organisationen mit kleinem Budget oder engen Zeitplänen bietet Sekundärforschung einen kostengünstigen Zugang zu Marktanalysen, Wettbewerbsinformationen und Trendbeobachtung. Das Wachstum der globalen Marktforschungsbranche auf 140 Milliarden US-Dollar zeigt die steigenden Investitionen in Forschung, wobei Sekundärforschung einen preiswerten Baustein umfassender Strategien darstellt.

Im Kontext von KI-Monitoring und generativer Suchmaschinenoptimierung spielt Sekundärforschung eine zentrale Rolle beim Aufbau von Vergleichsgrundlagen und der Analyse, wie KI-Systeme Quellen zitieren. Plattformen wie AmICited nutzen Prinzipien der Sekundärforschung, um Markenerwähnungen in KI-Systemen wie ChatGPT, Perplexity, Google KI-Überblicke und Claude zu verfolgen. Durch die Auswertung bestehender Daten zu Wettbewerber-Zitationen, Branchentrends und der historischen Markenperformance in KI-Antworten können Organisationen Muster identifizieren, nach denen KI-Systeme Quellen auswählen und nennen. Sekundärforschung hilft, Benchmarks für die KI-Sichtbarkeit zu etablieren und die eigene Position gegenüber Wettbewerbern und Branchennormen zu verstehen. Organisationen können Sekundärdaten zu Content-Performance, Zitationsmustern und KI-Präferenzen nutzen, um ihre Content-Strategie gezielt für bessere KI-Zitationen zu optimieren. Diese Integration von Sekundärforschung und KI-Monitoring ermöglicht ein umfassendes Verständnis darüber, wie Marken in generativen Suchergebnissen und KI-Antworten erscheinen. Die Analyse bestehender Zitationsdaten, Wettbewerberstrategien und Branchentrends liefert den Kontext für die Interpretation von Echtzeit-KI-Monitoringdaten und ermöglicht ausgereiftere Optimierungsstrategien. Da 47 % der Forschenden weltweit regelmäßig KI in der Marktforschung einsetzen, verändert die Verbindung von Sekundärforschung und KI-gestützten Analysetools die Art, wie Organisationen ihre Marktposition und KI-Sichtbarkeit erfassen.

Die Sicherstellung der Datenqualität in der Sekundärforschung erfordert strenge Validierungsprozesse und eine kritische Prüfung der Quellen. Forschende sollten die Originalmethodik prüfen, einschließlich Stichprobengröße, Eigenschaften der Grundgesamtheit, Datenerhebungsverfahren und potenzieller Verzerrungen, die das Ergebnis beeinflusst haben könnten. Begutachtete Zeitschriften haben höhere Glaubwürdigkeitsstandards als Blogs oder Meinungsartikel, da sie vor Veröffentlichung von Experten geprüft werden. Behörden und etablierte Forschungseinrichtungen wenden in der Regel strenge Qualitätskontrollen an, was ihre Daten zuverlässiger macht als selbstveröffentlichte Quellen. Ein Quervergleich der Ergebnisse über mehrere unabhängige Quellen hilft, Schlussfolgerungen zu validieren und Inkonsistenzen aufzudecken, die auf Qualitätsprobleme hinweisen könnten. Forschende sollten prüfen, ob der Erhebungszeitraum der Originalstudie mit den aktuellen Forschungsbedürfnissen übereinstimmt, denn Daten, die vor fünf Jahren gesammelt wurden, spiegeln möglicherweise nicht mehr die heutige Marktsituation wider. Das Veröffentlichungsdatum ist entscheidend – je älter Sekundärdaten sind, desto weniger relevant sind sie, insbesondere in dynamischen Branchen. Zudem sollte geprüft werden, ob die ursprünglichen Datenerhebungsmethoden mit den eigenen Forschungsanforderungen kompatibel sind, da unterschiedliche Methoden zu nicht vergleichbaren Ergebnissen führen können. Die Kontaktaufnahme zu den ursprünglichen Forschenden oder Organisationen kann zusätzlichen Aufschluss über Erhebungsprozesse, Rücklaufquoten und bekannte Einschränkungen geben. Dieses umfassende Validierungskonzept stellt sicher, dass Schlussfolgerungen aus Sekundärforschung auf glaubwürdigen, hochwertigen Daten und nicht auf potenziell fehlerhaften oder veralteten Informationen beruhen.

Sekundärforschung bietet zahlreiche strategische Vorteile und ist ein unverzichtbarer Bestandteil umfassender Forschungsprogramme. Einfach zugängliche Daten stehen über Online-Datenbanken, Bibliotheken und staatliche Portale bereit und erfordern nur wenig technisches Know-how zum Auffinden. Der schnelle Forschungszeitraum ermöglicht es Organisationen, Fragestellungen innerhalb von Tagen statt Monaten zu beantworten und damit flexibel und wettbewerbsfähig zu agieren. Geringe Kosten machen Sekundärforschung auch für Organisationen mit begrenztem Budget zugänglich und demokratisieren damit den Zugang zu Markteinblicken. Sekundärforschung kann weitere Forschungsmaßnahmen anstoßen, indem sie Wissenslücken aufzeigt, die gezielte Primärstudien rechtfertigen, und bildet so die Grundlage für nachfolgende Untersuchungen. Die Möglichkeit, mit groß angelegten Datensätzen wie Zensusdaten schnell aussagekräftige Ergebnisse zu erzielen, erlaubt Rückschlüsse auf breite Populationen ohne teure Umfragen. Sekundärforschung liefert Vorab-Erkenntnisse, mit denen entschieden werden kann, ob weiterführende Forschung notwendig ist – das spart Ressourcen, wenn sich Antworten bereits in der Literatur finden. Die Breite und Tiefe verfügbarer Daten ermöglichen es, Trends über Jahre hinweg zu analysieren, Muster zu erkennen und historischen Kontext für aktuelle Entscheidungen zu gewinnen. Organisationen können Wettbewerbsvorteile erzielen, indem sie interne Sekundärdaten nutzen, die Wettbewerbern nicht zur Verfügung stehen, und so einzigartige Einblicke in die eigene Performance und Marktstellung erhalten.

Trotz ihrer Vorteile weist die Sekundärforschung bedeutende Einschränkungen auf, die bedacht werden müssen. Veraltete Daten stellen ein zentrales Problem dar, da Sekundärquellen den aktuellen Stand von Markt, Verbraucherverhalten oder Technik oft nicht abbilden. In schnelllebigen Branchen können Sekundärdaten innerhalb weniger Monate obsolet sein; daher müssen Forschende stets die Aktualität prüfen. Kein Einfluss auf die Methodik bedeutet, dass Forschende nicht nachvollziehen können, wie die Originaldaten erhoben wurden, ob Qualitätsstandards eingehalten wurden oder ob unbekannte Verzerrungen eingeflossen sind. Fehlende Datenanpassung an eigene Fragestellungen erfordert häufig eine Anpassung der Ziele an die verfügbaren Informationen, da diese nicht immer exakt den eigenen Bedürfnissen entsprechen. Nicht-exklusive Datenzugriffe erlauben auch Wettbewerbern den Zugriff auf dieselben Quellen; exklusive Wettbewerbsvorteile, wie sie Primärforschung bietet, entfallen. Unbekannte Forscher-Bias der ursprünglichen Datensammler kann Ergebnisse beeinflusst haben, ohne dass dies nachvollziehbar ist. Lücken in der Datenrelevanz machen es oft erforderlich, Sekundärergebnisse durch Primärforschung zu ergänzen. Die Komplexität der Datenintegration verschiedener Quellen mit unterschiedlichen Methoden, Zeiträumen und Grundgesamtheiten kann analytische Herausforderungen mit sich bringen. Forschende müssen daher erhebliche Anstrengungen in die Datenprüfung und Validierung investieren, um verlässliche Erkenntnisse zu gewinnen.

Die Zukunft der Sekundärforschung wird maßgeblich durch künstliche Intelligenz, maschinelles Lernen und fortschrittliche Analysetechnologien geprägt. KI-gestützte Tools ermöglichen die Verarbeitung riesiger Datenmengen, die Erkennung komplexer Muster und die Gewinnung von Erkenntnissen, die manuell nicht zu erzielen wären. 83 % der Marktforschungsprofis planen, 2025 in KI für ihre Forschung zu investieren, was das breite Bewusstsein für das transformative Potenzial von KI zeigt. Die Integration von synthetischen Daten in die Sekundärforschung beschleunigt sich, über 70 % der Marktforschenden erwarten, dass synthetische Daten in drei Jahren mehr als 50 % der Datenerhebung ausmachen. Dies reflektiert die wachsende Bedeutung KI-generierter Erkenntnisse und die Notwendigkeit, klassische Sekundärquellen um algorithmisch erzeugte Daten zu ergänzen. Automatisierte Inhaltsanalyse mittels natürlicher Sprachverarbeitung erlaubt die Auswertung qualitativer Sekundärquellen im großen Stil und die Identifikation von Themen, Stimmungen und semantischen Beziehungen in Tausenden von Dokumenten. Die Verschmelzung von Sekundärforschung und Generative Engine Optimization (GEO) eröffnet neue Möglichkeiten, zu verstehen, wie KI-Systeme Quellen auswählen und referenzieren. Da Systeme wie ChatGPT, Perplexity und Claude zu primären Informationsquellen für Konsumenten werden, entwickeln sich Sekundärforschungsmethoden weiter, um zu analysieren, wie diese Systeme Informationen auswählen, zitieren und präsentieren. Organisationen nutzen zunehmend Sekundärforschung, um Vergleichsgrundlagen für ihre KI-Sichtbarkeit zu schaffen und zu verstehen, wie ihre Marken im Vergleich zu Wettbewerbern in KI-generierten Antworten erscheinen. Zukünftig wird Sekundärforschung voraussichtlich noch anspruchsvoller, schneller und enger mit KI-Monitoring-Plattformen verzahnt, die Markenerwähnungen über mehrere KI-Systeme hinweg in Echtzeit verfolgen. Dieser Wandel bedeutet eine grundlegende Weiterentwicklung der historischen Sekundärforschung hin zu dynamischer, KI-unterstützter Analyse, die kontinuierlich Einblicke in Marktposition, Wettbewerbsumfeld und KI-Sichtbarkeit liefert.

Organisationen, die das Potenzial der Sekundärforschung voll ausschöpfen möchten, sollten strukturierte Best Practices implementieren, die eine fundierte Analyse und verwertbare Ergebnisse sicherstellen. Definieren Sie klare Forschungsziele zu Beginn der Sekundärforschung, formulieren Sie konkrete Fragen, die mit Sekundärdaten beantwortet werden könnten, und legen Sie Erfolgskriterien fest. Priorisieren Sie die Glaubwürdigkeit der Quellen, indem Sie begutachtete wissenschaftliche Publikationen, Behörden und etablierte Forschungseinrichtungen selbstveröffentlichten oder tendenziösen Quellen vorziehen. Etablieren Sie Verifizierungsprotokolle, die den Abgleich von Ergebnissen über mehrere unabhängige Quellen vorschreiben, bevor Schlussfolgerungen gezogen werden. Dokumentieren Sie die Methodik, einschließlich aller genutzten Quellen, Analyseverfahren sowie eventueller Limitationen oder Verzerrungen. Prüfen Sie die Aktualität der Daten, indem Sie sicherstellen, dass die Sekundärdaten das aktuelle Marktumfeld widerspiegeln und nicht durch schnelle Veränderungen obsolet sind. Kombinieren Sie mit Primärforschung, wenn Sekundärdaten spezifische Fragestellungen nicht beantworten oder wenn die Validierung von Sekundärergebnissen erforderlich ist. Nutzen Sie interne Daten, indem Sie firmeninterne Datenbanken und frühere Forschungsprojekte gründlich prüfen, bevor Sie externe Quellen heranziehen. Verwenden Sie KI-gestützte Analysewerkzeuge, um große Sekundärdatensätze effizient zu bearbeiten und Muster zu erkennen, die manuell verborgen bleiben. Überwachen Sie die KI-Sichtbarkeit, indem Sie Sekundärforschungs-Insights mit KI-Monitoring-Plattformen wie AmICited kombinieren, um zu verstehen, wie Marken in KI-generierten Antworten erscheinen. Legen Sie Aktualisierungszyklen für Sekundärforschungsprojekte fest, da sich Marktbedingungen ändern und periodische Re-Analysen notwendig sein können, um die Aussagekraft der Erkenntnisse zu erhalten.

Sekundärforschung bleibt eine unverzichtbare Methodik für Organisationen, die kostengünstig und schnell Einblicke in Märkte, Wettbewerbsumfelder und Konsumtrends gewinnen möchten. Während die globale Marktforschungsbranche weiterhin wächst – von 102 Milliarden US-Dollar im Jahr 2021 auf 140 Milliarden US-Dollar in 2024 – wird Sekundärforschung ein immer wichtigerer Bestandteil umfassender Forschungsstrategien. Die Integration von KI- und Machine-Learning-Technologien verwandelt Sekundärforschung von einer manuellen, zeitaufwendigen Aufgabe in eine automatisierte, anspruchsvolle Disziplin, die riesige Datenmengen auswerten und komplexe Muster erkennen kann. Organisationen, die die Methodik der Sekundärforschung beherrschen, verschaffen sich bedeutende Wettbewerbsvorteile, indem sie schnelle Entscheidungen, kosteneffiziente Marktanalysen und fundierte strategische Planungen ermöglichen. Das Aufkommen von KI-Monitoring-Plattformen wie AmICited zeigt, wie sich die Prinzipien der Sekundärforschung weiterentwickeln, um neue Herausforderungen im generativen KI-Zeitalter zu meistern, in dem das Verständnis der Quellennennung und Referenzierung durch KI-Systeme entscheidend für Markenpräsenz und Marktpositionierung ist. Da 47 % der Forschenden weltweit KI regelmäßig in der Marktforschung einsetzen, liegt die Zukunft der Sekundärforschung in der anspruchsvollen Integration traditioneller Methoden mit modernster KI. Organisationen, die strenge Sekundärforschung mit KI-gestützter Analyse, Echtzeit-Monitoring und strategischer Validierung kombinieren, sind am besten positioniert, um das Maximum aus vorhandenen Daten zu ziehen und gleichzeitig die Glaubwürdigkeit sowie Genauigkeit für fundierte Entscheidungen in einer zunehmend komplexen, KI-geprägten Geschäftswelt zu sichern.

Primärforschung beinhaltet die direkte Erhebung eigener Daten durch Umfragen, Interviews oder Beobachtungen, während Sekundärforschung bereits existierende, von anderen erhobene Daten analysiert. Primärforschung ist zeitaufwendiger und kostspieliger, liefert aber maßgeschneiderte Erkenntnisse, während Sekundärforschung schneller und kostengünstiger ist, jedoch gegebenenfalls spezifische Forschungsfragen nicht exakt beantwortet. Häufig werden beide Methoden kombiniert, um umfassende Forschungsstrategien zu ermöglichen.

Quellen für Sekundärforschung sind unter anderem staatliche Statistiken und Volkszählungsdaten, wissenschaftliche Zeitschriften und begutachtete Publikationen, Marktstudien von professionellen Agenturen, Unternehmensberichte und Whitepapers, Daten von Branchenverbänden, Nachrichtenarchive und Medienveröffentlichungen sowie interne Datenbanken von Organisationen. Diese Quellen können intern (aus dem eigenen Unternehmen) oder extern (öffentlich zugänglich oder von Dritten erworben) sein. Die Wahl der Quelle hängt von den Forschungszielen, der Datenrelevanz und den Anforderungen an die Glaubwürdigkeit ab.

Sekundärforschung spart Kosten für die Datenerhebung, da die Informationen bereits von anderen gesammelt und aufbereitet wurden. Forscher vermeiden Ausgaben für die Rekrutierung von Teilnehmenden, die Durchführung von Umfragen oder Interviews und das Management von Feldstudien. Zudem sind Sekundärdaten häufig kostenlos oder zu minimalen Kosten über öffentliche Datenbanken, Bibliotheken und Behörden verfügbar. Organisationen können durch die Nutzung bestehender Datensätze 50–70 % ihrer Forschungskosten einsparen und so insbesondere bei begrenzten Ressourcen profitieren.

Sekundärforschungsdaten können veraltet sein und aktuelle Markttrends oder Veränderungen nicht abbilden. Die ursprüngliche Methodik der Datenerhebung ist oft unbekannt, was Fragen zur Datenqualität und Gültigkeit aufwirft. Forscher haben keinen Einfluss auf die Datenerhebung und können so unerkannte Verzerrungen nicht ausschließen. Sekundärdatensätze beantworten möglicherweise nicht exakt die eigenen Forschungsfragen, sodass Ziele angepasst werden müssen. Darüber hinaus fehlt Exklusivität, das heißt, auch Wettbewerber können auf dieselben Informationen zugreifen.

Organisationen sollten die ursprüngliche Forschungsmethodik, das Veröffentlichungsdatum und den Ruf der Quelle prüfen, bevor sie Sekundärdaten verwenden. Begutachtete wissenschaftliche Zeitschriften und Behörden wahren in der Regel höhere Glaubwürdigkeitsstandards als Blogs oder Meinungsartikel. Ein Abgleich der Daten über mehrere unabhängige Quellen hilft, Ergebnisse zu validieren und Unstimmigkeiten zu erkennen. Forschende sollten prüfen, ob Stichprobengröße, Population und Studiendesign der Originaluntersuchung mit den eigenen Anforderungen übereinstimmen. Die Kontaktaufnahme zu den ursprünglichen Forschenden oder Organisationen kann zusätzliche Informationen zu den Datenerhebungsprozessen liefern.

Sekundärforschung liefert historischen Kontext und Basisdaten für KI-Monitoring-Plattformen wie AmICited, die Marken-Erwähnungen über KI-Systeme wie ChatGPT, Perplexity und Claude verfolgen. Durch die Analyse bestehender Daten zu Wettbewerber-Erwähnungen, Branchentrends und der historischen Markenperformance können Organisationen Benchmarks für ihre KI-Sichtbarkeit festlegen. Sekundärforschung hilft, Muster in der Quellennennung von KI-Systemen zu erkennen, sodass Marken ihre Content-Strategie für bessere KI-Zitationen und Sichtbarkeit in generativen Suchergebnissen optimieren können.

KI-Tools automatisieren heute die Analyse von Sekundärdaten, sodass Forschende große Datensätze schneller verarbeiten und Muster erkennen, die manuell schwer zu entdecken wären. Rund 47 % der Forschenden weltweit nutzen regelmäßig KI in der Marktforschung, mit einer Adoptionsrate von 58 % in der Asien-Pazifik-Region. KI-gestützte Inhaltsanalyse erkennt Themen, semantische Zusammenhänge und Beziehungen in Sekundärquellen. Allerdings äußern 73 % der Forschenden Vertrauen in den KI-Einsatz bei Sekundärforschung, während in manchen Teams weiterhin Bedenken hinsichtlich fehlender Kompetenzen bestehen.

Sekundärforschung kann innerhalb von Tagen oder Wochen abgeschlossen werden, da die Daten bereits gesammelt und strukturiert vorliegen, während Primärforschung meist Wochen bis Monate für Planung, Datenerhebung und Analyse benötigt. Organisationen erhalten über Online-Datenbanken und Bibliotheken sofortigen Zugriff auf Sekundärdaten und können dadurch schneller Entscheidungen treffen. Der Zeitvorteil macht Sekundärforschung ideal für zeitkritische Geschäftsentscheidungen, Wettbewerbsanalysen und vorbereitende Forschungsphasen. Allerdings besteht der Nachteil darin, dass Sekundärdaten nicht immer die spezifischen, aktuellen Erkenntnisse liefern, die Primärforschung ermöglicht.

Beginnen Sie zu verfolgen, wie KI-Chatbots Ihre Marke auf ChatGPT, Perplexity und anderen Plattformen erwähnen. Erhalten Sie umsetzbare Erkenntnisse zur Verbesserung Ihrer KI-Präsenz.

Originalforschung und First-Party-Daten sind proprietäre Studien und Kundendaten, die Marken direkt erheben. Erfahren Sie, wie sie Autorität aufbauen, KI-Zitate...

Erfahren Sie, was die Informationsbeschaffungsstufe der Forschungsphase ist, ihre Bedeutung in der Forschungsmethodik, Techniken der Datenerhebung und wie sie d...

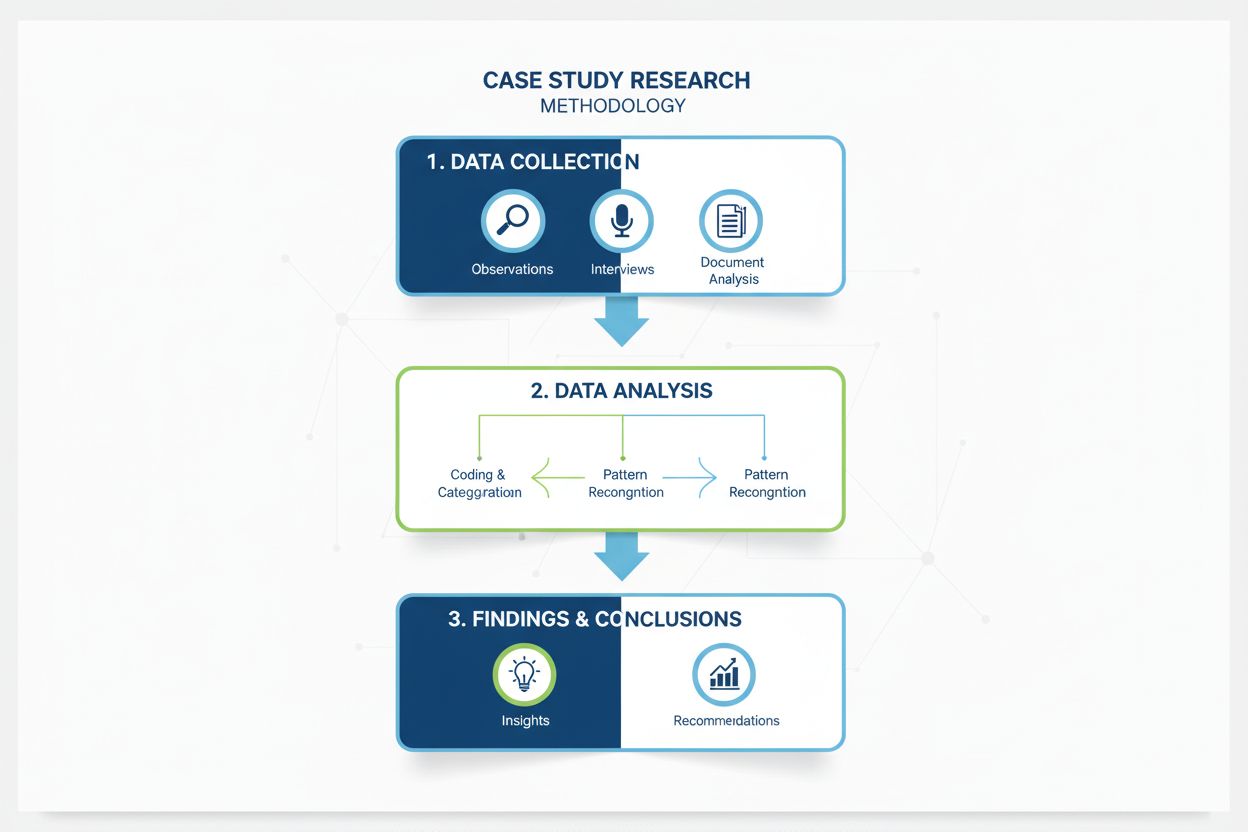

Umfassende Definition der Fallstudienforschungsmethodik. Erfahren Sie, wie Fallstudien eine tiefgehende Analyse spezifischer Beispiele, Datenerhebungsmethoden u...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.