Cómo Impugnar y Corregir Información Inexacta en Respuestas de IA

Aprende cómo impugnar información inexacta de IA, reportar errores a ChatGPT y Perplexity, e implementar estrategias para asegurar que tu marca esté representad...

La corrección de desinformación en IA se refiere a las estrategias y herramientas para identificar y abordar información incorrecta sobre marcas que aparece en respuestas generadas por IA de sistemas como ChatGPT, Gemini y Perplexity. Implica monitorear cómo los sistemas de IA representan a las marcas e implementar correcciones a nivel de fuente para asegurar que la información precisa se distribuya en plataformas confiables. A diferencia de la verificación de hechos tradicional, se centra en corregir las fuentes en las que confían los sistemas de IA y no en los propios resultados de la IA. Esto es esencial para mantener la reputación y precisión de la marca en un entorno de búsqueda impulsado por IA.

La corrección de desinformación en IA se refiere a las estrategias y herramientas para identificar y abordar información incorrecta sobre marcas que aparece en respuestas generadas por IA de sistemas como ChatGPT, Gemini y Perplexity. Implica monitorear cómo los sistemas de IA representan a las marcas e implementar correcciones a nivel de fuente para asegurar que la información precisa se distribuya en plataformas confiables. A diferencia de la verificación de hechos tradicional, se centra en corregir las fuentes en las que confían los sistemas de IA y no en los propios resultados de la IA. Esto es esencial para mantener la reputación y precisión de la marca en un entorno de búsqueda impulsado por IA.

La corrección de desinformación en IA se refiere a las estrategias, procesos y herramientas utilizadas para identificar y abordar información incorrecta, desactualizada o engañosa sobre marcas que aparece en respuestas generadas por IA en sistemas como ChatGPT, Gemini y Perplexity. Investigaciones recientes muestran que aproximadamente el 45% de las consultas a IA producen respuestas erróneas, por lo que la precisión de la marca en los sistemas de IA es una preocupación crítica para las empresas. A diferencia de los resultados de búsqueda tradicionales donde las marcas pueden controlar sus propios listados, los sistemas de IA sintetizan información de múltiples fuentes en la web, creando un panorama complejo donde la desinformación puede persistir silenciosamente. El desafío no es solo corregir respuestas individuales de la IA, sino entender por qué los sistemas de IA obtienen información incorrecta de las marcas en primer lugar e implementar soluciones sistemáticas a nivel de fuente.

Los sistemas de IA no inventan la información de las marcas desde cero; la ensamblan a partir de lo que ya existe en Internet. Sin embargo, este proceso genera varios puntos de falla previsibles que conducen a una mala representación de la marca:

| Causa raíz | Cómo ocurre | Impacto en el negocio |

|---|---|---|

| Inconsistencia en la fuente | La marca se describe de manera diferente en sitios web, directorios y artículos | La IA infiere un consenso erróneo a partir de información conflictiva |

| Fuentes autorizadas desactualizadas | Entradas antiguas de Wikipedia, listados de directorios o páginas comparativas contienen datos incorrectos | Las correcciones nuevas son ignoradas porque las fuentes antiguas tienen señales de mayor autoridad |

| Confusión de entidades | Nombres de marca similares o categorías superpuestas confunden a los sistemas de IA | Los competidores son acreditados por tus capacidades o la marca es omitida por completo |

| Ausencia de señales primarias | Falta de datos estructurados, páginas “Acerca de” claras o terminología consistente | La IA se ve obligada a inferir información, lo que lleva a descripciones vagas o incorrectas |

Cuando una marca se describe de manera diferente en varias plataformas, los sistemas de IA tienen dificultades para determinar cuál versión es la autorizada. En lugar de pedir aclaraciones, infieren consenso basados en la frecuencia y la autoridad percibida, incluso cuando ese consenso es incorrecto. Pequeñas diferencias en nombres de marca, descripciones o posicionamiento suelen duplicarse en plataformas, y una vez repetidas, estos fragmentos se convierten en señales que los modelos de IA tratan como confiables. El problema se intensifica cuando páginas antiguas pero de alta autoridad contienen información incorrecta; los sistemas de IA suelen favorecer estas fuentes sobre las correcciones nuevas, especialmente si esas correcciones no se han difundido ampliamente en plataformas confiables.

Corregir información incorrecta sobre marcas en sistemas de IA requiere un enfoque fundamentalmente diferente al de la limpieza SEO tradicional. En el SEO tradicional, las marcas actualizan sus propios listados, corrigen datos NAP (Nombre, Dirección, Teléfono) y optimizan el contenido on-page. La corrección de marca en IA se centra en cambiar lo que dicen las fuentes confiables sobre tu marca, no en controlar tu propia visibilidad. No corriges la IA directamente—corriges aquello en lo que la IA confía. Intentar “arreglar” respuestas de IA repitiendo afirmaciones incorrectas (incluso para negarlas) puede resultar contraproducente al reforzar la asociación que quieres eliminar. Los sistemas de IA reconocen patrones, no intenciones. Esto significa que toda corrección debe comenzar a nivel de fuente, retrocediendo hasta el origen de donde los sistemas de IA realmente aprenden la información.

Antes de poder corregir información incorrecta sobre tu marca, necesitas visibilidad sobre cómo los sistemas de IA la describen actualmente. Un monitoreo eficaz se enfoca en:

Las comprobaciones manuales por sí solas no son confiables porque las respuestas de la IA varían según el prompt, el contexto y el ciclo de actualización. Las herramientas estructuradas de monitoreo brindan la visibilidad necesaria para detectar errores a tiempo, antes de que se afiancen en los sistemas de IA. Muchas marcas no se dan cuenta de que están siendo mal representadas en IA hasta que un cliente lo menciona o surge una crisis. El monitoreo proactivo previene esto al detectar inconsistencias antes de que se propaguen.

Una vez que has identificado información incorrecta sobre tu marca, la solución debe ocurrir donde los sistemas de IA realmente aprenden, no solo donde aparece el error. Las correcciones efectivas a nivel de fuente incluyen:

El principio clave es este: las correcciones solo funcionan si se aplican a nivel de fuente. Cambiar lo que aparece en los resultados de la IA sin corregir las fuentes subyacentes es, en el mejor de los casos, temporal. Los sistemas de IA reevalúan continuamente las señales a medida que aparece contenido nuevo y resurgen páginas antiguas. Una corrección que no aborda la fuente original eventualmente será sobreescrita por la desinformación inicial.

Al corregir información inexacta de marca en directorios, marketplaces o plataformas que alimentan la IA, la mayoría de los sistemas requieren verificación que asocie la marca con propiedad y uso legítimos. La documentación comúnmente solicitada incluye:

El objetivo no es el volumen, sino la consistencia. Las plataformas evalúan si la documentación, los listados y los datos públicos de la marca están alineados. Tener estos materiales organizados de antemano reduce los ciclos de rechazo y acelera la aprobación al corregir información de marca a gran escala. La consistencia entre fuentes señala a los sistemas de IA que la información de tu marca es confiable y autorizada.

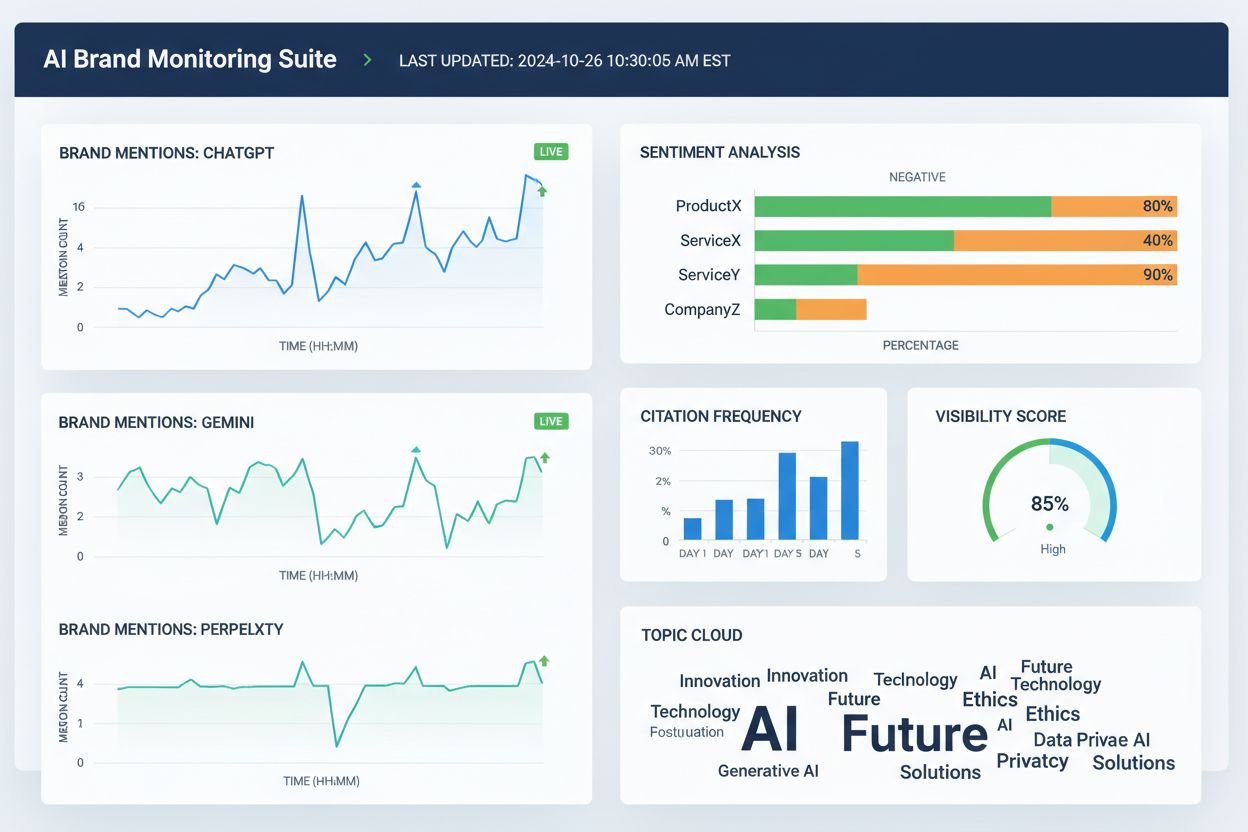

Actualmente existen varias herramientas que ayudan a los equipos a rastrear la representación de la marca en plataformas de búsqueda de IA y en la web en general. Si bien sus capacidades se superponen, generalmente se enfocan en visibilidad, atribución y consistencia:

Estas herramientas no corrigen directamente la información incorrecta de la marca. En cambio, ayudan a los equipos a detectar errores a tiempo, identificar discrepancias antes de que se propaguen, validar si las correcciones a nivel fuente mejoran la precisión de la IA y monitorear tendencias a largo plazo en atribución y visibilidad. Usadas junto con correcciones en la fuente y documentación, las herramientas de monitoreo proporcionan el ciclo de retroalimentación necesario para corregir información incorrecta de manera sostenible.

La precisión de la búsqueda por IA mejora cuando las marcas están claramente definidas como entidades, no solo como participantes vagos en una categoría. Para reducir la mala representación de la marca en sistemas de IA, enfócate en:

El objetivo no es decir más, sino decir lo mismo en todas partes. Cuando los sistemas de IA encuentran definiciones de marca consistentes en fuentes autorizadas, dejan de adivinar y comienzan a repetir la información correcta. Este paso es especialmente importante para marcas que experimentan menciones incorrectas, atribución a competidores u omisión en respuestas relevantes de IA. Incluso después de corregir la información errónea de marca, la precisión no es permanente. Los sistemas de IA reevalúan continuamente las señales, por lo que la claridad sostenida es esencial.

No existe un plazo fijo para corregir la mala representación de marca en sistemas de IA. Los modelos de IA se actualizan en función de la fuerza de la señal y el consenso, no por fechas de envío. Los patrones típicos incluyen:

El progreso temprano rara vez se muestra como una “respuesta corregida” repentina. En su lugar, busca señales indirectas: menor variabilidad en las respuestas de IA, menos descripciones conflictivas, citas más consistentes entre fuentes e inclusión gradual de tu marca donde antes estaba omitida. El estancamiento se ve diferente—si la misma frase incorrecta persiste a pesar de varias correcciones, normalmente indica que la fuente original no ha sido corregida o que se necesita un refuerzo más fuerte en otro lugar.

La forma más confiable de corregir información errónea de marca es reducir las condiciones que permiten que surja en primer lugar. Una prevención efectiva incluye:

Las marcas que tratan la visibilidad en IA como un sistema vivo—y no como un proyecto de limpieza puntual—se recuperan más rápido de los errores y experimentan menos casos de mala representación repetida. La prevención no se trata de controlar los resultados de la IA. Se trata de mantener insumos limpios y consistentes que los sistemas de IA puedan repetir con confianza. A medida que la búsqueda impulsada por IA evoluciona, las marcas que tienen éxito son aquellas que reconocen la corrección de desinformación como un proceso continuo que requiere monitoreo constante, gestión de fuentes y refuerzo estratégico de información precisa en plataformas confiables.

La corrección de desinformación en IA es el proceso de identificar y arreglar información incorrecta, desactualizada o engañosa sobre marcas que aparece en respuestas generadas por IA. A diferencia de la verificación de hechos tradicional, se centra en corregir las fuentes en las que confían los sistemas de IA (directorios, artículos, listados) en lugar de intentar editar directamente los resultados de la IA. El objetivo es asegurar que cuando los usuarios pregunten a sistemas de IA sobre tu marca, reciban información precisa.

Sistemas de IA como ChatGPT, Gemini y Perplexity ahora influyen en cómo millones de personas conocen las marcas. Las investigaciones muestran que el 45% de las consultas a IA producen errores, y la información incorrecta sobre la marca puede dañar la reputación, confundir a los clientes y generar pérdida de negocio. A diferencia de la búsqueda tradicional donde las marcas controlan sus propios listados, los sistemas de IA sintetizan información de múltiples fuentes, haciendo que la precisión de la marca sea más difícil de controlar pero más crítica de gestionar.

No, la corrección directa no funciona de manera efectiva. Los sistemas de IA no almacenan hechos de marca en ubicaciones editables: sintetizan respuestas a partir de fuentes externas. Repetirle a la IA que 'corrija' información puede incluso reforzar las alucinaciones al fortalecer la asociación que deseas eliminar. En su lugar, las correcciones deben aplicarse a nivel de fuente: actualizando directorios, corrigiendo listados desactualizados y publicando información precisa en plataformas confiables.

No hay un plazo fijo porque los sistemas de IA se actualizan según la fuerza de la señal y el consenso, no por fechas de envío. Las correcciones menores suelen aparecer en 2-4 semanas, las aclaraciones a nivel de entidad toman de 1-3 meses y el desplazamiento competitivo puede tardar de 3-6 meses o más. El progreso rara vez se muestra como una 'respuesta corregida' repentina; en su lugar, busca menor variabilidad en las respuestas y citas más consistentes entre fuentes.

Actualmente, varias herramientas rastrean la representación de la marca en plataformas de IA: Wellows monitorea menciones y sentimiento en ChatGPT, Gemini y Perplexity; Profound compara la visibilidad entre LLMs; Otterly.ai analiza el sentimiento de marca en respuestas de IA; BrandBeacon ofrece analíticas de posicionamiento; Ahrefs Brand Radar rastrea menciones web; y AmICited.com se especializa en monitorear cómo se cita y representa la marca en sistemas de IA. Estas herramientas ayudan a detectar errores a tiempo y validar si las correcciones están funcionando.

Las alucinaciones de IA ocurren cuando los sistemas de IA generan información que no se basa en datos de entrenamiento o que se decodifica incorrectamente. La desinformación en IA es información falsa o engañosa que aparece en los resultados de la IA, que puede deberse a alucinaciones pero también a fuentes desactualizadas, confusión de entidades o datos inconsistentes entre plataformas. La corrección de desinformación aborda tanto alucinaciones como inexactitudes a nivel fuente que conducen a una representación incorrecta de la marca.

Monitorea cómo los sistemas de IA describen tu marca haciéndoles preguntas sobre tu empresa, productos y posicionamiento. Busca información desactualizada, descripciones incorrectas, detalles ausentes o atribución a competidores. Usa herramientas de monitoreo para rastrear menciones en ChatGPT, Gemini y Perplexity. Verifica si tu marca está omitida en respuestas relevantes de IA. Compara las descripciones de la IA con tu información oficial para detectar discrepancias.

Es un proceso continuo. Los sistemas de IA reevalúan constantemente las señales a medida que aparece contenido nuevo y resurgen páginas antiguas. Una corrección puntual sin monitoreo permanente será eventualmente sobreescrita por la desinformación original. Las marcas que tienen éxito tratan la visibilidad en IA como un sistema vivo, manteniendo definiciones de marca consistentes en las fuentes, auditando directorios regularmente y monitoreando menciones en IA continuamente para detectar errores antes de que se propaguen.

Rastrea cómo sistemas de IA como ChatGPT, Gemini y Perplexity representan tu marca. Obtén información en tiempo real sobre menciones, citas y visibilidad de la marca en plataformas de IA con AmICited.com.

Aprende cómo impugnar información inexacta de IA, reportar errores a ChatGPT y Perplexity, e implementar estrategias para asegurar que tu marca esté representad...

Aprende métodos efectivos para identificar, verificar y corregir información inexacta en respuestas generadas por IA como ChatGPT, Perplexity y otros sistemas d...

Aprende estrategias efectivas para identificar, monitorear y corregir información inexacta sobre tu marca en respuestas generadas por IA como ChatGPT, Perplexit...

Consentimiento de Cookies

Usamos cookies para mejorar tu experiencia de navegación y analizar nuestro tráfico. See our privacy policy.