Ajuste fino

Definición de ajuste fino: adaptación de modelos de IA preentrenados para tareas específicas mediante entrenamiento específico de dominio. Descubre cómo el ajus...

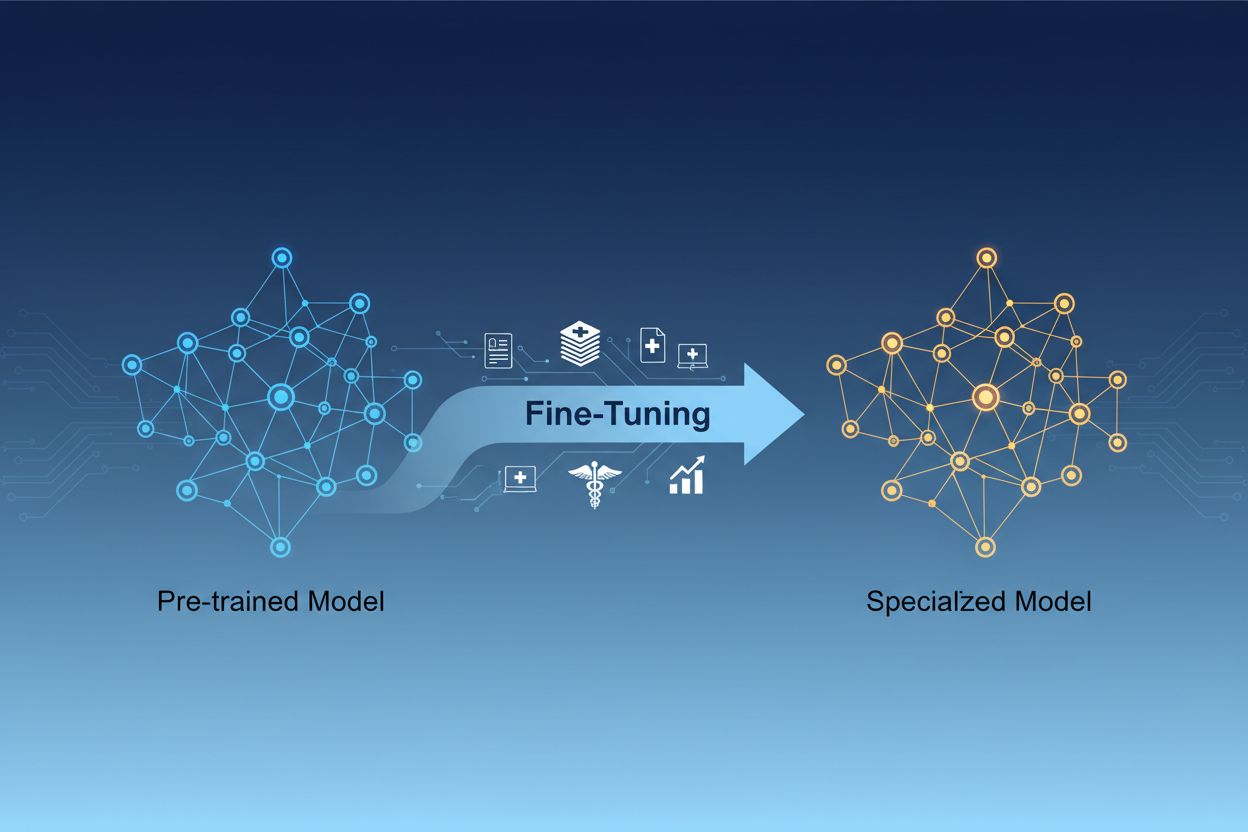

El ajuste fino de modelos de IA es el proceso de adaptar modelos de inteligencia artificial preentrenados para realizar tareas específicas o trabajar con datos especializados ajustando sus parámetros mediante entrenamiento adicional en conjuntos de datos de dominio específico. Este enfoque aprovecha el conocimiento fundamental existente mientras personaliza los modelos para aplicaciones empresariales particulares, permitiendo a las organizaciones crear sistemas de IA altamente especializados sin el coste computacional de entrenar desde cero.

El ajuste fino de modelos de IA es el proceso de adaptar modelos de inteligencia artificial preentrenados para realizar tareas específicas o trabajar con datos especializados ajustando sus parámetros mediante entrenamiento adicional en conjuntos de datos de dominio específico. Este enfoque aprovecha el conocimiento fundamental existente mientras personaliza los modelos para aplicaciones empresariales particulares, permitiendo a las organizaciones crear sistemas de IA altamente especializados sin el coste computacional de entrenar desde cero.

El ajuste fino de modelos de IA es el proceso de tomar un modelo de inteligencia artificial preentrenado y adaptarlo para realizar tareas específicas o trabajar con datos especializados. En lugar de entrenar un modelo desde cero, el ajuste fino aprovecha el conocimiento fundamental ya incorporado en un modelo preentrenado y ajusta sus parámetros mediante entrenamiento adicional en conjuntos de datos de dominio o tarea específicos. Este enfoque combina la eficiencia del aprendizaje por transferencia con la personalización necesaria para aplicaciones empresariales concretas. El ajuste fino permite a las organizaciones crear modelos de IA altamente especializados sin el coste computacional y la inversión de tiempo requeridos para entrenar desde cero, convirtiéndose en una técnica esencial en el desarrollo moderno de aprendizaje automático.

La distinción entre el ajuste fino y el entrenamiento desde cero representa una de las decisiones más importantes en el desarrollo de aprendizaje automático. Cuando entrenas un modelo desde cero, comienzas con pesos inicializados aleatoriamente y debes enseñarle todo sobre patrones de lenguaje, características visuales o conocimiento específico de dominio utilizando conjuntos de datos masivos y recursos computacionales sustanciales. Este enfoque puede requerir semanas o meses de entrenamiento y acceso a hardware especializado como GPUs o TPUs. Por el contrario, el ajuste fino parte de un modelo que ya comprende patrones y conceptos fundamentales, requiriendo solo una fracción de los datos y el poder de cómputo para adaptarlo a tus necesidades específicas. El modelo preentrenado ya ha aprendido características generales durante su fase inicial de entrenamiento, por lo que el ajuste fino se centra en ajustar estas características para adaptarlas a tu caso de uso particular. Esta ganancia de eficiencia hace que el ajuste fino sea el enfoque preferido para la mayoría de las organizaciones, ya que reduce tanto el tiempo de lanzamiento al mercado como los costes de infraestructura, logrando a menudo un rendimiento superior en comparación con entrenar modelos más pequeños desde cero.

| Aspecto | Ajuste fino | Entrenamiento desde cero |

|---|---|---|

| Tiempo de entrenamiento | Días a semanas | Semanas a meses |

| Requisitos de datos | Miles a millones de ejemplos | Millones a miles de millones de ejemplos |

| Coste computacional | Moderado (una sola GPU suele ser suficiente) | Extremadamente alto (se requieren múltiples GPUs/TPUs) |

| Conocimiento inicial | Aprovecha pesos preentrenados | Comienza con inicialización aleatoria |

| Rendimiento | A menudo superior con datos limitados | Mejor con conjuntos de datos masivos |

| Nivel de experiencia requerido | Intermedio | Avanzado |

| Nivel de personalización | Alto para tareas específicas | Máxima flexibilidad |

| Infraestructura | Recursos estándar en la nube | Clústeres de hardware especializado |

El ajuste fino se ha convertido en una capacidad crítica para las organizaciones que buscan desplegar soluciones de IA que ofrezcan ventajas competitivas. Al adaptar modelos preentrenados a tu contexto empresarial específico, puedes crear sistemas de IA que comprendan la terminología de tu sector, las preferencias de tus clientes y los requisitos operativos con una precisión notable. Esta personalización permite a las empresas lograr niveles de rendimiento que los modelos genéricos, listos para usar, simplemente no pueden igualar, especialmente al tratar con dominios especializados como la salud, los servicios legales o el soporte técnico. La rentabilidad del ajuste fino significa que incluso las organizaciones más pequeñas pueden ahora acceder a capacidades de IA de nivel empresarial sin grandes inversiones en infraestructura. Además, los modelos ajustados pueden desplegarse más rápido, permitiendo a las empresas responder rápidamente a oportunidades de mercado y presiones competitivas. La capacidad de mejorar continuamente los modelos ajustándolos con nuevos datos garantiza que tus sistemas de IA sigan siendo relevantes y efectivos a medida que evolucionan las condiciones del negocio.

Los principales beneficios empresariales del ajuste fino incluyen:

Varias técnicas consolidadas han surgido como mejores prácticas en el panorama del ajuste fino, cada una con ventajas distintas según tus requerimientos específicos. El ajuste fino completo implica actualizar todos los parámetros del modelo preentrenado, proporcionando máxima flexibilidad y a menudo el mejor rendimiento, pero requiere recursos computacionales significativos y conjuntos de datos más grandes para evitar el sobreajuste. Los métodos de ajuste fino eficiente en parámetros como LoRA (Low-Rank Adaptation) y QLoRA han revolucionado el campo permitiendo una adaptación efectiva del modelo mientras se actualiza solo una pequeña fracción de los parámetros, reduciendo drásticamente los requisitos de memoria y el tiempo de entrenamiento. Estas técnicas funcionan añadiendo matrices de bajo rango entrenables a las matrices de peso del modelo, capturando adaptaciones específicas de la tarea sin modificar los pesos originales preentrenados. Los módulos adaptadores representan otro enfoque, insertando pequeñas redes entrenables entre las capas del modelo preentrenado congelado, permitiendo un ajuste fino eficiente con un mínimo de parámetros adicionales. El ajuste fino basado en prompts se centra en optimizar los prompts de entrada en lugar de los pesos del modelo, útil para modelos donde el acceso a los parámetros está limitado. El ajuste fino de instrucciones entrena modelos para seguir instrucciones y comandos específicos, especialmente importante para grandes modelos de lenguaje que deben responder adecuadamente a solicitudes diversas de los usuarios. La elección entre estas técnicas depende de tus restricciones computacionales, tamaño del conjunto de datos, requisitos de rendimiento y la arquitectura del modelo con la que trabajes.

El ajuste fino de grandes modelos de lenguaje (LLMs) presenta oportunidades y desafíos únicos en comparación con el ajuste fino de modelos más pequeños u otros tipos de redes neuronales. Los LLMs modernos, como los modelos tipo GPT, contienen miles de millones de parámetros, lo que hace que el ajuste fino completo sea computacionalmente prohibitivo para la mayoría de las organizaciones. Esta realidad ha impulsado la adopción de técnicas eficientes en parámetros que permiten la adaptación efectiva de LLMs sin la necesidad de infraestructuras empresariales a gran escala. El ajuste fino de instrucciones se ha vuelto especialmente importante para los LLMs, donde los modelos se entrenan con ejemplos de instrucciones emparejados con respuestas de alta calidad, permitiéndoles seguir directrices de usuario de manera más efectiva. El aprendizaje por refuerzo a partir de retroalimentación humana (RLHF) representa un enfoque avanzado de ajuste fino donde los modelos se refinan aún más en función de preferencias y evaluaciones humanas, mejorando la alineación con los valores y expectativas humanas. La cantidad relativamente pequeña de datos específicos de la tarea necesarios para ajustar finamente los LLMs— a menudo solo cientos o miles de ejemplos—hace que este enfoque sea accesible para organizaciones sin grandes conjuntos de datos etiquetados. Sin embargo, el ajuste fino de LLMs requiere una atención cuidadosa a la selección de hiperparámetros, la programación de tasas de aprendizaje y la prevención del olvido catastrófico, donde el modelo pierde capacidades previamente aprendidas al adaptarse a nuevas tareas.

Las organizaciones de todos los sectores han descubierto aplicaciones poderosas para modelos de IA ajustados que aportan valor empresarial medible. La automatización del servicio al cliente es uno de los casos de uso más frecuentes, donde los modelos se ajustan con tickets de soporte específicos de la empresa, información de productos y estilos de comunicación para crear chatbots que gestionan consultas de clientes con experiencia de dominio y coherencia de marca. El análisis de documentos médicos y legales aprovecha el ajuste fino para adaptar modelos de lenguaje generales y comprender terminología especializada, requisitos regulatorios y formatos específicos del sector, permitiendo una extracción y clasificación precisa de información. El análisis de sentimiento y la moderación de contenidos pueden mejorarse significativamente ajustando los modelos con ejemplos de tu industria o comunidad específica, capturando patrones de lenguaje matizados y contexto que los modelos genéricos pasan por alto. La generación de código y la asistencia al desarrollo de software se beneficia del ajuste fino con la base de código, convenciones de programación y patrones arquitectónicos de tu organización, permitiendo herramientas de IA que generen código alineado con tus estándares. Los sistemas de recomendación se ajustan frecuentemente con datos de comportamiento de usuario y catálogos de productos para ofrecer sugerencias personalizadas que impulsan el compromiso y los ingresos. El reconocimiento de entidades nombradas y la extracción de información de documentos específicos de dominio—como informes financieros, artículos científicos o especificaciones técnicas—pueden mejorar considerablemente mediante el ajuste fino con ejemplos relevantes. Estas aplicaciones diversas demuestran que el ajuste fino no se limita a una sola industria o caso de uso, sino que representa una capacidad fundamental para crear sistemas de IA que aporten ventajas competitivas en prácticamente cualquier dominio empresarial.

El proceso de ajuste fino sigue un flujo de trabajo estructurado que comienza con una preparación cuidadosa y se extiende hasta el despliegue y la monitorización. La preparación de datos es el primer paso crítico, requiriendo que recolectes, limpies y formatees tu conjunto de datos de dominio de manera que coincida con la estructura de entrada-salida esperada por el modelo preentrenado. Este conjunto de datos debe ser representativo de las tareas que tu modelo ajustado realizará en producción, y la calidad es más importante que la cantidad: un conjunto pequeño de ejemplos de alta calidad suele superar a uno grande con etiquetas inconsistentes o ruidosas. La división en entrenamiento, validación y prueba asegura que puedas evaluar adecuadamente el rendimiento del modelo, con asignaciones típicas del 70-80% para entrenamiento, 10-15% para validación y 10-15% para prueba. La selección de hiperparámetros implica elegir tasas de aprendizaje, tamaños de lote, número de épocas de entrenamiento y otros parámetros que controlan el proceso de ajuste fino; estas elecciones impactan significativamente tanto el rendimiento como la eficiencia del entrenamiento. La inicialización del modelo utiliza los pesos preentrenados como punto de partida, preservando el conocimiento fundamental mientras permite que los parámetros se ajusten a tu tarea específica. La ejecución del entrenamiento implica actualizar iterativamente los parámetros del modelo con tus datos de entrenamiento mientras se monitorea el rendimiento en validación para detectar sobreajuste. La evaluación y la iteración usan tu conjunto de prueba para medir el rendimiento final y determinar si un ajuste fino adicional, otros hiperparámetros o más datos de entrenamiento mejorarían los resultados. La preparación para el despliegue incluye optimizar el modelo para la velocidad de inferencia y la eficiencia de recursos, potencialmente mediante técnicas de cuantización o destilación. Finalmente, la monitorización y el mantenimiento en producción aseguran que el modelo siga rindiendo bien a medida que cambian las distribuciones de datos con el tiempo, con un reentrenamiento periódico con nuevos datos para mantener la precisión.

El ajuste fino, aunque más eficiente que el entrenamiento desde cero, presenta su propio conjunto de retos que los profesionales deben gestionar cuidadosamente. El sobreajuste ocurre cuando los modelos memorizan los datos de entrenamiento en lugar de aprender patrones generalizables, un riesgo particular cuando se ajusta con conjuntos de datos pequeños; esto puede mitigarse con técnicas como la parada temprana, la regularización y el aumento de datos. El olvido catastrófico sucede cuando el ajuste fino hace que los modelos pierdan capacidades previamente aprendidas, especialmente problemático al adaptar modelos de propósito general a tareas especializadas; una selección cuidadosa de la tasa de aprendizaje y técnicas como la destilación de conocimiento ayudan a preservar el conocimiento fundamental. La calidad y el etiquetado de los datos representan retos prácticos significativos, ya que el ajuste fino requiere ejemplos etiquetados de alta calidad que representen con precisión tu dominio y casos de uso objetivo. La gestión de recursos computacionales exige equilibrar mejoras de rendimiento con el tiempo de entrenamiento y los costes de infraestructura, especialmente importante al trabajar con modelos grandes. La sensibilidad a hiperparámetros significa que el rendimiento del ajuste fino puede variar drásticamente según la tasa de aprendizaje, el tamaño de lote y otros parámetros, requiriendo experimentación y validación sistemáticas.

Mejores prácticas para un ajuste fino exitoso incluyen:

Las organizaciones a menudo se enfrentan a la elección entre tres enfoques complementarios para adaptar modelos de IA a tareas específicas: ajuste fino, generación aumentada por recuperación (RAG) e ingeniería de prompts. La ingeniería de prompts implica redactar instrucciones y ejemplos cuidadosamente para guiar el comportamiento del modelo sin modificar el propio modelo; este enfoque es rápido y no requiere entrenamiento, pero tiene una efectividad limitada para tareas complejas y no puede enseñar información genuinamente nueva a los modelos. RAG mejora las respuestas del modelo recuperando documentos o datos relevantes de fuentes externas antes de generar respuestas, permitiendo que los modelos accedan a información actual y conocimiento específico de dominio sin actualizar los parámetros; este enfoque es adecuado para tareas intensivas en conocimiento pero añade latencia y complejidad a la inferencia. El ajuste fino modifica los parámetros del modelo para incorporar profundamente el conocimiento y los patrones específicos de la tarea, proporcionando el mejor rendimiento para tareas bien definidas con suficiente entrenamiento, pero requiere más tiempo y recursos computacionales que los otros enfoques. La solución óptima a menudo implica combinar estas técnicas: usando ingeniería de prompts para prototipado rápido, RAG para aplicaciones intensivas en conocimiento y ajuste fino para sistemas críticos en rendimiento donde la inversión en entrenamiento está justificada. El ajuste fino destaca cuando se necesita un comportamiento consistente y de alto rendimiento en tareas específicas, cuando se dispone de suficientes datos de entrenamiento y cuando las ganancias de rendimiento justifican el esfuerzo de desarrollo. RAG es ideal para aplicaciones que requieren acceso a información actual o propietaria que cambia frecuentemente. La ingeniería de prompts sirve como un excelente punto de partida para la exploración y el prototipado antes de comprometerse con enfoques más exigentes en recursos. Comprender las fortalezas y limitaciones de cada enfoque permite a las organizaciones tomar decisiones informadas sobre qué técnicas emplear para los diferentes componentes de sus sistemas de IA.

El aprendizaje por transferencia es el concepto general de aprovechar el conocimiento de una tarea para mejorar el rendimiento en otra, mientras que el ajuste fino es una implementación específica del aprendizaje por transferencia. El ajuste fino toma un modelo preentrenado y ajusta sus parámetros con nuevos datos, mientras que el aprendizaje por transferencia también puede incluir la extracción de características, donde se congelan los pesos preentrenados y solo se entrenan nuevas capas. Todo ajuste fino implica aprendizaje por transferencia, pero no todo aprendizaje por transferencia requiere ajuste fino.

El tiempo de ajuste fino varía significativamente según el tamaño del modelo, el tamaño del conjunto de datos y el hardware disponible. Usando técnicas eficientes como LoRA, un modelo de 13 mil millones de parámetros puede ajustarse finamente en aproximadamente 5 horas en una sola GPU A100. Modelos más pequeños o métodos eficientes pueden tardar solo unas horas, mientras que el ajuste fino completo de modelos más grandes puede llevar días o semanas. La principal ventaja es que el ajuste fino es mucho más rápido que entrenar desde cero, lo cual puede llevar meses.

Sí, el ajuste fino está diseñado específicamente para funcionar eficazmente con datos limitados. Los modelos preentrenados ya han aprendido patrones generales, por lo que normalmente solo necesitas cientos o miles de ejemplos para un ajuste fino efectivo, en comparación con los millones requeridos para entrenar desde cero. Sin embargo, la calidad de los datos importa más que la cantidad: un conjunto pequeño de ejemplos representativos y de alta calidad superará a un conjunto grande con etiquetas inconsistentes o ruidosas.

LoRA (Low-Rank Adaptation) es una técnica eficiente de ajuste fino que añade matrices de bajo rango entrenables a las matrices de peso del modelo en lugar de actualizar todos los parámetros. Este enfoque reduce los parámetros entrenables en miles de veces manteniendo un rendimiento comparable al ajuste fino completo. LoRA es importante porque permite el ajuste fino en hardware estándar, reduce drásticamente los requisitos de memoria y permite a las organizaciones ajustar modelos grandes sin infraestructuras costosas.

El sobreajuste ocurre cuando la pérdida de entrenamiento disminuye pero la pérdida de validación aumenta, lo que indica que el modelo está memorizando los datos de entrenamiento en lugar de aprender patrones generalizables. Monitorea ambas métricas durante el entrenamiento: si el rendimiento en validación se estabiliza o empeora mientras el de entrenamiento sigue mejorando, probablemente tu modelo está sobreajustando. Implementa parada temprana para detener el entrenamiento cuando el rendimiento en validación deje de mejorar, y utiliza técnicas como regularización y aumento de datos para evitar el sobreajuste.

Los costes del ajuste fino incluyen recursos computacionales (tiempo de GPU/TPU), preparación y etiquetado de datos, almacenamiento del modelo e infraestructura de despliegue, así como monitoreo y mantenimiento continuo. Sin embargo, estos costes suelen ser de 10 a 100 veces menores que entrenar modelos desde cero. Usar técnicas eficientes como LoRA puede reducir los costes computacionales en un 80-90% en comparación con el ajuste fino completo, haciendo del ajuste fino un enfoque económico para la mayoría de las organizaciones.

Sí, el ajuste fino normalmente mejora significativamente la precisión del modelo para tareas específicas. Al entrenar con datos de dominio específico, los modelos aprenden patrones y terminología relevantes para la tarea que los modelos genéricos pasan por alto. Los estudios muestran que el ajuste fino puede mejorar la precisión en un 10-30% o más dependiendo de la tarea y la calidad del conjunto de datos. La mejora es más notable cuando la tarea de ajuste fino difiere de la tarea de preentrenamiento, ya que el modelo adapta sus características aprendidas a tus necesidades específicas.

El ajuste fino permite a las organizaciones mantener los datos sensibles en su propia infraestructura en lugar de enviarlos a APIs de terceros. Puedes ajustar modelos localmente con datos propietarios o regulados sin exponerlos a servicios externos, garantizando el cumplimiento de normativas de protección de datos como GDPR, HIPAA o requisitos específicos del sector. Este enfoque proporciona beneficios tanto de seguridad como de cumplimiento, manteniendo las ventajas de rendimiento de usar modelos preentrenados.

Rastrea cómo sistemas de IA como GPTs, Perplexity y Google AI Overviews citan y mencionan tu marca con la plataforma de monitoreo de IA de AmICited.

Definición de ajuste fino: adaptación de modelos de IA preentrenados para tareas específicas mediante entrenamiento específico de dominio. Descubre cómo el ajus...

Descubre la adaptación de IA en tiempo real: la tecnología que permite a los sistemas de IA aprender continuamente de los acontecimientos actuales y los datos. ...

Compara la optimización de datos de entrenamiento y las estrategias de recuperación en tiempo real para IA. Aprende cuándo usar fine-tuning versus RAG, implicac...

Consentimiento de Cookies

Usamos cookies para mejorar tu experiencia de navegación y analizar nuestro tráfico. See our privacy policy.