Cómo configurar robots.txt para rastreadores de IA: guía completa

Aprende a configurar robots.txt para controlar el acceso de rastreadores de IA como GPTBot, ClaudeBot y Perplexity. Gestiona la visibilidad de tu marca en respu...

Configuración de robots.txt con reglas de user-agent dirigidas específicamente a rastreadores de IA. El robots.txt específico para IA permite a los propietarios de sitios web controlar cómo los sistemas de inteligencia artificial, los grandes modelos de lenguaje y los bots de entrenamiento de IA acceden y utilizan su contenido. Distingue entre diferentes tipos de rastreadores de IA—rastreadoras de entrenamiento, rastreadores de búsqueda y fetchers activados por usuarios—permitiendo un control granular sobre la visibilidad del contenido para los sistemas de IA. Esta configuración se ha vuelto crítica ya que los rastreadores de IA representan ahora aproximadamente el 80% del tráfico de bots a muchos sitios web.

Configuración de robots.txt con reglas de user-agent dirigidas específicamente a rastreadores de IA. El robots.txt específico para IA permite a los propietarios de sitios web controlar cómo los sistemas de inteligencia artificial, los grandes modelos de lenguaje y los bots de entrenamiento de IA acceden y utilizan su contenido. Distingue entre diferentes tipos de rastreadores de IA—rastreadoras de entrenamiento, rastreadores de búsqueda y fetchers activados por usuarios—permitiendo un control granular sobre la visibilidad del contenido para los sistemas de IA. Esta configuración se ha vuelto crítica ya que los rastreadores de IA representan ahora aproximadamente el 80% del tráfico de bots a muchos sitios web.

La configuración específica para IA de robots.txt se refiere a la práctica de crear reglas dirigidas dentro de tu archivo robots.txt que abordan específicamente a los rastreadores de inteligencia artificial y bots de entrenamiento, distintos de los rastreadores tradicionales de motores de búsqueda como Googlebot. Mientras que el robots.txt convencional históricamente ha estado enfocado en gestionar Googlebot, Bingbot y otros indexadores de búsqueda, la aparición de grandes modelos de lenguaje y sistemas de entrenamiento de IA ha creado una categoría completamente nueva de tráfico de bots que requiere estrategias de gestión separadas. Según datos recientes de noviembre de 2025, los rastreadores de IA representan ahora aproximadamente el 80% de todo el tráfico de bots a muchos sitios de editores, cambiando fundamentalmente la importancia de la configuración de robots.txt de una herramienta de SEO opcional a un mecanismo crítico de protección de contenido. La distinción es relevante porque los rastreadores de entrenamiento de IA operan bajo modelos de negocio diferentes a los motores de búsqueda—están recopilando datos para entrenar modelos propietarios en lugar de generar tráfico de referencia—haciendo que el intercambio tradicional de permitir rastreadores a cambio de visibilidad en la búsqueda ya no sea aplicable. Para los editores, esto significa que las decisiones sobre robots.txt ahora impactan directamente la visibilidad del contenido ante los sistemas de IA, el uso no autorizado potencial de contenido propietario en conjuntos de datos de entrenamiento y las implicaciones generales de tráfico e ingresos por el descubrimiento vía IA.

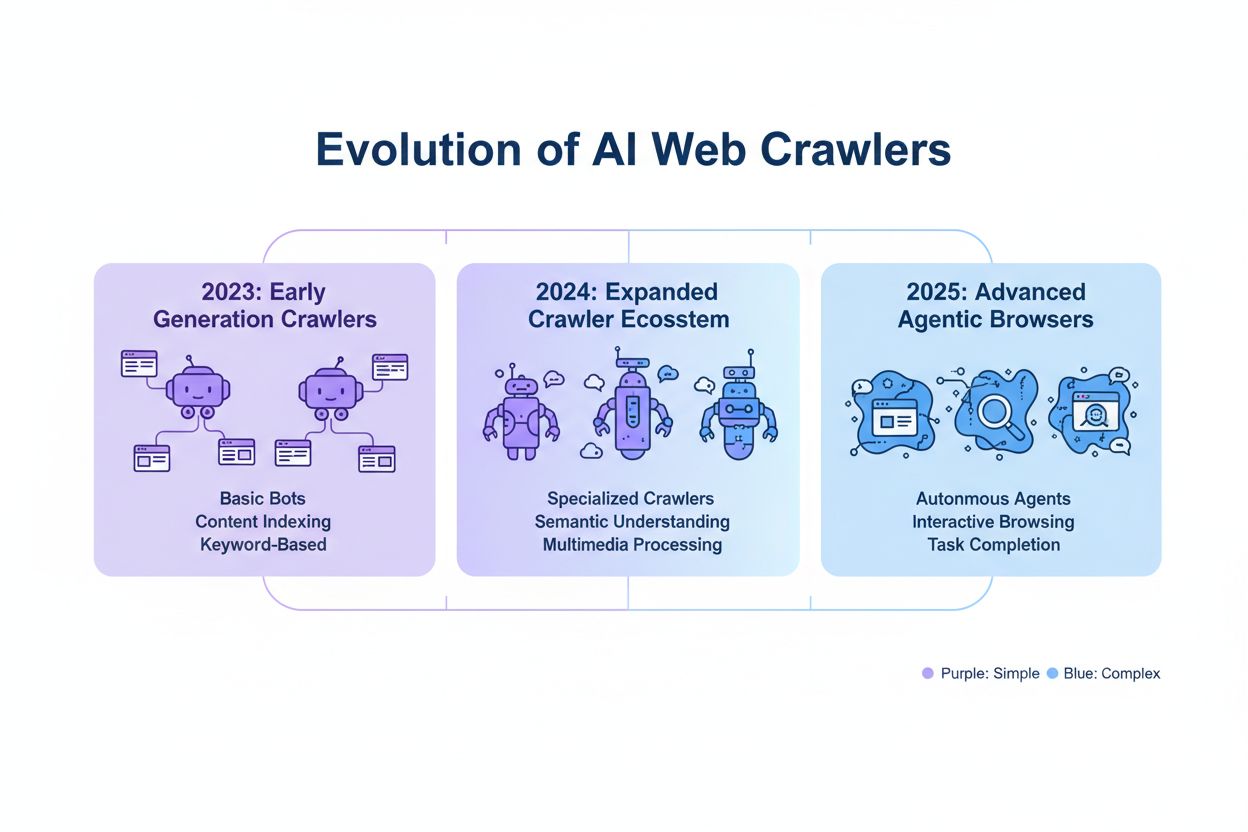

Los rastreadores de IA se dividen en tres categorías operativas distintas, cada una con diferentes características, implicaciones de tráfico y consideraciones estratégicas para los editores. Los rastreadores de entrenamiento están diseñados para recopilar grandes volúmenes de datos de texto para el desarrollo de modelos de aprendizaje automático; normalmente operan con altos requerimientos de ancho de banda, generan una carga significativa sobre el servidor y no proporcionan tráfico de referencia—ejemplos incluyen GPTBot de OpenAI y ClaudeBot de Anthropic. Los rastreadores de búsqueda y cita funcionan de manera similar a los motores de búsqueda tradicionales indexando contenido para su recuperación y proporcionando atribución; generan volúmenes de tráfico moderados y pueden dirigir tráfico de referencia mediante citas y enlaces—esta categoría incluye OAI-SearchBot de OpenAI y el rastreador AI Overviews de Google. Los rastreadores activados por el usuario operan bajo demanda cuando los usuarios finales solicitan explícitamente el análisis de una página web por IA, como la capacidad de ChatGPT para navegar por la web o las funciones de análisis de documentos de Claude; estos generan volúmenes de tráfico bajos pero representan un compromiso directo del usuario con tu contenido. La categorización es importante estratégicamente porque los rastreadores de entrenamiento presentan las mayores preocupaciones de protección de contenido con un beneficio comercial mínimo, los rastreadores de búsqueda ofrecen un punto intermedio con cierto potencial de referencia y los rastreadores activados por el usuario generalmente se alinean con la intención del usuario y pueden mejorar la visibilidad del contenido.

| Categoría de rastreador | Propósito | Volumen de tráfico | Potencial de referencia | Riesgo de contenido | Ejemplos |

|---|---|---|---|---|---|

| Entrenamiento | Desarrollo de modelos | Muy alto | Ninguno | Muy alto | GPTBot, ClaudeBot |

| Búsqueda/Cita | Indexación de contenido y atribución | Moderado | Moderado | Moderado | OAI-SearchBot, Google AI |

| Activado por usuario | Análisis bajo demanda | Bajo | Bajo | Bajo | ChatGPT Web Browse, Claude |

Las principales empresas de IA que operan rastreadores incluyen OpenAI, Anthropic, Google, Meta, Apple y Amazon, cada una con cadenas de user-agent distintas que permiten su identificación en registros de servidor y configuración de robots.txt. OpenAI opera múltiples rastreadores: GPTBot (user-agent: GPTBot/1.0) para recopilación de datos de entrenamiento, OAI-SearchBot (user-agent: OAI-SearchBot/1.0) para indexación de búsqueda y citas, y ChatGPT-User (user-agent: ChatGPT-User/1.0) para navegación web activada por el usuario. El rastreador principal de Anthropic es ClaudeBot (user-agent: Claude-Web/1.0 o anthropic-ai) utilizado para entrenamiento y desarrollo de base de conocimientos. Google opera Google-Extended (user-agent: Google-Extended/1.1) para Gemini y otros productos de IA, mientras que Meta usa facebookexternalhit para análisis de contenido, Apple opera AppleBot para Siri y funciones de búsqueda y Amazon utiliza Amazonbot para Alexa y capacidades de búsqueda. Para identificar estos rastreadores en tus registros de servidor, examina el encabezado User-Agent en las solicitudes HTTP—la mayoría de los rastreadores de IA legítimos incluyen el nombre de la empresa y el número de versión en este campo. Para mayor seguridad, puedes verificar la legitimidad del rastreador comprobando la dirección IP solicitante con los rangos IP publicados por cada empresa; OpenAI publica sus rangos de IP de rastreadores, al igual que Google y otros grandes proveedores, lo que te permite distinguir entre rastreadores legítimos y user-agents falsificados.

La sintaxis básica para reglas específicas de robots.txt para IA sigue el formato estándar de robots.txt con coincidencia de user-agent y directivas allow/disallow dirigidas a rastreadores específicos. Para bloquear el GPTBot de OpenAI de la recopilación de datos de entrenamiento mientras permites su rastreador de búsqueda, estructurarías tu robots.txt de la siguiente manera:

User-agent: GPTBot

Disallow: /

User-agent: OAI-SearchBot

Allow: /

Para un control más granular, puedes aplicar reglas específicas por ruta que bloqueen ciertas secciones mientras permiten otras—por ejemplo, bloqueando a los rastreadores de IA el acceso a tu contenido tras muro de pago o secciones de contenido generado por el usuario:

User-agent: GPTBot

Disallow: /premium/

Disallow: /user-content/

Allow: /public-articles/

User-agent: ClaudeBot

Disallow: /

Puedes agrupar varios user-agents bajo un mismo conjunto de reglas para aplicar restricciones idénticas a varios rastreadores, reduciendo la complejidad de la configuración. La prueba y validación de tu configuración de robots.txt es crítica; herramientas como el probador de robots.txt de Google Search Console y validadores de terceros pueden verificar que tus reglas sean sintácticamente correctas y sean interpretadas como se espera por los rastreadores. Recuerda que robots.txt es una recomendación y no es exigible—los rastreadores cumplidores respetarán estas reglas, pero los actores maliciosos o bots no cumplidores pueden ignorarlas completamente, por lo que podrían ser necesarios mecanismos de aplicación a nivel de servidor para contenido sensible.

La decisión de bloquear o permitir rastreadores de IA implica compensaciones fundamentales entre la protección de contenido y la visibilidad que varían significativamente según el modelo de negocio y la estrategia de contenido. Bloquear rastreadores de entrenamiento como GPTBot elimina completamente el riesgo de que tu contenido sea utilizado para entrenar modelos de IA propietarios sin compensación, pero también significa que tu contenido no aparecerá en respuestas generadas por IA, lo que podría reducir el descubrimiento y el tráfico de usuarios que interactúan con sistemas de IA. Por el contrario, permitir rastreadores de entrenamiento aumenta la probabilidad de que tu contenido sea incorporado en conjuntos de datos de entrenamiento de IA, potencialmente sin atribución ni compensación, pero puede mejorar la visibilidad si esos sistemas de IA eventualmente citan o referencian tu contenido. La decisión estratégica debe considerar la ventaja competitiva de tu contenido—la investigación propietaria, el análisis original y los datos únicos justifican un bloqueo más estricto, mientras que el contenido educativo atemporal o la información común pueden beneficiarse de una mayor visibilidad en IA. Distintos tipos de editores enfrentan diferentes cálculos: las organizaciones de noticias pueden permitir rastreadores de búsqueda para ganar tráfico de citas mientras bloquean rastreadores de entrenamiento, los editores educativos pueden permitir un acceso más amplio para aumentar el alcance, y las empresas SaaS pueden bloquear todos los rastreadores de IA para proteger documentación propietaria. Monitorear el impacto de tus decisiones de bloqueo mediante registros de servidor y análisis de tráfico es esencial para validar si tu configuración está logrando los resultados comerciales deseados.

Si bien robots.txt proporciona un mecanismo claro para comunicar políticas a los rastreadores, es fundamentalmente una recomendación y no exigible legalmente—los rastreadores cumplidores respetarán tus reglas, pero los actores no cumplidores pueden ignorarlas completamente, requiriendo capas técnicas adicionales de aplicación. La verificación y allowlisting de IP representa el método de aplicación más confiable; al mantener una lista de direcciones IP legítimas publicadas por OpenAI, Google, Anthropic y otras grandes empresas de IA, puedes verificar que las solicitudes que afirman ser de estos rastreadores realmente provienen de su infraestructura. Las reglas de firewall y el bloqueo a nivel de servidor proporcionan el mecanismo de aplicación más fuerte, permitiéndote rechazar solicitudes de user-agents o rangos de IP específicos a nivel de red antes de que consuman recursos del servidor. Para servidores Apache, la configuración .htaccess puede hacer cumplir restricciones a los rastreadores:

<IfModule mod_rewrite.c>

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} GPTBot [NC]

RewriteRule ^.*$ - [F,L]

</IfModule>

Las metaetiquetas en la sección head de tu HTML ofrecen un control granular, a nivel de página, sobre el acceso de rastreadores sin modificar robots.txt:

<meta name="robots" content="noindex, noimageindex, nofollowbyai">

La revisión regular de los registros del servidor para detectar actividad de rastreadores te permite identificar nuevos rastreadores, verificar que tus reglas estén siendo respetadas y detectar user-agents falsificados que intentan eludir tus restricciones. Herramientas como Knowatoa y Merkle ofrecen validación y monitoreo automatizados de tu configuración de robots.txt y del comportamiento de los rastreadores, proporcionando visibilidad sobre qué rastreadores acceden a tu sitio y si están respetando tus directivas.

El mantenimiento continuo de tu configuración de robots.txt específico para IA es fundamental porque el panorama de los rastreadores de IA evoluciona rápidamente, surgiendo nuevos rastreadores regularmente y modificando los existentes sus cadenas de user-agent y patrones de comportamiento. Tu estrategia de monitoreo debe incluir:

La rápida evolución de la tecnología de rastreadores de IA significa que una configuración de robots.txt adecuada hace seis meses puede ya no reflejar tus necesidades actuales ni el panorama de amenazas vigente, haciendo esencial la revisión y adaptación regular para mantener una protección de contenido efectiva.

La próxima generación de rastreadores de IA presenta desafíos novedosos que la configuración tradicional de robots.txt puede no ser capaz de abordar efectivamente. Los rastreadores de navegador agentic como ChatGPT Atlas y Google Project Mariner operan como navegadores web completos en lugar de clientes HTTP simples, renderizando JavaScript, ejecutando interacciones de usuario y comportándose de manera indistinguible de usuarios humanos—estos rastreadores pueden no identificarse con cadenas de user-agent distintivas, haciendo que el bloqueo basado en robots.txt sea ineficaz. Muchos rastreadores emergentes están adoptando cadenas de user-agent estándar de Chrome para evitar la detección y el bloqueo, ocultando deliberadamente su identidad para eludir las reglas de robots.txt y otros controles de acceso. Esta tendencia está impulsando una transición hacia el bloqueo basado en IP como una necesidad emergente, donde los editores deben mantener allowlists de direcciones IP legítimas de rastreadores y bloquear todo el tráfico de fuentes sospechosas, cambiando fundamentalmente el modelo de aplicación de la coincidencia de user-agent al control de acceso a nivel de red. Los user-agents falsificados y las técnicas de evasión son cada vez más comunes, con actores maliciosos que se hacen pasar por rastreadores legítimos o usan cadenas de user-agent genéricas para evadir la detección. El futuro de la gestión de rastreadores de IA probablemente requerirá un enfoque multinivel que combine la configuración de robots.txt, la verificación de IP, reglas de firewall y potencialmente análisis de comportamiento para distinguir rastreadores legítimos de actores maliciosos. Mantenerse informado sobre las tecnologías emergentes de rastreadores y participar en discusiones de la industria sobre ética y estándares de rastreadores es esencial para los editores que buscan mantener estrategias de protección de contenido efectivas.

Implementar una configuración efectiva de robots.txt específica para IA requiere un enfoque integral que equilibre la protección de contenido con los objetivos estratégicos de visibilidad. Comienza con una política clara de protección de contenido que defina qué categorías de contenido requieren bloqueo (investigación propietaria, contenido premium, contenido generado por usuarios) frente a cuáles pueden ser expuestas de manera segura a rastreadores de IA (artículos públicos, contenido educativo, información común). Implementa una estrategia de bloqueo por niveles que distinga entre rastreadores de entrenamiento (normalmente bloquear), rastreadores de búsqueda (normalmente permitir con monitoreo) y rastreadores activados por el usuario (normalmente permitir), en lugar de aplicar un enfoque de permitir-o-bloquear a todos los rastreadores de IA por igual. Combina robots.txt con aplicación a nivel de servidor implementando reglas de firewall y verificación de IP para tu contenido más sensible, reconociendo que robots.txt por sí solo es insuficiente para una protección sólida de contenido. Integra la gestión de rastreadores de IA en tu estrategia general de SEO y contenido considerando cómo las decisiones de bloqueo afectan tu visibilidad en respuestas generadas por IA, citas y funciones de búsqueda impulsadas por IA—esta integración asegura que tu configuración de robots.txt respalde y no socave tus objetivos comerciales generales. Establece una cadencia de monitoreo y mantenimiento con revisiones semanales de registros, verificación mensual de IP y auditorías comprensivas trimestrales para asegurar que tu configuración siga siendo efectiva a medida que evoluciona el panorama de los rastreadores. Utiliza herramientas como AmICited.com para monitorear la visibilidad de tu contenido en sistemas de IA y comprender el impacto de tus decisiones de bloqueo en el descubrimiento y cita por IA. Para diferentes tipos de editores: las organizaciones de noticias generalmente deberían permitir rastreadores de búsqueda mientras bloquean los de entrenamiento para maximizar el tráfico de citas; los editores educativos deberían considerar permitir un acceso más amplio para aumentar el alcance; y las empresas SaaS deberían implementar bloqueos estrictos para documentación propietaria. Cuando el bloqueo de robots.txt resulta insuficiente debido a user-agents falsificados o rastreadores no conformes, recurre a reglas de firewall y bloqueo basado en IP para hacer cumplir tus políticas de protección de contenido a nivel de red.

Los rastreadores de entrenamiento como GPTBot y ClaudeBot recopilan datos para el desarrollo de modelos y no proporcionan tráfico de referencia, lo que los convierte en un alto riesgo para la protección de contenido. Los rastreadores de búsqueda como OAI-SearchBot y PerplexityBot indexan contenido para búsquedas impulsadas por IA y pueden enviar tráfico de referencia a través de citas. La mayoría de los editores bloquean los rastreadores de entrenamiento mientras permiten los rastreadores de búsqueda para equilibrar la protección de contenido con la visibilidad.

Google afirma oficialmente que bloquear Google-Extended no afecta el posicionamiento en buscadores ni la inclusión en AI Overviews. Sin embargo, algunos webmasters han reportado preocupaciones, por lo que es recomendable monitorear tu rendimiento de búsqueda tras implementar bloqueos. AI Overviews en Google Search sigue las reglas estándar de Googlebot, no las de Google-Extended.

Sí, robots.txt es una recomendación más que una norma exigible. Los rastreadores bien comportados de las principales empresas generalmente respetan las directrices de robots.txt, pero algunos rastreadores las ignoran. Para una protección más fuerte, implementa bloqueos a nivel de servidor mediante .htaccess o reglas de firewall, y verifica los rastreadores legítimos usando los rangos de direcciones IP publicados.

Revisa y actualiza tu lista de bloqueo al menos trimestralmente. Surgen nuevos rastreadores de IA regularmente, así que revisa los registros del servidor mensualmente para identificar nuevos rastreadores que acceden a tu sitio. Sigue recursos comunitarios como el proyecto ai.robots.txt en GitHub para actualizaciones sobre rastreadores emergentes y cadenas de user-agent.

Esto depende de tus prioridades de negocio. Bloquear los rastreadores de entrenamiento protege tu contenido de ser incorporado en modelos de IA sin compensación. Bloquear los rastreadores de búsqueda puede reducir tu visibilidad en plataformas de descubrimiento impulsadas por IA como la búsqueda de ChatGPT o Perplexity. Muchos editores optan por un bloqueo selectivo que apunta a rastreadores de entrenamiento mientras permiten los de búsqueda y cita.

Revisa los registros de tu servidor en busca de cadenas de user-agent de rastreadores y verifica que los rastreadores bloqueados no estén accediendo a tus páginas de contenido. Usa herramientas de analítica para monitorear los patrones de tráfico de bots. Prueba tu configuración con Knowatoa AI Search Console o Merkle robots.txt Tester para validar que tus reglas funcionan como se espera.

Los rastreadores de navegador agentic como ChatGPT Atlas y Google Project Mariner operan como navegadores web completos en lugar de simples clientes HTTP. A menudo utilizan cadenas de user-agent estándar de Chrome, lo que los hace indistinguibles del tráfico normal de navegadores. El bloqueo basado en IP se vuelve necesario para controlar el acceso de estos rastreadores avanzados.

El robots.txt específico para IA controla el acceso a tu contenido, mientras que herramientas como AmICited monitorean cómo las plataformas de IA referencian y citan tu contenido. Juntos, proporcionan visibilidad y control completos: robots.txt gestiona el acceso de rastreadores y las herramientas de monitoreo rastrean el impacto de tu contenido en los sistemas de IA.

AmICited rastrea cómo los sistemas de IA como ChatGPT, Claude, Perplexity y Google AI Overviews citan y referencian tu marca. Combina la configuración de robots.txt con el monitoreo de visibilidad de IA para entender el impacto de tu contenido en las plataformas de IA.

Aprende a configurar robots.txt para controlar el acceso de rastreadores de IA como GPTBot, ClaudeBot y Perplexity. Gestiona la visibilidad de tu marca en respu...

Debate comunitario sobre la configuración de robots.txt para rastreadores de IA como GPTBot, ClaudeBot y PerplexityBot. Experiencias reales de webmasters y espe...

Aprende cómo implementar LLMs.txt en tu sitio web para ayudar a los sistemas de IA a comprender mejor tu contenido. Guía completa paso a paso para todas las pla...

Consentimiento de Cookies

Usamos cookies para mejorar tu experiencia de navegación y analizar nuestro tráfico. See our privacy policy.