Pruebas A/B para la Visibilidad en IA: Metodología y Mejores Prácticas

Domina las pruebas A/B para la visibilidad en IA con nuestra guía integral. Aprende experimentos GEO, metodología, mejores prácticas y estudios de caso reales p...

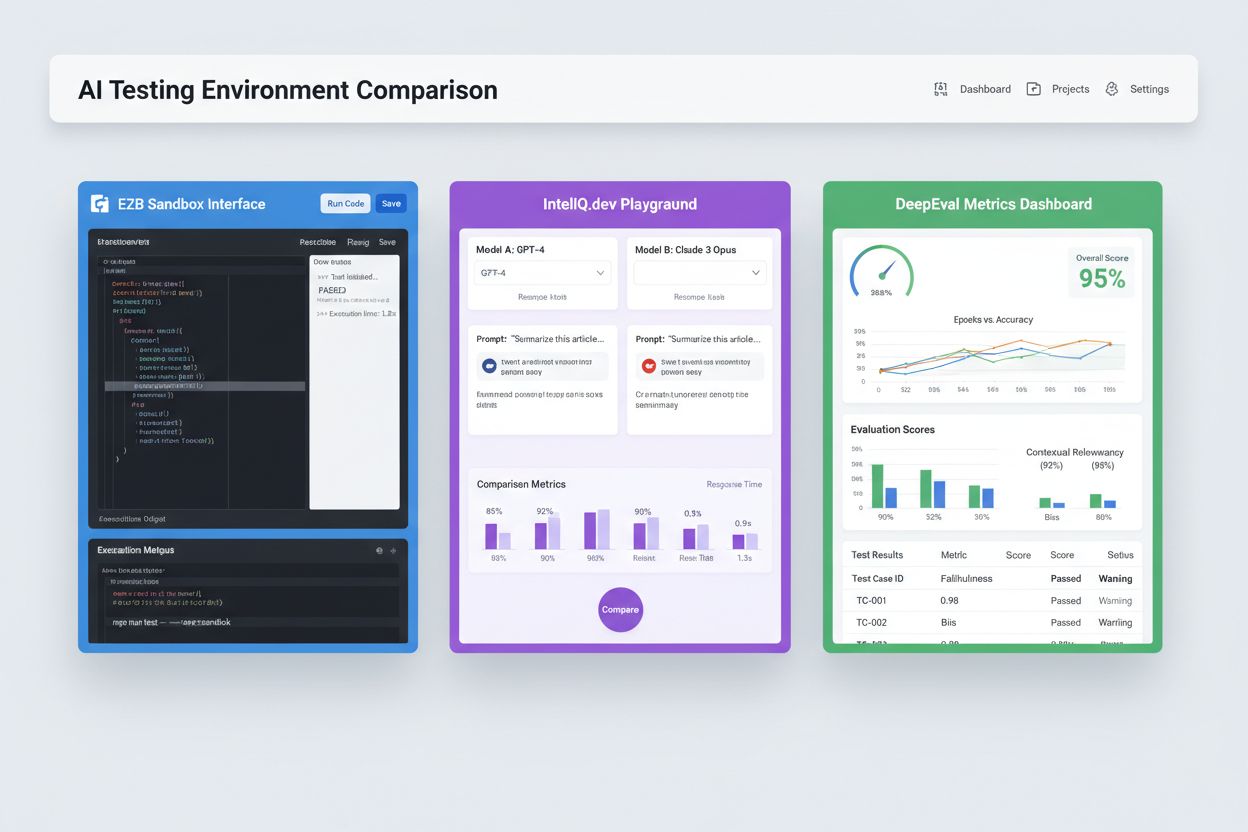

Entornos aislados tipo sandbox diseñados para validar, evaluar y depurar modelos y aplicaciones de inteligencia artificial antes de su implementación en producción. Estos espacios controlados permiten probar el rendimiento de contenidos de IA en diferentes plataformas, medir métricas y garantizar la fiabilidad sin afectar sistemas en vivo ni exponer datos sensibles.

Entornos aislados tipo sandbox diseñados para validar, evaluar y depurar modelos y aplicaciones de inteligencia artificial antes de su implementación en producción. Estos espacios controlados permiten probar el rendimiento de contenidos de IA en diferentes plataformas, medir métricas y garantizar la fiabilidad sin afectar sistemas en vivo ni exponer datos sensibles.

Un Entorno de Pruebas de IA es un espacio computacional controlado y aislado, diseñado para validar, evaluar y depurar modelos y aplicaciones de inteligencia artificial antes de su despliegue en sistemas de producción. Funciona como un sandbox donde desarrolladores, científicos de datos y equipos de QA pueden ejecutar modelos de IA de forma segura, probar diferentes configuraciones y medir el rendimiento frente a métricas predefinidas sin afectar sistemas en vivo ni exponer datos sensibles. Estos entornos replican las condiciones de producción mientras mantienen un aislamiento total, permitiendo identificar problemas, optimizar el comportamiento del modelo y garantizar la fiabilidad en diversos escenarios. El entorno de pruebas actúa como una puerta de calidad crítica en el ciclo de vida del desarrollo de IA, cerrando la brecha entre la experimentación y el despliegue a nivel empresarial.

Un Entorno de Pruebas de IA completo consta de varias capas técnicas interconectadas que colaboran para ofrecer capacidades de prueba integral. La capa de ejecución de modelos gestiona la inferencia y el cálculo real, soportando múltiples frameworks (PyTorch, TensorFlow, ONNX) y tipos de modelos (LLMs, visión por computadora, series temporales). La capa de gestión de datos administra los conjuntos de datos de prueba, fixtures y la generación de datos sintéticos, manteniendo el aislamiento y cumplimiento de datos. El framework de evaluación incluye motores de métricas, librerías de aserciones y sistemas de puntuación que miden las salidas de los modelos frente a los resultados esperados. La capa de monitoreo y registro captura trazas de ejecución, métricas de rendimiento, datos de latencia y registros de errores para análisis posteriores. La capa de orquestación gestiona flujos de trabajo de pruebas, ejecución en paralelo, asignación de recursos y aprovisionamiento del entorno. A continuación se muestra una comparación de componentes clave en diferentes tipos de entornos de pruebas:

| Componente | Pruebas LLM | Visión por Computadora | Series Temporales | Multi-Modal |

|---|---|---|---|---|

| Entorno de Modelo | Inferencia Transformer | Inferencia acelerada GPU | Procesamiento secuencial | Ejecución híbrida |

| Formato de Datos | Texto/tokens | Imágenes/tensores | Secuencias numéricas | Medios mixtos |

| Métricas de Evaluación | Similitud semántica, alucinación | Precisión, IoU, F1-score | RMSE, MAE, MAPE | Alineación cross-modal |

| Requisitos de Latencia | 100-500ms típico | 50-200ms típico | <100ms típico | 200-1000ms típico |

| Método de Aislamiento | Contenedor/VM | Contenedor/VM | Contenedor/VM | microVM Firecracker |

Los Entornos de Pruebas de IA modernos deben admitir ecosistemas heterogéneos de modelos, permitiendo a los equipos evaluar aplicaciones en diferentes proveedores de LLM, frameworks y objetivos de despliegue de forma simultánea. Las pruebas multiplataforma permiten comparar salidas de modelos como GPT-4 de OpenAI, Claude de Anthropic, Mistral y alternativas open-source como Llama en el mismo entorno de pruebas, facilitando una selección informada de modelos. Plataformas como E2B ofrecen sandboxes aislados que ejecutan código generado por cualquier LLM, soportando Python, JavaScript, Ruby y C++ con acceso completo al sistema de archivos, terminal y gestión de paquetes. IntelIQ.dev permite la comparación simultánea de múltiples modelos de IA con interfaces unificadas, posibilitando probar prompts y plantillas con políticas en diferentes proveedores. Los entornos de pruebas deben gestionar:

Los Entornos de Pruebas de IA satisfacen diversas necesidades organizacionales en desarrollo, aseguramiento de calidad y cumplimiento. Los equipos de desarrollo los utilizan para validar el comportamiento del modelo durante el desarrollo iterativo, probando variaciones de prompts, afinando parámetros y depurando salidas inesperadas antes de la integración. Los equipos de ciencia de datos aprovechan estos entornos para evaluar el rendimiento de los modelos en conjuntos de datos de validación, comparar diferentes arquitecturas y medir métricas como precisión, recall y F1-score. El monitoreo de producción implica pruebas continuas de modelos desplegados, detectando la degradación de rendimiento y activando pipelines de reentrenamiento cuando se sobrepasan umbrales de calidad. Equipos de cumplimiento y seguridad validan que los modelos cumplan normativas, no generen salidas sesgadas y gestionen datos sensibles adecuadamente. Ejemplos de aplicaciones empresariales incluyen:

El panorama de pruebas de IA incluye plataformas especializadas para diferentes escenarios y escalas organizacionales. DeepEval es un framework open-source de evaluación LLM que ofrece más de 50 métricas respaldadas por investigación, incluyendo corrección de respuestas, similitud semántica, detección de alucinaciones y puntuación de toxicidad, con integración nativa con Pytest para CI/CD. LangSmith (de LangChain) ofrece observabilidad, evaluación y despliegue integrados con trazabilidad, versionado de prompts y gestión de datasets para aplicaciones LLM. E2B proporciona sandboxes seguros y aislados impulsados por microVMs Firecracker, soportando ejecución de código con tiempos de arranque menores a 200ms, sesiones de hasta 24 horas e integración con principales proveedores de LLM. IntelIQ.dev enfatiza pruebas orientadas a la privacidad con cifrado de extremo a extremo, controles de acceso por roles y soporte para múltiples modelos de IA como GPT-4, Claude y alternativas open-source. La siguiente tabla compara capacidades clave:

| Herramienta | Enfoque Principal | Métricas | Integración CI/CD | Soporte Multi-Modelo | Modelo de Precio |

|---|---|---|---|---|---|

| DeepEval | Evaluación LLM | 50+ métricas | Pytest nativo | Limitado | Open-source + cloud |

| LangSmith | Observabilidad y evaluación | Métricas personalizadas | API | Ecosistema LangChain | Freemium + empresarial |

| E2B | Ejecución de código | Métricas de rendimiento | GitHub Actions | Todos los LLMs | Pago por uso + empresarial |

| IntelIQ.dev | Pruebas orientadas a privacidad | Métricas personalizadas | Workflow builder | GPT-4, Claude, Mistral | Suscripción |

Los Entornos Empresariales de Pruebas de IA deben implementar controles estrictos de seguridad para proteger datos sensibles, cumplir regulaciones y evitar accesos no autorizados. El aislamiento de datos exige que los datos de prueba nunca se filtren a APIs externas ni servicios de terceros; plataformas como E2B usan microVMs Firecracker para asegurar aislamiento completo de procesos sin acceso compartido al kernel. Los estándares de cifrado deben incluir cifrado de extremo a extremo para datos en reposo y en tránsito, con soporte para requisitos de cumplimiento HIPAA, SOC 2 Tipo 2 y GDPR. Los controles de acceso deben aplicar permisos por roles, logs de auditoría y flujos de aprobación para pruebas sensibles. Las buenas prácticas incluyen: mantener datasets de prueba separados de los de producción, aplicar enmascaramiento a datos personales (PII), usar generación de datos sintéticos para pruebas realistas sin riesgos de privacidad, realizar auditorías de seguridad regulares en la infraestructura de pruebas y documentar todos los resultados para fines de cumplimiento. También se recomienda implementar mecanismos de detección de sesgo para identificar conductas discriminatorias en los modelos, usar herramientas de interpretabilidad como SHAP o LIME para entender las decisiones del modelo, y establecer registros de decisiones para rastrear cómo los modelos llegan a resultados concretos, lo cual es clave para la responsabilidad regulatoria.

Los Entornos de Pruebas de IA deben integrarse de forma fluida con pipelines de integración y despliegue continuos existentes para habilitar puertas de calidad automatizadas y ciclos rápidos de iteración. La integración nativa CI/CD permite que las pruebas se ejecuten automáticamente en cada commit, pull request o en intervalos programados usando plataformas como GitHub Actions, GitLab CI o Jenkins. La integración de DeepEval con Pytest permite a los desarrolladores escribir casos de prueba como tests estándar de Python que se ejecutan en los flujos CI existentes, reportando resultados junto a tests unitarios tradicionales. La evaluación automatizada puede medir métricas de rendimiento del modelo, comparar salidas con versiones base y bloquear despliegues si no se cumplen umbrales de calidad. El manejo de artefactos implica almacenar datasets de prueba, checkpoints de modelos y resultados de evaluación en sistemas de control de versiones o repositorios de artefactos para reproducibilidad y trazabilidad. Entre los patrones de integración destacan:

El panorama de Entornos de Pruebas de IA evoluciona rápidamente para afrontar retos emergentes de complejidad, escala y heterogeneidad de modelos. Las pruebas agénticas ganan importancia a medida que los sistemas de IA superan la inferencia de un solo modelo, pasando a flujos multi-paso donde los agentes usan herramientas, toman decisiones e interactúan con sistemas externos—requiriendo nuevos marcos de evaluación que midan finalización de tareas, seguridad y fiabilidad. La evaluación distribuida permite pruebas a escala ejecutando miles de instancias concurrentes en la nube, fundamental en aprendizaje por refuerzo y entrenamiento masivo de modelos. El monitoreo en tiempo real evoluciona desde la evaluación por lotes hacia pruebas continuas de nivel productivo que detectan degradación de rendimiento, deriva de datos y sesgos emergentes en sistemas vivos. Plataformas de observabilidad como AmICited surgen como herramientas esenciales para monitoreo y visibilidad integral de IA, proporcionando dashboards centralizados que rastrean rendimiento, patrones de uso y métricas de calidad en todo el portafolio de IA. Los entornos de prueba del futuro integrarán cada vez más la remediación automática, donde los sistemas no solo detectan problemas sino que lanzan pipelines de reentrenamiento o actualizaciones de modelos de forma automática, y la evaluación cross-modal, soportando pruebas simultáneas de modelos de texto, imagen, audio y video en marcos unificados.

Un Entorno de Pruebas de IA es un sandbox aislado donde puedes probar de forma segura modelos, prompts y configuraciones sin afectar sistemas en vivo ni usuarios. El despliegue en producción es el entorno real donde los modelos sirven a usuarios finales. Los entornos de prueba permiten detectar problemas, optimizar el rendimiento y validar cambios antes de que lleguen a producción, reduciendo riesgos y asegurando la calidad.

Sí, los entornos modernos de pruebas de IA permiten pruebas multi-modelo. Plataformas como E2B, IntelIQ.dev y DeepEval te permiten probar el mismo prompt o entrada en diferentes proveedores de LLM (OpenAI, Anthropic, Mistral, etc.) de manera simultánea, facilitando la comparación directa de salidas y métricas de rendimiento.

Los Entornos Empresariales de Pruebas de IA implementan múltiples capas de seguridad, incluyendo aislamiento de datos (contenedorización o microVMs), cifrado de extremo a extremo, controles de acceso basados en roles, registro de auditoría y certificaciones de cumplimiento (SOC 2, GDPR, HIPAA). Los datos nunca salen del entorno aislado a menos que sean exportados explícitamente, protegiendo la información sensible.

Los entornos de prueba facilitan el cumplimiento al proporcionar auditorías de todas las evaluaciones de modelos, soportar el enmascaramiento de datos y la generación de datos sintéticos, aplicar controles de acceso y mantener el aislamiento completo de los datos de prueba respecto a los sistemas de producción. Esta documentación y control ayuda a las organizaciones a cumplir con normativas como GDPR, HIPAA y SOC 2.

Las métricas clave dependen de tu caso de uso: para LLMs, sigue precisión, similitud semántica, tasas de alucinación y latencia; para sistemas RAG, mide precisión/recuperación de contexto y fidelidad; para modelos de clasificación, monitorea precisión, recall y F1-score; para todos los modelos, evalúa la degradación de rendimiento en el tiempo e indicadores de sesgo.

El costo varía según la plataforma: DeepEval es open-source y gratuito; LangSmith ofrece un plan gratuito y opciones pagas desde $39/mes; E2B usa precios por uso según el tiempo de sandbox; IntelIQ.dev ofrece precios por suscripción. Muchas plataformas también cuentan con precios empresariales para despliegues a gran escala.

Sí, la mayoría de los entornos de pruebas modernos soportan integración CI/CD. DeepEval se integra nativamente con Pytest, E2B funciona con GitHub Actions y GitLab CI, y LangSmith ofrece integración por API. Esto permite pruebas automatizadas en cada commit y aplicación de puertas de despliegue.

Las pruebas end-to-end tratan toda tu aplicación de IA como una caja negra, evaluando la salida final frente a los resultados esperados. Las pruebas a nivel de componente evalúan piezas individuales (llamadas a LLM, recuperadores, uso de herramientas) por separado, usando trazado e instrumentación. Las pruebas a nivel de componente aportan mayor detalle sobre dónde ocurren los problemas, mientras las pruebas end-to-end validan el comportamiento global del sistema.

AmICited rastrea cómo los sistemas de IA referencian tu marca y contenido en ChatGPT, Claude, Perplexity y Google AI. Obtén visibilidad en tiempo real de tu presencia en IA con monitoreo y analítica integrales.

Domina las pruebas A/B para la visibilidad en IA con nuestra guía integral. Aprende experimentos GEO, metodología, mejores prácticas y estudios de caso reales p...

Aprende a probar la presencia de tu marca en motores de IA con pruebas de prompts. Descubre métodos manuales y automatizados para monitorear la visibilidad en I...

Aprende cómo construir y utilizar bibliotecas de prompts para pruebas manuales de visibilidad en IA. Guía DIY para comprobar cómo los sistemas de IA mencionan t...

Consentimiento de Cookies

Usamos cookies para mejorar tu experiencia de navegación y analizar nuestro tráfico. See our privacy policy.