Esiste un indice di ricerca AI? Come i motori AI indicizzano i contenuti

Scopri come funzionano gli indici di ricerca AI, le differenze tra i metodi di indicizzazione di ChatGPT, Perplexity e SearchGPT, e come ottimizzare i tuoi cont...

Scopri le differenze fondamentali tra l’indicizzazione AI e quella di Google. Scopri come LLM, embedding vettoriali e la ricerca semantica stanno rivoluzionando il recupero delle informazioni e cosa significa per la visibilità dei tuoi contenuti.

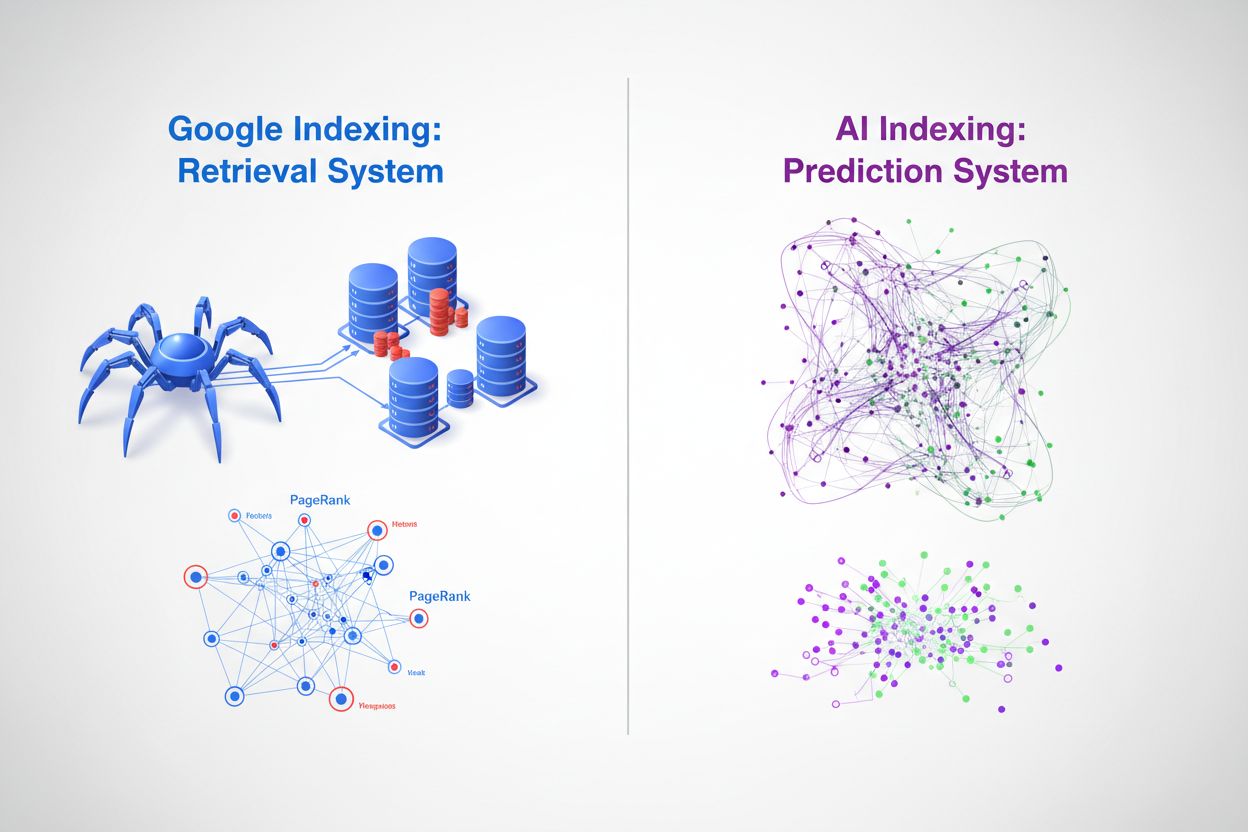

Alla base, l’indicizzazione di Google e l’indicizzazione AI rappresentano approcci fondamentalmente diversi all’organizzazione e al recupero delle informazioni. Il motore di ricerca tradizionale di Google opera come un sistema di recupero: scansiona il web, cataloga i contenuti e restituisce link classificati quando gli utenti interrogano parole chiave specifiche. Al contrario, l’indicizzazione AI tramite grandi modelli linguistici (LLM) come ChatGPT, Gemini e Copilot funziona come un sistema predittivo: codifica enormi quantità di dati di addestramento nelle reti neurali e genera risposte contestualmente rilevanti direttamente. Mentre Google si chiede “dove si trova questa informazione?”, l’AI domanda “qual è la risposta più pertinente?” Questa distinzione cambia radicalmente il modo in cui i contenuti vengono scoperti, classificati e presentati agli utenti, creando due ecosistemi informativi paralleli ma sempre più interconnessi.

Il processo di indicizzazione di Google segue una pipeline ben consolidata che domina la ricerca da oltre due decenni. I crawler Googlebot attraversano sistematicamente il web, seguendo i link da una pagina all’altra e raccogliendo contenuti, che vengono poi elaborati tramite l’infrastruttura di indicizzazione di Google. Il sistema estrae segnali chiave tra cui parole chiave, metadati e struttura dei link, memorizzando queste informazioni in enormi database distribuiti. Il PageRank proprietario di Google valuta l’importanza delle pagine in base alla quantità e qualità dei link che puntano a esse, operando secondo il principio che le pagine importanti ricevono più link da altre pagine importanti. La corrispondenza delle parole chiave rimane centrale per determinare la pertinenza: quando un utente inserisce una query, il sistema di Google identifica le pagine che contengono quei termini esatti o semanticamente simili e le classifica in base a centinaia di fattori tra cui autorità del dominio, freschezza dei contenuti, segnali di esperienza utente e rilevanza tematica. Questo approccio eccelle nel trovare rapidamente informazioni specifiche e si è dimostrato estremamente efficace per query di tipo navigazionale e transazionale, il che spiega l'89,56% della quota di mercato di Google nelle ricerche e l’elaborazione di 8,5-13,7 miliardi di query al giorno.

| Aspetto | Indicizzazione Google | Dettagli |

|---|---|---|

| Meccanismo Principale | Scansione Web & Indicizzazione | Googlebot attraversa sistematicamente le pagine web |

| Algoritmo di Ranking | PageRank + 200+ Fattori | Link, parole chiave, freschezza, esperienza utente |

| Rappresentazione Dati | Parole chiave & Link | Token di testo e relazioni ipertestuali |

| Frequenza Aggiornamenti | Scansione Continua | Indicizzazione in tempo reale di contenuti nuovi/aggiornati |

| Elaborazione Query | Corrispondenza Parole Chiave | Corrispondenza esatta e semantica delle parole chiave |

| Quota di Mercato | 89,56% Globale | 8,5-13,7 miliardi di query al giorno |

I modelli AI adottano un meccanismo di indicizzazione fondamentalmente diverso, basato su embedding vettoriali e comprensione semantica anziché sulla corrispondenza di parole chiave. Durante l’addestramento, gli LLM elaborano miliardi di token di dati testuali, imparando a rappresentare concetti, relazioni e significati come vettori ad alta dimensione in un processo chiamato generazione di embedding. Questi embedding catturano relazioni semantiche—ad esempio, “re” meno “uomo” più “donna” approssima “regina”—permettendo al modello di comprendere il contesto e l’intento invece di limitarsi a confrontare stringhe di caratteri. Il processo di indicizzazione nei sistemi AI coinvolge diversi meccanismi chiave:

Questo approccio consente ai sistemi AI di comprendere l’intento dell’utente anche quando le query utilizzano una terminologia diversa rispetto al materiale di origine, e di sintetizzare informazioni tra concetti multipli per generare risposte nuove. Il risultato è un paradigma di recupero fondamentalmente diverso, dove l’“indice” è distribuito nei pesi della rete neurale invece che in un database tradizionale.

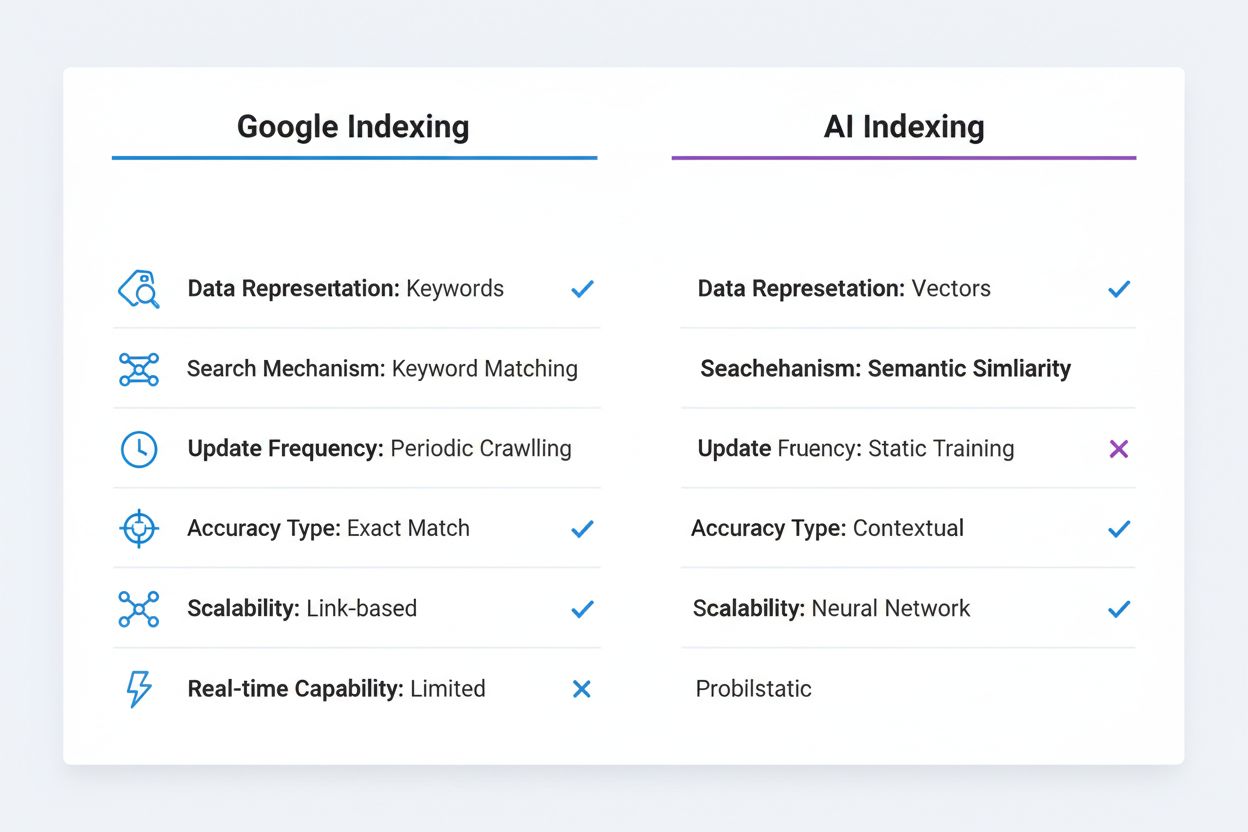

Le distinzioni tecniche tra indicizzazione Google e indicizzazione AI hanno profonde implicazioni per la scoperta e la visibilità dei contenuti. La corrispondenza esatta delle parole chiave, ancora importante nell’algoritmo di Google, è in gran parte irrilevante nei sistemi AI—un LLM comprende che “automobile”, “auto” e “veicolo” sono semanticamente equivalenti senza richiedere ottimizzazione esplicita delle parole chiave. L’indicizzazione di Google è deterministica e riproducibile; la stessa query restituisce gli stessi risultati classificati tra utenti e periodi di tempo (salvo personalizzazione). L’indicizzazione AI è probabilistica e variabile; la stessa query può generare risposte diverse in base ai parametri di temperatura e campionamento, anche se la conoscenza sottostante resta coerente. Il sistema di Google eccelle con informazioni strutturate e discrete come prezzi di prodotti, orari di attività e dati fattuali, che può estrarre e mostrare in snippet e pannelli informativi. I sistemi AI hanno difficoltà con questo tipo di informazioni precise e aggiornate, poiché i dati di addestramento hanno un limite temporale e non possono accedere in modo affidabile a informazioni in tempo reale senza strumenti esterni. Al contrario, i sistemi AI eccellono nella comprensione contestuale e sintesi, collegando concetti distanti ed esponendo relazioni complesse in linguaggio naturale. L’indicizzazione di Google richiede collegamenti e citazioni esplicite—il contenuto deve essere pubblicato online e collegato per essere scoperto. L’indicizzazione AI opera su conoscenza implicita codificata durante l’addestramento, il che significa che informazioni preziose contenute in PDF, contenuti a pagamento o database privati restano invisibili a entrambi i sistemi ma per motivi diversi.

| Aspetto di Confronto | Indicizzazione Google | Indicizzazione AI |

|---|---|---|

| Rappresentazione Dati | Parole chiave & Link | Embedding Vettoriali |

| Meccanismo di Ricerca | Corrispondenza Parole Chiave | Similarità Semantica |

| Frequenza Aggiornamento | Scansione Periodica | Dati di Addestramento Statici |

| Tipo di Accuratezza | Focus su Corrispondenza Esatta | Comprensione Contestuale |

| Modello di Scalabilità | Autorità basata sui link | Pesi della Rete Neurale |

| Capacità in tempo reale | Sì (con scansione) | Limitata (senza RAG) |

L’emergere dei database vettoriali rappresenta un ponte cruciale tra l’indicizzazione tradizionale e il recupero potenziato dall’AI, permettendo alle organizzazioni di implementare la ricerca semantica su larga scala. Database vettoriali come Pinecone, Weaviate e Milvus memorizzano embedding ad alta dimensione ed eseguono ricerca di similarità utilizzando metriche come similarità coseno e distanza euclidea, consentendo di trovare contenuti semanticamente correlati anche in assenza di corrispondenza esatta delle parole chiave. Questa tecnologia alimenta la Retrieval-Augmented Generation (RAG), una tecnica in cui i sistemi AI interrogano database vettoriali per recuperare contesto rilevante prima di generare risposte, migliorando radicalmente l’accuratezza e consentendo l’accesso a informazioni proprietarie o aggiornate. I sistemi RAG possono recuperare i documenti semanticamente più simili alla query dell’utente in millisecondi, fornendo al modello AI informazioni fondate da citare ed espandere. Google ha integrato la comprensione semantica nel suo algoritmo core tramite BERT e modelli successivi, superando la mera corrispondenza di parole chiave verso la comprensione dell’intento di ricerca e del significato dei contenuti. I database vettoriali permettono il recupero in tempo reale di informazioni rilevanti, consentendo agli AI di accedere a dati attuali, knowledge base aziendali e informazioni specialistiche senza necessità di riaddestramento. Questa capacità è particolarmente potente per le applicazioni enterprise, dove le organizzazioni necessitano che i sistemi AI rispondano a domande su informazioni proprietarie mantenendo accuratezza e fornendo citazioni verificabili.

L’ascesa dell’indicizzazione AI sta ridefinendo radicalmente il modo in cui i contenuti ottengono visibilità e generano traffico. Il fenomeno della ricerca zero-click—in cui Google risponde direttamente alle query nei risultati di ricerca senza che gli utenti debbano cliccare sui siti sorgente—è accelerato drasticamente con l’integrazione dell’AI, e i chatbot AI spingono oltre generando risposte senza alcuna attribuzione visibile. Il tradizionale traffico da click viene sostituito dalle citazioni AI, dove i creatori di contenuti ottengono visibilità tramite menzioni nelle risposte generate dall’AI anziché tramite click degli utenti. Questo cambiamento ha profonde implicazioni: un brand menzionato in una risposta di ChatGPT raggiunge milioni di utenti ma non genera traffico diretto né dati analitici sull’engagement. Autorità del brand e competenza tematica diventano sempre più importanti poiché i sistemi AI sono addestrati a citare fonti autorevoli e riconoscere l’expertise di dominio, rendendo fondamentale per le organizzazioni stabilire chiari segnali di autorità nei propri contenuti. I dati strutturati diventano più preziosi in questo contesto, facilitando sia a Google che ai sistemi AI la comprensione del contesto e della credibilità dei contenuti. Il gioco della visibilità non riguarda più solo il ranking per parole chiave—si tratta di essere riconosciuti come fonte autorevole degna di citazione da parte di sistemi AI che elaborano miliardi di documenti e devono distinguere informazioni affidabili da disinformazione.

Piuttosto che sostituire l’indicizzazione di Google, il futuro sembra essere quello della convergenza e coesistenza. Google ha già iniziato a integrare funzionalità AI direttamente nella ricerca tramite la funzione AI Overview (ex SGE), che genera riassunti AI accanto ai risultati di ricerca tradizionali, creando di fatto un sistema ibrido che combina l’infrastruttura di indicizzazione di Google con le capacità generative dell’AI. Questo approccio consente a Google di mantenere il suo punto di forza principale—indicizzazione web completa e analisi dei link—aggiungendo la capacità dell’AI di sintetizzare e contestualizzare le informazioni. Altri motori di ricerca e aziende AI stanno perseguendo strategie simili, con Perplexity che combina ricerca web e generazione AI, e Microsoft che integra ChatGPT in Bing. I sistemi di recupero informativo più sofisticati probabilmente adotteranno strategie di indicizzazione multimodale che sfruttano sia il recupero tradizionale basato su parole chiave per informazioni precise sia quello semantico/vettoriale per la comprensione del contesto. Organizzazioni e creatori di contenuti dovranno prepararsi a un panorama in cui i contenuti vanno ottimizzati per molteplici meccanismi di scoperta contemporaneamente—SEO tradizionale per l’algoritmo di Google, dati strutturati per i sistemi AI e ricchezza semantica per il recupero vettoriale.

I content strategist e i marketer devono ora adottare un approccio di doppia ottimizzazione che tenga conto sia dei meccanismi di ricerca tradizionale sia di quelli AI. Questo significa mantenere una solida ottimizzazione per parole chiave e strategie di link-building per Google, assicurandosi allo stesso tempo che i contenuti dimostrino autorità tematica, profondità semantica e ricchezza contestuale che i sistemi AI possano riconoscere e citare. Implementare una marcatura dati strutturati completa (Schema.org) diventa essenziale, aiutando sia Google che i sistemi AI a comprendere contesto, credibilità e relazioni dei contenuti—questo è particolarmente importante per i segnali E-E-A-T (Esperienza, Competenza, Autorevolezza, Affidabilità) che influenzano sia la probabilità di ranking che di citazione. Creare contenuti approfonditi e completi che esplorano a fondo gli argomenti diventa più prezioso che mai, poiché i sistemi AI sono più propensi a citare fonti autorevoli e ben documentate che forniscono un contesto completo, piuttosto che pagine sottili ottimizzate solo per parole chiave. Le organizzazioni dovrebbero implementare sistemi di monitoraggio delle citazioni per tracciare le menzioni nelle risposte AI, analogamente a come si tracciano i backlink, comprendendo che la visibilità negli output AI rappresenta una nuova forma di earned media. Costruire una knowledge base o content hub che dimostri chiara competenza in domini specifici aumenta la probabilità di essere riconosciuti come fonte autorevole dai sistemi AI. Infine, l’ascesa della Generative Engine Optimization (GEO) come disciplina implica che i marketer debbano capire come strutturare i contenuti, usare pattern linguistici naturali e costruire segnali di autorità che attraggano sia i sistemi di ranking algoritmico sia i meccanismi di citazione AI—un approccio più sofisticato e sfaccettato rispetto alla sola SEO tradizionale.

La distinzione tra indicizzazione AI e indicizzazione Google non riguarda la sostituzione di una con l’altra, ma piuttosto un’espansione fondamentale del modo in cui le informazioni sono organizzate, recuperate e presentate agli utenti. L’approccio basato sul recupero di Google resta potente per trovare rapidamente informazioni specifiche, mentre quello predittivo dell’AI eccelle nella sintesi, nel contesto e nella comprensione dell’intento dell’utente. Le organizzazioni di maggior successo saranno quelle che riconosceranno questa dualità e ottimizzeranno contenuti e presenza digitale per entrambi i sistemi contemporaneamente. Comprendendo le differenze tecniche tra questi approcci di indicizzazione, implementando dati strutturati, costruendo autorità tematica e monitorando la visibilità sia nella ricerca tradizionale che sulle piattaforme AI, le organizzazioni potranno garantire che i loro contenuti restino scopribili e preziosi in un panorama informativo sempre più complesso. Il futuro della ricerca non è singolare—è plurale, distribuito e sempre più intelligente.

L'indicizzazione di Google è un sistema di recupero che scansiona il web, cataloga i contenuti e restituisce link classificati in base a parole chiave e link. L'indicizzazione AI è un sistema predittivo che codifica i dati di addestramento nelle reti neurali e genera risposte contestualmente rilevanti direttamente. Google chiede 'dove si trova questa informazione?' mentre l'AI chiede 'qual è la risposta più pertinente?'

Gli embedding vettoriali convertono testo e altri dati in array numerici ad alta dimensione che catturano il significato semantico. Questi embedding permettono ai sistemi AI di comprendere che 'auto', 'automobile' e 'veicolo' sono semanticamente equivalenti senza una corrispondenza esplicita delle parole chiave. Concetti simili sono rappresentati come vettori vicini nello spazio ad alta dimensione.

I modelli AI tradizionali hanno un limite di conoscenza e non possono accedere in modo affidabile a informazioni in tempo reale. Tuttavia, i sistemi Retrieval-Augmented Generation (RAG) possono interrogare database vettoriali e fonti web per recuperare informazioni aggiornate prima di generare risposte, colmando questa lacuna.

Il GEO è una disciplina emergente focalizzata sull'ottimizzazione dei contenuti per le risposte generate dall'AI invece che per le classifiche di ricerca tradizionali. Si concentra su autorità tematica, dati strutturati, profondità semantica e credibilità del brand per aumentare la probabilità di essere citati dai sistemi AI.

La ricerca per parole chiave corrisponde esattamente o similmente a parole nei documenti. La ricerca semantica comprende il significato e l'intento delle query, permettendo di trovare risultati pertinenti anche quando viene usata una terminologia diversa. Ad esempio, una ricerca semantica per 'smartphone' potrebbe restituire anche risultati per 'dispositivo mobile' o 'cellulare.'

Più che una sostituzione, il futuro sembra essere una convergenza. Google sta integrando funzionalità AI nella ricerca tramite strumenti come AI Overviews, creando sistemi ibridi che uniscono l'indicizzazione tradizionale con l'AI generativa. Le organizzazioni devono ottimizzare per entrambi i sistemi simultaneamente.

Un database vettoriale memorizza embedding ad alta dimensione ed esegue ricerche di similarità utilizzando metriche come la similarità coseno. È fondamentale per implementare la ricerca semantica e la Retrieval-Augmented Generation (RAG), consentendo ai sistemi AI di accedere e recuperare informazioni rilevanti su larga scala in millisecondi.

I marketer dovrebbero adottare un approccio di doppia ottimizzazione: mantenere la SEO tradizionale per Google mentre costruiscono autorità tematica, implementano dati strutturati, creano contenuti completi e monitorano le citazioni AI. Concentrarsi sulla dimostrazione di competenza e credibilità per essere riconosciuti come fonte autorevole dai sistemi AI.

Tieni traccia di come appare il tuo brand nelle risposte generate dall'AI su ChatGPT, Gemini, Perplexity e Google AI Overviews. Ottieni insight in tempo reale sulle tue citazioni e visibilità AI.

Scopri come funzionano gli indici di ricerca AI, le differenze tra i metodi di indicizzazione di ChatGPT, Perplexity e SearchGPT, e come ottimizzare i tuoi cont...

Scopri come motori AI come ChatGPT, Perplexity e Gemini indicizzano e processano i contenuti web utilizzando crawler avanzati, NLP e machine learning per addest...

Scopri come inviare e ottimizzare i tuoi contenuti per i motori di ricerca AI come ChatGPT, Perplexity e Gemini. Approfondisci strategie di indicizzazione, requ...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.