Crawler AI spiegati: GPTBot, ClaudeBot e altri

Comprendi come funzionano i crawler AI come GPTBot e ClaudeBot, le loro differenze rispetto ai crawler di ricerca tradizionali e come ottimizzare il tuo sito pe...

Scopri come prendere decisioni strategiche sul blocco dei crawler AI. Valuta tipo di contenuto, fonti di traffico, modelli di ricavo e posizione competitiva con il nostro quadro decisionale completo.

I crawler AI sono diventati una forza significativa nell’ecosistema digitale, cambiando radicalmente il modo in cui i contenuti vengono scoperti, indicizzati e utilizzati su Internet. Questi sistemi automatizzati sono progettati per navigare sistematicamente nei siti web, estrarre dati e alimentarli in modelli di machine learning che alimentano tutto, dai motori di ricerca alle applicazioni di AI generativa. Lo scenario comprende tre tipi distinti di crawler: data scraper che estraggono informazioni specifiche per scopi commerciali, crawler dei motori di ricerca come Googlebot che indicizzano i contenuti per i risultati di ricerca, e crawler di assistenti AI che raccolgono dati di addestramento per grandi modelli linguistici. Tra gli esempi troviamo GPTBot di OpenAI, Claude-Web di Anthropic e il crawler AI Overviews di Google, ciascuno con scopi e impatti diversi. Secondo analisi recenti, circa il 21% dei 1.000 siti web principali ha già implementato qualche forma di blocco ai crawler AI, segno di una crescente consapevolezza della necessità di gestire questi visitatori automatizzati. Capire quali crawler stanno accedendo al tuo sito e perché lo fanno è il primo passo cruciale per decidere consapevolmente se bloccarli o consentirli. La posta in gioco è alta perché questa decisione influisce direttamente sulla visibilità dei tuoi contenuti, sui flussi di traffico e, in ultima analisi, sul tuo modello di ricavo.

Piuttosto che prendere una decisione generica di bloccare o consentire tutti i crawler AI, un approccio più sofisticato consiste nel valutare la propria situazione attraverso il Framework BEDC, ovvero Modello di Business, Rischio di Esposizione, Dipendenza dal Traffico Organico e Posizione Competitiva. Ognuno di questi quattro fattori ha un peso diverso a seconda delle caratteristiche del tuo sito web e, insieme, creano una matrice decisionale completa che tiene conto della complessità dell’editoria digitale moderna. Il framework riconosce che non esiste una risposta unica—ciò che funziona per un’organizzazione di news può essere completamente sbagliato per una SaaS, e ciò che avvantaggia un brand affermato può danneggiare un concorrente emergente. Valutando sistematicamente ogni fattore, puoi andare oltre le reazioni emotive verso l’AI e prendere decisioni basate sui dati e in linea con gli obiettivi di business.

| Fattore | Raccomandazione | Considerazione Chiave |

|---|---|---|

| Modello di Business | I siti supportati da pubblicità dovrebbero essere più cauti; i modelli in abbonamento possono essere più permissivi | Dipendenza dei ricavi dal coinvolgimento diretto degli utenti vs. licenze |

| Rischio di Esposizione | Ricerche originali e contenuti proprietari richiedono blocco; i contenuti generici possono essere più aperti | Vantaggio competitivo legato a insight o dati unici |

| Dipendenza dal Traffico Organico | Alta dipendenza (>40% traffico) suggerisce di consentire i crawler Google ma bloccare gli assistenti AI | Bilancio tra visibilità nella ricerca e protezione dei dati per l’addestramento AI |

| Posizione Competitiva | I leader di mercato possono permettersi di bloccare; chi emerge può beneficiare della visibilità AI | Vantaggio del primo arrivato nelle partnership AI vs. protezione dei contenuti |

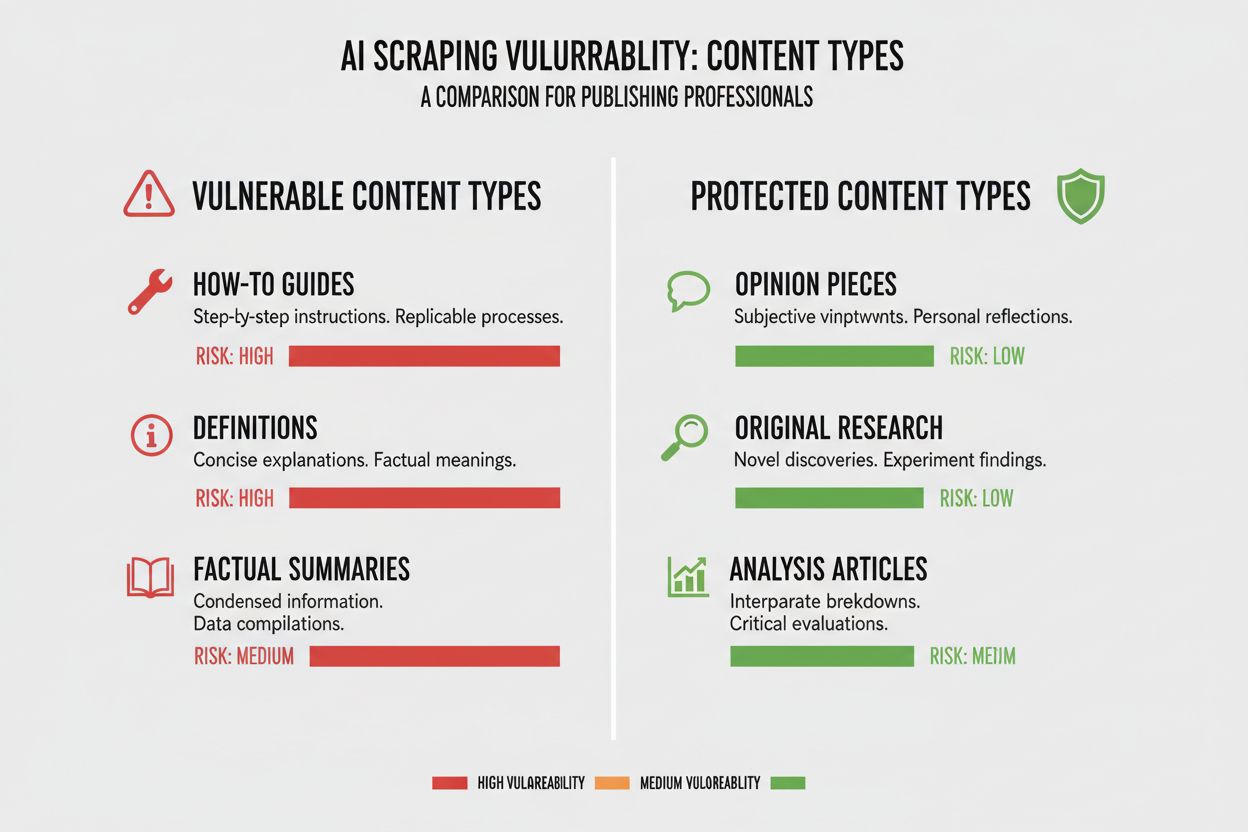

Tipologie diverse di contenuto presentano livelli molto differenti di vulnerabilità ai crawler AI, e comprendere la posizione dei tuoi contenuti in questo spettro è fondamentale per decidere. Ricerche originali e dati proprietari rappresentano i tuoi asset di maggior valore e meritano la protezione più forte, perché i modelli AI addestrati su questi contenuti possono competere direttamente con la tua strategia di monetizzazione. News e informazioni in tempo reale occupano una posizione intermedia—il valore legato alla tempestività si riduce rapidamente, ma essere indicizzati dai motori di ricerca resta fondamentale per il traffico, creando tensione tra visibilità nella ricerca e protezione dei dati per l’AI. I contenuti generici come guide pratiche, tutorial e materiale di riferimento sono molto meno vulnerabili perché ampiamente disponibili online e meno legati ai ricavi principali. Contenuti vocali e multimediali godono di una protezione naturale perché i crawler AI attuali hanno difficoltà a estrarre valore significativo da audio e video, rendendo questi formati intrinsecamente più sicuri dall’estrazione per l’addestramento AI. Contenuti educativi evergreen e articoli di opinione si collocano a metà: preziosi per il traffico organico ma meno minacciati dalla concorrenza AI. L’aspetto chiave è che la strategia di blocco deve essere proporzionale al vantaggio competitivo offerto dai tuoi contenuti: proteggere i “gioielli di famiglia” restando aperto ai crawler per ciò che beneficia da un’ampia distribuzione.

La dipendenza dal traffico organico è forse il fattore più concreto nella decisione sui crawler AI, perché quantifica direttamente il compromesso tra visibilità e protezione dei contenuti. I siti che ricevono oltre il 40% del traffico dalla ricerca organica affrontano un vincolo critico: bloccare i crawler AI spesso significa anche bloccare o limitare i crawler di Google, con conseguenze devastanti per la visibilità e il traffico organico. La distinzione tra Google-Extended (che effettua crawling per l’addestramento AI) e Googlebot (che effettua crawling per l’indicizzazione della ricerca) è fondamentale: in teoria puoi consentire uno e bloccare l’altro, anche se ciò comporta complessità tecniche. Un caso di studio dal New York Times mostra le dimensioni del fenomeno: la testata ha ricevuto circa 240.600 visite da crawler AI in un periodo specifico, evidenziando la portata del traffico AI per i grandi editori. Tuttavia, i dati di Akamai mostrano che bloccare i crawler comporta il 96% di traffico referral in meno da quelle fonti, suggerendo che il contributo dei crawler AI è minimo rispetto alla ricerca tradizionale. Il rapporto crawl-to-referral per i crawler AI è molto basso—spesso meno dello 0,15% dei contenuti scansionati genera visite di ritorno—quindi bloccarli ha un impatto trascurabile sul traffico reale. Per i siti con alta dipendenza dalla ricerca organica, la scelta di bloccare i crawler AI va bilanciata con il rischio di bloccare per errore i crawler dei motori di ricerca, cosa molto più dannosa per il business.

Il modello di ricavo influenza profondamente l’approccio ai crawler AI perché diverse strategie di monetizzazione creano incentivi diversi attorno alla distribuzione e protezione dei contenuti. I siti supportati da pubblicità vivono il conflitto più forte con i crawler AI, perché i ricavi dipendono dalle visite degli utenti per visualizzare annunci, e i modelli AI che sintetizzano i contenuti riducono la motivazione a cliccare. I modelli basati su abbonamento possono permettersi di essere più permissivi con i crawler AI, poiché i ricavi derivano dagli abbonamenti diretti e una certa visibilità AI potrebbe persino favorire le iscrizioni. I modelli ibridi che combinano pubblicità, abbonamenti e affiliazioni richiedono valutazioni più dettagliate: bloccare i crawler può proteggere la pubblicità ma compromettere affiliazioni o crescita degli abbonamenti. Un’opportunità emergente è il modello referral AI, dove i siti potrebbero guadagnare consentendo l’accesso ai crawler AI in cambio di attribuzione e traffico—modello ancora in sviluppo ma potenzialmente rivoluzionario per la distribuzione dei contenuti. Per chi vuole comprendere l’impatto reale dei crawler AI sul business, strumenti come AmICited.com sono fondamentali per tracciare dove i contenuti vengono citati e usati dai sistemi AI, offrendo visibilità sul valore effettivo dello scambio. È essenziale comprendere a fondo il proprio modello di ricavo per prevedere come i crawler AI influenzeranno ogni fonte di entrata, evitando decisioni generiche fondate solo su principi.

Dopo aver deciso di bloccare determinati crawler AI, l’implementazione tecnica richiede comprensione sia delle potenzialità che dei limiti degli strumenti disponibili. Il metodo più comune è robots.txt, un semplice file di testo nella root del sito che istruisce i crawler su quali aree possono o non possono accedere. Tuttavia, robots.txt ha un limite critico: è uno standard volontario, e i crawler malevoli o aggressivi possono ignorarlo. Ecco un esempio di blocco di specifici crawler AI tramite robots.txt:

User-agent: GPTBot

Disallow: /

User-agent: CCBot

Disallow: /

User-agent: anthropic-ai

Disallow: /

User-agent: Claude-Web

Disallow: /

Oltre a robots.txt, valuta di bloccare questi principali crawler AI:

Per una protezione più robusta, molte organizzazioni implementano il blocco a livello CDN tramite servizi come Cloudflare, che blocca il traffico al perimetro della rete prima che raggiunga i server, garantendo migliori prestazioni e sicurezza. Un approccio a doppio livello che combina robots.txt e blocco CDN offre la massima protezione, intercettando sia i crawler rispettosi che quelli che lo ignorano. È importante notare che il blocco a livello CDN richiede competenze tecniche e può avere effetti collaterali imprevisti se configurato male, quindi è consigliato ad aziende con risorse tecniche dedicate.

La verità scomoda sul blocco dei crawler AI è che l’impatto reale sul traffico è spesso molto inferiore rispetto alle reazioni emotive che il tema suscita, e i dati raccontano una storia più sfumata di quanto molti editori si attendano. Secondo analisi recenti, i crawler AI rappresentano in media solo lo 0,15% del traffico totale per la maggior parte dei siti, un dato sorprendentemente basso rispetto all’attenzione ricevuta. Tuttavia, la crescita del traffico dei crawler AI è notevole: alcune fonti segnalano una crescita di 7 volte anno su anno nelle richieste di crawling AI, segno che l’impatto attuale è piccolo ma la traiettoria è in forte ascesa. ChatGPT rappresenta circa il 78% di tutto il traffico dei crawler AI, rendendo il crawler di OpenAI il vero protagonista, seguito da contributi molto minori di altre aziende AI. Il rapporto crawl-to-referral è particolarmente rivelatore: pur richiedendo milioni di pagine, i crawler AI generano visite di ritorno a tassi spesso inferiori allo 0,15%, quindi il blocco ha impatto minimo sul traffico reale. Bloccare i crawler AI riduce il traffico referral del 96%, ma dato che era già minimo (spesso meno dello 0,15% del totale), l’impatto netto sul business è frequentemente trascurabile. Si crea così un paradosso: bloccare i crawler AI sembra una presa di posizione contro il furto di contenuti, ma l’effetto reale è spesso così piccolo che quasi non si nota nelle analytics. La vera domanda non è se bloccare i crawler danneggerà il traffico—di solito no—ma se consentirli crea opportunità o rischi strategici che superano il contributo minimo che forniscono.

La posizione competitiva nel proprio mercato determina profondamente l’approccio ai crawler AI, perché la strategia ottimale per un leader di settore è molto diversa rispetto a quella di un concorrente emergente. I player dominanti come New York Times, Wall Street Journal e le grandi testate possono permettersi di bloccare i crawler AI perché la notorietà del brand e le relazioni dirette con il pubblico li rendono indipendenti dalla scoperta tramite AI. Emergenti e editori di nicchia ragionano diversamente: essere indicizzati dai sistemi AI e comparire nei riassunti generati può essere uno dei pochi modi per ottenere visibilità contro i grandi concorrenti. Il vantaggio del primo arrivato nelle partnership AI può essere considerevole—chi negozia condizioni favorevoli con le aziende AI per primo può assicurarsi migliori attribuzioni, referral o accordi di licenza rispetto a chi aspetta. Esiste anche un effetto sussidio: quando i grandi editori bloccano i crawler, le aziende AI si affidano di più ai contenuti di chi invece consente, dando a questi ultimi una visibilità AI sproporzionata. Si crea quindi una dinamica competitiva in cui bloccare i crawler può danneggiare la propria posizione se i concorrenti li consentono e ottengono visibilità AI. Capire la propria posizione nel panorama competitivo è essenziale per prevedere come la decisione di blocco influirà sul proprio ruolo rispetto ai concorrenti.

Decidere se bloccare o consentire i crawler AI richiede una valutazione sistematica della propria situazione in base a criteri concreti. Usa questa checklist per guidare il processo decisionale:

Valutazione dell’Esposizione dei Contenuti

Analisi della Composizione del Traffico

Valutazione della Posizione di Mercato

Valutazione del Rischio sui Ricavi

Oltre a questa valutazione iniziale, implementa revisioni trimestrali della strategia sui crawler AI, poiché lo scenario evolve rapidamente e la scelta ottimale di oggi potrebbe cambiare in pochi mesi. Usa strumenti come AmICited.com per tracciare dove i tuoi contenuti vengono citati e usati nei sistemi AI, ottenendo dati concreti sul valore dello scambio. L’aspetto chiave è che questa decisione non va presa una volta e dimenticata—richiede valutazioni e aggiustamenti continui man mano che lo scenario AI si evolve e le condizioni di business cambiano.

Una grande opportunità emergente che potrebbe rivoluzionare tutto lo scenario dei crawler AI è la funzionalità pay-per-crawl di Cloudflare, che introduce un modello internet basato sui permessi in cui i proprietari dei siti possono monetizzare l’accesso dei crawler AI invece di bloccarli o consentirli semplicemente. Questo approccio riconosce che le aziende AI traggono valore dal crawling dei tuoi contenuti e, invece di entrare in guerra col blocco, puoi negoziare una compensazione per quell’accesso. Il modello si basa sulla verifica crittografica per garantire che solo i crawler autorizzati possano accedere ai tuoi contenuti, impedendo scraping non autorizzato e consentendo alle aziende AI legittime di pagare per l’accesso. Si crea così un controllo granulare su quali crawler possono accedere a quali contenuti, permettendo di monetizzare i contenuti di alto valore restando aperto ai motori di ricerca e altri crawler utili. Il modello pay-per-crawl consente anche funzionalità di audit AI, mostrando esattamente quali contenuti sono stati scansionati, quando e da chi, fornendo una trasparenza impossibile con i metodi tradizionali di blocco. Per gli editori che implementano questa strategia, le funzionalità di monitoraggio di AmICited.com diventano ancora più preziose, poiché è possibile tracciare non solo dove i contenuti appaiono nei sistemi AI, ma anche verificare di ricevere la giusta compensazione per quell’uso. Anche se il modello è ancora agli inizi e poco adottato, rappresenta un approccio più sofisticato rispetto alla scelta binaria tra bloccare e consentire—uno che riconosce il valore reciproco nel rapporto tra editori e aziende AI, proteggendo i propri interessi tramite meccanismi contrattuali e tecnici.

Bloccare i crawler AI impedisce loro di accedere ai tuoi contenuti tramite robots.txt o blocco a livello CDN, proteggendo i tuoi dati dall’essere utilizzati per l’addestramento AI. Consentire i crawler significa che i tuoi contenuti possono essere indicizzati dai sistemi AI, potenzialmente comparendo in riassunti e risposte generate dall’AI. La scelta dipende dal tipo di contenuto, modello di ricavo e posizione competitiva.

Bloccare i crawler AI non danneggerà direttamente la tua SEO se blocchi solo crawler specifici per l’AI come GPTBot e consenti Googlebot. Tuttavia, se per errore blocchi Googlebot, il tuo posizionamento nei motori di ricerca ne risentirà in modo significativo. La chiave è un controllo granulare per bloccare solo i crawler di addestramento AI mantenendo l’accesso ai motori di ricerca.

Sì, puoi utilizzare robots.txt per bloccare specifici crawler in base alla loro stringa user-agent consentendone altri. Ad esempio, potresti bloccare GPTBot ma consentire Google-Extended, o viceversa. Questo approccio granulare ti permette di proteggere i tuoi contenuti da alcune aziende AI restando visibile ad altre.

robots.txt è uno standard volontario che si basa sul rispetto delle tue istruzioni da parte dei crawler—alcune aziende AI lo ignorano. Il blocco a livello CDN (come quello di Cloudflare) blocca il traffico al perimetro della rete prima che raggiunga i tuoi server, offrendo un’applicazione più rigorosa. Un approccio a doppio livello che utilizza entrambi i metodi offre la migliore protezione.

Puoi controllare i log del server per le stringhe user-agent dei crawler AI noti come GPTBot, CCBot e Claude-Web. Strumenti come AmICited.com offrono funzionalità di monitoraggio per tracciare dove i tuoi contenuti compaiono nei sistemi AI e con quale frequenza vengono accessi dai crawler AI.

Il pay-per-crawl è un modello emergente in cui le aziende AI pagano per accedere ai tuoi contenuti. Sebbene sia ancora in fase beta e poco adottato, rappresenta una potenziale nuova fonte di ricavo. La validità dipende dal volume di traffico dei crawler AI e dai compensi che le aziende AI sono disposte a pagare.

Se un crawler AI ignora le direttive del tuo robots.txt, implementa il blocco a livello CDN tramite servizi come Cloudflare. Puoi anche configurare il tuo server per restituire errori 403 agli user-agent dei crawler AI noti. In caso di violazioni persistenti, valuta azioni legali o contatta direttamente l’azienda AI.

Rivedi la tua strategia sui crawler AI ogni trimestre, poiché lo scenario evolve rapidamente. Monitora i cambiamenti nel traffico dei crawler AI, i nuovi crawler che entrano nel mercato e i cambiamenti nella tua posizione competitiva. Usa strumenti come AmICited.com per tracciare come i tuoi contenuti vengono utilizzati dai sistemi AI e adatta la strategia di conseguenza.

Traccia dove compare il tuo contenuto nelle risposte generate dall’AI e comprendi l’impatto dei crawler AI sulla tua attività con la piattaforma di monitoraggio completa di AmICited.com.

Comprendi come funzionano i crawler AI come GPTBot e ClaudeBot, le loro differenze rispetto ai crawler di ricerca tradizionali e come ottimizzare il tuo sito pe...

Scopri quali crawler AI autorizzare o bloccare nel tuo robots.txt. Guida completa che copre GPTBot, ClaudeBot, PerplexityBot e oltre 25 crawler AI con esempi di...

Guida completa ai crawler AI nel 2025. Identifica GPTBot, ClaudeBot, PerplexityBot e oltre 20 altri bot AI. Scopri come bloccare, consentire o monitorare i craw...