Come si Comportano i Case Study nei Risultati di Ricerca AI

Scopri come i case study si posizionano nei motori di ricerca AI come ChatGPT, Perplexity e Google AI Overviews. Scopri perché i sistemi di intelligenza artific...

Scopri come formattare i case study per le citazioni AI. Scopri il modello per strutturare storie di successo che i LLM citano in AI Overviews, ChatGPT e Perplexity.

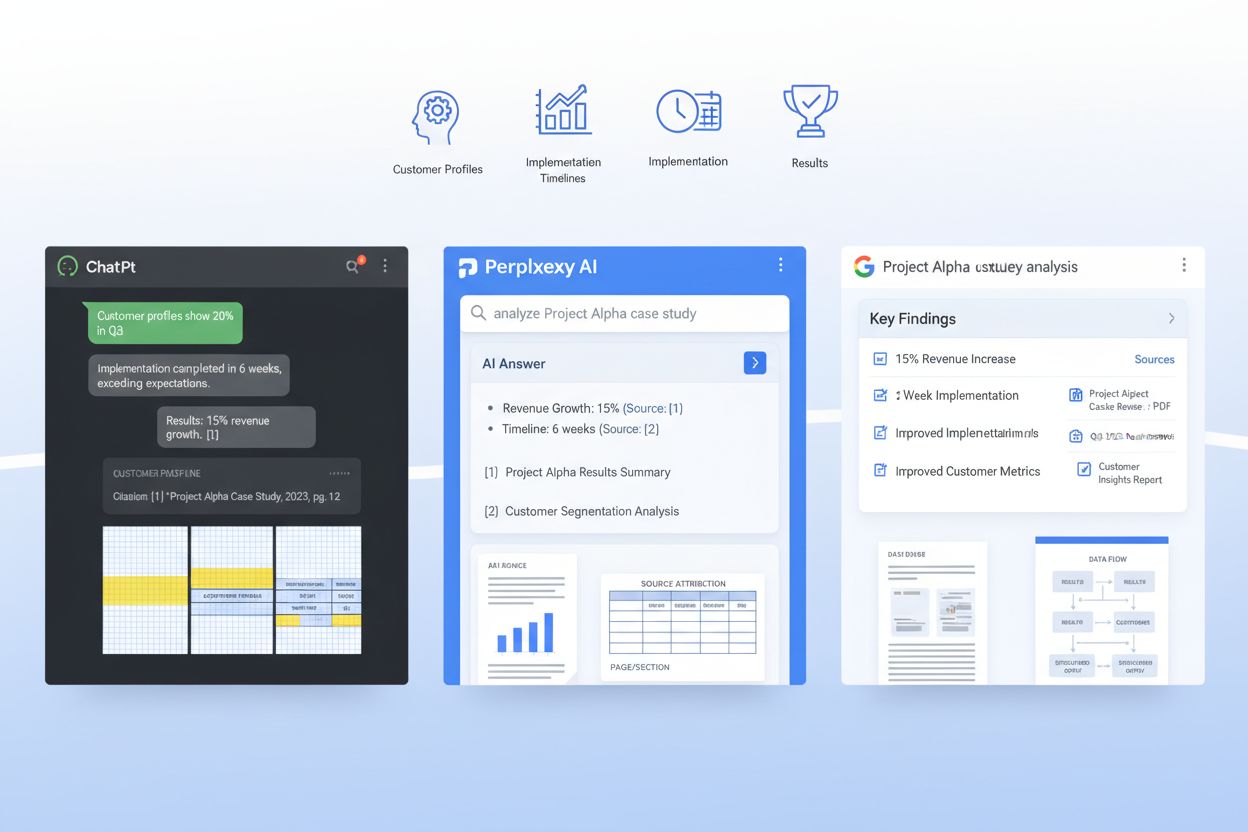

I sistemi AI come ChatGPT, Perplexity e le AI Overviews di Google stanno cambiando radicalmente il modo in cui i buyer B2B scoprono e validano i case study—eppure la maggior parte delle aziende li pubblica ancora in formati che i LLM riescono a malapena a interpretare. Quando un buyer enterprise chiede a un sistema AI “Quali piattaforme SaaS funzionano meglio per il nostro caso d’uso?”, il sistema cerca tra milioni di documenti per trovare prove rilevanti, ma i case study formattati male restano invisibili a questi sistemi di recupero. Questo crea un gap critico: mentre i case study tradizionali generano una win rate base del 21% nelle trattative avanzate, i case study ottimizzati per l’AI possono aumentare la probabilità di citazione del 28-40% se strutturati correttamente per i modelli di machine learning. Le aziende che vincono in questo nuovo scenario capiscono che il vantaggio dei dati proprietari deriva dall’essere scopribili dai sistemi AI, non solo dai lettori umani. Senza un’ottimizzazione intenzionale per il recupero LLM, le tue storie di successo più convincenti restano di fatto inaccessibili ai sistemi AI che ora influenzano oltre il 60% delle decisioni di acquisto enterprise.

Un case study pronto per l’AI non è solo una narrazione ben scritta—è un documento strutturato strategicamente che serve contemporaneamente i lettori umani e i modelli di machine learning. I case study più efficaci seguono un’architettura coerente che permette ai LLM di estrarre le informazioni chiave, comprendere il contesto e citare la tua azienda con fiducia. Ecco il modello essenziale che separa i case study scopribili dall’AI da quelli che si perdono nei sistemi di retrieval:

| Sezione | Scopo | Ottimizzazione AI |

|---|---|---|

| Sommario TL;DR | Contesto immediato per lettori impegnati | In alto per consumo anticipato di token; 50-75 parole |

| Snapshot cliente | Identificazione rapida del profilo aziendale | Strutturato come: Settore / Dimensione Azienda / Località / Ruolo |

| Contesto di business | Definizione del problema e situazione di mercato | Usa terminologia coerente; evita variazioni di gergo |

| Obiettivi | Obiettivi specifici e misurabili del cliente | Elenca numerato; includi target quantitativi |

| Soluzione | Come il tuo prodotto/servizio ha risposto all’esigenza | Spiega esplicitamente la corrispondenza feature-benefit |

| Implementazione | Tempi, processo e dettagli di adozione | Suddividi in fasi; includi durata e milestone |

| Risultati | Outcome quantificati e metriche di impatto | Presenta come: Metrica / Baseline / Finale / Miglioramento % |

| Evidenze | Dati, screenshot o validazione terza parte | Includi tabelle per le metriche; cita le fonti chiaramente |

| Citazioni cliente | Voce autentica e validazione emotiva | Attribuisci per nome, ruolo, azienda; 1-2 frasi ciascuna |

| Segnali di riuso | Link interni e suggerimenti di cross-promotion | Suggerisci case study correlati, webinar o risorse |

Questa struttura garantisce che ogni sezione abbia una doppia funzione: si legge in modo naturale per gli umani ma offre chiarezza semantica ai sistemi RAG (Retrieval-Augmented Generation) che alimentano i LLM moderni. La coerenza di questo formato su tutta la tua libreria di case study rende esponenzialmente più facile per i sistemi AI estrarre dati comparabili e citare la tua azienda con sicurezza.

Oltre alla struttura, le scelte di formattazione specifiche che adotti hanno un impatto enorme sull’effettiva capacità dei sistemi AI di trovare e citare i tuoi case study. I LLM processano i documenti diversamente dagli umani—non scorrono o usano la gerarchia visiva come i lettori, ma sono molto sensibili a marker semantici e pattern di formattazione coerenti. Ecco gli elementi di formattazione che più potenziano il recupero AI:

Queste scelte di formattazione non riguardano l’estetica—servono a rendere il tuo case study leggibile dalle macchine così che, quando un LLM cerca prove rilevanti, la storia della tua azienda sia quella citata.

L’approccio più sofisticato ai case study AI-ready prevede l’inserimento di uno schema JSON direttamente nel documento o nello strato metadata, creando un doppio livello dove gli umani leggono la narrazione mentre le macchine interpretano i dati strutturati. Gli schemi JSON forniscono ai LLM rappresentazioni chiare e non ambigue delle informazioni chiave, migliorando drasticamente accuratezza e rilevanza delle citazioni. Ecco un esempio di struttura:

{

"@context": "https://schema.org",

"@type": "CaseStudy",

"name": "Enterprise SaaS Platform riduce il tempo di onboarding del 60%",

"customer": {

"name": "TechCorp Industries",

"industry": "Servizi finanziari",

"companySize": "500-1000 dipendenti",

"location": "San Francisco, CA"

},

"solution": {

"productName": "Nome del tuo prodotto",

"category": "Automazione workflow",

"implementationDuration": "8 settimane"

},

"results": {

"metrics": [

{"name": "Riduzione tempo onboarding", "baseline": "120 giorni", "final": "48 giorni", "improvement": "60%"},

{"name": "Tasso di adozione utenti", "baseline": "45%", "final": "89%", "improvement": "97%"},

{"name": "Riduzione ticket supporto", "baseline": "450/mese", "final": "120/mese", "improvement": "73%"}

]

},

"datePublished": "2024-01-15",

"author": {"@type": "Organization", "name": "La tua azienda"}

}

Implementando strutture JSON compatibili schema.org, dai ai LLM un modo standardizzato per comprendere e citare il tuo case study. Questo approccio si integra perfettamente con i sistemi RAG, permettendo ai modelli AI di estrarre metriche precise, comprendere il contesto cliente e attribuire le citazioni alla tua azienda con alta affidabilità. Le aziende che usano case study strutturati in JSON vedono un’accuratezza delle citazioni AI 3-4 volte superiore rispetto ai soli formati narrativi.

I sistemi RAG non processano il tuo case study come un unico blocco, ma lo suddividono in chunk semantici che rientrano nella finestra di contesto di un LLM, e la tua struttura determina direttamente se questi chunk saranno utili o frammentati. Un chunking efficace significa organizzare il case study affinché i confini semantici coincidano con il modo in cui i sistemi RAG divideranno il contenuto. Questo richiede una dimensione intenzionale dei paragrafi: ognuno dovrebbe concentrarsi su un solo concetto o dato, tipicamente 100-150 parole, così che quando un RAG estrae un chunk, contiene sempre informazioni complete e coerenti e non frasi orfane. La separazione narrativa è fondamentale—usa interruzioni nette tra problema, soluzione e risultati così che un LLM possa estrarre “la sezione risultati” come unità coesa senza confonderla con dettagli di implementazione. Inoltre, l’efficienza dei token conta: usando tabelle per le metriche invece della prosa, riduci il numero di token necessari a trasmettere le stesse informazioni, permettendo ai LLM di includere più porzioni del tuo case study nelle risposte senza superare i limiti di contesto. L’obiettivo è rendere il tuo case study “RAG-friendly” così che ogni chunk estratto sia autonomamente prezioso e contestualizzato.

Pubblicare case study per i sistemi AI richiede bilanciare la specificità che li rende credibili con gli obblighi di riservatezza verso i clienti. Molte aziende esitano a pubblicare case study dettagliati perché temono di esporre informazioni sensibili, ma una redazione e anonimizzazione strategica permette di mantenere sia trasparenza che fiducia. L’approccio più efficace prevede la creazione di più versioni di ogni case study: una versione interna completa con nomi clienti, metriche esatte e dettagli proprietari, e una versione pubblica ottimizzata per l’AI che anonimizza il cliente ma preserva impatto quantitativo e insight strategici. Ad esempio, invece di “TechCorp Industries ha risparmiato $2,3M all’anno”, potresti pubblicare “Azienda mid-market di servizi finanziari ha ridotto i costi operativi del 34%"—la metrica resta specifica per la citazione LLM, ma l’identità del cliente è protetta. Controllo delle versioni e tracciamento della compliance sono essenziali: tieni traccia chiara di cosa è stato redatto, quando e perché, assicurando che la tua libreria sia pronta per audit. Questo approccio di governance rafforza la tua strategia di citazione AI perché ti permette di pubblicare più case study più spesso senza attriti legali, offrendo ai LLM più prove da scoprire e citare.

Prima di pubblicare un case study, valida che funzioni effettivamente quando processato da LLM e sistemi RAG—non dare per scontato che una buona formattazione si traduca automaticamente in buone performance AI. Testare i tuoi case study sui sistemi AI reali rivela se struttura, metadata e contenuto abilitano davvero una citazione precisa e un recupero efficace. Ecco cinque approcci di test fondamentali:

Verifica della rilevanza: Inserisci il tuo case study su ChatGPT, Perplexity o Claude con query relative alla tua soluzione. Il sistema AI recupera e cita il tuo case study in risposta a domande pertinenti?

Accuratezza della sintesi: Chiedi a un LLM di riassumere il case study e verifica che il riassunto riporti le metriche chiave, il contesto cliente e l’impatto business senza distorsioni o allucinazioni.

Estrazione delle metriche: Testa se l’AI riesce a estrarre numeri specifici dal tuo case study (es. “Qual è stato il miglioramento del time-to-value?”). Le tabelle dovrebbero restituire un’accuratezza superiore al 96%; la prosa va testata separatamente.

Fedeltà dell’attribuzione: Verifica che quando il LLM cita il tuo case study, attribuisca correttamente le informazioni alla tua azienda e al cliente, non a competitor o fonti generiche.

Query edge-case: Testa con domande inusuali o tangenziali per assicurarti che il case study non venga applicato a casi che non copre davvero.

Questi test vanno ripetuti trimestralmente, man mano che il comportamento dei LLM evolve, e i risultati dovrebbero guidare aggiornamenti a formattazione e struttura.

Misurare l’impatto dei case study ottimizzati per l’AI richiede di tracciare sia metriche lato AI (quante volte i tuoi case study vengono citati dai LLM) sia metriche lato umano (come queste citazioni influenzano i deal reali). Lato AI, usa AmICited.com per monitorare la frequenza delle citazioni su ChatGPT, Perplexity e Google AI Overviews—traccia quante volte la tua azienda appare in risposte AI per query rilevanti, e misura se la frequenza cresce dopo la pubblicazione di nuovi case study AI-ready. Fissa una baseline delle citazioni attuali e punta a aumentare le citazioni del 40-60% entro sei mesi dall’implementazione della nuova formattazione. Lato umano, collega la crescita delle citazioni AI a metriche downstream: traccia quanti deal menzionano “ti ho trovato tramite una ricerca AI” o “un AI ha consigliato il tuo case study”, misura il miglioramento della win rate in trattative dove il case study è stato citato da un AI (target: miglioramento del 28-40% rispetto al 21% baseline), e monitora l’accorciamento del ciclo di vendita in account che hanno incontrato il tuo case study tramite discovery AI. Tieni d’occhio anche le metriche SEO—i case study AI-ready con markup schema spesso si posizionano meglio anche nella ricerca tradizionale, generando un doppio beneficio. Il feedback qualitativo del team sales è altrettanto importante: chiedi loro se i prospect arrivano più preparati e se le citazioni dei case study riducono il tempo di gestione delle obiezioni. Il KPI finale è il fatturato: traccia l’ARR incrementale attribuibile ai deal influenzati da case study citati da AI, e avrai una giustificazione ROI chiara per continuare a investire in questo formato.

L’ottimizzazione dei case study per le citazioni AI produce ROI solo se il processo diventa operativo e ripetibile, non un progetto occasionale. Inizia codificando il tuo template AI-ready in un formato standard che i team marketing e sales usano per ogni nuova storia di successo cliente—così garantisci coerenza e riduci il tempo di pubblicazione. Integra questo template nel CMS o sistema di gestione contenuti così che pubblicare un nuovo case study generi automaticamente schema JSON, header metadata ed elementi di formattazione senza lavoro manuale. Rendi la creazione di case study una routine trimestrale o mensile, non un evento annuale, perché i LLM scoprono e citano più spesso le aziende con librerie di case study più profonde e recenti. Posiziona i case study come parte centrale della strategia di abilitazione del ricavo: devono alimentare collateral di vendita, marketing di prodotto, campagne demand gen e playbook per customer success. Infine, crea un ciclo di miglioramento continuo monitorando quali case study generano più citazioni AI, quali metriche risuonano di più con i LLM e quali segmenti cliente sono più citati—e usa questi insight per guidare la prossima generazione di case study. Le aziende che vincono nell’era AI non scrivono solo case study migliori; trattano i case study come asset strategici di ricavo che richiedono ottimizzazione, misurazione e affinamento continui.

Inizia estraendo il testo dai tuoi PDF e mappa i contenuti esistenti su uno schema standard con campi come profilo cliente, sfida, soluzione e risultati. Poi crea una versione HTML leggera o CMS di ogni storia con titoli chiari e metadati, mantenendo il PDF originale come risorsa scaricabile invece che come fonte primaria per il recupero AI.

Il marketing o il product marketing di solito gestisce la narrazione, ma vendite, soluzioni tecniche e customer success dovrebbero fornire dati grezzi, dettagli di implementazione e validazione. I team legale, privacy e RevOps aiutano a garantire governance, corretta redazione e allineamento con sistemi esistenti come CRM e piattaforme di sales enablement.

Un CMS headless o una piattaforma di contenuti strutturati è ideale per memorizzare schemi e metadati, mentre un CRM o uno strumento di sales enablement può evidenziare le storie giuste nel flusso di lavoro. Per il recupero AI, di solito abbinerai un database vettoriale a un layer di orchestrazione LLM come LangChain o LlamaIndex.

Trascrivi le testimonianze video e i webinar, poi tagga le trascrizioni con gli stessi campi e sezioni dei tuoi case study scritti in modo che l'AI possa citarli. Per grafici e diagrammi, includi brevi alt-text o didascalie che descrivano il messaggio chiave così i modelli di recupero possono collegare asset visivi a domande specifiche.

Mantieni lo schema core e gli ID coerenti a livello globale, poi crea varianti tradotte che localizzano lingua, valuta e contesto normativo preservando le metriche canoniche. Conserva le versioni specifiche per località come oggetti separati ma collegati, così i sistemi AI possono dare priorità alle risposte nella lingua dell'utente senza frammentare il tuo modello dati.

Rivedi i case study ad alto impatto almeno annualmente, o prima se ci sono importanti cambiamenti di prodotto, nuove metriche o cambiamenti di contesto cliente. Usa un flusso di lavoro semplice per la gestione delle versioni con date di ultima revisione e flag di stato per segnalare a sistemi AI e umani quali storie sono più aggiornate.

Integra il recupero dei case study direttamente negli strumenti che i commerciali già usano e crea playbook concreti che mostrano come chiedere all'assistente prove pertinenti. Rafforza l'adozione condividendo storie di successo in cui case study personalizzati e proposti dall'AI hanno aiutato a chiudere trattative più velocemente o a coinvolgere nuovi stakeholder.

I case study tradizionali sono scritti per lettori umani con una narrazione fluida e design visivo. I case study ottimizzati per l'AI mantengono la narrazione ma aggiungono metadati strutturati, formattazione coerente, schemi JSON e chiarezza semantica che permette ai LLM di estrarre, comprendere e citare informazioni specifiche con un'accuratezza superiore al 96%.

Traccia come i sistemi AI citano il tuo brand su ChatGPT, Perplexity e Google AI Overviews. Ottieni insight sulla tua visibilità AI e ottimizza la tua strategia di contenuto.

Scopri come i case study si posizionano nei motori di ricerca AI come ChatGPT, Perplexity e Google AI Overviews. Scopri perché i sistemi di intelligenza artific...

Discussione della community su come i case study si comportano nei risultati di ricerca AI. Esperienze reali da marketer che monitorano le citazioni dei case st...

Scopri come Smart Rent ha generato il 345% di lead in più tramite citazioni AI. Caso studio reale che mostra strategia di generazione lead B2B, risultati e tatt...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.