Tassi di Conversione del Traffico AI: Perché la Qualità Supera la Quantità

Scopri perché il traffico AI converte 23 volte meglio della ricerca organica. Impara come ottimizzare per le piattaforme AI e misurare il vero ROI dai visitator...

Scopri perché la qualità dei dati è più importante della quantità per i modelli di IA. Impara strategie di allocazione delle risorse, implicazioni sui costi e framework pratici per ottimizzare l’investimento nei dati di training per l’IA.

La saggezza convenzionale nel machine learning ha a lungo sostenuto che “più dati sono sempre meglio”. Tuttavia, ricerche recenti mettono in discussione questa convinzione, con prove convincenti che la qualità dei dati conta molto più della quantità nel determinare le prestazioni dei modelli IA. Uno studio arxiv del 2024 (2411.15821) su piccoli modelli linguistici ha rilevato che la qualità dei dati di training gioca un ruolo molto più significativo del puro volume, rivelando che la relazione tra quantità di dati e accuratezza del modello è molto più sfumata di quanto si pensasse. Le implicazioni sui costi sono sostanziali: organizzazioni che investono molto nella raccolta dati senza dare priorità alla qualità spesso sprecano risorse su storage, elaborazione e overhead computazionale, ottenendo ritorni decrescenti sulle prestazioni dei modelli.

La qualità dei dati non è un concetto monolitico ma un framework multidimensionale che comprende diversi aspetti critici. Accuratezza indica quanto correttamente i dati rappresentano la realtà e se le etichette sono assegnate correttamente. Coerenza assicura che i dati seguano formati e standard uniformi su tutto il dataset. Completezza misura se tutte le informazioni necessarie sono presenti senza lacune o valori mancanti. Rilevanza determina se i dati affrontano direttamente il problema che il modello IA deve risolvere. Affidabilità indica l’attendibilità della fonte dati e la sua stabilità nel tempo. Infine, il rumore rappresenta variazioni indesiderate o errori che possono fuorviare il training del modello. Comprendere queste dimensioni aiuta le organizzazioni a dare priorità alla curatela dei dati in modo strategico.

| Dimensione della qualità | Definizione | Impatto sull’IA |

|---|---|---|

| Accuratezza | Correttezza delle etichette e rappresentazione dei dati | Influenza direttamente l’affidabilità delle previsioni del modello; dati etichettati male causano errori sistematici |

| Coerenza | Formattazione uniforme e struttura dati standardizzata | Permette training stabile; le incoerenze confondono gli algoritmi di apprendimento |

| Completezza | Presenza di tutte le informazioni necessarie senza lacune | Valori mancanti riducono l’efficacia dei dati di training; impatta la generalizzazione |

| Rilevanza | I dati affrontano direttamente il dominio del problema | Dati molto rilevanti superano grandi volumi di dati generici |

| Affidabilità | Attendibilità delle fonti dati e stabilità | Fonti inaffidabili introducono bias sistematici; influenza la robustezza del modello |

| Rumore | Variazioni indesiderate ed errori di misura | Rumore controllato migliora la robustezza; rumore eccessivo degrada le prestazioni |

Perseguire la quantità di dati senza garanzie di qualità crea una serie di problemi che vanno ben oltre le metriche di prestazione del modello. Le ricerche di Rishabh Iyer dimostrano che gli esperimenti sul rumore delle etichette rivelano drastici cali di accuratezza—dati etichettati male degradano attivamente le prestazioni del modello invece di fornire semplici esempi neutrali. Oltre alle preoccupazioni sull’accuratezza, le organizzazioni affrontano crescenti costi di storage e processamento per dataset che non migliorano i risultati dei modelli, insieme a significativi costi ambientali dovuti all’overhead computazionale non necessario. L’imaging medico fornisce un esempio concreto: un dataset di migliaia di radiografie etichettate erroneamente potrebbe addestrare un modello che compie con sicurezza errori diagnostici pericolosi, mettendo a rischio i pazienti. La falsa economia della raccolta di dati economici e di bassa qualità diventa evidente considerando i costi di retraining, debugging e fallimenti in produzione dovuti a dati di training scadenti.

La qualità specifica di dominio supera costantemente il volume generico nelle applicazioni IA pratiche. Considera un classificatore di sentiment allenato su recensioni di film: un dataset accuratamente curato di 10.000 recensioni di film supererà nettamente un dataset generico di sentiment con 100.000 esempi presi da notizie finanziarie, social media e recensioni di prodotti. La rilevanza dei dati di training per il problema specifico conta molto più della scala grezza, poiché i modelli apprendono pattern specifici della loro distribuzione di training. Quando i dati non sono rilevanti per l’applicazione target, il modello apprende correlazioni spurie e non si generalizza ai casi d’uso reali. Le organizzazioni dovrebbero dare priorità alla raccolta di dataset più piccoli che corrispondano esattamente al dominio del problema, invece di accumulare grandi dataset generici che richiedono ampio filtraggio e pre-processing.

L’approccio ottimale alla strategia dati non si trova in nessuno dei due estremi ma nel raggiungere la “Goldilocks Zone"—il punto d’equilibrio dove quantità e qualità dei dati sono bilanciate appropriatamente per il problema specifico. Troppi pochi dati, anche se perfettamente etichettati, lasciano i modelli sottostimati e incapaci di cogliere la complessità dei pattern reali. Al contrario, dati eccessivi con problemi di qualità creano spreco computazionale e instabilità nel training. Lo studio arxiv dimostra concretamente questo equilibrio: una duplicazione minima ha migliorato l’accuratezza dello 0,87% a livelli di duplicazione del 25%, mentre una duplicazione eccessiva al 100% ha causato un crollo catastrofico dell’accuratezza del 40%. L’equilibrio ideale dipende da molteplici fattori tra cui il tipo di algoritmo, la complessità del problema, le risorse computazionali disponibili e la varianza naturale del dominio target. La distribuzione dei dati dovrebbe riflettere la variabilità reale invece di essere artificialmente uniforme, per insegnare ai modelli a gestire la variabilità che incontreranno in produzione.

Non tutti i dati aggiuntivi sono uguali—la distinzione tra augmentazione benefica e degradazione dannosa è cruciale per una strategia dati efficace. Perturbazioni controllate e tecniche di augmentazione migliorano la robustezza del modello insegnando agli algoritmi a gestire variazioni reali come leggere rotazioni, cambi di illuminazione o piccole variazioni nelle etichette. Il dataset MNIST di cifre scritte a mano dimostra questo principio: modelli addestrati con versioni aumentate (cifre ruotate, scalate o leggermente distorte) generalizzano meglio alle variazioni reali di scrittura rispetto ai modelli addestrati solo su immagini originali. Tuttavia, corruzione severa—rumore casuale, etichettature sistematicamente errate o iniezione di dati irrilevanti—degrada attivamente le prestazioni e spreca risorse computazionali. La differenza cruciale sta nell’intenzionalità: l’augmentazione è progettata per riflettere variazioni realistiche, mentre i dati spazzatura sono rumore indiscriminato che confonde gli algoritmi. Le organizzazioni devono distinguere tra questi approcci quando espandono i propri dataset.

Per le organizzazioni con risorse limitate, l’active learning offre una soluzione potente che riduce le necessità di dati mantenendo o migliorando le prestazioni dei modelli. Invece di raccogliere e etichettare passivamente tutti i dati disponibili, gli algoritmi di active learning identificano quali esempi non etichettati sarebbero più informativi per il modello, riducendo drasticamente il lavoro umano di annotazione. Questo approccio permette di ottenere ottime prestazioni con molto meno dati etichettati, focalizzando lo sforzo umano sugli esempi più impattanti. L’active learning democratizza lo sviluppo IA rendendolo accessibile a team senza enormi budget per le etichette, consentendo di costruire modelli efficaci con una selezione dati strategica, invece che con puro volume. Imparando in modo efficiente con meno dati, le organizzazioni possono iterare più velocemente, ridurre i costi e investire le risorse nell’assicurare la qualità piuttosto che nella raccolta infinita di dati.

Una strategia di allocazione delle risorse efficace richiede di dare priorità alla qualità rispetto alla quantità nelle decisioni sui dati. Le organizzazioni dovrebbero investire in pipeline di validazione dei dati che intercettino gli errori prima che entrino nei dataset di training, implementando controlli automatici per coerenza, completezza e accuratezza. Strumenti di profilazione dei dati possono identificare problemi di qualità su larga scala, rivelando pattern di etichettatura errata, valori mancanti o esempi irrilevanti da affrontare prima del training. Le implementazioni di active learning riducono il volume di dati da revisionare umanamente, assicurando che gli esempi revisionati siano i più informativi possibili. Il monitoraggio continuo delle prestazioni del modello in produzione rivela se i problemi di qualità dei dati di training si manifestano come fallimenti reali, consentendo feedback loop rapidi per il miglioramento. La strategia ottimale bilancia la raccolta dati con una curatela rigorosa, riconoscendo che 1.000 esempi perfettamente etichettati spesso superano 100.000 rumorosi sia in prestazioni del modello che in costo totale di proprietà.

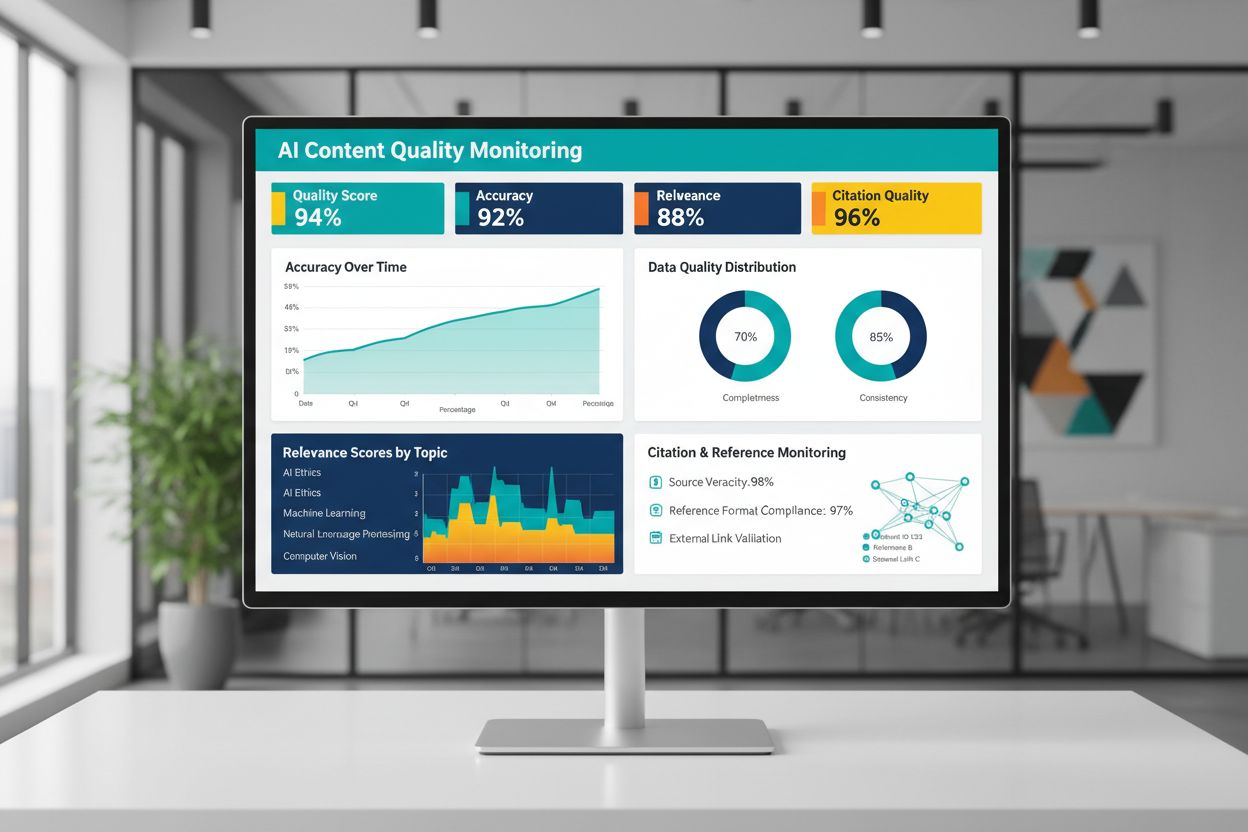

La qualità dei contenuti generati o addestrati dall’IA dipende fondamentalmente dalla qualità dei dati di training, rendendo il monitoraggio continuo delle output IA essenziale per mantenere l’affidabilità. Piattaforme come AmICited.com rispondono a questa esigenza critica monitorando le risposte dell’IA e tracciando l’accuratezza delle citazioni—un indicatore diretto della qualità e dell’affidabilità dei contenuti. Quando i sistemi IA sono addestrati su dati di bassa qualità, con citazioni scadenti o informazioni inesatte, le loro output ereditano questi difetti, potenzialmente diffondendo misinformation su larga scala. Gli strumenti di monitoraggio dovrebbero tracciare non solo le metriche di accuratezza, ma anche rilevanza, coerenza e la presenza di evidenze a supporto delle affermazioni fatte dai sistemi IA. Le organizzazioni che distribuiscono sistemi IA devono implementare feedback loop che identificano quando le output divergono dagli standard di qualità attesi, permettendo un retraining rapido o la correzione dei dati sottostanti. L’investimento in infrastrutture di monitoraggio si ripaga intercettando precocemente la degradazione della qualità, prima che impatti gli utenti o danneggi la credibilità dell’organizzazione.

Tradurre i principi della qualità dei dati in azione richiede un approccio strutturato che inizi dalla valutazione e prosegua con misurazione e iterazione. Inizia valutando la baseline attuale—comprendi la qualità dei dati di training esistenti tramite audit e profilazione. Definisci metriche di qualità chiare allineate al tuo caso d’uso specifico, che siano soglie di accuratezza, standard di coerenza o criteri di rilevanza. Implementa pratiche di data governance che stabiliscano ownership, procedure di validazione e controlli di qualità prima che i dati entrino nelle pipeline di training. Parti da dataset più piccoli e accuratamente curati invece di tentare subito di processare grandi volumi, così puoi stabilire standard e processi di qualità su scala gestibile. Misura rigorosamente i miglioramenti confrontando le prestazioni del modello prima e dopo le azioni sulla qualità, creando una giustificazione basata su evidenze per continuare ad investire. Scala gradualmente man mano che affini i processi, ampliando la raccolta dati solo dopo aver dimostrato che i miglioramenti di qualità si traducono in reali guadagni di prestazione.

No. Ricerche recenti dimostrano che la qualità dei dati conta spesso più della quantità. Dati di scarsa qualità, etichettati erroneamente o irrilevanti possono degradare attivamente le prestazioni del modello, anche su larga scala. La chiave è trovare il giusto equilibrio tra avere dati sufficienti per un training efficace e mantenere alti standard di qualità.

La qualità dei dati comprende diverse dimensioni: accuratezza (etichette corrette), coerenza (formattazione uniforme), completezza (assenza di valori mancanti), rilevanza (allineamento con il tuo problema), affidabilità (fonti attendibili) e livelli di rumore. Definisci metriche specifiche per il tuo caso d’uso e implementa controlli di validazione per intercettare i problemi di qualità prima del training.

La dimensione ideale dipende dalla complessità dell’algoritmo, dal tipo di problema e dalle risorse disponibili. Anziché puntare alla massima dimensione, cerca la 'Goldilocks Zone'—abbastanza dati da cogliere i pattern reali senza essere sovraccaricati da esempi irrilevanti o ridondanti. Parti da dati curati e scala gradualmente in base ai miglioramenti delle prestazioni.

L’augmentazione dei dati applica perturbazioni controllate (rotazioni, leggere distorsioni, variazioni di illuminazione) che preservano la vera etichetta insegnando ai modelli a gestire la variabilità reale. Questo differisce dai dati spazzatura: l’augmentazione è intenzionale e riflette variazioni realistiche, rendendo i modelli più robusti alle condizioni operative.

L’active learning identifica quali esempi non etichettati sarebbero più informativi per il modello, riducendo drasticamente il lavoro di annotazione. Invece di etichettare tutti i dati disponibili, concentri lo sforzo umano sugli esempi più impattanti, raggiungendo ottime prestazioni con molto meno dati etichettati.

Dai priorità alla qualità rispetto alla quantità. Investi in pipeline di validazione dei dati, strumenti di profilazione e processi di governance che garantiscano dati di training di alta qualità. Le ricerche mostrano che 1.000 esempi perfettamente etichettati spesso superano 100.000 rumorosi sia in prestazioni del modello che in costo totale di gestione.

I dati di scarsa qualità portano a molteplici costi: retraining del modello, debugging, fallimenti in produzione, sovraccarico di storage e spreco computazionale. In ambiti critici come l’imaging medico, dati di training di bassa qualità possono causare errori pericolosi. L’economia apparente di dati economici e di bassa qualità si rivela quando si considerano questi costi nascosti.

Implementa un monitoraggio continuo delle output IA tracciando accuratezza, rilevanza, coerenza e qualità delle citazioni. Piattaforme come AmICited monitorano come i sistemi IA fanno riferimento alle informazioni e tracciano l’accuratezza delle citazioni. Crea feedback loop collegando le prestazioni in produzione alla qualità dei dati di training per miglioramenti rapidi.

Traccia come i sistemi di IA fanno riferimento al tuo brand e assicurati dell’accuratezza dei contenuti con la piattaforma di monitoraggio IA di AmICited. Comprendi la qualità delle risposte generate dall’IA sulla tua azienda.

Scopri perché il traffico AI converte 23 volte meglio della ricerca organica. Impara come ottimizzare per le piattaforme AI e misurare il vero ROI dai visitator...

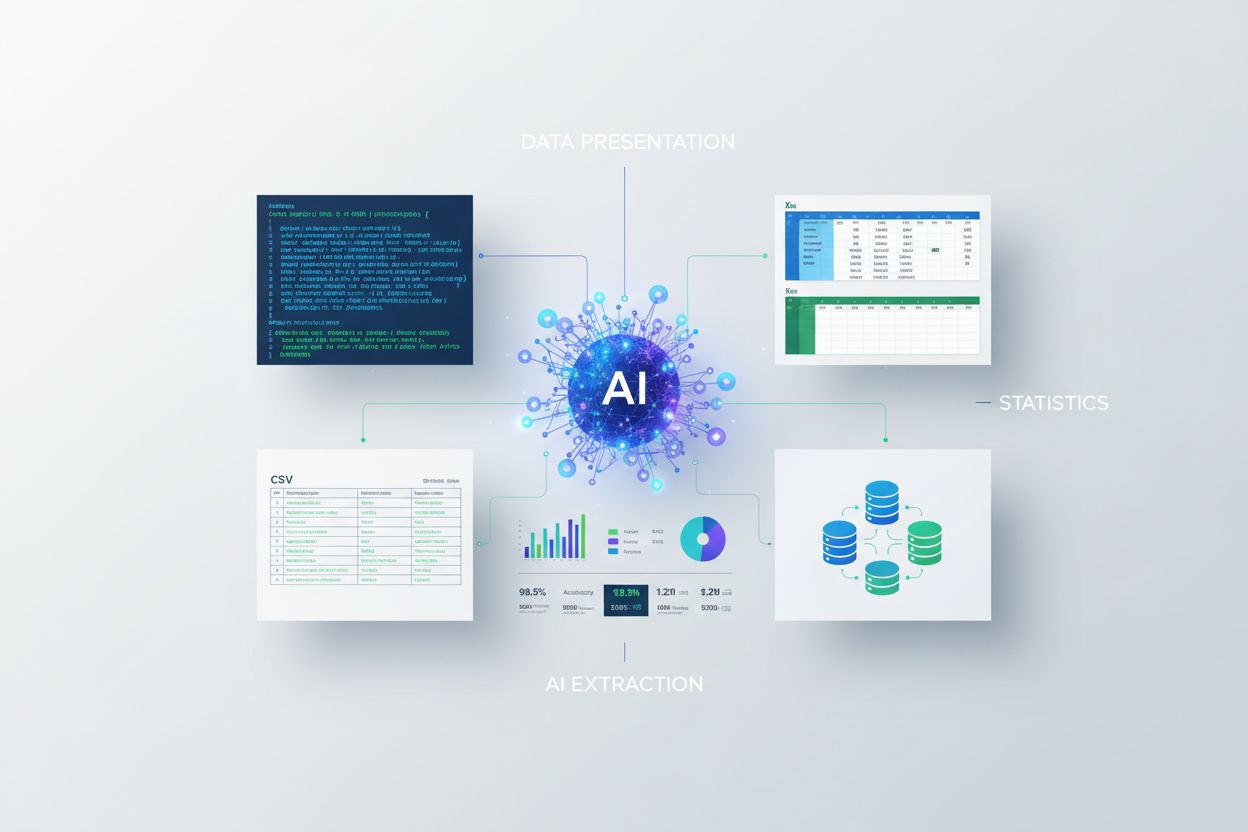

Scopri come presentare le statistiche per l'estrazione AI. Scopri le migliori pratiche per la formattazione dei dati, JSON vs CSV, e assicurati che i tuoi dati ...

Scopri come creare ricerche originali e contenuti PR guidati dai dati che i sistemi di IA citano attivamente. Scopri i 5 attributi dei contenuti degni di citazi...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.