Identificare le lacune di visibilità dei contenuti AI

Scopri come identificare e colmare le lacune di visibilità dei contenuti AI su ChatGPT, Perplexity e Google AI Overviews. Scopri metodi di analisi e strumenti p...

Scopri come i modelli di IA citano dati visivi e grafici. Scopri perché la visualizzazione dei dati è importante per le citazioni da parte dell’IA e come monitorare i tuoi contenuti visivi con AmICited.

I dati visivi rappresentano un vero collo di bottiglia per i moderni large language model, che sono stati addestrati principalmente su informazioni testuali e hanno difficoltà a elaborare, interpretare e citare grafici con la stessa precisione riservata ai contenuti scritti. Gli attuali LLM affrontano limiti significativi quando si trovano di fronte a visualizzazioni di dati: devono prima convertire gli elementi visivi in descrizioni testuali, un processo che spesso fa perdere sfumature essenziali, valori precisi e relazioni contestuali presenti nel grafico originale. L’incapacità dei sistemi LLM di processare accuratamente i dati visivi fa sì che grafici, tabelle e infografiche spesso non vengano citati o vengano citati in modo errato, creando una lacuna di credibilità per i creatori di contenuti che investono tempo nella produzione di visualizzazioni di alta qualità. Questa sfida è particolarmente rilevante per ricercatori, analisti e organizzazioni che si affidano all’elaborazione dei grafici da parte dell’IA per sintetizzare informazioni, poiché la mancanza di un’adeguata attribuzione mina sia il lavoro dell’autore originale sia l’affidabilità dei riepiloghi generati dall’IA. Comprendere questi limiti è essenziale per chiunque crei contenuti visivi in un panorama informativo sempre più guidato dall’intelligenza artificiale.

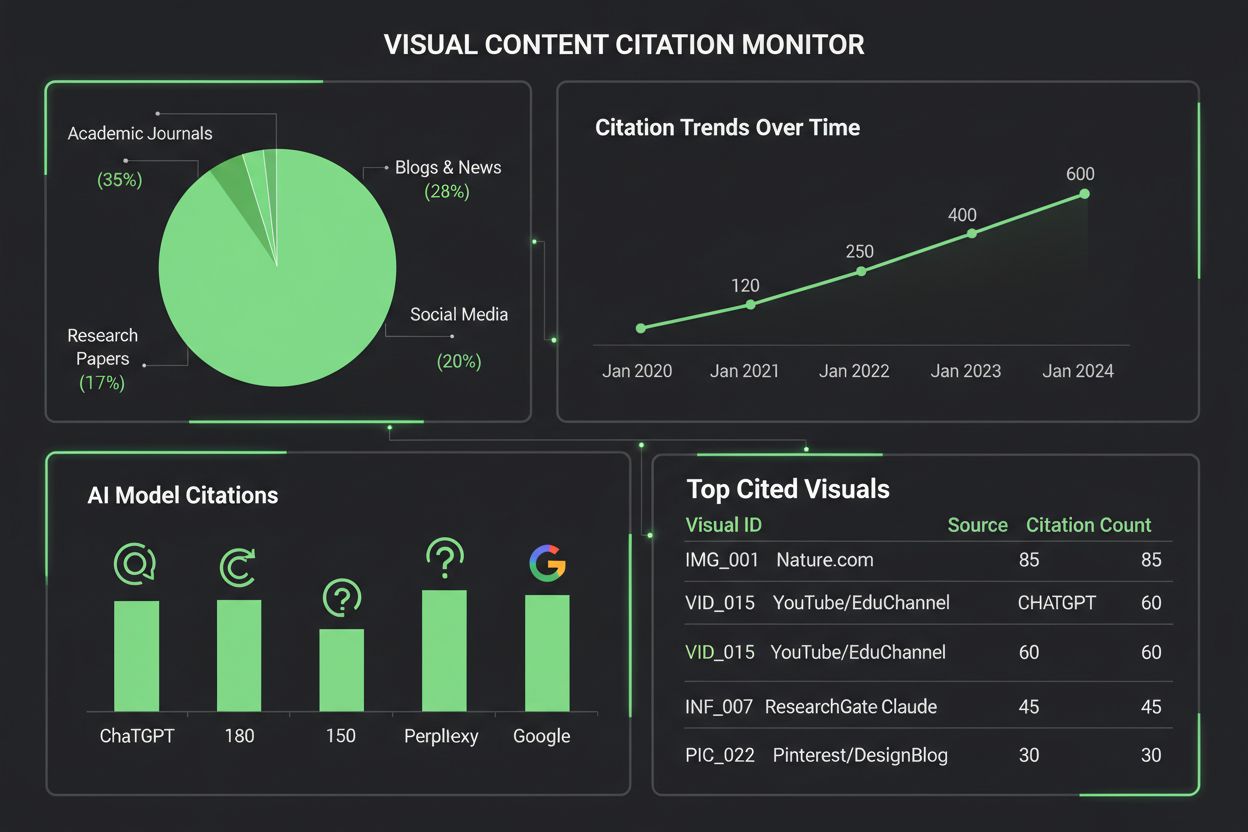

Diversi sistemi di IA affrontano la citazione dei contenuti visivi con livelli di sofisticazione diversi, a seconda della loro architettura sottostante e delle metodologie di addestramento. La seguente tabella illustra come le principali piattaforme di IA gestiscono le citazioni visive:

| Modello IA | Capacità di citazione visiva | Formato citazione | Livello di accuratezza | Supporto multimodale |

|---|---|---|---|---|

| ChatGPT (GPT-4V) | Moderata | Testo descrittivo | 65-75% | Sì (input immagini) |

| Claude 3 | Alta | Attribuzione dettagliata | 80-85% | Sì (abilitato alla visione) |

| Perplexity AI | Alta | Fonte + riferimento visivo | 85-90% | Sì (integrato con il web) |

| Google AI Overviews | Moderata-Alta | Citazioni in linea | 75-80% | Sì (ricerca immagini) |

| Gemini Pro Vision | Moderata | Riferimento contestuale | 70-78% | Sì (multimodale) |

Claude dimostra prestazioni superiori nell’attribuzione dei contenuti visivi, fornendo spesso informazioni dettagliate sulla fonte e sul contesto visivo quando fa riferimento ai grafici, mentre Perplexity AI eccelle nell’integrare le citazioni visive con le fonti web, creando una traccia di attribuzione più completa. GPT-4V di ChatGPT può elaborare immagini ma tende spesso a fornire descrizioni generiche piuttosto che citazioni precise, soprattutto con grafici finanziari complessi o visualizzazioni scientifiche. Google AI Overviews cerca di mantenere le citazioni in linea per i contenuti visivi ma a volte confonde il creatore del grafico con la fonte dei dati, generando ambiguità sull’attribuzione. Per i creatori di contenuti, questa variabilità significa che la stessa visualizzazione può ricevere trattamenti molto diversi a seconda del sistema IA che la elabora: un grafico potrebbe essere citato correttamente da Claude ma completamente non attribuito da ChatGPT, evidenziando la necessità critica di protocolli standardizzati di citazione visiva nell’ecosistema IA.

La visualizzazione dei dati svolge un ruolo sorprendentemente influente nel modo in cui i modelli di IA comprendono e rappresentano le informazioni, poiché i grafici e le tabelle inseriti nei dataset di addestramento insegnano ai modelli a riconoscere pattern, relazioni e gerarchie nei dati complessi. La qualità e la varietà dei dati visivi nei set di addestramento influenzano direttamente la capacità dei sistemi di IA di interpretare e citare visualizzazioni simili, il che significa che i modelli addestrati su dataset visivi completi mostrano prestazioni significativamente migliori nell’attribuzione dei contenuti visivi. I pattern visivi appresi durante l’addestramento influenzano l’output dei modelli in modi sottili ma misurabili: un modello addestrato ampiamente su grafici scientifici correttamente etichettati genererà con maggiore probabilità citazioni accurate per visualizzazioni simili rispetto a uno addestrato principalmente su testo. La sfida si aggrava perché la maggior parte dei grandi modelli linguistici sono stati addestrati su dati provenienti dal web, dove i contenuti visivi spesso mancano di metadati, alt-text o attribuzione della fonte, perpetuando un ciclo in cui i sistemi di IA imparano a processare i grafici senza imparare a citarli. Le organizzazioni che investono in dataset di visualizzazione dei dati di alta qualità e ben documentati stanno in realtà costruendo fondamenta migliori per i futuri sistemi di IA, anche se questo investimento resta ancora poco sfruttato nel settore.

Monitorare come i sistemi di IA citano i contenuti visivi richiede un approccio multilivello che combina rilevamento automatico e verifica manuale. I principali metodi di monitoraggio includono:

AmICited.com è specializzato nel monitoraggio delle citazioni di contenuti visivi su più piattaforme di IA, offrendo ai creatori di contenuti report dettagliati su come i loro grafici vengono citati, attribuiti o trascurati da ChatGPT, Claude, Perplexity, Google AI e altri sistemi. L’importanza del monitoraggio delle citazioni visive non può essere sottovalutata: senza un adeguato monitoraggio, i creatori perdono visibilità su come il loro lavoro influenza i contenuti generati dall’IA, rendendo impossibile promuovere pratiche di attribuzione migliori o comprendere la reale portata delle proprie visualizzazioni. Gli strumenti di monitoraggio visivo di AmICited colmano questa lacuna offrendo avvisi in tempo reale quando i grafici vengono citati, analisi dettagliate sull’accuratezza delle citazioni e suggerimenti concreti per migliorare la reperibilità dei contenuti visivi nei sistemi di IA.

Creare visualizzazioni che abbiano maggiori probabilità di essere citate dai sistemi di IA richiede scelte progettuali intenzionali che privilegino chiarezza, ricchezza di metadati e leggibilità per le macchine. Schemi di colori vivaci e ad alto contrasto ed etichette chiare migliorano notevolmente l’elaborazione dei grafici da parte dell’IA, poiché i modelli hanno difficoltà con gradienti sottili, elementi sovrapposti e legende ambigue che gli esseri umani possono invece interpretare facilmente. Includi descrizioni alt-text complete che non si limitino a descrivere cosa mostra il grafico, ma anche le relazioni tra i dati, gli insight chiave e le informazioni sulla fonte: questi metadati diventano la base per citazioni accurate da parte dell’IA. Inserisci dati strutturati all’interno delle visualizzazioni utilizzando standard come JSON-LD o microdata markup: ciò consente ai sistemi di IA di estrarre valori e relazioni precisi senza dover interpretare solo l’aspetto visivo. Assicurati che i titoli dei grafici siano descrittivi e specifici, invece che generici, poiché i modelli di IA utilizzano i titoli come ancoraggi primari per comprendere e citare i contenuti visivi. Fornisci attribuzione della fonte direttamente nella visualizzazione tramite note a piè di pagina, watermark o etichette integrate, rendendo impossibile per i sistemi di IA separare il grafico dalla sua origine. Le organizzazioni che adottano costantemente queste pratiche vedono un miglioramento misurabile nel modo in cui i loro contenuti visivi vengono citati sulle piattaforme di IA, traducendosi in maggiore attribuzione, visibilità e credibilità professionale.

Il panorama degli strumenti per il monitoraggio delle citazioni visive continua ad espandersi man mano che le organizzazioni riconoscono l’importanza di tracciare come i sistemi di IA fanno riferimento ai contenuti visivi. AmICited.com si distingue come soluzione completa progettata specificamente per monitorare le citazioni di contenuti visivi su più piattaforme di IA, offrendo ai creatori dashboard dettagliate che mostrano esattamente quando e come i loro grafici vengono citati da ChatGPT, Claude, Perplexity, Google AI Overviews e altri sistemi emergenti. Le piattaforme tradizionali di tracking delle citazioni come Google Scholar e Scopus si concentrano principalmente su articoli accademici e citazioni testuali, lasciando i contenuti visivi ampiamente non monitorati e non attribuiti. Strumenti specializzati come Tinybird e piattaforme di data visualization simili ora integrano funzionalità di monitoraggio delle citazioni, consentendo alle organizzazioni di osservare come le loro visualizzazioni di dati in tempo reale vengano consumate e citate dai sistemi di IA. Le capacità di analisi visiva di AmICited forniscono metriche sulla frequenza delle citazioni, tassi di accuratezza e pattern specifici per piattaforma, permettendo ai creatori di contenuti di capire quali sistemi di IA attribuiscono correttamente il loro lavoro e quali richiedono intervento. Per le organizzazioni che vogliono davvero proteggere la propria proprietà intellettuale visiva e comprendere l’influenza dei propri contenuti nell’ecosistema informativo guidato dall’IA, l’implementazione di una soluzione dedicata come AmICited.com è diventata essenziale: trasforma il monitoraggio delle citazioni da osservazione passiva a pratica di gestione attiva che porta a risultati di attribuzione migliori.

Gli attuali modelli di IA hanno capacità diverse quando si tratta di citare contenuti visivi. Mentre modelli avanzati come Claude e Perplexity possono fare riferimento ai grafici con ragionevole precisione, molti sistemi hanno difficoltà con una corretta attribuzione. La maggior parte dei LLM è stata addestrata principalmente su dati testuali, rendendo la citazione visiva meno affidabile rispetto a quella testuale. Ecco perché strumenti di monitoraggio come AmICited sono essenziali per tracciare come vengono effettivamente citate le tue visualizzazioni.

AmICited.com offre un monitoraggio completo dei contenuti visivi su diverse piattaforme di IA tra cui ChatGPT, Claude, Perplexity e Google AI Overviews. La piattaforma utilizza il fingerprinting visivo automatico e l'analisi dei metadati per identificare quando i tuoi grafici appaiono nei contenuti generati dall'IA, fornendo avvisi in tempo reale e analisi dettagliate sulla precisione e la frequenza delle citazioni.

I sistemi di IA citano i grafici con maggiore precisione quando questi presentano colori vivaci e ad alto contrasto, etichette chiare, titoli descrittivi e alt-text completo. L'inclusione di markup di dati strutturati, l'attribuzione della fonte all'interno della visualizzazione e legende ben organizzate migliorano notevolmente l'elaborazione e la probabilità di citazione da parte dell'IA. Creare più versioni delle visualizzazioni complesse—semplificate per l'IA e dettagliate per gli umani—migliora anche la reperibilità.

In base alle capacità attuali, Claude 3 e Perplexity AI mostrano la massima precisione nell'attribuzione dei contenuti visivi, con tassi di accuratezza delle citazioni dell'80-90%. Google AI Overviews e Gemini Pro Vision si comportano moderatamente bene con una precisione del 75-80%, mentre GPT-4V di ChatGPT, pur avendo capacità visive, spesso fornisce descrizioni generiche invece di citazioni precise. Queste capacità continuano ad evolversi con l'aggiornamento dei modelli.

Il monitoraggio delle citazioni visive è fondamentale per la visibilità del marchio, la valutazione del valore dei contenuti e la protezione della proprietà intellettuale. Quando i tuoi grafici vengono correttamente citati dai sistemi di IA, aumenta la visibilità del tuo brand nei contenuti generati dall'IA, conferma l'influenza dei tuoi contenuti e ti aiuta a capire come il tuo lavoro influenza la sintesi delle informazioni guidata dall'IA. Senza monitoraggio, perdi visibilità sulla portata e l'impatto dei tuoi contenuti.

AmICited è specializzato nel monitorare le citazioni dei contenuti visivi su più piattaforme di IA, offrendo dashboard dettagliate che mostrano quando e come i tuoi grafici vengono citati. La piattaforma offre avvisi in tempo reale, metriche sull'accuratezza delle citazioni, analisi specifiche per piattaforma e suggerimenti praticabili per migliorare la reperibilità dei contenuti visivi. Trasforma il monitoraggio delle citazioni da osservazione passiva a gestione attiva della tua proprietà intellettuale visiva.

Le citazioni testuali nei sistemi di IA sono generalmente più affidabili perché i LLM sono stati addestrati principalmente su dati testuali. Le citazioni visive richiedono passaggi aggiuntivi: l'IA deve prima convertire gli elementi visivi in descrizioni testuali, spesso perdendo sfumature e valori precisi. Questo processo di conversione introduce maggiori possibilità di errore, rendendo le citazioni visive meno accurate e coerenti rispetto a quelle testuali tra le diverse piattaforme IA.

Assolutamente. Implementa le migliori pratiche come l'uso di colori vivaci e ad alto contrasto, la creazione di titoli e alt-text descrittivi, l'inserimento di markup di dati strutturati e l'attribuzione della fonte direttamente nelle visualizzazioni. Evita gradienti sottili, elementi sovrapposti e legende ambigue. Considera la creazione di versioni semplificate dei grafici complessi specificamente per l'elaborazione da parte dell'IA. Questi miglioramenti rendono le tue visualizzazioni più facilmente reperibili e citabili dai sistemi di IA.

Tieni traccia di come i sistemi di IA citano i tuoi grafici e le tue visualizzazioni su ChatGPT, Claude, Perplexity e Google AI. Ricevi avvisi in tempo reale e analisi dettagliate sull'attribuzione dei contenuti visivi.

Scopri come identificare e colmare le lacune di visibilità dei contenuti AI su ChatGPT, Perplexity e Google AI Overviews. Scopri metodi di analisi e strumenti p...

Scopri come le visualizzazioni dei dati migliorano la visibilità nella ricerca AI, aiutano le LLM a comprendere i contenuti e aumentano le citazioni nelle rispo...

Guida completa per le agenzie di marketing per comprendere, implementare e offrire servizi di visibilità AI ai clienti. Scopri strategie di monitoraggio, strume...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.