Prevenire le crisi di visibilità AI: Strategie proattive

Scopri come prevenire le crisi di visibilità AI con monitoraggio proattivo, sistemi di allerta precoce e protocolli di risposta strategici. Proteggi il tuo marc...

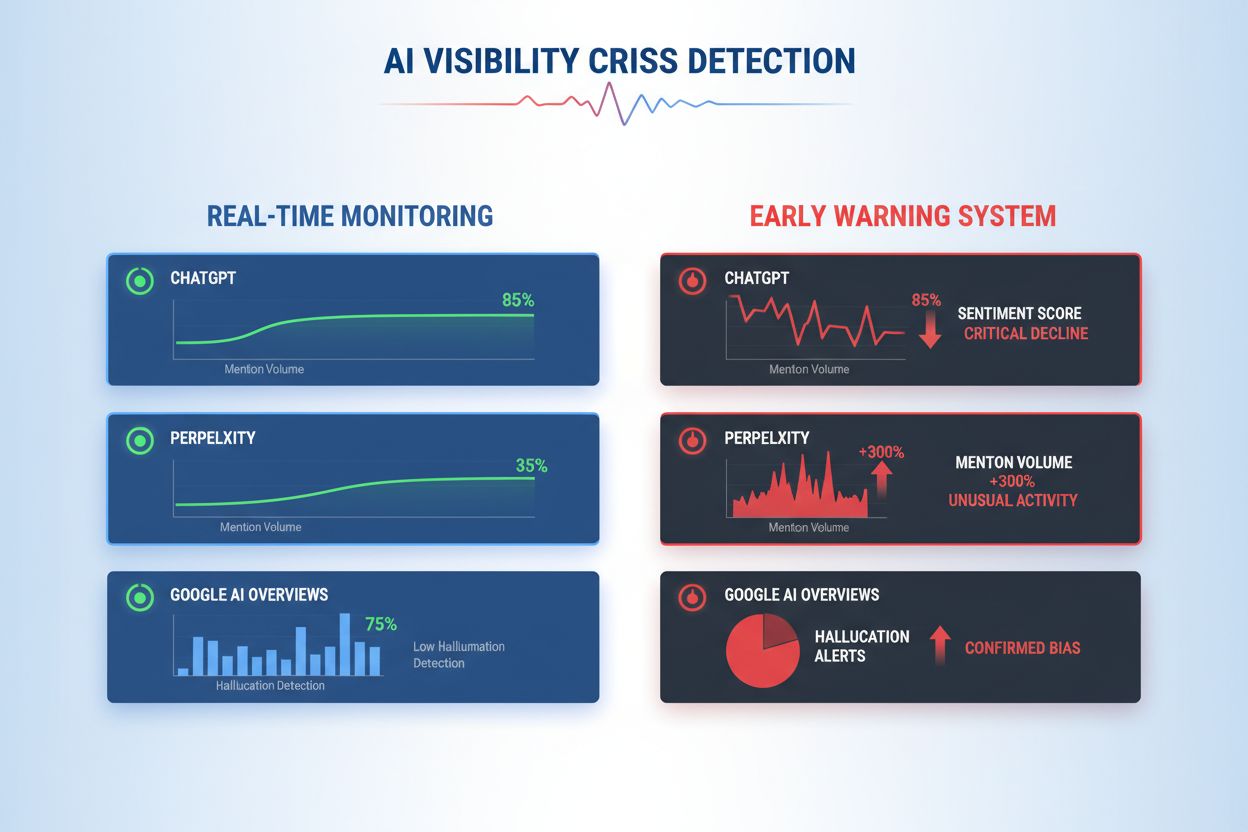

Impara a rilevare precocemente le crisi di visibilità AI con monitoraggio in tempo reale, analisi del sentiment e rilevamento delle anomalie. Scopri i segnali di allarme e le migliori pratiche per proteggere la reputazione del tuo brand nelle ricerche AI.

Una crisi di visibilità AI si verifica quando i sistemi di intelligenza artificiale producono output imprecisi, fuorvianti o dannosi che danneggiano la reputazione del brand ed erodono la fiducia del pubblico. A differenza delle crisi PR tradizionali che derivano da decisioni o azioni umane, le crisi di visibilità AI emergono dall’intersezione tra la qualità dei dati di addestramento, il bias algoritmico e la generazione di contenuti in tempo reale—rendendole fondamentalmente più difficili da prevedere e controllare. Ricerche recenti indicano che il 61% dei consumatori ha ridotto la fiducia nei brand dopo aver incontrato allucinazioni AI o risposte AI false, mentre il 73% ritiene che le aziende dovrebbero essere ritenute responsabili per ciò che i loro sistemi AI dichiarano pubblicamente. Queste crisi si diffondono più rapidamente rispetto alla disinformazione tradizionale perché appaiono autorevoli, provengono da canali di brand affidabili e possono influenzare migliaia di utenti contemporaneamente prima che sia possibile un intervento umano.

Il rilevamento efficace delle crisi di visibilità AI richiede il monitoraggio sia degli input (dati, conversazioni e materiali di addestramento che alimentano i tuoi sistemi AI) sia degli output (ciò che la tua AI effettivamente dice ai clienti). Il monitoraggio degli input esamina i dati di social listening, il feedback dei clienti, i dataset di addestramento e le fonti esterne per individuare bias, disinformazione o pattern problematici che potrebbero contaminare le risposte AI. Il monitoraggio degli output traccia ciò che i sistemi AI generano realmente—risposte, raccomandazioni e contenuti prodotti in tempo reale. Quando il chatbot di una grande compagnia di servizi finanziari ha iniziato a raccomandare investimenti in criptovalute basandosi su dati di addestramento distorti, la crisi si è diffusa sui social media in poche ore, influenzando il prezzo delle azioni e attirando l’attenzione dei regolatori. Allo stesso modo, quando un sistema AI nel settore sanitario ha fornito informazioni mediche obsolete provenienti da dataset corrotti, ci sono voluti tre giorni per identificare la causa principale, durante i quali migliaia di utenti hanno ricevuto indicazioni potenzialmente dannose. Il divario tra la qualità degli input e l’accuratezza degli output crea un punto cieco dove le crisi possono incubare inosservate.

| Aspetto | Monitoraggio Input (Fonti) | Monitoraggio Output (Risposte AI) |

|---|---|---|

| Cosa traccia | Social media, blog, news, recensioni | Risposte ChatGPT, Perplexity, Google AI |

| Metodo di rilevamento | Tracciamento keyword, analisi del sentiment | Query prompt, analisi delle risposte |

| Indicatore di crisi | Post negativi virali, reclami in trend | Allucinazioni, raccomandazioni errate |

| Tempo di risposta | Ore o giorni | Minuti o ore |

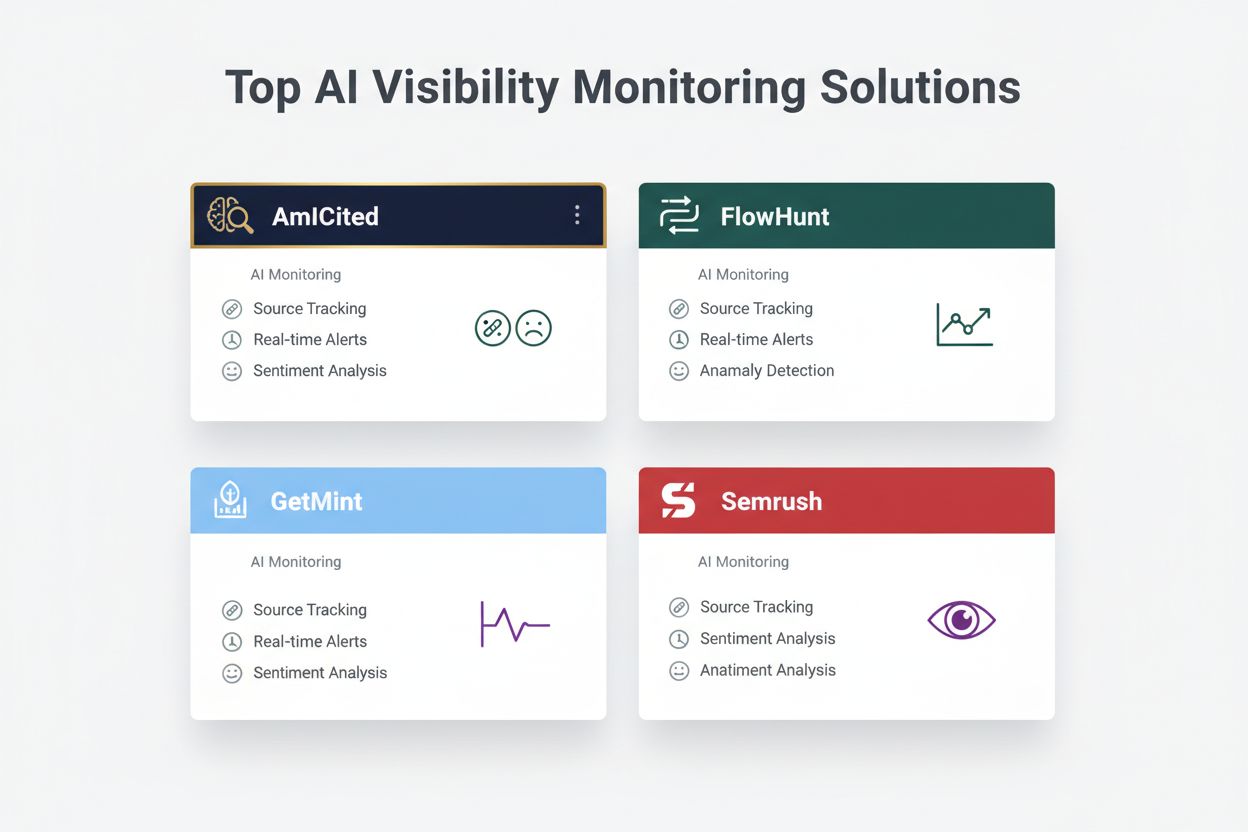

| Strumenti principali | Brandwatch, Mention, Sprout Social | AmICited, GetMint, Semrush |

| Fascia di costo | $500-$5.000/mese | $800-$3.000/mese |

Le organizzazioni dovrebbero predisporre un monitoraggio continuo di questi segnali di allarme precoce specifici che indicano una crisi di visibilità AI emergente:

Il moderno rilevamento delle crisi di visibilità AI si basa su fondamenti tecnici sofisticati che combinano natural language processing (NLP), algoritmi di machine learning e rilevamento delle anomalie in tempo reale. I sistemi NLP analizzano il significato semantico e il contesto degli output AI, non solo il matching di keyword, permettendo di individuare disinformazione sottile che gli strumenti tradizionali non rilevano. Gli algoritmi di analisi del sentiment processano migliaia di menzioni social, recensioni clienti e ticket di supporto simultaneamente, calcolando punteggi di sentiment e identificando cambiamenti di intensità emotiva che segnalano crisi emergenti. I modelli di machine learning stabiliscono pattern di comportamento AI normali, poi segnalano deviazioni che eccedono soglie statistiche—ad esempio, rilevando quando l’accuratezza delle risposte scende dal 94% al 78% su uno specifico tema. Le capacità di processamento in tempo reale consentono alle organizzazioni di identificare e rispondere alle crisi in pochi minuti anziché ore, aspetto critico quando gli output AI raggiungono migliaia di utenti istantaneamente. I sistemi avanzati impiegano metodi ensemble che combinano più algoritmi di rilevamento, riducendo i falsi positivi pur mantenendo la sensibilità alle minacce reali, e integrano cicli di feedback dove revisori umani migliorano continuamente l’accuratezza del modello.

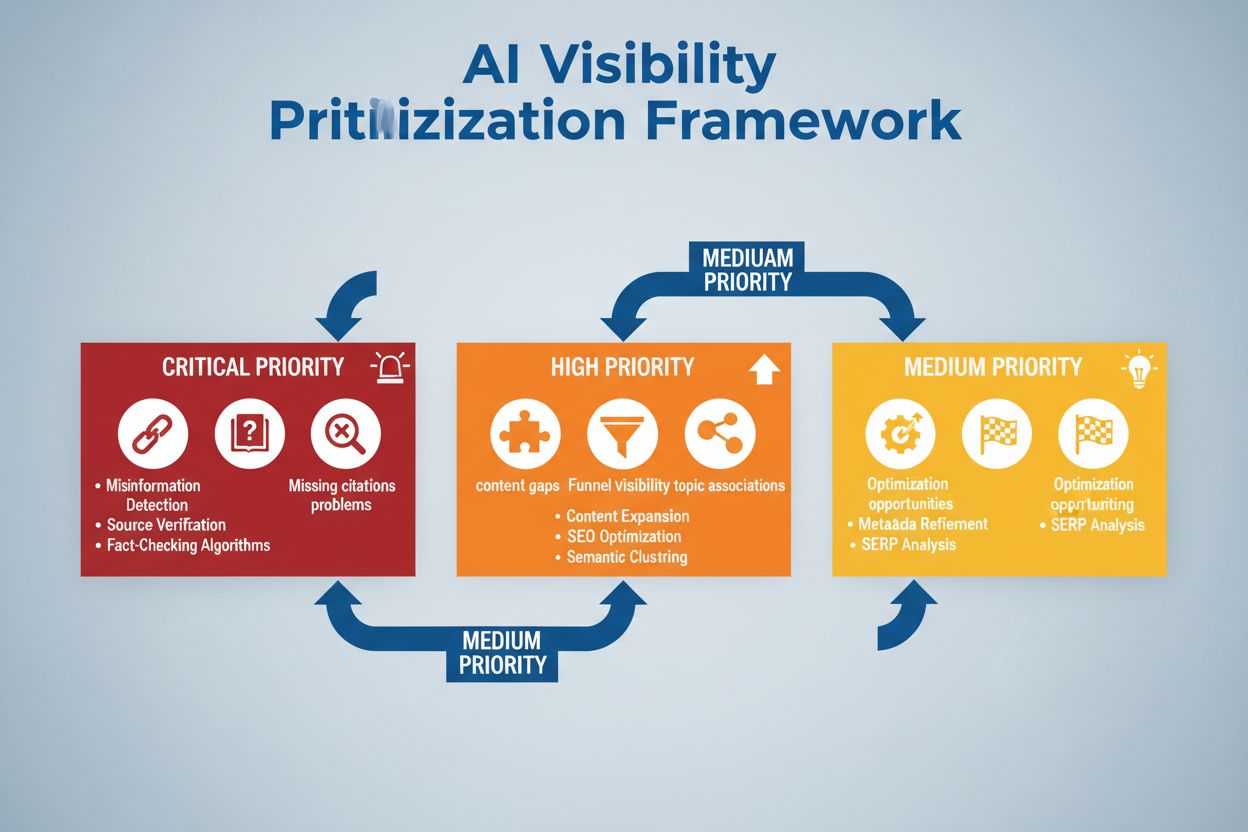

Implementare un rilevamento efficace richiede di definire soglie di sentiment e punti di attivazione specifici adattati alla tolleranza al rischio e agli standard di settore della propria organizzazione. Una compagnia finanziaria può impostare una soglia secondo cui ogni raccomandazione di investimento AI che riceve oltre 50 menzioni negative in 4 ore attiva una revisione umana immediata e potenziale spegnimento del sistema. Le organizzazioni sanitarie dovrebbero adottare soglie più basse—magari 10-15 menzioni negative sull’accuratezza medica—dato il rischio più alto della disinformazione sulla salute. I workflow di escalation dovrebbero specificare chi viene avvisato a ogni livello di gravità: un calo dell’accuratezza del 20% può attivare la notifica al team lead, mentre un calo del 40% fa scattare l’escalation immediata al crisis management e ai legali. L’implementazione pratica prevede la definizione di template di risposta per scenari comuni (es. “Il sistema AI ha fornito informazioni obsolete a causa di un problema nei dati di addestramento”), l’istituzione di protocolli di comunicazione con clienti e regolatori e la creazione di decision tree che guidano i responder attraverso triage e remediation. Le organizzazioni dovrebbero anche fissare framework di misurazione che tracciano velocità di rilevamento (tempo tra l’emergere della crisi e l’identificazione), tempo di risposta (identificazione-mitigazione) ed efficacia (percentuale di crisi rilevate prima di un impatto utente significativo).

Il rilevamento delle anomalie costituisce la base tecnica dell’identificazione proattiva delle crisi, lavorando sulla definizione di baseline comportamentali normali e segnalando deviazioni significative. Le organizzazioni stabiliscono innanzitutto metriche di baseline su più dimensioni: tassi di accuratezza tipici per diverse funzioni AI (es. 92% per raccomandazioni prodotto, 87% per risposte customer service), latenze di risposta normali (es. 200-400ms), distribuzione attesa del sentiment (es. 70% positivo, 20% neutro, 10% negativo) e pattern standard di engagement degli utenti. Gli algoritmi di rilevamento delle deviazioni confrontano costantemente le performance in tempo reale con queste baseline, usando metodi statistici come l’analisi z-score (segnalando valori oltre 2-3 deviazioni standard dalla media) o isolation forest (identificando pattern outlier in dati multidimensionali). Ad esempio, se un motore di raccomandazione normalmente produce il 5% di falsi positivi ma improvvisamente sale al 18%, il sistema avvisa immediatamente gli analisti per indagare su possibili corruzioni nei dati di addestramento o drift del modello. Anomalie contestuali sono importanti quanto quelle statistiche—un sistema AI può mantenere metriche di accuratezza normali pur producendo output che violano requisiti di compliance o linee guida etiche, richiedendo regole di rilevamento specifiche oltre l’analisi statistica pura. Un rilevamento efficace delle anomalie richiede ricalibrazione regolare delle baseline (settimanale o mensile) per considerare pattern stagionali, modifiche di prodotto ed evoluzione del comportamento utente.

Un monitoraggio completo combina social listening, analisi degli output AI e aggregazione dati in sistemi di visibilità unificati che prevengono punti ciechi. Gli strumenti di social listening tracciano le menzioni del brand, prodotti e funzioni AI su social, news, forum e piattaforme di recensioni, intercettando cambi di sentiment prima che si trasformino in crisi diffuse. Parallelamente, i sistemi di monitoraggio output AI registrano e analizzano ogni risposta generata dall’AI, controllando accuratezza, coerenza, compliance e sentiment in tempo reale. Le piattaforme di aggregazione dati normalizzano questi flussi eterogenei—convertendo punteggi di sentiment social, metriche di accuratezza, reclami utenti e dati di performance di sistema in formati confrontabili—permettendo agli analisti di vedere correlazioni che il monitoraggio isolato non rivelerebbe. Una dashboard unificata mostra metriche chiave: trend attuali del sentiment, tassi di accuratezza per funzione, volume reclami utenti, performance di sistema e alert di anomalia, tutto aggiornato in tempo reale con contesto storico. L’integrazione con i tool esistenti (CRM, support, dashboard analytics) garantisce che i segnali di crisi raggiungano automaticamente i decisori, senza necessità di compilazione manuale dei dati. Le organizzazioni che adottano questo approccio riportano una rilevazione delle crisi più rapida del 60-70% rispetto al monitoraggio manuale e un netto miglioramento della coordinazione della risposta tra i team.

Un rilevamento efficace delle crisi deve collegarsi direttamente all’azione tramite framework decisionali e procedure di risposta strutturate che trasformano gli alert in risposte coordinate. I decision tree guidano i responder nel triage: è un falso positivo o una crisi reale? Qual è lo scope (10 utenti o 10.000)? Qual è la gravità (imprecisione minore o violazione regolatoria)? Qual è la causa principale (dati di addestramento, algoritmo, problema di integrazione)? In base a queste risposte, il sistema indirizza la crisi ai team appropriati e attiva template di risposta predefiniti che specificano linguaggio comunicativo, referenti per escalation e step di remediation. Per una crisi di allucinazione, il template può includere: pausa immediata del sistema AI, linguaggio per notifica ai clienti, protocollo di indagine della causa e tempistica per il ripristino. Le procedure di escalation definiscono handoff chiari: il rilevamento iniziale attiva la notifica al team lead, le crisi confermate passano al crisis management, le violazioni regolatorie coinvolgono immediatamente legali e compliance. L’efficacia della risposta va misurata con metriche come mean time to detection (MTTD), mean time to resolution (MTTR), percentuale di crisi contenute prima di raggiungere i media e impatto clienti (utenti coinvolti prima della mitigazione). Revisioni post-crisi individuano lacune di rilevamento o risposta, alimentando miglioramenti nei sistemi di monitoraggio e nei framework decisionali.

Nel valutare le soluzioni per il rilevamento delle crisi di visibilità AI, diverse piattaforme si distinguono per capacità specialistiche e posizionamento sul mercato. AmICited.com si colloca come soluzione di fascia alta, offrendo monitoraggio output AI specializzato con verifica di accuratezza in tempo reale, rilevamento allucinazioni e controllo compliance su più piattaforme AI; i prezzi partono da $2.500/mese per deployment enterprise con integrazioni personalizzate. FlowHunt.io è anch’essa tra le soluzioni top, fornendo social listening completo combinato ad analisi sentiment AI, rilevamento anomalie e workflow di escalation automatizzati; il prezzo parte da $1.800/mese con scalabilità flessibile. GetMint propone un monitoraggio focalizzato sul mid-market che combina social listening con tracking base degli output AI, a partire da $800/mese ma con funzionalità di rilevamento anomalie più limitate. Semrush offre brand monitoring più ampio con moduli AI-specifici integrati alla piattaforma di social listening, a partire da $1.200/mese ma richiedendo configurazione extra per il rilevamento AI. Brandwatch fornisce social listening enterprise con monitoraggio AI personalizzabile, da $3.000/mese ma con le opzioni di integrazione più estese verso i sistemi enterprise esistenti. Per le organizzazioni che danno priorità al rilevamento crisi AI specializzato, AmICited.com e FlowHunt.io offrono la migliore accuratezza e tempi di rilevamento più rapidi, mentre Semrush e Brandwatch sono più indicati per chi cerca brand monitoring ampio con componenti AI.

Le organizzazioni che implementano il rilevamento delle crisi di visibilità AI dovrebbero adottare queste best practice operative: attivare monitoraggio continuo sia sugli input che sugli output AI, evitando di affidarsi solo ad audit periodici, così da individuare le crisi in pochi minuti invece che giorni. Investire nella formazione del team affinché customer service, prodotto e crisis management comprendano i rischi AI e riconoscano i segnali di allarme nelle interazioni con i clienti e nei feedback social. Condurre audit regolari (almeno trimestrali) sulla qualità dei dati di addestramento, sulle performance dei modelli e sull’accuratezza dei sistemi di rilevamento, identificando e correggendo vulnerabilità prima che diventino crisi. Mantenere documentazione dettagliata di tutti i sistemi AI, fonti dati di addestramento, limiti noti e incidenti precedenti, per consentire un’analisi rapida delle cause in caso di crisi. Infine, integrare il monitoraggio della visibilità AI direttamente nel framework di crisis management, garantendo che gli alert AI attivino le stesse procedure di risposta rapida delle crisi PR tradizionali, con percorsi di escalation chiari e decisori pre-autorizzati. Le organizzazioni che trattano la visibilità AI come una preoccupazione operativa continua anziché un rischio occasionale registrano il 75% in meno di impatti clienti correlati alle crisi e tempi di recupero 3 volte più rapidi quando gli incidenti si verificano.

Una crisi di visibilità AI si verifica quando modelli AI come ChatGPT, Perplexity o Google AI Overviews forniscono informazioni inesatte, negative o fuorvianti sul tuo brand. A differenza delle crisi tradizionali sui social media, queste possono diffondersi rapidamente attraverso i sistemi AI e raggiungere milioni di utenti senza comparire nei risultati di ricerca tradizionali o nei feed dei social.

Il social listening traccia ciò che le persone dicono sul tuo marchio sui social media e sul web. Il monitoraggio della visibilità AI traccia ciò che i modelli AI dicono effettivamente sul tuo brand quando rispondono alle domande degli utenti. Entrambi sono importanti perché le conversazioni social alimentano i dati di addestramento AI, ma la risposta finale dell'AI è ciò che la maggior parte degli utenti vede.

I segnali chiave includono improvvisi cali nel sentiment positivo, picchi nel volume di menzioni provenienti da fonti a bassa autorità, modelli AI che raccomandano concorrenti, allucinazioni sui tuoi prodotti e sentiment negativo in fonti ad alta autorità come testate giornalistiche o Reddit.

Le crisi di visibilità AI possono svilupparsi rapidamente. Un post virale sui social può raggiungere milioni di persone in poche ore e, se contiene disinformazione, può influenzare i dati di addestramento AI e apparire nelle risposte AI nel giro di giorni o settimane, a seconda del ciclo di aggiornamento del modello.

È necessaria una strategia a due livelli: strumenti di social listening (come Brandwatch o Mention) per monitorare le fonti che alimentano i modelli AI, e strumenti di monitoraggio AI (come AmICited o GetMint) per tracciare ciò che i modelli AI dicono effettivamente. Le migliori soluzioni combinano entrambe le capacità.

Per prima cosa, identifica la causa principale tramite il tracciamento delle fonti. Poi pubblica contenuti autorevoli che contraddicano la disinformazione. Infine, monitora le risposte AI per verificare che la correzione abbia funzionato. Questo richiede competenze sia nella gestione delle crisi sia nell’ottimizzazione dei contenuti.

Non puoi prevenire tutte le crisi, ma il monitoraggio proattivo e una risposta rapida ne riducono significativamente l’impatto. Intervenendo tempestivamente e affrontando le cause principali, puoi impedire che i problemi minori diventino gravi danni reputazionali.

Monitora le tendenze del sentiment, il volume delle menzioni, la share of voice nelle risposte AI, la frequenza delle allucinazioni, la qualità delle fonti, i tempi di risposta e l’impatto sui clienti. Queste metriche aiutano a comprendere la gravità della crisi e misurare l’efficacia della risposta.

Rileva le crisi di visibilità AI prima che danneggino la tua reputazione. Ottieni segnali di allarme precoce e proteggi il tuo brand su ChatGPT, Perplexity e Google AI Overviews.

Scopri come prevenire le crisi di visibilità AI con monitoraggio proattivo, sistemi di allerta precoce e protocolli di risposta strategici. Proteggi il tuo marc...

Esplora il futuro del monitoraggio della visibilità nell’AI, dagli standard di trasparenza alla conformità normativa. Scopri come i brand possono prepararsi al ...

Scopri come dare priorità strategicamente ai problemi di visibilità AI. Scopri il framework per identificare problemi critici, ad alta e media priorità nella tu...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.