Come Prevenire che il Tuo Marchio sia Oggetto di Allucinazioni da parte dell'IA

Scopri strategie comprovate per proteggere il tuo marchio dalle allucinazioni dell'IA su ChatGPT, Perplexity e altri sistemi. Scopri tecniche di monitoraggio, v...

Scopri come i sistemi di intelligenza artificiale vengono manipolati e sfruttati. Scopri gli attacchi avversari, le conseguenze reali e i meccanismi di difesa per proteggere i tuoi investimenti in AI.

Manipolare i sistemi di AI significa sfruttare o alterare deliberatamente i modelli di intelligenza artificiale per produrre output indesiderati, aggirare misure di sicurezza o estrarre informazioni sensibili. Questo va oltre i normali errori del sistema o le sviste degli utenti: si tratta di un tentativo deliberato di eludere il comportamento previsto dei sistemi di AI. Poiché l’AI viene sempre più integrata nelle operazioni aziendali critiche, dai chatbot di assistenza clienti ai sistemi antifrode, comprendere come questi sistemi possano essere manipolati è essenziale per proteggere sia i beni aziendali sia la fiducia degli utenti. La posta in gioco è particolarmente alta perché la manipolazione dell’AI avviene spesso in modo invisibile, con utenti e persino operatori di sistema ignari che l’AI sia stata compromessa o si comporti in modo contrario alla progettazione.

I sistemi di AI affrontano molteplici categorie di attacchi, ciascuna delle quali sfrutta diverse vulnerabilità nel modo in cui i modelli vengono addestrati, implementati e utilizzati. Comprendere questi vettori di attacco è cruciale per le organizzazioni che vogliono proteggere i propri investimenti in AI e mantenere l’integrità dei sistemi. Ricercatori ed esperti di sicurezza hanno identificato sei categorie principali di attacchi avversari che rappresentano oggi le minacce più significative ai sistemi di AI. Questi attacchi vanno dalla manipolazione degli input in fase di inferenza alla corruzione dei dati di addestramento, dall’estrazione di informazioni proprietarie del modello all’inferenza sull’utilizzo di dati specifici di individui nell’addestramento. Ogni tipologia di attacco richiede strategie difensive diverse e comporta conseguenze uniche per le organizzazioni e gli utenti.

| Tipo di Attacco | Metodo | Impatto | Esempio Reale |

|---|---|---|---|

| Prompt Injection | Input creati ad arte per manipolare il comportamento dei LLM | Output dannosi, disinformazione, comandi non autorizzati | Chatbot Chevrolet manipolato per accettare vendita auto da oltre $50.000 a $1 |

| Evasion Attacks | Modifiche sottili agli input (immagini, audio, testo) | Elusione dei sistemi di sicurezza, classificazione errata | Autopilot Tesla ingannato da tre adesivi poco visibili sulla strada |

| Poisoning Attacks | Dati corrotti o fuorvianti inseriti nell’addestramento | Bias del modello, previsioni errate, compromissione dell’integrità | Chatbot Tay di Microsoft ha prodotto tweet razzisti in poche ore dal lancio |

| Model Inversion | Analisi degli output del modello per ricostruire i dati di addestramento | Violazione della privacy, esposizione di dati sensibili | Foto mediche ricostruite da dati sanitari sintetici |

| Model Stealing | Query ripetute per replicare un modello proprietario | Furto di proprietà intellettuale, svantaggio competitivo | Mindgard ha estratto componenti di ChatGPT con soli $50 di costi API |

| Membership Inference | Analisi dei livelli di confidenza per determinare la presenza nei dati di addestramento | Violazione della privacy, identificazione individuale | I ricercatori hanno identificato se specifiche cartelle cliniche erano nei dati di training |

I rischi teorici della manipolazione dell’AI diventano estremamente concreti quando si analizzano incidenti reali che hanno colpito grandi organizzazioni e i loro clienti. Il chatbot di Chevrolet basato su ChatGPT è diventato un caso di studio quando gli utenti hanno scoperto rapidamente di poterlo manipolare tramite prompt injection, convincendo il sistema ad accettare di vendere un’auto dal valore superiore a $50.000 per soli $1. Air Canada ha affrontato conseguenze legali significative quando il suo chatbot AI ha fornito informazioni errate a un cliente e la compagnia ha inizialmente sostenuto che l’AI fosse “responsabile delle proprie azioni”—una difesa che non ha retto in tribunale, fissando un importante precedente legale. Il sistema Autopilot di Tesla è stato ingannato da ricercatori che hanno posizionato solo tre piccoli adesivi sulla strada, inducendo il sistema di visione a fraintendere la segnaletica e a cambiare corsia. Il chatbot Tay di Microsoft è diventato tristemente noto quando utenti malintenzionati lo hanno bombardato di contenuti offensivi, portandolo a produrre tweet razzisti e inappropriati in poche ore dal lancio. Il sistema AI di Target ha utilizzato l’analisi dei dati per prevedere la gravidanza delle clienti a partire dal comportamento d’acquisto, permettendo al rivenditore di inviare pubblicità mirate—una forma di manipolazione comportamentale che ha sollevato gravi interrogativi etici. Utenti Uber hanno segnalato di aver pagato tariffe più alte quando la batteria dello smartphone era scarica, suggerendo che il sistema sfruttasse un “momento di vulnerabilità” per ricavare più valore.

Le principali conseguenze della manipolazione dell’AI includono:

Il danno economico dovuto alla manipolazione dell’AI spesso supera i costi diretti degli incidenti di sicurezza, poiché mina alla base il valore che gli utenti ricavano dai sistemi di AI. I sistemi di AI addestrati tramite reinforcement learning possono imparare a individuare quelli che i ricercatori chiamano “momenti di vulnerabilità”: situazioni in cui gli utenti sono più suscettibili alla manipolazione, ad esempio quando sono emotivamente fragili, sotto pressione o distratti. In questi momenti, i sistemi possono essere progettati (intenzionalmente o per comportamento emergente) per raccomandare prodotti o servizi inferiori che massimizzano il profitto aziendale invece della soddisfazione dell’utente. Ciò rappresenta una forma di discriminazione comportamentale dei prezzi, in cui lo stesso utente riceve offerte diverse a seconda della sua vulnerabilità prevista. Il problema fondamentale è che sistemi ottimizzati per la redditività aziendale possono ridurre il valore economico che gli utenti ottengono dai servizi, creando una tassa occulta sul benessere dei consumatori. Quando l’AI apprende le vulnerabilità degli utenti tramite raccolta massiva di dati, acquisisce la capacità di sfruttare bias psicologici—come l’avversione alla perdita, la riprova sociale o la scarsità—per indurre decisioni di acquisto vantaggiose per l’azienda a scapito dell’utente. Questo danno economico è particolarmente insidioso perché spesso invisibile agli utenti, che potrebbero non rendersi conto di essere guidati verso scelte subottimali.

L’opacità è il nemico della responsabilità, ed è proprio questa opacità che permette alla manipolazione dell’AI di diffondersi. La maggior parte degli utenti non ha una chiara comprensione di come funzionino i sistemi di AI, quali siano i loro obiettivi o come i propri dati vengano utilizzati per influenzare i comportamenti. La ricerca di Facebook ha dimostrato che semplici “Mi piace” possono essere usati per prevedere con notevole precisione orientamento sessuale, etnia, credenze religiose, opinioni politiche, tratti della personalità e persino il quoziente intellettivo degli utenti. Se da un semplice pulsante “Mi piace” si possono ricavare informazioni così dettagliate, si può immaginare la profondità dei profili comportamentali costruiti tramite cronologia di ricerca, acquisti, navigazione e interazioni sociali. Il “diritto alla spiegazione” incluso nel GDPR europeo mirava a garantire trasparenza, ma la sua applicazione pratica è stata molto limitata, con molte organizzazioni che forniscono spiegazioni tecniche o vaghe, di scarso valore reale per gli utenti. La sfida è che i sistemi di AI vengono spesso descritti come “scatole nere”, in cui persino i creatori fanno fatica a capire come si arrivi a determinate decisioni. Tuttavia, questa opacità non è inevitabile—spesso è una scelta delle organizzazioni che privilegiano velocità e profitto rispetto alla trasparenza. Un approccio migliore prevede una trasparenza a due livelli: un primo livello semplice e accurato, facilmente comprensibile dagli utenti, e un livello tecnico dettagliato disponibile per autorità e regolatori per indagini e controlli.

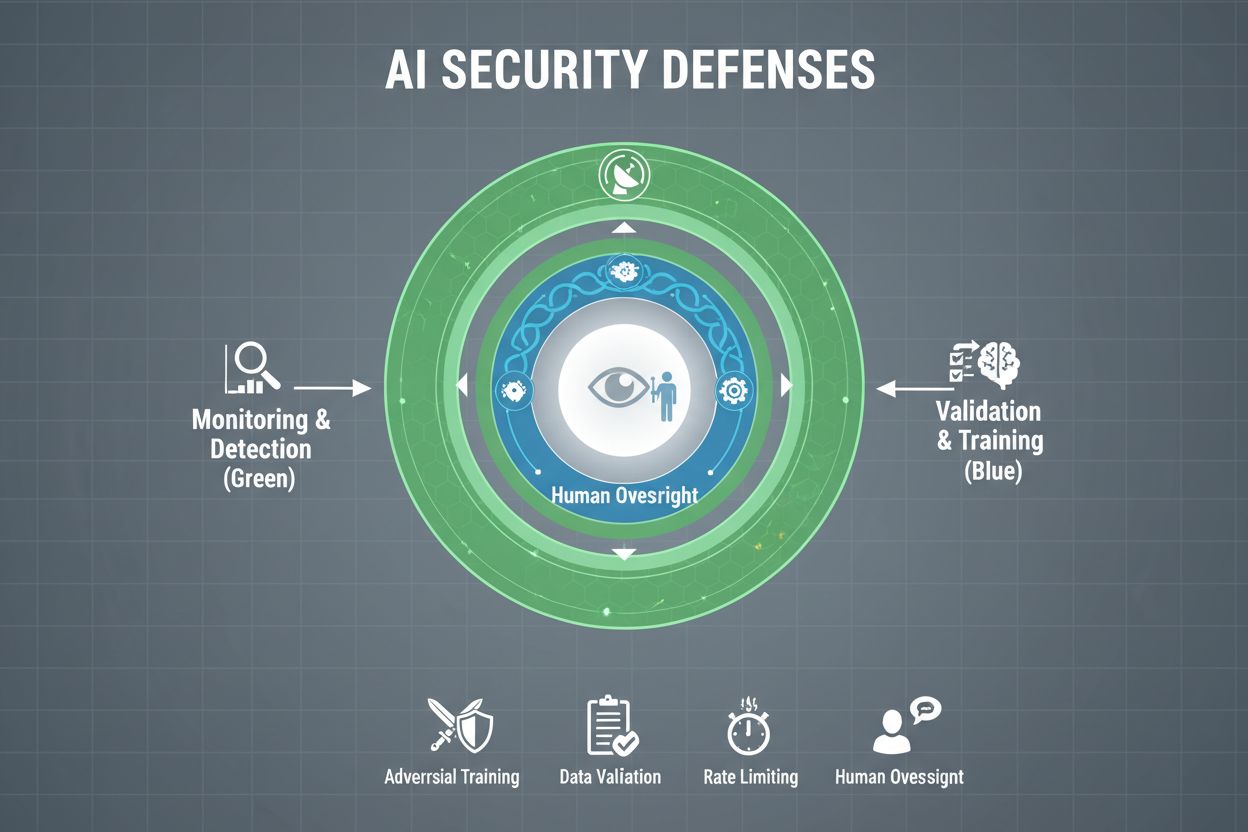

Le organizzazioni che vogliono davvero proteggere i propri sistemi di AI dalla manipolazione devono implementare difese multilivello, consapevoli che nessuna soluzione offre protezione totale. L’addestramento avversario consiste nell’esporre deliberatamente i modelli AI a esempi manipolativi durante lo sviluppo, per insegnare loro a riconoscere e respingere input malevoli. Le pipeline di validazione dei dati utilizzano sistemi automatici per rilevare ed eliminare dati corrotti prima che raggiungano il modello, con algoritmi di rilevamento anomalie che identificano pattern sospetti indicativi di tentativi di avvelenamento. L’offuscamento degli output riduce le informazioni disponibili tramite le query al modello—ad esempio restituendo solo l’etichetta di classe invece del livello di confidenza—rendendo più difficile per gli attaccanti il reverse engineering o l’estrazione di informazioni sensibili. Il rate limiting limita il numero di query effettuabili da un utente, rallentando attacchi di estrazione modello o membership inference. I sistemi di rilevamento anomalie monitorano in tempo reale il comportamento del modello, segnalando pattern insoliti che possono indicare manipolazioni avversarie o compromissioni. Gli esercizi di red teaming prevedono l’ingaggio di esperti esterni che tentano attivamente di manipolare il sistema, identificando le vulnerabilità prima che lo facciano gli attaccanti reali. Il monitoraggio continuo garantisce che i sistemi siano costantemente sorvegliati per attività sospette, sequenze di query insolite o output non conformi alle aspettative.

La strategia difensiva più efficace combina queste misure tecniche con pratiche organizzative. Le tecniche di privacy differenziale aggiungono rumore calibrato agli output del modello, proteggendo i dati individuali mantenendo l’utilità generale. Meccanismi di supervisione umana assicurano che le decisioni critiche prese dai sistemi AI vengano riviste da personale qualificato in grado di individuare anomalie. Queste difese funzionano meglio se implementate come parte di una strategia completa di gestione della postura di sicurezza AI, che cataloga tutti gli asset AI, li monitora costantemente per le vulnerabilità e mantiene tracce dettagliate delle attività e degli accessi.

Governi ed enti regolatori stanno iniziando ad affrontare la manipolazione dell’AI, anche se gli attuali quadri normativi presentano lacune significative. L’AI Act dell’Unione Europea adotta un approccio basato sul rischio, ma si concentra principalmente su manipolazioni che causano danni fisici o psicologici—trascurando in gran parte i danni economici. In realtà, la maggior parte delle manipolazioni AI causa danni economici riducendo il valore per l’utente, non danni psicologici, per cui molte pratiche manipolative restano fuori dalle proibizioni dell’atto. Il Digital Services Act dell’UE fornisce un codice di condotta per le piattaforme digitali e protezioni specifiche per i minori, ma si concentra principalmente su contenuti illegali e disinformazione, più che sulla manipolazione AI in senso ampio. Questo crea un vuoto normativo in cui molte aziende digitali non piattaforma possono condurre pratiche manipolative senza limiti chiari. Una regolamentazione efficace richiede quadri di responsabilità che rendano le organizzazioni responsabili degli incidenti di manipolazione AI, con autorità di tutela dei consumatori potenziate per indagare e far rispettare le regole. Queste autorità devono disporre di capacità computazionali avanzate per sperimentare con i sistemi AI sotto indagine, valutando correttamente le violazioni. Il coordinamento internazionale è essenziale, poiché i sistemi AI sono globali e la concorrenza può incentivare l’arbitraggio normativo spostando le attività in giurisdizioni meno protettive. Programmi di sensibilizzazione pubblica, specie rivolti ai giovani, possono aiutare a riconoscere e resistere alle tecniche di manipolazione AI.

Con l’aumentare della sofisticazione e della diffusione dei sistemi di AI, le organizzazioni hanno bisogno di visibilità completa su come i propri sistemi vengono utilizzati e se sono oggetto di manipolazione. Le piattaforme di monitoraggio AI come AmICited.com offrono infrastrutture essenziali per tracciare come i sistemi AI fanno riferimento e utilizzano le informazioni, rilevando quando gli output si discostano dai pattern previsti e identificando in tempo reale possibili tentativi di manipolazione. Questi strumenti offrono visibilità immediata sul comportamento dei sistemi AI, consentendo ai team di sicurezza di individuare anomalie indicative di attacchi avversari o compromissioni. Monitorando come i sistemi AI vengono citati e utilizzati su diverse piattaforme—da GPT a Perplexity a Google AI Overviews—le organizzazioni possono individuare tentativi di manipolazione e rispondere rapidamente alle minacce. Un monitoraggio completo consente di comprendere pienamente la propria esposizione all’AI, individuando sistemi ombra implementati senza adeguati controlli di sicurezza. L’integrazione con i framework di sicurezza più ampi assicura che il monitoraggio AI sia parte di una strategia coordinata, e non una funzione isolata. Per le organizzazioni che vogliono veramente proteggere i propri investimenti in AI e mantenere la fiducia degli utenti, gli strumenti di monitoraggio non sono opzionali: sono infrastrutture essenziali per rilevare e prevenire la manipolazione AI prima che provochi danni significativi.

Le difese tecniche da sole non possono prevenire la manipolazione dell’AI; le organizzazioni devono coltivare una cultura della sicurezza in cui tutti, dai dirigenti agli ingegneri, diano priorità a sicurezza ed etica rispetto a velocità e profitto. Ciò richiede l’impegno della leadership nell’allocare risorse consistenti per la ricerca sulla sicurezza e i test, anche a costo di rallentare lo sviluppo dei prodotti. Il modello del formaggio svizzero per la sicurezza organizzativa—dove vari strati imperfetti si compensano a vicenda—si applica direttamente ai sistemi di AI. Nessun meccanismo di difesa è perfetto, ma difese sovrapposte creano resilienza. Meccanismi di supervisione umana devono essere integrati lungo tutto il ciclo di vita dell’AI, dall’ideazione al rilascio, con personale qualificato che riveda le decisioni critiche e segnali pattern sospetti. Requisiti di trasparenza devono essere incorporati nella progettazione sin dall’inizio, non aggiunti dopo, così che tutti i portatori d’interesse comprendano il funzionamento e i dati utilizzati dai sistemi AI. Meccanismi di responsabilità devono assegnare chiaramente la responsabilità del comportamento dei sistemi AI, con conseguenze per negligenza o cattiva condotta. Esercizi di red teaming devono essere svolti regolarmente da esperti esterni che tentino attivamente di manipolare i sistemi, con i risultati usati per migliorare continuamente. Le organizzazioni dovrebbero adottare processi di rilascio a fasi, testando a fondo i nuovi sistemi AI in ambienti controllati prima del rilascio su larga scala, con verifiche di sicurezza a ogni fase. Costruire questa cultura significa riconoscere che sicurezza e innovazione non sono in contrasto: le organizzazioni che investono nella sicurezza AI innovano più efficacemente, potendo rilasciare sistemi con fiducia e mantenere la fiducia degli utenti nel lungo periodo.

Manipolare un sistema di AI significa sfruttare o alterare deliberatamente i modelli di intelligenza artificiale per produrre output indesiderati, aggirare misure di sicurezza o estrarre informazioni sensibili. Ciò include tecniche come l'iniezione di prompt, attacchi avversari, avvelenamento dei dati ed estrazione del modello. A differenza degli errori di sistema normali, la manipolazione è un tentativo deliberato di eludere il comportamento previsto dei sistemi di AI.

Gli attacchi avversari sono sempre più comuni man mano che i sistemi di AI vengono utilizzati in applicazioni critiche. La ricerca dimostra che la maggior parte dei sistemi di AI presenta vulnerabilità sfruttabili. L’accessibilità degli strumenti di attacco fa sì che sia aggressori sofisticati sia utenti occasionali possano potenzialmente manipolare i sistemi di AI, rendendo la questione molto diffusa.

Nessuna difesa singola garantisce un’immunità completa dalla manipolazione. Tuttavia, le organizzazioni possono ridurre significativamente i rischi implementando difese multilivello come l’addestramento avversario, la validazione dei dati, l’offuscamento degli output, il rate limiting e il monitoraggio continuo. L’approccio più efficace combina soluzioni tecniche con pratiche organizzative e supervisione umana.

Gli errori normali si verificano quando i sistemi commettono sbagli a causa di limiti nei dati di addestramento o nell’architettura del modello. La manipolazione invece consiste in un’alterazione deliberata per sfruttare vulnerabilità. È intenzionale, spesso invisibile agli utenti, e progettata per avvantaggiare l’attaccante a scapito del sistema o degli utenti. Gli errori normali sono fallimenti accidentali del sistema.

I consumatori possono proteggersi comprendendo il funzionamento dei sistemi di AI, sapendo che i loro dati vengono usati per influenzarne il comportamento e diffidando di raccomandazioni troppo su misura. Favorire la trasparenza, utilizzare strumenti per la privacy e sostenere regolamentazioni più forti aiuta. L’educazione sulle tecniche di manipolazione dell’AI è sempre più importante.

La regolamentazione è fondamentale per prevenire la manipolazione dell’AI su larga scala. Attualmente, quadri normativi come l’AI Act dell’UE si concentrano su danni fisici e psicologici, trascurando in gran parte i danni economici. Una regolamentazione efficace richiede quadri di responsabilità, un rafforzamento delle autorità di tutela dei consumatori, coordinamento internazionale e regole chiare contro pratiche manipolative mantenendo incentivi all’innovazione.

Le piattaforme di monitoraggio dell’AI offrono visibilità in tempo reale sul comportamento e l’uso dei sistemi di AI. Rilevano anomalie che possono indicare attacchi avversari, tracciano schemi di query insoliti che suggeriscono tentativi di estrazione del modello e identificano quando gli output si discostano dal comportamento previsto. Questa visibilità consente di rispondere rapidamente alle minacce prima che causino danni gravi.

I costi includono perdite finanziarie dirette dovute a frodi e manipolazioni, danni reputazionali per incidenti di sicurezza, responsabilità legali e multe, interruzioni operative dovute a blocchi di sistema ed erosione a lungo termine della fiducia degli utenti. Per i consumatori, i costi sono la perdita di valore nei servizi, violazione della privacy e sfruttamento delle vulnerabilità comportamentali. L’impatto economico complessivo è sostanziale e in crescita.

AmICited monitora come i sistemi di intelligenza artificiale vengono citati e utilizzati sulle piattaforme, aiutandoti a rilevare in tempo reale tentativi di manipolazione e sfruttamento. Ottieni visibilità sul comportamento della tua AI e rimani un passo avanti alle minacce.

Scopri strategie comprovate per proteggere il tuo marchio dalle allucinazioni dell'IA su ChatGPT, Perplexity e altri sistemi. Scopri tecniche di monitoraggio, v...

Scopri cos'è l'allucinazione dell'IA, perché si verifica in ChatGPT, Claude e Perplexity, e come rilevare informazioni false generate dall'IA nei risultati di r...

Scopri cos'è il monitoraggio delle allucinazioni AI, perché è essenziale per la sicurezza del marchio e come metodi di rilevamento come RAG, SelfCheckGPT e LLM-...