Come Ottimizzare i Contenuti YMYL per i Motori di Ricerca AI | Amicited

Scopri come ottimizzare i tuoi contenuti Your Money or Your Life (YMYL) per motori di ricerca AI come ChatGPT, Perplexity e i Riassunti AI di Google. Padroneggi...

Scopri come le organizzazioni sanitarie possono ottimizzare i contenuti medici per la visibilità sui LLM, gestire i requisiti YMYL e monitorare le citazioni AI con la piattaforma di monitoraggio AmICited.com.

I contenuti Your Money or Your Life (YMYL) comprendono argomenti che influenzano direttamente il benessere degli utenti, inclusi salute, finanza, sicurezza e informazioni civiche—e la sanità si trova al vertice della gerarchia di controllo di Google. Dopo il core update di marzo 2024, il gigante della ricerca ha ridotto la visibilità dei contenuti di bassa qualità del 40%, segnalando una repressione senza precedenti contro le informazioni mediche inattendibili. Tuttavia, la sfida per le organizzazioni sanitarie è cambiata radicalmente: i contenuti devono ora essere visibili non solo ai motori di ricerca, ma anche ai Large Language Models (LLM) che sempre più spesso sono il primo punto di riferimento per chi cerca informazioni sulla salute. Con il 5% di tutte le ricerche Google di tipo sanitario e il 58% dei pazienti che ora utilizzano strumenti AI per informazioni sulla salute, i fornitori sanitari affrontano un gap critico di visibilità—i loro contenuti possono posizionarsi bene nella ricerca tradizionale ma restare invisibili ai sistemi AI consultati effettivamente dai pazienti. Questo doppio requisito di visibilità rappresenta una nuova frontiera nella strategia dei contenuti sanitari.

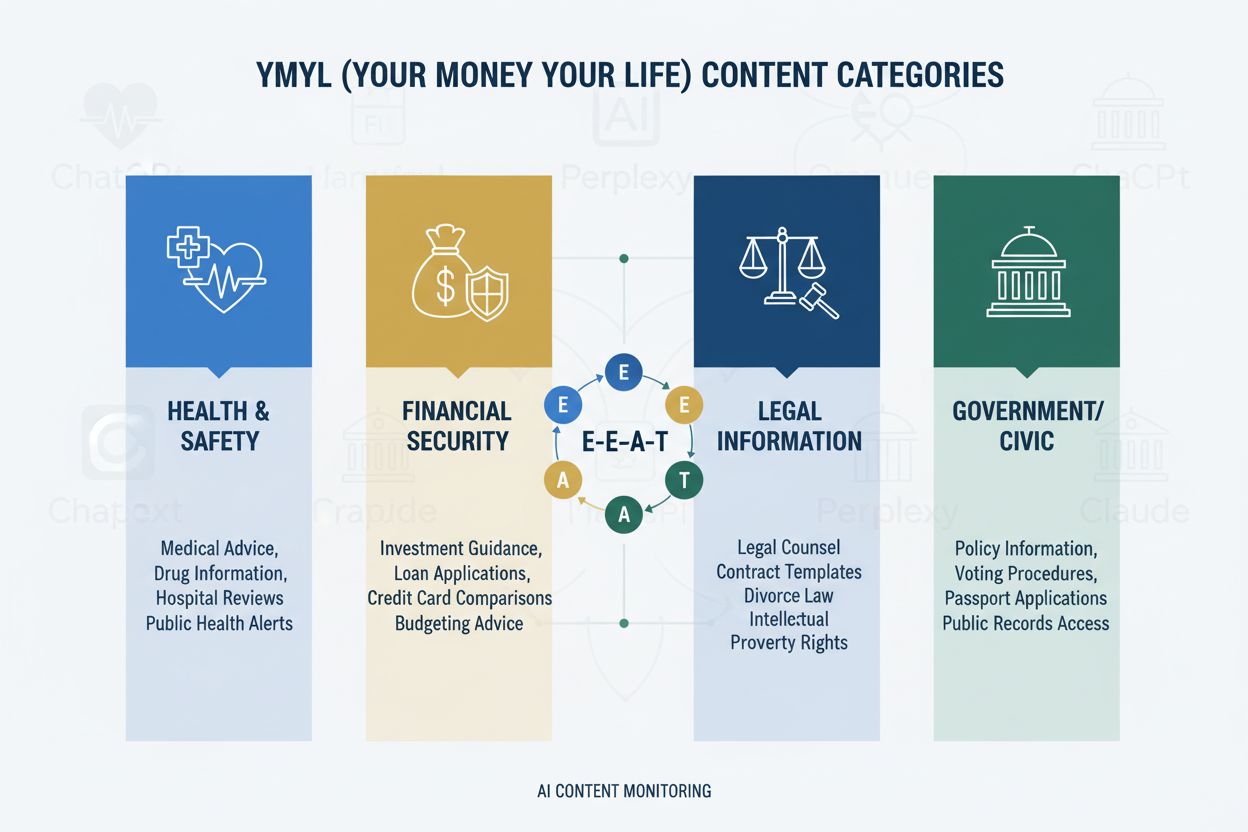

Il framework YMYL classifica i contenuti in quattro domini critici: Salute (condizioni mediche, trattamenti, benessere), Finanza (consulenza sugli investimenti, pianificazione finanziaria), Sicurezza (procedure di emergenza, sicurezza), e Civico (voto, questioni legali)—con la sanità sottoposta al livello massimo di controllo per il suo impatto diretto sul benessere umano. Il framework E-E-A-T di Google (Esperienza, Competenza, Autorevolezza, Affidabilità) serve come standard di valutazione, richiedendo ai contenuti sanitari di dimostrare reale conoscenza medica, credenziali professionali e accuratezza verificabile. Le Quality Rater Guidelines sottolineano esplicitamente che i contenuti sanitari devono essere creati o revisionati da professionisti medici qualificati, con credenziali dell’autore chiare e supporto istituzionale. Le organizzazioni sanitarie devono comprendere che E-E-A-T non è facoltativo—è il requisito fondamentale sia per la visibilità sui motori di ricerca che per l’inclusione nei LLM. Di seguito la gerarchia d’impatto delle categorie YMYL:

| Categoria YMYL | Livello d’Impatto | Intensità del Controllo | Rilevanza Sanitaria |

|---|---|---|---|

| Salute | Critico | Massima | Sicurezza diretta del paziente |

| Finanza | Alto | Alto | Assicurazioni, costi |

| Sicurezza | Alto | Alto | Protocolli d’emergenza |

| Civico | Medio | Medio | Politiche sanitarie |

Nonostante la loro sofisticazione, i LLM mostrano tassi di errore allarmanti nell’elaborazione delle informazioni mediche, con una ricerca Stanford HAI che documenta il 30-50% di affermazioni non supportate nelle risposte sanitarie. GPT-4 con Retrieval-Augmented Generation (RAG) produce ancora risposte in cui il 50% contiene affermazioni non supportate, anche se addestrato su fonti autorevoli—un fenomeno noto come allucinazione che può manifestarsi con la raccomandazione di dispositivi medici inesistenti, suggerimenti di protocolli di trattamento errati o interazioni farmacologiche inventate. Un caso esemplare ha coinvolto Men’s Journal che ha pubblicato un articolo generato dall’AI contenente 18 errori medici specifici, inclusi suggerimenti terapeutici pericolosi. Il problema di fondo è che l’AI manca di “Esperienza”—la conoscenza clinica di prima mano che distingue i medici esperti dai sistemi di pattern-matching statistici. Ciò significa che, senza contenuti strutturati e autorevoli da parte di professionisti medici verificati, i LLM genereranno con sicurezza indicazioni mediche plausibili ma potenzialmente pericolose.

AI Overviews e sistemi di risposta LLM simili stanno cambiando radicalmente il modo in cui i pazienti scoprono informazioni sulla salute, fornendo risposte dirette senza la necessità di visitare siti web, eliminando di fatto il tradizionale click-through che ha alimentato il traffico web sanitario per decenni. Ora la visibilità dei contenuti dipende dalla citazione all’interno delle risposte AI più che dalla posizione in classifica, il che significa che l’articolo di un fornitore sanitario potrebbe essere sintetizzato in una risposta AI senza mai ricevere traffico o attribuzione. I LLM sintetizzano informazioni da più fonti contemporaneamente, creando una nuova architettura informativa in cui i singoli siti competono per l’inclusione nei sommari AI piuttosto che per le prime posizioni di ricerca. I fornitori sanitari devono riconoscere che la Share of Model (SOM)—la percentuale di risposte AI che cita i propri contenuti—è diventata la metrica di visibilità critica, sostituendo i tradizionali tassi di click-through. Questo cambiamento di paradigma richiede di ripensare radicalmente la strategia di contenuto: invece di ottimizzare per i click, le organizzazioni sanitarie devono ottimizzare per qualità della citazione, accuratezza e chiarezza strutturale affinché i propri contenuti diventino la fonte preferita per la sintesi dei LLM.

I LLM elaborano i contenuti medici in modo più efficace se organizzati con una struttura gerarchica chiara che rispecchia il ragionamento clinico: definizione della condizione → presentazione dei sintomi → criteri diagnostici → opzioni di trattamento → prognosi. L’architettura a divulgazione progressiva—presentare concetti semplici prima di quelli complessi—consente ai LLM di costruire modelli mentali accurati senza confondere condizioni correlate ma distinte. Il design dei contenuti “question-first” (rispondere prima a “Cos’è la condizione X?” che a “Come si tratta?”) si allinea al modo in cui i LLM recuperano e sintetizzano informazioni su più documenti. Ricchezza semantica e concetti interconnessi—collegare esplicitamente condizioni, trattamenti e fattori di rischio correlati—aiuta i LLM a comprendere relazioni che altrimenti rimarrebbero implicite. L’implementazione del markup Schema.org medico (MedicalCondition, MedicalProcedure, MedicalTreatment) offre dati strutturati che i LLM possono interpretare e citare in modo affidabile. Un linguaggio naturale che imita la spiegazione esperta—usando terminologia da medico ma accessibile—trasmette autenticità sia ai LLM che ai lettori umani. Le organizzazioni sanitarie dovrebbero esaminare i contenuti esistenti rispetto a questi requisiti strutturali, poiché spesso quelli ottimizzati per la SEO tradizionale mancano di chiarezza gerarchica e ricchezza semantica necessarie ai LLM per una sintesi accurata.

La presenza su più piattaforme amplifica i segnali di autorità in modo che le strategie su singolo sito non possono ottenere, poiché i LLM riconoscono la competenza dimostrata in modo coerente su vari canali autorevoli. Le piattaforme di Q&A mediche come HealthTap e Figure 1 offrono interazione diretta medico-paziente che i LLM riconoscono come autorevolezza autentica, con credenziali verificate e coinvolgimento in tempo reale. Reti professionali tra cui Doximity e le community LinkedIn dedicate alla medicina stabiliscono riconoscimento tra pari e reputazione professionale, elementi che i LLM considerano fortemente nella valutazione dell’autorità. Contributi a Wikipedia medica e simili basi collaborative indicano volontà di contribuire al sapere pubblico senza motivazione commerciale, un segnale di affidabilità recepito dai LLM. Pagine complete di credibilità degli autori—con certificazioni, pubblicazioni, esperienza clinica e affiliazioni—devono essere presenti sul sito principale e collegate in modo coerente su tutte le piattaforme. Coerenza cross-platform nelle credenziali, specialità e prospettive rafforza l’autenticità; contraddizioni tra piattaforme generano scetticismo nei LLM. Le organizzazioni sanitarie dovrebbero sviluppare una strategia di autorità multipiattaforma che consideri ogni canale come rinforzo e non come entità separata, garantendo che l’expertise dei medici sia visibile e verificabile in tutto l’ecosistema digitale.

Le tradizionali analisi sanitarie—monitoraggio del traffico organico, tassi di click e ranking—non raccontano nulla sulla visibilità AI, creando un pericoloso punto cieco dove i contenuti appaiono “di successo” secondo le metriche classiche ma restano invisibili ai LLM. La Share of Model (SOM) emerge come nuova metrica critica, misurando quale percentuale di risposte AI su una determinata condizione cita i contenuti della tua organizzazione. Un monitoraggio efficace richiede test sistematici su più piattaforme LLM (ChatGPT, Claude, Perplexity e altri concorrenti emergenti) usando domande coerenti sulle proprie aree di specializzazione, documentando frequenza e posizionamento delle citazioni nelle risposte. La qualità della citazione conta quanto la frequenza—essere citati come fonte primaria pesa più che figurare in un elenco di riferimenti, e i LLM distinguono tra citazioni per expertise specifica e per informazioni generiche. Gli strumenti di monitoraggio variano dal testing manuale (eseguendo query e documentando i risultati) a piattaforme automatizzate che seguono l’andamento della SOM nel tempo e segnalano variazioni di visibilità. Indicatori indiretti come aumento delle ricerche di brand, feedback dei pazienti che menzionano consigli AI e pattern di referral dai sistemi AI offrono dati supplementari per validare le tendenze SOM. Le organizzazioni sanitarie dovrebbero stabilire misurazioni di base della SOM subito, dato che il contesto competitivo evolve rapidamente e i vantaggi di visibilità si accumulano nel tempo.

Le organizzazioni sanitarie dovrebbero iniziare da una singola area di specializzazione invece di tentare una trasformazione su larga scala, consentendo ai team di acquisire esperienza e affinare i processi prima di estendere l’approccio. Gli audit dei contenuti in ottica LLM richiedono di valutare gli articoli esistenti per chiarezza gerarchica, ricchezza semantica, architettura question-first e credibilità dell’autore—spesso rivelando che contenuti ben posizionati mancano della struttura necessaria ai LLM. I test di visibilità sulle piattaforme AI tramite domande specifiche di specialità stabiliscono la SOM di partenza e identificano quali condizioni e trattamenti sono visibili o invisibili. L’implementazione dell’architettura question-first comporta la ristrutturazione di contenuti esistenti o la creazione di nuovi che partono dalle domande del paziente (“Perché ho questo sintomo?”) prima delle spiegazioni cliniche. Le pagine di credibilità dell’autore vanno create per ogni medico collaboratore, includendo certificazioni, specialità, pubblicazioni, esperienza clinica e collegamenti coerenti da tutti i contenuti firmati. La creazione di cluster di contenuti attorno alle condizioni—coprendo sintomi, diagnosi, opzioni di trattamento e prognosi—aiuta i LLM a comprendere la condizione in modo completo anziché tramite articoli isolati. Questo approccio graduale permette di misurare l’impatto, ottimizzare la strategia e costruire competenze interne prima di estendersi ad altre specialità.

La conformità HIPAA resta fondamentale anche se i contenuti diventano visibili ai LLM; la tutela della privacy del paziente si applica sia che l’informazione sia accessibile da motori di ricerca che da sistemi AI, richiedendo un’attenta anonimizzazione e de-identificazione di eventuali casi clinici. Disclaimer medici e requisiti di accuratezza devono essere espliciti e ben visibili, con chiare indicazioni che le informazioni AI non sostituiscono la consulenza di un professionista e che le circostanze individuali possono differire dalle linee guida generali. Fact-checking e citazione delle fonti diventano elementi di conformità critici, poiché le organizzazioni sanitarie sono responsabili dell’accuratezza dei contenuti pubblicati, e i LLM amplificano gli errori su migliaia di interazioni. Il controllo normativo sui contenuti medici generati da AI è in aumento, con FDA e FTC sempre più attenti a come i sistemi AI presentano le informazioni; le organizzazioni sanitarie devono assicurare che tutti i contenuti—siano essi scritti da umani o assistiti da AI—soddisfino gli standard regolatori. La revisione medica umana da parte di medici qualificati deve restare obbligatoria per tutti i contenuti, con processi documentati di verifica a dimostrazione dell’impegno su accuratezza e sicurezza. Le considerazioni di responsabilità vanno oltre la malpractice tradizionale, includendo la possibile responsabilità per le informazioni che i LLM sintetizzano e presentano ai pazienti; le organizzazioni dovrebbero consultare consulenti legali sulla responsabilità rispetto all’uso dei propri contenuti nei sistemi AI. Conformità e sicurezza non possono essere trattate come aspetti secondari nella corsa alla visibilità AI.

L’AI continuerà a ridefinire la scoperta delle informazioni sanitarie a un ritmo crescente, con i LLM sempre più sofisticati nel ragionamento medico e sempre più centrali nel modo in cui i pazienti ricercano le condizioni di salute. Le organizzazioni sanitarie che adattano ora la propria strategia di contenuto si posizionano come fonti affidabili in questo nuovo ecosistema, mentre chi rimanda rischia di diventare invisibile ai sistemi AI effettivamente utilizzati dai pazienti. Chi adotta presto ottiene un vantaggio competitivo grazie ai segnali di autorità, a metriche SOM più alte e alla fiducia dei pazienti costruita tramite coerenza nelle risposte AI—vantaggi che crescono nel tempo man mano che i LLM imparano a riconoscere e privilegiare le fonti affidabili. L’integrazione tra SEO tradizionale e ottimizzazione per LLM non è una scelta esclusiva ma una strategia complementare, dato che i motori di ricerca incorporano sempre più tecnologia LLM e i pazienti continuano a usare fonti diverse. La sostenibilità a lungo termine dipende dalla reale expertise più che da trucchi di ottimizzazione; le organizzazioni che investono in conoscenza medica autentica, credenziali trasparenti e informazioni accurate prospereranno indipendentemente da come evolveranno i meccanismi di scoperta. Il panorama dei contenuti sanitari è cambiato radicalmente, e chi coglie questa transizione come opportunità e non come minaccia definirà il futuro della scoperta delle informazioni di salute per i pazienti.

YMYL (Your Money Your Life) si riferisce a contenuti che possono influenzare significativamente la salute, la stabilità finanziaria o la sicurezza delle persone. La sanità è la categoria più sottoposta a controlli poiché la disinformazione medica può causare gravi danni o la morte. Google applica standard algoritmici più rigorosi ai contenuti YMYL, e i LLM vengono sempre più utilizzati dai pazienti per ricercare informazioni di salute, rendendo la conformità YMYL fondamentale per la visibilità.

I LLM sintetizzano informazioni da più fonti per fornire risposte dirette, mentre i motori di ricerca classificano singole pagine. I contenuti sanitari ora devono essere strutturati per la citazione da parte dei sistemi AI, non solo per il posizionamento su Google. Ciò significa che i tuoi contenuti potrebbero educare migliaia di persone tramite risposte AI senza ricevere traffico diretto al sito, richiedendo un approccio di ottimizzazione fondamentalmente diverso.

E-E-A-T significa Esperienza, Competenza, Autorevolezza e Affidabilità. I contenuti sanitari richiedono i più alti standard E-E-A-T, con enfasi sull’esperienza medica diretta e credenziali verificate. Le Quality Rater Guidelines di Google menzionano E-E-A-T 137 volte, riflettendo la sua importanza critica per la visibilità dei contenuti sanitari sia nei motori di ricerca che nei sistemi LLM.

Studi dimostrano che l’AI genera affermazioni mediche non supportate nel 30-50% dei casi e inventa informazioni mediche. L’AI manca di esperienza medica reale e non può verificare le informazioni rispetto agli standard medici attuali. Ecco perché la revisione umana e la paternità da parte di esperti rimangono essenziali—l’AI dovrebbe assistere i professionisti sanitari, non sostituirli.

Testa i tuoi contenuti su ChatGPT, Claude e Perplexity usando domande comuni dei pazienti nella tua specialità. Monitora le metriche Share of Model (SOM)—la percentuale di risposte AI che citano i tuoi contenuti. AmICited.com automatizza questo monitoraggio, offrendo insight in tempo reale su come il tuo brand sanitario appare su diverse piattaforme LLM.

La SEO tradizionale si concentra sul posizionamento di singole pagine per parole chiave. L’ottimizzazione per LLM enfatizza la copertura completa, la ricchezza semantica e contenuti strutturati che i sistemi AI possono comprendere e citare. Entrambi gli approcci sono complementari—le organizzazioni sanitarie necessitano di strategie integrate che ottimizzino sia per i motori di ricerca sia per i LLM.

L’AI dovrebbe essere utilizzata solo come strumento di supporto agli esperti medici umani, non per sostituirli. Tutti i contenuti sanitari devono essere revisionati e approvati da professionisti qualificati prima della pubblicazione. I rischi sono troppo alti per affidarsi a generazione AI senza supervisione ed evidenza da parte di esperti.

AmICited.com monitora come i brand sanitari e i contenuti medici appaiono nelle risposte AI su ChatGPT, Perplexity, Google AI Overviews e altre piattaforme LLM. Fornisce metriche di visibilità, monitora la Share of Model (SOM) e offre raccomandazioni di ottimizzazione per aiutare le organizzazioni sanitarie a garantire che la loro expertise sia scoperta tramite le ricerche dei pazienti guidate dall’AI.

Controlla come i tuoi contenuti medici appaiono su ChatGPT, Perplexity, Google AI Overviews e altre piattaforme LLM. Ottieni insight in tempo reale sulla tua Share of Model (SOM) e ottimizza per la scoperta di pazienti guidata dall’IA.

Scopri come ottimizzare i tuoi contenuti Your Money or Your Life (YMYL) per motori di ricerca AI come ChatGPT, Perplexity e i Riassunti AI di Google. Padroneggi...

I contenuti YMYL richiedono elevati standard E-E-A-T. Scopri cosa qualifica un contenuto come Your Money Your Life, perché è importante per la SEO e la visibili...

Discussione della comunità su come i sistemi AI gestiscono gli argomenti YMYL (Your Money or Your Life). Approfondimenti reali su visibilità di contenuti salute...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.