Ricerca AI multimodale

Scopri come i sistemi di ricerca AI multimodale elaborano insieme testo, immagini, audio e video per offrire risultati più accurati e contestualmente rilevanti ...

Scopri come ottimizzare testo, immagini e video per i sistemi di IA multimodale. Scopri strategie per migliorare citazioni e visibilità AI su ChatGPT, Gemini e Perplexity.

L’IA multimodale rappresenta un cambiamento fondamentale nel modo in cui i sistemi di intelligenza artificiale elaborano e comprendono le informazioni. A differenza dei sistemi unimodali che gestiscono solo testo, immagini o video in modo indipendente, l’IA multimodale integra più tipi di dati simultaneamente per creare una comprensione più completa di informazioni complesse. Questo approccio riflette il modo in cui gli esseri umani processano naturalmente il mondo: non separiamo ciò che vediamo da ciò che ascoltiamo o leggiamo, ma sintetizziamo tutti gli input insieme. Il mercato dell’IA multimodale, valutato 1,6 miliardi di dollari nel 2024, sta vivendo una crescita esplosiva con un tasso di crescita annuale composto (CAGR) del 32,7%, riflettendo l’importanza fondamentale della tecnologia nelle strategie AI aziendali. Gli analisti di settore prevedono che il 40% di tutte le soluzioni di IA generativa saranno multimodali entro il 2027, secondo la ricerca Gartner. Questa transizione non è semplicemente incrementale; rappresenta un cambio di paradigma nel modo in cui le organizzazioni sfruttano l’IA per il vantaggio competitivo. La convergenza delle capacità di elaborazione di testo, immagini e video consente ai sistemi di IA di offrire intuizioni e funzionalità prima impossibili con approcci a singola modalità.

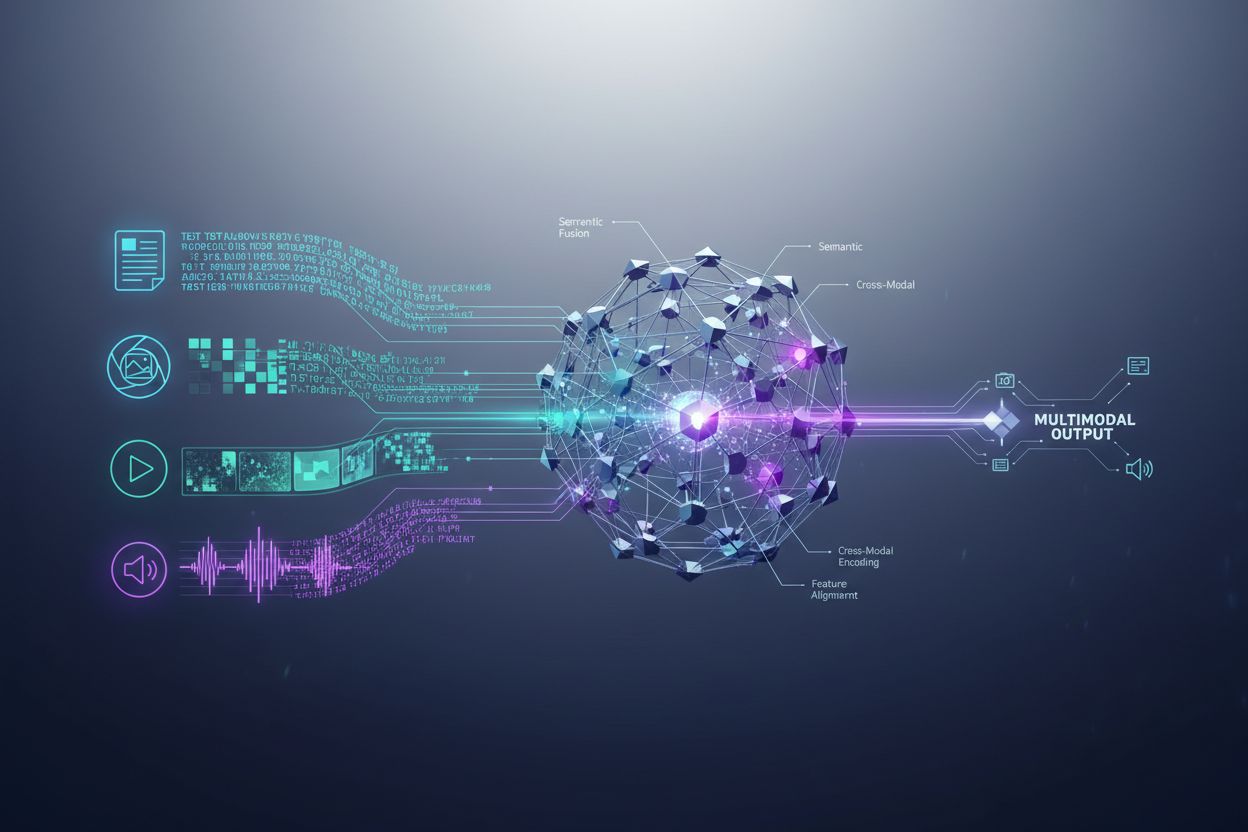

I sistemi di IA multimodale impiegano componenti architetturali sofisticati per gestire senza soluzione di continuità input di dati diversi. Gli encoder sono reti neurali specializzate che convertono ogni tipo di dato—testo, immagini e video—in una rappresentazione numerica unificata chiamata embedding. Questi embedding catturano il significato semantico di ciascuna modalità in uno spazio matematico condiviso, consentendo al sistema di confrontare e collegare informazioni tra diversi tipi di contenuti. Il meccanismo di fusione combina poi questi embedding, sia attraverso concatenazione, somma o tecniche di fusione avanzate che determinano quanto peso ciascuna modalità debba contribuire al risultato finale. I meccanismi di cross-attention permettono al modello di concentrarsi dinamicamente sulle informazioni rilevanti tra le modalità; ad esempio, nell’analisi di un’immagine di prodotto con testo associato, il sistema può soffermarsi su specifiche caratteristiche visive che corrispondono alle descrizioni testuali. Questo processo multi-step consente ai sistemi multimodali di ottenere una comprensione contestuale che i sistemi unimodali non possono replicare. La tabella seguente illustra le differenze di capacità:

| Capacità | IA Unimodale | IA Multimodale |

|---|---|---|

| Analisi Testuale | Eccellente | Eccellente |

| Comprensione delle Immagini | Limitata/Nessuna | Eccellente |

| Elaborazione Video | Limitata/Nessuna | Eccellente |

| Ragionamento Cross-Modale | Non Possibile | Eccellente |

| Integrazione del Contesto | Fonte Singola | Fonti Multiple |

| Accuratezza nel Mondo Reale | 60-75% | 85-95% |

| Velocità di Elaborazione | Veloce | Ottimizzata Veloce |

Il panorama dell’IA multimodale è dominato da diverse potenti piattaforme che hanno fissato nuovi standard per l’elaborazione integrata. GPT-4o di OpenAI rappresenta un modello multimodale di punta, in grado di gestire senza soluzione di continuità testo, immagini e video con integrazione nativa tra tutte le modalità. Google Gemini offre capacità multimodali di livello enterprise con particolare forza nella comprensione di documenti visivi complessi e contenuti video di lunga durata. Claude di Anthropic offre sofisticato ragionamento multimodale con enfasi sull’accuratezza e sulla comprensione sfumata degli input testuali e visivi. La tecnologia ImageBind di Meta dimostra un diverso approccio architetturale, creando uno spazio di embedding unificato attraverso sei modalità tra cui testo, immagini, audio, profondità, termico e dati IMU. Queste piattaforme rappresentano l’avanguardia della tecnologia multimodale, ciascuna portando innovazioni architetturali e strategie di ottimizzazione distintive. Le organizzazioni che selezionano piattaforme multimodali devono valutare non solo l’ampiezza delle capacità, ma anche l’ottimizzazione delle prestazioni, l’efficienza dei costi e l’integrazione con i flussi di lavoro esistenti.

L’IA multimodale sta trasformando le operazioni in quasi tutti i settori, offrendo miglioramenti misurabili in efficienza, accuratezza ed esperienza cliente. Le organizzazioni che implementano queste tecnologie riportano risultati notevoli:

Sanità: I radiologi utilizzano l’IA multimodale per analizzare immagini mediche combinate con cartelle cliniche e note del paziente, migliorando l’accuratezza diagnostica e riducendo i tempi di analisi fino al 40%. I sistemi di IA possono correlare risultati visivi con la storia clinica testuale per identificare schemi che l’uomo potrebbe non vedere.

Retail: Aziende di moda e e-commerce sfruttano l’IA multimodale per abbinare descrizioni dei clienti con l’inventario visivo, consentendo ricerche “per descrizione” che aumentano i tassi di conversione. Le raccomandazioni di prodotto migliorano significativamente quando l’IA comprende sia le preferenze visive che i feedback testuali.

Manifattura: I processi di controllo qualità accelerano notevolmente con sistemi di ispezione multimodale che combinano rilevamento visivo dei difetti con dati dei sensori e registri di manutenzione, ottenendo catalogazione dei problemi di produzione 100 volte più veloce rispetto ai processi manuali.

Creazione di Contenuti: Le aziende media utilizzano l’IA multimodale per generare automaticamente didascalie, trascrizioni e metadati per i contenuti video, con il 72% dei dirigenti media che utilizza l’IA generativa riportando un ROI positivo sugli investimenti.

Customer Service: I chatbot potenziati con capacità multimodali possono elaborare immagini inviate dai clienti insieme a descrizioni testuali, fornendo soluzioni di supporto più accurate e contestuali.

Agricoltura: Gli agricoltori adottano sistemi multimodali che analizzano immagini delle colture, dati meteorologici e rilevamenti dei sensori del suolo per ottimizzare irrigazione, fertilizzazione e gestione dei parassiti.

Robotica: I sistemi autonomi utilizzano la percezione multimodale per navigare in ambienti complessi, combinando input visivi con segnali audio e feedback tattile per un funzionamento più sicuro e intelligente.

Per massimizzare l’efficacia dei sistemi di IA multimodale, i contenuti testuali richiedono strategie di ottimizzazione deliberate che migliorino la leggibilità da parte delle macchine e la comprensione contestuale. Il markup dei dati strutturati utilizzando gli standard schema.org aiuta i sistemi di IA a comprendere le relazioni semantiche all’interno dei tuoi contenuti, consentendo connessioni cross-modali più precise. Implementare un linguaggio conversazionale invece di uno stile puramente formale permette ai sistemi multimodali di cogliere meglio l’intento e il contesto, specialmente quando il testo è elaborato insieme a elementi visivi o video. Intestazioni e sottotitoli descrittivi svolgono una doppia funzione: guidano i lettori umani e forniscono segnali strutturali cruciali che aiutano i sistemi di IA a organizzare e prioritizzare le informazioni. Includere parole chiave rilevanti in contesti naturali—invece di forzarne la presenza—assicura che i contenuti testuali siano in linea con il modo in cui i sistemi multimodali identificano le relazioni tematiche tra le modalità. L’ottimizzazione dei metadati, inclusi title tag, meta description e attributi di dati strutturati, fornisce segnali espliciti sul significato dei contenuti che i sistemi multimodali possono sfruttare. Le organizzazioni dovrebbero anche considerare come il testo completi i contenuti visivi; didascalie e alt text non sono solo funzioni di accessibilità—sono elementi di ottimizzazione critici che permettono all’IA multimodale di comprendere la relazione tra informazioni testuali e visive.

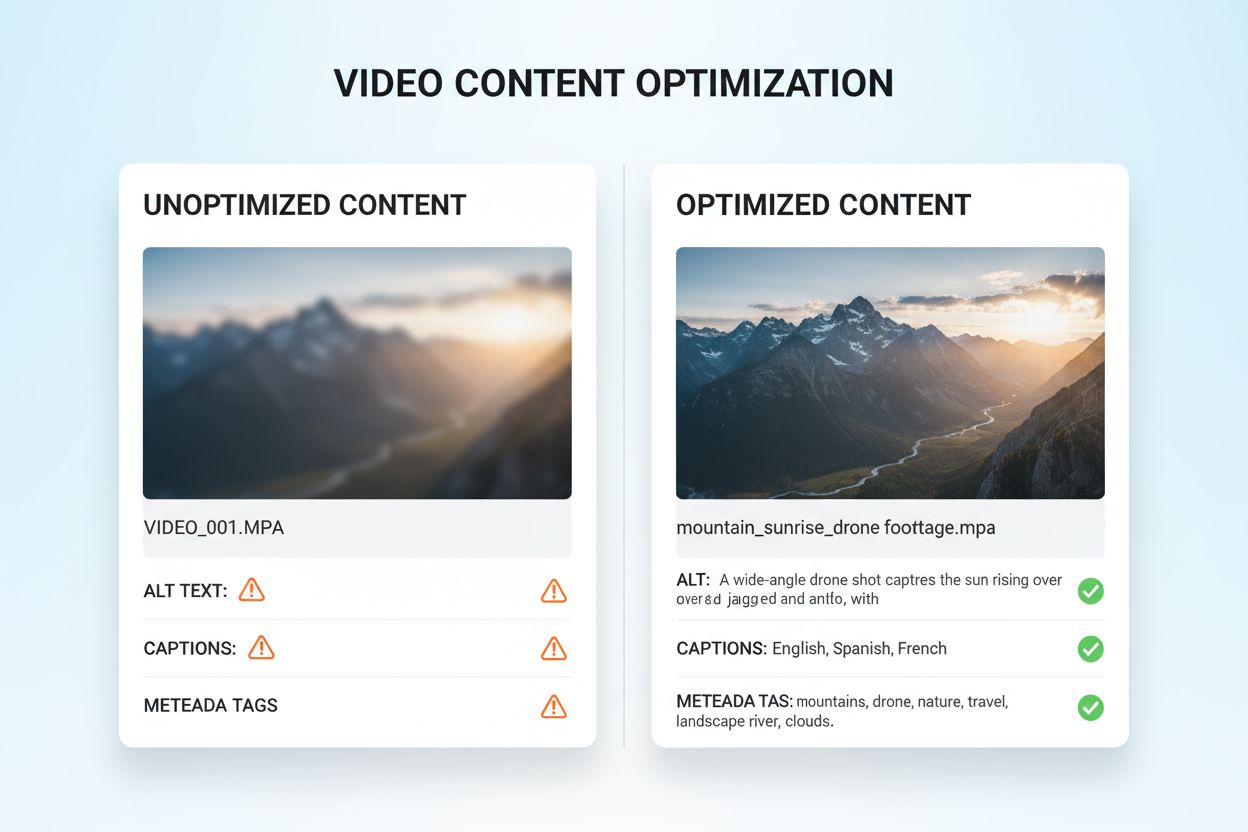

L’ottimizzazione dei contenuti visivi e video per l’IA multimodale richiede un approccio completo che va ben oltre le pratiche SEO tradizionali. L’alt text descrittivo è fondamentale; invece di descrizioni generiche, l’alt text deve cogliere il significato semantico, il contesto e i dettagli rilevanti che aiutano i sistemi di IA a comprendere cosa rappresenta l’immagine. Le convenzioni di denominazione dei file sono molto importanti—nomi descrittivi come “grafico-confronto-prodotti-2024.jpg” forniscono contesto essenziale che i sistemi di IA usano per capire lo scopo del contenuto. Didascalie e trascrizioni video sono elementi di ottimizzazione imprescindibili; consentono ai sistemi multimodali di correlare i contenuti parlati con gli elementi visivi, migliorando notevolmente la comprensione di materiali video complessi. I campi di metadati come titolo, descrizione e tag devono essere compilati con precisione e specificità, poiché influenzano direttamente il modo in cui i sistemi di IA categorizzano e collegano i contenuti visivi ad altre modalità. La compressione delle immagini e l’ottimizzazione tecnica garantiscono che la qualità visiva sia sufficientemente alta per l’analisi AI mantenendo tempi di caricamento rapidi. I dati strutturati per i contenuti visivi, incluso il markup per immagini, video e gallerie multimediali, forniscono segnali espliciti sulle relazioni tra i contenuti. Le organizzazioni dovrebbero considerare anche i metadati temporali per i video—marcare momenti chiave, cambi di scena e transizioni tematiche aiuta i sistemi multimodali a comprendere la struttura narrativa ed estrarre i segmenti rilevanti.

I sistemi di IA multimodale adottano due approcci architetturali principali, ognuno con vantaggi e compromessi distinti. Le architetture unificate elaborano tutte le modalità tramite una singola rete neurale integrata che apprende rappresentazioni congiunte fin dall’inizio del processo. Questo approccio in genere offre un ragionamento cross-modale superiore perché il sistema sviluppa una comprensione profonda di come le modalità siano correlate, ma richiede più risorse computazionali e tempi di addestramento più lunghi. Le architetture modulari mantengono reti specializzate separate per ciascuna modalità, poi combinano i loro output attraverso meccanismi di fusione. Questo approccio offre maggiore flessibilità, consentendo alle organizzazioni di sostituire singoli processori di modalità senza riaddestrare l’intero sistema, e richiede solitamente meno risorse computazionali. I modelli Mixture of Experts (MoE) rappresentano un approccio ibrido emergente, in cui diverse reti esperte si specializzano in diverse modalità o compiti, e un meccanismo di gating indirizza gli input agli esperti appropriati. Questa architettura raggiunge miglioramenti di efficienza del 30-50% rispetto ai modelli unificati densi mantenendo una precisione comparabile. La scelta tra gli approcci architetturali dipende dai casi d’uso specifici: le architetture unificate eccellono nei compiti di ragionamento complesso che richiedono una profonda comprensione cross-modale, mentre gli approcci modulari sono adatti a scenari che richiedono flessibilità ed efficienza delle risorse.

Un’implementazione efficace di IA multimodale richiede solidi framework di misurazione che traccino sia le prestazioni tecniche sia l’impatto aziendale. Gli indicatori chiave di prestazione (KPI) dovrebbero includere metriche di accuratezza per ogni modalità, qualità del ragionamento cross-modale, latenza di elaborazione e costo per inferenza. Le piattaforme di analytics dovrebbero rilevare come l’IA multimodale influenza le metriche aziendali a valle: tassi di conversione nel retail, accuratezza diagnostica in sanità, efficienza produttiva in manifattura. Le organizzazioni devono implementare il monitoraggio dell’attribuzione per comprendere quale modalità contribuisce maggiormente a risultati specifici—queste informazioni guidano gli sforzi di ottimizzazione e l’allocazione delle risorse. La misurazione del ROI deve considerare sia i risparmi diretti di costo (come la catalogazione 100x più veloce riportata dalle aziende manifatturiere) sia i benefici indiretti come la maggiore soddisfazione del cliente o la riduzione degli errori. Gli strumenti di monitoraggio dovrebbero tracciare il degrado delle prestazioni del modello nel tempo, poiché il drift dei dati reali può ridurre l’accuratezza dei sistemi multimodali se non è gestito attivamente. Per le organizzazioni che sfruttano contenuti e intuizioni generati dall’IA, il monitoraggio delle citazioni e dell’attribuzione diventa sempre più importante; strumenti come AmICited.com aiutano a monitorare come i sistemi di IA citano le fonti e attribuiscono le informazioni, offrendo visibilità sui processi decisionali dell’IA e garantendo la conformità ai requisiti di provenienza dei contenuti. Audit regolari delle prestazioni e cicli di ottimizzazione assicurano che i sistemi multimodali continuino a fornire valore man mano che le esigenze aziendali e i modelli di dati evolvono.

Il panorama dell’IA multimodale continua a evolversi rapidamente, con diverse tendenze trasformative che stanno ridefinendo come le organizzazioni sfrutteranno queste tecnologie. L’integrazione della voce rappresenta la prossima frontiera, poiché i sistemi combinano sempre più input audio con dati visivi e testuali, consentendo una comprensione davvero completa della comunicazione umana e del contesto ambientale. I sistemi Agentic AI—agenti AI che possono pianificare ed eseguire autonomamente compiti multi-step—sfrutteranno la percezione multimodale per navigare in scenari reali complessi, dai veicoli autonomi all’automazione dei processi aziendali. Le capacità di elaborazione in tempo reale stanno avanzando notevolmente, consentendo l’analisi multimodale di flussi video dal vivo, feed audio e dati dei sensori simultaneamente, aprendo possibilità di decision making istantaneo per applicazioni sensibili al tempo. I miglioramenti di efficienza tramite tecniche come distillazione e quantizzazione renderanno le capacità multimodali sofisticate accessibili anche alle organizzazioni con risorse computazionali limitate, democratizzando l’accesso all’IA avanzata. Emergeranno modelli specialistici di settore, con sistemi multimodali ottimizzati per settori specifici come sanità, legale o servizi finanziari, offrendo prestazioni superiori rispetto ai modelli generalisti. La convergenza di queste tendenze suggerisce che l’IA multimodale passerà da vantaggio competitivo a requisito fondamentale per le organizzazioni che vogliono restare rilevanti in un panorama sempre più guidato dall’IA. Le realtà che iniziano oggi a ottimizzare i propri contenuti e processi per l’IA multimodale saranno meglio posizionate per sfruttare queste capacità emergenti domani.

L'IA multimodale elabora contemporaneamente più tipi di dati (testo, immagini, audio, video), mentre l'IA unimodale tradizionale gestisce solo un tipo. Questo consente una comprensione del contesto più ricca e risultati più accurati. I sistemi multimodali possono comprendere le relazioni tra diverse modalità, offrendo intuizioni che i sistemi a singola modalità non possono replicare.

Poiché l'IA multimodale sta diventando lo standard per le soluzioni di IA generativa (si prevede che raggiungerà il 40% entro il 2027), ottimizzare i tuoi contenuti garantisce una migliore visibilità nelle risposte generate dall'IA. Le organizzazioni che ottimizzano su testo, immagini e video ottengono citazioni AI migliori, maggiore visibilità su piattaforme come ChatGPT e Gemini e migliori prestazioni complessive dei contenuti.

Monitora metriche chiave come l'accuratezza tra le modalità, la qualità del ragionamento cross-modale, la latenza di elaborazione e l'impatto aziendale (tassi di conversione, engagement, ecc.). Utilizza strumenti come AmICited.com per monitorare come i sistemi di IA citano i tuoi contenuti e implementa analisi per capire quali modalità contribuiscono maggiormente ai risultati aziendali.

Le sfide principali includono garantire la coerenza dei metadati tra le modalità, mantenere alta qualità di alt text e didascalie, allineare i dati temporali nei video e gestire le risorse computazionali necessarie all'elaborazione. Le organizzazioni dovrebbero pianificare anche la preparazione dei dati (10-20% del budget del progetto) e la gestione del cambiamento mentre i team si adattano alle nuove pratiche di ottimizzazione.

Sanità, retail, manifattura, creazione di contenuti, customer service, agricoltura e robotica ne traggono grandi vantaggi. La sanità la utilizza per l'accuratezza diagnostica, il retail per la scoperta dei prodotti, la manifattura per il controllo qualità (catalogazione 100x più veloce) e le aziende media riportano un ROI del 72% sugli investimenti in IA generativa.

AmICited.com monitora come i sistemi di IA come ChatGPT, Perplexity e Google AI Overviews citano i tuoi contenuti tra diverse modalità. Fornisce visibilità in tempo reale sulla tua presenza nella ricerca AI, aiutandoti a capire come i tuoi contenuti testuali, visivi e video vengono referenziati nelle risposte generate dall'IA.

Le architetture unificate elaborano tutte le modalità tramite una singola rete integrata, offrendo un ragionamento cross-modale superiore ma richiedendo più risorse computazionali. Le architetture modulari mantengono reti separate per ogni modalità, offrendo maggiore flessibilità ed efficienza. I modelli Mixture of Experts (MoE) forniscono un approccio ibrido con miglioramenti di efficienza del 30-50%.

Ottimizza il testo con dati strutturati e linguaggio conversazionale, aggiungi alt text descrittivo e metadati alle immagini, includi didascalie e trascrizioni per i video e utilizza convenzioni di denominazione coerenti dei file. Assicurati che tutte le modalità lavorino insieme per fornire un contesto completo e implementa markup schema per aiutare i sistemi di IA a comprendere le relazioni semantiche.

Traccia come i sistemi di IA multimodale citano i tuoi contenuti su ChatGPT, Perplexity, Google AI Overviews e altre piattaforme. Ottieni visibilità in tempo reale sulla tua presenza nella ricerca AI.

Scopri come i sistemi di ricerca AI multimodale elaborano insieme testo, immagini, audio e video per offrire risultati più accurati e contestualmente rilevanti ...

Scopri cos'è il contenuto multimodale per l'IA, come funziona e perché è importante. Esplora esempi di sistemi di IA multimodale e le loro applicazioni nei vari...

Diventa esperto nell'ottimizzazione della ricerca AI multimodale. Scopri come ottimizzare immagini e query vocali per risultati di ricerca potenziati dall'AI, c...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.