Come Evolverà la Ricerca AI nel 2026?

Scopri le tendenze chiave che stanno plasmando l'evoluzione della ricerca AI nel 2026, tra cui capacità multimodali, sistemi agentici, recupero delle informazio...

Scopri come ottimizzare i contenuti basati su domande per sistemi AI conversazionali come ChatGPT e Perplexity. Scopri struttura, autorevolezza e strategie di monitoraggio per massimizzare le citazioni AI.

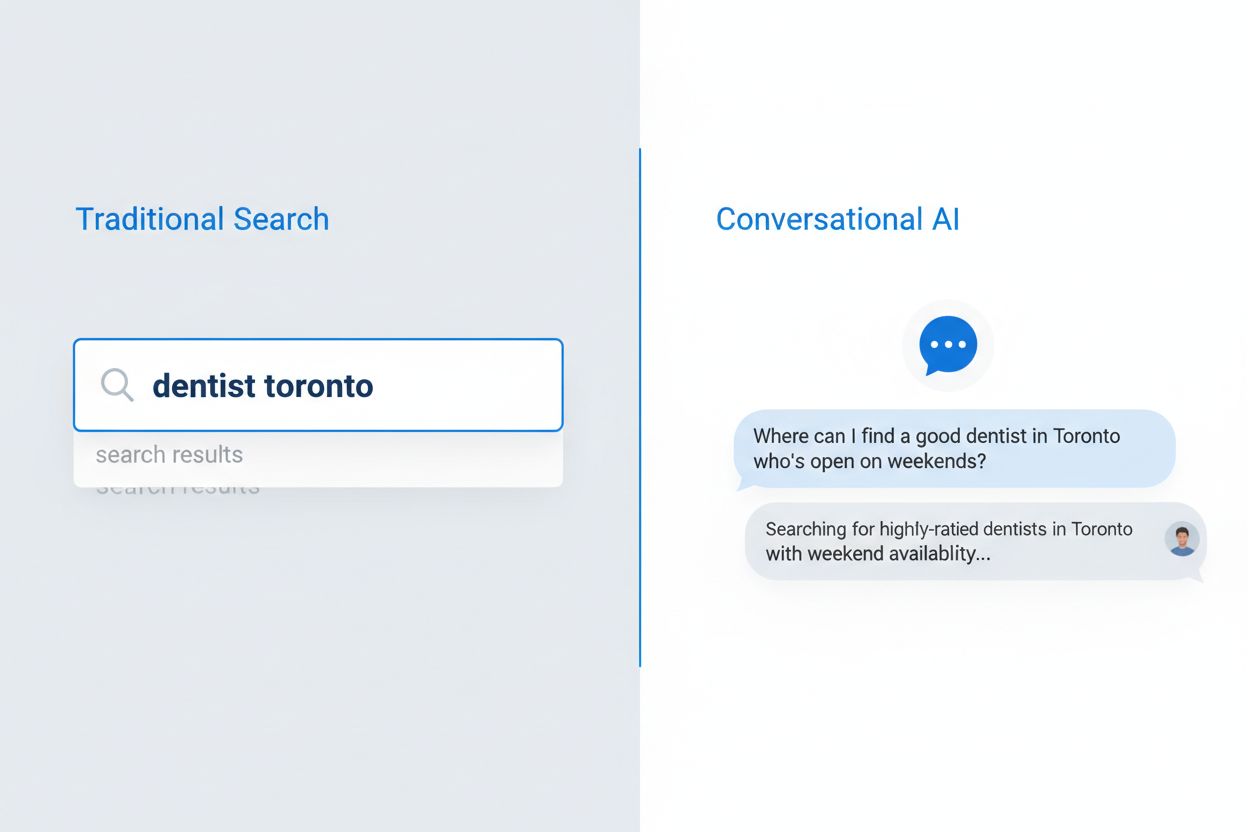

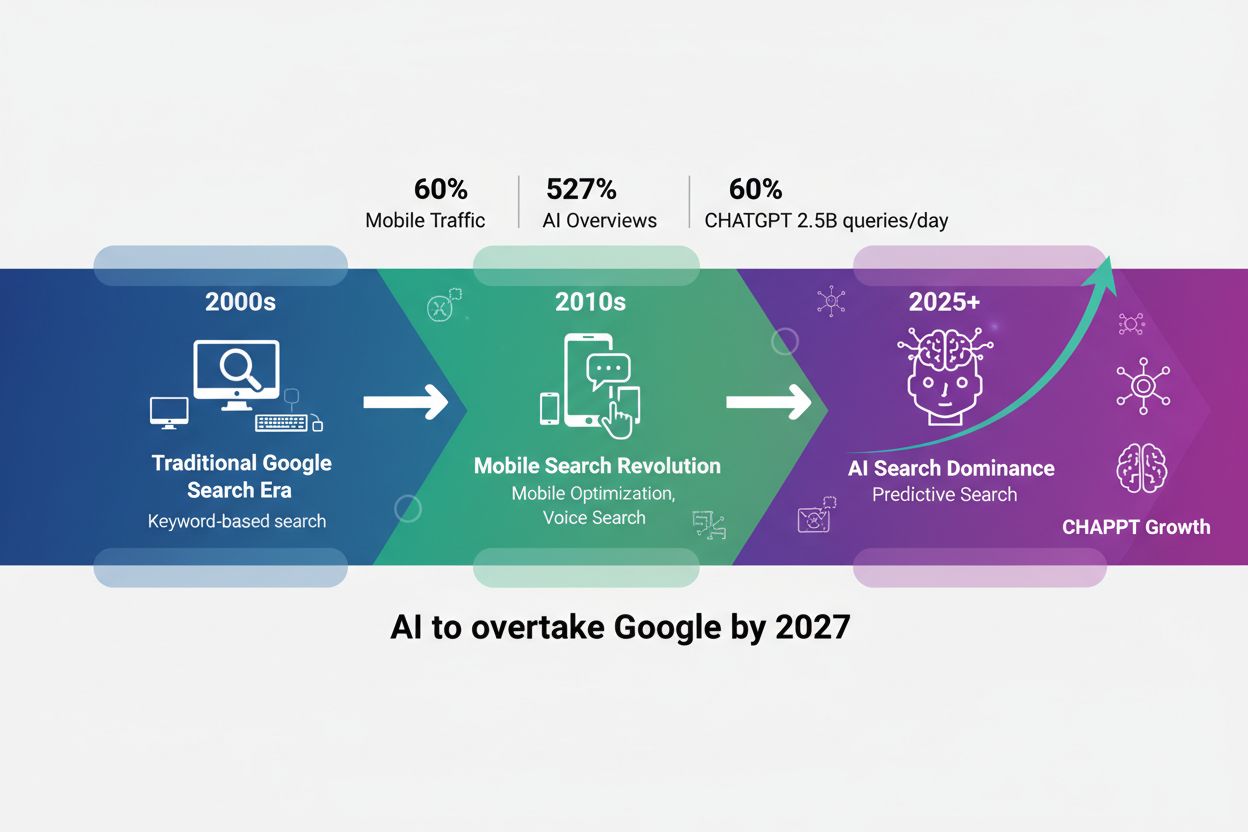

Il comportamento degli utenti nella ricerca si è trasformato radicalmente negli ultimi cinque anni, spostandosi da frasi keyword frammentate verso query naturali e conversazionali. Questo cambiamento è stato accelerato dall’adozione diffusa della ricerca vocale, da modelli di navigazione mobile-first e da significativi aggiornamenti degli algoritmi come BERT e MUM di Google che ora privilegiano la comprensione semantica rispetto alla semplice corrispondenza delle keyword. Gli utenti non cercano più termini isolati, ma pongono domande complete che riflettono il loro modo di parlare e pensare. La differenza è evidente:

L’adozione della ricerca vocale è stata particolarmente influente, con il 50% di tutte le ricerche ora effettuate tramite voce, costringendo motori di ricerca e sistemi AI ad adattarsi a pattern linguistici più lunghi e naturali. I dispositivi mobili sono diventati l’interfaccia di ricerca principale per la maggior parte degli utenti e le query conversazionali risultano più naturali su mobile rispetto alla digitazione di keyword. Gli aggiornamenti dell’algoritmo di Google hanno reso chiaro che la comprensione dell’intento e del contesto dell’utente conta molto di più rispetto alla densità delle keyword o alla corrispondenza esatta delle frasi, cambiando radicalmente il modo in cui i contenuti devono essere scritti e strutturati per restare visibili sia nella ricerca tradizionale che nei sistemi AI.

La ricerca AI conversazionale rappresenta un paradigma radicalmente diverso rispetto alla ricerca tradizionale basata su keyword, con differenze evidenti su come vengono processate le query, come vengono forniti i risultati e come viene interpretato l’intento utente. Mentre i motori di ricerca tradizionali restituiscono una lista di link ordinati, i sistemi AI conversazionali analizzano le query nel contesto, recuperano informazioni rilevanti da più fonti e sintetizzano risposte complete in linguaggio naturale. L’architettura tecnica è molto diversa: la ricerca tradizionale si basa su corrispondenza di keyword e analisi dei link, mentre l’AI conversazionale utilizza modelli linguistici di grandi dimensioni con generazione aumentata da recupero (RAG) per comprendere il significato semantico e generare risposte contestuali. Comprendere queste differenze è fondamentale per chi crea contenuti e vuole visibilità in entrambi i sistemi, poiché le strategie di ottimizzazione divergono in modo significativo.

| Dimensione | Ricerca Tradizionale | AI Conversazionale |

|---|---|---|

| Input | Keyword o frasi brevi (media 2-4 parole) | Domande conversazionali complete (media 8-15 parole) |

| Output | Lista di link ordinati da cliccare | Risposta sintetizzata con citazioni delle fonti |

| Contesto | Limitato ai termini della query e alla posizione utente | Cronologia completa della conversazione e preferenze utente |

| Intento Utente | Inferito da keyword e pattern di clic | Esplicitamente compreso tramite linguaggio naturale |

| Esperienza Utente | Necessario cliccare su siti esterni | Risposta fornita direttamente nell’interfaccia |

Questa distinzione ha profonde implicazioni per la strategia di contenuto. Nella ricerca tradizionale, apparire tra i primi 10 risultati equivale a visibilità; nell’AI conversazionale, ciò che conta è essere scelti come fonte di citazione. Una pagina può posizionarsi bene per una keyword ma non essere mai citata da un sistema AI se non soddisfa i criteri di autorevolezza, completezza e chiarezza. I sistemi AI valutano i contenuti in modo diverso, privilegiando risposte dirette alle domande, una chiara gerarchia informativa e una comprovata esperienza più che l’ottimizzazione delle keyword e i profili di backlink.

I grandi modelli linguistici utilizzano un sofisticato processo chiamato Generazione Aumentata da Recupero (RAG) per selezionare quali contenuti citare quando rispondono alle domande degli utenti, e questo processo è molto diverso dal tradizionale ranking della ricerca. Quando un utente pone una domanda, l’LLM recupera prima i documenti rilevanti dai suoi dati di addestramento o fonti indicizzate, quindi li valuta su più criteri prima di decidere quali citare nella risposta. Il processo di selezione privilegia diversi fattori chiave che i creatori di contenuti devono conoscere:

Segnali di autorevolezza – Gli LLM riconoscono l’autorevolezza del dominio tramite profili di backlink, anzianità del dominio e performance storica nei risultati di ricerca, preferendo fonti consolidate e affidabili rispetto a domini nuovi o con poche citazioni.

Rilevanza semantica – Il contenuto deve rispondere direttamente alla domanda dell’utente con alta similarità semantica, non solo corrispondenza di keyword; gli LLM comprendono significato e contesto meglio della semplice corrispondenza.

Struttura e chiarezza dei contenuti – Contenuti ben organizzati con titoli chiari, risposte dirette e un flusso logico sono più facilmente selezionati perché gli LLM possono estrarre informazioni rilevanti da contenuti strutturati.

Freschezza e aggiornamento – I contenuti aggiornati di recente sono preferiti, soprattutto per argomenti dove le informazioni attuali sono rilevanti; i contenuti obsoleti vengono declassati anche se erano storicamente autorevoli.

Completezza – I contenuti che trattano un argomento in modo approfondito, con angolazioni diverse, dati a supporto e pareri di esperti sono più facilmente citati rispetto a una trattazione superficiale.

Il processo di citazione non è casuale; gli LLM sono addestrati a citare le fonti che meglio supportano le loro risposte e sempre più spesso mostrano le citazioni agli utenti, rendendo la scelta della fonte un importante parametro di visibilità per i creatori di contenuti.

La struttura dei contenuti è diventata uno dei fattori più importanti per la visibilità AI, ma molti creatori di contenuti continuano a ottimizzare solo per il lettore umano senza considerare come i sistemi AI analizzano ed estraggono le informazioni. Gli LLM processano i contenuti in modo gerarchico, usando titoli, suddivisioni e formattazione per comprendere e individuare i passaggi rilevanti da citare. La struttura ottimale per l’AI segue linee guida precise: ogni sezione dovrebbe avere 120-180 parole, permettendo agli LLM di estrarre blocchi significativi senza lunghezze eccessive; i titoli H2 e H3 devono indicare chiaramente la gerarchia degli argomenti; le risposte dirette devono comparire all’inizio delle sezioni e non essere nascoste nei paragrafi.

I titoli basati su domande e le sezioni FAQ sono particolarmente efficaci perché si allineano perfettamente al modo in cui i sistemi AI interpretano le query degli utenti. Quando un utente chiede “Quali sono le best practice per il content marketing?”, un sistema AI può immediatamente abbinare la query a una sezione intitolata “Quali sono le best practice per il content marketing?” ed estrarre il contenuto rilevante. Questo allineamento strutturale aumenta notevolmente la probabilità di citazione. Ecco un esempio di contenuto strutturato correttamente:

## Quali sono le best practice per il content marketing?

### Definisci prima il tuo pubblico target

[120-180 parole di contenuto diretto e pratico che risponde a questa specifica domanda]

### Crea un calendario editoriale

[120-180 parole di contenuto diretto e pratico che risponde a questa specifica domanda]

### Misura e ottimizza le performance

[120-180 parole di contenuto diretto e pratico che risponde a questa specifica domanda]

Questa struttura consente agli LLM di individuare rapidamente le sezioni rilevanti, estrarre pensieri completi senza frammentazioni e citare sezioni specifiche con sicurezza. I contenuti che non hanno questa struttura—lunghi paragrafi senza titoli chiari, risposte nascoste o gerarchia poco definita—sono molto meno probabilmente selezionati per la citazione, indipendentemente dalla qualità.

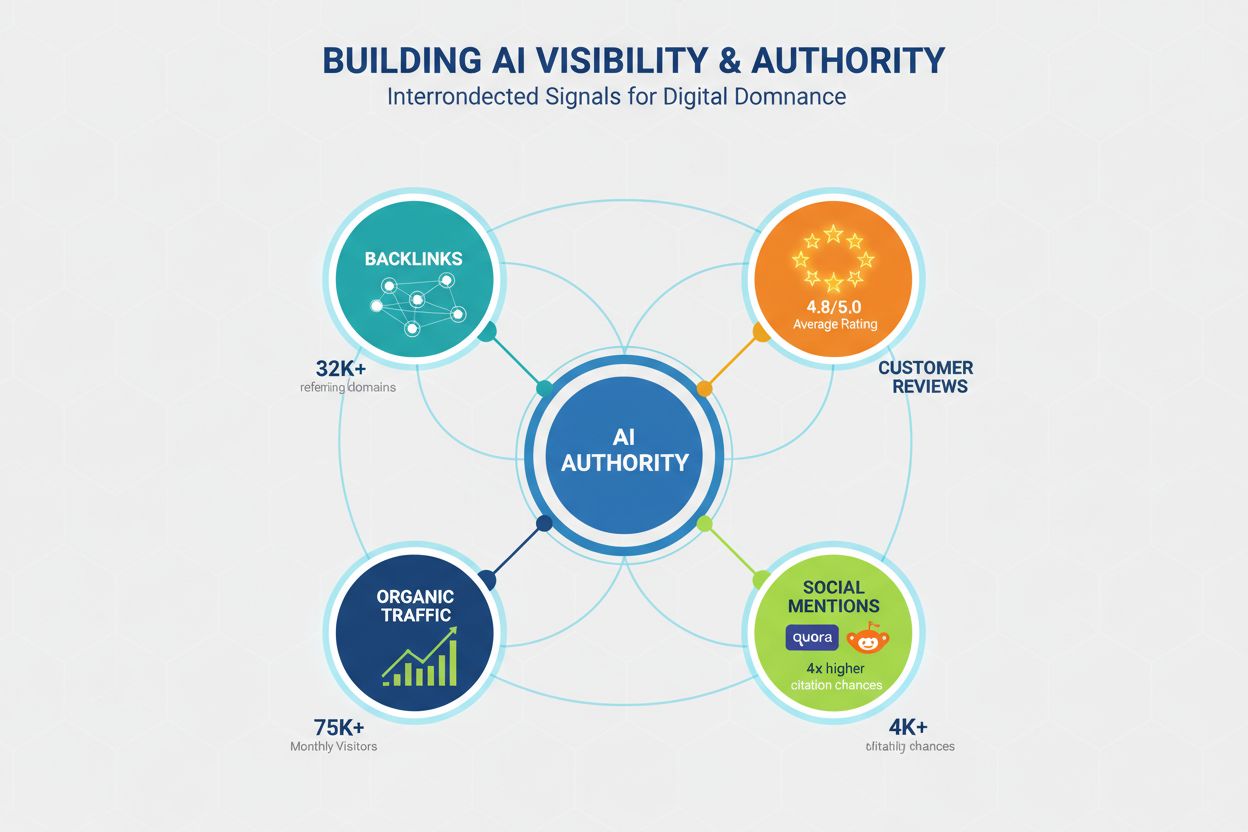

L’autorevolezza resta un fattore critico per la visibilità AI, anche se i segnali che la determinano sono andati oltre le metriche SEO tradizionali. Gli LLM riconoscono l’autorevolezza attraverso molteplici canali e i creatori di contenuti devono costruire credibilità su più dimensioni per massimizzare le probabilità di citazione. Le ricerche indicano che i domini con oltre 32.000 domini referenti vedono tassi di citazione significativamente più alti e i punteggi di Domain Trust sono fortemente correlati alla visibilità AI. Tuttavia, l’autorevolezza non si costruisce solo con i backlink; è un concetto sfaccettato che include:

Profilo di backlink – Backlink di qualità da domini autorevoli segnalano competenza; oltre 50 backlink di alta qualità corrispondono a tassi di citazione 4,8 volte superiori rispetto ai domini con pochi backlink.

Prova sociale e presenza nella community – Menzioni su piattaforme come Quora, Reddit e forum di settore indicano che i tuoi contenuti sono affidabili e citati da utenti reali; la partecipazione attiva aumenta la credibilità.

Recensioni e piattaforme di rating – Presenza su Trustpilot, G2, Capterra e piattaforme simili con recensioni positive crea segnali di fiducia riconosciuti dagli LLM; i brand con rating di almeno 4,5 stelle vedono tassi di citazione 3,2 volte più alti.

Traffico homepage e riconoscibilità del brand – Il traffico diretto verso la homepage indica notorietà e fiducia; gli LLM danno più peso ai brand riconosciuti rispetto alle fonti sconosciute.

Credenziali degli esperti e firme – Contenuti firmati da esperti riconosciuti con credenziali e biografie chiare sono valutati più positivamente; l’expertise dell’autore è un segnale distinto rispetto all’autorità del dominio.

Costruire autorevolezza per la visibilità AI richiede una strategia a lungo termine che va oltre la SEO tradizionale, integrando coinvolgimento nella community, gestione delle recensioni e brand building insieme all’ottimizzazione tecnica.

La profondità dei contenuti è uno dei migliori predittori della citazione AI: le ricerche mostrano che contenuti completi e ben documentati ricevono molte più citazioni rispetto a quelli superficiali. La soglia minima per una visibilità competitiva è circa 1.900 parole, ma una copertura davvero completa che domina le citazioni AI supera di solito le 2.900 parole. Non si tratta solo di lunghezza, ma di profondità informativa, numero di dati a supporto e ampiezza di prospettive trattate.

I dati sulla profondità dei contenuti sono chiari:

Impatto delle citazioni di esperti – I contenuti con almeno 4 citazioni di esperti ricevono in media 4,1 citazioni, contro 2,4 citazioni per quelli senza prospettive di esperti; gli LLM riconoscono l’apporto degli esperti come segnale di credibilità.

Densità di dati statistici – I contenuti con almeno 19 dati statistici ricevono 5,4 citazioni in media, rispetto a 2,8 per quelli con pochi dati; gli LLM privilegiano le affermazioni supportate da dati.

Copertura completa – I contenuti che trattano almeno 8 sottotemi ricevano 5,1 citazioni in media, rispetto a 3,2 per chi tratta solo 3-4 sottotemi; l’ampiezza della copertura è fondamentale.

Ricerche originali – I contenuti che presentano ricerche originali, sondaggi o dati proprietari raggiungono 6,2 citazioni in media, risultando i più premiati in termini di visibilità AI.

La profondità conta perché gli LLM sono addestrati a fornire risposte complete e ben documentate, e tendono naturalmente a citare contenuti che permettono di offrire molteplici punti di vista, dati e opinioni di esperti in un’unica fonte.

La freschezza dei contenuti è un fattore spesso sottovalutato per la visibilità AI: le ricerche mostrano che i contenuti aggiornati di recente ricevono molte più citazioni rispetto a quelli datati. L’impatto è netto: i contenuti aggiornati negli ultimi tre mesi ottengono in media 6,0 citazioni, contro solo 3,6 per quelli non aggiornati da oltre un anno. Questa metrica riflette la preferenza degli LLM per le informazioni attuali e il loro riconoscimento che i contenuti freschi sono più accurati e rilevanti.

Una strategia di aggiornamento trimestrale dovrebbe diventare la prassi per chi punta alla visibilità AI. Non occorrono riscritture complete; aggiornamenti strategici che aggiungono nuove statistiche, esempi aggiornati, case study e sviluppi recenti bastano per segnalare freschezza. Per argomenti sensibili al tempo come tecnologia, marketing o news, potrebbero essere necessari aggiornamenti mensili. Il processo di aggiornamento comprende:

I contenuti statici in un settore in evoluzione perderanno visibilità AI anche se erano una volta autorevoli, perché gli LLM riconoscono che le informazioni datate sono meno utili per gli utenti.

Le prestazioni tecniche sono sempre più importanti per la visibilità AI, poiché gli LLM e i sistemi che li alimentano privilegiano i contenuti provenienti da siti veloci e ben ottimizzati. I Core Web Vitals—le metriche di Google per l’esperienza di pagina—sono fortemente correlate ai tassi di citazione, indicando che gli LLM considerano i segnali di esperienza utente nella scelta delle fonti. L’impatto delle prestazioni è rilevante: le pagine con First Contentful Paint (FCP) sotto i 0,4 secondi ricevono in media 6,7 citazioni, contro solo 2,1 per quelle oltre 2,5 secondi.

L’ottimizzazione tecnica per la visibilità AI deve concentrarsi su:

Largest Contentful Paint (LCP) – Obiettivo sotto 2,5 secondi; le pagine che rispettano questo valore ottengono in media 5,8 citazioni contro 2,9 delle più lente.

Cumulative Layout Shift (CLS) – Mantenere un punteggio sotto 0,1; layout instabili segnalano bassa qualità agli LLM e riducono le probabilità di citazione.

Interaction to Next Paint (INP) – Ottimizzare la reattività sotto i 200ms; le pagine interattive ricevono 5,2 citazioni in media contro 3,1 per le più lente.

Reattività mobile – L’indicizzazione mobile-first rende le prestazioni su mobile fondamentali; le pagine con esperienza mobile scadente ricevono il 40% di citazioni in meno.

HTML pulito e semantico – Gerarchia corretta dei titoli, tag semantici e codice pulito aiutano gli LLM a interpretare meglio i contenuti e aumentano la probabilità di citazione.

Le prestazioni tecniche non sono solo una questione di esperienza utente; sono un segnale diretto per i sistemi AI sulla qualità e l’affidabilità dei contenuti.

L’ottimizzazione basata su domande è il modo più diretto per allineare i contenuti ai pattern di ricerca AI conversazionali, con un impatto particolarmente forte per i domini più piccoli senza grande autorevolezza. Le ricerche mostrano che i titoli basati su domande hanno un impatto 7 volte superiore per i domini sotto i 50K visitatori mensili rispetto ai titoli tradizionali, rendendo questa strategia particolarmente efficace per i brand emergenti. Anche le sezioni FAQ sono potenti, raddoppiando la probabilità di citazione se implementate correttamente con coppie domanda-risposta chiare.

La differenza tra titoli basati su domande e titoli tradizionali è significativa:

Titolo sbagliato: “Top 10 strumenti di marketing”

Titolo corretto: “Quali sono i 10 migliori strumenti di marketing per le piccole imprese?”

Titolo sbagliato: “Strategia di content marketing”

Titolo corretto: “Come dovrebbero sviluppare una strategia di content marketing le piccole imprese?”

Titolo sbagliato: “Best practice per l’email marketing”

Titolo corretto: “Quali sono le best practice per l’email marketing nelle aziende e-commerce?”

Tattiche pratiche di ottimizzazione includono:

Ottimizzazione dei titoli – Inserisci la domanda principale a cui risponde il tuo contenuto; usa linguaggio naturale invece di frasi piene di keyword.

Sezioni FAQ – Crea sezioni dedicate con 5-10 domande e risposte dirette; questo raddoppia la probabilità di citazione sulle query competitive.

Allineamento dei sottotitoli – Usa titoli H2 e H3 che seguano i pattern delle domande comuni; questo aiuta gli LLM ad abbinare le query degli utenti ai tuoi contenuti.

Posizionamento delle risposte dirette – Inserisci risposte dirette all’inizio delle sezioni, non nascoste nei paragrafi; gli LLM estraggono meglio le risposte in posizione prominente.

L’ottimizzazione basata su domande non è un trucco per “ingannare” il sistema; significa allineare la struttura dei tuoi contenuti al modo in cui gli utenti fanno domande e i sistemi AI le interpretano.

Molti creatori di contenuti sprecano tempo e risorse su tattiche di ottimizzazione che hanno poco o nessun impatto sulla visibilità AI, o che addirittura la danneggiano. Comprendere questi falsi miti ti aiuterà a concentrarti su strategie realmente efficaci. Un mito persistente è che i file LLMs.txt abbiano un impatto significativo sulla visibilità; le ricerche mostrano che questi file hanno un impatto trascurabile, con domini che li utilizzano che vedono pattern di citazione solo marginalmente diversi (3,8 vs 4,1 citazioni in media) rispetto a chi non li utilizza.

Falsi miti da evitare:

Solo il markup FAQ schema non aiuta – Sebbene il markup FAQ sia utile per la ricerca tradizionale, dà benefici minimi per la visibilità AI; conta molto di più la struttura reale dei contenuti. I contenuti con schema FAQ ma struttura scadente ricevono in media 3,6 citazioni, mentre quelli ben strutturati senza schema arrivano a 4,2.

L’over-ottimizzazione riduce le citazioni – URL, titoli e meta description troppo ottimizzati riducono la probabilità di citazione; contenuti molto ottimizzati ricevono 2,8 citazioni in media, mentre quelli scritti naturalmente arrivano a 5,9. Gli LLM riconoscono e penalizzano i tentativi di forzare l’ottimizzazione.

Il keyword stuffing non aiuta gli LLM – A differenza dei motori di ricerca tradizionali, gli LLM comprendono il significato semantico e rilevano il keyword stuffing come segnale di bassa qualità; i contenuti in linguaggio naturale ricevono molte più citazioni.

Solo i backlink non garantiscono visibilità – L’autorevolezza è importante, ma qualità e struttura dei contenuti contano di più; un dominio autorevole con struttura scadente ottiene meno citazioni di un dominio meno autorevole ma con struttura eccellente.

Lunghezza senza sostanza non funziona – Allungare i contenuti solo per raggiungere certi conteggi di parole senza aggiungere valore riduce la probabilità di citazione; gli LLM riconoscono e penalizzano i “contenuti vuoti”.

Concentrati sulla qualità autentica, una struttura chiara e una reale competenza invece che su trucchi di ottimizzazione.

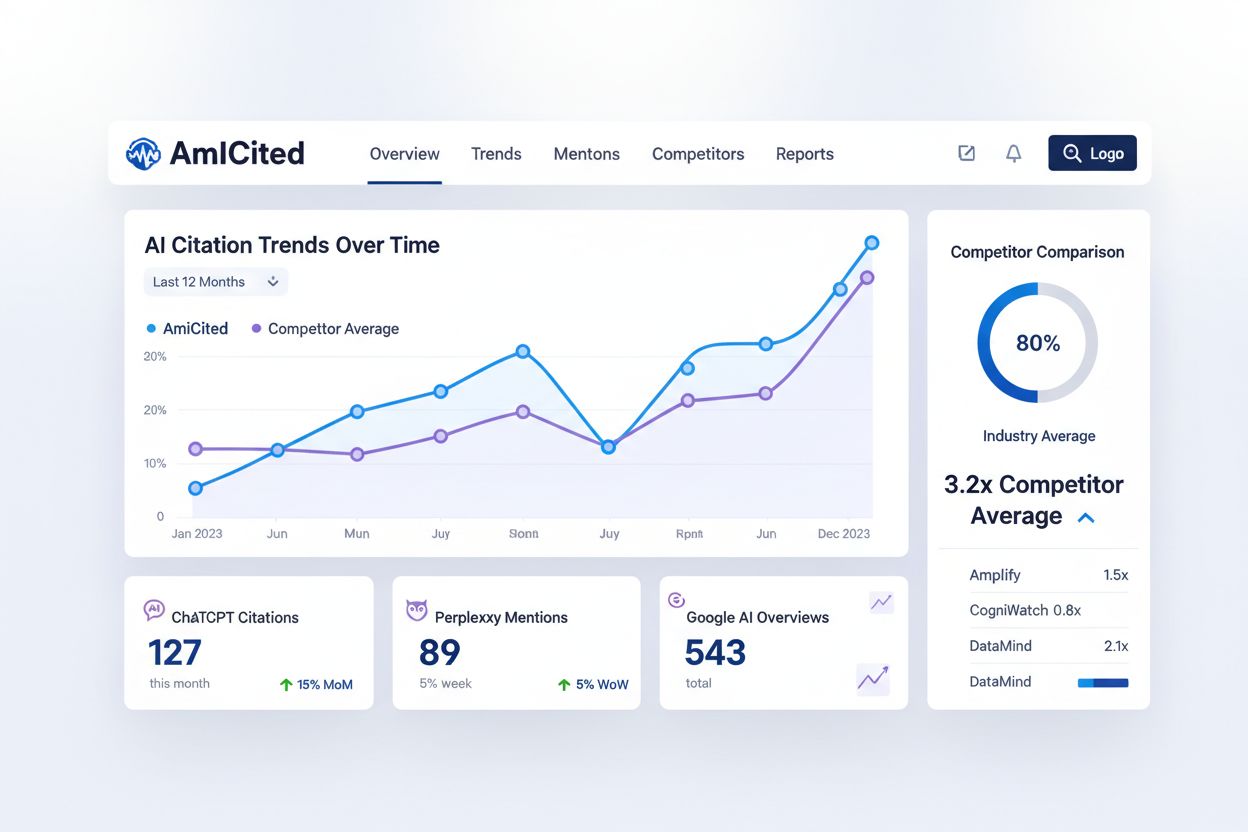

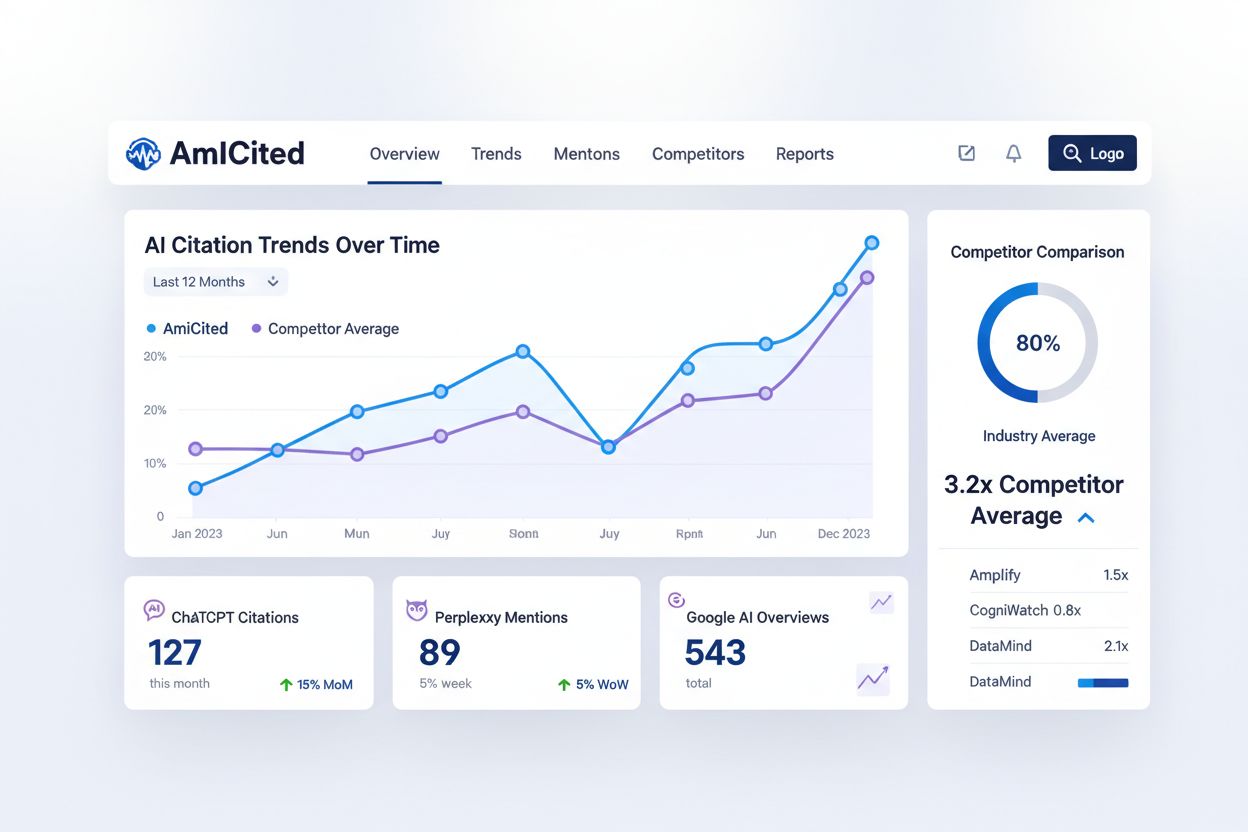

Monitorare come i sistemi AI conversazionali citano i tuoi contenuti è essenziale per comprendere la tua visibilità AI e individuare opportunità di ottimizzazione, ma la maggior parte dei creatori di contenuti non ha visibilità su questa metrica critica. AmICited.com offre una piattaforma dedicata per tracciare come ChatGPT, Perplexity, Google AI Overviews e altri sistemi AI citano il tuo brand e i tuoi contenuti. Questa capacità di monitoraggio colma un gap fondamentale nella cassetta degli attrezzi dei content creator, integrando i tradizionali strumenti SEO e fornendo visibilità su un paradigma di ricerca completamente diverso.

AmICited traccia diverse metriche chiave che gli strumenti SEO tradizionali non possono misurare:

Frequenza delle citazioni – Quanto spesso i tuoi contenuti sono citati dai diversi sistemi AI; questa metrica mostra quali contenuti risuonano con gli algoritmi AI e quali argomenti vanno migliorati.

Pattern delle citazioni – Quali pagine e contenuti sono citati più spesso; questo ti aiuta a identificare i tuoi contenuti più forti e le eventuali lacune.

Visibilità AI dei competitor – Vedi come i tuoi tassi di citazione AI si confrontano con quelli dei competitor; questo benchmarking ti aiuta a capire la tua posizione competitiva nel panorama AI.

Monitoraggio delle tendenze – Segui come la tua visibilità AI cambia nel tempo mentre implementi ottimizzazioni; puoi così misurare l’impatto delle tue strategie di contenuto.

Diversità delle fonti – Traccia le citazioni sui diversi sistemi AI; la visibilità su ChatGPT può essere diversa rispetto a Perplexity o Google AI Overviews, e capire queste differenze ti aiuta a ottimizzare per i singoli sistemi.

Integrare AmICited nella tua strategia di monitoraggio dei contenuti ti fornisce i dati necessari per ottimizzare specificamente la visibilità AI invece di andare alla cieca.

Implementare una strategia di contenuti basata su domande per l’AI conversazionale richiede un approccio sistematico che migliori i contenuti esistenti e stabilisca nuove pratiche di ottimizzazione per il futuro. Il processo deve essere metodico e guidato dai dati, iniziando con un audit dei contenuti attuali e proseguendo con ottimizzazione strutturale, costruzione dell’autorevolezza e monitoraggio continuo. Questo framework in otto step offre una roadmap pratica per trasformare la tua strategia di contenuto e massimizzare la visibilità AI.

Audita i contenuti esistenti – Analizza le tue prime 50 pagine per struttura, lunghezza, gerarchia dei titoli e frequenza di aggiornamento; individua le pagine già ben strutturate e quelle da ottimizzare.

Individua keyword di domande ad alto valore – Ricerca le query conversazionali nel tuo settore con strumenti come Answer the Public, Quora e Reddit; dai priorità alle domande con alto volume e intento commerciale.

Ristruttura con sezioni Q&A – Riorganizza i contenuti esistenti integrando titoli basati su domande e risposte dirette; trasforma i titoli focalizzati sulle keyword in titoli basati su domande che rispecchiano le query degli utenti.

Implementa la gerarchia dei titoli – Assicurati che tutti i contenuti seguano una gerarchia H2/H3 corretta con organizzazione chiara degli argomenti; suddividi le sezioni lunghe in blocchi da 120-180 parole separati da sottotitoli descrittivi.

Aggiungi sezioni FAQ – Crea sezioni FAQ dedicate per le tue 20 pagine principali, con 5-10 domande e risposte dirette; dai priorità alle domande che emergono dai dati di ricerca e dai feedback degli utenti.

Costruisci autorevolezza tramite backlink – Sviluppa una strategia di backlink puntando a domini di alta qualità nel tuo settore; concentrati sulla qualità delle fonti più che sulla quantità.

Monitora con AmICited – Imposta il monitoraggio per il tuo brand e i contenuti chiave; stabilisci metriche di base e traccia i cambiamenti man mano che ottimizzi.

Aggiornamenti trimestrali – Definisci una programmazione per il refresh trimestrale dei contenuti, aggiungendo nuove statistiche, aggiornando esempi e assicurando freschezza; dai priorità ai contenuti con più traffico e più citazioni.

Questa strategia trasforma la tua ottimizzazione da SEO tradizionale a un approccio completo che massimizza la visibilità sia nella ricerca tradizionale che nei sistemi AI conversazionali.

I contenuti basati su domande sono materiali strutturati attorno a domande in linguaggio naturale che gli utenti pongono ai sistemi di AI conversazionale. Invece di puntare su keyword come 'dentista Torino', si mirano domande complete come 'Dove posso trovare un buon dentista a Torino aperto nei fine settimana?'. Questo approccio allinea i contenuti al modo naturale di parlare delle persone e a come i sistemi AI interpretano le query.

La ricerca tradizionale restituisce una lista di link ordinati in base alla corrispondenza delle keyword, mentre l'AI conversazionale sintetizza risposte dirette da più fonti. L'AI conversazionale comprende il contesto, mantiene la cronologia della conversazione e fornisce risposte sintetizzate con citazioni. Questa differenza fondamentale richiede strategie di ottimizzazione dei contenuti diverse.

Gli LLM analizzano i contenuti in modo gerarchico utilizzando la struttura dei titoli e le sezioni per capire l'organizzazione delle informazioni. Una struttura ottimale con sezioni da 120-180 parole, una chiara gerarchia H2/H3 e risposte dirette all'inizio delle sezioni facilita l'estrazione e la citazione dei tuoi contenuti da parte dei sistemi AI. Una struttura scadente riduce la probabilità di citazione, indipendentemente dalla qualità dei contenuti.

Le ricerche mostrano che circa 1.900 parole rappresentano la soglia minima per una visibilità AI competitiva, mentre una copertura davvero completa arriva a 2.900+ parole. Tuttavia, la profondità conta più della lunghezza: contenuti con citazioni di esperti, dati statistici e prospettive multiple ricevono molte più citazioni rispetto a contenuti 'gonfiati'.

I contenuti aggiornati negli ultimi tre mesi ricevono in media 6,0 citazioni, contro 3,6 per i contenuti obsoleti. Implementa una strategia di aggiornamento trimestrale aggiungendo nuove statistiche, aggiornando esempi e inserendo sviluppi recenti. Questo segnala freschezza ai sistemi AI e mantiene la competitività nelle citazioni.

Sì. Anche se i grandi domini hanno vantaggi di autorevolezza, i siti più piccoli possono competere attraverso una migliore struttura dei contenuti, ottimizzazione basata su domande e coinvolgimento della community. I titoli basati su domande hanno un impatto 7 volte superiore per i domini più piccoli e una presenza attiva su Quora e Reddit può offrire una probabilità di citazione 4 volte maggiore.

AmICited monitora come ChatGPT, Perplexity e Google AI Overviews citano il tuo brand e i tuoi contenuti. Offre visibilità sulle modalità di citazione, individua lacune nei contenuti, traccia la visibilità AI dei competitor e misura l'impatto delle tue ottimizzazioni—metriche che i tradizionali strumenti SEO non forniscono.

No. Sebbene il markup schema sia utile per la ricerca tradizionale, offre benefici minimi per la visibilità AI. I contenuti con schema FAQ ricevono in media 3,6 citazioni, mentre contenuti ben strutturati senza schema ne ricevono 4,2. Concentrati più sulla struttura e qualità reale dei contenuti che sul solo markup.

Scopri come ChatGPT, Perplexity e Google AI Overviews citano il tuo brand con il monitoraggio delle citazioni AI di AmICited.

Scopri le tendenze chiave che stanno plasmando l'evoluzione della ricerca AI nel 2026, tra cui capacità multimodali, sistemi agentici, recupero delle informazio...

Scopri come ottimizzare il tuo brand per assistenti vocali come Alexa e Siri. Esplora strategie per migliorare la visibilità nei risultati di ricerca vocale e r...

Scopri come la ricerca AI sta rimodellando la SEO. Impara le differenze chiave tra piattaforme AI come ChatGPT e la ricerca tradizionale di Google, e come ottim...