PR guidato dai dati: Creare ricerche che l'IA vuole citare

Scopri come creare ricerche originali e contenuti PR guidati dai dati che i sistemi di IA citano attivamente. Scopri i 5 attributi dei contenuti degni di citazi...

Scopri come i dati di sondaggi proprietari e le statistiche originali diventano magneti di citazioni per gli LLM. Scopri strategie per migliorare la visibilità AI e ottenere più citazioni da ChatGPT, Perplexity e Google AI Overviews.

I Large Language Model non inventano dati: li prelevano da fonti verificabili. Quando il tuo team pubblica statistiche uniche o metodologie originali, possiedi temporaneamente quella conoscenza, offrendo agli LLM un motivo per citarti e validare così le loro risposte. Questa è la base di ciò che IDX chiama “Authority Flywheel”, un sistema in cui la ricerca proprietaria diventa il tuo magnete di citazioni più potente.

La meccanica è semplice: i modelli AI valutano le fonti in base alla possibilità di verificare le affermazioni su più canali. Quando pubblichi una ricerca originale, crei un asset di conoscenza che non esiste in nessun altro luogo sul web. Questa unicità costringe gli LLM a citare la tua fonte se vogliono includere quei dati nelle loro risposte. Una campagna per The Zebra, una piattaforma assicurativa, dimostra perfettamente questo principio: combinando ricerca proprietaria e Digital PR sono stati generati oltre 1.580 link media di alta qualità e un incremento del traffico organico del 354%.

Secondo ricerche recenti, il 48,6% degli esperti SEO ha identificato la Digital PR come la tattica di link building più efficace per il 2025. Ma il vero potere risiede in ciò che accade dopo: quando i tuoi dati proprietari vengono distribuiti su domini di alto livello tramite Digital PR, confermano la tua autorità in molteplici reti di conoscenza contemporaneamente. Questa validazione multicanale è esattamente ciò che cercano gli LLM quando decidono se citare il tuo brand.

L’insight chiave: i dati proprietari creano quella che i ricercatori chiamano “proprietà temporanea della conoscenza”. Diversamente dai contenuti generici che competono con migliaia di articoli simili, la tua ricerca originale è l’unica fonte per quei dati specifici. Questo principio di scarsità rende più probabile che gli LLM ti citino, perché citarti è l’unico modo per includere quell’informazione nelle loro risposte.

Comprendere come gli LLM recuperano e selezionano realmente le fonti è fondamentale per ottimizzare le citazioni. Questi sistemi non funzionano come i motori di ricerca tradizionali. Operano invece tramite due percorsi di conoscenza distinti: memoria parametrica (conoscenza appresa durante l’addestramento) e conoscenza recuperata (informazioni in tempo reale tramite Retrieval-Augmented Generation, o RAG).

La conoscenza parametrica rappresenta tutto ciò che un LLM “sa” dalla fase di pre-addestramento. Questa conoscenza è statica e fissata al cut-off dell’addestramento del modello. Circa il 60% delle query su ChatGPT viene risposto solo tramite conoscenza parametrica senza alcuna ricerca web. Le entità menzionate frequentemente tra fonti autorevoli durante l’addestramento sviluppano rappresentazioni neurali più forti, risultando più facilmente richiamabili. I contenuti di Wikipedia rappresentano circa il 22% dei dati di addestramento dei principali LLM, spiegando la frequenza delle citazioni Wikipedia nelle risposte AI.

La conoscenza recuperata opera diversamente. Quando un LLM ha bisogno di informazioni aggiornate, utilizza sistemi RAG che combinano semantic search (vettori densi) e keyword matching (BM25) tramite Reciprocal Rank Fusion. Le ricerche dimostrano che il retrieval ibrido offre un miglioramento del 48% rispetto agli approcci singoli. Il sistema poi riordina i risultati usando modelli cross-encoder prima di inserire i primi 5-10 blocchi nel prompt LLM come contesto.

| Segnale | Priorità SEO tradizionale | Priorità citazione LLM | Perché conta |

|---|---|---|---|

| Autorità di dominio | Alta (fattore centrale) | Debole/Neutrale | Gli LLM privilegiano la struttura dei contenuti rispetto alla forza del dominio |

| Quantità di backlink | Alta (segnale primario) | Debole/Neutrale | Gli LLM valutano la credibilità in modo diverso |

| Struttura dei contenuti | Media | Critica | Heading chiari e blocchi risposta essenziali per l’estrazione |

| Dati proprietari | Bassa | Molto alta | Informazioni uniche forzano la citazione |

| Volume di ricerca brandizzato | Bassa | Massima (correlazione 0,334) | Indica autorità e domanda reale |

| Freschezza | Media | Alta | Gli LLM preferiscono contenuti aggiornati |

| Segnali E-E-A-T | Media | Alta | Credenziali autore e trasparenza sono importanti |

La differenza critica: gli LLM non classificano le pagine, ma estraggono blocchi semantici. Una pagina con metriche SEO tradizionali scarse ma struttura cristallina e dati proprietari può superare una pagina autorevole ma vaga. Questo cambiamento fondamentale implica che la strategia di citazione deve privilegiare leggibilità per le macchine e chiarezza, più che i tradizionali indicatori di link building.

Le metriche che contano per la visibilità AI sono cambiate radicalmente rispetto ai segnali SEO tradizionali. Per due decenni, autorità di dominio, backlink e ranking di parole chiave hanno definito il successo. Nel 2025, queste metriche sono diventate quasi irrilevanti per le citazioni di LLM. Al loro posto emerge una nuova gerarchia basata su come i sistemi AI valutano e selezionano davvero le fonti.

Il volume di ricerca brandizzato è oggi il predittore più forte delle citazioni LLM, con un coefficiente di correlazione di 0,334 – molto più alto di qualunque metrica SEO tradizionale. Ha senso: se milioni di persone cercano il tuo brand, segnala autorità e domanda reale. Gli LLM riconoscono questo segnale e lo pesano molto quando decidono se citarti. I backlink invece mostrano correlazione debole o neutra con le citazioni AI, contraddicendo decenni di saggezza SEO.

Il cambiamento riguarda anche la valutazione dei contenuti. Aggiungere statistiche aumenta la visibilità AI del 22%. Inserire citazioni dirette la incrementa del 37%. Le ricerche originali vengono citate 3 volte più spesso dei contenuti generici. Non sono miglioramenti marginali: rappresentano cambiamenti fondamentali nel modo in cui gli LLM valutano la qualità delle fonti.

| Metrica | Focus passato (pre-2024) | Nuovo focus (2025+) | Impatto sulle citazioni LLM |

|---|---|---|---|

| Indicatore qualità link | DA/DR (autorità dominio) | Rilevanza tematica & contesto editoriale | Grounding e diversità delle fonti |

| Strategia anchor text | Parole chiave esatte | Brand/Menzioni entità | Riconoscimento entità e coerenza |

| Tipo di contenuto | Guest post (volume) | Ricerca originale/Data journalism | 3x probabilità di citazione |

| Misurazione obiettivo | Aumento ranking | Tasso di citazione in AI Overview | Validazione fiducia e autorità |

| Approccio outreach | Acquisizione link | Costruzione relazioni/valore | Maggiore qualità editoriale |

Questa matrice rivela un insight cruciale: i brand vincenti nella visibilità AI non sono necessariamente quelli con più backlink o maggiore autorità di dominio. Sono quelli che producono ricerca originale, mantengono segnali brandizzati coerenti e pubblicano contenuti strutturati per l’estrazione automatica. Il vantaggio competitivo si è spostato dalla quantità di link alla qualità e unicità dei contenuti.

I dati di sondaggio proprietari hanno un ruolo unico nella strategia di visibilità AI. Diversamente dai report di settore generici che gli LLM possono reperire da più fonti, i tuoi dati originali sono citabili solo dal tuo sito. Questo crea un vantaggio nelle citazioni che i concorrenti non possono replicare, anche con profili di backlink forti.

I dati di sondaggio funzionano perché offrono ciò che gli LLM chiamano “grounding”: prove verificabili che validano le affermazioni. Quando affermi che “il 78% dei marketing leader dà priorità alla visibilità AI”, gli LLM possono citare il tuo sondaggio come prova. Senza questi dati, la stessa affermazione sarebbe speculativa e gli LLM la ignorerebbero o citerebbero la ricerca di un concorrente.

I dati di sondaggio più efficaci rispondono a domande specifiche poste dal tuo pubblico target:

L’impatto è misurabile. Ricerche dimostrano che aggiungere statistiche aumenta la visibilità AI del 22%, mentre le citazioni la fanno salire del 37%. La ricerca originale viene citata 3 volte più spesso dei contenuti generici. Questi moltiplicatori si sommano quando combini più tipologie di dati proprietari in un unico asset.

La chiave è la trasparenza. Gli LLM valutano la metodologia tanto quanto i risultati. Se la metodologia è solida, la dimensione del campione sufficiente e i risultati onestamente presentati (inclusi i limiti), gli LLM ti citeranno con sicurezza. Se la metodologia è vaga o i risultati sembrano di parte, gli LLM daranno priorità alle fonti più trasparenti.

Pubblicare dati proprietari è solo metà della battaglia. L’altra metà è strutturare quei dati per permettere agli LLM di estrarli e citarli facilmente. L’architettura dei contenuti conta quanto i dati stessi.

Inizia con risposte dirette. Gli LLM preferiscono contenuti che partono dalla risposta, non dal percorso. Invece di “Abbiamo condotto un sondaggio per capire le priorità marketing, ecco cosa abbiamo trovato”, scrivi “Il 78% dei marketing leader ora dà priorità alla visibilità AI nella strategia 2025”. Questa struttura diretta rende l’estrazione più semplice e aumenta le possibilità di citazione.

La lunghezza ottimale del paragrafo per l’estrazione LLM è di 40-60 parole. Questa misura consente agli LLM di estrarre un pensiero completo senza troncamenti. Paragrafi più lunghi vengono spezzati, perdendo contesto; quelli più corti potrebbero non contenere abbastanza informazioni.

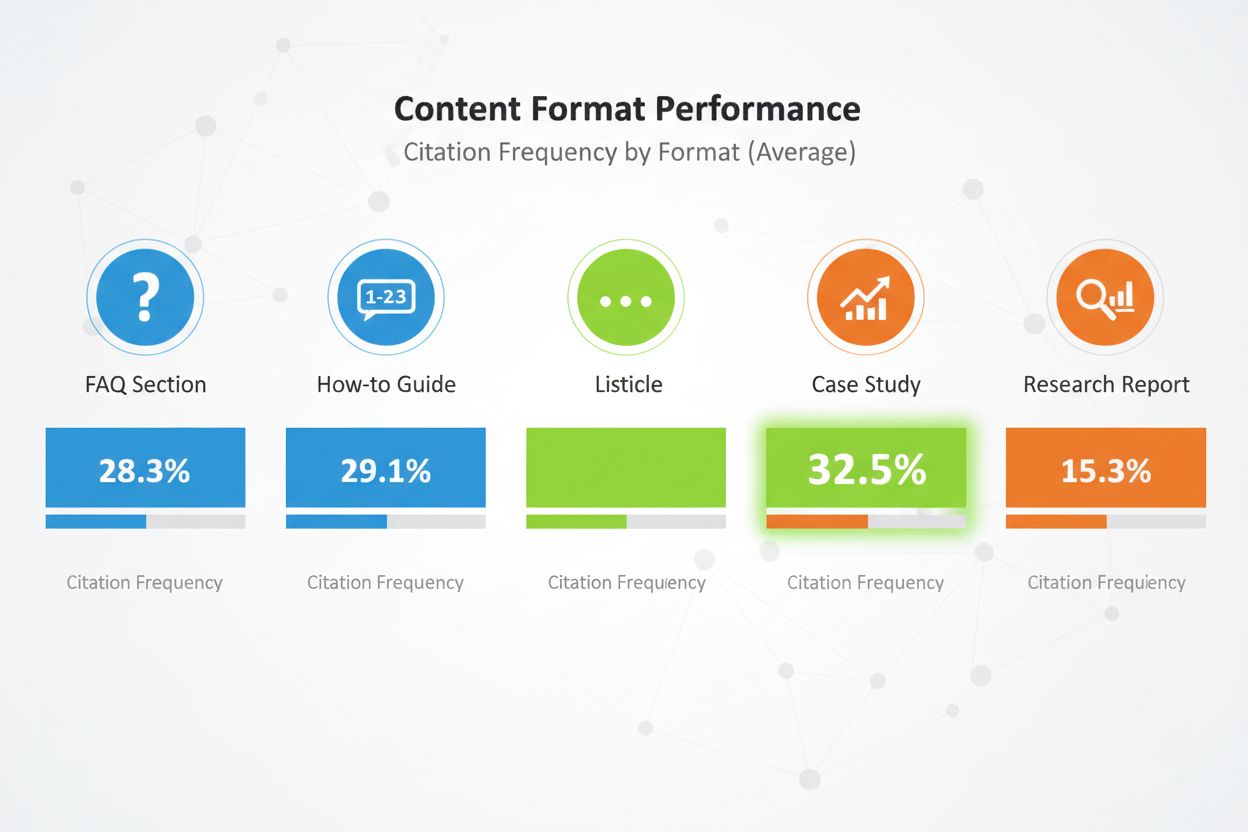

Il formato dei contenuti conta molto. I listicle comparativi ricevono il 32,5% di tutte le citazioni AI – il tasso più alto tra tutti i formati. Le sezioni FAQ funzionano eccezionalmente bene perché rispecchiano il modo in cui gli utenti interrogano i sistemi AI. Guide pratiche, case study e report di ricerca ottengono buoni risultati, ma i listicle superano costantemente gli altri formati.

Struttura i contenuti con una gerarchia di heading chiara. Usa heading H2 che rispecchiano le query più probabili. Sotto ogni H2, usa H3 per i sotto-argomenti. Questa gerarchia aiuta gli LLM a comprendere la struttura e ad estrarre le sezioni rilevanti.

Implementa segnali E-E-A-T ovunque. Inserisci bio degli autori con credenziali e esperienza reale. Collega validazioni di terze parti delle tue affermazioni. Sii trasparente nella metodologia. Cita le fonti. Questi segnali comunicano agli LLM che i tuoi contenuti sono affidabili e degni di citazione.

Usa HTML semantico. Struttura i dati con i tag <table>, <ul>, <ol> invece che div stile CSS. Rende i tuoi contenuti più facili da analizzare e riassumere per l’AI. Inserisci schema markup (Article, FAQPage, HowTo) per fornire ulteriore contesto sul tipo di contenuto.

Infine, aggiorna regolarmente i contenuti. Gli LLM preferiscono dati freschi, specie se sensibili al tempo. Se il tuo sondaggio è del 2024, aggiorna nel 2025. Aggiungi timestamp “Ultimo aggiornamento” per dimostrare che mantieni attivamente i tuoi contenuti. Questo segnala agli LLM che i tuoi dati sono aggiornati e affidabili.

Pubblicare dati proprietari sul tuo sito è necessario ma non sufficiente. Gli LLM scoprono i contenuti tramite molteplici canali, e la tua strategia di distribuzione determina quanti di questi canali trasportano i tuoi dati.

La Digital PR è il canale di distribuzione più efficace per i dati proprietari. Quando la tua ricerca appare su pubblicazioni di settore, testate e blog autorevoli, crea molteplici opportunità di citazione. Gli LLM indicizzano queste menzioni di terze parti e le usano per validare la tua fonte originale. Un brand presente su 4+ piattaforme ha 2,8 volte più probabilità di essere citato da ChatGPT rispetto a brand con presenza limitata.

I canali di distribuzione efficaci includono:

Ogni canale serve a uno scopo. I comunicati stampa creano awareness e copertura media. Le pubblicazioni di settore danno credibilità e raggiungono i decisori. L’amplificazione su LinkedIn raggiunge i professionisti su larga scala. L’engagement su Reddit dimostra la fiducia della community. Le piattaforme di recensioni forniscono dati strutturati facilmente analizzabili dagli LLM.

L’effetto moltiplicatore è notevole. Quando i tuoi dati proprietari appaiono su più fonti autorevoli, gli LLM vedono segnali coerenti sul web. Questa coerenza aumenta la fiducia nei tuoi dati e rende la citazione più probabile. Una sola menzione sul tuo sito può passare inosservata. Gli stessi dati menzionati sul sito, in un comunicato stampa, su una pubblicazione di settore e su una piattaforma di recensioni diventano impossibili da ignorare.

Anche il tempismo conta. Distribuisci strategicamente i dati proprietari. Rilascia prima sul sito con comunicato stampa. Poi pubblicazioni di settore. Poi amplifica sui social e nella community. Questo approccio scaglionato crea un’onda di visibilità sostenuta invece che un picco singolo.

Pubblicare dati proprietari senza misurarne l’impatto è come fare pubblicità senza tracciare le conversioni. Serve visibilità su quanto i tuoi dati ottengano effettivamente citazioni e migliorino la tua visibilità AI.

Inizia dal tracciamento della frequenza citazionale. Identifica 20-50 domande chiave che i tuoi dati proprietari risolvono. Interroga mensilmente le principali piattaforme AI (ChatGPT, Perplexity, Claude, Google AI Overviews) con queste domande. Documenta se il tuo brand compare, in quale posizione, e se la citazione include un link al tuo sito.

Calcola la frequenza di citazione come percentuale: (Prompts dove sei menzionato) / (Totale prompts) × 100. Punta a una frequenza di citazione del 30%+ sulle query core. I brand top nelle categorie competitive arrivano anche al 50%+.

Traccia l’AI Share of Voice (AI SOV) eseguendo prompt identici e calcolando la percentuale delle menzioni del tuo brand. Se appari in 3 risposte su 10 e i competitor in 2 ciascuno, il tuo AI SOV è 30%. Nelle categorie competitive, mira a un AI SOV superiore del 10-20% rispetto alla tua quota di mercato tradizionale.

Monitora l’analisi del sentiment. Oltre alla menzione, traccia se le AI descrivono positivamente, neutrale o negativamente il tuo brand. Usa strumenti come Profound AI specializzati nella detection di allucinazioni – identificando quando le AI forniscono informazioni errate o obsolete sul tuo brand. Punta a un sentiment positivo del 70%+ sulle piattaforme AI.

Imposta una dashboard Knowledge-Based Indicator (KBI) che tracci:

Aggiorna queste metriche mensilmente. Cerca trend, non singoli dati. Un mese scarso di citazioni può essere rumore. Tre mesi di declino indicano un problema che richiede intervento.

Tracciare manualmente le citazioni dei dati proprietari è laborioso e soggetto a errori. AmICited.com offre l’infrastruttura per monitorare la tua visibilità AI su larga scala, specificamente pensata per i brand che usano i dati proprietari come strategia di citazione.

La piattaforma monitora come i sistemi AI citano la tua ricerca proprietaria su ChatGPT, Perplexity, Google AI Overviews, Claude, Gemini e altre AI emergenti. Invece di interrogare manualmente ogni piattaforma ogni mese, AmICited automatizza il processo, eseguendo i tuoi prompt target in continuazione e tracciando i pattern citazionali in tempo reale.

Le funzionalità chiave includono:

La piattaforma si integra con il tuo stack di analytics, inserendo i dati di citazione AI nei dashboard marketing accanto alle metriche SEO tradizionali. Questa visione unificata ti aiuta a comprendere il vero impatto della strategia dati proprietari su visibilità di brand e generazione pipeline.

Per i brand che puntano seriamente alla visibilità AI, AmICited fornisce l’infrastruttura di misurazione che rende possibile l’ottimizzazione. Non puoi migliorare ciò che non misuri, e gli analytics tradizionali non sono stati pensati per tracciare le citazioni LLM. AmICited colma questo gap, dandoti la visibilità necessaria per massimizzare il ROI dei tuoi investimenti in dati proprietari.

Anche le strategie di dati proprietari ben intenzionate falliscono spesso a causa di errori evitabili. Conoscere questi ostacoli ti aiuta a evitarli.

L’errore più comune è nascondere i dati dietro form “Contatta le vendite”. Gli LLM non possono accedere a contenuti protetti, quindi si baseranno su informazioni incomplete o speculative dai forum. Se i risultati dei tuoi sondaggi sono nascosti, gli LLM citeranno una discussione Reddit sul tuo prodotto invece della ricerca ufficiale. Pubblica pubblicamente i risultati chiave con metodologia trasparente. Puoi proteggere i report dettagliati mantenendo i dati riassuntivi accessibili.

Terminologia incoerente sulle piattaforme crea confusione. Se il tuo sito parla di “piattaforma di marketing automation” e su LinkedIn ti definisci “CRM software”, gli LLM fanno fatica a ricostruire la natura del tuo business. Usa sempre lo stesso linguaggio di categoria. Definisci una mappa terminologica e applicala su sito, LinkedIn, Crunchbase e altre piattaforme.

Credenziali autore mancanti minano la fiducia. Gli LLM valutano attentamente i segnali E-E-A-T. Se al sondaggio mancano bio autore con credenziali reali, gli LLM lo ignorano. Inserisci bio dettagliate con esperienza, certificazioni e pubblicazioni precedenti. Linka i profili autore su LinkedIn e altre piattaforme.

Statistiche obsolete danneggiano la credibilità. Se il sondaggio è del 2023 ma lo citi nel 2025, gli LLM se ne accorgono. Aggiorna la ricerca regolarmente. Aggiungi timestamp “Ultimo aggiornamento”. Conduci sondaggi nuovi ogni anno per mantenere la freschezza. Gli LLM preferiscono dati recenti, specialmente su temi sensibili al tempo.

Metodologia vaga riduce la possibilità di citazione. Se la metodologia del sondaggio non è trasparente, gli LLM mettono in dubbio la validità dei risultati. Pubblica la metodologia apertamente. Spiega dimensione e metodo del campione, periodo, limiti. La trasparenza genera fiducia.

Keyword stuffing nei contenuti dati proprietari funziona peggio sulle AI che nella ricerca tradizionale. Gli LLM rilevano e penalizzano il linguaggio artificiale. Scrivi naturale. Punta su chiarezza e accuratezza, non sulla densità keyword. I tuoi dati dovrebbero sembrare vera ricerca, non copy marketing.

Contenuti scarni attorno ai dati proprietari sono penalizzati. Un solo paragrafo con i risultati del sondaggio non basta. Crea contenuti completi che esplorano implicazioni, danno contesto e rispondono alle domande successive. Punta a 2.000+ parole di contenuto sostanzioso per ogni asset dati principale.

Esempi reali dimostrano la forza dei dati proprietari per la visibilità AI. Questi brand hanno investito in ricerca originale e visto risultati misurabili.

Il successo Digital PR di The Zebra: The Zebra, piattaforma di comparazione assicurativa, ha combinato ricerca proprietaria e Digital PR generando oltre 1.580 link media di alta qualità e un +354% di traffico organico. Pubblicando dati di settore assicurativo originali e distribuendoli tramite earned media, è diventata la fonte di riferimento per i dati assicurativi. Gli LLM ora citano le ricerche di The Zebra per domande su trend e prezzi assicurativi.

La strategia di engagement community di Tally: Tally, builder di form online, ha migliorato la propria visibilità AI partecipando attivamente ai forum community e condividendo la roadmap prodotto. Più che pubblicare ricerche, Tally è diventato voce autorevole nelle community degli utenti. Questo engagement autentico ha reso ChatGPT fonte top di referral, portando a forti aumenti settimanali di nuovi iscritti. Grazie a evidenze curate e specifiche, Tally ha alzato l’accuratezza GPT-4 dal 56% all’89%.

Il programma di ricerca continua di HubSpot: HubSpot pubblica regolarmente report su trend marketing, efficacia sales e best practice customer service. Questi report sono diventati standard di settore, citati spesso dagli LLM. L’impegno di HubSpot nella ricerca costante ha reso il brand sinonimo di dati e insight marketing. Quando gli LLM rispondono su trend marketing, la ricerca di HubSpot compare costantemente.

Questi casi studio condividono elementi chiave: ricerca originale, metodologia trasparente, distribuzione coerente e aggiornamenti continui. Nessuno di questi brand si è affidato a un solo progetto di ricerca. Hanno invece costruito programmi che generano dati proprietari in modo continuativo, creando un vantaggio citazionale costante.

La lezione è chiara: i dati proprietari non sono una tattica una tantum. Sono un investimento strategico per diventare fonte autorevole nella tua categoria. I brand che investono in ricerca regolare, metodologia trasparente e distribuzione strategica ottengono citazioni costanti dagli LLM e costruiscono un vantaggio competitivo duraturo nella visibilità AI.

Non servono enormi dataset. Anche un sondaggio mirato da 100-500 rispondenti può fornire insight proprietari di valore che gli LLM citeranno. La chiave è che i dati siano originali, la metodologia trasparente e i risultati azionabili. Qualità e unicità contano più della quantità.

Sondaggi sulla soddisfazione dei clienti, ricerca su trend di settore, analisi della concorrenza, studi sul comportamento degli utenti e ricerche sulle dimensioni di mercato funzionano tutti bene. I dati migliori rispondono a domande specifiche che il tuo pubblico target si pone e offrono insight che i concorrenti non hanno.

Piattaforme in tempo reale come Perplexity possono citare dati freschi nel giro di settimane. ChatGPT e altri modelli con aggiornamenti meno frequenti possono impiegare 2-3 mesi. Dati proprietari costanti e di alta qualità mostrano tipicamente aumenti misurabili nelle citazioni entro 3-6 mesi.

No. Gli LLM non possono accedere a contenuti protetti, quindi si baseranno invece su informazioni incomplete o speculative prese dai forum. Pubblica i risultati chiave pubblicamente con metodologia trasparente. Puoi proteggere report dettagliati mantenendo comunque dati riassuntivi e insight accessibili pubblicamente.

Usa una terminologia chiara e coerente su tutte le piattaforme. Includi metodologia trasparente nella tua ricerca. Aggiungi credenziali e certificazioni dell'autore. Inserisci link a validazioni di terze parti. Usa schema markup per strutturare i tuoi dati. Monitora le citazioni ogni mese e correggi rapidamente eventuali imprecisioni.

Sì. Le ricerche originali guadagnano tipicamente backlink e copertura mediatica, migliorando il posizionamento tradizionale. Inoltre, i dati proprietari creano contenuti più completi e autorevoli, utili sia per la SEO tradizionale che per la visibilità AI.

I dati proprietari sono ricerche originali che conduci direttamente. I report generici sono ampiamente disponibili. Gli LLM preferiscono i dati proprietari perché sono unici e citabili solo dalla tua fonte. Questo crea un vantaggio nelle citazioni che i concorrenti non possono facilmente replicare.

Traccia la frequenza delle citazioni, l'AI Share of Voice, il volume di ricerca brandizzata e il traffico dalle piattaforme AI. Confronta questi indicatori prima e dopo la pubblicazione dei dati proprietari. Calcola il valore del traffico referenziato dalle AI (tipicamente con un tasso di conversione 4,4 volte superiore rispetto all'organico tradizionale) per determinare il ROI.

Monitora come i sistemi AI citano i tuoi dati proprietari su ChatGPT, Perplexity, Google AI Overviews e altro ancora. Ottieni insight in tempo reale sulla tua visibilità AI e sul posizionamento competitivo.

Scopri come creare ricerche originali e contenuti PR guidati dai dati che i sistemi di IA citano attivamente. Scopri i 5 attributi dei contenuti degni di citazi...

Scopri come le citazioni di esperti aumentano la visibilità del tuo marchio nei motori di ricerca IA come ChatGPT e Perplexity. Scopri strategie per ottenere ci...

Scopri come funziona l'autorità delle citazioni nelle risposte AI, come le diverse piattaforme citano le fonti e perché è importante per la visibilità del tuo b...