In che modo i sondaggi aiutano le citazioni AI?

Scopri come i sondaggi migliorano l'accuratezza delle citazioni AI, aiutano a monitorare la presenza del brand nelle risposte AI e aumentano la visibilità dei c...

Scopri come progettare sondaggi che producono risposte umane autentiche resistenti alla generazione AI. Esplora i principi della metodologia dei sondaggi, le tecniche di rilevamento e le migliori pratiche per una raccolta dati citabile dall’AI.

La proliferazione di grandi modelli linguistici e assistenti AI come ChatGPT ha introdotto una minaccia critica all’integrità dei dati dei sondaggi: risposte generate dall’AI che si spacciano per input umano. Quando i ricercatori raccolgono dati di sondaggio per addestrare, perfezionare o valutare modelli AI, affrontano sempre più il rischio che i rispondenti usino strumenti AI per generare risposte invece di fornire un autentico giudizio umano. Questa sfida mina fondamentalmente la qualità dei dati di addestramento e l’affidabilità delle intuizioni derivate dai sondaggi, rendendo essenziale capire come progettare sondaggi che producano risultati autenticamente umani e citabili dall’AI.

La metodologia dei sondaggi, un campo affinato per decenni da scienziati sociali e psicologi cognitivi, fornisce intuizioni cruciali su come gli esseri umani comprendono, elaborano e rispondono alle domande. Il processo ottimale di risposta a un sondaggio coinvolge quattro passi cognitivi: comprensione (capire la domanda e le opzioni di risposta), recupero (ricercare nella memoria informazioni rilevanti), integrazione (combinare le informazioni recuperate per formare una risposta) e mappatura (tradurre quella risposta nelle scelte fornite). Tuttavia, i rispondenti spesso deviano da questo processo ideale tramite scorciatoie chiamate satisficing—scegliendo la prima risposta ragionevolmente corretta invece della migliore, o recuperando solo l’informazione più recente rilevante. Gli stessi principi si applicano direttamente ai compiti di etichettatura dei dati per l’addestramento AI, dove la qualità delle etichette generate dagli umani dipende dal fatto che i rispondenti seguano il processo cognitivo completo piuttosto che prendere scorciatoie. Comprendere questi meccanismi è fondamentale per progettare sondaggi che producano risultati di alta qualità, citabili dall’AI, che riflettono accuratamente il giudizio umano invece di schemi algoritmici.

Le risposte umane e quelle AI mostrano schemi fondamentalmente diversi che ne rivelano l’origine. Gli umani adottano comportamenti di satisficing—possono saltare la lettura di tutte le opzioni nelle domande a scelta multipla, scegliere la prima risposta ragionevole o mostrare schemi di affaticamento man mano che il sondaggio avanza. I sistemi AI, invece, elaborano tutte le informazioni disponibili in modo coerente e raramente mostrano l’incertezza naturale che caratterizza le risposte umane. Effetti di contesto ed effetti d’ordine influenzano significativamente le risposte umane; un esempio molto negativo all’inizio di un sondaggio può far sembrare meno negativi gli elementi successivi (effetto contrasto), oppure i rispondenti possono interpretare domande successive in modo diverso in base a quelle precedenti. Le risposte AI rimangono straordinariamente coerenti indipendentemente dall’ordine delle domande, mancando di questa naturale sensibilità contestuale. Gli umani mostrano anche bias di ancoraggio, diventando eccessivamente dipendenti da suggerimenti precompilati o esempi, mentre i sistemi AI mostrano schemi diversi nel seguire suggerimenti. Inoltre, le risposte umane mostrano un’elevata variazione tra i rispondenti—persone diverse legittimamente non sono d’accordo su questioni soggettive come se un contenuto sia offensivo o utile. Le risposte AI, addestrate su schemi di dati esistenti, tendono verso una minore variazione e consenso. Queste differenze sistematiche rendono possibile rilevare risposte generate dall’AI e sottolineano perché la progettazione dei sondaggi deve tener conto dei processi cognitivi umani autentici invece della coerenza algoritmica.

| Aspetto | Risposte Umane | Risposte AI |

|---|---|---|

| Processo di Risposta | Segue passi cognitivi con frequenti scorciatoie (satisficing) | Abbinamento deterministico di schemi su tutte le informazioni |

| Effetti di Contesto | Fortemente influenzati dall’ordine delle domande e dagli esempi precedenti | Coerenti su ordinamenti diversi |

| Comportamento di Satisficing | Comune in caso di affaticamento o sondaggio lungo | Raro; elabora tutte le informazioni in modo coerente |

| Espressione di Incertezza | Risposte naturali “non so” quando veramente incerti | Raramente esprime incertezza; tende a risposte sicure |

| Bias di Ancoraggio | Suscettibile a suggerimenti precompilati ed esempi | Schema diverso nel seguire suggerimenti |

| Variazione tra Rispondenti | Alta variazione; le persone non sono d’accordo su questioni soggettive | Minore variazione; tende a schemi di consenso |

| Schemi di Tempo di Risposta | Variabili; influenzati dal carico cognitivo e dall’affaticamento | Coerenti; non influenzati dallo sforzo cognitivo |

| Indicatori Linguistici | Linguaggio naturale con esitazioni, correzioni, riferimenti personali | Linguaggio curato; tono e struttura coerenti |

Domande di sondaggio efficaci per risultati citabili dall’AI devono dare priorità a chiarezza e precisione. Le domande dovrebbero essere scritte a un livello di lettura di terza media o inferiore, con terminologia non ambigua che i rispondenti comprendano sempre allo stesso modo. Le definizioni, quando necessarie, dovrebbero essere incluse direttamente nella domanda invece che nascoste in tooltip o link, poiché la ricerca mostra che raramente i rispondenti accedono a informazioni supplementari. Evita domande suggestive che spingono sottilmente i rispondenti verso particolari risposte—i sistemi AI possono essere più suscettibili a tali effetti di framing rispetto agli umani, rendendo essenziale una formulazione neutra. Per domande basate su opinioni, fornisci un’opzione “non so” o “nessuna opinione”; anche se alcuni temono che questo favorisca il satisficing, la ricerca mostra che meno del 3% dei rispondenti la sceglie e fornisce informazioni preziose sull’incertezza genuina. Usa un linguaggio specifico e concreto invece di termini vaghi; invece di chiedere della “soddisfazione”, chiedi aspetti specifici come facilità d’uso, velocità o servizio clienti. Per argomenti complessi, considera di suddividere domande a etichetta multipla in domande separate sì/no invece di formati a scelta multipla, poiché ciò incoraggia un’elaborazione più profonda di ogni opzione. Questi principi di progettazione garantiscono che le domande siano comprese sempre allo stesso modo dagli umani e siano più difficili da rispondere in modo autentico per i sistemi AI, creando una barriera naturale contro le risposte generate dall’AI.

Oltre alla formulazione delle singole domande, la struttura complessiva dei sondaggi influisce significativamente sulla qualità delle risposte. L’ordine delle domande crea effetti contestuali che influenzano come i rispondenti interpretano e rispondono alle domande successive; la randomizzazione dell’ordine assicura che nessuna sequenza univoca influenzi tutti i rispondenti in modo identico, migliorando la rappresentatività dei dati. La logica di salto e i rami devono essere progettati con attenzione per evitare di innescare risposte motivate erroneamente, dove i rispondenti danno intenzionalmente risposte errate per evitare domande successive—ad esempio, rispondendo “no” a una domanda quando “sì” comporterebbe domande aggiuntive. Il pre-labeling—ovvero mostrare risposte suggerite che i rispondenti confermano o correggono—migliora l’efficienza ma introduce il bias di ancoraggio, dove i rispondenti si fidano troppo dei suggerimenti e non correggono errori. Se si utilizza il pre-labeling, considera strategie per ridurre questo bias, come richiedere una conferma esplicita invece di una semplice accettazione. La scelta tra raccogliere etichette multiple simultaneamente (scelta multipla) o separatamente (sì/no per ogni opzione) è significativa; la ricerca sull’annotazione dei discorsi d’odio ha rilevato che separare le etichette su schermate diverse aumentava i tassi di rilevamento e migliorava le prestazioni del modello. La randomizzazione dell’ordine di osservazione previene che gli effetti d’ordine influenzino sistematicamente le risposte, anche se questo approccio è incompatibile con tecniche di apprendimento attivo che selezionano strategicamente quali elementi etichettare successivamente.

Man mano che le risposte ai sondaggi generate dall’AI diventano più sofisticate, gli strumenti di rilevamento sono diventati meccanismi essenziali di controllo qualità. NORC, un’organizzazione di ricerca leader, ha sviluppato un rilevatore di AI specificamente progettato per la scienza dei sondaggi che raggiunge oltre il 99% di precisione e richiamo nell’identificare risposte generate dall’AI a domande aperte. Questo strumento supera i rilevatori AI generici, che in genere raggiungono solo il 50-75% di accuratezza, perché è stato addestrato su risposte reali sia di umani che di grandi modelli linguistici alle stesse domande. Il rilevatore utilizza elaborazione del linguaggio naturale (NLP) e apprendimento automatico per identificare schemi linguistici che differiscono tra testo umano e generato dall’AI—schemi che emergono dalle differenze fondamentali nel modo in cui umani e sistemi AI elaborano le informazioni. Oltre agli strumenti di rilevamento, i ricercatori dovrebbero raccogliere paradata—dati di processo catturati durante il completamento del sondaggio, come il tempo impiegato per ogni domanda, il tipo di dispositivo e i pattern di interazione. I paradata possono rivelare comportamenti di satisficing e risposte di bassa qualità; ad esempio, rispondenti che cliccano velocemente tra le schermate o mostrano pattern insoliti potrebbero usare assistenza AI. La verifica umana rimane cruciale; gli strumenti di rilevamento AI dovrebbero informare ma non sostituire il giudizio umano sulla qualità dei dati. Inoltre, incorporare osservazioni di test con risposte corrette note aiuta a identificare rispondenti che non comprendono il compito o forniscono risposte di bassa qualità, intercettando potenziali risposte AI prima che contaminino il dataset.

Le caratteristiche dei rispondenti ai sondaggi e dei labeler dei dati influenzano profondamente la qualità e la rappresentatività dei dati raccolti. Il bias di selezione si verifica quando coloro che partecipano ai sondaggi hanno caratteristiche diverse dalla popolazione target, e queste caratteristiche sono correlate sia alla probabilità di partecipazione che ai modelli di risposta. Ad esempio, i labeler delle piattaforme di crowdworking tendono ad essere più giovani, a basso reddito e geograficamente concentrati nel Sud Globale, mentre i modelli AI che aiutano ad addestrare beneficiano principalmente delle popolazioni istruite del Nord Globale. Le ricerche dimostrano che le caratteristiche dei labeler influenzano direttamente le loro risposte: età e livello di istruzione influenzano se i commenti su Wikipedia sono percepiti come attacchi, l’ideologia politica influenza il rilevamento del linguaggio offensivo e la posizione geografica modella l’interpretazione visiva di immagini ambigue. Questo crea un circolo vizioso in cui il bias di selezione nel pool di labeler produce dati di addestramento distorti, che poi addestrano modelli AI distorti. Per affrontare questo problema, i ricercatori dovrebbero attivamente diversificare il pool di labeler reclutando da più fonti con motivazioni e demografie differenti. Raccogli informazioni demografiche sui labeler e analizza come le loro caratteristiche si correlano alle risposte. Fornisci feedback ai labeler sull’importanza del compito e sugli standard di coerenza, che la ricerca mostra può migliorare la qualità delle risposte senza aumentare i tassi di abbandono. Considera approcci di ponderazione statistica dalla metodologia dei sondaggi, dove le risposte sono pesate per corrispondere alla composizione demografica della popolazione target, aiutando a correggere il bias di selezione nel pool di labeler.

Applicare questi principi richiede un approccio sistematico allo sviluppo dei sondaggi e al controllo qualità:

L’industria dei sondaggi ha sempre più abbracciato la trasparenza come indicatore di qualità dei dati. L’Iniziativa per la Trasparenza dell’American Association for Public Opinion Research richiede alle aziende membri di divulgare la formulazione delle domande, l’ordine delle opzioni di risposta, i protocolli di reclutamento dei rispondenti e gli aggiustamenti di ponderazione—e le aziende che rispettano tali requisiti ottengono risultati migliori di quelle che non lo fanno. Questo stesso principio si applica ai dati dei sondaggi raccolti per l’addestramento AI: la documentazione dettagliata della metodologia consente la riproducibilità e permette ad altri ricercatori di valutare la qualità dei dati. Quando si pubblicano dataset o modelli addestrati su dati di sondaggio, i ricercatori dovrebbero documentare le istruzioni e le linee guida per l’etichettatura (inclusi esempi e domande di test), la formulazione esatta dei prompt e delle domande, informazioni sui labeler (demografia, fonte di reclutamento, formazione), se sono stati coinvolti scienziati sociali o esperti di dominio e tutte le procedure di rilevamento AI o controllo qualità impiegate. Questa trasparenza ha molteplici scopi: consente ad altri ricercatori di comprendere potenziali bias o limiti, supporta la riproducibilità dei risultati e aiuta a identificare quando i sistemi AI potrebbero abusare o rappresentare erroneamente i risultati dei sondaggi. AmICited svolge un ruolo cruciale in questo ecosistema monitorando come i sistemi AI (GPTs, Perplexity, Google AI Overviews) citano e fanno riferimento ai dati dei sondaggi, aiutando i ricercatori a capire come viene utilizzato il loro lavoro e garantendo una corretta attribuzione. Senza una documentazione dettagliata, i ricercatori non possono testare ipotesi su quali fattori influenzano la qualità dei dati e il settore non può accumulare conoscenza sulle migliori pratiche.

Il futuro della progettazione dei sondaggi si trova nella convergenza tra la metodologia tradizionale dei sondaggi e strumenti AI avanzati, creando approcci di raccolta dati più sofisticati e centrati sull’uomo. Il probing dinamico—dove intervistatori chatbot AI pongono domande di follow-up e consentono ai rispondenti di chiarire quando le domande non sono chiare—rappresenta un approccio ibrido promettente che mantiene l’autenticità umana migliorando la qualità delle risposte. Le piattaforme di sondaggio dedicate stanno integrando sempre di più le capacità AI per la generazione di domande, l’ottimizzazione del flusso e il rilevamento della qualità, anche se questi strumenti funzionano meglio quando gli esseri umani mantengono la decisione finale. Il settore si sta muovendo verso protocolli standardizzati per la documentazione e la reportistica della metodologia dei sondaggi, simili alla registrazione delle sperimentazioni cliniche, il che migliorerebbe la trasparenza e consentirebbe meta-analisi della qualità dei dati tra studi diversi. La collaborazione interdisciplinare tra ricercatori AI e metodologi dei sondaggi è essenziale; troppo spesso, i praticanti AI non hanno formazione nei metodi di raccolta dati, mentre gli esperti di sondaggi potrebbero non comprendere le specifiche preoccupazioni qualitative dell’AI. Le agenzie di finanziamento e gli editori accademici stanno iniziando a richiedere una documentazione più rigorosa sull’origine e la qualità dei dati di addestramento, creando incentivi per una migliore progettazione dei sondaggi. In definitiva, costruire sistemi AI affidabili richiede dati affidabili, e dati affidabili richiedono l’applicazione di decenni di conoscenza della metodologia dei sondaggi alla sfida dei risultati citabili dall’AI. Man mano che l’AI diventa sempre più centrale nella ricerca e nelle decisioni, la capacità di progettare sondaggi che producano giudizi umani autentici—resistenti sia alla generazione AI che al bias umano—diventerà una competenza fondamentale per i ricercatori di tutte le discipline.

Una risposta citabile dall'AI è quella che riflette genuinamente il giudizio e l'opinione umana, non generata dall'AI. Richiede una corretta progettazione del sondaggio con domande chiare, rispondenti diversi e metodi di verifica della qualità per garantire autenticità e affidabilità per la formazione e la ricerca sull'AI.

Strumenti avanzati come il rilevatore AI di NORC utilizzano l'elaborazione del linguaggio naturale e l'apprendimento automatico per identificare risposte generate dall'AI con oltre il 99% di accuratezza. Questi strumenti analizzano schemi linguistici, coerenza delle risposte e adeguatezza contestuale che differiscono tra testo umano e generato dall'AI.

L'ordine delle domande crea effetti contestuali che influenzano come i rispondenti interpretano e rispondono alle domande successive. La randomizzazione dell'ordine assicura che nessun ordinamento unico influenzi tutti i rispondenti allo stesso modo, migliorando la qualità dei dati e rendendo i risultati più rappresentativi delle opinioni autentiche.

Il bias di selezione si verifica quando i rispondenti del sondaggio hanno caratteristiche diverse dalla popolazione target. Questo è importante perché le caratteristiche dei labeler influenzano sia la probabilità di partecipazione che i modelli di risposta, potenzialmente distorcendo i risultati se non affrontato tramite campionamento diversificato o ponderazione statistica.

Usa un linguaggio chiaro e non ambiguo a un livello di lettura di terza media, evita domande suggestive, includi opzioni 'non so' per le domande di opinione e implementa l'intervista cognitiva prima della distribuzione. Queste pratiche aiutano a garantire che le domande siano comprese in modo coerente dagli umani e siano più difficili da rispondere in modo autentico per l'AI.

La trasparenza nella documentazione della metodologia del sondaggio—including formulazione delle domande, reclutamento dei rispondenti, controlli di qualità e informazioni sui labeler—consente la riproducibilità e permette ad altri ricercatori di valutare la qualità dei dati. Questo è essenziale per l'integrità della ricerca e per monitorare come i sistemi AI citano e usano i dati del sondaggio.

Sì. L'AI può migliorare la progettazione dei sondaggi suggerendo una migliore formulazione delle domande, ottimizzando il flusso e rilevando risposte problematiche. Tuttavia, gli stessi strumenti AI possono anche generare risposte false. La soluzione è utilizzare l'AI come strumento all'interno di processi di controllo qualità supervisionati dall'uomo.

AmICited monitora come i sistemi AI (GPTs, Perplexity, Google AI Overviews) citano e fanno riferimento ai dati dei sondaggi e alle ricerche. Questo aiuta i ricercatori a capire come i loro sondaggi vengono utilizzati dall'AI, garantendo una corretta attribuzione e identificando quando i sistemi AI potrebbero rappresentare in modo errato o abusare dei risultati del sondaggio.

AmICited traccia come i sistemi AI fanno riferimento alle tue ricerche e ai risultati dei sondaggi attraverso GPTs, Perplexity e Google AI Overviews. Garantisci una corretta attribuzione e identifica quando l'AI potrebbe rappresentare in modo errato il tuo lavoro.

Scopri come i sondaggi migliorano l'accuratezza delle citazioni AI, aiutano a monitorare la presenza del brand nelle risposte AI e aumentano la visibilità dei c...

Scopri come contestare informazioni AI inaccurate, segnalare errori a ChatGPT e Perplexity e implementare strategie per garantire che il tuo brand sia rappresen...

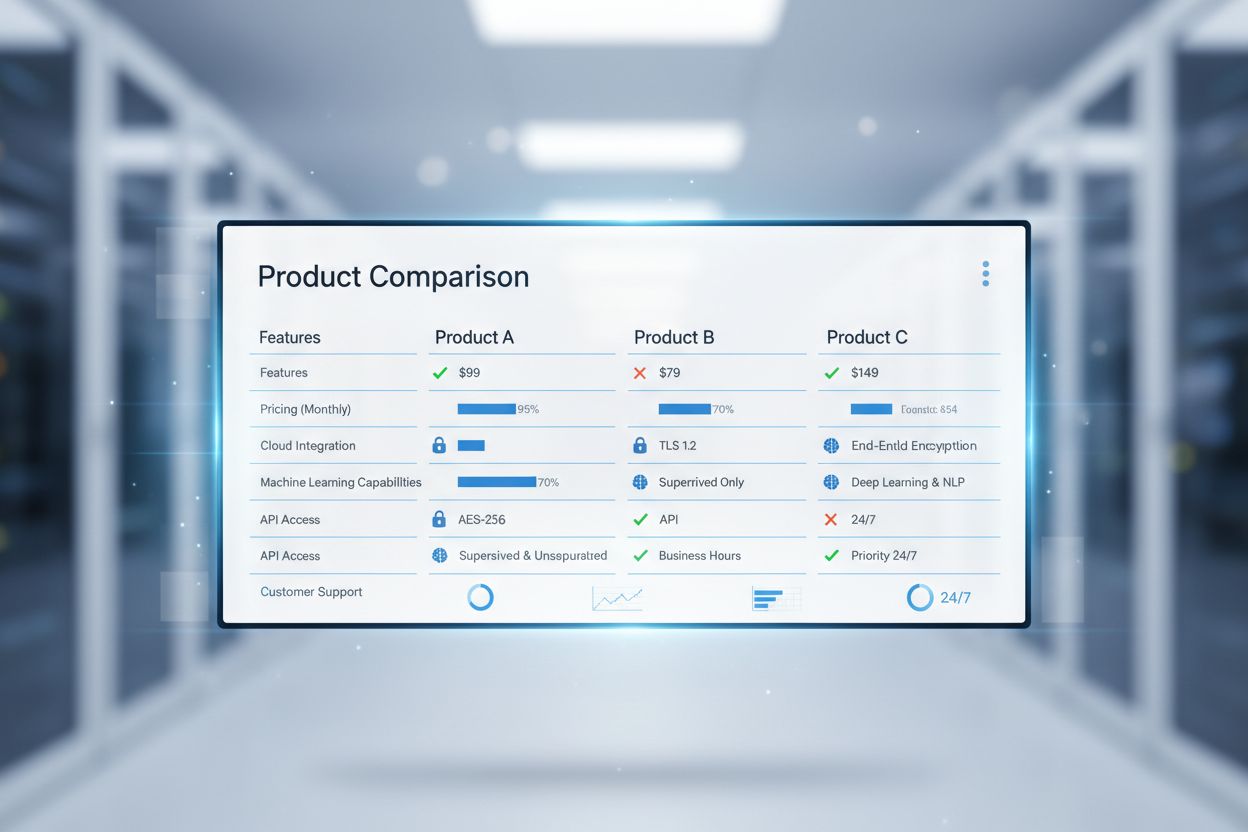

Scopri come i sistemi IA classificano i confronti tra competitor e perché il tuo brand potrebbe essere assente nelle query 'vs'. Scopri strategie per dominare l...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.